Az OpenAI kutatói úgy vélik, hogy felfedeztek egy megdöbbentően egyszerű módszert az objektumfelismerő szoftverek elkacsintására, amelyhez csak toll és papír szükséges.

Pontosabban a labor legújabb számítógépes látásmodellje, CLIP, „tipográfiai támadásnak” nevezett módon becsapható. Egyszerűen írja fel az „iPod” vagy „pizza” szavakat egy kis papírra, ragassza fel egy almára, és a szoftver tévesen minősíti a gyümölcsöt Cupertino zenelejátszónak vagy finom ételnek.

„Úgy gondoljuk, hogy a fent leírtakhoz hasonló támadások korántsem pusztán tudományos aggályok” – áll a CLIP hátterében. mondott ezen a héten. "A modell robusztus szövegolvasási képességét kihasználva azt találjuk, hogy még a kézzel írt szöveget tartalmazó fényképek is gyakran megtéveszthetik a modellt." Hozzátették, hogy „ez a támadás a vadonban működik”, és „nem igényel több technológiát, mint toll és papír”.

A CLIP nem az egyetlen mesterségesen intelligens szoftver, amely ilyen egyszerű trükkökbe esik. Bebizonyosodott, hogy ragasztószalaggal használható bolondítsa meg a Tesla Autopilotját félreolvasni egy 35 mph táblát 85 mph-nak. Az úgynevezett ellenséges támadások más formáihoz azonban szükség van némi műszaki know-how végrehajtása: jellemzően zaj hozzáadása egy fényképhez vagy ravaszkodó a matrica gondosan elrendezett pixelekből, hogy tévedjen a tárgyfelismerő rendszerben, mondjuk egy banánt egy kenyérpirítóhoz. A CLIP esetében azonban erre nincs szükség.

Elég annyit mondanunk, hogy az OpenAI modelljét szöveges képek, valamint tárgyak és egyéb, az internetről kikapart képek felhasználásával képezték ki.

Úgy gondolja, hogy az okosórája jó szívrohamra való figyelmeztetésre? Kiderült, hogy meglepően könnyű becsapni az AI-t

Ezt a megközelítést azért választották, hogy a CLIP meglehetősen általános célú maradjon, és szükség szerint finomhangolható legyen egy adott munkaterheléshez anélkül, hogy átképzésre lenne szükség. Adott egy kép, nem csak a jelenetet leíró szöveges címkék megfelelő készletét tudja megjósolni, hanem újra felhasználható nagy képadatbázisok közötti keresésre és feliratozásra.

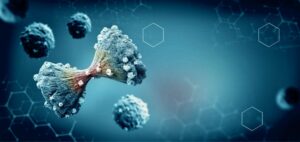

A CLIP képes megtanulni absztrakt fogalmakat különböző reprezentációkban, mondta az OpenAI. Például a modell képes felismerni a Pókembert, ha a szuperhőst fényképen, vázlaton vagy szövegben ábrázolják. Ennél is érdekesebb, hogy a kutatóknak sikerült találniuk a neurális hálózatban olyan neuroncsoportokat, amelyek akkor aktiválódnak, amikor a szoftver megpillantja a Pókembert.

Ezeket így írták le multimodális neuronok. „Az egyik ilyen neuron például a „Pókember” neuron, amely egy pók képére, a „pók” szöveg képére és a „Pókember” képregényszereplőre reagál akár jelmezben, akár illusztrálva. ” – mondta az OpenAI csapata. A CLIP-nek mindenféle multimodális neuronja van, amelyek különböző fogalmakat képviselnek, például évszakokat, országokat, érzelmeket és tárgyakat.

De a modell legnagyobb erősségei – sokoldalúsága és robusztussága – egyben a legnagyobb gyengesége is. Megállapították, hogy a CLIP-et könnyen becsapják a tipográfiai támadások.

Objektumfelismerő mesterséges intelligencia – a buta program ötlete egy intelligens programról: Hogyan nézik a neurális hálók valójában csak a textúrákat

Visszatérve az alma vs pizza példához, a multimodális neuronok, amelyek megtanulták az alma ábrázolását, nem tüzelnek olyan jól, ha látják a „pizza” írott szót. Ehelyett a pizzával kapcsolatos neuronok aktiválódnak. A modell könnyen összetéveszthető.

Bizonyíték van arra, hogy a multimodális neuronokat használó absztrakt tanulás az emberi agyban is előfordul. De sajnos itt halványulnak el a modern gépek biológiai társaikhoz képest. Az emberek nyilvánvalóan meg tudják állapítani, hogy az alma, amelyen egy pizza felirat olvasható, még mindig alma, míg az AI modellek még nem.

Az OpenAI szerint a CLIP nem teljesít olyan jól, mint egyes számítógépes látásmodellek, amelyeket ma termelésben használnak. Támadó elfogultságoktól is szenved, neuronjai a „Közel-Kelet” fogalmát a „terrorizmussal”, a feketéket pedig a gorillákkal társítják. A modellt jelenleg csak kutatási célokra használják, és az OpenAI még dönt a kód kiadásáról vagy sem.

„A CLIP-ről alkotott saját értelmezésünk még mindig fejlődik, és még mindig azt határozzuk meg, hogy kiadnánk-e a CLIP nagy verzióit, és hogyan. Reméljük, hogy a kiadott verziók és a ma bejelentett eszközök további közösségi feltárása elősegíti a multimodális rendszerek általános megértését, valamint a saját döntéshozatalunkhoz is hozzájárul” – áll a közleményben.

Az OpenAI megtagadta a további megjegyzéseket a CLIP-ről. ®

Forrás: https://go.theregister.com/feed/www.theregister.com/2021/03/05/openai_writing_attack/

- AI

- amp

- Apple

- Támadások

- madár

- Bit

- Fekete

- Feketék

- Doboz

- agyvelő

- feliratok

- kód

- közösség

- Számítógépes látás

- országok

- adatbázisok

- felfedezett

- érzelmek

- kutatás

- sólyom

- természet

- általános

- jó

- Hogyan

- HTTPS

- Az emberek

- ötlet

- kép

- Internet

- IT

- Címkék

- nagy

- legutolsó

- TANUL

- tanulás

- gép

- Közel-Kelet

- modell

- zene

- hálózat

- ideg-

- neurális hálózat

- Zaj

- OpenAI

- Más

- Papír

- Emberek (People)

- Pizza

- játékos

- Termelés

- Program

- kutatás

- Keresés

- készlet

- Egyszerű

- okos

- So

- szoftver

- szuperhős

- rendszer

- Systems

- Műszaki

- Technológia

- Terrorizmus

- felső

- látomás

- hét

- szavak

- művek