A RISC-V processzorok, amelyeket néhány évvel ezelőtt bizonyos funkciók kiegészítő processzorainak számítottak, úgy tűnik, hogy egy teljesen más típusú szerephez – a nagy teljesítményű számítástechnikához – kapnak támogatást.

Ez még a vita szakaszában van. Kérdések maradnak a szoftveres ökoszisztémával, vagy azzal kapcsolatban, hogy a chipek, kártyák és rendszerek elég megbízhatóak-e. És vannak üzleti és technikai problémák is, az üzleti kérdések a legnehezebbek. De a lendületéről beszél RISC-V architektúra, amely a nyílt ISA-nak köszönhetően hatalmas felfutást tapasztalt az elfogadás és a kísérletezés terén. Ez viszont szabadságot ad az iparágnak, hogy újítson vele.

„Nem az ISA (utasításkészlet-architektúra) önmagában olyan vonzó” – mondta Rupert Baines, a vállalat marketing igazgatója. Codasip. „Ez az, amit köré épít. Ezért fontosak a biztonsággal és a közzététellel foglalkozó legjobb gyakorlatok, irányelvek és hivatkozási architektúrák körüli munkacsoportok. Az Open Titan, amely a bizalom nyílt forráskódú gyökere, fontos, mert ez egy jól bevált referenciaarchitektúra. Az emberek ránézhetnek, és nem találják fel újra a kereket, és esetleg hibáznak.”

A nagy kérdés most az, hogy ezt az architektúrát meddig lehet új irányokba tolni. A chipipar szilárdan belépett a tartomány-specifikus számítástechnika korszakába, ahol a processzorok nagymértékben testre szabhatók bizonyos feladatokhoz, és azután felülmúlják a többi rögzített architektúrát ezekben a feladatokban. De ez is problémásabbá teheti a szoftverek portolását, ha a szoftvert az egyéni magokhoz kell optimalizálni.

A RISC-V esetében a nagy teljesítményű számítástechnika és a szuperszámítástechnika óriási előrelépést jelenthet. A szuperszámítógép az általános célú számítógépekhez képest nagy teljesítményű számítógép. Ezek jellemzően lebegőpontos gépek vektorkiterjesztésekkel, és a jelenlegi vezető Frontier körülbelül 1.1 exaFLOP-val képes működni a LINPACK benchmarkon. 8,730,112 86 XNUMX processzormagot tartalmaz az xXNUMX ISA-n.

Ennek ellenére az ilyen behemótok iránti igény egyre nőtt, ahogy más alternatívák széles körben elérhetővé válnak. A HPC korábban egyedi tervezésű, minden célra alkalmas számítógép volt. Manapság egy nagyon hasonló képesség mindenki számára elérhető, aki nagy sebességű kiszolgálók fürtjeit telepíti, akár a helyszínen, akár a felhőben.

Azt, hogy a RISC-V-nek van-e itt lehetséges játéka, számos különböző szemszögből kell megvizsgálni. Kinek lehet szüksége RISC-V architektúrára épülő szuperszámítógépre, és ki hajlandó fizetni érte? A RISC-V ISA és a bővítmények rendelkeznek minden szükséges képességgel egy szuperszámítógép létrehozásához? Létrehozott valaki megfelelő teljesítménnyel rendelkező magot? Minden szükséges szoftver a helyén van?

Arm nyomdokaiba lépve

Egészen a közelmúltig a legtöbb szuperszámítógép az Intel x86 architektúráján alapult. Az Arm javítani akarta a nagy teljesítményű számítástechnikában való behatolását, és 2016 körül készen állt az alapvető hardvertámogatás.

„Amikor az első Arm szuperszámítógépes programokat elindították, az Arm még nem volt kész abban az értelemben, hogy az egész ökoszisztéma ott volt, vagy hogy minden probléma megoldódott” – mondja Rob Aitken, a Synopsys fickó. „Inkább arról volt szó, hogy valaki, valahol azt mondta, elég közel van ahhoz, hogy hajlandó vagyok kockáztatni. hajlandó vagyok kipróbálni. Azt mondanám, hogy a RISC-V vagy azon a ponton van, vagy nagyon közel van ahhoz a ponthoz, ahol valaki hajlandó lesz kockáztatni vele, és építeni valamit egy szuperszámítógép számára.

22. június 2020-én a japán Fugaku szuperszámítógép, amelyet a Fujitsu 48 magos A64FX SoC-je hajt, lett az első karral hajtott szuperszámítógép, amely – legalábbis egy pillanatra – a világ leggyorsabb számítógépeként az első helyre került. A legerősebb nagy teljesítményű számítógépek listája megtalálható a TOP500 lista.

A teljesítmény nem az egyetlen szempont. „Ahhoz, hogy sikeres HPC-kompatibilis processzor legyen, teljesítmény, hatékonyság és biztonság biztosítására van szükség, ugyanakkor támogatni kell az alkalmazások ökoszisztémáját és a fontos, élvonalbeli szerverszabványokat” – mondja David Lecomber, a HPC és eszközök vezető igazgatója. számára Fegyver Infrastruktúra üzletág. „Amikor a tervezési rugalmasságról van szó, akkor fontos, hogy ezt a rugalmasságot ott biztosítsuk, ahol az a legjobban szolgálja a fejlesztőt. Például egy stabil és konzisztens ISA kritikus fontosságú a kereskedelmi HPC-fejlesztők számára, de a rugalmas tervezés a memória alrendszer (DDR5, HBM, CXL-csatlakozás) vagy gyorsítók (on-die vagy PCIe/CXL-csatolt) között nagy teljesítményű. .”

Mit jelent a leggyorsabb?

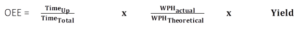

A teljesítménymutatók az elmúlt néhány évben megváltoztak az iparágban. Noha továbbra is az abszolút teljesítmény uralkodik, a rendszereket gyakran korlátozza a teljesítmény, ami bizonyos feladatokra optimalizált architektúrákat eredményez. De kérdéseket vet fel a teljesítmény mérésével kapcsolatban is, mert valószínűleg egyetlen gép sem lesz a leggyorsabb minden feladatban.

Az iparág évek óta használja a LINPACK referenciaértéket, de ez egyre vitatottabb, és nem ad egyszerű választ. Az egyik megközelítés a benchmark kiterjesztése, és ezt HPC Challenge benchmark csomagként emlegetik. Az egyik ötletgazda, Jack Dongarra, a Tennessee Egyetem informatika professzora (kiterjedt életrajz itt), az Egyesült Államok kormánya bízta meg ezzel a munkával. De az egyik probléma megoldása létrehoz egy másikat. A benchmark többé nem ad egyetlen számot, ami megnehezíti az összehasonlítást.

A teljesítmény más okok miatt is nehezen mérhető. Az átviteli sebesség és a késleltetés gyakran egymás ellen van állítva, és ez nem korlátozódik csak a szuperszámítógépekre. Így az egyik rendszer gyorsabban képes az egyik választ produkálni, de a másik rövidebb idő alatt képes egy sor választ előállítani, még akkor is, ha az első válaszra kicsit tovább kell várni.

Mivel az alkalmazások már több mint 1 millió magra skálázhatók a kereskedelmi felhőben, a HPC méret szerinti építése többé nem probléma. Itt az ideje az eredmények elérésének, és ez különösen igaz azokra a feladatokra, amelyek a lehető legközelebbi valós idejű eredményeket kívánják meg. Ez azt jelenti, hogy a HPC-t valószínűleg továbbra is olyan feladatokra fogják használni, mint a pénzügyi kereskedés, ahol az ellenfél legcsekélyebb különbséggel való legyőzése azt jelenti, hogy Ön nyer, ő pedig veszít – néha hatalmas pénzösszegekkel.

A rendszer kiegyensúlyozása

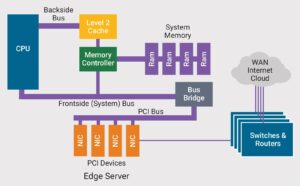

Bármely számítógép felépítéséhez sok tényező megfelelő egyensúlyra van szüksége. „Ha a HPC-t nézzük, az gyakran olyan dolgokra összpontosít, mint az órajel, a magok száma, a magok méretezhetősége a kapcsolódó összekapcsolással” – mondja Frank Schirrmeister, a megoldásokért és üzletfejlesztésért felelős alelnöke. Arteris IP. "De a memória sávszélessége, az energiahatékonyság és a saját vektoros utasítások hozzáadásának képessége ugyanolyan fontos."

Ezt adatáramlási problémának kell tekinteni. „Az adatok valahol elkezdődnek, a memóriából ki kell tölteni őket egy processzorba, feldolgozni egy processzorral vagy gyorsítóval, majd vissza kell helyezni a memóriába” – mondja a Synopsys Aitken. „Ez az egész út, ahol a szűk keresztmetszetek vannak. Ennek kulcsfontosságú része az „uncore”, ennek kulcsfontosságú része a memóriarendszer. Egy adott feladat megoldása során meg kell határozni, hogy hol vannak a szűk keresztmetszetek a rendszerarchitektúrában. Ez független a CPU-tól. A vállalati térben a világ ezt vizsgálja a RISC-V esetében, és dolgozik rajta, de ez még nem feltétlenül van meg.”

Sok esetben az uncore-ban történik meg az igazi innováció. „Ha egy klasztert nézünk, akkor sok processzor kapcsolódik egymáshoz” – mondja az Arteris Schirrmeister. „Itt figyelembe kell venni a magok méretezhetőségét, ez pedig a magok és az összekapcsolás együttes optimalizálását jelenti. A RISC-V lehetőséget ad az innovációra ezen a szinten, valószínűleg jobban, mint néhány szabványos licenc. De ez nagyon sok munka, és természetesen nem triviális. És ez része annak a titkos szósznak, hogy hogyan fog működni a klaszter integrálva.”

Manapság sok feladatot, például az AI/ML-t, egyedi gyorsítók hajtják végre, és az általános célú magok valószínűleg csak ütemezési és koordinációs feladatokat végeznek. „Domainspecifikus gyorsítást kell végrehajtania, vagy különféle gyorsítókat kell használnia az adatközpontokban szükséges növekvő számítási feladatok kezeléséhez” – mondja Travis Lanier, a Ventana alelnöke. "Ezt nem fogja tudni megtenni általános CPU-kkal."

Mások egyetértenek. „Az alapvető teljesítmény az asztal tétje” – mondja Arm's Lecomber. „Egy HPC-kompatibilis CPU-nak jó vektorteljesítményre és magonkénti memória sávszélességre van szüksége. Végül, de ugyanolyan kritikus, a HPC-kompatibilis CPU-knak hatékonyságot kell biztosítaniuk. A fejlesztőknek programozási hatékonyságra van szükségük ahhoz, hogy a lehető legnagyobb teljesítményt tudják kihozni a rendelkezésre álló magokból és gyorsítókból. A rack-szintű és az adatközpontok energiahatékonysága korlátozó tervezési és működési tényezővé válik.”

A szilícium teljesítménye nem csak az ISA-ról vagy akár az RTL-ről szól. „Ha megnézünk bármilyen IP-címet, a sikerük gyakran a fizikai eszközökkel való kapcsolatokon, a dolgok fizikai tudatosságán múlik” – mondja Schirrmeister. „A rendszer részét képező interconnect még a mi részünkről is megköveteli az IP és a megvalósítási folyamat együttes optimalizálását a megfelelő teljesítmény és teljesítmény elérése érdekében. Ugyanez igaz a RISC-V-re is, hogy HPC-kompatibilis legyen. Ez nem olyan egyszerű, de megjelentek bejelentések a processzorokról, amelyek úgy tűnik, hogy közvetlenül az adatközpont más magjai ellen lépnek fel.”

A teljesítmény nem csak a hardvertől függ. Egy adott hardverhez hosszú ideig tarthat a szoftver portolása és optimalizálása, ehhez pedig a megfelelő ökoszisztémára van szükség. „Arm nagyon okos volt az ökoszisztéma előkészítésében” – teszi hozzá Schirrmeister. „Az ökoszisztémák a különböző architektúrák köré összpontosulnak, mint például az x86, az ArmV9 és most a RISC-V. Mindig eltartott egy ideig, amíg ezek az ökoszisztémák készen állnak, és mindent támogattak. Mindennek idő kell, hogy kialakuljon és stabilizálódjon. Azt mondanám, hogy ez valószínűleg a RISC-V korai napja. Igen, nagy a lendület, és potenciálisan sokkal gyorsabban érünk oda, mint a múltban. A RISC-V profitál abból, ami Armmel történt, mert tanulhatsz abból, mi kellett ahhoz, hogy megvegyék a lábukat az ajtóban.”

Iparági támogatás

Egyértelműen van még tennivaló a RISC-V HPC-re való felkészítésén. A megbeszélés és a szükséges munka megkönnyítése érdekében a RISC-V konzorcium létrehozta a nagy teljesítményű számítástechnikával foglalkozó speciális érdekcsoportot (SIG-HPC). A csoport célja a HPC közösség követelményeinek kielégítése és a RISC-V ISA összehangolása. Honlapjuk szerint a hatókör meghatározásával kezdték, és a SIG-HPC érdekeit rangsorolták, hogy a felfedezéstől és a hiányelemzéstől a megvalósításig nagy hatású eredményeket nyújtsanak. Ennek eléréséhez két dologra volt szükség: meg kell tervezni a versenyképessé váláshoz vezető utat, és kiterjeszteni ezt az utat, hogy új funkciókkal és képességekkel vezesse a közösséget.

Az iparágban is sok olyan dolog történik, amely megmutatja, merre tart több vállalat. Az Intel jelentős összegeket fektetett be a barcelonai szuperszámítási központba. 400 millió eurós beruházást jelentett be egy új laboratóriumba, amely a RISC-V processzorok és szuperszámítógépek fejlesztésére irányul. Jeff McVeigh, az Intel Supercomputing Group alelnöke és vezérigazgatója azonban egy kapcsolódó sajtóközleményben azt mondta, hogy „A HPC-hez készült RISC-V még sok évre van hátra”.

Céljuk a mai szuperszámítógépeknél nagyságrendekkel gyorsabb zetta-osztályú rendszerek felépítése, és ez öt éven belül valósítható meg.

A nagy teljesítményű processzorok másik fejlesztője, a MIPS tavaly jelentette be, hogy átállt a RISC-V-t használó processzorok fejlesztésére. A MIPS bejelentette, hogy elérhetővé teszi első, RISC-V ISA-n alapuló magját, amelyet jelenleg olyan alkalmazásokhoz engedélyeznek, mint az autós vezetést segítő rendszerek és az autonóm vezetés. De a MIPS szerint a processzormag adatközpontokhoz, tárolókhoz és nagy teljesítményű számítástechnikához is használható.

Akárcsak a szoftverfejlesztésnél, 90%-ban még csak félúton van kész. Ahogy Tom Cargill, a Bell Labstól, egykor híresen mondta: „A kód első 90%-a teszi ki a fejlesztési idő első 90%-át. A kód fennmaradó 10%-a a fejlesztési idő másik 90%-át teszi ki.”

Összefüggő

RISC-V függetlenített vektor feldolgozó egység (VPU) HPC-hez

“Vitruvius+: An Area-Efficient RISC-V Decoupled Vector Coprocessor for High Performance Computing Applications” published by researchers at Barcelona Supercomputing Center.

A RISC-V adatközpontokat céloz meg

A nyílt forráskódú architektúra egyre nagyobb teret hódít az összetettebb tervekben, ahogy az ökoszisztéma érik.

- SEO által támogatott tartalom és PR terjesztés. Erősödjön még ma.

- Platoblockchain. Web3 metaverzum intelligencia. Felerősített tudás. Hozzáférés itt.

- Forrás: https://semiengineering.com/is-risc-v-ready-for-supercomputing/

- 1

- 2016

- 2020

- a

- képesség

- Képes

- Rólunk

- Abszolút

- gyorsulás

- gázpedál

- gyorsítók

- elérni

- Szerint

- Fiókok

- cím

- Hozzáteszi

- Örökbefogadás

- ellen

- AI / ML

- Minden termék

- alternatívák

- mindig

- elemzés

- és a

- bejelentés

- Közlemények

- Másik

- válasz

- válaszok

- bárki

- megjelenik

- alkalmazások

- megközelítés

- építészet

- ARM

- körül

- Támogatás

- társult

- vonzó

- autóipari

- autonóm

- elérhetőség

- elérhető

- tudatosság

- vissza

- Sávszélesség

- barcelona

- alapján

- alapvető

- mert

- válik

- egyre

- Behemótok

- hogy

- Csengő

- benchmark

- Előnyök

- BEST

- legjobb gyakorlatok

- Jobb

- Nagy

- Bit

- épít

- Épület

- üzleti

- üzlet fejlesztés

- képességek

- Cargill

- esetek

- Központ

- központú

- Centers

- központ

- biztosan

- kihívás

- változó

- fő

- csip

- játékpénz

- választás

- világosan

- óra

- közel

- felhő

- Fürt

- kód

- kereskedelmi

- közösség

- Companies

- képest

- versenyképes

- bonyolult

- számítás

- számítógép

- Computer Science

- számítógépek

- számítástechnika

- kapcsolatok

- Fontolja

- megfontolás

- figyelembe vett

- következetes

- konzorcium

- folytatódik

- vitatott

- összehangolás

- Mag

- tudott

- CPU

- teremt

- készítette

- teremt

- kritikai

- Jelenlegi

- Jelenleg

- szokás

- dátum

- Adatközpont

- adatközpontok

- David

- Nap

- elszánt

- meghatározott

- szállít

- kézbesítés

- függő

- bevezetéséhez

- Design

- tervek

- Fejleszt

- Fejlesztő

- fejlesztők

- fejlesztése

- Fejlesztés

- különböző

- nehéz

- közvetlenül

- Igazgató

- felfedezés

- vita

- Ennek

- Által

- gépkocsivezető

- vezetés

- minden

- Korai

- ökoszisztéma

- ökoszisztémák

- hatékonyság

- bármelyik

- elég

- lépett

- Vállalkozás

- teljesen

- egyaránt

- Ez volt

- különösen

- Még

- Minden

- mindenki

- minden

- fejlődik

- példa

- Bontsa

- terjed

- kiterjesztések

- kiterjedt

- kivonat

- megkönnyítése

- tényezők

- remekül

- gyorsabb

- leggyorsabb

- Jellemzők

- fickó

- kevés

- Végül

- pénzügyi

- határozottan

- vezetéknév

- rögzített

- Rugalmasság

- áramlási

- koncentrál

- Előre

- talált

- szabadság

- ból ből

- Határ

- funkciók

- egyre

- Játszik

- rés

- általános

- Általános rendeltetésű

- kap

- szerzés

- óriás

- adott

- ad

- Célok

- megy

- jó

- Kormány

- Csoport

- Csoportok

- Növekvő

- irányelvek

- fogantyú

- megtörténik

- hardver

- Cím

- súlyosan

- segít

- itt

- Magas

- Nagy teljesítményű számítástechnika

- nagy teljesítményű

- nagyon

- házigazdája

- Hogyan

- How To

- azonban

- hpc

- HTTPS

- azonosítani

- végrehajtás

- fontos

- javul

- in

- egyre inkább

- független

- ipar

- Infrastruktúra

- újít

- Innováció

- utasítás

- integrált

- Intel

- összekapcsolt

- kamat

- érdekek

- befektetett

- beruházás

- IP

- kérdés

- kérdések

- IT

- maga

- csatlakozó

- Japán

- Kulcs

- labor

- Labs

- keresztnév

- Tavaly

- Késleltetés

- vezet

- vezető

- TANUL

- szint

- Engedélyezett

- engedélyek

- Valószínű

- vonal

- Lista

- kis

- Hosszú

- hosszú idő

- hosszabb

- néz

- nézett

- keres

- veszít

- Sok

- gép

- gép

- csinál

- KÉSZÍT

- menedzser

- sok

- Margó

- Marketing

- tömeges

- megérik

- eszközök

- intézkedés

- Memory design

- Metrics

- esetleg

- millió

- hiba

- Lendület

- pénz

- több

- a legtöbb

- szükségszerűen

- elengedhetetlen

- Szükség

- szükséges

- igények

- Új

- Új funkciók

- szám

- célkitűzés

- Tiszt

- ONE

- nyitva

- nyílt forráskódú

- működik

- operatív

- Optimalizálja

- optimalizált

- érdekében

- rendelés

- kezdeményezők

- Más

- teljesítményben felülmúl

- saját

- rész

- múlt

- ösvény

- Fizet

- Emberek (People)

- teljesítmény

- Előadja

- fizikai

- darab

- Hely

- Plató

- Platón adatintelligencia

- PlatoData

- játszani

- pont

- lehetséges

- potenciálisan

- hatalom

- powered

- erős

- gyakorlat

- előkészített

- elnök

- nyomja meg a

- CIKK

- valószínűleg

- Probléma

- problémák

- feldolgozás

- Processzor

- processzorok

- gyárt

- Egyetemi tanár

- Programozás

- Programok

- megfelelően

- ad

- amely

- közzétett

- Kiadás

- meglökött

- tesz

- kérdés

- Kérdések

- emelés

- kész

- igazi

- real-time

- miatt

- nemrég

- referenciák

- említett

- összefüggő

- engedje

- megbízható

- marad

- megmaradó

- képvisel

- szükség

- követelmények

- megköveteli,

- kutatók

- Eredmények

- Kockázat

- Szerep

- gyökér

- Mondott

- azonos

- azt mondja,

- skálázhatóság

- Skála

- Tudomány

- hatálya

- Titkos

- biztonság

- idősebb

- értelemben

- Series of

- szolgálja

- készlet

- számos

- előadás

- Szilícium

- hasonló

- Egyszerű

- egyetlen

- Méret

- okos

- So

- szoftver

- szoftverfejlesztés

- Megoldások

- Megoldása

- néhány

- valami

- valahol

- Hely

- beszél

- speciális

- különleges

- sebesség

- Spot

- stabilizálni

- stabil

- Színpad

- standard

- szabványok

- kezdődött

- kezdődik

- Még mindig

- tárolás

- siker

- sikeres

- ilyen

- megfelelő

- kíséret

- szuperszámítógép

- szuperszámítógépek

- Szuperszámítógép

- támogatás

- Támogatott

- Legfőbb

- túlfeszültség

- kapcsolva

- rendszer

- Systems

- táblázat

- szabott

- Vesz

- tart

- célok

- Feladat

- feladatok

- Műszaki

- A

- a világ

- azok

- dolog

- dolgok

- áteresztőképesség

- idő

- titán-

- nak nek

- Ma

- szerszámok

- felső

- vontatás

- Kereskedés

- igaz

- Bízzon

- FORDULAT

- jellemzően

- nekünk

- Amerikai kormány

- egység

- egyetemi

- használ

- különféle

- Hatalmas

- Alelnök

- várjon

- kívánatos

- weboldal

- Mit

- Kerék

- vajon

- ami

- míg

- WHO

- széles körben

- Wikipedia

- lesz

- hajlandó

- nyer

- belül

- Munka

- dolgozott

- dolgozó

- Munkacsoportok

- világ

- világ

- lenne

- év

- év

- A te

- zephyrnet