A Chicagói Egyetem boffins a héten kiadta a Nightshade 1.0-t, egy olyan eszközt, amely arra készült, hogy megbüntesse a gépi tanulási modellek gátlástalan készítőit, akik előzetes engedély nélkül képezik ki rendszereiket az adatokra.

nadragulya egy támadó adatmérgező eszköz, egy társa a defenzív stílusú védelmi eszköznek Máz, Amely A regisztráció fedett tavaly februárban.

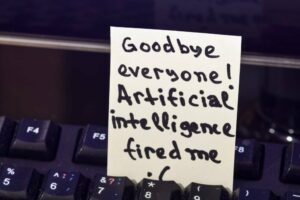

A Nightshade megmérgezi a képfájlokat, hogy emésztési zavarokat okozzon azoknak a modelleknek, akik engedély nélkül vesznek fel adatokat. Célja, hogy ezek az imázsorientált modellek tiszteletben tartsák a tartalomkészítők munkájuk felhasználásával kapcsolatos kívánságait.

"A Nightshade egy többcélú optimalizálás, amely minimalizálja az eredeti kép látható változásait." mondott a projektért felelős csapat.

„Például az emberi szem egy zöld mezőben lévő tehén árnyékolt képét láthatja nagyjából változatlan formában, de egy mesterséges intelligencia modell egy nagy bőrtáskát láthat a fűben heverni. "

A Nightshade-et a Chicagói Egyetem doktoranduszai, Shawn Shan, Wenxin Ding és Josephine Passananti, valamint Heather Zheng és Ben Zhao professzorok fejlesztették ki, akik közül néhányan a Glaze-ben is segítettek.

Leírva a kutatási papír 2023 októberében a Nightshade egy azonnali specifikus mérgezési támadás. Egy kép megmérgezése magában foglalja egy címke (például egy macska) kiválasztását, amely leírja, hogy mit ábrázol valójában, hogy elmossák ennek a fogalomnak a határait, amikor a képet bekebelezik a modellképzéshez.

Így a Nightshade-mérgezett képekre kiképzett modell felhasználója beküldhet egy macskát, és értesítést kaphat egy kutya vagy hal képéről. Az ilyen típusú előre nem látható válaszok jelentősen kevésbé hasznosítják a szöveg-kép modelleket, ami azt jelenti, hogy a modellgyártók arra ösztönöznek, hogy csak a szabadon kínált adatokon tanuljanak.

"A Nightshade hatékony eszközt jelenthet a tartalomtulajdonosok számára, hogy megvédjék szellemi tulajdonukat azokkal a modelloktatókkal szemben, akik figyelmen kívül hagyják vagy figyelmen kívül hagyják a szerzői jogi figyelmeztetéseket, a ne kaparja fel/feltérképezzék a direktívákat és az opt-out listákat" - állítják a szerzők közleményükben.

A műalkotások alkotóinak és tulajdonosainak kívánságait figyelmen kívül hagyása perhez vezetett tavaly nyújtották be, amely az AI-vállalkozások javát szolgáló, engedély nélküli adatgyűjtés elleni szélesebb körű visszalépés része. A több művész nevében a Stability AI, a Deviant Art és a Midjourney ellen benyújtott jogsértési kereset azt állítja, hogy az alperes cégek által használt Stable Diffusion modell engedély nélkül tartalmazza a művészek munkáit. A 2023 novemberében módosított ügyben új alperes szerepel, a Runway AI, tovább hogy pereskedjenek.

A szerzők arra figyelmeztetnek, hogy a Nightshade-nek vannak bizonyos korlátai. Pontosabban, a szoftverrel feldolgozott képek finoman eltérhetnek az eredetitől, különösen a lapos színeket és sima hátteret használó grafikák. Azt is megfigyelik, hogy a Nightshade visszavonására szolgáló technikák kifejlesztésére kerülhet sor, bár úgy gondolják, hogy hozzáigazíthatják szoftverüket, hogy lépést tartsanak az ellenintézkedésekkel.

– mondta Matthew Guzdial, az Albertai Egyetem számítástechnikai adjunktusa egy közösségi médiában Hozzászólás, „Ez klassz és időszerű munka! De attól tartok, hogy túlzásba vitték, mint megoldást. Csak CLIP-alapú modellekkel működik, és a szerzők szerint 8 millió „megmérgezett” képre lenne szükség ahhoz, hogy jelentős hatást gyakoroljon a LAION modellekhez hasonló képek előállítására.”

A Glaze, amely tavaly júniusban elérte az 1.0-t, igen webes verzió, és most rajta van 1.1.1 kiadás, megváltoztatja a képeket, hogy megakadályozza, hogy az ezekre a képekre kiképzett modellek lemásolják a művész vizuális stílusát.

A stílusmimika – amely a zárt szöveg-kép szolgáltatásokon, például a Midjourney-n és a nyílt forráskódú modelleken keresztül, például a Stable Diffusion-on keresztül érhető el – egyszerűen úgy lehetséges, hogy egy szöveg-kép modellt arra kérünk, hogy egy adott művész stílusában készítsen képet.

A csapat úgy gondolja, hogy a művészeknek módot kell adni arra, hogy megakadályozzák vizuális stílusaik megörökítését és reprodukálását.

"A stílusmimika számos káros következménnyel jár, amelyek első pillantásra nem feltétlenül nyilvánvalóak" - állítják a Boffins. „Azok a művészek, akiknek a stílusát szándékosan másolják, nemcsak a jutalékok és az alapjövedelem veszteségét látják, hanem az online szétszórt gyenge minőségű szintetikus másolatok is rontják márkájukat és hírnevüket. A legfontosabb, hogy a művészek stílusukat identitásukkal társítják.”

A stílusutánzatot a személyazonosság-lopáshoz hasonlítják, és azt mondják, hogy ez elriasztja a feltörekvő művészeket az új alkotásoktól.

A csapat azt javasolja a művészeknek, hogy a Nightshade-t és a Glaze-t is használják. Jelenleg a két eszközt külön-külön kell letölteni és telepíteni, de a kombinált verzió fejlesztés alatt áll. ®

- SEO által támogatott tartalom és PR terjesztés. Erősödjön még ma.

- PlatoData.Network Vertical Generative Ai. Erősítse meg magát. Hozzáférés itt.

- PlatoAiStream. Web3 Intelligence. Felerősített tudás. Hozzáférés itt.

- PlatoESG. Carbon, CleanTech, Energia, Környezet, Nap, Hulladékgazdálkodás. Hozzáférés itt.

- PlatoHealth. Biotechnológiai és klinikai vizsgálatok intelligencia. Hozzáférés itt.

- Forrás: https://go.theregister.com/feed/www.theregister.com/2024/01/20/nightshade_ai_images/

- :van

- :is

- :nem

- 1

- 2023

- 8

- a

- Rólunk

- tulajdonképpen

- alkalmazkodni

- ellen

- AI

- alberta

- azt állítja,

- Is

- an

- és a

- VANNAK

- Művészet

- művész

- Előadók

- artwork

- AS

- becsvágyó

- Helyettes

- Társult

- At

- támadás

- szerzők

- elérhető

- háttérrel

- alapvető

- Alapjövedelem

- BE

- óta

- nevében

- hogy

- Hisz

- am

- haszon

- elhomályosít

- mindkét

- határait

- márka

- tágabb

- épült

- vállalkozások

- de

- by

- hívott

- TUD

- elfog

- eset

- CAT

- óvatosság

- Változások

- Chicago

- követelés

- zárt

- CO

- kombinált

- jutalékok

- társ

- számítógép

- Computer Science

- koncepció

- Fontolja

- tartalom

- tartalomkészítők

- tartalomtulajdonosok

- Hűvös

- példányban

- copyright

- teremt

- alkotók

- cs

- dátum

- védekező

- körülír

- fejlett

- különböző

- Diffusion

- irányelvek

- do

- nem

- Kutya

- e

- minden

- biztosítására

- Eter (ETH)

- példa

- Szemek

- Kudarc

- február

- mező

- Fájlok

- cégek

- vezetéknév

- Hal

- lakás

- A

- önként

- ból ből

- generáló

- szerzés

- Ad

- Pillantás

- fű

- Zöld

- káros

- Aratás

- Legyen

- segített

- HTML

- HTTPS

- emberi

- i

- Identitás

- személyazonosság-lopás

- figyelmen kívül hagy

- kép

- képek

- Hatás

- ami fontos

- in

- Ösztönző

- tartalmaz

- Jövedelem

- magában

- megsértése

- szellemi

- szellemi tulajdon

- szándékolt

- szándékosan

- jár

- IT

- ITS

- jpg

- június

- Tart

- Címke

- nagy

- nagymértékben

- keresztnév

- Tavaly

- per

- tanulás

- Led

- kevesebb

- mint

- korlátozások

- listák

- le

- Elő/Utó

- gép

- gépi tanulás

- készült

- csinál

- Makers

- Lehet..

- eszközök

- Média

- Mid Journey

- esetleg

- millió

- minimalizálja

- visszaélés

- modell

- modellek

- a legtöbb

- kell

- Új

- bejelentés

- november

- Most

- szám

- megfigyelni

- Nyilvánvaló

- október

- of

- támadó

- felajánlott

- on

- online

- csak

- nyílt forráskódú

- optimalizálás

- or

- érdekében

- eredeti

- eredmények

- tulajdonosok

- Béke

- Papír

- rész

- különösen

- mert

- engedély

- engedély nélkül

- szedés

- Plató

- Platón adatintelligencia

- PlatoData

- méreg

- lehetséges

- erős

- jelenleg

- megakadályozása

- feldolgozott

- gyárt

- termel

- Egyetemi tanár

- program

- ingatlan

- védelme

- védelem

- ad

- pénztárca

- világítás

- elérte

- kap

- ajánlja

- felszabaduló

- reprodukció

- hírnév

- szükség

- tisztelet

- válaszok

- felelős

- kifutópálya

- s

- Mondott

- azt mondják

- elszórt

- Tudomány

- lát

- Szolgáltatások

- számos

- Shawn

- kellene

- jelentős

- jelentősen

- hasonló

- egyszerűen

- sima

- Közösség

- Közösségi média

- szoftver

- megoldások

- néhány

- különleges

- kifejezetten

- Stabilitás

- stabil

- Állami

- Diákok

- stílus

- stílusok

- beküldése

- szintetikus

- Systems

- csapat

- technikák

- hogy

- A

- lopás

- azok

- ők

- ezt

- ezen a héten

- azok

- bár?

- Keresztül

- időszerű

- nak nek

- szerszám

- szerszámok

- Vonat

- kiképzett

- Képzések

- kettő

- egyetemi

- University of Chicago

- kiszámíthatatlan

- használ

- használt

- hasznos

- használó

- használ

- változat

- nagyon

- látható

- vizuális

- volt

- Út..

- háló

- hét

- Mit

- amikor

- ami

- WHO

- kit

- akinek

- kívánságait

- val vel

- nélkül

- Munka

- művek

- aggódik

- lenne

- év

- zephyrnet

- Zhao