Vous avez exécuté avec succès votre A / B tests de, a méticuleusement analysé les données et fait décisions stratégiques sur la base des résultats. Cependant, une situation déconcertante émerge alors que les résultats observés dans ces Outils de test A / B ne correspondent pas aux observations du monde réel.

Ce qui donne? Bienvenue dans le monde de la divergence entre les outils de test A/B et les observations en situation réelle. C'est une course folle où des facteurs comme variance statistique, Biais d'échantillonnage, différences contextuelles, problèmes techniques, décalage horaire, Et même régression à la moyenne peut fausser vos résultats soigneusement calculés.

Bouclez votre ceinture alors que nous plongeons dans les détails de la raison pour laquelle ces des divergences se produisent et ce que vous pouvez faire à leur sujet.

Problèmes techniques

Les outils de test A/B s'appuient sur Code JavaScript ou d'autres implémentations techniques pour affecter les utilisateurs à différentes variantes. Cependant, malgré leur robustesse, ces outils sont pas à l'abri de problèmes techniques qui peuvent avoir un impact sur la précision de leurs résultats. Par exemple, erreurs de script dans la mise en œuvre peut se produire, empêchant bon suivi des interactions des utilisateurs ou conduisant à une mauvaise affectation des utilisateurs aux variations. Ces les erreurs peuvent perturber les données processus de collecte et introduire des incohérences dans les résultats obtenus. De plus, des problèmes de compatibilité avec différents navigateurs Web or variations dans les mécanismes de mise en cache peut affecter la fonctionnalité de l'outil, potentiellement entraînant des écarts entre les observés résultats et les terres parsemées de expérience utilisateur réelle.

De plus, l'incidence de problèmes techniques peut varier en fonction du complexité du site or application en cours de test. Sites Web présentant des complexes parcours utilisateurs or contenu dynamique sont particulièrement sujets aux défis techniques qui peuvent perturber les tests A/B processus. La présence de scripts tiers or intégrations peut encore compliquer les choses, car conflits or erreurs dans ces composants peuvent interférer avec la suivi précis du comportement des utilisateurs. Ces complexités techniques soulignent l'importance de tests approfondis et d'une assurance qualité pour garantir le bon fonctionnement des Outils de test A / B et les minimiser le risque d'écarts entre les résultats des outils et la performance réelle des variations dans des scénarios réels.

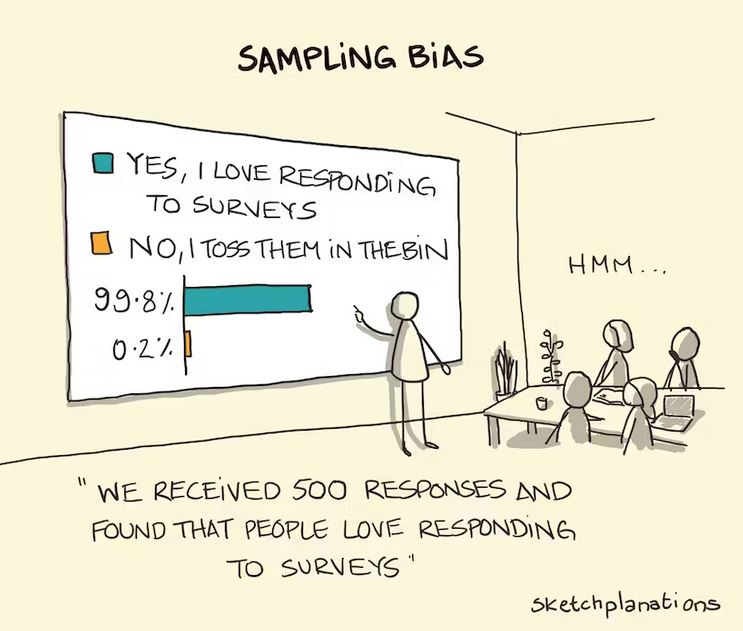

Biais d'échantillonnage

Les outils de test A/B attribuent souvent des utilisateurs à différentes variations au hasard. Cependant, en raison de la nature aléatoire de l'affectation, il peut y avoir des cas où certains segments d'utilisateurs sont disproportionnellement représenté dans une variante par rapport à une autre. Cela peut introduire biais et influer sur les résultats observé dans l'outil. Par exemple, si une variation particulière est montrée plus fréquemment aux utilisateurs qui sont déjà enclin à faire un achat, il peut gonfler artificiellement le taux de conversion pour cette variation.

De même, si un certains segments d'utilisateurs sont sous-représentés dans une variante, l'outil ne peut pas capturer leur comportement de manière adéquate, entraînant conclusions inexactes sur l'efficacité de la variation. Ce Biais d'échantillonnage peut créer un contradiction entre le les résultats obtenus des outils de test AB et des comportement réel de la base d'utilisateurs plus large.

Désalignement des délais

Outils de test A/B généralement accumuler des données sur une période déterminée pour analyser les résultats. Cependant, le moment de la collecte des données en relation avec le performance en direct de la variation peut introduire des écarts. Un problème commun est lorsque l'outil collecte des données pendant une durée plus longue que la période pendant laquelle la variation était réellement en direct. Dans de tels cas, l'outil peut par inadvertance comprendre délais supplémentaires où la performance de la variation différait de la version prévue, faussant ainsi l'analyse globale. Cela peut mener à conclusions trompeuses et les une déconnexion entre le résultats de l'outil et les terres parsemées de impact réel de la variation pendant son intervalle de temps prévu.

Inversement, il peut également y avoir des cas où la période de collecte de données de l'outil de test A/B ne parvient pas à capturer le plein effet de la variante. Si la délai de l'outil is plus courte que la période nécessaire pour que les utilisateurs s'engagent pleinement avec et répondre à la variation, les résultats peuvent ne reflète pas fidèlement la vérité performance. Cela peut se produire lorsque la variation nécessite une période d'adaptation plus longue pour que les utilisateurs adaptent leur comportement ou lorsque le l'impact de la variation se déploie progressivement au fil du temps. Dans de tels cas, l'outil peut tirer prématurément des conclusions sur l'efficacité de la variation, conduisant à une contradiction entre les résultats de l'outil et les performances réelles à long terme dans des conditions réelles.

À atténuer l'impact de décalage des délais, il est crucial de planifier soigneusement et les synchroniser la période de collecte des données des outils de test A/B avec le déploiement en direct des variantes. Cela consiste à aligner les dates de début et de fin de la phase de test avec le délai réel lorsque les variantes sont actives. De plus, compte tenu de la temps de latence potentiel pour les utilisateurs de s'adapter et de répondre aux changements peut fournir un compréhension plus complète de l'impact réel de la variation. En assurant un bon alignement des délais, les entreprises peuvent réduire le risque des écarts et faire plus précis basé sur des données décisions basées sur les résultats obtenus à partir des tests A/B.

Différence contextuelle

Les outils de test A/B fonctionnent souvent dans un environnement de test contrôlé, où les utilisateurs sont pas au courant du test et peut se comporter différemment par rapport au moment où la variation est mettre en direct dans le monde réel. Un facteur important contribuant à la divergence entre les résultats de l'outil de test et le spectacle vivant est le effet de nouveauté. Lorsque les utilisateurs rencontrer une nouvelle variation dans un environnement de test, ils peuvent manifester une curiosité accrue or fiançailles simplement parce que c'est différent de ce à quoi ils sont habitués. Ceci peut gonfler artificiellement les mesures de performance enregistrées par l'outil de test, car les utilisateurs peuvent interagir avec la variation avec plus d'enthousiasme qu'ils ne le feraient dans leurs habitudes de navigation ou d'achat habituelles.

De plus, la prise de conscience de faire partie d'une expérience peuvent influencer le comportement des utilisateurs. Lorsque les utilisateurs savent qu'ils font partie d'un processus de test, ils peuvent exhiber conscient or préjugés subconscients qui peuvent affecter leurs réponses. Ce phénomène, connu sous le nom de Hawthorne effet, se réfère à la altération du comportement en raison de la conscience d'être observé ou testé. Les utilisateurs peuvent devenir plus attentifs, gênés ou enclins à se comporter d'une manière qu'ils perçoivent comme souhaitable, ce qui pourrait fausser les résultats obtenus à partir de l'outil de test. Ce décalage entre les tests contrôlés environnement et le monde réel peut entraîner des différences dans l'engagement des utilisateurs et les taux de conversion lorsque la variation est mise en œuvre en dehors de l'environnement de test. Une personne avec un oeil vif peuvent généralement remarquer les indices subtils qui déterminent qu'ils entrent dans un test A/B.

De plus, le absence de monde réel le contexte dans l'environnement de test peut également avoir un impact sur le comportement de l'utilisateur et influencent ensuite les résultats. Dans le monde réel, les utilisateurs rencontrent des variations dans le contexte de leur vie quotidienne, qui comprend un large éventail de facteurs externes tels que contraintes de temps, distractions concurrentesou circonstances personnelles. Ces éléments contextuels peuvent influencer de manière significative la décision de l'utilisateur.Rendre le et les actes. Toutefois, Outils de test A / B souvent isoler les utilisateurs de ces influences du monde réel, en se concentrant uniquement sur la variation elle-même. Par conséquent, les résultats de l'outil peuvent ne pas capturer avec précision la façon dont les utilisateurs répondrait à la variation face à la complexité de leurs expériences quotidiennes. Cette divergence dans les facteurs contextuels peut conduire à des différences dans le comportement des utilisateurs et les les résultats entre l'outil de test et la performance en direct de la variation.

Régression à la moyenne

Dans les tests A/B, il est pas rare d'observer résultats extrêmes pour une variation pendant la phase de test. Cela peut arriver en raison de hasard aléatoire, un segment spécifique d'utilisateurs étant plus réactif à la variation, ou d'autres facteurs cela peut ne pas être vrai lorsque la variation est exposée à un public plus large et plus diversifié sur une période prolongée. Ce phénomène est connu sous le nom de régression à la moyenne.

Régression à la moyenne Se produit quand extrême or résultats aberrants observés lors des tests sont pas durable à long terme. Par exemple, si une variation montre un une augmentation significative in taux de conversion pendant la phase de test, il est possible que ce pic soit dû à un groupe spécifique d'utilisateurs particulièrement réceptifs aux changements. Cependant, lorsque la variation est mettre en direct et les exposé à un public plus large et plus diversifié, il est probable que le pic initial diminueraainsi que, les performances convergeront vers le niveau moyen ou de référence. Cela peut mener à résultats différents par rapport à ce que l'outil de test indiquait initialement, car les résultats extrêmes observés lors des tests peuvent ne pas être indicatifs de l'impact à long terme de la variation.

Comprendre l' notion de régression à la moyenne est essentielle lors de l'interprétation des résultats des tests A/B. Il souligne l'importance de ne pas compter uniquement sur la phase de test initiale résultats mais compte tenu de la performance globale de la variation sur une période plus période étendue. En considérant le potentiel de régression vers la moyenne, les entreprises peut éviter de tirer des conclusions erronées or mise en œuvre des changements à base d' pointes temporaires or creux observés pendant la phase de test. Cela souligne la nécessité d'une interprétation prudente des résultats des tests A/B et d'avoir une vision globale des performances de la variation dans le monde réel.

Conclusion

Donc, voilà. La réalité des outils d'A/B testing ne correspond pas toujours au monde réel résultats que vous rencontrez. Ce n'est pas un défaut dans vos compétences d'analyse ou un signe que les tests A/B ne sont pas fiables. C'est juste le nature de la bête.

Quand interpréter les résultats des tests A/B, il est crucial de ne pas compter uniquement sur premiers résultats mais considérez le performance globale de la variation sur une longue période. Ce faisant, les entreprises peuvent éviter de tirer des conclusions erronées or mise en œuvre des changements sur la base des pics ou creux temporaires observés pendant la phase de test.

Pour naviguer dans le fossé de la réalité, il est important d'aborder Le test A / B résultats avec un œil critique. Soyez conscient de la limites des outils et les tenir compte des contextes du monde réel. Complétez vos résultats avec d'autres méthodes de recherche pour acquérir une compréhension complète des performances de la variation. En adoptant une approche holistique, vous serez bien équipé pour prendre des décisions basées sur les données qui correspondent à la réalité de vos utilisateurs.

- Contenu propulsé par le référencement et distribution de relations publiques. Soyez amplifié aujourd'hui.

- PlatoData.Network Ai générative verticale. Autonomisez-vous. Accéder ici.

- PlatoAiStream. Intelligence Web3. Connaissance Amplifiée. Accéder ici.

- PlatonESG. Automobile / VE, Carbone, Technologie propre, Énergie, Environnement, Solaire, La gestion des déchets. Accéder ici.

- Décalages de bloc. Modernisation de la propriété des compensations environnementales. Accéder ici.

- La source: https://blog.2checkout.com/gap-between-ab-testing-tools-and-real-outcomes/

- :est

- :ne pas

- :où

- ][p

- $UP

- 32

- a

- A Propos

- AC

- précision

- avec précision

- infection

- présenter

- actually

- adapter

- adaptation

- En outre

- adéquatement

- affecter

- AG

- AI

- aligner

- aligner

- aussi

- toujours

- an

- selon une analyse de l’Université de Princeton

- il analyse

- analysé

- et les

- Une autre

- une approche

- SONT

- AS

- assurance

- public

- moyen

- AVG

- éviter

- conscients

- base

- basé

- Baseline

- BE

- car

- devenez

- va

- jusqu'à XNUMX fois

- plus large

- Parcourir

- entreprises

- mais

- by

- calculé

- CAN

- capturer

- Capturer

- prudemment

- cas

- prudent

- globaux

- Modifications

- collection

- recueille

- par rapport

- compatibilité

- complexe

- complexités

- complexité

- composants électriques

- complet

- conditions

- Considérer

- considérant

- contexte

- contextuel

- contribuant

- contrôlée

- Conversion

- engendrent

- critique

- crucial

- Tous les jours

- données

- data-driven

- décisions

- Selon

- déploiement

- Malgré

- Déterminer

- différences

- différent

- contradiction

- Perturber

- plusieurs

- Public diversifié

- do

- faire

- dessiner

- deux

- durée

- pendant

- e

- efficacité

- éléments

- émerge

- mettre en relief

- rencontre

- fin

- participation

- assurer

- assurer

- entrant

- Environment

- essential

- Ether (ETH)

- Pourtant, la

- de tous les jours

- exemple

- réalisé

- d'experience

- Expériences

- exposé

- externe

- extrême

- œil

- facteur

- facteurs

- FAIL

- défectueux

- Doté d'

- résultats

- défaut

- mettant l'accent

- Pour

- fréquemment

- De

- plein

- d’étiquettes électroniques entièrement

- fonctionnement

- plus

- Gain

- écart

- gif

- donne

- arriver

- Vous avez

- accrue

- Faits saillants

- appuyez en continu

- holistique

- Comment

- Cependant

- HTTPS

- HubSpot

- i

- if

- immunitaire

- Impact

- la mise en oeuvre

- mis en œuvre

- importance

- important

- in

- Incliné

- comprendre

- inclut

- indiqué

- indicatif

- influencer

- initiale

- possible

- instance

- prévu

- interagir

- interactions

- interférer

- l'interprétation

- développement

- introduire

- Investopedia

- vous aider à faire face aux problèmes qui vous perturbent

- IT

- SES

- jpg

- juste

- connu

- plus importantes

- conduire

- conduisant

- Niveau

- Probable

- le travail

- Vit

- Location

- long-term

- plus long

- LES PLANTES

- a prendre une

- Fabrication

- compte

- largeur maximale

- Mai..

- signifier

- méthodes

- méticuleusement

- Métrique

- pourrait

- PLUS

- Nature

- NAVIGUER

- Besoin

- Nouveauté

- Remarquer..

- observée

- obtenu

- se produire

- of

- de rabais

- souvent

- on

- ONE

- fonctionner

- or

- Autre

- les résultats

- au contrôle

- plus de

- global

- partie

- particulier

- particulièrement

- performant

- période

- personne

- phase

- phénomène

- plan

- Platon

- Intelligence des données Platon

- PlatonDonnées

- possible

- défaillances

- l'éventualité

- présence

- prévention

- processus

- correct

- fournir

- achat

- qualité

- aléatoire

- gamme

- Tarif

- Tarifs

- clients

- réal

- monde réel

- Réalité

- enregistré

- se réfère

- refléter

- régression

- Standard

- rapport

- compter

- s'appuyer

- représenté

- a besoin

- un article

- Réagir

- réponses

- résultat

- Résultats

- Rouler

- robuste

- Courir

- s

- scénarios

- But

- clignotant

- segments

- Shorts

- montré

- Spectacles

- signer

- de façon significative

- situation

- compétences

- So

- uniquement

- sophistiqué

- groupe de neurones

- spécifié

- épi

- pointes

- Commencer

- statistique

- Avec succès

- tel

- complément

- prend

- prise

- Technique

- temporaire

- tester

- examiné

- Essais

- que

- qui

- Le

- le monde

- leur

- Les

- Là.

- Ces

- l'ont

- this

- ceux

- fiable

- calendrier

- à

- outil

- les outils

- vers

- Tracking

- oui

- typiquement

- Rare

- soulignés

- compréhension

- Utilisateur

- Expérience utilisateur

- utilisateurs

- Voir

- votes

- W

- était

- façons

- we

- web

- sites Internet

- bienvenu

- ont été

- Quoi

- quand

- qui

- WHO

- why

- large

- Large gamme

- Wikipédia

- Sauvage

- sera

- comprenant

- dans les

- world

- pourra

- X

- you

- Votre

- zéphyrnet