Suresh est un responsable technologique possédant une expertise technique approfondie dans les semi-conducteurs, l'intelligence artificielle, la cybersécurité, l'Internet des objets, le matériel, les logiciels, etc. Il a passé 20 ans dans l'industrie, plus récemment en tant que directeur exécutif pour l'open source zéro- développement de puces de confiance au Technology Innovation Institute d'Abu Dhabi et dans d'autres sociétés de semi-conducteurs Fortune 500 telles qu'Intel, Qualcomm et MediaTek dans divers rôles de direction, où il a recherché et développé des technologies hautement performantes, économes en énergie, sécurisées post-quantiques et sûres. micropuces/systèmes sur puces (SoC)/accélérateurs pour les marchés des centres de données, des clients, des smartphones, des réseaux, de l'IoT et de l'IA/ML. Il a contribué au Falcon LLM (classé n°1 en huggingface) et a été l'architecte principal de la plate-forme matérielle d'IA personnalisée (annulée – les priorités ont changé). Il détient plus de 15 brevets américains et a publié/présenté plus de 20 conférences.

Suresh est un responsable technologique possédant une expertise technique approfondie dans les semi-conducteurs, l'intelligence artificielle, la cybersécurité, l'Internet des objets, le matériel, les logiciels, etc. Il a passé 20 ans dans l'industrie, plus récemment en tant que directeur exécutif pour l'open source zéro- développement de puces de confiance au Technology Innovation Institute d'Abu Dhabi et dans d'autres sociétés de semi-conducteurs Fortune 500 telles qu'Intel, Qualcomm et MediaTek dans divers rôles de direction, où il a recherché et développé des technologies hautement performantes, économes en énergie, sécurisées post-quantiques et sûres. micropuces/systèmes sur puces (SoC)/accélérateurs pour les marchés des centres de données, des clients, des smartphones, des réseaux, de l'IoT et de l'IA/ML. Il a contribué au Falcon LLM (classé n°1 en huggingface) et a été l'architecte principal de la plate-forme matérielle d'IA personnalisée (annulée – les priorités ont changé). Il détient plus de 15 brevets américains et a publié/présenté plus de 20 conférences.

Suresh occupe également activement un poste de direction chez RISC-V International où il préside le Trusted Computing Group pour développer la capacité informatique confidentielle RISC-V et préside le groupe AI/ML pour développer l'accélération matérielle RISC-V pour les charges de travail AI/ML telles que Transformer les grands modèles de langage utilisés dans les applications de type ChatGPT. Il conseille également des startups et des sociétés de capital-risque sur l'aide à la décision d'investissement, la stratégie produit, la due diligence technologique, etc.

Il est titulaire d'un MBA de l'INSEAD, d'un MS du Birla Institute of Technology & Science Pilani, d'un certificat d'ingénierie des systèmes du MIT, d'un certificat d'IA de Stanford et d'un certificat de sécurité fonctionnelle automobile du TÜV SÜD.

Parlez-nous de votre société

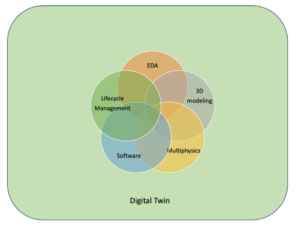

"Mastiṣka AI» (Mastiṣka signifie Cerveau en sanskrit) est une société d'IA axée sur la construction d'ordinateurs de type cerveau pour exécuter plus efficacement des modèles de base pour les cas d'utilisation de l'IA générative de demain.

Quels problèmes résolvez-vous ?

Compte tenu des avantages de l’IA/GenAI, sa demande ne fera qu’augmenter, tout comme ses effets secondaires sur notre planète. Comment réduire ou neutraliser les effets secondaires de l’IA sur notre planète ? Le captage du carbone et l’énergie nucléaire vont dans la bonne direction. Mais nous devons fondamentalement repenser la façon dont nous faisons de l’IA : est-ce la mauvaise façon de faire des tonnes de multiplications matricielles ?

Notre cerveau peut apprendre et effectuer de nombreuses tâches en parallèle, avec une consommation inférieure ou égale à 10 W, mais pourquoi ces systèmes d'IA consomment-ils des dizaines de mégawatts pour entraîner des modèles ?

Peut-être que l'avenir nous réserve des architectures économes en énergie telles que des architectures neuromorphiques et des transformateurs basés sur des réseaux neuronaux qui sont les plus proches du cerveau humain, qui pourraient consommer 100 à 1000 XNUMX fois moins d'énergie, réduisant ainsi le coût d'utilisation de l'IA, la démocratisant ainsi et économisant notre énergie. planète.

Les défis actuels auxquels nous sommes confrontés avec l'IA, à savoir a) la disponibilité, b) l'accessibilité, c) l'abordabilité et d) la sécurité environnementale, ainsi que quelques recommandations pour les relever.

Si nous prévoyons dans le futur, certains concepts AGI utiles sont démontrés dans le film « HER », où le personnage « Samantha » – un agent conversationnel qui est naturel, comprend les émotions, fait preuve d'empathie, est un copilote incroyable au travail – et court appareils portables toute la journée, nous devrons peut-être relever les défis ci-dessous dès maintenant.

Problème 1 : La formation d'un LLM peut coûter entre 150 10 et plus de 10 millions de dollars, et elle permet uniquement à ceux qui ont les moyens les plus riches de développer l'IA. De plus, les coûts d'inférence sont également énormes (coûtent XNUMX fois plus qu'une recherche sur le Web)

—> Nous devons améliorer l'efficacité énergétique des modèles/matériels pour démocratiser l'IA au profit de l'humanité.

Problème 2 : L'exécution de gigantesques modèles d'IA pour des agents conversationnels ou des systèmes de recommandation a un impact négatif sur l'environnement en termes de consommation d'électricité et de refroidissement.

—> Nous devons améliorer l'efficacité énergétique des modèles/matériel pour sauver notre planète pour nos enfants.

Problème 3 : Le cerveau humain est capable d’effectuer plusieurs tâches à la fois, mais ne consomme que 10 watts au lieu de mégawatts.

-> Peut-être devrions-nous construire plus rapidement des machines comme notre cerveau et non les multiplicateurs matriciels habituels.

L’humanité ne peut prospérer qu’avec des innovations durables, et non en abattant toutes les forêts et en faisant bouillir les océans au nom de l’innovation. Nous devons protéger notre planète pour le bien-être de nos enfants et des générations futures…

Quels sont vos domaines d'application les plus forts ?

Formation et inférence de modèles de base basés sur un transformateur (et la future architecture neuronale), avec une efficacité énergétique 50 à 100 fois supérieure à celle des solutions basées sur GPU actuelles.

Qu'est-ce qui empêche vos clients de dormir la nuit ?

Problèmes pour les clients qui utilisent actuellement d'autres produits :

La consommation d'électricité pour la formation d'énormes modèles de langage dépasse le toit, par exemple, la formation d'un LLM de 13 B de paramètres sur 390 B de jetons de texte sur 200 GPU pendant 7 jours coûte 151,744 XNUMX $ (Source : nouvelle page de service de cluster de formation HuggingFace – https://lnkd.in/g6Vc5cz3). Et des modèles encore plus grands avec plus de 100 paramètres B coûtent 10 millions de dollars rien que pour s'entraîner. Payez ensuite pour l'inférence à chaque fois qu'une nouvelle demande d'invite arrive.

Consommation d'eau pour le refroidissement, des chercheurs de l'Université de Californie à Riverside ont estimé l'impact environnemental d'un service de type ChatGPT et affirment qu'il engloutit 500 millilitres d'eau (près de ce qu'il y a dans une bouteille d'eau de 16 onces) chaque fois que vous lui demandez un série de 5 à 50 invites ou questions. La gamme varie en fonction de la localisation de ses serveurs et de la saison. L'estimation inclut la consommation indirecte d'eau que les entreprises ne mesurent pas, par exemple pour refroidir les centrales électriques qui alimentent les centres de données en électricité. (Source: https://lnkd.in/gybcxX8C)

Problèmes pour les non-clients des produits actuels :

Je ne peux pas me permettre d'acheter du matériel

Je ne peux pas me permettre d'utiliser les services cloud

Impossible d’innover ou de tirer parti de l’IA – coincé avec un modèle de services qui élimine tout avantage concurrentiel

À quoi ressemble le paysage concurrentiel et comment vous différenciez-vous ?

- Les GPU dominent l'espace de formation, même si les ASIC spécialisés sont également en concurrence sur ce segment

- L'inférence Cloud & Edge a trop d'options disponibles

Numérique, analogique, photonique – vous l’appelez, les gens essaient de s’attaquer au même problème.

Pouvez-vous partager vos réflexions sur l’état actuel de l’architecture des puces pour l’IA/ML, c’est-à-dire quelles sont, selon vous, les tendances et opportunités les plus importantes à l’heure actuelle ?

Tendances suivantes :

Tendance 1: Il y a 10 ans, l'apprentissage profond basé sur le matériel prospérait, et aujourd'hui, ce même matériel freine le progrès. En raison du coût énorme du matériel et des coûts d’électricité nécessaires au fonctionnement des modèles, il est devenu difficile d’accéder au matériel. Seules les entreprises aux poches profondes peuvent se le permettre et deviennent des monopoles.

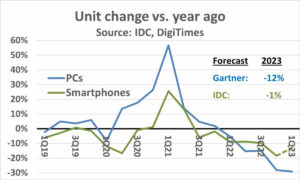

Tendance 2: Maintenant que ces modèles existent, nous devons les utiliser à des fins pratiques afin que la charge d'inférence augmente, permettant ainsi aux processeurs dotés d'accélérateurs d'IA de revenir sous le feu des projecteurs.

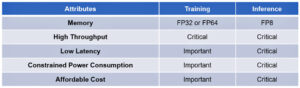

Tendance 3: Les startups tentent de proposer des représentations alternatives de nombres à virgule flottante selon lesquelles le format IEEE traditionnel – tel que logarithmique et basé sur les positifs – est bon mais pas suffisant. L'optimisation de l'espace de conception PPA$ explose lorsque nous essayons d'optimiser l'un et l'autre se lance.

Tendance 4: L'industrie s'éloigne du modèle d'IA basé sur les services pour héberger ses propres modèles privés dans ses propres locaux – mais l'accès au matériel est un défi en raison des pénuries d'approvisionnement, des sanctions, etc.

Situation actuelle :

La disponibilité du matériel et des données a alimenté la croissance de l'IA il y a 10 ans, aujourd'hui, le même matériel la freine en quelque sorte - laissez-moi vous expliquer

Depuis que les processeurs se portent mal et que les GPU ont été réutilisés pour faire de l'IA, beaucoup de choses se sont passées

Les entreprises ont abordé 4 segments de l'IA/ML, à savoir : 1) la formation cloud, 2) l'inférence cloud, 3) l'inférence Edge et 4) la formation Edge (apprentissage fédéré pour les applications sensibles à la confidentialité).

Numérique et analogique

Côté formation – une pléthore d'entreprises fabriquant des GPU, des accélérateurs clients basés sur RISC-V, des puces à l'échelle d'une tranche (850 XNUMX cœurs), etc. là où les processeurs traditionnels manquent (leur usage général). Côté inférence – Les accélérateurs NN sont disponibles auprès de tous les fabricants, dans les smartphones, les ordinateurs portables et autres appareils de pointe.

Des architectures analogiques basées sur des memristors sont également apparues il y a quelque temps.

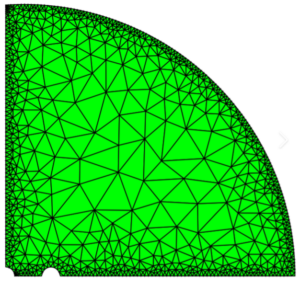

Nous pensons que les processeurs peuvent être très efficaces en matière d'inférence si nous les améliorons avec des accélérations telles que des extensions matricielles.

Côté RISC-V :

Du côté RISC-V, nous développons des accélérateurs pour les opérations matricielles et autres opérations non linéaires afin d'éliminer les éventuels goulots d'étranglement pour les charges de travail des transformateurs. Les goulots d'étranglement de Von Neumann sont également résolus en concevant des mémoires plus proches de l'informatique, faisant finalement des processeurs dotés d'une accélération de l'IA le bon choix pour l'inférence.

Opportunités:

Des opportunités uniques existent pour combler le marché des modèles de fondations. Exemple – OpenAI a mentionné qu'il n'était pas en mesure de sécuriser suffisamment de calculs d'IA (GPU) pour continuer à proposer ses services ChatGPT… et les informations rapportent des coûts d'électricité 10 fois supérieurs à ceux d'une recherche Internet régulière et 500 ml d'eau pour refroidir les systèmes. pour chaque requête. Il y a un marché à combler ici – ce n’est pas une niche, mais c’est le marché tout entier qui démocratisera l’IA en relevant tous les défis mentionnés ci-dessus – a) disponibilité, b) accessibilité, c) prix abordable et d) sécurité environnementale.

Sur quelles nouvelles fonctionnalités/technologies travaillez-vous ?

Nous construisons un cerveau comme un ordinateur en tirant parti des techniques neuromodrphiques et en adaptant des modèles pour tirer parti du matériel économe en énergie, en réutilisant la plupart des cadres ouverts disponibles.

Comment envisagez-vous la croissance ou l’évolution du secteur de l’IA/ML au cours des 12 à 18 prochains mois ?

Alors que la demande de GPU s'est détériorée (coûtant environ 30 XNUMX $) et que certaines régions du monde sont confrontées à des sanctions pour acheter ces GPU, certaines régions du monde se sentent figées dans la recherche et le développement de l'IA sans accès aux GPU. Les plates-formes matérielles alternatives vont conquérir le marché.

Les modèles commenceront peut-être à rétrécir – les modèles personnalisés ou même fondamentalement, la densité de l'information augmenterait

Même question, mais qu’en est-il de la croissance et du changement dans les 3 à 5 prochaines années ?

a) Les processeurs dotés d'extensions IA captureraient le marché de l'inférence IA

b) Les modèles deviendraient agiles et les paramètres disparaîtraient à mesure que la densité de l'information passerait de 16 % à 90 %

c) L'efficacité énergétique s'améliore, l'empreinte CO2 diminue

d) De nouvelles architectures apparaissent

e) les coûts du matériel et de l'énergie diminuent, de sorte que la barrière à l'entrée pour les petites entreprises souhaitant créer et former des modèles devient abordable

f) les gens parlent du moment pré-AGI, mais ma référence serait le personnage de Samantha (IA conversationnelle) dans le film "elle".. ce qui est peut-être peu probable étant donné le coût élevé de la mise à l'échelle

Quels sont certains des défis qui pourraient avoir un impact ou limiter la croissance du secteur de l’IA/ML ?

a) Accès au matériel

b) Coûts énergétiques et coûts de refroidissement et dommages environnementaux

Lisez aussi:

Entretien avec le PDG : David Moore de Pragmatic

Interview du PDG : Dr Meghali Chopra de Sandbox Semiconductor

- Contenu propulsé par le référencement et distribution de relations publiques. Soyez amplifié aujourd'hui.

- PlatoData.Network Ai générative verticale. Autonomisez-vous. Accéder ici.

- PlatoAiStream. Intelligence Web3. Connaissance Amplifiée. Accéder ici.

- PlatonESG. Carbone, Technologie propre, Énergie, Environnement, Solaire, La gestion des déchets. Accéder ici.

- PlatoHealth. Veille biotechnologique et essais cliniques. Accéder ici.

- La source: https://semiwiki.com/ceo-interviews/338703-ceo-interview-suresh-sugumar-of-mastiska-ai/

- :possède

- :est

- :ne pas

- :où

- $UP

- 1

- 10

- 150

- 20

- 20 ans

- 200

- 50

- 500

- 7

- a

- Capable

- A Propos

- au dessus de

- abu dhabi

- accélération

- accélérateurs

- accès

- accessibilité

- activement

- propos

- adressé

- adresser

- Avantage

- Affaires

- encore

- Agent

- agents

- AGI

- depuis

- AI

- Modèles AI

- recherche ai

- Systèmes d'IA

- cas d'utilisation de l'IA

- AI / ML

- aligné

- Tous

- Permettre

- permet

- le long de

- aussi

- alternative

- incroyable

- an

- ainsi que

- Une autre

- tous

- de n'importe où

- Application

- applications

- architecture

- SONT

- domaines

- Arrive

- artificiel

- intelligence artificielle

- AS

- Asics

- demander

- At

- l'automobile

- disponibilité

- disponibles

- et

- b

- une barrière

- basé

- BE

- devenez

- devient

- devenir

- était

- va

- CROYONS

- ci-dessous

- référence

- profiter

- avantages.

- jusqu'à XNUMX fois

- Au-delà

- goulets d'étranglement

- lié

- Cerveau

- cerveaux

- construire

- Développement

- mais

- acheter

- by

- Californie

- CAN

- annulé

- aptitude

- capable

- capital

- capturer

- carbone

- la capture du carbone

- cas

- Centres

- CEO

- Entretien avec le PDG

- certificat

- challenge

- globaux

- Change

- modifié

- en changeant

- caractère

- ChatGPT

- Enfants

- puce

- chips

- le choix

- Chopra

- client

- Fermer

- plus

- le cloud

- Grappe

- co2

- comment

- Sociétés

- Société

- par rapport

- rivaliser

- compétitif

- calcul

- ordinateur

- ordinateurs

- informatique

- concepts

- conférences

- consommer

- consommation

- continuer

- contribué

- de la conversation

- IA conversationnel

- Freddi

- Prix

- Costs

- pourriez

- engendrent

- Courant

- État actuel

- Lecture

- Customiser

- des clients

- Clients

- Coupe

- Cybersécurité

- données

- les centres de données

- Datacenter

- David

- journée

- jours

- décision

- profond

- l'apprentissage en profondeur

- profond

- Demande

- démocratiser

- Démocratiser

- démontré

- densité

- Selon

- Conception

- développer

- développé

- développement

- Développement

- Compatibles

- Dhabi

- différencier

- diligence

- direction

- Directeur

- do

- faire

- dollars

- Ne pas

- down

- dr

- Goutte

- deux

- Notre expertise

- Edge

- les effets

- efficace

- efficace

- efficacement

- électricité

- la consommation d'électricité

- éliminé

- élimine

- émotions

- Empathie

- énergie

- l'efficacité énergétique

- ENGINEERING

- de renforcer

- assez

- Tout

- entrée

- Environment

- environnementales

- envisager

- estimation

- estimé

- etc

- Ether (ETH)

- Pourtant, la

- faire une éventuelle

- Chaque

- exemple

- exécutif

- Directeur exécutif

- exister

- nous a permis de concevoir

- Explose

- extensions

- Visage

- faucon

- plus rapide

- sentiment

- remplir

- entreprises

- flottant

- concentré

- Pied

- Pour

- prévoir

- le format

- fortune

- Fondation

- cadres

- De

- gelé

- alimenté

- fonctionnel

- fondamentalement

- avenir

- Général

- Les générations

- génératif

- IA générative

- donné

- Go

- Goes

- aller

- Bien

- GPU

- Réservation de groupe

- Croissance

- Croissance

- Matériel

- Vous avez

- he

- d'où

- ici

- Haute

- détient

- hébergement

- Comment

- HTTPS

- majeur

- Étreindre

- humain

- Humanité

- IEEE

- if

- image

- Impact

- améliorer

- améliore

- in

- Dans d'autres

- inclut

- Améliore

- industrie

- d'information

- innovons

- Innovation

- innovations

- plutôt ;

- Institut

- Intel

- Intelligence

- International

- Internet

- Interview

- un investissement

- IOT

- IT

- SES

- juste

- enfants

- Genre

- Peindre

- paysage d'été

- langue

- ordinateurs portables

- gros

- plus importantes

- conduire

- Leadership

- APPRENTISSAGE

- apprentissage

- laisser

- Levier

- en tirant parti

- comme

- feux de la rampe

- LIMIT

- charge

- situé

- Style

- ressembler

- baisser

- Les machines

- Fabrication

- Fabricants

- de nombreuses

- Marché

- Marchés

- Matrice

- largeur maximale

- Mai..

- peut être

- MBA

- me

- sens

- veux dire

- mesurer

- Souvenirs

- mentionné

- pourrait

- million

- million de dollars

- MIT

- modèle

- numériques jumeaux (digital twin models)

- moment

- monopoles

- mois

- PLUS

- (en fait, presque toutes)

- film

- en mouvement

- MS

- must

- my

- prénom

- à savoir

- Nature

- Besoin

- basé sur le réseau

- de mise en réseau

- Neural

- Nouveauté

- nouvelles

- next

- niche

- nuit

- agile

- maintenant

- nucléaire

- Pouvoir nucléaire

- nombre

- océans

- of

- on

- ONE

- uniquement

- ouvert

- open source

- OpenAI

- Opérations

- Opportunités

- à mettre en œuvre pour gérer une entreprise rentable. Ce guide est basé sur trois décennies d'expérience

- Optimiser

- Options

- or

- Autre

- nos

- ande

- propre

- page

- Parallèle

- paramètre

- paramètres

- les pièces

- Brevets

- Payer

- Personnes

- être

- planète

- plantes

- plateforme

- Plateformes

- Platon

- Intelligence des données Platon

- PlatonDonnées

- pléthore

- plus

- les poches

- Point

- position

- possible

- power

- centrales

- Méthode

- Imprimé

- Privé

- Problème

- d'ouvrabilité

- Produit

- Produits

- Profil

- Progrès

- instructions

- protéger

- but

- des fins

- Push

- Puts

- Qualcomm

- question

- fréquemment posées

- gamme

- classé

- Lire

- récemment

- Recommandation

- recommandations

- réduire

- réduire

- Standard

- Rapports

- nécessaire

- un article

- Recherche et développement

- chercheurs

- bon

- Bord de l'eau

- rôle

- toit

- Courir

- pour le running

- fonctionne

- des

- Sécurité

- même

- Les sanctions

- tas de sable

- Épargnez

- économie

- dire

- mise à l'échelle

- Sciences

- Rechercher

- Saison

- secteur

- sécurisé

- sur le lien

- segments

- semi-conducteur

- Semi-conducteurs

- Série

- serveurs

- service

- Services

- service

- Partager

- les pénuries

- devrait

- montré

- Spectacles

- côté

- significative

- depuis

- faibles

- smartphone

- smartphones

- So

- Logiciels

- Solutions

- Résoudre

- quelques

- Identifier

- Space

- spécialisé

- dépensé

- Stanford

- Commencer

- Startups

- Région

- de Marketing

- la plus forte

- tel

- la quantité

- Support

- durable

- Système

- tacle

- s'attaquer

- adaptation

- Prenez

- discutons-en

- tâches

- Technique

- Technologie

- innovation technologique

- conditions

- texte

- que

- qui

- La

- El futuro

- les informations

- le monde

- leur

- Les

- puis

- Là.

- ainsi

- Ces

- l'ont

- des choses

- this

- ceux

- bien que?

- Prospérer

- fiable

- à

- aujourd'hui

- Tokens

- demain

- trop

- top

- mélanger

- traditionnel

- Train

- Formation

- transformateur

- transformateurs

- Trends

- confiance

- Essai

- essayer

- sous

- comprend

- université

- Université de la Californie

- improbable

- us

- Utilisation

- utilisé

- d'utiliser

- en utilisant

- divers

- entreprise

- capital-risque

- entreprise de risques capitaux

- très

- ab

- était

- Eau

- Façon..

- we

- web

- Welfare

- ont été

- Quoi

- quand

- qui

- WHO

- why

- sera

- comprenant

- sans

- activités principales

- de travail

- world

- pourra

- faux

- années

- you

- Votre

- zéphyrnet