Image par auteur

Gemini est un nouveau modèle développé par Google, et Bard redevient utilisable. Avec Gemini, il est désormais possible d'obtenir des réponses presque parfaites à vos requêtes en leur fournissant des images, de l'audio et du texte.

Dans ce tutoriel, nous découvrirons l'API Gemini et comment la configurer sur votre machine. Nous explorerons également diverses fonctions de l'API Python, notamment la génération de texte et la compréhension d'images.

GEMINI est un nouveau modèle d'IA développé grâce à la collaboration entre les équipes de Google, notamment Google Research et Google DeepMind. Il a été spécialement conçu pour être multimodal, ce qui signifie qu'il peut comprendre et travailler avec différents types de données comme le texte, le code, l'audio, les images et la vidéo.

Gemini est le modèle d'IA le plus avancé et le plus vaste développé par Google à ce jour. Il a été conçu pour être très flexible afin de pouvoir fonctionner efficacement sur une large gamme de systèmes, des centres de données aux appareils mobiles. Cela signifie qu’il a le potentiel de révolutionner la manière dont les entreprises et les développeurs peuvent créer et faire évoluer des applications d’IA.

Voici trois versions du modèle Gemini conçues pour différents cas d'utilisation :

- Gémeaux Ultra : L'IA la plus grande et la plus avancée, capable d'effectuer des tâches complexes.

- Gémeaux Pro : Un modèle équilibré qui offre de bonnes performances et évolutivité.

- Gémeaux Nano : Le plus efficace pour les appareils mobiles.

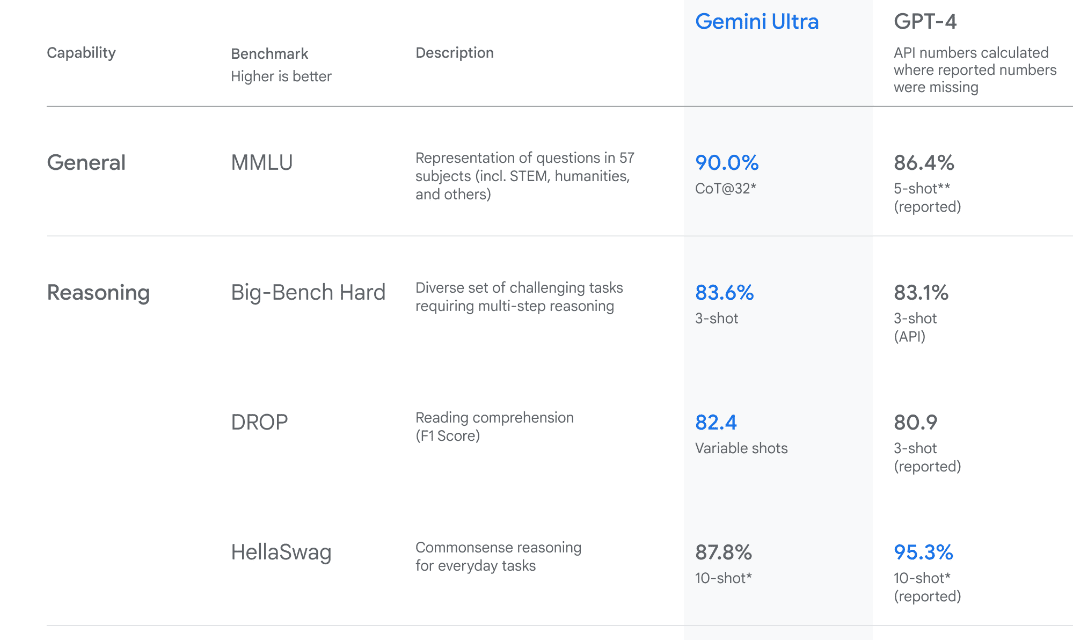

Image de Présentation des Gémeaux

Gemini Ultra offre des performances de pointe, dépassant les performances de GPT-4 sur plusieurs paramètres. Il s’agit du premier modèle à surpasser les experts humains sur le benchmark Massive Multitask Language Understanding, qui teste les connaissances du monde et la résolution de problèmes dans 57 sujets divers. Cela met en valeur ses capacités avancées de compréhension et de résolution de problèmes.

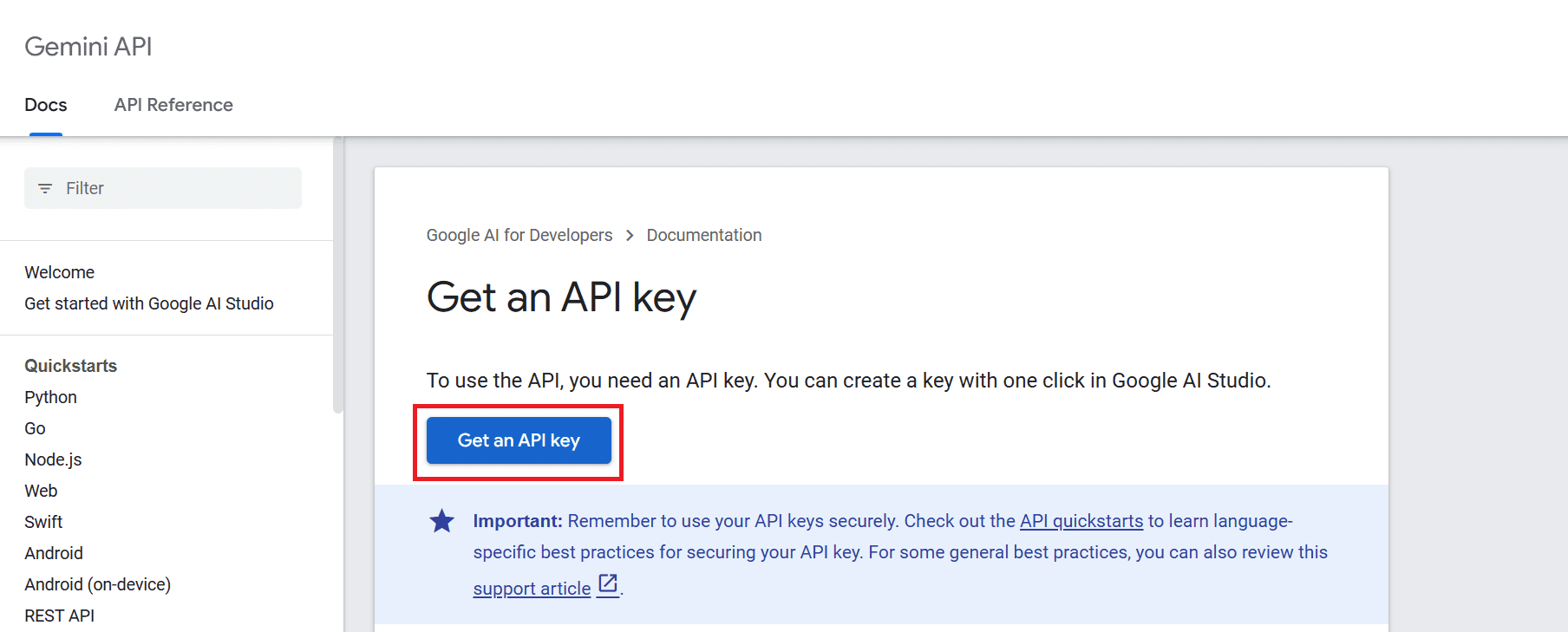

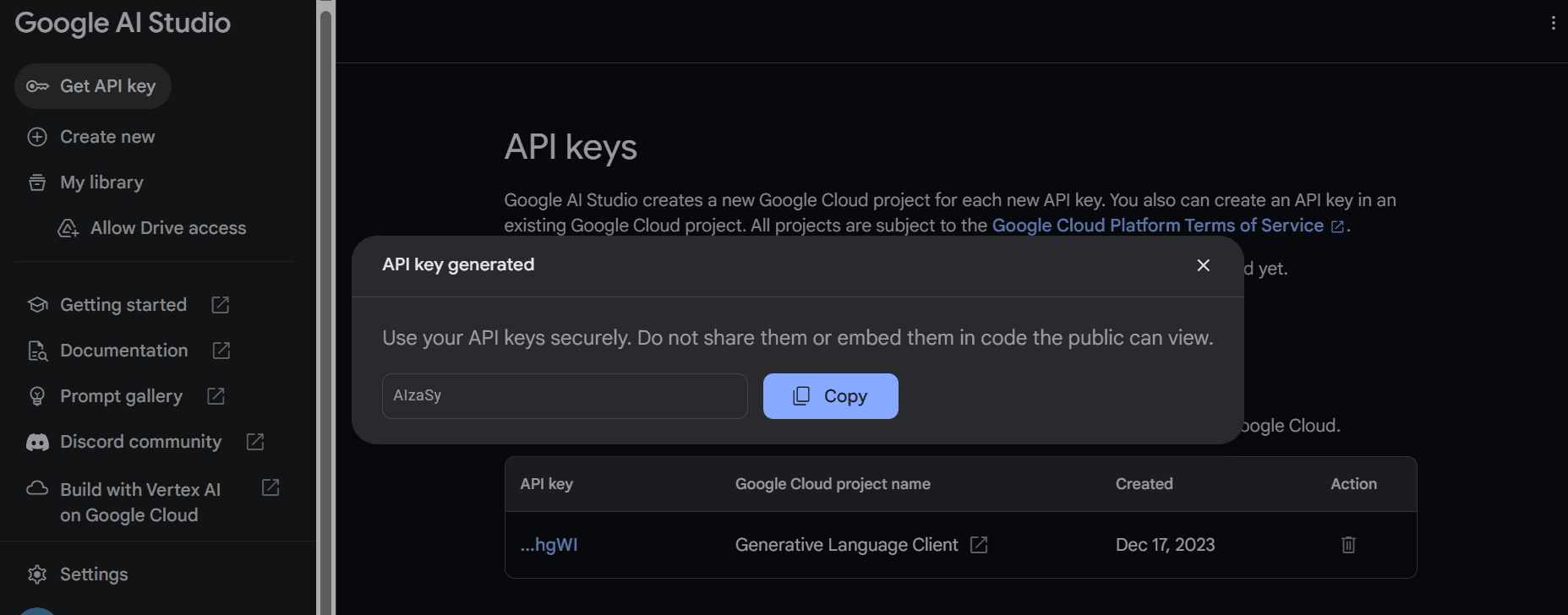

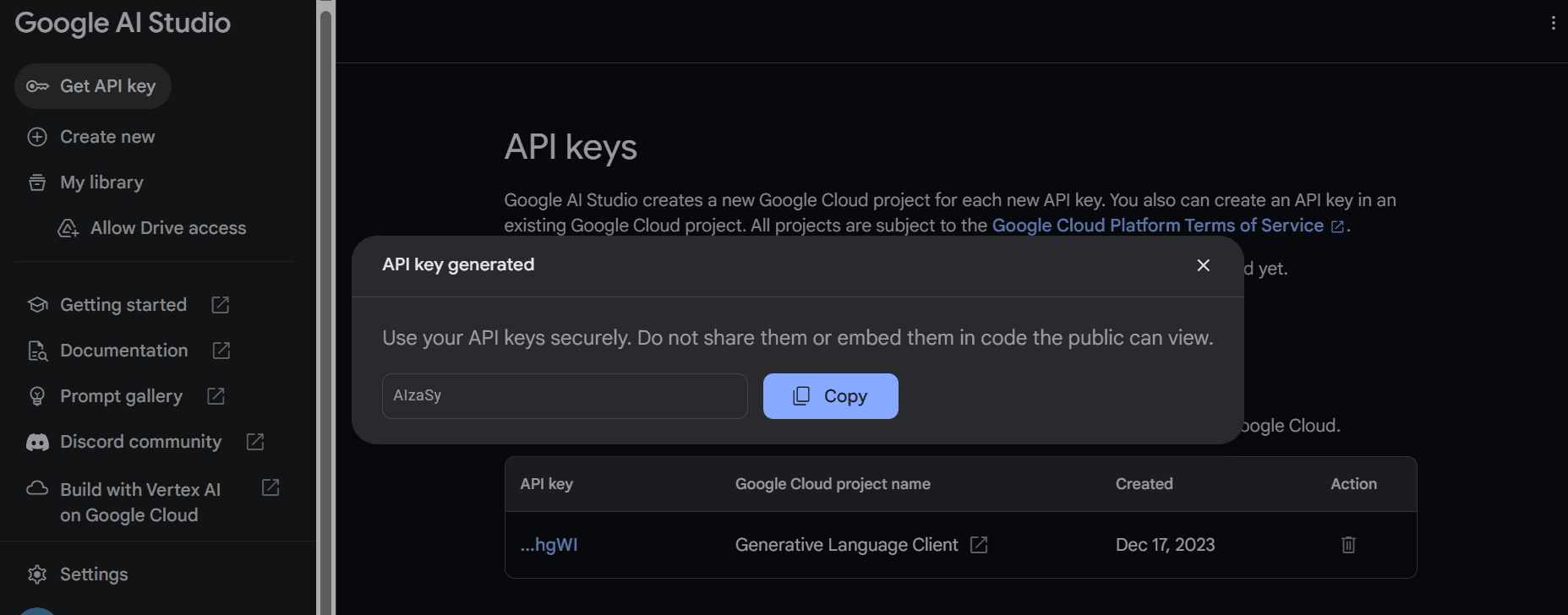

Pour utiliser l'API, nous devons d'abord obtenir une clé API que vous pouvez accéder à partir d'ici : https://ai.google.dev/tutorials/setup.

Après cela, cliquez sur le bouton « Obtenir une clé API », puis cliquez sur « Créer une clé API dans un nouveau projet ».

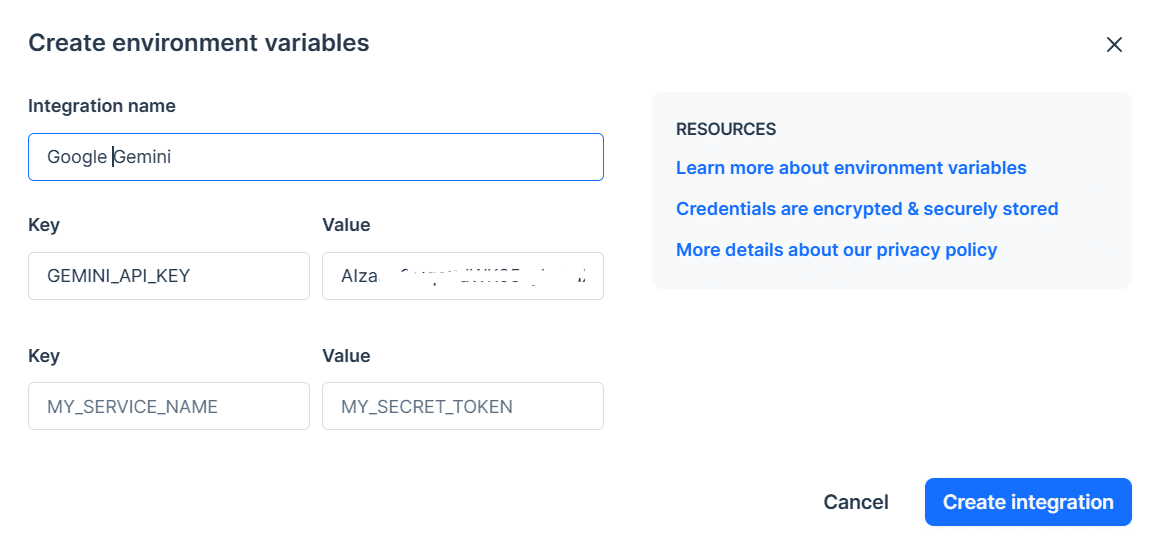

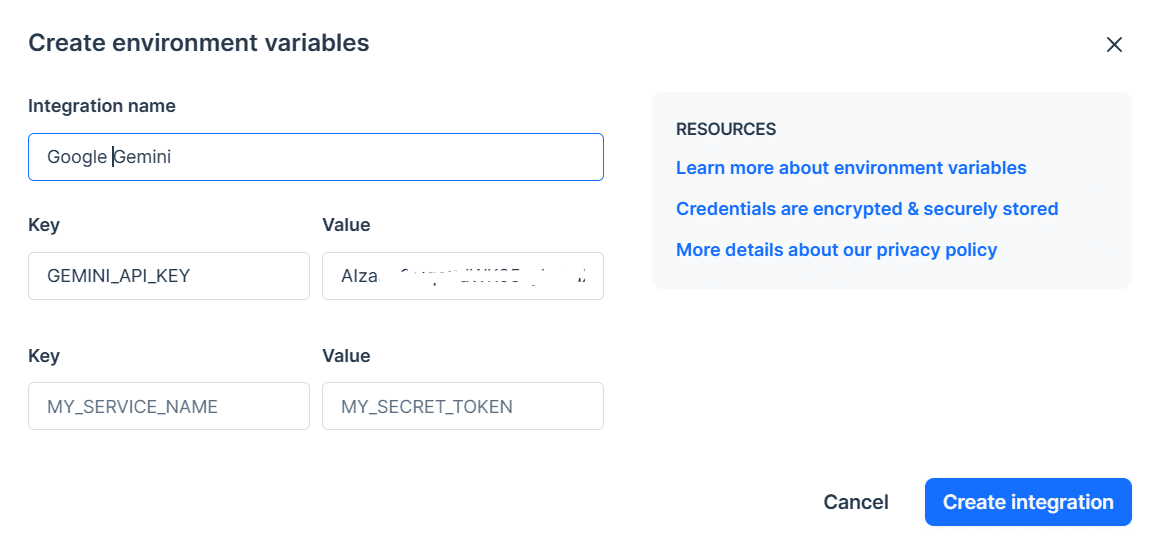

Copiez la clé API et définissez-la comme variable d'environnement. Nous utilisons Deepnote et il nous est assez simple de définir la clé avec le nom « GEMINI_API_KEY ». Accédez simplement à l'intégration, faites défiler vers le bas et sélectionnez les variables d'environnement.

Dans la prochaine étape, nous installerons l'API Python à l'aide de PIP :

pip install -q -U google-generativeaiAprès cela, nous définirons la clé API sur GenAI de Google et lancerons l’instance.

import google.generativeai as genai

import os

gemini_api_key = os.environ["GEMINI_API_KEY"]

genai.configure(api_key = gemini_api_key)Après avoir configuré la clé API, utiliser le modèle Gemini Pro pour générer du contenu est simple. Fournissez une invite à la fonction `generate_content` et affichez le résultat sous forme de Markdown.

from IPython.display import Markdown

model = genai.GenerativeModel('gemini-pro')

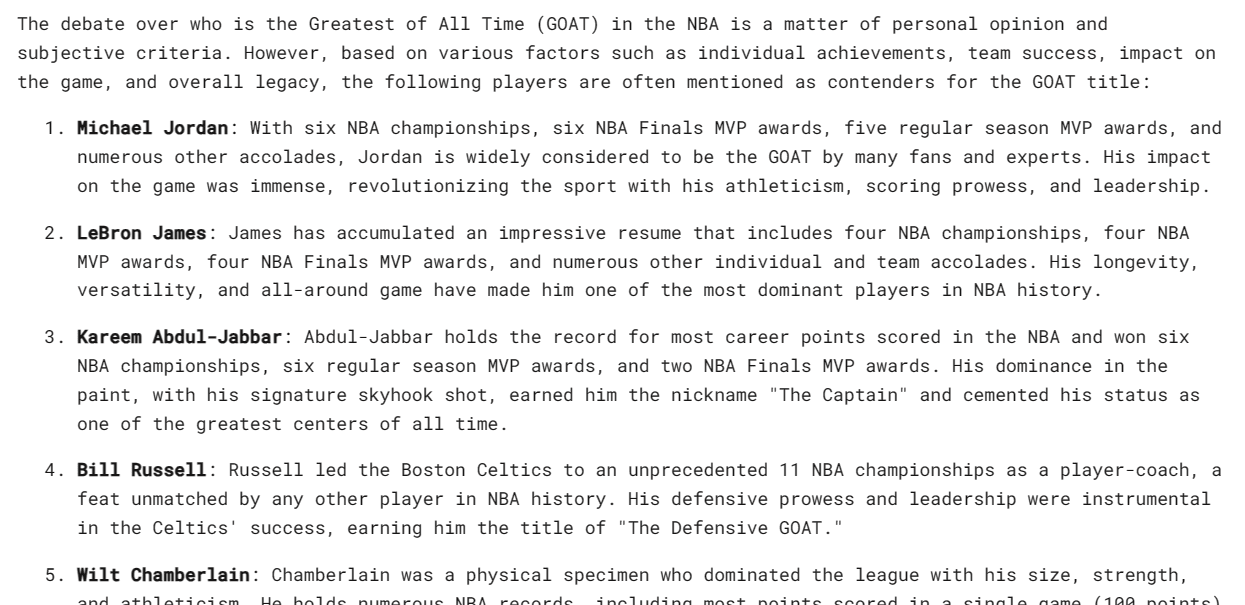

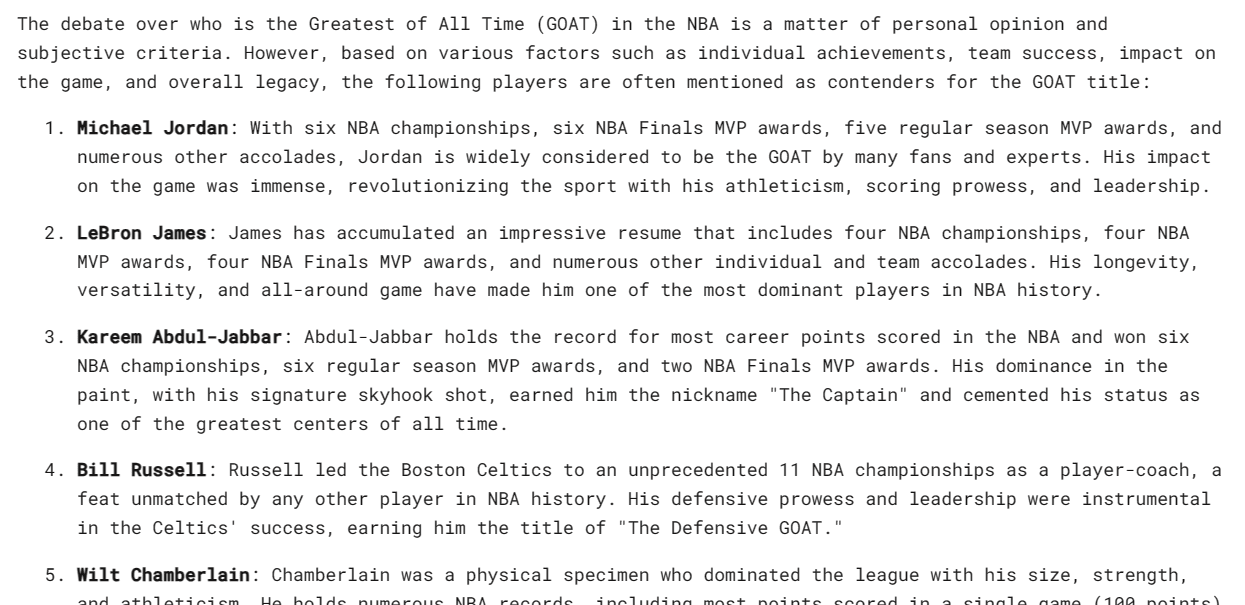

response = model.generate_content("Who is the GOAT in the NBA?")

Markdown(response.text)C'est incroyable, mais je ne suis pas d'accord avec la liste. Cependant, je comprends que tout est une question de préférence personnelle.

Gemini peut générer plusieurs réponses, appelées candidats, pour une seule invite. Vous pouvez sélectionner celui qui convient le mieux. Dans notre cas, nous n’avons eu qu’une seule réponse.

response.candidates

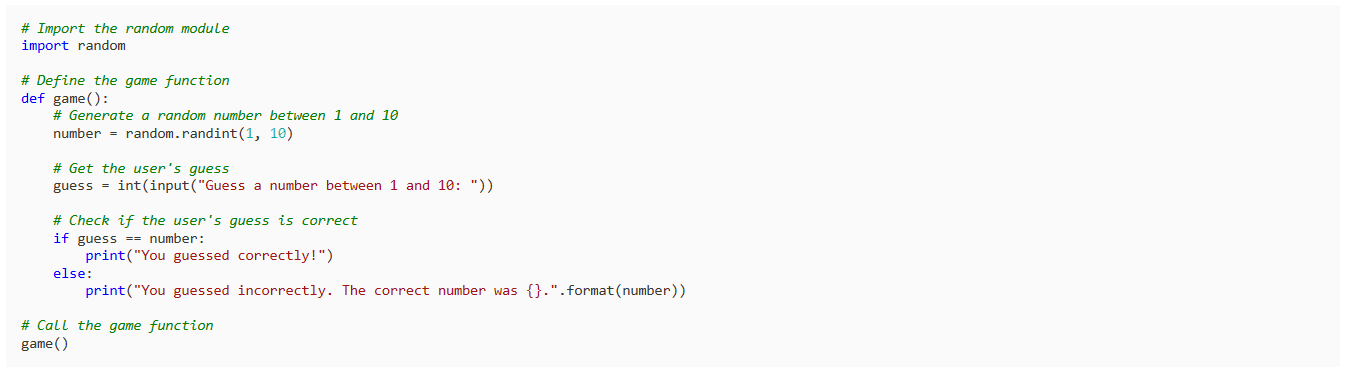

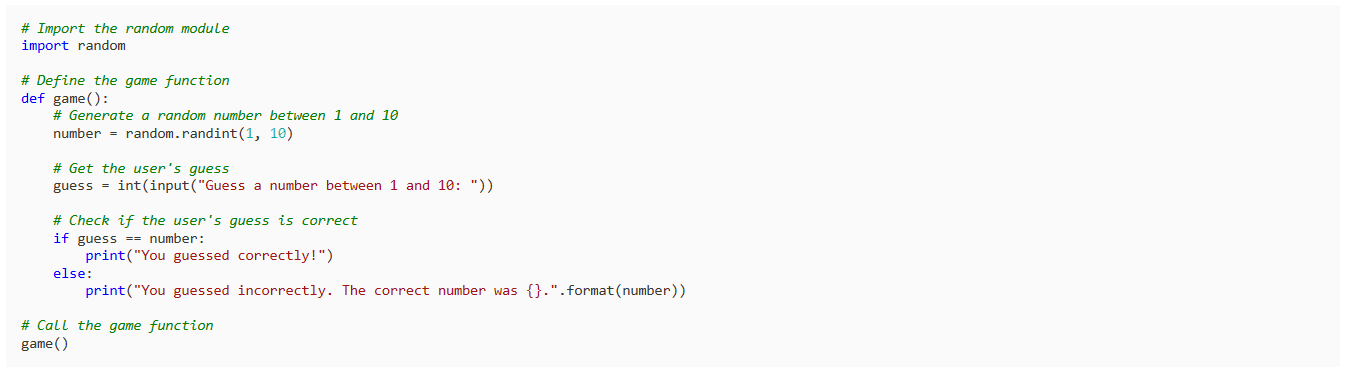

Demandons-lui d'écrire un jeu simple en Python.

response = model.generate_content("Build a simple game in Python")

Markdown(response.text)Le résultat est simple et pertinent. La plupart des LLM commencent par expliquer le code Python au lieu de l'écrire.

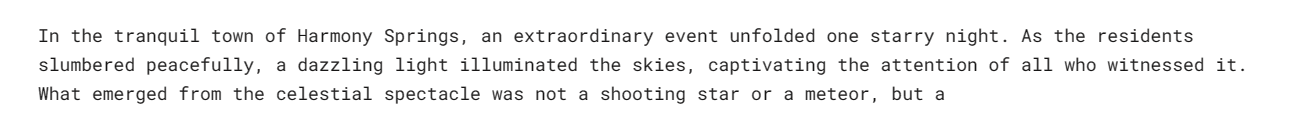

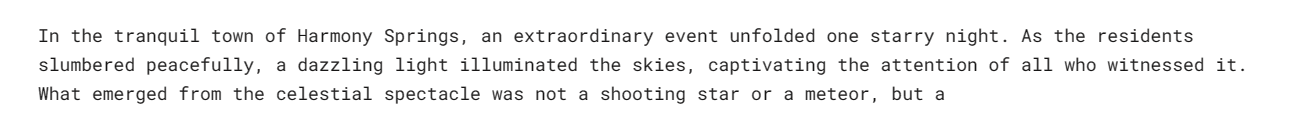

Vous pouvez personnaliser votre réponse en utilisant l'argument `Generation_config`. Nous limitons le nombre de candidats à 1, ajoutons le mot vide « espace » et définissons le nombre maximum de jetons et la température.

response = model.generate_content(

'Write a short story about aliens.',

generation_config=genai.types.GenerationConfig(

candidate_count=1,

stop_sequences=['space'],

max_output_tokens=200,

temperature=0.7)

)

Markdown(response.text)Comme vous pouvez le constater, la réponse s'est arrêtée avant le mot « espace ». Incroyable.

Vous pouvez également utiliser l'argument `stream` pour diffuser la réponse. Elle est similaire aux API Anthropic et OpenAI mais plus rapide.

model = genai.GenerativeModel('gemini-pro')

response = model.generate_content("Write a Julia function for cleaning the data.", stream=True)

for chunk in response:

print(chunk.text)

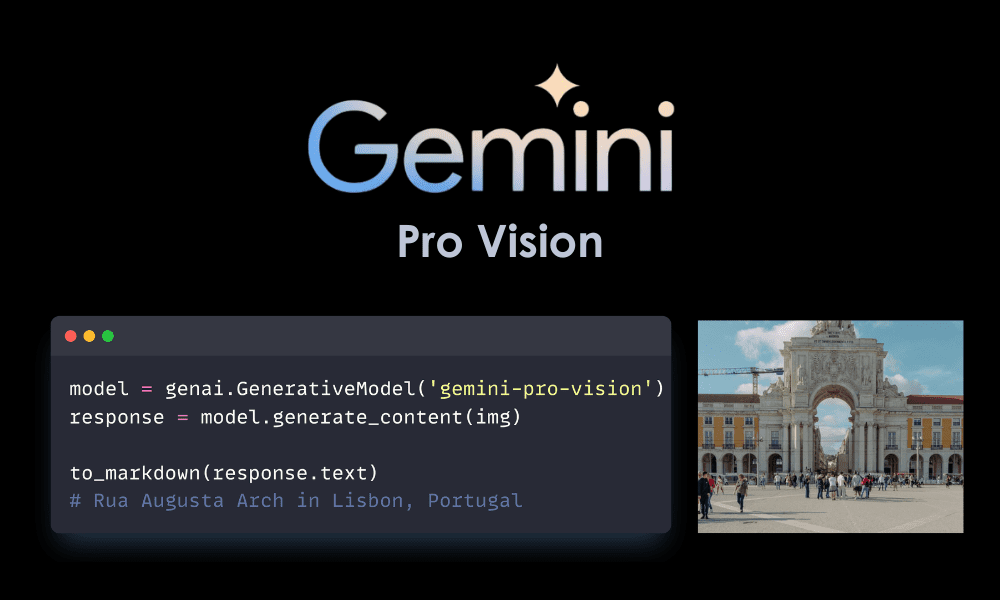

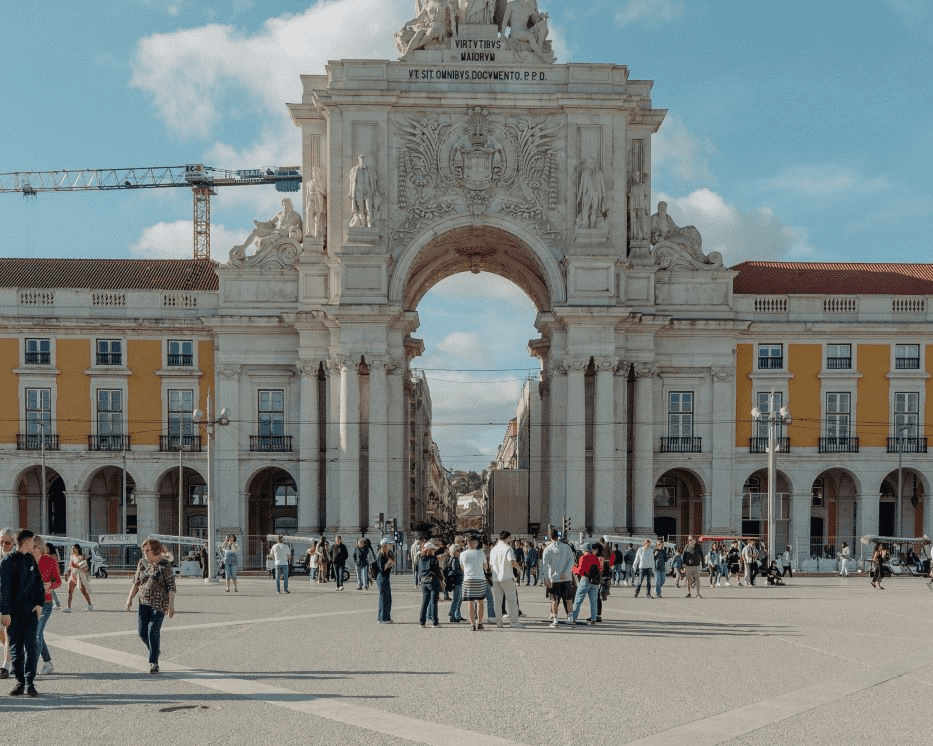

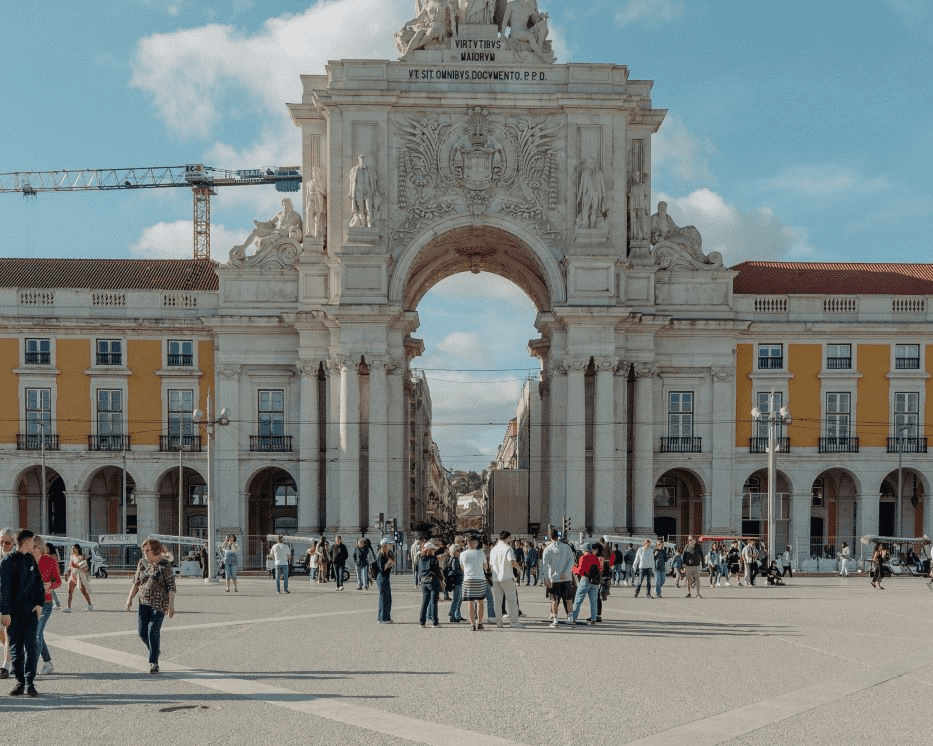

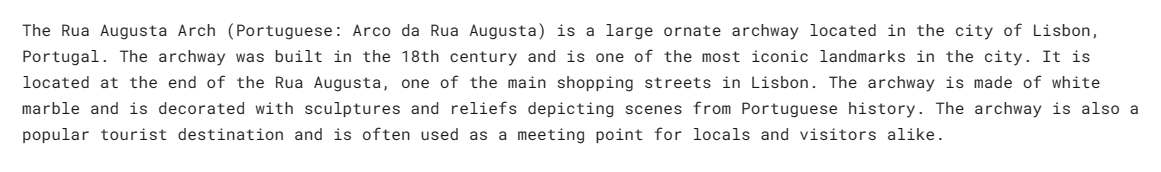

Dans cette section, nous chargerons Masood Aslami photo et utilisez-la pour tester la multimodalité de Gemini Pro Vision.

Chargez les images dans le `PIL` et affichez-le.

import PIL.Image

img = PIL.Image.open('images/photo-1.jpg')

imgNous avons une photo de haute qualité de l’arche de la Rua Augusta.

Chargeons le modèle Gemini Pro Vision et fournissons-lui l'image.

model = genai.GenerativeModel('gemini-pro-vision')

response = model.generate_content(img)

Markdown(response.text)Le modèle identifiait avec précision le palais et fournissait des informations supplémentaires sur son histoire et son architecture.

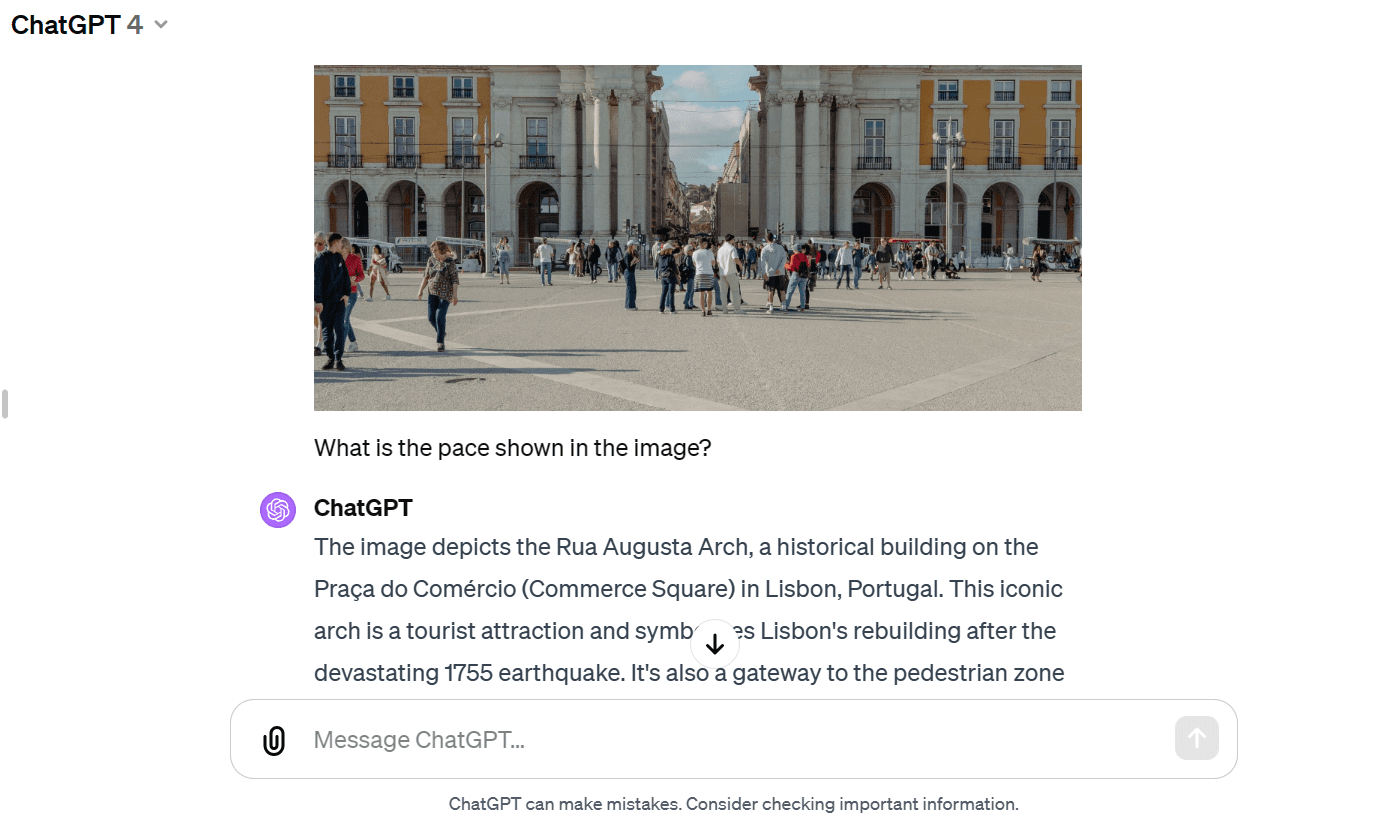

Fournissons la même image au GPT-4 et lui posons des questions sur l'image. Les deux modèles ont fourni des réponses presque similaires. Mais j'aime davantage la réponse GPT-4.

Nous allons maintenant fournir le texte et l'image à l'API. Nous avons demandé au modèle de vision d'écrire un blog de voyage en utilisant l'image comme référence.

response = model.generate_content(["Write a travel blog post using the image as reference.", img])

Markdown(response.text)Cela m'a fourni un court blog. Je m'attendais à un format plus long.

Comparé à GPT-4, le modèle Gemini Pro Vision a eu du mal à générer un blog au format long.

Nous pouvons configurer le modèle pour avoir une session de discussion aller-retour. De cette façon, le modèle se souvient du contexte et de la réponse en utilisant les conversations précédentes.

Dans notre cas, nous avons démarré la session de chat et demandé au modèle de m'aider à démarrer avec le jeu Dota 2.

model = genai.GenerativeModel('gemini-pro')

chat = model.start_chat(history=[])

chat.send_message("Can you please guide me on how to start playing Dota 2?")

chat.historyComme vous pouvez le voir, l'objet `chat` enregistre l'historique de l'utilisateur et du mode chat.

Nous pouvons également les afficher dans un style Markdown.

for message in chat.history:

display(Markdown(f'**{message.role}**: {message.parts[0].text}'))

Posons la question complémentaire.

chat.send_message("Which Dota 2 heroes should I start with?")

for message in chat.history:

display(Markdown(f'**{message.role}**: {message.parts[0].text}'))Nous pouvons faire défiler vers le bas et voir toute la session avec le modèle.

Les modèles d'intégration sont de plus en plus populaires pour les applications contextuelles. Le modèle Gemini embedding-001 permet de représenter des mots, des phrases ou des documents entiers sous forme de vecteurs denses codant pour une signification sémantique. Cette représentation vectorielle permet de comparer facilement la similarité entre différents morceaux de texte en comparant leurs vecteurs d'incorporation correspondants.

Nous pouvons fournir le contenu à `embed_content` et convertir le texte en intégrations. C'est aussi simple que ça.

output = genai.embed_content(

model="models/embedding-001",

content="Can you please guide me on how to start playing Dota 2?",

task_type="retrieval_document",

title="Embedding of Dota 2 question")

print(output['embedding'][0:10])[0.060604308, -0.023885584, -0.007826327, -0.070592545, 0.021225851, 0.043229062, 0.06876691, 0.049298503, 0.039964676, 0.08291664]Nous pouvons convertir plusieurs morceaux de texte en intégrations en passant une liste de chaînes à l'argument « contenu ».

output = genai.embed_content(

model="models/embedding-001",

content=[

"Can you please guide me on how to start playing Dota 2?",

"Which Dota 2 heroes should I start with?",

],

task_type="retrieval_document",

title="Embedding of Dota 2 question")

for emb in output['embedding']:

print(emb[:10])[0.060604308, -0.023885584, -0.007826327, -0.070592545, 0.021225851, 0.043229062, 0.06876691, 0.049298503, 0.039964676, 0.08291664]

[0.04775657, -0.044990525, -0.014886052, -0.08473655, 0.04060122, 0.035374347, 0.031866882, 0.071754575, 0.042207796, 0.04577447]Si vous rencontrez des difficultés pour reproduire le même résultat, consultez mon Espace de travail Deepnote.

Il existe de nombreuses fonctions avancées que nous n’avons pas abordées dans ce didacticiel d’introduction. Vous pouvez en savoir plus sur l'API Gemini en accédant à la page API Gemini : démarrage rapide avec Python.

Dans ce didacticiel, nous avons découvert Gemini et comment accéder à l'API Python pour générer des réponses. En particulier, nous avons appris la génération de texte, la compréhension visuelle, le streaming, l'historique des conversations, la sortie personnalisée et l'intégration. Cependant, cela ne fait qu’effleurer la surface de ce que les Gémeaux peuvent faire.

N'hésitez pas à partager avec moi ce que vous avez construit à l'aide de l'API gratuite Gemini. Les possibilités sont illimitées.

Abid Ali Awan (@1abidaliawan) est un spécialiste des données certifié qui aime créer des modèles d'apprentissage automatique. Actuellement, il se concentre sur la création de contenu et la rédaction de blogs techniques sur les technologies d'apprentissage automatique et de science des données. Abid est titulaire d'une maîtrise en gestion de la technologie et d'un baccalauréat en génie des télécommunications. Sa vision est de créer un produit d'IA utilisant un réseau de neurones graphiques pour les étudiants aux prises avec une maladie mentale.

- Contenu propulsé par le référencement et distribution de relations publiques. Soyez amplifié aujourd'hui.

- PlatoData.Network Ai générative verticale. Autonomisez-vous. Accéder ici.

- PlatoAiStream. Intelligence Web3. Connaissance Amplifiée. Accéder ici.

- PlatonESG. Carbone, Technologie propre, Énergie, Environnement, Solaire, La gestion des déchets. Accéder ici.

- PlatoHealth. Veille biotechnologique et essais cliniques. Accéder ici.

- La source: https://www.kdnuggets.com/how-to-access-and-use-gemini-api-for-free?utm_source=rss&utm_medium=rss&utm_campaign=how-to-access-and-use-gemini-api-for-free

- :possède

- :est

- $UP

- 1

- 10

- 12

- 13

- 14

- 17

- 27

- 7

- 8

- 9

- a

- Qui sommes-nous

- accès

- avec précision

- à travers

- ajoutant

- Supplémentaire

- renseignements supplémentaires

- Avancée

- encore

- AI

- extraterrestres

- Tous

- permet

- presque

- aussi

- incroyable

- an

- ainsi que les

- réponses

- Anthropique

- api

- Apis

- applications

- architecture

- SONT

- argument

- AS

- demander

- At

- acoustique

- Équilibré

- BE

- devenir

- était

- before

- référence

- jusqu'à XNUMX fois

- Blog

- blogue

- tous les deux

- construire

- Développement

- construit

- entreprises

- mais

- bouton (dans la fenêtre de contrôle qui apparaît maintenant)

- by

- appelé

- CAN

- candidat

- candidats

- capacités

- capable

- maisons

- cas

- Centres

- Support et maintenance de Salesforce

- le chat

- vérifier

- Nettoyage

- cliquez

- code

- collaboration

- comparer

- comparant

- complexe

- contenu

- création de contenu

- contexte

- Conversation

- conversations

- convertir

- Correspondant

- couverture

- création

- Lecture

- Customiser

- personnaliser

- données

- les centres de données

- science des données

- Data Scientist

- Date

- DeepMind

- Degré

- dense

- un

- développé

- mobiles

- Compatibles

- didn

- différent

- Commande

- plusieurs

- do

- INSTITUTIONNELS

- Don

- Dota

- Dota 2

- down

- même

- Easy

- efficace

- efficacement

- enrobage

- ENGINEERING

- Tout

- Environment

- Ether (ETH)

- attend

- de santé

- Expliquer

- explorez

- plus rapide

- Prénom

- flexible

- mettant l'accent

- suivre

- Pour

- le format

- Gratuit

- de

- fonction

- fonctions

- jeu

- GEMINI

- générer

- génération

- obtenez

- gif

- Go

- aller

- Bien

- graphique

- Réseau neuronal graphique

- guide

- ait eu

- Vous avez

- ayant

- he

- vous aider

- ici

- Héros

- Haute

- très

- sa

- Histoire

- détient

- Comment

- How To

- Cependant

- HTTPS

- humain

- i

- identifié

- maladie

- image

- satellite

- importer

- in

- Y compris

- de plus en plus

- d'information

- initier

- installer

- instance

- plutôt ;

- l'intégration

- développement

- d'introduction

- IT

- SES

- jpg

- julia

- juste

- KDnuggetsGenericName

- ACTIVITES

- spécialisées

- langue

- le plus grand

- APPRENTISSAGE

- savant

- apprentissage

- comme

- illimité

- Liste

- charge

- plus long

- aime

- click

- machine learning

- FAIT DU

- gestion

- de nombreuses

- massif

- maître

- max

- me

- sens

- veux dire

- mental

- Maladie mentale

- Métrique

- Breeze Mobile

- appareils mobiles

- Mode

- modèle

- numériques jumeaux (digital twin models)

- PLUS

- (en fait, presque toutes)

- plusieurs

- prénom

- nano

- NBA

- réseau et

- Neural

- Réseau neuronal

- Nouveauté

- next

- maintenant

- objet

- of

- on

- ONE

- uniquement

- OpenAI

- fonctionner

- or

- OS

- nos

- ande

- Surpasser

- sortie

- Palais

- particulier

- En passant

- parfaite

- performant

- effectuer

- personnel

- photo

- pièces

- Platon

- Intelligence des données Platon

- PlatonDonnées

- jouer

- veuillez cliquer

- Point

- Populaire

- possibilités

- possible

- Post

- défaillances

- précédent

- Pro

- Problème

- résolution de problèmes

- Produit

- professionels

- fournir

- à condition de

- aportando

- Python

- qualité

- requêtes

- question

- assez

- gamme

- RE

- référence

- représentation

- représenté

- un article

- réponse

- réponses

- résultat

- révolutionner

- s

- même

- économie

- Évolutivité

- Escaliers intérieurs

- échelle ai

- Sciences

- Scientifique

- volute

- Section

- sur le lien

- Sélectionner

- Session

- set

- mise

- plusieurs

- Partager

- Shorts

- devrait

- similaires

- étapes

- unique

- So

- Résoudre

- Space

- spécifiquement

- Commencer

- j'ai commencé

- state-of-the-art

- étapes

- Arrêter

- arrêté

- Histoire

- courant

- streaming

- Luttant

- Étudiante

- Catégorie

- convient

- Surface

- Système

- T

- tâches

- équipes

- Technique

- Les technologies

- Technologie

- télécommunication

- tester

- tests

- texte

- génération de texte

- qui

- Les

- leur

- Les

- puis

- this

- trois

- Avec

- à

- Tokens

- Voyage

- difficulté

- tutoriel

- types

- Ultra

- comprendre

- compréhension

- us

- utilisable

- utilisé

- Utilisateur

- en utilisant

- variable

- divers

- Vidéo

- vision

- visuel

- était

- Façon..

- we

- Quoi

- qui

- WHO

- large

- Large gamme

- sera

- comprenant

- Word

- des mots

- activités principales

- world

- écrire

- écriture

- you

- Votre

- zéphyrnet