Suresh on teknologiajohtaja, jolla on syvää teknistä asiantuntemusta puolijohteista, tekoälystä, kyberturvallisuudesta, esineiden internetistä, laitteistoista, ohjelmistoista jne. Hän työskenteli alalla 20 vuotta, viimeksi toimien avoimen lähdekoodin nolla- luottaa sirukehitykseen Technology Innovation Institutessa, Abu Dhabissa ja muissa Fortune 500 -puolijohdeyrityksissä, kuten Intel, Qualcomm ja MediaTek erilaisissa johtotehtävissä, joissa hän tutki ja kehitti tehokkaita, energiatehokkaita, post-quantum-turvallisia ja turvallisia. mikrosirut / system-on-chips (SoC:t) / kiihdyttimiä datakeskus-, asiakas-, älypuhelin-, verkko-, IoT- ja AI/ML-markkinoille. Hän osallistui Falcon LLM:ään (sijoittui ykköseksi huggingfacessa) ja oli räätälöidyn AI-laitteistoalustan johtava arkkitehti (peruutettu – prioriteetteja muutettu). Hänellä on yli 1 US-patenttia ja hän on julkaissut / esiintynyt yli 15 konferenssissa.

Suresh on teknologiajohtaja, jolla on syvää teknistä asiantuntemusta puolijohteista, tekoälystä, kyberturvallisuudesta, esineiden internetistä, laitteistoista, ohjelmistoista jne. Hän työskenteli alalla 20 vuotta, viimeksi toimien avoimen lähdekoodin nolla- luottaa sirukehitykseen Technology Innovation Institutessa, Abu Dhabissa ja muissa Fortune 500 -puolijohdeyrityksissä, kuten Intel, Qualcomm ja MediaTek erilaisissa johtotehtävissä, joissa hän tutki ja kehitti tehokkaita, energiatehokkaita, post-quantum-turvallisia ja turvallisia. mikrosirut / system-on-chips (SoC:t) / kiihdyttimiä datakeskus-, asiakas-, älypuhelin-, verkko-, IoT- ja AI/ML-markkinoille. Hän osallistui Falcon LLM:ään (sijoittui ykköseksi huggingfacessa) ja oli räätälöidyn AI-laitteistoalustan johtava arkkitehti (peruutettu – prioriteetteja muutettu). Hänellä on yli 1 US-patenttia ja hän on julkaissut / esiintynyt yli 15 konferenssissa.

Suresh toimii myös aktiivisesti johtoasemassa RISC-V Internationalissa, jossa hän toimii Trusted Computing Groupin puheenjohtajana RISC-V:n luottamuksellisen laskentakyvyn kehittämiseksi ja johtaa AI/ML Groupia kehittämään RISC-V-laitteistokiihdytystä AI/ML-työkuormille, kuten esim. Transformer Large Language -mallit, joita käytetään ChatGPT-tyyppisissä sovelluksissa. Hän neuvoo myös startuppeja ja pääomasijoitusyrityksiä sijoituspäätösten tukemisessa, tuotestrategiassa, teknologian due diligencessa jne.

Hän suoritti MBA-tutkinnon INSEADista, MS-tutkinnon Birla Institute of Technology & Science Pilanista, Systems Engineering -sertifikaatin MIT:stä, AI-sertifikaatin Stanfordista ja autoteollisuuden toiminnallisen turvallisuustodistuksen TÜV SÜD:ltä.

Kerro meille yrityksestäsi

"Mastiṣka AI” (Mastiṣka tarkoittaa Sanskritin kielellä Brain) on tekoälyyritys, joka on keskittynyt rakentamaan aivojen kaltaisia tietokoneita ajaakseen perusmalleja tehokkaammin tulevaisuuden Generative AI -käyttötapauksissa.

Mitä ongelmia ratkaiset?

Tekoälyn/GenAI:n edut huomioon ottaen sen kysyntä vain kasvaa, samoin kuin sen sivuvaikutukset planeetallamme. Kuinka voimme vähentää tai neutraloida tekoälyn sivuvaikutuksia planeetallamme? Hiilen talteenotto ja ydinvoima ovat oikeaan suuntaan. Mutta meidän on pohjimmiltaan harkittava uudelleen tapaa, jolla teemme tekoälyä, onko se väärä tapa tehdä tonnia matriisikertoja?

Aivomme voivat oppia ja tehdä monia tehtäviä rinnakkain, 10 watin teholla ja alle, mutta miksi nämä tekoälyjärjestelmät kuluttavat 10 megawattia mallien kouluttamiseen?

Ehkä tulevaisuudessa on energiatehokkaita arkkitehtuureja, kuten neuromorfisia arkkitehtuureja ja hermoverkkopohjaisia muuntajia, jotka ovat lähimpänä ihmisaivoja, jotka saattavat kuluttaa 100–1000 kertaa vähemmän energiaa, mikä vähentää tekoälyn käyttökustannuksia, mikä demokratisoi sen ja säästää planeetta.

Tekoälyn nykyiset haasteet ovat a) saatavuus, b) saavutettavuus, c) kohtuuhintaisuus ja d) ympäristöturvallisuus sekä joitain suosituksia niiden ratkaisemiseksi.

Jos ennakoimme tulevaisuutta, joitain hyödyllisiä AGI-konsepteja esitellään elokuvassa "HER", jossa hahmo "Samantha" - keskusteleva agentti, joka on luonnollinen, ymmärtää tunteita, osoittaa empatiaa, on hämmästyttävä perämies työssä - ja juoksee eteenpäin. kämmenlaitteita koko päivän ajan, meidän on ehkä vastattava alla oleviin haasteisiin juuri nyt.

Ongelma 1: LLM:n kouluttaminen voi maksaa 150 10 - 10+ miljoonaa dollaria, ja se antaa vain syvemmille taskuille mahdollisuuden kehittää tekoälyä. Lisäksi päättelykustannukset ovat valtavat (maksaa XNUMX kertaa enemmän kuin verkkohaku)

-> Meidän on parannettava mallien/laitteiston energiatehokkuutta tekoälyn demokratisoimiseksi ihmiskunnan hyödyksi.

Ongelma 2: Valtavien tekoälymallien käyttäminen keskusteluagenteille tai suositusjärjestelmille rasittaa ympäristöä sähkönkulutuksen ja jäähdytyksen osalta.

-> Meidän on parannettava mallien/laitteiston energiatehokkuutta pelastaaksemme planeettamme lapsillemme.

Ongelma 3: Ihmisaivot kykenevät ja voivat tehdä moniajoja, mutta kuluttavat vain 10 wattia megawattien sijaan.

-> Ehkä meidän pitäisi rakentaa aivomme kaltaisia koneita eikä tavallisia matriisikertoimia nopeammin.

Ihmiskunta voi menestyä vain kestävillä innovaatioilla, ei kaattamalla kaikkia metsiä ja keittämällä valtameriä innovaatioiden nimissä. Meidän on suojeltava planeettamme lapsiemme ja tulevien sukupolvien hyvinvoinnin vuoksi…

Mitkä sovellusalueet ovat vahvimpia?

Transformeriin (ja tulevaisuuden hermoarkkitehtuuriin) perustuvien perusmallien koulutus ja päättely 50-100 kertaa energiatehokkaammin verrattuna nykypäivän GPU-pohjaisiin ratkaisuihin.

Mikä saa asiakkaasi hereillä öisin?

Asiakkaille, jotka tällä hetkellä käyttävät muita tuotteita:

Huungoisten kielimallien koulutuksen sähkönkulutus on ylivoimainen, esimerkiksi 13B-parametrin LLM:n harjoittelu 390B-tekstitunnisteilla 200 GPU:lla 7 päivän ajan maksaa 151,744 XNUMX dollaria (Lähde: HuggingFacen uusi koulutusklusterin palvelusivu – https://lnkd.in/g6Vc5cz3). Ja vielä suuremmat mallit 100+B-parametrilla maksavat 10+M $ pelkkä harjoittelu. Maksa sitten päättelystä aina, kun uusi kehotuspyyntö saapuu.

Vedenkulutus jäähdytykseen, Kalifornian yliopiston Riversiden tutkijat arvioivat ChatGPT:n kaltaisen palvelun ympäristövaikutuksia ja sanovat, että se imee 500 millilitraa vettä (lähes 16 unssin vesipullon määrää) joka kerta, kun kysyt siltä 5–50 kehotteen tai kysymyksen sarja. Valikoima vaihtelee sen palvelinten sijainnin ja vuodenajan mukaan. Arvio sisältää epäsuoran vedenkäytön, jota yritykset eivät mittaa – esimerkiksi konesaleille sähköä toimittavien voimalaitosten jäähdyttämiseen. (Lähde: https://lnkd.in/gybcxX8C)

Ongelmat muille kuin nykyisten tuotteiden asiakkaille:

Ei ole varaa CAPEXilla ostaa laitteita

Ei ole varaa käyttää pilvipalveluita

Ei voi innovoida tai hyödyntää tekoälyä – juuttunut palvelumalliin, joka eliminoi kilpailuedun

Miltä kilpailuympäristö näyttää ja miten erotut toisistaan?

- Grafiikkasuorittimet hallitsevat harjoitustilaa, vaikka erikoistuneet ASICit kilpailevat myös tässä segmentissä

- Cloud & Edge -päätelmässä on liian monta vaihtoehtoa

Digitaalinen, analoginen, fotoninen – ihmiset yrittävät ratkaista saman ongelman.

Voitko jakaa ajatuksesi AI/ML:n siruarkkitehtuurin nykytilasta eli mitkä näet tärkeimmät trendit ja mahdollisuudet tällä hetkellä?

Seuraavat trendit:

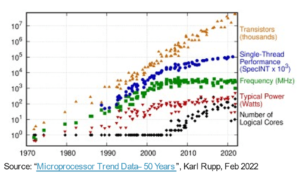

Trendi 1: 10 vuotta sitten laitteistopohjainen syväoppiminen kukoisti, ja nyt sama laitteisto estää edistymistä. Koska mallien käyttökustannukset ovat valtavia laitteisto- ja sähkökustannuksia, laitteiston käyttämisestä on tullut haaste. Vain yrityksillä, joilla on paljon taskuja, on niihin varaa, ja niistä on tulossa monopoleja.

Trendi 2: Nyt kun nämä mallit ovat olemassa, meidän on käytettävä niitä käytännön tarkoituksiin, jotta päättelykuorma kasvaa, jolloin tekoälykiihdyttimillä varustetut prosessorit pääsevät jälleen parrasvaloihin.

Trendi 3: Startupit yrittävät keksiä vaihtoehtoisia liukulukujen esityksiä, joiden mukaan perinteinen IEEE-muoto – kuten logaritminen ja positiivinen – ovat hyviä, mutta eivät riittäviä. PPA$-suunnittelutilan optimointi räjähtää, kun yritämme optimoida yhtä ja toinen menee räjähdysmäisesti.

Trendi 4: Toimiala on siirtymässä palvelupohjaisesta tekoälyn mallista omien yksityisten mallien isännöintiin omissa tiloissaan – mutta laitteiston saatavuus on haaste tarjontapulan, sanktioiden jne.

Tämänhetkinen tilanne:

Laitteiston ja datan saatavuus vauhditti tekoälyn kasvua 10 vuotta sitten, nyt sama laitteisto tavallaan estää sitä – anna minun selittää

Siitä lähtien kun prosessoreilla kävi kurjasti ja grafiikkasuorittimet otettiin uudelleen käyttöön tekoälyä varten, tapahtui monia asioita

Yritykset ovat käsitelleet 4 AI/ML-segmenttiä, nimittäin - 1) pilvikoulutusta, 2) pilvipäätelmiä, 3) reunapäätelmiä ja 4) reunakoulutusta (yhdistetty oppiminen yksityisyyttä herkille sovelluksille).

Digitaalinen & Analoginen

Koulutuspuoli – lukuisia yrityksiä, jotka tekevät grafiikkasuoritteita, RISC-V-pohjaisia asiakaskiihdyttimiä, kiekon mittakaavan siruja (850 XNUMX ydintä) ja niin edelleen, missä perinteisiltä prosessoreilta puuttuu (niiden yleinen käyttötarkoitus). Päätelmäpuoli – NN-kiihdyttimiä on saatavilla kaikilta valmistajilta älypuhelimissa, kannettavissa tietokoneissa ja muissa reunalaitteissa.

Analogiset memristoripohjaiset arkkitehtuurit ilmestyivät myös jokin aika sitten.

Uskomme, että prosessorit voivat olla erittäin hyviä päättelemään, jos tehostamme sitä kiihdytyksellä, kuten matriisilaajennuksilla

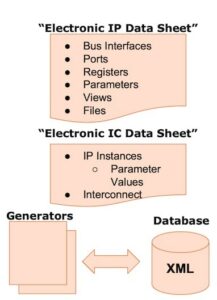

Asian RISC-V puoli:

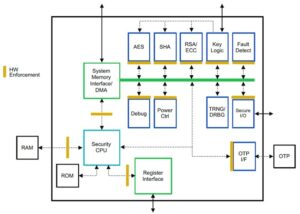

RISC-V-puolella kehitämme kiihdyttimiä matriisioperaatioita ja muita epälineaarisia operaatioita varten eliminoidaksemme mahdolliset pullonkaulat muuntajien työkuormituksilta. Von Neumannin pullonkauloja korjataan myös arkkitehtuurilla muistoja lähempänä laskentaa, mikä tekee lopulta tekoälykiihdytyksellä varustetuista prosessoreista oikean vaihtoehdon päätelmien tekemiseen.

Mahdollisuudet:

Perustusmallien markkinoilla on ainutlaatuiset mahdollisuudet täyttää. Esimerkki – OpenAI ovat maininneet, etteivät he pystyneet turvaamaan tarpeeksi tekoälylaskentaa (GPU:ita) jatkaakseen ChatGPT-palveluitaan… ja uutiset kertovat sähkökustannuksista, jotka ovat 10-kertaiset tavallisen Internet-haun kustannuksiin ja 500 ml:aan vettä järjestelmien jäähdyttämiseen. jokaiseen kyselyyn. Täällä on täytettävä markkina - se ei ole markkinarako, vaan koko markkinat, jotka demokratisoivat tekoälyä vastaamalla kaikkiin edellä mainittuihin haasteisiin – a) saatavuus, b) saavutettavuus, c) kohtuuhintaisuus ja d) ympäristöturvallisuus.

Mitä uusia ominaisuuksia/tekniikkaa työskentelet?

Rakennamme tietokoneiden kaltaisia aivoja hyödyntäen neuromodrfisia tekniikoita ja räätälöimme malleja energiatehokkaan laitteiston hyödyntämiseksi, käyttämällä uudelleen käytettävissä olevia avoimia puitteita.

Millaisena kuvittelet AI/ML-sektorin kasvavan tai muuttuvan seuraavien 12–18 kuukauden aikana?

Kun GPU:iden kysyntä on kiihtynyt (maksaa noin 30 XNUMX dollaria) ja joissakin osissa maailmaa uhkaa sanktioita näiden GPU:iden ostamisesta, jotkut osat maailmaa kokevat jäätyneensä tekoälytutkimukseen ja -kehitykseen ilman pääsyä GPU:ihin. Vaihtoehtoiset laitteistoalustat valtaavat markkinat.

Mallit alkavat ehkä kutistua – mukautetut mallit tai jopa pohjimmiltaan tietotiheys kasvaisi

Sama kysymys, mutta entä kasvu ja muutos seuraavan 3-5 vuoden aikana?

a) Tekoälylaajennuksella varustetut prosessorit kaappasivat tekoälyn päättelymarkkinat

b) Malleista tulee ketterä, ja parametrit putoavat, kun informaatiotiheys paranee 16 %:sta 90 %:iin

c) Energiatehokkuus paranee, CO2-jalanjälki pienenee

d) Uusia arkkitehtuureja tulee esiin

e) laitteisto- ja energiakustannukset laskevat, joten pienten yritysten markkinoille pääsyn este mallien luomisessa ja kouluttamisessa tulee kohtuuhintaiseksi

f) ihmiset puhuvat pre-AGI-hetkistä, mutta vertailukohtanani olisi hahmottuva Samantha (keskustelutekoäly) elokuvassa "her".. mikä saattaa olla epätodennäköistä, kun otetaan huomioon suurentamisen korkeat kustannukset.

Mitkä ovat haasteita, jotka voivat vaikuttaa tai rajoittaa AI/ML-sektorin kasvua?

a) Pääsy laitteistoon

b) Energiakustannukset ja jäähdytyskustannukset sekä ympäristöhaitat

Lue myös:

Toimitusjohtajan haastattelu: David Moore, Pragmatic

Toimitusjohtajan haastattelu: Dr. Meghali Chopra Sandbox Semiconductorista

Toimitusjohtajan haastattelu: Dr. J Provine of Aligned Carbon

- SEO-pohjainen sisällön ja PR-jakelu. Vahvista jo tänään.

- PlatoData.Network Vertical Generatiivinen Ai. Vahvista itseäsi. Pääsy tästä.

- PlatoAiStream. Web3 Intelligence. Tietoa laajennettu. Pääsy tästä.

- PlatoESG. hiili, CleanTech, energia, ympäristö, Aurinko, Jätehuolto. Pääsy tästä.

- PlatonHealth. Biotekniikan ja kliinisten kokeiden älykkyys. Pääsy tästä.

- Lähde: https://semiwiki.com/ceo-interviews/338703-ceo-interview-suresh-sugumar-of-mastiska-ai/

- :on

- :On

- :ei

- :missä

- $ YLÖS

- 1

- 10

- 150

- 20

- 20 vuotta

- 200

- 50

- 500

- 7

- a

- pystyy

- Meistä

- edellä

- Abu Dhabi

- kiihtyvyys

- kiihdyttimiä

- pääsy

- saavutettavuus

- aktiivisesti

- osoite

- osoitettu

- käsitellään

- Etu

- Asioiden

- uudelleen

- Agentti

- aineet

- AGI

- sitten

- AI

- AI-mallit

- ai tutkimusta

- AI-järjestelmät

- ai käyttötapauksia

- AI / ML

- linjassa

- Kaikki

- Salliminen

- mahdollistaa

- pitkin

- Myös

- vaihtoehto

- hämmästyttävä

- an

- ja

- Toinen

- Kaikki

- kaikkialla

- Hakemus

- sovellukset

- arkkitehtuuri

- OVAT

- alueet

- Saapuu

- keinotekoinen

- tekoäly

- AS

- Asics

- kysyä

- At

- Automotive

- saatavuus

- saatavissa

- pois

- b

- este

- perustua

- BE

- tulevat

- tulee

- tulossa

- ollut

- ovat

- Uskoa

- alle

- benchmark

- hyödyttää

- Hyödyt

- välillä

- Jälkeen

- pullonkauloja

- sidottu

- Aivot

- äly

- rakentaa

- Rakentaminen

- mutta

- Ostetaan

- by

- Kalifornia

- CAN

- peruttu

- valmiudet

- kykenee

- pääoma

- kaapata

- hiili

- hiilidioksidin talteenoton

- tapauksissa

- keskuksissa

- toimitusjohtaja

- Toimitusjohtajan haastattelu

- todistus

- haaste

- haasteet

- muuttaa

- muuttunut

- muuttuviin

- merkki

- ChatGPT

- Lapset

- siru

- sirut

- valinta

- Chopra

- asiakas

- lähellä

- lähempänä

- pilvi

- Cluster

- co2

- Tulla

- Yritykset

- yritys

- verrattuna

- kilpailla

- kilpailukykyinen

- Laskea

- tietokone

- tietokoneet

- tietojenkäsittely

- käsitteet

- konferenssit

- kuluttaa

- kulutus

- jatkaa

- osaltaan

- puhekielen

- keskusteleva AI

- Viileä

- Hinta

- kustannukset

- voisi

- luoda

- Nykyinen

- Nykyinen tila

- Tällä hetkellä

- asiakassuhde

- asiakas

- Asiakkaat

- leikkaus

- tietoverkkojen

- tiedot

- datakeskukset

- Datacenter

- David

- päivä

- päivää

- päätös

- syvä

- syvä oppiminen

- syvempää

- Kysyntä

- demokratisoida

- Democratizing

- osoittivat

- tiheys

- Riippuen

- Malli

- kehittää

- kehitetty

- kehittämällä

- Kehitys

- Laitteet

- Dhabi

- eriyttää

- ahkeruus

- suunta

- Johtaja

- do

- ei

- tekee

- dollaria

- Dont

- alas

- dr

- Pudota

- kaksi

- ansainnut

- reuna

- vaikutukset

- tehokkuus

- tehokas

- tehokkaasti

- sähkö

- sähkönkulutus

- poistaa

- eliminoi

- tunteet

- Empatia

- energia

- energiatehokkuuden

- Tekniikka

- parantaa

- tarpeeksi

- Koko

- merkintä

- ympäristö

- ympäristön

- kuvitella

- arvio

- arvioidaan

- jne.

- Eetteri (ETH)

- Jopa

- lopulta

- Joka

- esimerkki

- johtaja

- Pääjohtaja

- olla

- asiantuntemus

- räjähtää

- laajennukset

- Kasvot

- päin

- haukka

- nopeampi

- tunne

- täyttää

- yritykset

- kelluva

- keskityttiin

- Jalka

- varten

- aavistaa

- muoto

- rikkaus

- perusta

- puitteet

- alkaen

- jäädytetty

- ruokkivat

- toiminnallinen

- pohjimmiltaan

- tulevaisuutta

- general

- sukupolvet

- generatiivinen

- Generatiivinen AI

- tietty

- Go

- Goes

- menee

- hyvä

- GPU

- Ryhmä

- Kasvava

- Kasvu

- Palvelimet

- Olla

- he

- siten

- tätä

- Korkea

- pitää

- hotellit

- Miten

- HTTPS

- valtava

- HalaaKasvot

- ihmisen

- Ihmiskunta

- IEEE

- if

- kuva

- Vaikutus

- parantaa

- parantaa

- in

- Muilla

- sisältää

- Kasvaa

- teollisuus

- tiedot

- innovoida

- Innovaatio

- innovaatiot

- sen sijaan

- Instituutti

- Intel

- Älykkyys

- kansainvälisesti

- Internet

- Haastatella

- investointi

- Esineiden internet

- IT

- SEN

- vain

- Lasten

- laji

- Lack

- Landschaft

- Kieli

- kannettavat tietokoneet

- suuri

- suurempi

- johtaa

- Johto

- OPPIA

- oppiminen

- antaa

- Vaikutusvalta

- vipuvaikutuksen

- pitää

- parrasvalot

- RAJOITA

- kuormitus

- sijaitsevat

- katso

- näyttää joltakin

- alentaa

- Koneet

- Tekeminen

- Valmistaja

- monet

- markkinat

- markkinat

- Matriisi

- max-width

- Saattaa..

- ehkä

- MBA

- me

- merkitys

- välineet

- mitata

- Muistoja

- mainitsi

- ehkä

- miljoona

- miljoona dollaria

- MIT

- malli

- mallit

- hetki

- monopolit

- kk

- lisää

- eniten

- elokuva

- liikkuvat

- MS

- täytyy

- my

- nimi

- nimittäin

- Luonnollinen

- Tarve

- verkkopohjainen

- verkostoituminen

- hermo-

- Uusi

- uutiset

- seuraava

- markkinarako

- yön

- ketterä

- nyt

- ydin-

- Ydinvoima

- numero

- valtamerten

- of

- on

- ONE

- vain

- avata

- avoimen lähdekoodin

- OpenAI

- Operations

- Mahdollisuudet

- optimointi

- Optimoida

- Vaihtoehdot

- or

- Muut

- meidän

- ulos

- oma

- sivulla

- Parallel

- parametri

- parametrit

- osat

- Patentit

- Maksaa

- Ihmiset

- ehkä

- kone

- kasvit

- foorumi

- Platforms

- Platon

- Platonin tietotieto

- PlatonData

- yletön

- plus

- taskut

- Kohta

- sijainti

- mahdollinen

- teho

- voimalaitokset

- Käytännön

- Painaa

- yksityinen

- Ongelma

- ongelmia

- Tuotteet

- Tuotteemme

- Profiili

- Edistyminen

- ohjeita

- suojella

- tarkoitus

- tarkoituksiin

- Työnnä

- puts

- Qualcomm

- kysymys

- kysymykset

- alue

- sijoittui

- Lue

- äskettäin

- Suositus

- suosituksia

- vähentää

- vähentämällä

- säännöllinen

- Raportit

- pyyntö

- tutkimus

- tutkimus ja kehitys

- Tutkijat

- oikein

- Jokiranta

- roolit

- katto

- ajaa

- juoksu

- toimii

- turvallista

- Turvallisuus

- sama

- seuraamukset

- hiekkalaatikko

- Säästä

- tallentaa

- sanoa

- skaalaus

- tiede

- Haku

- Kausi

- sektori

- turvallinen

- nähdä

- segmentit

- puolijohde

- Puolijohteet

- Sarjat

- palvelimet

- palvelu

- Palvelut

- palvelevat

- Jaa:

- pulaa

- shouldnt

- osoittivat

- Näytä

- puoli

- merkittävä

- koska

- pienempiä

- älypuhelin

- älypuhelimet

- So

- Tuotteemme

- Ratkaisumme

- Solving

- jonkin verran

- lähde

- Tila

- erikoistunut

- käytetty

- Stanford

- Alkaa

- Startups

- Osavaltio

- Strategia

- vahvin

- niin

- toimittaa

- tuki

- kestävä

- järjestelmät

- puuttua

- puuttumalla

- räätälöinti

- ottaa

- Puhua

- tehtävät

- Tekninen

- Elektroniikka

- teknologinen innovaatio

- ehdot

- teksti

- kuin

- että

- -

- Tulevaisuus

- tiedot

- maailma

- heidän

- Niitä

- sitten

- Siellä.

- siten

- Nämä

- ne

- asiat

- tätä

- ne

- vaikka?

- Kukoistaa

- aika

- että

- tämän päivän

- tokens

- huomenna

- liian

- ylin

- arvonta

- perinteinen

- Juna

- koulutus

- muuntaja

- muuntajat

- Trendit

- luotettu

- yrittää

- yrittää

- varten

- ymmärtää

- yliopisto

- University of California

- epätodennäköinen

- us

- Käyttö

- käyttää

- käytetty

- käyttämällä

- eri

- hanke

- riskipääomaa

- riskipääomayritykset

- hyvin

- of

- oli

- vesi

- Tapa..

- we

- verkko

- Hyvinvointi

- olivat

- Mitä

- kun

- joka

- KUKA

- miksi

- tulee

- with

- ilman

- Referenssit

- työskentely

- maailman-

- olisi

- Väärä

- vuotta

- te

- Sinun

- zephyrnet