Sponsored Viimeisten kahden vuosikymmenen aikana yritykset ovat saaneet datakeskusten hallinnan taiteelliseen muotoon. Standardointi ja automaatio tarkoittavat tehokkuuden parantamista sekä raakalaskennan että virrankulutuksen suhteen. Virtualisoinnin ja säilöinnin kaltaiset tekniikat tarkoittavat, että käyttäjät ja kehittäjät voivat käyttää resursseja tehokkaammin itsepalvelun käyttöönoton mahdollistamiseen asti.

Nykyaikaisia datakeskuksia käyttävät yleiskäyttöiset x86-arkkitehtuurit eivät kuitenkaan yksinkertaisesti sovellu tekoälyn työmäärien suorittamiseen. Tekoälyn tutkijat kiertivät tämän uudelleensuuntaamalla GPU-tekniikkaa tekoälyn toiminnan nopeuttamiseksi, ja tämä on voimistanut koneoppimisen innostavaa innovaatiota viimeisen vuosikymmenen aikana.

Tämä on kuitenkin ongelma yrityksille, jotka haluavat suorittaa tekoälyn työmäärät. Tyypillisesti CPU-isäntä plus -kiihdytin -menetelmä on tarkoittanut yhden laatikon ostamista, joka integroi GPU: t ja x86-pohjaisen isäntälaskurin. Tämä voi aloittaa yrityksen infrastruktuuritiimien hälytyskellot. Vaikka tällaiset järjestelmät voivat teoriassa olla plug and play, ne voivat viedä paljon telineeseen tilaa ja saattaa asettaa erilaisia teho- ja jäähdytysvaatimuksia valtavirran laskennalle. Ne voivat myös olla joustamattomia, ja laskennan suhde GPU-kiihdyttimeen on kiinteä, mikä rajoittaa joustavuutta, kun jongleerataan useita työkuormia, joilla on erilaiset isäntälaskentavaatimukset.

Kun tutkijat ja datatieteilijät työskentelevät yhä suurempien mallien ja tietojoukkojen kanssa - olemme nyt turvallisesti biljoonan plus -parametrien alueella - tahdin pitämisestä lisäämällä tekoälyn hevosvoimaa tulee kysymys uuden uuden järjestelmän ostamisesta. Sitten toinen. Ja toinen. Mutta tämä ei juurikaan korjaa epätasapainoa isäntälaskennan ja tekoälyn kiihtyvyyden välillä.

Ja loput erittäin viritetystä palvelinkeskuksestasi? No, et voi todella hyödyntää sitä, kun kaikki tekoälyn työpilvet tapahtuvat siilossa. Tämä saa kokeneet tietohallintojohtajat ja infrastruktuurin ylläpitäjät ymmärrettävästi hermostumaan mahdollisuudesta erikoistuneisiin, tekoälyyn keskittyviin sarjoihin, jotka muuttuvat hajautettujen resurssien siiloiksi heidän silmiensä edessä.

AI-pakkauksen purkaminen

Joten vaikka Ocore Tørudbakken, Graphcoren SVP-järjestelmät, sanoo, että tekoälystä tai konetiedosta tulee väistämättä datakeskuksen neljäs pilari (perinteisen) laskennan, verkostoitumisen ja tallennuksen rinnalla, hän sanoo myös, että tämän ei pitäisi olla mustaa. laatikkojärjestelmät.

Pikemminkin Yhdistyneessä kuningaskunnassa toimiva tekoälyjärjestelmien valmistaja väittää, että tekoälyn tulivoima on erotettava isäntälaskelmasta ja pakattava muotoon, joka ei vain sovi helposti, mutta myös hyödyntää täysin nykyaikaisia datakeskuksia.

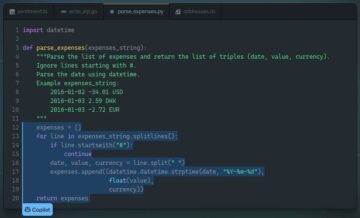

Tässä tulee sisään IPU-POD-järjestelmäperhe. IPU-POD on järjestelmäkokoonpanoperhe, joka perustuu IPU-M2000: een, 1U: n terään, joka tuottaa 1 petaFLOP AI-laskelman. Jokainen kone sisältää neljä GC200-, Mk2 Colossus Intelligence Processing Unit -yksikköä tai IPU: ta, joista jokaisessa on 1472 itsenäistä ydintä tai laattaa, joista kukin voi käyttää kuutta samanaikaista säiettä ja jotka jakavat 900 Mt prosessorin sisäistä muistia samalla piillä.

Lähtökohtana CIO / CTO: lle, joka haluaa varustaa datakeskuksensa tekoälyn laskentaresursseilla, jotka sopivat paremmin heidän datakeskuksen toimintaan, ovat IPU-POD16 ja IPU-POD64.

IPU-POD64 koostuu kuudestatoista IPU-M2000: sta, data- ja hallintakytkimistä ja valittuna yhdestä tai neljästä hajautetusta palvelimesta. Se tuottaa 1 petaFLOPS FP4 -laskentatehoa ja vie noin 16RU telineiden tilaa, hajautettuna yhteen tai useampaan telineeseen, palvelimen varauksesta riippuen. IPU-POD16.16 on esittelytuote niille, jotka haluavat tutkia ja aloittaa innovaatiomatkansa tekniikan avulla. IPU-POD20: ssa on kaksi makua, suora liitäntä, joka on ennalta määritetty plug-and-play-järjestelmä, ja vaihtoehto, joka käyttää kytkimiä. Molemmat variantit käyttävät yhtä isäntäpalvelinta ja toimittavat 16 petaFLOPS FP16 laskennalihasta.

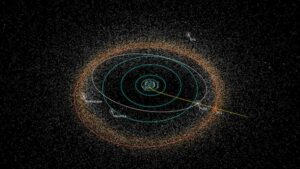

Skaalaus tehdään jokaiseen IPU-M2000: een Graphcoren omalla sisäisellä Gateway-sirulla. Tämä laite tukee 100 Gbps: n tiedonsiirtoa kumpaankin suuntaan vierekkäisten IPU-POD-telineiden kanssa. Osana IPU-Fabric-yhteenliitäntää nämä yhteydet voivat olla suoria tai kytkimien avulla joustavuuden ja vianmäärityksen lieventämiseksi. Laajennuksen perusta on Graphcoren IPU-kangas, jonka kokonaiskaistanleveys on 2.8 Tbps. Kuusitoista M2000: ta suurennetaan telineessä, joka luo IPU-POD64: n. Telineiden välistä tiedonsiirtoa varten IPU-kangas voidaan määrittää kytkettynä 3D-torus-topologiana tukemaan tuhansia IPU: ita ja jopa 1024 IPU-M2000: ta, mikä luo massiivisesti rinnakkaisen järjestelmän, joka tuottaa 16 Exaflops-laskentaa.

Tämä eritelty lähestymistapa on sekä hyperskalereiden että yritysten halu minimoida tukemiensa palvelinten SKU: iden määrä. Graphcore-järjestelmät ovat käytännössä "verkkoon kiinnitettyjä", Tørudbakken sanoo. Asiakkaat yksinkertaisesti asentavat Graphcoren Poplar-ohjelmiston - joka tukee alan standardeja koneoppimiskehyksiä - ensisijaisiin palvelimiinsa tarjotakseen isäntälaskennan IPU-pohjaiselle järjestelmälle. Keskeistä on, että palvelimen kapasiteetti voidaan valita ylös- tai alaspäin asteittain kyseisen tekoälyn työmäärän mukaan. Joten vaikka NLP-tyyppiset kuormitukset tarvitsevat tyypillisesti pienemmän isäntälaskennan ja IO: n suhteen, tietokonenäkökuormitukset aiheuttavat yleensä isommalle kuormitukselle.

Hajauttamisella on myös etuja joustavuuden kannalta, Tørudbakken sanoo. "Jos sinulla on vika - ja palvelimet, ne epäonnistuvat, eikö niin - voit hyödyntää verkkopinon tarjoamia tavallisia vianmääritysprotokollia. Joten jos palvelin tai virtuaalikone epäonnistuu, voit siirtää sen toiseen valmiustilapalvelimeen tai virtuaalikoneeseen. "

IPU-kangas on suunniteltu tukemaan kokoamista viestinnässä ja massiivisessa mittakaavassa. Kun datatutkijat kokoavat koodinsa Poplarilla, heidän mallinsa kartoitetaan IPU-POD-järjestelmän yli vierekkäisenä IPU-resurssina, olennaisesti ikään kuin se olisi yksi jättiläinen IPU, prosessoreiden yksittäisiin ytimiin saakka, mikä luo optimaalisen sarjakuvan tukemaan koneoppimismalli käsillä, joko yhdellä IPU: lla tai skaalaus 1000: een saakka. Tulos, Graphcore sanoo, on determinististä ja värinätöntä viestintää, vaikka järjestelmää laajennettaisiin valtavasti.

Mutta Tørudbakkenin mukaan käyttäjä "ei välitä lainkaan laitteistoista tai järjestelmistä ollenkaan - he haluavat pohjimmiltaan hyvin skaalautuvan alustan, jolla he voivat käyttää koodiaan."

Mitä tulee koodin suorituksen nopeuteen, Graphcoren viimeisimmät vertailuarvot osoittivat, että BERT-Large-ohjelman harjoitusaika voidaan yli puolittaa IPU-POD-järjestelmällä verrattuna DGX A100 GPU-pohjaiseen järjestelmään, ja yli kolminkertainen läpimenokyky päätelmiin pienin viive. Markov Chain Monte Carlon työmäärällä IPU-M2000 suoritti harjoittelutyön alle kolmessa tunnissa, kun taas A48 GPU: n 100 tuntia.

Parannukset ovat entistä selvempiä nykyaikaisemmilla malleilla. IPU-M2000 lisäsi kymmenen kertaa enemmän koulutustehoa EfficientNet-B4: llä ja 18x IPU-optimoidulla kokoonpanolla. Päätelmän perusteella IPU-M2000 tuotti 60-kertaisen kasvun ja 16-kertaisen viiveen vähenemisen GPU-järjestelmään verrattuna. Tämä epäilemättä miellyttää datatieteilijöitä, mutta heidän infrastruktuurikollegoillaan saattaa olla paljon proosalisempia huolenaiheita, kuten kysymykset, kuten "toimiiko järjestelmä optimaalisesti ja todennäköisesti epäonnistuuko?" IPU-POD-järjestelmiä tukee täysin hallintaohjelmistopaketti, joka mahdollistaa järjestelmien hallinnan ja havaittavuuden.

Koostuu alan standardeista, avoimen lähdekoodin yritystyökaluista, kuten OpenBMC, RedFish DTMF, Prometheus ja Grafana, ja niissä on hyvin dokumentoidut, avoimet sovellusliittymät hallintajärjestelmien integrointia varten. "Oletetaan, että virtalähde on pettymässä, ja sitten haluat varoitus siitä varhaisessa vaiheessa ”, Tørudbakken sanoo. "Joten, voit lähettää tukityöntekijän korvaamaan sen tai jos sinulla on DIMM, joka on epäonnistumassa, sama asia."

Ja infrastruktuuritiimit ovat myös hyvin huolissaan siitä, että he saavat parhaan hyödyn investoinneistaan tekoälylaitteisiinsa, mikä tarkoittaa, että sillä on tuki mahdollisimman monelle työmäärälle, työpaikoille ja ryhmille.

AI kenellekään?

Vaikka IPU-POD-arkkitehtuuri voidaan laajentaa kymmeniin tuhansiin IPU: iin, luoden houkutteleva kangas datatieteilijöille malliensa ajamiseksi, kuten Tørudbakken sanoo, todellisuudessa on harvoja tapauksia, joissa yksi käyttäjä vie kaikki tekoälyn laskentakapasiteetti: "Tyypillisesti sinulla on useita käyttäjiä ja sinulla on useita vuokralaisia, jotka vain käyttävät järjestelmää." Tämä tarkoittaa vahvaa resurssien hallintaa. Graphcoren ohjelmistopino sallii "virtuaalisten IPU: iden" ja "luomisen", mikä antaa meille periaatteessa mahdollisuuden kaivaa pod useisiin virtuaalisiin palkkeihin, jotka ovat täysin eristettyjä. Yhden virtuaalisen podin IPU tai järjestelmä ei voi puhua viereisen podin muiden IPU: iden kanssa. "

Tähän liittyy alan standardien orkestrointityökalujen, kuten SLURM ja Kubernetes, tuki, jotta isännällä toimivat virtuaalikoneet tai säiliöt voidaan liittää IPU-järjestelmän VPOD: iin. Kuten Tørudbakken sanoo, puhuiko sitten hyperasteikolla tai yhdellä telineellä, samalla kun datatieteilijä keskittyy saamaan mahdollisimman paljon valtaa mallin ajamiseksi, heidän johtajansa tai yritys haluavat varmuuden siitä, että "tämä resurssi on minun ja vain minun . ”

Tämä on osoitus odotuksesta, että monilla organisaatioilla saattaa olla ensimmäinen kokemus IPU: sta hyperskalaattoreiden tai tammikuussa käynnistetyn Graphcoren oman paljasmetallipilvipalvelun, Graphcloudin kautta. Tørudbakken odottaa kuitenkin, että monet haluavat viime kädessä tuoda koneen älykkyyden paikalle, nimenomaan yksityisyyden, salassapidon ja viiveen vuoksi. Tällöin he ovat työskennelleet hyvin perinteisten yhtälöiden kanssa omistamisen kokonaiskustannusten ympärillä. Yksi opex-kysymys on hänen mukaansa: "Kuinka paljon voimaa kulutat tosiasiallisesti, jotta voit suorittaa, sanotaan, BERT-työn? Vuoden? Kun tarkastelet molempia laatikkotasoa, mutta myös järjestelmätasoa, ratkaisu on erittäin houkutteleva. ”

Capex-näkökulmasta yhtälö on vieläkin suorempi. Ainoa uusi komponentti, jonka heidän on todella lisättävä, on IPU-M2000-pohjainen IPU-POD-järjestelmä. Loput - verkottuminen ja tallennus - on asia, jota monilla ihmisillä on jo. "

Ja se on kiistatta yhtä häiritsevää kuin voit olla, kun tuodaan koneen älykkyyttä datakeskukseen.

Sponsori: Graphcore