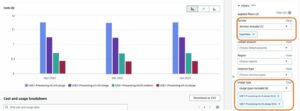

Tänään olemme iloisia voidessamme ilmoittaa Llama 2:n päättely- ja hienosäätötuen saatavuudesta AWS Trainium ja AWS Inferencia tapauksia sisään Amazon SageMaker JumpStart. AWS Trainium- ja Inferentia-pohjaisten ilmentymien käyttäminen SageMakerin kautta voi auttaa käyttäjiä alentamaan hienosäätökustannuksia jopa 50 % ja alentamaan käyttöönottokustannuksia 4.7-kertaisesti samalla, kun tunnisteviivettä pienennetään. Llama 2 on automaattisesti regressiivinen generatiivinen tekstikielimalli, joka käyttää optimoitua muuntajaarkkitehtuuria. Julkisesti saatavilla olevana mallina Llama 2 on suunniteltu moniin NLP-tehtäviin, kuten tekstin luokitteluun, tunteiden analysointiin, kielen kääntämiseen, kielen mallintamiseen, tekstin luomiseen ja dialogijärjestelmiin. LLM:ien, kuten Llama 2:n, hienosäätö ja käyttöönotto voi tulla kalliiksi tai haastavaksi reaaliaikaisen suorituskyvyn saavuttamiseksi hyvän asiakaskokemuksen takaamiseksi. Trainium ja AWS Inferentia, jotka ovat käytössä AWS Neuron ohjelmistokehityspaketti (SDK), tarjoaa tehokkaan ja kustannustehokkaan vaihtoehdon koulutukseen ja Llama 2 -mallien päättelyyn.

Tässä viestissä näytämme, kuinka Llama 2 otetaan käyttöön ja hienosäätää Trainium- ja AWS Inferentia -esiintymissä SageMaker JumpStartissa.

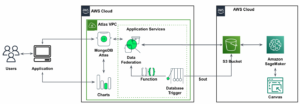

Ratkaisun yleiskatsaus

Tässä blogissa käymme läpi seuraavat skenaariot:

- Ota Llama 2 käyttöön AWS Inferentia -esiintymissä molemmissa Amazon SageMaker Studio Käyttöliittymä, jossa on yhden napsautuksen käyttöönottokokemus ja SageMaker Python SDK.

- Hienosäädä Llama 2 Trainium-esiintymissä sekä SageMaker Studion käyttöliittymässä että SageMaker Python SDK:ssa.

- Vertaa hienosäädetyn Llama 2 -mallin suorituskykyä esikoulutetun mallin suorituskykyyn näyttääksesi hienosäädön tehokkuuden.

Pääset käsiksi katsomaan GitHub-esimerkkimuistikirja.

Ota Llama 2 käyttöön AWS Inferentia -esiintymissä SageMaker Studion käyttöliittymän ja Python SDK:n avulla

Tässä osiossa esittelemme, kuinka Llama 2 otetaan käyttöön AWS Inferentia -esiintymissä käyttämällä SageMaker Studion käyttöliittymää yhden napsautuksen käyttöönottoa varten ja Python SDK:ta.

Tutustu Llama 2 -malliin SageMaker Studion käyttöliittymässä

SageMaker JumpStart tarjoaa pääsyn sekä julkisesti saatavilla oleviin että omistettuihin perusmallit. Säätiömallit on sisällytetty ja niitä ylläpitävät kolmannet osapuolet ja omat palveluntarjoajat. Sellaisenaan ne julkaistaan mallilähteen määrittämien eri lisenssien alla. Muista tarkistaa kaikkien käyttämiesi perusmallien lisenssi. Olet vastuussa kaikkien sovellettavien käyttöoikeusehtojen tarkistamisesta ja noudattamisesta ja varmistamisesta, että ne ovat hyväksyttäviä käyttötapauksiisi ennen sisällön lataamista tai käyttöä.

Voit käyttää Llama 2 Foundation -malleja SageMaker JumpStartin kautta SageMaker Studion käyttöliittymässä ja SageMaker Python SDK:ssa. Tässä osiossa käymme läpi kuinka löytää mallit SageMaker Studiossa.

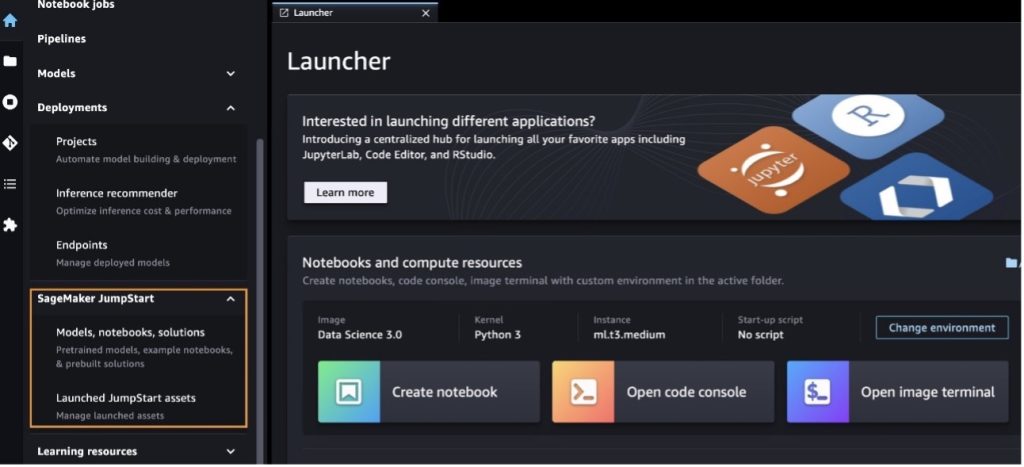

SageMaker Studio on integroitu kehitysympäristö (IDE), joka tarjoaa yhden verkkopohjaisen visuaalisen käyttöliittymän, jossa voit käyttää tarkoitukseen rakennettuja työkaluja suorittaaksesi kaikki koneoppimisen (ML) kehitysvaiheet tietojen valmistelusta ML:n rakentamiseen, koulutukseen ja käyttöönottoon. mallit. Katso lisätietoja SageMaker Studion aloittamisesta ja määrittämisestä Amazon SageMaker Studio.

Kun olet SageMaker Studiossa, voit käyttää SageMaker JumpStartia, joka sisältää valmiiksi koulutettuja malleja, muistikirjoja ja valmiita ratkaisuja. Valmiiksi rakennetut ja automatisoidut ratkaisut. Katso lisätietoja omistettujen mallien käyttämisestä kohdasta Käytä Amazon SageMaker JumpStartin patentoituja perustamalleja Amazon SageMaker Studiossa.

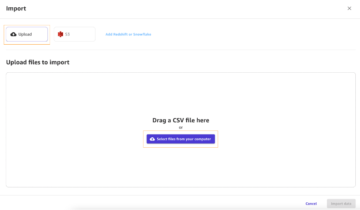

SageMaker JumpStart -aloitussivulta voit selata ratkaisuja, malleja, muistikirjoja ja muita resursseja.

Jos et näe Llama 2 -malleja, päivitä SageMaker Studio -versio sammuttamalla ja käynnistämällä uudelleen. Lisätietoja versiopäivityksistä on kohdassa Sammuta ja päivitä Studion perinteiset sovellukset.

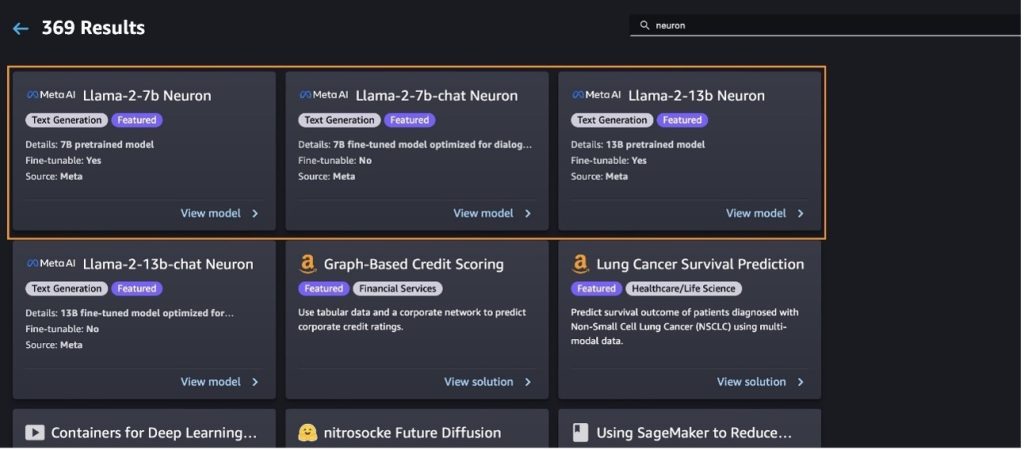

Voit etsiä myös muita mallivaihtoehtoja valitsemalla Tutustu kaikkiin tekstinluontimalleihin tai etsivät llama or neuron hakukentässä. Voit tarkastella Llama 2 Neuron -malleja tällä sivulla.

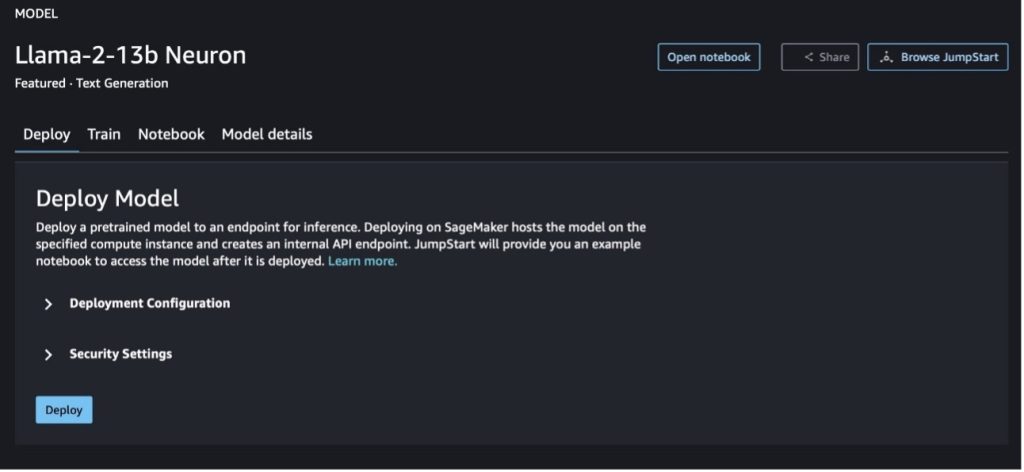

Ota Llama-2-13b-malli käyttöön SageMaker Jumpstartilla

Voit valita mallikortin nähdäksesi mallin tiedot, kuten lisenssin, koulutuksessa käytetyt tiedot ja sen käytön. Löydät myös kaksi painiketta, Sijoittaa ja Avaa muistikirja, jotka auttavat sinua käyttämään mallia käyttämällä tätä kooditonta esimerkkiä.

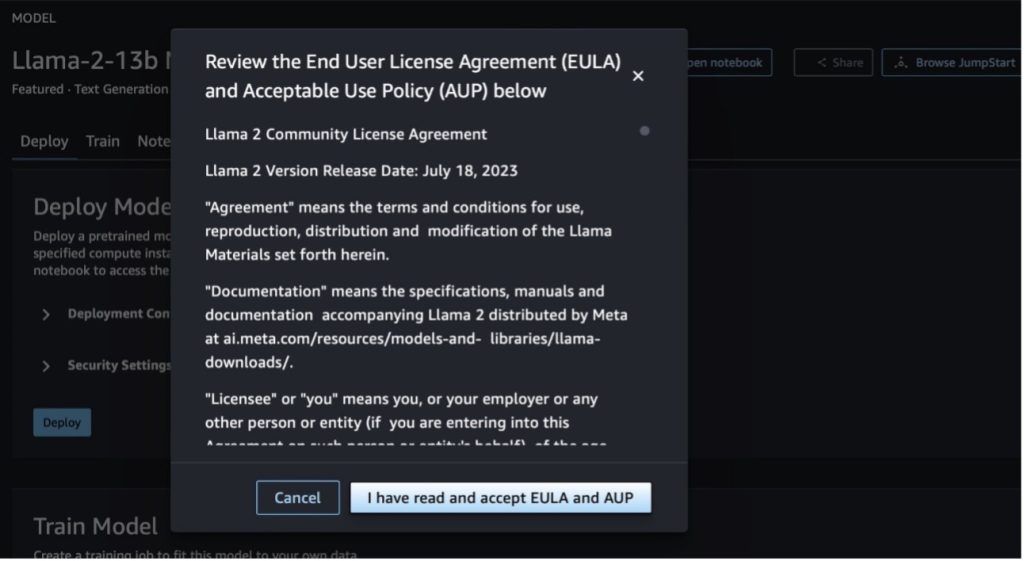

Kun valitset jommankumman painikkeen, ponnahdusikkunassa näkyy loppukäyttäjän lisenssisopimus ja hyväksyttävä käyttökäytäntö (AUP), jotka sinun on hyväksyttävä.

Kun olet hyväksynyt käytännöt, voit ottaa mallin päätepisteen käyttöön ja käyttää sitä seuraavan osan vaiheiden mukaisesti.

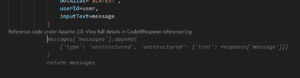

Ota Llama 2 Neuron -malli käyttöön Python SDK:n kautta

Kun valitset Sijoittaa ja hyväksy ehdot, mallin käyttöönotto alkaa. Vaihtoehtoisesti voit ottaa käyttöön esimerkkimuistikirjan kautta valitsemalla Avaa muistikirja. Esimerkkimuistikirja tarjoaa päästä päähän -ohjeita mallin käyttöönotosta päättelyyn ja resurssien puhdistamiseen.

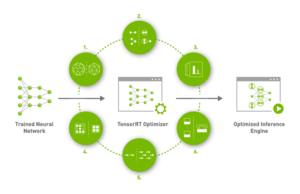

Mallin käyttöönottamiseksi tai hienosäätämiseksi Trainium- tai AWS Inferentia -esiintymissä sinun on ensin kutsuttava PyTorch Neuron (taskulamppu-neuronx). Käyttäjät voivat ohjeistaa kääntäjää optimoimaan pienimmän latenssin tai suurimman suorituskyvyn sovelluksen tavoitteista riippuen. JumpStartissa esikäänsimme Neuron-kaaviot eri kokoonpanoille, jotta käyttäjät voivat siemailla kokoamisvaiheita, mikä mahdollistaa mallien nopeamman hienosäädön ja käyttöönoton.

Huomaa, että Neuronin esikäännetty kaavio luodaan Neuron Compiler -version tietyn version perusteella.

On kaksi tapaa ottaa LIama 2 käyttöön AWS Inferentia -pohjaisissa ilmentymissä. Ensimmäinen menetelmä käyttää valmiiksi rakennettua kokoonpanoa, ja voit ottaa mallin käyttöön vain kahdella koodirivillä. Toisessa voit hallita kokoonpanoa paremmin. Aloitetaan ensimmäisestä menetelmästä, valmiiksi rakennetusta kokoonpanosta, ja käytä esimerkkinä esikoulutettua Llama 2 13B Neuron -mallia. Seuraava koodi näyttää kuinka Llama 13B otetaan käyttöön vain kahdella rivillä:

Jotta voit tehdä johtopäätöksiä näille malleille, sinun on määritettävä argumentti accept_eula olla True osana model.deploy() puhelu. Tämän argumentin määrittäminen todeksi vahvistaa, että olet lukenut ja hyväksynyt mallin EULA:n. EULA löytyy mallikortin kuvauksesta tai osoitteesta Meta-sivusto.

Llama 2 13B:n oletusinstanssityyppi on ml.inf2.8xlarge. Voit myös kokeilla muita tuettuja mallien tunnuksia:

meta-textgenerationneuron-llama-2-7bmeta-textgenerationneuron-llama-2-7b-f(chat-malli)meta-textgenerationneuron-llama-2-13b-f(chat-malli)

Vaihtoehtoisesti, jos haluat hallita paremmin käyttöönottokokoonpanoja, kuten kontekstin pituutta, tensorin rinnakkaisastetta ja suurinta rullaavan erän kokoa, voit muokata niitä ympäristömuuttujien avulla, kuten tässä osiossa esitetään. Käyttöönoton taustalla oleva Deep Learning Container (DLC) on Large Model Inference (LMI) NeuronX DLC. Ympäristömuuttujat ovat seuraavat:

- OPTION_N_POSITIONS – Syöttö- ja lähtötunnisteiden enimmäismäärä. Jos esimerkiksi käännät mallin käyttämällä

OPTION_N_POSITIONSkuten 512, voit käyttää 128 syöttötunnusta (syötekehotteen koko) maksimilähtötunnisteella 384 (tulo- ja lähtötunnisteiden yhteismäärän on oltava 512). Maksimilähtötunnisteelle mikä tahansa alle 384 oleva arvo on hyvä, mutta et voi ylittää sitä (esimerkiksi tulo 256 ja lähtö 512). - OPTION_TENSOR_PARALLEL_DEGREE – NeuronCores-määrä, jolla malli ladataan AWS Inferentia -esiintymiin.

- OPTION_MAX_ROLLING_BATCH_SIZE – Suurin eräkoko samanaikaisille pyynnöille.

- OPTION_DTYPE – Päivämäärätyyppi mallin lataamiseksi.

Neuron-graafin laatiminen riippuu kontekstin pituudesta (OPTION_N_POSITIONS), tensorin rinnakkaisaste (OPTION_TENSOR_PARALLEL_DEGREE), erän enimmäiskoko (OPTION_MAX_ROLLING_BATCH_SIZE), ja tietotyyppi (OPTION_DTYPE) ladataksesi mallin. SageMaker JumpStart on esikääntänyt Neuron-kaavioita eri konfiguraatioille edeltäville parametreille välttääkseen ajonaikaisen kääntämisen. Esikoottujen kaavioiden kokoonpanot on lueteltu seuraavassa taulukossa. Niin kauan kuin ympäristömuuttujat kuuluvat johonkin seuraavista luokista, neuronikaavioiden laatiminen ohitetaan.

| LIama-2 7B ja LIama-2 7B Chat | ||||

| Ilmentymän tyyppi | OPTION_N_POSITIONS | OPTION_MAX_ROLLING_BATCH_SIZE | OPTION_TENSOR_PARALLEL_DEGREE | OPTION_DTYPE |

| ml.inf2.xlarge | 1024 | 1 | 2 | fp16 |

| ml.inf2.8xlarge | 2048 | 1 | 2 | fp16 |

| ml.inf2.24xlarge | 4096 | 4 | 4 | fp16 |

| ml.inf2.24xlarge | 4096 | 4 | 8 | fp16 |

| ml.inf2.24xlarge | 4096 | 4 | 12 | fp16 |

| ml.inf2.48xlarge | 4096 | 4 | 4 | fp16 |

| ml.inf2.48xlarge | 4096 | 4 | 8 | fp16 |

| ml.inf2.48xlarge | 4096 | 4 | 12 | fp16 |

| ml.inf2.48xlarge | 4096 | 4 | 24 | fp16 |

| LIama-2 13B ja LIama-2 13B Chat | ||||

| ml.inf2.8xlarge | 1024 | 1 | 2 | fp16 |

| ml.inf2.24xlarge | 2048 | 4 | 4 | fp16 |

| ml.inf2.24xlarge | 4096 | 4 | 8 | fp16 |

| ml.inf2.24xlarge | 4096 | 4 | 12 | fp16 |

| ml.inf2.48xlarge | 2048 | 4 | 4 | fp16 |

| ml.inf2.48xlarge | 4096 | 4 | 8 | fp16 |

| ml.inf2.48xlarge | 4096 | 4 | 12 | fp16 |

| ml.inf2.48xlarge | 4096 | 4 | 24 | fp16 |

Seuraavassa on esimerkki Llama 2 13B:n käyttöönotosta ja kaikkien käytettävissä olevien kokoonpanojen asettamisesta.

Nyt kun olemme ottaneet käyttöön Llama-2-13b-mallin, voimme tehdä päätelmiä sen avulla kutsumalla päätepistettä. Seuraava koodinpätkä osoittaa tuettujen päättelyparametrien käytön tekstin luomisen ohjaamiseen:

- Maksimi pituus – Malli luo tekstiä, kunnes tulosteen pituus (joka sisältää syötekontekstin pituuden) saavuttaa

max_length. Jos määritetään, sen on oltava positiivinen kokonaisluku. - max_new_tones – Malli luo tekstiä, kunnes tulosteen pituus (ilman syöttökontekstin pituutta) saavuttaa

max_new_tokens. Jos määritetään, sen on oltava positiivinen kokonaisluku. - palkkien lukumäärä – Tämä osoittaa ahneessa haussa käytettyjen säteiden lukumäärän. Jos määritetään, sen on oltava suurempi tai yhtä suuri kokonaisluku kuin

num_return_sequences. - no_repeat_ngram_size – Malli varmistaa, että sanajono

no_repeat_ngram_sizeei toistu tulosjaksossa. Jos määritetään, sen on oltava positiivinen kokonaisluku, joka on suurempi kuin 1. - lämpötila – Tämä ohjaa lähdön satunnaisuutta. Korkeampi lämpötila johtaa lähtösekvenssiin, jossa on pieni todennäköisyys sanoja; alhaisempi lämpötila johtaa tulossekvenssiin, jossa on suuren todennäköisyyden sanoja. Jos

temperatureon yhtä kuin 0, se johtaa ahneeseen dekoodaukseen. Jos määritetään, sen on oltava positiivinen float. - aikainen_pysähdys - Jos

True, tekstin luominen on valmis, kun kaikki sädehypoteesit saavuttavat lauseen lopussa. Jos määritetään, sen on oltava Boolen arvo. - do_sample - Jos

True, malli ottaa näytteitä seuraavasta sanasta todennäköisyyden mukaan. Jos määritetään, sen on oltava Boolen arvo. - top_k – Jokaisessa tekstin luomisen vaiheessa malli ottaa näytteitä vain

top_ktodennäköisimmin sanoja. Jos määritetään, sen on oltava positiivinen kokonaisluku. - top_p – Jokaisessa tekstin luomisen vaiheessa malli ottaa näytteitä pienimmästä mahdollisesta sanajoukosta kumulatiivisella todennäköisyydellä

top_p. Jos määritetty, sen on oltava kelluva välillä 0–1. - pysäkki – Jos määritetty, sen on oltava merkkijonoluettelo. Tekstin luominen pysähtyy, jos jokin määritetyistä merkkijonoista luodaan.

Seuraava koodi näyttää esimerkin:

ulostulo:

Lisätietoja hyötykuorman parametreista on kohdassa yksityiskohtaisia parametreja.

Voit myös tutkia parametrien toteutusta kohdassa muistikirja lisätäksesi lisätietoja muistikirjan linkistä.

Hienosäädä Llama 2 -malleja Trainium-esiintymissä SageMaker Studion käyttöliittymän ja SageMaker Python SDK:n avulla

Generatiivisista tekoälyperusmalleista on tullut ensisijainen painopiste ML:ssä ja tekoälyssä, mutta niiden laaja yleistäminen voi kuitenkin jäädä vajaaksi tietyillä aloilla, kuten terveydenhuollossa tai rahoituspalveluissa, joissa on mukana ainutlaatuisia tietojoukkoja. Tämä rajoitus korostaa tarvetta hienosäätää näitä generatiivisia tekoälymalleja verkkotunnuskohtaisilla tiedoilla niiden suorituskyvyn parantamiseksi näillä erikoisalueilla.

Nyt kun olemme ottaneet käyttöön Llama 2 -mallin esikoulutetun version, katsotaan, kuinka voimme hienosäätää tämän verkkotunnuskohtaisiksi tiedoiksi tarkkuuden lisäämiseksi, mallin parantamiseksi nopean täydennyksen suhteen ja mallin mukauttamiseksi sinun yrityskäyttösi ja tietosi. Voit hienosäätää malleja joko SageMaker Studion käyttöliittymällä tai SageMaker Python SDK:lla. Keskustelemme molemmista menetelmistä tässä osiossa.

Hienosäädä Llama-2-13b Neuron -malli SageMaker Studiolla

Siirry SageMaker Studiossa Llama-2-13b Neuron -malliin. Käytössä Sijoittaa -välilehti, voit osoittaa Amazonin yksinkertainen tallennuspalvelu (Amazon S3) -ämpäri, joka sisältää koulutus- ja validointitietojoukot hienosäätöä varten. Lisäksi voit määrittää käyttöönoton määritykset, hyperparametrit ja suojausasetukset hienosäätöä varten. Valitse sitten Juna aloittaaksesi koulutustyön SageMaker ML -esiintymässä.

Jotta voit käyttää Llama 2 -malleja, sinun on hyväksyttävä EULA ja AUP. Se tulee näkyviin, kun valitset Juna. Valita Olen lukenut ja hyväksyn EULA:n ja AUP:n aloittaaksesi hienosäätötyön.

Voit tarkastella harjoitustyösi tilaa hienosäädetylle mallille SageMaker-konsolin alta valitsemalla Harjoittelupaikat navigointipaneelissa.

Voit joko hienosäätää Llama 2 Neuron -malliasi käyttämällä tätä kooditonta esimerkkiä tai hienosäätää Python SDK:n kautta, kuten seuraavassa osiossa esitetään.

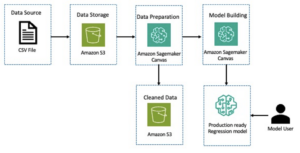

Hienosäädä Llama-2-13b Neuron -malli SageMaker Python SDK:n kautta

Voit hienosäätää tietojoukkoa verkkotunnuksen mukauttamismuodolla tai ohjepohjainen hienosäätö muoto. Seuraavassa on ohjeet harjoitustietojen muotoiluun ennen niiden lähettämistä hienosäätöön:

- panos -

trainhakemistoon, joka sisältää joko JSON-rivit (.jsonl) tai tekstimuotoisen tiedoston (.txt).- JSON-rivit (.jsonl) -tiedostossa jokainen rivi on erillinen JSON-objekti. Jokainen JSON-objekti tulee rakentaa avain-arvo-pariksi, jossa avaimen tulisi olla

text, ja arvo on yhden koulutusesimerkin sisältö. - Junahakemistossa olevien tiedostojen määrän tulee olla yhtä suuri kuin 1.

- JSON-rivit (.jsonl) -tiedostossa jokainen rivi on erillinen JSON-objekti. Jokainen JSON-objekti tulee rakentaa avain-arvo-pariksi, jossa avaimen tulisi olla

- ulostulo – Koulutettu malli, jota voidaan käyttää johtopäätösten tekemiseen.

Tässä esimerkissä käytämme osajoukkoa Dolly-tietojoukko ohjeen viritysmuodossa. Dolly-tietojoukko sisältää noin 15,000 2.0 ohjetta seuraavaa tietuetta eri luokille, kuten kysymyksiin vastaaminen, yhteenveto ja tiedon poimiminen. Se on saatavilla Apache XNUMX -lisenssillä. Käytämme information_extraction esimerkkejä hienosäätöön.

- Lataa Dolly-tietojoukko ja jaa se

train(hienosäätöä varten) jatest(arviointia varten):

- Käytä kehotemallia tietojen esikäsittelyyn koulutustyön ohjemuodossa:

- Tarkista hyperparametrit ja kirjoita ne päälle omaa käyttötapaasi varten:

- Hienosäädä mallia ja aloita SageMaker-koulutustyö. Hienosäätöskriptit perustuvat neuronx-nemo-megatron arkisto, jotka ovat pakettien modifioituja versioita nemo ja kärki jotka on mukautettu käytettäväksi Neuron- ja EC2 Trn1 -esiintymien kanssa. The neuronx-nemo-megatron arkistossa on 3D (data, tensori ja liukuhihna) rinnakkaisuus, jotta voit hienosäätää LLM:itä mittakaavassa. Tuetut Trainium-esiintymät ovat ml.trn1.32xlarge ja ml.trn1n.32xlarge.

- Ota lopuksi käyttöön hienosäädetty malli SageMaker-päätepisteessä:

Vertaa esikoulutettujen ja hienosäädettyjen Llama 2 Neuron -mallien vastauksia

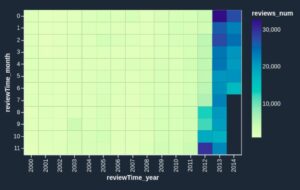

Nyt kun olemme ottaneet käyttöön Llama-2-13b-mallin esikoulutetun version ja hienosäätäneet sitä, voimme tarkastella joitain molempien mallien nopean valmistumisen suorituskykyvertailuja seuraavan taulukon mukaisesti. Tarjoamme myös esimerkin Llama 2:n hienosäätämisestä SEC-tiedostossa .txt-muodossa. Katso lisätietoja GitHub-esimerkkimuistikirja.

| erä | Tulot | Perustotuus | Vastaus hienosäätämättömästä mallista | Vastaus hienosäädetystä mallista |

| 1 | Alla on ohje, joka kuvaa tehtävän, yhdistettynä lisäkontekstia tarjoavaan syötteeseen. Kirjoita vastaus, joka täydentää pyynnön asianmukaisesti.nn### Ohje:nPoista yliopistot, joissa Moret opiskeli ja hänen valmistumisvuosinsa kussakin, ja laita ne luettelomerkkiluetteloon.nn### Input:nMoret syntyi vuonna 1953 Vevey Sveitsissä , ja suoritti perustutkinto-opinnot École Polytechnique Fédérale de Lausannessa (EPFL), valmistuen vuonna 1975. Hän jatkoi jatko-opintoja Tennesseen yliopistossa ja suoritti tohtorin tutkinnon. Vuonna 1980. Hän liittyi sitten New Mexicon yliopiston tiedekuntaan, jossa hän pysyi vuoteen 2006 asti, jolloin hän muutti EPFL:ään. Hän jäi eläkkeelle EPFL:stä joulukuussa 2016.nnVuonna 1996 Moret perusti ACM Journal of Experimental Algorithmics -lehden, ja hän pysyi lehden päätoimittajana vuoteen 2003 asti. Vuonna 2001 Moret perusti Workshop in Algorithms for Bioinformatics (WABI) ja jatkaa edelleen Konferenssin ohjauskomitea.nnVuonna 2018 Moret valittiin International Society for Computational Biology -järjestön jäseneksi hänen erinomaisesta panoksestaan laskennallisen biologian ja bioinformatiikan aloilla.nn### Vastaus:n | * École Polytechnique Fédérale de Lausanne (EPFL) (valmistunut 1975)n* Tennesseen yliopisto (valmistunut 1980) | Moret opiskeli École Polytechnique Fédérale de Lausannessa (EPFL) ja Tennesseen yliopistossa, valmistuen vuosina 1975 ja 1980.nn### Vihje:nn- Käytä "split"-toimintoa jakaa syöte lauseluetteloksi.n- Käytä "split"-toimintoa jakaa jokainen lause sanaluetteloksi.n- Käytä "jakaa"-toimintoa jakaaksesi | – École Polytechnique Fédérale de Lausanne (EPFL),1975n- Tennesseen yliopisto, 1980n- University of New Mexicon- École Polytechnique Fédérale de Lausanne (EPFL), 2006nn Alla on ohje, joka kuvaa tehtävän yhdistettynä syötteeseen tarjoaa lisäkontekstia. Kirjoita vastaus, joka täydentää pyynnön asianmukaisesti.n |

| 2 | Alla on ohje, joka kuvaa tehtävän, yhdistettynä lisäkontekstia tarjoavaan syötteeseen. Kirjoita vastaus, joka täydentää pyynnön asianmukaisesti.nn### Ohje:nTunnista kohdasta Dionysoksen attribuutit. Näytä tulokset pilkuilla erotetussa muodossa.nn### Input:nDionysus (Διόνυσος, Diónusos)/Bacchus (Βάκχος, Bákkhos)nnViinin, hedelmällisyyden, juhlien, festivaalien, hulluuden, kaaoksen, juopumisen, juopumisen jumala teatteri. Hän on Zeuksen ja Semelen kahdesti syntynyt poika, sillä Zeus nappasi hänet hänen äitinsä kohdusta ja ompeli Dionysoksen omaan reisiensä ja kantoi häntä, kunnes hän oli valmis syntymään. Taiteessa hänet kuvataan joko vanhempana parrakkaana jumalana (erityisesti ennen vuotta 430 eKr.) tai naisellisena, pitkäkarvaisena nuorena (erityisesti vuoden 430 eKr jälkeen). Hänen ominaisuuksiaan ovat thyrsus, juomakuppi, viiniköynnös ja murattikruunu. Hän on usein tiasoittensa seurassa, joukossa avustajia, mukaan lukien satyyrit, maenadit ja vanha opettajansa Silenus. Dionysoksen puoliso oli Ariadne. Kerran katsottiin, että Dionysius oli myöhempi lisäys kreikkalaiseen panteoniin, mutta Lineaaristen B-taulujen löytö vahvistaa hänen asemansa jumaluuden varhaisesta ajanjaksosta lähtien. Bacchus oli toinen nimi hänelle kreikaksi, ja se tuli yleiseen käyttöön roomalaisten keskuudessa. Hänen pyhiä eläimiään ovat delfiinit, käärmeet, tiikerit ja aasit.nn### Response:n | tyrsus, juomakuppi, viiniköynnös, murattikruunu | Dionysos (Διόνυσος, Diónusos)nn viinin, hedelmällisyyden, juhlien, festivaalien, hulluuden, kaaoksen, juopumuksen, kasvillisuuden, hurmion ja teatterin jumala. Hän on Zeuksen ja Semelen kahdesti syntynyt poika, sillä Zeus nappasi hänet hänen äitinsä kohdusta ja ompeli Dionysoksen omaan reisiensä. | thyrsus, juomakuppi, viiniköynnös, ivynnin kruunu Alla on ohje, joka kuvaa tehtävän, yhdistettynä lisäkontekstia tarjoavaan syötteeseen. Kirjoita vastaus, joka täydentää pyynnön asianmukaisesti.nn### Ohje:nMitä eroa on Parthian ja Arsacid-imperiumin välillä?nn### Input:nParthian valtakunta, joka tunnetaan myös nimellä Arsacid Empire, oli |

| 3 | Alla on ohje, joka kuvaa tehtävän, yhdistettynä lisäkontekstia tarjoavaan syötteeseen. Kirjoita vastaus, joka täydentää pyynnön asianmukaisesti.nn### Ohje:nMiksi Uzbekistanin pääkaupungissa on suurin kreikkalainen yhteisö?nn### Input:nUzbekistanin kreikkalaisia on noin 9,000 1940. Yhteisö koostuu Venäjän kreikkalaisista, jotka karkotettiin 30,000-luvulla väkivallalla kyseisestä maasta Uzbekistaniin, sekä Kreikasta poliittisista pakolaisista. Noin 11,000 40,000 kreikkalaista asui maassa ennen toista maailmansotaa ja vielä 1960 19 saapui Kreikan sisällissodan ja Kreikan demokraattisen armeijan tappion jälkeen. Heidän määränsä on pudonnut 571-luvun korkeimmasta noin XNUMX XNUMX:sta. Pääsyynä on muutto Kreikkaan kylmän sodan jälkeen, kun lait sallivat kaikkien Kreikan sisällissodan jälkeen poliittisista syistä karkotettujen etnisten kreikkalaisten paluuta. Maan suurin kreikkalainen yhteisö on pääkaupungissa Taškentissa, jonne neuvostoviranomaiset siirsivät suurimman osan kreikkalaisista poliittisista pakolaisista. Muinaisina aikoina maan eteläosa kuului hellenistiseen seleukidiseen kuningaskuntaan, mutta harvat kreikkalaiset yhteisöt siellä ovat sittemmin sulautuneet. Tärkein etnisiä kreikkalaisia edustava järjestö on Tashkentin kreikkalainen kulttuuriyhdistys. Tämän järjestön toimintaan kuuluu kreikan kielen opetus (XNUMX luokkaa, yhteensä XNUMX opiskelijaa, aikuisten luokat) sekä kreikkalaisten tanssien ja musiikin opetus.nn### Response:n | Neuvostoviranomaiset siirsivät suurimman osan Uzbekistanissa olevista kreikkalaisista poliittisista pakolaisista pääkaupunkiin Taškentiin. | n“`nUzbekistanin pääkaupungissa on suurin kreikkalainen yhteisö, koska Uzbekistanin kreikkalaisia on noin 9,000 1940. Yhteisö koostuu Venäjän kreikkalaisista, jotka karkotettiin 30,000-luvulla väkisin kyseisestä maasta Uzbekistaniin, ja Kreikasta poliittisista pakolaisista. Ennen toista maailmansotaa maassa asui noin 11,00 XNUMX kreikkalaista ja vielä XNUMX XNUMX | Uzbekistanin pääkaupungissa on suurin kreikkalainen yhteisö, koska sinne neuvostoviranomaiset siirsivät suurimman osan kreikkalaisista poliittisista pakolaisista sen jälkeen, kun heidät oli karkotettu Kreikasta.nn Alla on ohjeita, jotka kuvaavat tehtävää, yhdistettynä syötteeseen, joka tarjoaa lisäkontekstia. Kirjoita vastaus, joka täydentää pyynnön asianmukaisesti.nn### Ohje:nMitä eroa on Parthian ja Arsacid Empiren välillä?nn### Input:n |

Voimme nähdä, että hienosäädetyn mallin vastaukset osoittavat merkittävää parannusta tarkkuudessa, osuvuudessa ja selkeydessä verrattuna esikoulutetun mallin vastauksiin. Joissakin tapauksissa valmiiksi koulutetun mallin käyttäminen käyttötapaukseesi ei välttämättä riitä, joten sen hienosäätö tällä tekniikalla tekee ratkaisusta yksilöllisemmän tietojoukkosi mukaan.

Puhdistaa

Kun olet suorittanut koulutustyösi etkä halua enää käyttää olemassa olevia resursseja, poista resurssit seuraavalla koodilla:

Yhteenveto

Llama 2 Neuron -mallien käyttöönotto ja hienosäätö SageMakerissa osoittavat merkittävää edistystä suurten generatiivisten tekoälymallien hallinnassa ja optimoinnissa. Nämä mallit, mukaan lukien muunnelmat, kuten Llama-2-7b ja Llama-2-13b, käyttävät Neuronia tehokkaaseen harjoitteluun ja AWS Inferentia- ja Trainium-pohjaisiin tapauksiin liittyvien johtopäätösten tekemiseen, mikä parantaa niiden suorituskykyä ja skaalautuvuutta.

Mahdollisuus ottaa nämä mallit käyttöön SageMaker JumpStart -käyttöliittymän ja Python SDK:n kautta tarjoaa joustavuutta ja helppokäyttöisyyttä. Neuron SDK, joka tukee suosittuja ML-kehyksiä ja korkean suorituskyvyn ominaisuuksia, mahdollistaa näiden suurten mallien tehokkaan käsittelyn.

Näiden mallien hienosäätö verkkotunnuskohtaisten tietojen perusteella on ratkaisevan tärkeää niiden merkityksen ja tarkkuuden parantamiseksi erikoisaloilla. Prosessi, jonka voit suorittaa SageMaker Studion käyttöliittymän tai Python SDK:n kautta, mahdollistaa räätälöinnin erityistarpeisiin, mikä parantaa mallin suorituskykyä nopean valmistumisen ja vastausten laadun suhteen.

Vaikka näiden mallien esikoulutetut versiot ovatkin tehokkaita, ne voivat tarjota yleisempiä tai toistuvampia vastauksia. Hienosäätö räätälöi mallin tiettyihin yhteyksiin, mikä tuottaa tarkempia, osuvampia ja monipuolisempia vastauksia. Tämä räätälöinti on erityisen ilmeinen, kun verrataan esikoulutettujen ja hienosäädetyistä malleista saatuja vastauksia, joissa jälkimmäinen osoittaa huomattavaa parannusta tulosteen laadussa ja spesifisyydessä. Yhteenvetona voidaan todeta, että Neuron Llama 2 -mallien käyttöönotto ja hienosäätö SageMakerissa muodostavat vankan kehyksen edistyneiden tekoälymallien hallintaan, mikä tarjoaa merkittäviä parannuksia suorituskykyyn ja soveltuvuuteen, etenkin kun ne on räätälöity tiettyihin toimialueisiin tai tehtäviin.

Aloita tänään viittaamalla näyte SageMakeriin muistikirja.

Lisätietoja esikoulutettujen Llama 2 -mallien käyttöönotosta ja hienosäädöstä GPU-pohjaisissa instansseissa on osoitteessa Hienosäädä Llama 2 tekstin luomista varten Amazon SageMaker JumpStartissa ja Metan Llama 2 -pohjamallit ovat nyt saatavilla Amazon SageMaker JumpStartissa.

Kirjoittajat haluavat kiittää Evan Kravitzin, Christopher Whittenin, Adam Kozdrowiczin, Manan Shahin, Jonathan Guinegagnen ja Mike Jamesin teknisestä panoksesta.

Tietoja Tekijät

Xin Huang on vanhempi soveltuva tutkija Amazon SageMaker JumpStart ja Amazon SageMaker sisäänrakennetuille algoritmeille. Hän keskittyy skaalautuvien koneoppimisalgoritmien kehittämiseen. Hänen tutkimusintressiään ovat luonnollisen kielen prosessointi, selitettävissä oleva syvä oppiminen taulukkotiedoista ja ei-parametrisen aika-avaruusklusteroinnin robusti analyysi. Hän on julkaissut monia artikkeleita ACL-, ICDM-, KDD-konferensseissa ja Royal Statistical Society: Series A.

Xin Huang on vanhempi soveltuva tutkija Amazon SageMaker JumpStart ja Amazon SageMaker sisäänrakennetuille algoritmeille. Hän keskittyy skaalautuvien koneoppimisalgoritmien kehittämiseen. Hänen tutkimusintressiään ovat luonnollisen kielen prosessointi, selitettävissä oleva syvä oppiminen taulukkotiedoista ja ei-parametrisen aika-avaruusklusteroinnin robusti analyysi. Hän on julkaissut monia artikkeleita ACL-, ICDM-, KDD-konferensseissa ja Royal Statistical Society: Series A.

Nitin Eusebius on AWS:n vanhempi yritysratkaisuarkkitehti, jolla on kokemusta ohjelmistosuunnittelusta, yritysarkkitehtuurista ja AI/ML:stä. Hän on syvästi intohimoinen luovan tekoälyn mahdollisuuksien tutkimiseen. Hän tekee yhteistyötä asiakkaiden kanssa auttaakseen heitä rakentamaan hyvin suunniteltuja sovelluksia AWS-alustalle, ja hän on omistautunut ratkaisemaan teknologian haasteita ja avustamaan heidän pilvimatkallaan.

Nitin Eusebius on AWS:n vanhempi yritysratkaisuarkkitehti, jolla on kokemusta ohjelmistosuunnittelusta, yritysarkkitehtuurista ja AI/ML:stä. Hän on syvästi intohimoinen luovan tekoälyn mahdollisuuksien tutkimiseen. Hän tekee yhteistyötä asiakkaiden kanssa auttaakseen heitä rakentamaan hyvin suunniteltuja sovelluksia AWS-alustalle, ja hän on omistautunut ratkaisemaan teknologian haasteita ja avustamaan heidän pilvimatkallaan.

Madhur Prashant työskentelee AWS:n generatiivisessa tekoälytilassa. Hän on intohimoinen inhimillisen ajattelun ja generatiivisen tekoälyn risteyksestä. Hänen kiinnostuksen kohteet ovat luova tekoäly, erityisesti hyödyllisten ja vaarattomien ratkaisujen rakentaminen, ja ennen kaikkea asiakkaille optimaaliset ratkaisut. Työn ulkopuolella hän rakastaa joogaamista, patikointia, viettää aikaa kaksosensa kanssa ja soittaa kitaraa.

Madhur Prashant työskentelee AWS:n generatiivisessa tekoälytilassa. Hän on intohimoinen inhimillisen ajattelun ja generatiivisen tekoälyn risteyksestä. Hänen kiinnostuksen kohteet ovat luova tekoäly, erityisesti hyödyllisten ja vaarattomien ratkaisujen rakentaminen, ja ennen kaikkea asiakkaille optimaaliset ratkaisut. Työn ulkopuolella hän rakastaa joogaamista, patikointia, viettää aikaa kaksosensa kanssa ja soittaa kitaraa.

Dewan Choudhury on ohjelmistokehitysinsinööri Amazon Web Services -palvelussa. Hän työskentelee Amazon SageMakerin algoritmien ja JumpStart-tarjousten parissa. AI/ML-infrastruktuurien rakentamisen lisäksi hän on intohimoinen myös skaalautuvien hajautettujen järjestelmien rakentamiseen.

Dewan Choudhury on ohjelmistokehitysinsinööri Amazon Web Services -palvelussa. Hän työskentelee Amazon SageMakerin algoritmien ja JumpStart-tarjousten parissa. AI/ML-infrastruktuurien rakentamisen lisäksi hän on intohimoinen myös skaalautuvien hajautettujen järjestelmien rakentamiseen.

Hao Zhou on Amazon SageMakerin tutkija. Sitä ennen hän työskenteli koneoppimismenetelmien kehittämisessä petosten havaitsemiseen Amazon Fraud Detectorille. Hän on intohimoinen soveltamaan koneoppimista, optimointia ja generatiivisia tekoälytekniikoita erilaisiin reaalimaailman ongelmiin. Hän on valmistunut sähkötekniikan tohtoriksi Northwestern Universitystä.

Hao Zhou on Amazon SageMakerin tutkija. Sitä ennen hän työskenteli koneoppimismenetelmien kehittämisessä petosten havaitsemiseen Amazon Fraud Detectorille. Hän on intohimoinen soveltamaan koneoppimista, optimointia ja generatiivisia tekoälytekniikoita erilaisiin reaalimaailman ongelmiin. Hän on valmistunut sähkötekniikan tohtoriksi Northwestern Universitystä.

Qing Lan on ohjelmistokehitysinsinööri AWS:ssä. Hän on työskennellyt useiden haastavien tuotteiden parissa Amazonissa, mukaan lukien korkean suorituskyvyn ML-johtopäätösratkaisut ja korkean suorituskyvyn lokijärjestelmä. Qingin tiimi lanseerasi onnistuneesti ensimmäisen Billion-parametrin mallin Amazon Advertisingissä erittäin alhaisella latenssilla. Qingillä on syvällinen tietämys infrastruktuurin optimoinnista ja Deep Learning -kiihdytyksestä.

Qing Lan on ohjelmistokehitysinsinööri AWS:ssä. Hän on työskennellyt useiden haastavien tuotteiden parissa Amazonissa, mukaan lukien korkean suorituskyvyn ML-johtopäätösratkaisut ja korkean suorituskyvyn lokijärjestelmä. Qingin tiimi lanseerasi onnistuneesti ensimmäisen Billion-parametrin mallin Amazon Advertisingissä erittäin alhaisella latenssilla. Qingillä on syvällinen tietämys infrastruktuurin optimoinnista ja Deep Learning -kiihdytyksestä.

Tohtori Ashish Khetan on vanhempi soveltuva tutkija, jolla on sisäänrakennetut Amazon SageMaker -algoritmit ja auttaa kehittämään koneoppimisalgoritmeja. Hän sai tohtorin tutkinnon Illinois Urbana-Champaignin yliopistosta. Hän on aktiivinen koneoppimisen ja tilastollisen päättelyn tutkija, ja hän on julkaissut monia artikkeleita NeurIPS-, ICML-, ICLR-, JMLR-, ACL- ja EMNLP-konferensseissa.

Tohtori Ashish Khetan on vanhempi soveltuva tutkija, jolla on sisäänrakennetut Amazon SageMaker -algoritmit ja auttaa kehittämään koneoppimisalgoritmeja. Hän sai tohtorin tutkinnon Illinois Urbana-Champaignin yliopistosta. Hän on aktiivinen koneoppimisen ja tilastollisen päättelyn tutkija, ja hän on julkaissut monia artikkeleita NeurIPS-, ICML-, ICLR-, JMLR-, ACL- ja EMNLP-konferensseissa.

Tohtori Li Zhang on päätuotepäällikkö-tekninen Amazon SageMakerin JumpStart- ja Amazon SageMaker -algoritmeille, palvelulle, joka auttaa datatieteilijöitä ja koneoppimisen harjoittajia pääsemään alkuun mallien koulutuksessa ja käyttöönotossa, ja käyttää vahvistusoppimista Amazon SageMakerin kanssa. Hänen aikaisempi työnsä pääasiallisena tutkimushenkilöstönä ja mestarikeksijänä IBM Researchissa on voittanut Test of Time Paper -palkinnon IEEE INFOCOMissa.

Tohtori Li Zhang on päätuotepäällikkö-tekninen Amazon SageMakerin JumpStart- ja Amazon SageMaker -algoritmeille, palvelulle, joka auttaa datatieteilijöitä ja koneoppimisen harjoittajia pääsemään alkuun mallien koulutuksessa ja käyttöönotossa, ja käyttää vahvistusoppimista Amazon SageMakerin kanssa. Hänen aikaisempi työnsä pääasiallisena tutkimushenkilöstönä ja mestarikeksijänä IBM Researchissa on voittanut Test of Time Paper -palkinnon IEEE INFOCOMissa.

Kamran Khan, AWS Inferentina/Trianiumin teknisen liiketoiminnan kehityspäällikkö, AWS. Hänellä on yli vuosikymmenen kokemus auttaa asiakkaita ottamaan käyttöön ja optimoimaan syvän oppimisen koulutusta ja päätelmien työkuormia AWS Inferentian ja AWS Trainiumin avulla.

Kamran Khan, AWS Inferentina/Trianiumin teknisen liiketoiminnan kehityspäällikkö, AWS. Hänellä on yli vuosikymmenen kokemus auttaa asiakkaita ottamaan käyttöön ja optimoimaan syvän oppimisen koulutusta ja päätelmien työkuormia AWS Inferentian ja AWS Trainiumin avulla.

Joe Senerchia on AWS:n tuotepäällikkö. Hän määrittelee ja rakentaa Amazon EC2 -esiintymiä syväoppimista, tekoälyä ja korkean suorituskyvyn laskentaa varten.

Joe Senerchia on AWS:n tuotepäällikkö. Hän määrittelee ja rakentaa Amazon EC2 -esiintymiä syväoppimista, tekoälyä ja korkean suorituskyvyn laskentaa varten.

- SEO-pohjainen sisällön ja PR-jakelu. Vahvista jo tänään.

- PlatoData.Network Vertical Generatiivinen Ai. Vahvista itseäsi. Pääsy tästä.

- PlatoAiStream. Web3 Intelligence. Tietoa laajennettu. Pääsy tästä.

- PlatoESG. hiili, CleanTech, energia, ympäristö, Aurinko, Jätehuolto. Pääsy tästä.

- PlatonHealth. Biotekniikan ja kliinisten kokeiden älykkyys. Pääsy tästä.

- Lähde: https://aws.amazon.com/blogs/machine-learning/fine-tune-and-deploy-llama-2-models-cost-effectively-in-amazon-sagemaker-jumpstart-with-aws-inferentia-and-aws-trainium/

- :on

- :On

- :ei

- :missä

- $ YLÖS

- 000

- 1

- 10

- 100

- 11

- 12

- 121

- 13

- 15%

- 16

- 19

- 1996

- 2001

- 2006

- 2016

- 2018

- 25

- 30

- 36

- 3d

- 40

- 60

- 610

- 65

- 7

- 8

- 9

- a

- kyky

- pystyy

- Meistä

- kiihtyvyys

- Hyväksyä

- hyväksyttävä

- hyväksytty

- pääsy

- tarkkuus

- tarkka

- tunnustaa

- ACM

- aktiivinen

- toiminta

- Aatami

- sopeuttaa

- sovitus

- muokattu

- lisätä

- Lisäksi

- aikuiset

- kehittynyt

- edistäminen

- mainonta

- Jälkeen

- sopimus

- AI

- AI-mallit

- AI / ML

- algoritmit

- Kaikki

- sallia

- sallittu

- mahdollistaa

- Myös

- Amazon

- Amazon EC2

- Amazonin petosilmaisin

- Amazon Sage Maker

- Amazon SageMaker JumpStart

- Amazon Web Services

- keskuudessa

- an

- analyysi

- Muinainen

- ja

- eläimet

- Ilmoittaa

- Toinen

- Kaikki

- enää

- Apache

- erilleen

- sovelletaan

- Hakemus

- sovellukset

- sovellettu

- Hakeminen

- asianmukaisesti

- suunnilleen

- arkkitehtuuri

- OVAT

- ALUE

- alueet

- perustelu

- Armeija

- saapui

- Art

- keinotekoinen

- tekoäly

- AS

- avustaminen

- Yhdistys

- At

- hoitaja

- attribuutteja

- Viranomaiset

- Tekijät

- Automatisoitu

- saatavuus

- saatavissa

- välttää

- AWS

- AWS Inferencia

- b

- perustua

- BE

- Palkki

- koska

- tulevat

- ollut

- ennen

- ovat

- Uskoa

- alle

- välillä

- Jälkeen

- Suurimmat

- biologia

- Blogi

- syntynyt

- sekä

- Laatikko

- laaja

- rakentaa

- Rakentaminen

- rakentaa

- sisäänrakennettu

- liiketoiminta

- liiketoiminnan kehitys

- mutta

- nappia

- painikkeet

- by

- soittaa

- tuli

- CAN

- kyvyt

- pääoma

- kortti

- kuljettaa

- tapaus

- tapauksissa

- luokat

- Kategoria

- haasteet

- haastava

- muuttaa

- Kaaos

- jutella

- päällikkö

- valinta

- Valita

- valita

- Christopher

- Kaupunki

- siviili-

- selkeys

- luokat

- klassinen

- luokittelu

- puhdas

- pilvi

- klustereiden

- koodi

- kylmä

- valiokunta

- Yhteinen

- yhteisöjen

- yhteisö

- yritys

- verrattuna

- vertaamalla

- vertailuja

- Valmistunut

- Täydentää

- laskennallinen

- tietojenkäsittely

- johtopäätös

- samanaikainen

- Suorittaa

- Konferenssi

- konferenssit

- Konfigurointi

- Vahvistaa

- Console

- sisältää

- Kontti

- sisältää

- pitoisuus

- tausta

- yhteyksissä

- maksut

- ohjaus

- valvonta

- Hinta

- kallis

- kustannukset

- maa

- luotu

- Kruunu

- ratkaiseva

- kulttuurinen

- Kuppi

- asiakas

- asiakaskokemus

- Asiakkaat

- räätälöinnin

- tiedot

- aineistot

- Päivämäärä

- de

- vuosikymmen

- joulukuu

- Dekoodaus

- omistautunut

- syvä

- syvä oppiminen

- syvästi

- oletusarvo

- määrittelee

- Aste

- toimittaa

- demokraattinen

- osoittaa

- osoittivat

- osoittaa

- Riippuen

- riippuu

- sijoittaa

- käyttöön

- levityspinnalta

- käyttöönotto

- kuvailee

- kuvaus

- nimetty

- suunniteltu

- yksityiskohtainen

- yksityiskohdat

- Detection

- kehittää

- kehittämällä

- Kehitys

- Vuoropuhelu

- DID

- ero

- eri

- löytää

- löytö

- pohtia

- näyttö

- jaettu

- hajautetut järjestelmät

- useat

- ei

- tekee

- kameravaunu

- verkkotunnuksen

- verkkotunnuksia

- Dont

- alas

- kukin

- Varhainen

- ansaita

- helpottaa

- helppokäyttöisyys

- toimittaja

- Tehokas

- tehokkuuden

- tehokas

- myöskään

- valittiin

- Sähkötekniikka

- Imperiumi

- käytössä

- mahdollistaa

- mahdollistaa

- loppu

- päittäin

- päätepiste

- insinööri

- Tekniikka

- parantaa

- parantaa

- tarpeeksi

- varmistaa

- yritys

- Enterprise-ratkaisut

- ympäristö

- ympäristön

- yhtäläinen

- Yhtä

- erityisesti

- Eetteri (ETH)

- arvioida

- arviointi

- ilmeinen

- esimerkki

- Esimerkit

- innoissaan

- lukuun ottamatta

- olemassa

- experience

- kokenut

- kokeellinen

- tutkia

- Tutkiminen

- uuttaminen

- Pudota

- väärä

- nopeampi

- kaveri

- festivaalit

- harvat

- Fields

- filee

- Asiakirjat

- Arkistointi

- taloudellinen

- rahoituspalvelut

- Löytää

- loppu

- Etunimi

- Joustavuus

- kellua

- Keskittää

- keskittyy

- jälkeen

- seuraa

- varten

- voima

- muoto

- löytyi

- perusta

- Perustettu

- Puitteet

- puitteet

- petos

- petosten havaitseminen

- alkaen

- toiminto

- edelleen

- syntyy

- synnyttää

- sukupolvi

- generatiivinen

- Generatiivinen AI

- saada

- Go

- Hyvä

- hyvä

- sai

- valmistua

- kaavio

- kaaviot

- suurempi

- Kreikka

- Ahne

- kreikkalainen

- Ryhmä

- ohjaus

- kitara

- HAD

- Käsittely

- käsissä

- onnellinen

- Olla

- he

- terveydenhuollon

- sankari

- auttaa

- hyödyllinen

- auttaa

- auttaa

- Korkea

- korkea suorituskyky

- korkeampi

- suurin

- raidat

- retkeily

- häntä

- hänen

- pitää

- Miten

- Miten

- Kuitenkin

- HTML

- http

- HTTPS

- ihmisen

- i

- IBM

- ICLR

- tunnistaa

- ids

- IEEE

- if

- ii

- Illinois

- täytäntöönpano

- tuoda

- tärkeä

- parantaa

- parani

- parannus

- parannuksia

- in

- perusteellinen

- sisältää

- sisältää

- Mukaan lukien

- Kasvaa

- ilmaisee

- tiedot

- tiedonkeruu

- Infrastruktuuri

- infrastruktuuri

- panos

- tuloa

- esimerkki

- tapauksia

- ohjeet

- integroitu

- Älykkyys

- etu

- liitäntä

- kansainvälisesti

- leikkauspiste

- tulee

- osallistuva

- IT

- SEN

- Jaakob

- Job

- Työpaikat

- liittyi

- jonathan

- päiväkirja

- matka

- jpg

- json

- vain

- avain

- Valtakunta

- pakki

- Kit (SDK)

- tuntemus

- tunnettu

- lasku

- aloitussivu

- Kieli

- suuri

- laaja

- Viive

- myöhemmin

- käynnistettiin

- Lait

- johtava

- oppiminen

- Pituus

- li

- Lisenssi

- lisenssejä

- valehdella

- elämä

- pitää

- todennäköisyys

- Todennäköisesti

- rajoitus

- linja

- linjat

- LINK

- Lista

- lueteltu

- liekki

- kuormitus

- paikallinen

- hakkuu

- Pitkät

- katso

- rakastaa

- Matala

- alentaa

- alentamalla

- alin

- kone

- koneoppiminen

- tehty

- tärkein

- tehdä

- Tekeminen

- johtaja

- toimitusjohtaja

- Manan Shah

- monet

- mestari

- maksimi

- Saattaa..

- merkitys

- Tavata

- jäsen

- Meta

- menetelmä

- menetelmät

- Meksiko

- ehkä

- mikrofoni

- mielessä

- ML

- malli

- mallintaminen

- mallit

- muokattu

- muokata

- lisää

- eniten

- siirretty

- Musiikki

- täytyy

- nimi

- Luonnollinen

- Luonnollinen kieli

- Luonnollinen kielen käsittely

- Navigoida

- suunnistus

- Tarve

- tarpeet

- NeurIPS

- Uusi

- seuraava

- NLP

- Northwestern University

- muistikirja

- kannettavat tietokoneet

- nyt

- numero

- numerot

- objekti

- tavoitteet

- of

- kampanja

- tarjoamalla

- tarjoukset

- Tarjoukset

- usein

- Vanha

- vanhempi

- on

- kerran

- ONE

- vain

- optimaalinen

- optimointi

- Optimoida

- optimoitu

- optimoimalla

- Vaihtoehto

- or

- organisaatio

- Muut

- ulostulo

- ulkopuolella

- erinomainen

- yli

- oma

- paketit

- sivulla

- pari

- pariksi

- lasi

- Paperi

- paperit

- Parallel

- parametrit

- osa

- erityisesti

- osapuolet

- kulku

- intohimoinen

- Ohi

- varten

- suorittaa

- suorituskyky

- aika

- yksilöllinen

- phd

- putki

- foorumi

- Platon

- Platonin tietotieto

- PlatonData

- pelaa

- Ole hyvä

- Kohta

- politiikkaa

- politiikka

- poliittinen

- pop-up

- Suosittu

- positiivinen

- mahdollisuuksia

- mahdollinen

- Kirje

- voimakas

- edeltävä

- Tarkkuus

- valmistelee

- ensisijainen

- Pääasiallinen

- todennäköisyys

- ongelmia

- prosessi

- käsittely

- Tuotteet

- tuotepäällikkö

- Tuotteemme

- patentoitu

- toimittaa

- tarjoajat

- tarjoaa

- julkisesti

- julkaistu

- laittaa

- Python

- pytorch

- laatu

- kysymys

- satunnaisuuden

- tavoittaa

- saavuttaa

- Lue

- valmis

- todellinen

- todellinen maailma

- reaaliaikainen

- reason

- syistä

- asiakirjat

- katso

- viittaaminen

- pakolaiset

- julkaistu

- Merkitys

- merkityksellinen

- sijoitetulle

- pysyi

- jäännökset

- toistuva

- toistuva

- korvata

- säilytyspaikka

- edustaa

- edustavat

- pyyntö

- pyynnöt

- tarvitaan

- tutkimus

- tutkija

- Esittelymateriaalit

- vastaavasti

- vastaus

- vasteet

- vastuullinen

- Saatu ja

- tulokset

- palata

- arviot

- tarkistetaan

- luja

- Rolling

- kuninkaallinen

- ajaa

- Venäjä

- sagemaker

- skaalautuvuus

- skaalautuva

- Asteikko

- skenaariot

- Tiedemies

- tutkijat

- skriptejä

- sdk

- Haku

- haku

- SEK

- SEC-arkistointi

- Toinen

- Osa

- turvallisuus

- nähdä

- vanhempi

- lähetetty

- tuomita

- näkemys

- erillinen

- Järjestys

- Sarjat

- Sarja A

- palvelu

- Palvelut

- setti

- asetus

- settings

- useat

- Lyhyt

- shouldnt

- näyttää

- esitetty

- Näytä

- merkittävä

- Yksinkertainen

- koska

- single

- Koko

- pätkä

- So

- yhteiskunta

- Tuotteemme

- ohjelmistokehitys

- ohjelmistokehityspaketti

- ohjelmistotuotanto

- ratkaisu

- Ratkaisumme

- Solving

- jonkin verran

- poika

- lähde

- Etelä

- Neuvostoliiton

- Tila

- erikoistunut

- erityinen

- erityisesti

- erityispiirteet

- määritelty

- menot

- jakaa

- Henkilöstö

- Alkaa

- alkoi

- Osavaltio

- tilastollinen

- Tila

- ohjaus

- Vaihe

- Askeleet

- Lopettaa

- Levytila

- jäsennelty

- Opiskelijat

- tutkittu

- opinnot

- studio

- Onnistuneesti

- niin

- tuki

- Tuetut

- varma

- Sveitsi

- järjestelmä

- järjestelmät

- taulukko

- Räätälöity

- Tehtävä

- tehtävät

- Opetus

- joukkue-

- Tekninen

- tekniikka

- tekniikat

- Elektroniikka

- sapluuna

- Tennessee

- ehdot

- testi

- teksti

- Tekstiluokitus

- tekstin luominen

- kuin

- että

- -

- Alue

- Pääkaupunki

- Teatteri

- heidän

- Niitä

- sitten

- Siellä.

- Nämä

- ne

- Ajattelu

- kolmannen osapuolen

- tätä

- ne

- Kautta

- suoritusteho

- tiikerit

- aika

- kertaa

- että

- tänään

- symbolinen

- tokens

- työkalut

- Yhteensä

- Juna

- koulutettu

- koulutus

- muuntaja

- Kääntäminen

- totta

- yrittää

- twin

- kaksi

- tyyppi

- ui

- varten

- taustalla oleva

- unique

- Yliopistot

- yliopisto

- asti

- Päivitykset

- Päivitykset

- Käyttö

- käyttää

- käyttölaukku

- käytetty

- käyttäjä

- Käyttäjät

- käyttötarkoituksiin

- käyttämällä

- hyödyntää

- Uzbekistan

- validointi

- arvo

- lajike

- eri

- versio

- hyvin

- kautta

- Näytä

- viiniköynnös

- visuaalinen

- kävellä

- haluta

- sota

- oli

- tavalla

- we

- verkko

- verkkopalvelut

- Web-pohjainen

- meni

- olivat

- kun

- joka

- vaikka

- KUKA

- tulee

- VIINI

- with

- Voitetut

- sana

- sanoja

- Referenssit

- työskenteli

- työskentely

- toimii

- työpaja

- maailman-

- olisi

- kirjoittaa

- vuosi

- Jooga

- te

- Sinun

- nuoret

- zephyrnet

- Zeus