Después de años de desarrollo, Meta finalmente podría implementar sus aceleradores de inteligencia artificial de manera significativa este año.

El imperio Facebook confirmó esta semana su deseo de complementar las implementaciones de las GPU Nvidia H100 y AMD MI300X con su familia de chips Meta Training Inference Accelerator (MTIA). Específicamente, Meta implementará un procesador optimizado para inferencias, supuestamente con el nombre en código Artemisa, basado en las piezas de primera generación del gigante de Silicon Valley burlado el año pasado.

"Estamos entusiasmados con el progreso que hemos logrado en nuestros esfuerzos internos de silicio con MTIA y estamos en camino de comenzar a implementar nuestra variante de inferencia en producción en 2024", dijo un portavoz de Meta. El registro el jueves.

"Consideramos que nuestros aceleradores desarrollados internamente son altamente complementarios a las GPU disponibles comercialmente al ofrecer la combinación óptima de rendimiento y eficiencia en cargas de trabajo metaespecíficas", continuó el representante. ¿Detalles? No. El portavoz nos dijo: "Esperamos compartir más actualizaciones sobre nuestros futuros planes MTIA a finales de este año".

Consideramos que eso significa que el chip centrado en la inferencia de segunda generación se está implementando ampliamente, después de una versión de primera generación solo para laboratorio para la inferencia, y es posible que más adelante descubramos partes destinadas principalmente al entrenamiento o al entrenamiento y la inferencia.

Meta se ha convertido en uno de los mejores clientes de Nvidia y AMD a medida que ha crecido su implementación de cargas de trabajo de IA, aumentando su necesidad y uso de silicio especializado para que su software de aprendizaje automático se ejecute lo más rápido posible. Por tanto, la decisión del gigante de Instagram de desarrollar sus propios procesadores personalizados no es tan sorprendente.

De hecho, la megacorporación, a primera vista, llega relativamente tarde a la fiesta del silicio de IA personalizado en términos de implementación en el mundo real. Amazon y Google han estado utilizando componentes locales para acelerar los sistemas internos de aprendizaje automático, como modelos de recomendación y códigos de aprendizaje automático de clientes durante algunos años. Mientras tanto, Microsoft reveló sus aceleradores locales el año pasado.

Pero más allá del hecho de que Meta está lanzando un chip de inferencia MTIA a escala, la red social no ha revelado su arquitectura precisa ni qué cargas de trabajo está reservando para el silicio interno y cuáles está descargando a las GPU de AMD y Nvidia.

Es probable que Meta ejecute modelos establecidos en sus ASIC personalizados para liberar recursos de GPU para aplicaciones más dinámicas o en evolución. Hemos visto a Meta seguir este camino antes con aceleradores personalizados diseñados para descargar datos y calcular cargas de trabajo de video intensivas.

En cuanto al diseño subyacente, los observadores de la industria de SemiAnalysis nos dicen que el nuevo chip se basa estrechamente en la arquitectura de las piezas de primera generación de Meta.

Peldaños

Anunciadas a principios de 2023 después de tres años de desarrollo, las piezas MTIA v1 de Meta, que nuestros amigos de La próxima plataforma miró la primavera pasada, se diseñaron específicamente teniendo en mente modelos de recomendación de aprendizaje profundo.

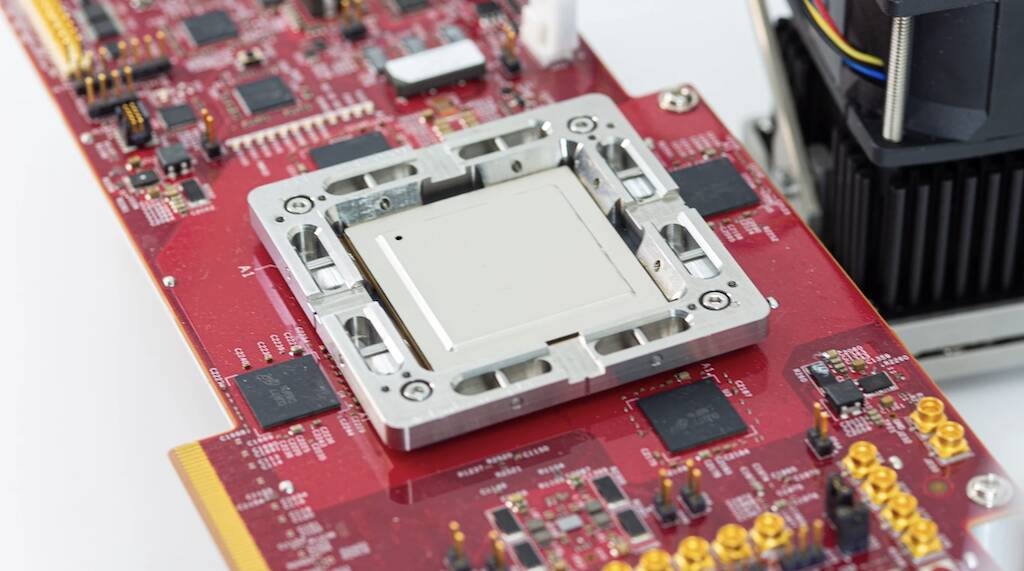

El chip de primera generación se construyó alrededor de un clúster de CPU RISC-V y se fabricó utilizando el proceso de 7 nm de TSMC. Debajo del capó, el componente empleaba una matriz de elementos de procesamiento de ocho por ocho, cada uno equipado con dos núcleos de CPU RV, uno de los cuales está equipado con extensiones matemáticas vectoriales. Estos núcleos se alimentan de unos generosos 128 MB de SRAM en chip y hasta 128 GB de memoria LPDDR5.

Como afirmó Meta el año pasado, el chip funcionó a 800 MHz y alcanzó un máximo de 102.4 billones de operaciones por segundo de rendimiento INT8 o 51.2 teraFLOPS con precisión media (FP16). En comparación, el H100 de Nvidia es capaz de alcanzar casi cuatro petaFLOPS de rendimiento escaso en el FP8. Si bien no es tan potente como las GPU de Nvidia o AMD, el chip tenía una gran ventaja: el consumo de energía. El chip en sí tenía una potencia de diseño térmico de sólo 25 vatios.

Según la Semianálisis, el último chip de Meta cuenta con núcleos mejorados y cambia LPDDR5 por memoria de gran ancho de banda empaquetada con la tecnología de chip en oblea sobre sustrato (CoWoS) de TSMC.

Otra diferencia notable es que el chip de segunda generación de Meta verá una implementación generalizada en toda la infraestructura de su centro de datos. Según el titán de Facebook, si bien la pieza de primera generación se utilizó para ejecutar modelos publicitarios de producción, nunca salió del laboratorio.

Persiguiendo la inteligencia artificial general

Dejando a un lado las piezas personalizadas, la empresa matriz de Facebook e Instagram se ha deshecho miles de millones de dólares en GPU en los últimos años para acelerar todo tipo de tareas que no se adaptan a las plataformas de CPU convencionales. Sin embargo, el auge de grandes modelos de lenguaje, como GPT-4 y el propio Llama 2 de Meta, ha cambiado el panorama e impulsado el despliegue de clústeres de GPU masivos.

A la escala que opera Meta, estas tendencias han requerido cambios drásticos en su infraestructura, incluida la rediseñar de varios centros de datos para soportar los inmensos requisitos de energía y refrigeración asociados con grandes implementaciones de IA.

Y las implementaciones de Meta solo aumentarán en los próximos meses a medida que la compañía cambie su enfoque del metaverso al Desarrollo de inteligencia artificial general. Supuestamente, el trabajo realizado en IA ayudará a formar el metaverso o algo así.

Según el director ejecutivo Mark Zuckerberg, Meta planea implementar hasta 350,000 Nvidia H100 sólo este año.

La empresa también anunció planes para implementar la nueva tecnología de AMD. lanzado GPU MI300X en sus centros de datos. Zuckerberg afirmó que su corporación terminaría el año con la potencia informática equivalente a 600,000 H100. Claramente, los chips MTIA de Meta no reemplazarán a las GPU en el corto plazo. ®

- Distribución de relaciones públicas y contenido potenciado por SEO. Consiga amplificado hoy.

- PlatoData.Network Vertical Generativo Ai. Empodérate. Accede Aquí.

- PlatoAiStream. Inteligencia Web3. Conocimiento amplificado. Accede Aquí.

- PlatoESG. Carbón, tecnología limpia, Energía, Ambiente, Solar, Gestión de residuos. Accede Aquí.

- PlatoSalud. Inteligencia en Biotecnología y Ensayos Clínicos. Accede Aquí.

- Fuente: https://go.theregister.com/feed/www.theregister.com/2024/02/02/meta_ai_chips/

- :posee

- :es

- $ UP

- 000

- 102

- 2%

- 2023

- 2024

- 25

- 350

- 4

- 51

- 600

- 800

- a

- Nuestra Empresa

- acelerar

- acelerador

- aceleradores

- Conforme

- a través de

- Ventaja

- Publicidad

- Después

- AI

- Todos

- solo

- junto al

- también

- Amazon

- AMD

- an

- y

- anunció

- aplicaciones

- arquitectura

- somos

- en torno a

- artificial

- inteligencia general artificial

- AS

- Asics

- aparte

- asociado

- At

- Hoy Disponibles

- basado

- BE

- a las que has recomendado

- esto

- antes

- MEJOR

- Más allá de

- biz

- Se jacta

- construido

- by

- capaz

- ceo

- cambiado

- Cambios

- chip

- Papas fritas

- afirmó

- con claridad.

- de cerca

- Médico

- CO

- código

- comercialmente

- compañía

- comparación

- complementario

- componente

- componentes

- Calcular

- informática

- potencia de cálculo

- Confirmado

- consumo

- continuado

- convencional

- CORPORACIÓN

- CPU

- personalizado

- cliente

- Clientes

- datos

- Datacenter

- Koops

- entregar

- desplegar

- Desplegando

- despliegue

- Despliegues

- Diseño

- diseñado

- deseo

- detalles

- desarrollar

- desarrollado

- Desarrollo

- HIZO

- un cambio

- dólares

- hecho

- DE INSCRIPCIÓN

- impulsados

- lugar de trabajo dinámico

- cada una

- Temprano en la

- eficiencia

- esfuerzos

- ya sea

- elementos

- Imperio

- empleado

- final

- equipado

- Equivalente a

- se establece

- Éter (ETH)

- evolución

- excitado

- extensiones

- Cara

- hecho

- familia

- RÁPIDO

- Fed

- pocos

- Finalmente

- Encuentre

- Focus

- siguiendo

- formulario

- adelante

- Digital XNUMXk

- Gratuito

- amigos

- Desde

- futuras

- General

- inteligencia general

- generoso

- obtener

- gigante

- Go

- va

- GPU

- GPU

- crecido

- tenido

- A Mitad

- Tienen

- ayuda

- altamente

- su

- de cosecha propia

- capucha

- Sin embargo

- HTTPS

- inmenso

- mejorado

- in

- Incluye

- creciente

- energético

- EN LA MINA

- Intelligence

- Destinado a

- intensivo

- interno

- internamente

- ISN

- IT

- SUS

- sí mismo

- jpg

- solo

- el lab

- paisaje

- idioma

- large

- mayores

- Apellido

- El año pasado

- Tarde

- luego

- más reciente

- izquierda

- como

- que otros

- Llama

- Mira

- hecho

- gran

- para lograr

- manera

- muchos

- marca

- Mark Zuckerberg

- masivo

- las matemáticas

- Matrix

- Puede..

- personalizado

- significativo

- Mientras tanto

- Salud Cerebral

- Meta

- Metaverso

- Microsoft

- mente

- mezcla

- ML

- modelos

- meses

- más,

- Cerca

- hace casi

- ¿ Necesita ayuda

- del sistema,

- nunca

- Nuevo

- nuevo chip

- recién

- Next

- ni

- notable

- Nvidia

- of

- on

- ONE

- , solamente

- opera

- Operaciones

- óptimo

- or

- nuestros

- salir

- Más de

- EL DESARROLLADOR

- empaquetado

- parte

- partes

- fiesta

- para

- actuación

- jubilación

- Plataformas

- Platón

- Inteligencia de datos de Platón

- PlatónDatos

- posible

- industria

- poderoso

- necesidad

- Precisión

- las cuales

- tratamiento

- Procesador

- procesadores

- Producción

- Progreso

- RE

- mundo real

- reciente

- relativamente

- Requisitos

- Recursos

- Reuters

- Revelado

- Subir

- Rodar

- Rolling

- Ruta

- Ejecutar

- s

- Escala

- Segundo

- ver

- visto

- Varios

- compartir

- Turnos

- Silicio

- Silicon Valley

- So

- Social

- redes sociales

- Software

- algo

- algo

- Pronto

- escaso

- especializado

- específicamente

- portavoz

- primavera

- comienzo

- tal

- complementar

- SOPORTE

- sorprendente

- Todas las funciones a su disposición

- T

- toma

- tareas

- tecnología

- les digas

- términos

- esa

- El

- El paisaje

- El metaverso

- térmico

- Estas

- así

- esta semana

- este año

- Tres

- jueves

- Así

- titán

- a

- les dijo a

- rematado

- seguir

- oficios

- Formación

- Tendencias

- Trillones

- TSMC

- dos

- bajo

- subyacente

- Actualizaciones

- us

- utilizan el

- usado

- usando

- v1

- Valle

- Variante

- Ve

- vector

- versión

- Video

- fue

- Camino..

- we

- semana

- tuvieron

- que

- mientras

- extensamente

- extendido

- seguirá

- Won

- Actividades:

- se

- año

- años

- zephyrnet

- Zuckerberg