Como la conferencia EDA más antigua y más grande, la Conferencia de Automatización del Diseño (DAC) reúne a las mejores mentes para presentar, discutir, exhibir y debatir los últimos y mejores avances en EDA. Lo logra en forma de documentos técnicos, charlas, stands de empresas, pabellones de productos y paneles de discusión.

Un aspecto clave para impulsar los avances en la automatización del diseño es discutir los requisitos EDA en evolución, para que la industria pueda desarrollar las soluciones según las demandas del mercado. En DAC 2021, Cadence patrocinó una interesante sesión de panel que llega al corazón de esto. La sesión se tituló “Cómo las empresas de sistemas están remodelando los requisitos para EDA”, con participantes que representaban a Arm, Intel, Google, AMD y Meta (Facebook). La discusión fue organizada y moderada por Frank Schirrmeister de Cadence Design Systems.

La siguiente es una síntesis de la sesión del panel sobre los requisitos de EDA para respaldar la próxima era de la electrónica.

Frank prepara el escenario

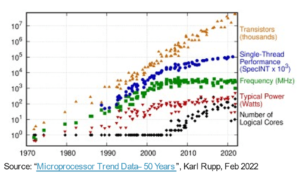

Haciendo referencia a un artículo de la revista Wired, Frank destaca cómo las cargas de trabajo del centro de datos se multiplicaron por seis entre 2010 y 2018. El tráfico de Internet se multiplicó por diez y la capacidad de almacenamiento se multiplicó por 25 durante el mismo período. Sin embargo, el uso de energía del centro de datos aumentó solo un 6% durante el mismo período y tenemos tecnología de semiconductores, arquitecturas de diseño y EDA para agradecerlo.

La industria electrónica está entrando en una era de arquitecturas y lenguajes específicos de dominio, como predijeron John Hennessy y David Patterson en 2018. Los factores principales que impulsan este movimiento son la computación a hiperescala, el procesamiento perimetral de alto rendimiento y la proliferación de dispositivos de consumo. Se espera que la próxima generación de dispositivos de consumo hiperconectados y siempre activos brinde experiencias de usuario inimaginables incluso hace unos años.

Global DataSphere cuantifica y analiza la cantidad de datos creados, capturados y replicados en un año determinado en todo el mundo. El crecimiento de la creación de datos de punto final se estima en una CAGR del 85 % entre 2019 y 2025 y 175 zettabytes en 2025. Es tanto como granos de arena hay en todas las playas del mundo. Eso es bastante información para ser procesada y tratada.

Todas las empresas en la sesión del panel están involucradas en la creación, el análisis, la captura y/o la reproducción de esta enorme cantidad de datos. La discusión cubrirá lo que ellos ven como sus requisitos en la industria de EDA.

Brazo – Chris Bergey

Desde una perspectiva de infraestructura, la participación de Arm es desde HPC hasta centros de datos, 5G y puertas de enlace perimetrales. La computación especializada es un área de gran enfoque ahora. La validación del sistema es clave cuando los clientes se comprometen a realizar grandes gastos de I+D. Cuando se trata de arquitecturas de chiplets que aprovechan las implementaciones 2D/2.5D/3D, es relativamente más fácil cuando todas las matrices y las reglas de diseño pertenecen a una sola empresa.

Para implementaciones heterogéneas, el empaquetado de múltiples chips generalmente se usa en mercados donde los márgenes son lo suficientemente altos para acomodar los esfuerzos de diseño adicionales, las consecuencias del rendimiento y el apilamiento de márgenes. En realidad, las implementaciones de chiplets híbridos ayudarán a que el mercado crezca más rápido. Se espera que la industria de EDA juegue un papel importante en hacer que la implementación de chiplets heterogéneos sea más fácil y robusta.

Intel – Rebecca Lipon

La memoria de alto ancho de banda (HBM) y los servidores de alta velocidad impulsaron el desarrollo de IP crítica que abrió las compuertas para una gran cantidad de aplicaciones y productos nuevos. La industria tiene que mantener su determinación de continuar en viajes similares y tratar de ir más allá. Por ejemplo, innovación a nivel de IP a nivel de empaque.

Open Compute Project (OCP) es la fundación iniciada por Meta hace una década. Muchas empresas, incluidas todas las empresas representadas en el panel de hoy, son miembros de esta fundación. Funciona en iniciativas que le permiten utilizar firmware y software abiertos que aceleran el desarrollo y prolongan la vida útil de los productos.

Una de las iniciativas en las que se centra OCP es la computación componible y el soporte de arquitecturas específicas de dominio. La industria de EDA debería analizar esto y considerar a Linux como un modelo para la comunidad de código abierto.

Google – Amir Salek

La cantidad de categorías de flujos de trabajo que se ejecutan en nuestros centros de datos globales es de miles. Y Google Cloud agrega una dimensión completamente nueva a la demanda de servir y procesar datos, admitiendo diferentes cargas de trabajo. Cada carga de trabajo tiene sus propias características y, aunque muchas de ellas pueden ejecutarse en hardware de propósito general, muchas más necesitan hardware personalizado.

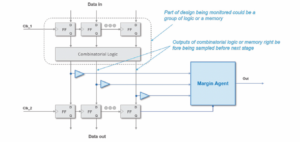

Las pruebas y la confiabilidad son las principales áreas de preocupación. Creo que esto juega un papel importante en términos de comprender las causas de la marginalidad y decidir cómo abordarlas. Mirando las cápsulas de TPU, estamos hablando de miles y miles de chips que se unen para trabajar en coordinación como una supercomputadora. Entonces, cualquier pequeño problema de confiabilidad durante las pruebas y los escapes de prueba, básicamente se magnifica. Y luego, después de muchos días, descubres que todo el esfuerzo fue básicamente inútil y tienes que repetir el trabajo nuevamente.

La creación de prototipos de FPGA es una gran plataforma para pruebas y validación. Estamos duplicando la emulación y la creación de prototipos cada año para asegurarnos de cerrar la brecha entre el hardware y el software.

AMD-Alex Starr

Desde el centro de datos hasta el consumidor, toda la pila de software debe ejecutarse en cualquier solución. Y muchos de nuestros diseños se implementan utilizando arquitectura de chiplets y eso trae consigo diferentes tipos de complejidad con los que lidiar. Lo que me quita el sueño es cómo verificar y validar estos sistemas complejos y llegar al mercado rápidamente.

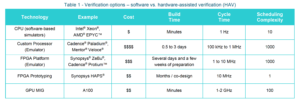

El mercado de emuladores de hardware y sistemas de creación de prototipos FPGA está en auge y es probablemente el área de mayor crecimiento dentro de EDA. Los emuladores de hoy pueden adaptarse a diseños muy grandes y ayudar a crear prototipos de dispositivos más grandes. Las plataformas de aceleración por hardware para poner diseños grandes son tremendamente caras y difíciles de conseguir trabajando a esa escala. Y, a medida que los diseños crecen a más de cinco mil millones de fechas, los emuladores no van a escalar. La emulación utilizada para la creación de prototipos está en su límite. Estamos buscando un tipo híbrido de enfoques basados en modelos. Los estamos refinando internamente y en colaboración con organismos de estándares externos. Realmente queremos extendernos a nuestros clientes OEM y sus ecosistemas también.

Meta (Facebook) – Drew Wingard

Estamos trabajando en chips para habilitar nuestra visión del Metaverso. Metaverse involucra dispositivos portátiles socialmente aceptables para todo el día, como anteojos de realidad aumentada. Esta nueva plataforma informática pone una enorme cantidad de recursos de procesamiento directamente en la cara. El resultado es que exige factores de forma muy ajustados, bajo consumo de energía y mínima disipación de calor.

Necesitamos poner diferentes partes del procesamiento en software y hardware. Necesitamos pensar mucho en las compensaciones entre latencias y rendimientos y el costo de la computación y el costo de la comunicación. Necesitamos una combinación de opciones en torno a diferentes clases de procesamiento heterogéneo y mucho apoyo en torno al modelado. Y tenemos que equilibrar el deseo de optimizar los requisitos versus ofrecer opciones porque nadie sabe cuál será la aplicación asesina.

Como empresa de consumo, la privacidad es increíblemente importante ya que se relaciona con el uso de nuestros productos. Nuestros productos deben ser socialmente aceptables tanto para las personas que los usan como para las personas frente a ellos.

Cuando combinamos todo lo anterior, la disponibilidad de modelos de sistemas y los tiempos de ciclo de diseño se vuelven increíblemente importantes. Muchos desafíos giran en torno a la disponibilidad de modelos y la interoperabilidad entre modelos. Aquí es donde continuar trabajando de cerca con la industria de EDA abre oportunidades.

Comparte esta publicación a través de: Fuente: https://semiwiki.com/eda/cadence/306880-how-system-companies-are-re-shaping-the-requirements-for-eda/

- 2019

- 2021

- 5G

- Nuestra Empresa

- a través de

- alex

- Todos

- AMD

- applicación

- aplicaciones

- arquitectura

- Reservada

- ARM

- en torno a

- artículo

- aumentado

- Realidad Aumentada

- Automatización

- disponibilidad

- Básicamente

- Playas

- MEJOR

- mil millones

- Poco

- Manojo

- Cadencia

- CAGR

- Capacidad

- retos

- Papas fritas

- Soluciones

- colaboración

- Comunicación

- vibrante e inclusiva

- Empresas

- compañía

- integraciones

- Calcular

- informática

- Congreso

- consumidor

- continue

- Creamos

- crítico

- Clientes

- datos

- Data Center

- los centros de datos

- Fechas

- acuerdo

- tratar

- debate

- Demanda

- Diseño

- desarrollar

- Desarrollo

- Dispositivos

- una experiencia diferente

- Dimensiones

- discutir

- dominio

- duplicación

- DE INSCRIPCIÓN

- conducción

- durante

- ecosistemas

- Southern Implants

- Electrónica

- ejemplo

- gastos

- Experiencias

- Cara

- factores importantes

- más rápida

- Firme

- cómodo

- Focus

- centrado

- formulario

- Fundación

- FPGA

- brecha

- gafas

- Buscar

- va

- Google Cloud

- Crecer

- Incremento

- Materiales

- ayuda

- Alta

- Cómo

- Como Hacer

- HTTPS

- Híbrido

- implementado

- importante

- Incluye

- aumentado

- energético

- EN LA MINA

- Innovation

- Intel

- Internet

- Interoperabilidad

- involucra

- IP

- IT

- Trabajos

- Clave

- Idiomas

- large

- más reciente

- Nivel

- Linux

- mirando

- gran

- Realizar

- Mercado

- Industrias

- Miembros

- Meta

- Metaverso

- modelo

- modelado

- modelos

- más,

- movimiento

- que ofrece

- habiertos

- abre

- Del Mañana

- Opciones

- embalaje

- la perspectiva

- plataforma

- Plataformas

- Jugar

- vainas

- industria

- presente

- política de privacidad

- Producto

- Productos

- proyecto

- prototipado

- I + D

- Realidad

- Requisitos

- Recursos

- Rodar

- reglas

- Ejecutar

- Escala

- semiconductor

- servicio

- similares

- So

- Software

- Soluciones

- Patrocinado

- estándares de salud

- fundó

- STORAGE

- supercomputadora

- SOPORTE

- te

- Todas las funciones a su disposición

- hablar

- Discursos

- Técnico

- Tecnología

- test

- Pruebas

- El metaverso

- el mundo

- equipo

- hoy

- de hoy

- juntos

- tráfico

- tremendo

- Versus

- visión

- vestibles

- ¿

- dentro de

- Actividades:

- trabajando

- funciona

- mundo

- mundo

- año

- años

- Rendimiento