Bild erstellt vom Herausgeber mit Midjourney

Willkommen zur dieswöchigen Ausgabe von „This Week in AI“ auf KDnuggets. Dieser kuratierte wöchentliche Beitrag soll Sie über die spannendsten Entwicklungen in der sich schnell entwickelnden Welt der künstlichen Intelligenz auf dem Laufenden halten. Von bahnbrechenden Schlagzeilen, die unser Verständnis der Rolle von KI in der Gesellschaft prägen, bis hin zu zum Nachdenken anregenden Artikeln, aufschlussreichen Lernressourcen und hervorgehobener Forschung, die die Grenzen unseres Wissens erweitert, bietet dieser Beitrag einen umfassenden Überblick über die aktuelle KI-Landschaft. Dieses wöchentliche Update soll Sie in diesem sich ständig weiterentwickelnden Bereich auf dem Laufenden und informiert halten. Bleiben Sie dran und viel Spaß beim Lesen!

In der Rubrik „Schlagzeilen“ werden die Top-Neuigkeiten und Entwicklungen der vergangenen Woche im Bereich Künstliche Intelligenz besprochen. Die Informationen reichen von staatlichen KI-Richtlinien bis hin zu technologischen Fortschritten und Unternehmensinnovationen im Bereich KI.

OpenAI steckt aufgrund der hohen Kosten für den Betrieb von ChatGPT und anderen KI-Diensten in finanziellen Schwierigkeiten. Trotz des schnellen frühen Wachstums ist die Nutzerbasis von ChatGPT in den letzten Monaten zurückgegangen. OpenAI kämpft darum, seine Technologie effektiv zu monetarisieren und nachhaltige Einnahmen zu generieren. Unterdessen wird weiterhin in besorgniserregendem Tempo Bargeld verschwendet. Da sich der Wettbewerb verschärft und der GPU-Mangel in Unternehmen die Modellentwicklung behindert, muss OpenAI dringend Wege zur Rentabilität finden. Gelingt dies nicht, droht dem bahnbrechenden KI-Startup möglicherweise der Bankrott.

???? Stability AI kündigt StableCode an, einen KI-Codierungsassistenten für Entwickler

Stability AI hat StableCode veröffentlicht, sein erstes generatives KI-Produkt, das für die Softwareentwicklung optimiert ist. StableCode umfasst mehrere Modelle, die auf über 500 Milliarden Code-Tokens trainiert wurden, um eine intelligente automatische Vervollständigung bereitzustellen, auf Anweisungen in natürlicher Sprache zu reagieren und große Codebereiche zu verwalten. Während Konversations-KI bereits Code schreiben kann, wurde StableCode speziell entwickelt, um die Produktivität von Programmierern durch das Verständnis der Codestruktur und -abhängigkeiten zu steigern. Mit seinen speziellen Schulungen und Modellen, die lange Kontexte verarbeiten können, zielt StableCode darauf ab, die Arbeitsabläufe der Entwickler zu verbessern und die Eintrittsbarriere für angehende Programmierer zu senken. Die Einführung stellt den Vorstoß von Stability AI in KI-gestützte Codierungstools inmitten des wachsenden Wettbewerbs in diesem Bereich dar.

???? Einführung von Superalignment von OpenAI

OpenAI arbeitet proaktiv an der Bewältigung potenzieller Risiken durch superintelligente KI durch sein neues Superalignment-Team, das Techniken wie Reinforcement Learning aus menschlichem Feedback nutzt, um KI-Systeme auszurichten. Hauptziele sind die Entwicklung skalierbarer Trainingsmethoden, die andere KI-Systeme nutzen, die Validierung der Modellrobustheit und Stresstests der gesamten Alignment-Pipeline, selbst bei absichtlich falsch ausgerichteten Modellen. Insgesamt möchte OpenAI zeigen, dass maschinelles Lernen durch bahnbrechende Ansätze zur verantwortungsvollen Steuerung der Superintelligenz sicher durchgeführt werden kann.

???? Lernen Sie beim Suchen (und Stöbern) mithilfe generativer KI

Google kündigt mehrere Aktualisierungen seiner KI-Funktionen zur Suchmaschinengenerierung (SGE) an, darunter Hover-Definitionen für Wissenschafts-/Geschichtsthemen, farbcodierte Syntaxhervorhebung für Codeübersichten und ein frühes Experiment namens „SGE beim Surfen“, das wichtige Punkte zusammenfasst und Benutzern hilft Erkunden Sie Seiten, wenn Sie lange Inhalte im Web lesen. Diese zielen darauf ab, das Verständnis komplexer Themen zu verbessern, die Verdauung von Codierungsinformationen zu verbessern und die Navigation und das Lernen beim Surfen der Benutzer zu unterstützen. Die Aktualisierungen stellen die kontinuierlichen Bemühungen von Google dar, sein KI-Sucherlebnis auf der Grundlage des Nutzerfeedbacks weiterzuentwickeln, wobei der Schwerpunkt auf dem Verständnis und der Extraktion wichtiger Details aus komplexen Webinhalten liegt.

???? Together.ai erweitert Llama2 auf ein 32-KB-Kontextfenster

LLaMA-2-7B-32K ist ein von Together Computer entwickeltes Open-Source-Sprachmodell mit langem Kontext, das die Kontextlänge von Metas LLaMA-2 auf 32K-Token erweitert. Es nutzt Optimierungen wie FlashAttention-2, um effizientere Inferenz und Training zu ermöglichen. Das Modell wurde mit einer Mischung aus Daten, darunter Büchern, Aufsätzen und Lehrdaten, vorab trainiert. Es werden Beispiele zur Feinabstimmung langer QS- und Zusammenfassungsaufgaben bereitgestellt. Benutzer können über Hugging Face auf das Modell zugreifen oder das OpenChatKit zur individuellen Feinabstimmung verwenden. Wie alle Sprachmodelle kann LLaMA-2-7B-32K voreingenommene oder falsche Inhalte generieren, was Vorsicht bei der Verwendung erfordert.

Der Abschnitt „Artikel“ präsentiert eine Reihe von zum Nachdenken anregenden Artikeln zum Thema künstliche Intelligenz. Jeder Artikel befasst sich eingehend mit einem bestimmten Thema und bietet den Lesern Einblicke in verschiedene Aspekte der KI, darunter neue Techniken, revolutionäre Ansätze und bahnbrechende Tools.

Mit LangChain können Entwickler leistungsfähige sprachbasierte KI-Apps erstellen, ohne das Rad neu erfinden zu müssen. Seine zusammensetzbare Struktur erleichtert das Mischen und Anpassen von Komponenten wie LLMs, Eingabeaufforderungsvorlagen, externen Tools und Speicher. Dies beschleunigt das Prototyping und ermöglicht die nahtlose Integration neuer Funktionen im Laufe der Zeit. Ganz gleich, ob Sie einen Chatbot, einen QA-Bot oder einen Multi-Step-Argument-Agenten erstellen möchten, LangChain bietet die Bausteine, um schnell fortschrittliche KI zusammenzustellen.

📰 So verwenden Sie ChatGPT zum Konvertieren von Text in eine PowerPoint-Präsentation

Der Artikel beschreibt einen zweistufigen Prozess für die Verwendung von ChatGPT zum Konvertieren von Text in eine PowerPoint-Präsentation, wobei zunächst der Text in Folientitel und Inhalt zusammengefasst wird und dann Python-Code generiert wird, um die Zusammenfassung mithilfe der Python-pptx-Bibliothek in das PPTX-Format zu konvertieren. Dies ermöglicht die schnelle Erstellung ansprechender Präsentationen aus langen Textdokumenten und erspart mühsamen manuellen Aufwand. Es werden klare Anweisungen zum Erstellen der ChatGPT-Eingabeaufforderungen und zum Ausführen des Codes bereitgestellt, was eine effiziente automatisierte Lösung für Präsentationsanforderungen bietet.

📰 Offene Herausforderungen in der LLM-Forschung

Der Artikel bietet einen Überblick über 10 wichtige Forschungsrichtungen zur Verbesserung großer Sprachmodelle: Reduzierung von Halluzinationen, Optimierung der Kontextlänge/-konstruktion, Einbeziehung multimodaler Daten, Beschleunigung von Modellen, Entwurf neuer Architekturen, Entwicklung von GPU-Alternativen wie photonischen Chips, Entwicklung verwendbarer Agenten, Verbesserung des Lernens menschliches Feedback, Verbesserung der Chat-Schnittstellen und Ausweitung auf nicht-englische Sprachen. Es zitiert relevante Veröffentlichungen in diesen Bereichen und weist auf Herausforderungen wie die Darstellung menschlicher Präferenzen für verstärktes Lernen und den Aufbau von Modellen für ressourcenarme Sprachen hin. Der Autor kommt zu dem Schluss, dass einige Themen wie die Mehrsprachigkeit zwar leichter zu bewältigen sind, andere wie die Architektur jedoch mehr Durchbrüche erfordern. Insgesamt wird sowohl technisches als auch nichttechnisches Fachwissen von Forschern, Unternehmen und der Gemeinschaft von entscheidender Bedeutung sein, um LLMs positiv zu steuern.

📰 Warum Sie (wahrscheinlich) kein LLM verfeinern müssen

Der Artikel bietet einen Überblick über 10 wichtige Forschungsrichtungen zur Verbesserung großer Sprachmodelle: Reduzierung von Halluzinationen, Optimierung der Kontextlänge/-konstruktion, Einbeziehung multimodaler Daten, Beschleunigung von Modellen, Entwurf neuer Architekturen, Entwicklung von GPU-Alternativen wie photonischen Chips, Entwicklung verwendbarer Agenten, Verbesserung des Lernens menschliches Feedback, Verbesserung der Chat-Schnittstellen und Ausweitung auf nicht-englische Sprachen. Es zitiert relevante Veröffentlichungen in diesen Bereichen und weist auf Herausforderungen wie die Darstellung menschlicher Präferenzen für verstärktes Lernen und den Aufbau von Modellen für ressourcenarme Sprachen hin. Der Autor kommt zu dem Schluss, dass einige Themen wie die Mehrsprachigkeit zwar leichter zu bewältigen sind, andere wie die Architektur jedoch mehr Durchbrüche erfordern. Insgesamt wird sowohl technisches als auch nichttechnisches Fachwissen von Forschern, Unternehmen und der Gemeinschaft von entscheidender Bedeutung sein, um LLMs positiv zu steuern.

📰 Best Practices zur Verwendung des OpenAI GPT-Modells

Der Artikel beschreibt Best Practices zum Erhalten hochwertiger Ausgaben bei Verwendung der GPT-Modelle von OpenAI und stützt sich dabei auf die Erfahrungen der Community. Es wird empfohlen, detaillierte Eingabeaufforderungen mit Einzelheiten wie Länge und Persona bereitzustellen. mehrstufige Anweisungen; Beispiele zum Nachahmen; Referenzen und Zitate; Zeit für kritisches Denken; und Codeausführung für Präzision. Das Befolgen dieser Tipps zum Anweisen der Modelle, wie z. B. das Festlegen von Schritten und Personas, kann zu genaueren, relevanteren und anpassbareren Ergebnissen führen. Der Leitfaden soll Benutzern dabei helfen, Eingabeaufforderungen effektiv zu strukturieren, um die leistungsstarken generativen Fähigkeiten von OpenAI optimal zu nutzen.

📰 Wir liegen alle falsch in Bezug auf KI

Der Autor argumentiert, dass die aktuellen KI-Fähigkeiten unterschätzt werden, und verwendet Beispiele wie Kreativität, Suche und Personalisierung, um verbreiteten Missverständnissen entgegenzuwirken. Er erklärt, dass KI kreativ sein kann, indem sie Konzepte neu kombiniert und nicht nur zufällige Ideen generiert; Es handelt sich nicht nur um eine leistungsstarke Suchmaschine wie Google; und es kann personalisierte Beziehungen entwickeln, nicht nur allgemeine Fähigkeiten. Der Autor ist sich zwar nicht sicher, welche Anwendungen sich als am nützlichsten erweisen werden, mahnt jedoch zu Offenheit und nicht zur Ablehnung und betont, dass sich das Potenzial von KI am besten durch fortgesetzte praktische Erkundung bestimmen lässt. Er kommt zu dem Schluss, dass unsere Vorstellungskraft in Bezug auf KI begrenzt ist und ihre Einsatzmöglichkeiten die aktuellen Vorhersagen wahrscheinlich weit übertreffen.

Der Abschnitt „Tools“ listet nützliche Apps und Skripte auf, die von der Community für diejenigen erstellt wurden, die sich mit praktischen KI-Anwendungen beschäftigen möchten. Hier finden Sie eine Reihe von Werkzeugtypen, von großen umfassenden Codebasen bis hin zu kleinen Nischenskripten. Beachten Sie, dass die Tools ohne Billigung und ohne jegliche Garantie weitergegeben werden. Machen Sie vor der Installation und Verwendung Ihrer Software Ihre eigenen Hausaufgaben!

️ MetaGPT: Das Multi-Agent-Framework

MetaGPT verwendet eine einzeilige Anforderung als Eingabe und gibt User Stories/Wettbewerbsanalysen/Anforderungen/Datenstrukturen/APIs/Dokumente usw. aus. Intern umfasst MetaGPT Produktmanager/Architekten/Projektmanager/Ingenieure. Es bietet den gesamten Prozess eines Softwareunternehmens zusammen mit sorgfältig orchestrierten SOPs.

Das Ziel dieses Projekts ist die Erforschung einer experimentellen neuen Pipeline zum Trainieren eines leistungsstarken aufgabenspezifischen Modells. Wir versuchen, die gesamte Komplexität zu abstrahieren, damit es so einfach wie möglich ist, von der Idee zum performanten, vollständig trainierten Modell zu gelangen.

Geben Sie einfach eine Beschreibung Ihrer Aufgabe ein und das System generiert einen Datensatz von Grund auf, analysiert ihn im richtigen Format und optimiert ein LLaMA 2-Modell für Sie.

DoctorGPT ist ein großes Sprachmodell, das die US-amerikanische medizinische Zulassungsprüfung bestehen kann. Dies ist ein Open-Source-Projekt mit der Mission, jedem seinen eigenen Privatarzt zur Verfügung zu stellen. DoctorGPT ist eine Version des 2-Milliarden-Parameter-großen Sprachmodells Llama7 von Meta, das anhand eines medizinischen Dialogdatensatzes verfeinert und dann mithilfe von Reinforcement Learning und Constitutional AI weiter verbessert wurde. Da das Modell nur 3 Gigabyte groß ist, passt es auf jedes lokale Gerät, sodass für die Nutzung keine API bezahlt werden muss.

- SEO-gestützte Content- und PR-Distribution. Holen Sie sich noch heute Verstärkung.

- PlatoData.Network Vertikale generative KI. Motiviere dich selbst. Hier zugreifen.

- PlatoAiStream. Web3-Intelligenz. Wissen verstärkt. Hier zugreifen.

- PlatoESG. Automobil / Elektrofahrzeuge, Kohlenstoff, CleanTech, Energie, Umwelt, Solar, Abfallwirtschaft. Hier zugreifen.

- PlatoHealth. Informationen zu Biotechnologie und klinischen Studien. Hier zugreifen.

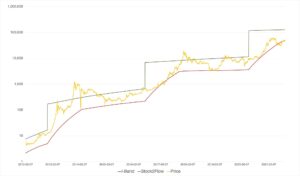

- ChartPrime. Verbessern Sie Ihr Handelsspiel mit ChartPrime. Hier zugreifen.

- BlockOffsets. Modernisierung des Eigentums an Umweltkompensationen. Hier zugreifen.

- Quelle: https://www.kdnuggets.com/2023/08/this-week-ai-2023-08-18.html?utm_source=rss&utm_medium=rss&utm_campaign=this-week-in-ai-august-18-openai-in-financial-trouble-stability-ai-announces-stablecode

- :hast

- :Ist

- :nicht

- $UP

- 000

- 10

- 11

- 14

- 2024

- 500

- 7

- a

- LiveBuzz

- ABSTRACT

- beschleunigt

- beschleunigend

- Zugang

- genau

- über

- Adresse

- advanced

- Fortschritte

- Vorrückend

- Makler

- Agenten

- AI

- KI-Dienste

- KI-Systeme

- Hilfe

- Ziel

- Ziel

- ausrichten

- Alle

- erlaubt

- entlang

- bereits

- Alternativen

- inmitten

- an

- Analyse

- und

- Kündigt an

- Ankündigung

- jedem

- Bienen

- APIs

- Anwendungen

- Ansätze

- Apps

- Architekten

- Architektur

- SIND

- Bereiche

- Argumentiert

- um

- Feld

- Artikel

- Artikel

- künstlich

- künstliche Intelligenz

- AS

- Aspekte

- strebend

- Assistentin

- At

- AUGUST

- Autor

- Automatisiert

- ein Weg

- bankrott

- Bankruptcy

- Barriere

- Base

- basierend

- BE

- BESTE

- Best Practices

- voreingenommen

- Milliarde

- Milliarden Token

- Blockiert

- Bücher

- Auftrieb

- Wander- und Outdoorschuhen

- beide

- Grenzen

- Durchbrüche

- Browsing

- bauen

- Building

- Gebäudemodelle

- brennen

- beschäftigt

- by

- namens

- CAN

- Fähigkeiten

- fähig

- vorsichtig

- Bargeld

- Vorsicht

- Herausforderungen

- Chatbot

- ChatGPT

- Pommes frites

- klar

- Code

- Programmierung

- gemeinsam

- community

- Unternehmen

- Unternehmen

- zwingend

- Wettbewerb

- wettbewerbsfähig

- Komplex

- Komplexität

- Komponenten

- umfassend

- Computer

- Konzepte

- durchgeführt

- Inhalt

- Kontext

- Kontexte

- weiter

- weiter

- Konversations

- Konversations-KI

- verkaufen

- Unternehmen

- Kosten

- Counter

- erstellen

- erstellt

- Schaffung

- Kreativ (Creative)

- Kreativität

- kritischem

- kuratiert

- Strom

- anpassbare

- maßgeschneiderte

- technische Daten

- tief

- Definitionen

- Abhängigkeiten

- Beschreibung

- entworfen

- Entwerfen

- Trotz

- detailliert

- Details

- Bestimmen

- entwickeln

- entwickelt

- Entwickler:in / Unternehmen

- Entwickler

- Entwicklung

- Entwicklung

- Entwicklungen

- Gerät

- Dialog

- Richtungen

- do

- Arzt

- Unterlagen

- Nicht

- Zeichnung

- zwei

- jeder

- Früh

- Einfache

- Ausgabe

- Herausgeber

- effektiv

- effizient

- Bemühungen

- Betonung

- ermöglichen

- Eingriff

- Motor

- Ingenieure

- zu steigern,

- Eine Verbesserung der

- Unternehmen

- Ganz

- Eintrag

- etc

- Äther (ETH)

- Sogar

- Jedes

- jedermann

- entwickelt sich

- Prüfung

- Beispiele

- überschreiten

- Ausführung

- Ausbau

- ERFAHRUNGEN

- Experiment

- experimentell

- Expertise

- Exploration

- ERKUNDEN

- erweitern

- erweitert

- extern

- Gesicht

- zugewandt

- scheitert

- weit

- Feedback

- Feld

- Revolution

- Finden Sie

- Vorname

- Setzen Sie mit Achtsamkeit

- Folgende

- Aussichten für

- Beutezug

- Format

- für

- voller

- weiter

- erzeugen

- Erzeugung

- Generation

- generativ

- Generative KI

- bekommen

- Go

- Kundenziele

- Ziele

- staatlich

- GPU

- Bahnbrechend

- bahnbrechend

- persönlichem Wachstum

- Wachstum

- Garantie

- die Vermittlung von Kompetenzen,

- Griff

- praktische

- glücklich

- he

- Schlagzeilen

- Hilfe

- hilft

- hier

- GUTE

- leistungsstark

- hochwertige

- Hervorheben

- Hausaufgaben

- Horizont

- schweben

- HTML

- HTTPS

- human

- Idee

- Ideen

- if

- Phantasie

- zu unterstützen,

- verbessert

- Verbesserung

- in

- Dazu gehören

- Einschließlich

- beinhaltet

- einarbeiten

- Information

- informiert

- Innovationen

- Varianten des Eingangssignals:

- aufschlussreiche

- Einblicke

- Installation

- Lehr-

- Anleitung

- Integration

- Intelligenz

- Intelligent

- absichtlich

- Schnittstellen

- innen

- in

- Probleme

- IT

- SEINE

- nur

- KDnuggets

- Behalten

- Wesentliche

- Wissen

- Landschaft

- Sprache

- Sprachen

- grosse

- starten

- führen

- lernen

- Länge

- Hebelwirkungen

- Nutzung

- Bibliothek

- Lizenzierung

- Gefällt mir

- wahrscheinlich

- Limitiert

- Line

- Listen

- Lama

- aus einer regionalen

- Lang

- suchen

- senken

- Maschine

- Maschinelles Lernen

- MACHT

- verwalten

- Manager

- manuell

- Spiel

- Kann..

- Mittlerweile

- sowie medizinische

- Memory

- nur

- Meta

- Methoden

- Geist / Bewusstsein

- Missverständnisse

- Ziel

- mischen

- Mischung

- Modell

- für

- monetarisieren

- Monat

- mehr

- effizienter

- vor allem warme

- mehrere

- Natürliche

- Natürliche Sprache

- Menü

- Need

- Bedürfnisse

- Neu

- News

- Nische

- nicht

- Nicht-technisch

- Bemerkens

- beschaffen

- of

- bieten

- on

- EINEM

- einzige

- XNUMXh geöffnet

- Open-Source-

- OpenAI

- optimiert

- Optimierung

- or

- orchestriert

- Andere

- Anders

- UNSERE

- Umrissen

- übrig

- Gesamt-

- Überwindung

- Überblick

- besitzen

- Seiten

- Papiere

- Parameter

- passieren

- passt

- AUFMERKSAMKEIT

- Personalisierung

- Personalisiert

- Stücke

- Pionierarbeit

- Pipeline

- Plato

- Datenintelligenz von Plato

- PlatoData

- Punkte

- Politik durchzulesen

- möglich

- Post

- Potenzial

- größte treibende

- Praktisch

- Praktiken

- Präzision

- Prognosen

- Vorlieben

- presentation

- Presentations

- Geschenke

- Vor

- privat

- wahrscheinlich

- Prozessdefinierung

- Produkt

- PRODUKTIVITÄT

- Rentabilität

- Programmierer

- Projekt

- Prototyping

- Belegen

- die

- vorausgesetzt

- bietet

- Bereitstellung

- Schieben

- Python

- F&A

- zufällig

- Angebot

- schnell

- schnell

- Bewerten

- lieber

- RE

- Leser

- Lesebrillen

- kürzlich

- empfiehlt

- Reduzierung

- Referenzen

- Verstärkung lernen

- Beziehungen

- freigegeben

- relevant

- vertreten

- Darstellen

- representiert

- erfordern

- Anforderung

- Voraussetzungen:

- Forschungsprojekte

- Forscher

- Downloads

- Reagieren

- Die Ergebnisse

- Einnahmen

- Revolutionär

- Recht

- Risiken

- Robustheit

- Rollen

- Laufen

- s

- sicher

- skalierbaren

- kratzen

- Skripte

- nahtlos

- Suche

- Suchmaschine

- Abschnitt

- Lösungen

- mehrere

- Form

- von Locals geführtes

- Engpässe

- erklären

- da

- Größe

- Fähigkeiten

- Schlitten

- klein

- So

- Gesellschaft

- Software

- Software-Entwicklung

- Lösung

- einige

- Raumfahrt

- überspannt

- spezialisiert

- spezifisch

- Besonderheiten

- Stabilität

- Anfang

- Staaten

- bleiben

- Shritte

- Geschichten

- Der Stress

- Struktur

- Struggling

- so

- ZUSAMMENFASSUNG

- Superintelligenz

- nachhaltiger

- Syntax

- System

- Systeme und Techniken

- nimmt

- Aufgabe

- und Aufgaben

- Team

- Technische

- Techniken

- technologische

- Technologie

- Vorlagen

- Testen

- als

- zur Verbesserung der Gesundheitsgerechtigkeit

- Das

- die Informationen

- ihr

- dann

- Dort.

- Diese

- Denken

- fehlen uns die Worte.

- diese Woche

- diejenigen

- zum Nachdenken anregen

- Durch

- Zeit

- Tipps

- Titel

- zu

- gemeinsam

- Tokens

- Werkzeug

- Werkzeuge

- Top

- Thema

- Themen

- Training

- trainiert

- Ausbildung

- Ärger

- versuchen

- Typen

- Verständnis

- Aktualisierung

- aktualisiert

- Updates

- Triebe

- us

- verwendbar

- -

- Mitglied

- Nutzer

- verwendet

- Verwendung von

- validieren

- verschiedene

- Version

- wollen

- wurde

- Weg..

- we

- Netz

- Woche

- wöchentlich

- Rad

- wann

- ob

- welche

- während

- WHO

- werden wir

- mit

- ohne

- Workflows

- arbeiten,

- weltweit wie ausgehandelt und gekauft ausgeführt wird.

- schreiben

- Code schreiben

- Falsch

- U

- Ihr

- Zephyrnet