Ich habe kürzlich mit Stelios Diamantidis (Distinguished Architect, Head of Strategy, Autonomous Design Solutions) über die Ankündigung von Synopsys zum 100th Kunden-Tapeout mit ihrer DSO.ai-Lösung. Meine Sorge zu KI-bezogenen Artikeln besteht darin, den Hype zu vermeiden, der KI im Allgemeinen umgibt, und umgekehrt die Skepsis als Reaktion auf diesen Hype, die einige dazu veranlasst, alle KI-Behauptungen als Schlangenöl abzutun. Ich war froh, Stelios lachen zu hören und stimme ihm von ganzem Herzen zu. Wir hatten eine sehr fundierte Diskussion darüber, was DSO.ai heute kann, was ihre Referenzkunden in der Lösung sehen (basierend auf dem, was es heute kann) und was er mir über die Technologie sagen könnte.

Was DSO.ai tut

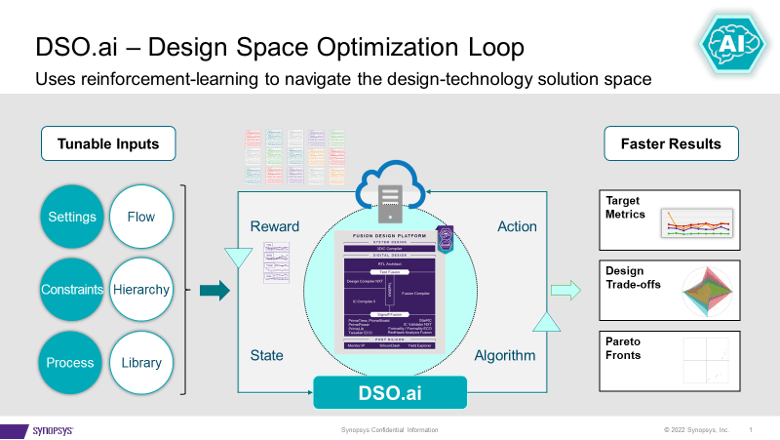

DSO.ai ist mit Fusion Compiler und IC Compiler II gekoppelt, was, wie Stelios betonte, bedeutet, dass dies eine Optimierungslösung auf Blockebene ist; Vollständige SoCs sind noch kein Ziel. Dies passt zu aktuellen Designpraktiken, wie Stelios sagte, ein wichtiges Ziel ist es, sich leicht in bestehende Abläufe einzufügen. Der Zweck der Technologie besteht darin, Implementierungsingenieuren, oft einem einzigen Ingenieur, die Möglichkeit zu geben, ihre Produktivität zu verbessern und gleichzeitig einen größeren Designraum für eine bessere PPA zu erkunden, als es sonst möglich gewesen wäre.

Synopsys kündigte das erste Tapeout im Sommer 2021 an und hat nun 100 Tapeouts angekündigt. Das spricht für die Nachfrage und Wirksamkeit einer solchen Lösung. Stelios fügte hinzu, dass der Wert für Anwendungen, die einen Block viele Male instanziieren müssen, noch deutlicher wird. Denken Sie an einen Many-Core-Server, eine GPU oder einen Netzwerk-Switch. Optimieren Sie einen Block einmal, instanziieren Sie ihn viele Male – das kann zu einer erheblichen PPA-Verbesserung führen.

Ich habe gefragt, ob Kunden, die dies tun, alle mit 7 nm und darunter arbeiten. Überraschenderweise gibt es eine aktive Nutzung bis zu 40 nm. Ein interessantes Beispiel ist ein Flash-Controller, ein Design, das nicht sehr leistungsempfindlich ist, aber mehrere zehn bis hundert Millionen Einheiten ausführen kann. Eine Reduzierung der Größe um sogar 5 % kann hier einen großen Einfluss auf die Margen haben.

Was ist unter der Haube

DSO.ai basiert auf Reinforcement Learning, ein heißes Thema dieser Tage, aber ich habe in diesem Artikel keinen Hype versprochen. Ich bat Stelios, ein bisschen mehr ins Detail zu gehen, war aber nicht überrascht, als er sagte, er könne nicht zu viel preisgeben. Was er mir sagen konnte, war interessant genug. Er wies darauf hin, dass in allgemeineren Anwendungen ein Zyklus durch einen Trainingssatz (eine Epoche) eine schnelle (Sekunden bis Minuten) Methode voraussetzt, um die nächsten möglichen Schritte zu bewerten, beispielsweise durch Gradientenvergleiche.

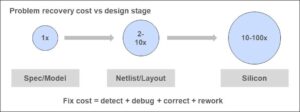

Aber ernsthaftes Blockdesign kann nicht mit schnellen Schätzungen optimiert werden. Jeder Versuch muss den gesamten Produktionsfluss durchlaufen und realen Herstellungsprozessen zugeordnet werden. Flows, deren Ausführung Stunden dauern kann. Ein Teil der Strategie für effektives bestärkendes Lernen angesichts dieser Einschränkung ist Parallelität. Der Rest ist die geheime Sauce von DSO.ai. Sicherlich können Sie sich vorstellen, dass, wenn diese geheime Sauce basierend auf einer bestimmten Epoche effektive Verfeinerungen hervorbringen kann, Parallelismus den Fortschritt durch die nächste Epoche beschleunigen wird.

Zu diesem Zweck muss diese Funktion wirklich in einer Cloud ausgeführt werden, um Parallelität zu unterstützen. Private On-Premises Cloud ist eine Option. Microsoft hat angekündigt, dass sie DSO.ai auf Azure hosten, und ST berichtet in der Pressemitteilung von DSO.ai, dass sie diese Fähigkeit genutzt haben, um die Implementierung eines ARM-Kerns zu optimieren. Ich kann mir vorstellen, dass es einige interessante Debatten über die Vor- und Nachteile einer Optimierung in einer öffentlichen Cloud auf beispielsweise 1000 Servern geben könnte, wenn sich die Flächenreduzierung lohnt.

Kunden-Feedback

Synopsys behauptet, dass Kunden (einschließlich ST und SK Hynix in dieser Ankündigung) eine Produktivitätssteigerung von mehr als dem Dreifachen, eine bis zu 3 % niedrigere Gesamtleistung und eine deutliche Reduzierung der Chipgröße bei reduziertem Einsatz von Gesamtressourcen melden. Angesichts dessen, was Stelios beschrieben hat, klingt das für mich vernünftig. Das Werkzeug ermöglicht die Untersuchung von mehr Punkten im Entwurfszustandsraum innerhalb eines gegebenen Zeitplans, als dies bei einer manuellen Untersuchung möglich wäre. Solange der Suchalgorithmus (die geheime Zutat) effektiv ist, würde das natürlich ein besseres Optimum finden als eine manuelle Suche.

Kurz gesagt, weder KI-Hype noch Schlangenöl. DSO.ai schlägt vor, dass KI als glaubwürdige technische Erweiterung bestehender Abläufe in den Mainstream eintritt. Sie können mehr von erfahren Pressemitteilung kostenlose Sprach- und Videotelefonie über das Internet dieses Blog.

Teile diesen Beitrag über:

- SEO-gestützte Content- und PR-Distribution. Holen Sie sich noch heute Verstärkung.

- Platoblockkette. Web3-Metaverse-Intelligenz. Wissen verstärkt. Hier zugreifen.

- Quelle: https://semiwiki.com/artificial-intelligence/324430-synopsys-design-space-optimization-hits-a-milestone/

- 100

- 2021

- a

- Über uns

- beschleunigen

- über

- aktiv

- hinzugefügt

- AI

- Algorithmus

- Alle

- erlaubt

- und

- angekündigt

- Ankündigung

- Anwendungen

- Bereich

- ARM

- um

- Artikel

- Artikel

- Autonom

- Vermeidung von

- Azure

- basierend

- wird

- unten

- Besser

- Big

- Bit

- Blockieren

- vorsichtig

- sicherlich

- aus aller Welt

- Cloud

- wie die

- Hautpflegeprobleme

- Nachteile

- Controller

- Kernbereich

- könnte

- Kurs

- glaubwürdig

- Strom

- Kunde

- Kunden

- Zyklus

- Tage

- Debatten

- Demand

- beschrieben

- Design

- Sterben

- Diskussion

- Entfernen

- Distinguished

- Dabei

- nach unten

- jeder

- leicht

- Effektiv

- Wirksamkeit

- betonen

- ermöglichen

- Ingenieur

- Entwicklung

- Ingenieure

- genug

- Epoche

- Schätzungen

- Sogar

- Beispiel

- vorhandenen

- Exploration

- Möglichkeiten sondieren

- Erweiterung

- FAST

- Finden Sie

- Vorname

- passen

- Blinken (Flash)

- Fluss

- Fließt

- für

- voller

- Verschmelzung

- Allgemeines

- gegeben

- Kundenziele

- GPU

- glücklich

- ganzer

- hier

- Treffer

- Hosting

- HEISS

- STUNDEN

- HTTPS

- Hype

- Impact der HXNUMXO Observatorien

- Implementierung

- wichtig

- zu unterstützen,

- Verbesserung

- in

- Einschließlich

- Steigert

- interessant

- IT

- größer

- lachen

- LERNEN

- lernen

- Lang

- gemacht

- Mainstream

- manuell

- Herstellung

- viele

- Mapping

- Margen

- max-width

- Mittel

- Methode

- Microsoft

- könnte

- Meilenstein

- Million

- Minuten

- mehr

- Weder

- Netzwerk

- weiter

- offensichtlich

- ÖL

- EINEM

- Optimierung

- Optimieren

- optimiert

- Optimum

- Option

- Andernfalls

- Gesamt-

- Teil

- Leistung

- Plato

- Datenintelligenz von Plato

- PlatoData

- Points

- Punkte

- möglich

- Post

- Werkzeuge

- Praktiken

- Presse

- Pressemitteilung

- privat

- anpassen

- Produktion

- PRODUKTIVITÄT

- Fortschritt

- versprochen

- PROS

- Öffentlichkeit

- Public Cloud

- Zweck

- Direkt

- Reaktion

- echt

- vernünftig

- kürzlich

- Reduziert

- Reduzierung

- Verstärkung lernen

- Release

- berichten

- Reporting

- Downloads

- REST

- zeigen

- Führen Sie

- Laufen

- Said

- Zeitplan

- Suche

- Sekunden

- Die Geheime

- empfindlich

- ernst

- kompensieren

- Short

- signifikant

- Single

- Größe

- Skepsis

- Lösung

- Lösungen

- einige

- Raumfahrt

- spricht

- Bundesstaat

- Shritte

- Strategie

- Schlägt vor

- Sommer

- Support

- überrascht

- Schalter

- Nehmen

- Target

- Technologie

- Das

- Die Gegend

- ihr

- Durch

- mal

- zu

- heute

- auch

- Werkzeug

- Thema

- Gesamt

- Ausbildung

- Versuch

- für

- Einheiten

- -

- Wert

- Was

- welche

- während

- werden wir

- .

- arbeiten,

- wert

- würde

- Zephyrnet