Das rasante Wachstum der generativen KI bringt vielversprechende neue Innovationen mit sich und wirft gleichzeitig neue Herausforderungen auf. Zu diesen Herausforderungen gehören einige, die vor der generativen KI üblich waren, wie z. B. Voreingenommenheit und Erklärbarkeit Neue, die nur für Foundation-Modelle gelten (FMs), einschließlich Halluzination und Toxizität. Bei AWS sind wir dazu verpflichtet Generative KI verantwortungsvoll entwickeln, Wir verfolgen einen menschenzentrierten Ansatz, der Bildung, Wissenschaft und unsere Kunden in den Vordergrund stellt, um verantwortungsvolle KI über den gesamten KI-Lebenszyklus hinweg zu integrieren.

Im vergangenen Jahr haben wir neue Funktionen in unsere generativen KI-Anwendungen und -Modelle eingeführt, wie zum Beispiel integrierte Sicherheitsscans Amazon Code Whisperer, Schulung zum Erkennen und Blockieren schädlicher Inhalte Amazonas-Titan, und Datenschutz in Amazonas Grundgestein. Unsere Investition in sichere, transparente und verantwortungsvolle generative KI umfasst die Zusammenarbeit mit der globalen Gemeinschaft und politischen Entscheidungsträgern, da wir beides gefördert und unterstützt haben Freiwillige KI-Verpflichtungen des Weißen Hauses und KI-Sicherheitsgipfel im Vereinigten Königreich. Und wir arbeiten weiterhin Hand in Hand mit Kunden zusammen, um verantwortungsvolle KI mit speziell entwickelten Tools wie zu implementieren Amazon SageMaker klären, ML-Governance mit Amazon SageMakerUnd vieles mehr.

Einführung neuer verantwortungsvoller KI-Innovationen

Da generative KI auf neue Branchen, Organisationen und Anwendungsfälle ausgeweitet wird, muss dieses Wachstum mit einer nachhaltigen Investition in eine verantwortungsvolle FM-Entwicklung einhergehen. Kunden möchten, dass ihre FMs unter Berücksichtigung von Sicherheit, Fairness und Schutz gebaut werden, damit sie wiederum KI verantwortungsvoll einsetzen können. Wir freuen uns, auf der diesjährigen AWS re:Invent neue Funktionen zur Förderung verantwortungsvoller generativer KI-Innovationen in einem breiten Spektrum von Funktionen ankündigen zu können, darunter neue integrierte Tools, Kundenschutz, Ressourcen zur Verbesserung der Transparenz und Tools zur Bekämpfung von Desinformation. Unser Ziel ist es, Kunden die Informationen zur Verfügung zu stellen, die sie benötigen, um FMs im Hinblick auf wichtige Gesichtspunkte der verantwortungsvollen KI wie Toxizität und Robustheit zu bewerten, und Leitplanken einzuführen, um Schutzmaßnahmen auf der Grundlage von Kundenanwendungsfällen und Richtlinien für verantwortungsvolle KI anzuwenden. Gleichzeitig möchten unsere Kunden besser über die Sicherheit, Fairness, Sicherheit und andere Eigenschaften von KI-Diensten und FMs informiert werden, wenn sie diese in ihrer eigenen Organisation nutzen. Wir freuen uns, weitere Ressourcen ankündigen zu können, die Kunden dabei helfen sollen, unsere AWS-KI-Services besser zu verstehen und die von ihnen gewünschte Transparenz zu liefern.

Umsetzung von Schutzmaßnahmen: Leitplanken für Amazon Bedrock

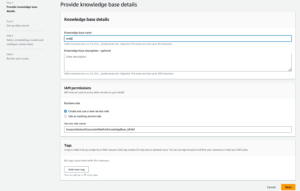

Sicherheit hat Priorität, wenn es um die Einführung generativer KI in großem Maßstab geht. Unternehmen möchten sichere Interaktionen zwischen ihren Kunden und generative KI-Anwendungen fördern, die schädliche oder beleidigende Sprache vermeiden und mit den Unternehmensrichtlinien übereinstimmen. Der einfachste Weg, dies zu erreichen, besteht darin, in der gesamten Organisation einheitliche Sicherheitsvorkehrungen zu treffen, damit jeder sicher Innovationen durchführen kann. Gestern haben wir die Vorschau von angekündigt Leitplanken für Amazon Bedrock– eine neue Funktion, die es einfach macht, anwendungsspezifische Schutzmaßnahmen basierend auf Kundenanwendungsfällen und verantwortungsvollen KI-Richtlinien zu implementieren.

Leitplanken sorgen für Konsistenz bei der Reaktion von FMs auf Amazon Bedrock auf unerwünschte und schädliche Inhalte in Anwendungen. Kunden können Leitplanken auf große Sprachmodelle auf Amazon Bedrock sowie auf fein abgestimmte Modelle und in Kombination mit anwenden Agenten für Amazon Bedrock. Mit Guardrails können Sie Themen angeben, die vermieden werden sollen, und der Dienst erkennt und verhindert automatisch Anfragen und Antworten, die in eingeschränkte Kategorien fallen. Kunden können auch Schwellenwerte für Inhaltsfilter für verschiedene Kategorien konfigurieren, darunter Hassreden, Beleidigungen, sexualisierte Sprache und Gewalt, um schädliche Inhalte bis zum gewünschten Grad herauszufiltern. Beispielsweise kann eine Online-Banking-Anwendung eingerichtet werden, um Anlageberatung zu vermeiden und unangemessene Inhalte (wie Hassreden, Beleidigungen und Gewalt) einzuschränken. In naher Zukunft werden Kunden auch in der Lage sein, personenbezogene Daten (PII) in Benutzereingaben und Antworten von FMs zu schwärzen, Obszönitätsfilter festzulegen und eine Liste mit benutzerdefinierten Wörtern bereitzustellen, die bei Interaktionen zwischen Benutzern und FMs blockiert werden sollen, um die Compliance zu verbessern und vieles mehr Schutz der Benutzer. Mit Guardrails können Sie mit generativer KI schneller Innovationen einführen und gleichzeitig Schutzmaßnahmen im Einklang mit den Unternehmensrichtlinien aufrechterhalten.

Identifizieren des besten FM für einen bestimmten Anwendungsfall: Modellbewertung in Amazon Bedrock

Heutzutage verfügen Unternehmen über eine breite Palette von FM-Optionen, um ihre generativen KI-Anwendungen voranzutreiben. Um das richtige Gleichgewicht zwischen Genauigkeit und Leistung für ihren Anwendungsfall zu finden, müssen Unternehmen Modelle effizient vergleichen und die beste Option auf der Grundlage der für sie wichtigen verantwortungsvollen KI und Qualitätsmetriken finden. Um Modelle zu bewerten, müssen Unternehmen zunächst Tage damit verbringen, Benchmarks zu ermitteln, Bewertungstools einzurichten und Bewertungen durchzuführen, was alles umfassende Fachkenntnisse in der Datenwissenschaft erfordert. Darüber hinaus sind diese Tests nicht für die Bewertung subjektiver Kriterien (z. B. Markenstimme, Relevanz und Stil) geeignet, die eine Beurteilung durch langwierige, zeitintensive menschliche Überprüfungsabläufe erfordern. Die Zeit, das Fachwissen und die Ressourcen, die für diese Bewertungen – für jeden neuen Anwendungsfall – erforderlich sind, machen es für Unternehmen schwierig, Modelle anhand verantwortungsvoller KI-Dimensionen zu bewerten und eine fundierte Entscheidung darüber zu treffen, welches Modell ihren Kunden das genaueste und sicherste Erlebnis bietet.

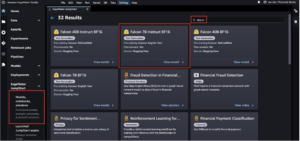

Jetzt als Vorschau verfügbar, Modellbewertung auf Amazon Bedrock hilft Kunden, die besten FMs für ihren spezifischen Anwendungsfall zu bewerten, zu vergleichen und auszuwählen, basierend auf benutzerdefinierten Metriken wie Genauigkeit und Sicherheit, wobei entweder automatische oder menschliche Bewertungen verwendet werden. In der Amazon Bedrock-Konsole wählen Kunden die FMs aus, die sie für eine bestimmte Aufgabe vergleichen möchten, beispielsweise für die Beantwortung von Fragen oder die Zusammenfassung von Inhalten. Für automatische Bewertungen wählen Kunden vordefinierte Bewertungskriterien (z. B. Genauigkeit, Robustheit und Toxizität) aus und laden ihren eigenen Testdatensatz hoch oder wählen aus integrierten, öffentlich verfügbaren Datensätzen aus. Für subjektive Kriterien oder differenzierte Inhalte, die ein Urteilsvermögen erfordern, können Kunden mit nur wenigen Klicks ganz einfach menschliche Bewertungsworkflows einrichten. Diese Workflows nutzen das interne Arbeitsteam eines Kunden oder nutzen eine von AWS bereitgestellte verwaltete Belegschaft, um Modellantworten auszuwerten. Bei menschenbasierten Bewertungen definieren Kunden anwendungsfallspezifische Kennzahlen (z. B. Relevanz, Stil und Markenstimme). Sobald Kunden den Einrichtungsprozess abgeschlossen haben, führt Amazon Bedrock Auswertungen durch und generiert einen Bericht, sodass Kunden leicht nachvollziehen können, wie das Modell im Hinblick auf wichtige Sicherheits- und Genauigkeitskriterien funktioniert, und das beste Modell für ihren Anwendungsfall auswählen können.

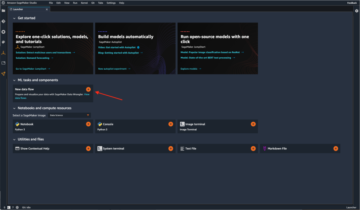

Diese Fähigkeit zur Modellbewertung ist nicht auf Amazon Bedrock beschränkt. Kunden können die Modellbewertung auch in Amazon SageMaker Clarify verwenden, um die beste FM-Option anhand wichtiger Qualitäts- und Verantwortungsmetriken wie Genauigkeit, Robustheit und Toxizität einfach zu bewerten, zu vergleichen und auszuwählen alle FMs.

Bekämpfung von Desinformation: Wasserzeichen in Amazon Titan

Heute haben wir es angekündigt Amazon Titan-Bildgenerator in der Vorschau, die es Kunden ermöglicht, schnell und in großem Maßstab qualitativ hochwertige Bilder zu erstellen und zu verbessern. Wir haben in jeder Phase des Modellentwicklungsprozesses eine verantwortungsvolle KI berücksichtigt, einschließlich der Auswahl von Trainingsdaten, dem Aufbau von Filterfunktionen zur Erkennung und Entfernung unangemessener Benutzereingaben und Modellausgaben sowie der Verbesserung der demografischen Vielfalt unserer Modellausgaben. Alle von Amazon Titan generierten Bilder enthalten standardmäßig ein unsichtbares Wasserzeichen, das dazu beitragen soll, die Verbreitung von Desinformation zu reduzieren, indem es einen diskreten Mechanismus zur Identifizierung von KI-generierten Bildern bietet. AWS gehört zu den ersten Modellanbietern, die in großem Umfang integrierte unsichtbare Wasserzeichen herausbringen, die in Bildausgaben integriert werden und so konzipiert sind, dass sie änderungsresistent sind.

Vertrauen aufbauen: Mit Entschädigung hinter unseren Modellen und Anwendungen stehen

Der Aufbau von Kundenvertrauen ist für AWS von zentraler Bedeutung. Wir sind seit unserer Gründung mit unseren Kunden auf einer Reise und mit dem Wachstum der generativen KI sind wir weiterhin bestrebt, gemeinsam innovative Technologien zu entwickeln. Damit Kunden die Leistungsfähigkeit unserer generativen KI nutzen können, müssen sie wissen, dass sie geschützt sind. AWS bietet Urheberrechtsentschädigungsschutz für Ausgaben der folgenden generativen KI-Dienste von Amazon: Amazon Titan Text Express, Amazon Titan Text Lite, Amazon Titan Embeddings, Amazon Titan Multimodal Embeddings, Amazon CodeWhisperer Professional, AWS HealthScribe, Amazon Lex und Amazon personalisieren. Dies bedeutet, dass Kunden, die die Dienste verantwortungsvoll nutzen, vor Ansprüchen Dritter wegen angeblicher Urheberrechtsverletzungen durch die von diesen Diensten generierten Ergebnisse geschützt sind (siehe Abschnitt 50.10 der Servicebedingungen). Darüber hinaus schützt unsere Standard-IP-Entschädigung für die Nutzung der Dienste Kunden vor Ansprüchen Dritter wegen angeblicher IP-Verletzung durch die Dienste und die zu ihrer Schulung verwendeten Daten. Anders ausgedrückt: Wenn Sie einen der oben aufgeführten generativen KI-Dienste von Amazon nutzen und jemand Sie wegen IP-Verletzung verklagt, verteidigt AWS diese Klage, einschließlich der Übernahme etwaiger Urteile gegen Sie oder der Vergleichskosten.

Wir stehen hinter unseren generativen KI-Diensten und arbeiten daran, diese kontinuierlich zu verbessern. Während AWS neue Dienste einführt und die generative KI weiterentwickelt, wird sich AWS weiterhin unermüdlich darauf konzentrieren, das Vertrauen der Kunden zu gewinnen und aufrechtzuerhalten.

Für mehr Transparenz: AWS AI Service Card für Amazon Titan Text

We führte AWS AI Service Cards ein bei re:Invent 2022 als Transparenzressource, um Kunden dabei zu helfen, unsere AWS-KI-Services besser zu verstehen. AI Service Cards sind eine Form der verantwortungsvollen KI-Dokumentation, die Kunden einen zentralen Ort bietet, an dem sie Informationen zu den beabsichtigten Anwendungsfällen und Einschränkungen, verantwortungsvollen KI-Designentscheidungen sowie Best Practices für die Bereitstellung und Leistungsoptimierung unserer KI-Dienste finden können. Sie sind Teil eines umfassenden Entwicklungsprozesses, den wir unternehmen, um unsere Dienste auf verantwortungsvolle Weise aufzubauen, der Fairness, Erklärbarkeit, Wahrhaftigkeit und Robustheit, Governance, Transparenz, Datenschutz und Sicherheit, Sicherheit und Kontrollierbarkeit berücksichtigt.

Bei re:Invent kündigen wir dieses Jahr eine an neue AI Service Card für Amazon Titan Text zur Erhöhung der Transparenz in Stiftungsmodellen. Wir führen außerdem vier neue AI Service Cards ein, darunter: Amazon Comprehend PII erkennen, Amazon Transcribe-Toxizitätserkennung, Amazon Rekognition Face Liveness und AWS HealthScribe. Sie können jede dieser Karten auf der erkunden AWS-Website. Während die generative KI weiter wächst und sich weiterentwickelt, wird Transparenz darüber, wie Technologie entwickelt, getestet und genutzt wird, eine entscheidende Komponente sein, um das Vertrauen von Unternehmen und ihren Kunden gleichermaßen zu gewinnen. Bei AWS sind wir bestrebt, der breiteren Community weiterhin Transparenzressourcen wie AI Service Cards zur Verfügung zu stellen – und Feedback zu den besten Wegen für die Zukunft zu sammeln.

Investition in verantwortungsvolle KI über den gesamten generativen KI-Lebenszyklus hinweg

Wir freuen uns über die neuen Innovationen, die diese Woche auf der re:Invent angekündigt wurden und unseren Kunden mehr Tools, Ressourcen und integrierte Schutzmaßnahmen für den sicheren Aufbau und Einsatz generativer KI bieten. Von der Modellbewertung über Leitplanken bis hin zu Wasserzeichen können Kunden jetzt generative KI schneller in ihr Unternehmen einführen und gleichzeitig Risiken minimieren. Neue Schutzmaßnahmen für Kunden wie IP-Schadensersatz und neue Ressourcen zur Verbesserung der Transparenz wie zusätzliche AI Service Cards sind ebenfalls wichtige Beispiele für unser Engagement, Vertrauen zwischen Technologieunternehmen, politischen Entscheidungsträgern, Community-Gruppen, Wissenschaftlern und mehr aufzubauen. Wir tätigen weiterhin sinnvolle Investitionen in verantwortungsvolle KI über den gesamten Lebenszyklus eines Basismodells – um unseren Kunden dabei zu helfen, KI auf sichere und verantwortungsvolle Weise zu skalieren.

Über die Autoren

Peter Hallinan leitet Initiativen in Wissenschaft und Praxis der verantwortungsbewussten KI bei AWS AI, zusammen mit einem Team verantwortungsbewusster KI-Experten. Er verfügt über fundiertes Fachwissen in den Bereichen KI (PhD, Harvard) und Unternehmertum (Blindsight, verkauft an Amazon). Zu seinen ehrenamtlichen Tätigkeiten gehörte die Tätigkeit als beratender Professor an der Stanford University School of Medicine und als Präsident der amerikanischen Handelskammer in Madagaskar. Wenn möglich, ist er mit seinen Kindern in den Bergen unterwegs: Skifahren, Klettern, Wandern und Rafting

Peter Hallinan leitet Initiativen in Wissenschaft und Praxis der verantwortungsbewussten KI bei AWS AI, zusammen mit einem Team verantwortungsbewusster KI-Experten. Er verfügt über fundiertes Fachwissen in den Bereichen KI (PhD, Harvard) und Unternehmertum (Blindsight, verkauft an Amazon). Zu seinen ehrenamtlichen Tätigkeiten gehörte die Tätigkeit als beratender Professor an der Stanford University School of Medicine und als Präsident der amerikanischen Handelskammer in Madagaskar. Wenn möglich, ist er mit seinen Kindern in den Bergen unterwegs: Skifahren, Klettern, Wandern und Rafting

vasi Philomin ist derzeit Vizepräsident für generative KI bei AWS. Er leitet generative KI-Projekte, darunter Amazon Bedrock, Amazon Titan und Amazon CodeWhisperer.

vasi Philomin ist derzeit Vizepräsident für generative KI bei AWS. Er leitet generative KI-Projekte, darunter Amazon Bedrock, Amazon Titan und Amazon CodeWhisperer.

- SEO-gestützte Content- und PR-Distribution. Holen Sie sich noch heute Verstärkung.

- PlatoData.Network Vertikale generative KI. Motiviere dich selbst. Hier zugreifen.

- PlatoAiStream. Web3-Intelligenz. Wissen verstärkt. Hier zugreifen.

- PlatoESG. Kohlenstoff, CleanTech, Energie, Umwelt, Solar, Abfallwirtschaft. Hier zugreifen.

- PlatoHealth. Informationen zu Biotechnologie und klinischen Studien. Hier zugreifen.

- Quelle: https://aws.amazon.com/blogs/machine-learning/announcing-new-tools-and-capabilities-to-enable-responsible-ai-innovation/

- :hast

- :Ist

- :nicht

- $UP

- 10

- 100

- 125

- 2022

- 50

- a

- Fähigkeit

- Fähig

- LiveBuzz

- oben

- Begleitet

- Genauigkeit

- genau

- über

- Aktivitäten

- Zusatz

- Zusätzliche

- Adressen

- Beratung

- gegen

- AI

- KI-Dienste

- Ziel

- ausrichten

- gleich

- Alle

- neben

- ebenfalls

- Amazon

- Amazon Code Whisperer

- Amazon Sage Maker

- Amazon Web Services

- amerikanisch

- unter

- an

- und

- Bekannt geben

- angekündigt

- Ankündigung

- Ein anderer

- jedem

- Anwendung

- Anwendungen

- Bewerben

- Ansatz

- SIND

- um

- AS

- fragen

- Einschätzungen

- At

- automatische

- Im Prinzip so, wie Sie es von Google Maps kennen.

- verfügbar

- vermeiden

- vermieden

- AWS

- AWS re: Invent

- Balance

- Bankinggg

- basierend

- BE

- war

- Bevor

- hinter

- Benchmarks

- BESTE

- Best Practices

- Besser

- zwischen

- vorspannen

- Blockieren

- beide

- Marke

- bringen

- Brings

- breit

- breiteres

- bauen

- Vertrauen aufbauen

- Building

- erbaut

- eingebaut

- by

- CAN

- Fähigkeiten

- capability

- Karte

- Karten

- Häuser

- Fälle

- Kategorien

- Herausforderungen

- Labor-Klimakammer

- weltweit

- Wahl

- Entscheidungen

- Auswählen

- aus aller Welt

- Klettern

- Zusammenarbeit

- Bekämpfung

- Kombination

- kommt

- Geschäfte

- Engagement

- begangen

- gemeinsam

- community

- Unternehmen

- Unternehmen

- vergleichen

- Compliance

- Komponente

- begreifen

- umfassend

- Überlegungen

- betrachtet

- konsistent

- Konsul (Console)

- Consulting

- enthalten

- Inhalt

- ständig

- fortsetzen

- weiter

- fortgesetzt

- Urheberrecht

- Urheberrechtsverletzung

- Kernbereich

- Kosten

- Berichterstattung

- Abdeckung

- Kriterien

- Zur Zeit

- Original

- Kunde

- Kunden

- technische Daten

- Datenschutz

- Datenwissenschaft

- Datensätze

- Tage

- tief

- tiefes Fachwissen

- Standard

- definieren

- Übergeben

- demographisch

- einsetzen

- Einsatz

- Design

- entworfen

- erwünscht

- entdecken

- entwickelt

- Entwicklung

- schwer

- Größe

- Desinformation

- Diversität

- do

- Dokumentation

- Antrieb

- im

- e

- jeder

- verdienen

- Gesamt-Einnahmen abzüglich Provision

- einfachste

- leicht

- Einfache

- Bildungswesen

- effizient

- Bemühungen

- entweder

- befähigt

- ermöglichen

- ermutigt

- End-to-End

- zu steigern,

- Ganz

- Unternehmertum

- Äther (ETH)

- bewerten

- Auswerten

- Auswertung

- Auswertungen

- Jedes

- jedermann

- entwickelt sich

- Beispiel

- Beispiele

- aufgeregt

- ERFAHRUNGEN

- Expertise

- Experten

- Erklärbarkeit

- ERKUNDEN

- express

- Gesicht

- Fairness

- Fallen

- beschleunigt

- Feedback

- wenige

- Filter

- Filterung

- Filter

- Finden Sie

- Fertig

- Vorname

- Setzen Sie mit Achtsamkeit

- Folgende

- Aussichten für

- unten stehende Formular

- vorwärts

- Fördern

- Foundation

- vier

- für

- weiter

- Außerdem

- Zukunft

- sammeln

- erzeugt

- erzeugt

- generativ

- Generative KI

- gegeben

- gibt

- Global

- Governance

- Gruppen

- Wachsen Sie über sich hinaus

- Wachstum

- schädlich

- Geschirr

- Harvard

- hassen

- Hassreden

- Haben

- he

- Hilfe

- hilft

- hochwertige

- Wandern

- seine

- Häuser

- Ultraschall

- HTTPS

- human

- identifizieren

- Identifizierung

- if

- Image

- Bilder

- implementieren

- wichtig

- zu unterstützen,

- Verbesserung

- in

- Anfang

- das

- inklusive

- Dazu gehören

- Einschließlich

- Erhöhung

- Branchen

- Information

- informiert

- Verletzung

- Initiativen

- wir innovieren

- Innovation

- Innovationen

- innovativ

- innovative Technologie

- Eingänge

- integrieren

- integriert

- beabsichtigt

- Interaktionen

- in

- einführen

- eingeführt

- Einführung

- Investition

- Investments

- unsichtbar

- IP

- IT

- Reise

- jpg

- nur

- Wesentliche

- Wissen

- Sprache

- grosse

- startet

- Start

- Klage

- umwandeln

- Lasst uns

- Niveau

- Hebelwirkung

- Lebenszyklus

- Gefällt mir

- LIMIT

- Einschränkungen

- Limitiert

- Liste

- Gelistet

- Aufrechterhaltung

- um

- MACHT

- verwaltet

- sinnvoll

- Mittel

- Mechanismus

- Medizin

- Metrik

- Geist / Bewusstsein

- mildernd

- Modell

- für

- mehr

- vor allem warme

- sollen

- In der Nähe von

- Need

- Neu

- jetzt an

- of

- WOW!

- Offensive

- Angebote

- on

- einmal

- Einsen

- Online

- Online-Banking

- Optimierung

- Option

- Optionen

- or

- Organisation

- Organisationen

- Andere

- UNSERE

- Ausgänge

- besitzen

- Teil

- passt

- Leistung

- durchgeführt

- Persönlich

- phd

- pii

- Ort

- Plato

- Datenintelligenz von Plato

- PlatoData

- Politik durchzulesen

- Politiker

- möglich

- Werkzeuge

- Praxis

- Praktiken

- Präsident

- verhindert

- Vorspann

- priorisiert

- Prioritätsliste

- Datenschutz

- Datenschutz und Sicherheit

- Prozessdefinierung

- produziert

- PROFANITÄT

- Professionell

- Professor

- aussichtsreich

- fördern

- immobilien

- geschützt

- Schutz

- schützt

- die

- vorausgesetzt

- Anbieter

- Bereitstellung

- öffentlich

- setzen

- Qualität

- Abfragen

- wirft

- Angebot

- schnell

- schnell

- RE

- Veteran

- Release

- Relevanz

- bleiben

- entfernen

- berichten

- falls angefordert

- erfordert

- resistent

- Ressourcen

- Downloads

- Reagieren

- Antworten

- Verantwortung

- für ihren Verlust verantwortlich.

- verantwortungsbewusst

- eingeschränkt

- Recht

- Risiko

- Robustheit

- Laufen

- läuft

- Safe

- Schutzmaßnahmen

- sicher

- Sicherheit

- sagemaker

- gleich

- Skalieren

- Skala ai

- Waage

- Scannen

- Schule

- Wissenschaft

- Wissenschaftler

- Abschnitt

- Verbindung

- Sicherheitdienst

- sehen

- wählen

- Auswahl

- Lösungen

- Dienst

- kompensieren

- Einstellung

- Siedlung

- Setup

- da

- Single

- So

- verkauft

- einige

- Jemand,

- spezifisch

- Rede

- verbringen

- Verbreitung

- Stufe

- Stand

- Standard

- Stehen

- Stanford

- Stanford Universität

- Streik

- Stil

- so

- Sues

- Unterstützte

- Dach

- Einnahme

- Aufgabe

- Team

- Technologie

- Technologieunternehmen

- getestet

- Testen

- Tests

- Text

- zur Verbesserung der Gesundheitsgerechtigkeit

- Das

- die Informationen

- Großbritannien

- ihr

- Sie

- Diese

- vom Nutzer definierten

- basierte Online-to-Offline-Werbezuordnungen von anderen gab.

- fehlen uns die Worte.

- diese Woche

- dieses Jahr

- diejenigen

- Durch

- Zeit

- Titan

- zu

- gemeinsam

- Werkzeuge

- Themen

- Training

- Ausbildung

- Transparenz

- transparent

- Vertrauen

- WENDE

- Uk

- verstehen

- unternehmen

- einzigartiges

- Universität

- -

- Anwendungsfall

- benutzt

- Mitglied

- Nutzer

- Verwendung von

- lebenswichtig

- Stimme

- freiwillig

- Freiwillige

- vp

- wollen

- Wasserzeichen

- Watermarking

- Wasserzeichen

- Weg..

- Wege

- we

- Netz

- Web-Services

- Webseite

- Woche

- GUT

- waren

- Was

- wann

- welche

- während

- WHO

- ganze

- breit

- Große Auswahl

- weit

- werden wir

- mit

- .

- Worte

- Arbeiten

- Workflows

- Belegschaft

- Jahr

- gestern

- U

- Zephyrnet