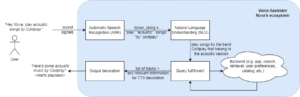

Jüngste Fortschritte in der Entwicklung von LLMs haben ihre Verwendung für verschiedene NLP-Aufgaben populär gemacht, die zuvor mit älteren Methoden des maschinellen Lernens gelöst wurden. Große Sprachmodelle sind in der Lage, eine Vielzahl von Sprachproblemen wie Klassifizierung, Zusammenfassung, Informationsabruf, Inhaltserstellung, Beantwortung von Fragen und Aufrechterhaltung einer Konversation zu lösen – und das alles mit nur einem einzigen Modell. Aber woher wissen wir, dass sie bei all diesen verschiedenen Aufgaben gute Arbeit leisten?

Der Aufstieg der LLMs hat ein ungelöstes Problem ans Licht gebracht: Wir haben keinen zuverlässigen Standard für ihre Bewertung. Was die Bewertung erschwert, ist, dass sie für sehr unterschiedliche Aufgaben verwendet werden und es uns an einer klaren Definition fehlt, was für jeden Anwendungsfall eine gute Antwort ist.

In diesem Artikel werden aktuelle Ansätze zur Evaluierung von LLMs erörtert und eine neue LLM-Bestenliste vorgestellt, die die menschliche Evaluierung nutzt und bestehende Evaluierungstechniken verbessert.

Die erste und übliche erste Form der Bewertung besteht darin, das Modell anhand mehrerer kuratierter Datensätze laufen zu lassen und seine Leistung zu untersuchen. HuggingFace hat eine erstellt Öffnen Sie die LLM-Bestenliste wo Open-Access-Großmodelle anhand von vier bekannten Datensätzen bewertet werden (AI2 Reasoning Challenge , HellaSwag , MMLU , WahrhaftigQA). Dies entspricht einer automatischen Auswertung und prüft die Fähigkeit des Modells, die Fakten für bestimmte Fragestellungen zu ermitteln.

Dies ist ein Beispiel für eine Frage aus dem MMLU Datensatz.

Betreff: College_Medizin

Frage: Eine zu erwartende Nebenwirkung der Kreatin-Supplementierung ist.

- A) Muskelschwäche

- B) Zunahme der Körpermasse

- C) Muskelkrämpfe

- D) Verlust von Elektrolyten

Antwort: (B)

Die Bewertung des Modells bei der Beantwortung dieser Art von Fragen ist eine wichtige Kennzahl und dient der Faktenüberprüfung, testet jedoch nicht die generative Fähigkeit des Modells. Dies ist wohl der größte Nachteil dieser Bewertungsmethode, denn die Generierung von Freitext ist eines der wichtigsten Merkmale von LLMs.

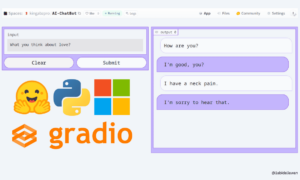

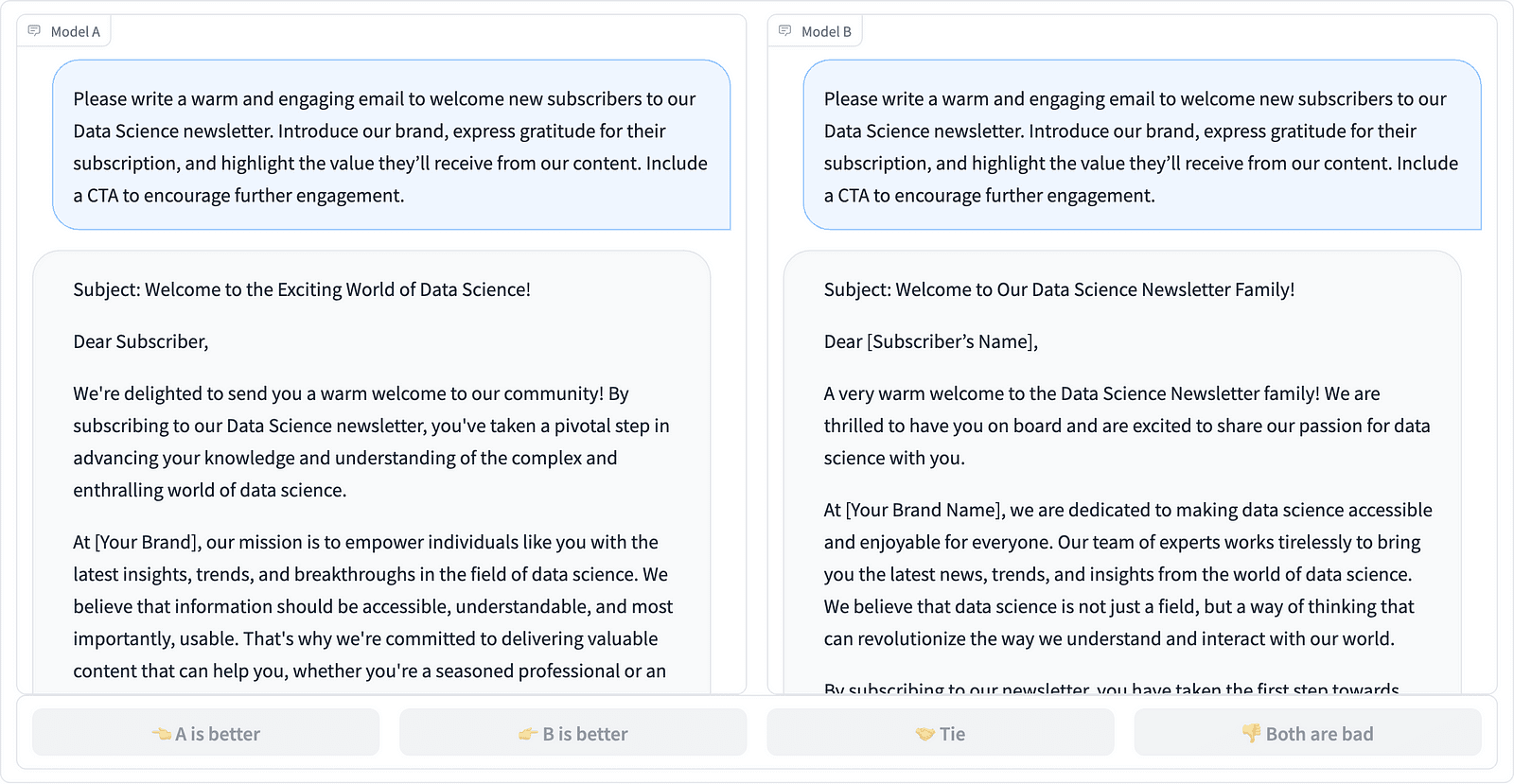

In der Community scheint es einen Konsens darüber zu geben, dass wir zur ordnungsgemäßen Bewertung des Modells eine menschliche Bewertung benötigen. Dies geschieht typischerweise durch den Vergleich der Antworten verschiedener Modelle.

Vergleich zweier Eingabeaufforderungsabschlüsse im LMSYS-Projekt – Screenshot des Autors

Annotatoren entscheiden, welche Antwort besser ist, wie im obigen Beispiel zu sehen ist, und quantifizieren manchmal den Qualitätsunterschied der Eingabeaufforderungsvervollständigungen. LMSYS Org hat eine erstellt Leaderboard Das nutzt diese Art der menschlichen Bewertung und vergleicht 17 verschiedene Modelle und berichtet über die Elo-Wertung für jedes Modell.

Da die menschliche Bewertung schwer zu skalieren sein kann, wurden Anstrengungen unternommen, den Bewertungsprozess zu skalieren und zu beschleunigen, und dies führte zu einem interessanten Projekt namens „ AlpakaEval. Hier wird jedes Modell mit einer Basislinie (text-davinci-003 bereitgestellt von GPT-4) verglichen und die menschliche Bewertung durch die GPT-4-Beurteilung ersetzt. Dies ist zwar schnell und skalierbar, aber können wir dem Modell hier vertrauen, dass es die Bewertung durchführt? Wir müssen uns der Modellverzerrungen bewusst sein. Das Projekt hat tatsächlich gezeigt, dass GPT-4 längere Antworten begünstigen könnte.

LLM-Bewertungsmethoden entwickeln sich weiter, da die KI-Community nach einfachen, fairen und skalierbaren Ansätzen sucht. Die neueste Entwicklung kommt vom Team von Toloka mit einem neuen Leaderboard um aktuelle Bewertungsstandards weiter voranzutreiben.

The new Leaderboard vergleicht Modellantworten mit realen Benutzeraufforderungen, die nach nützlichen NLP-Aufgaben kategorisiert sind, wie in beschrieben dieses InstructGPT-Papier. Außerdem wird die Gesamtsiegrate jedes Modells in allen Kategorien angezeigt.

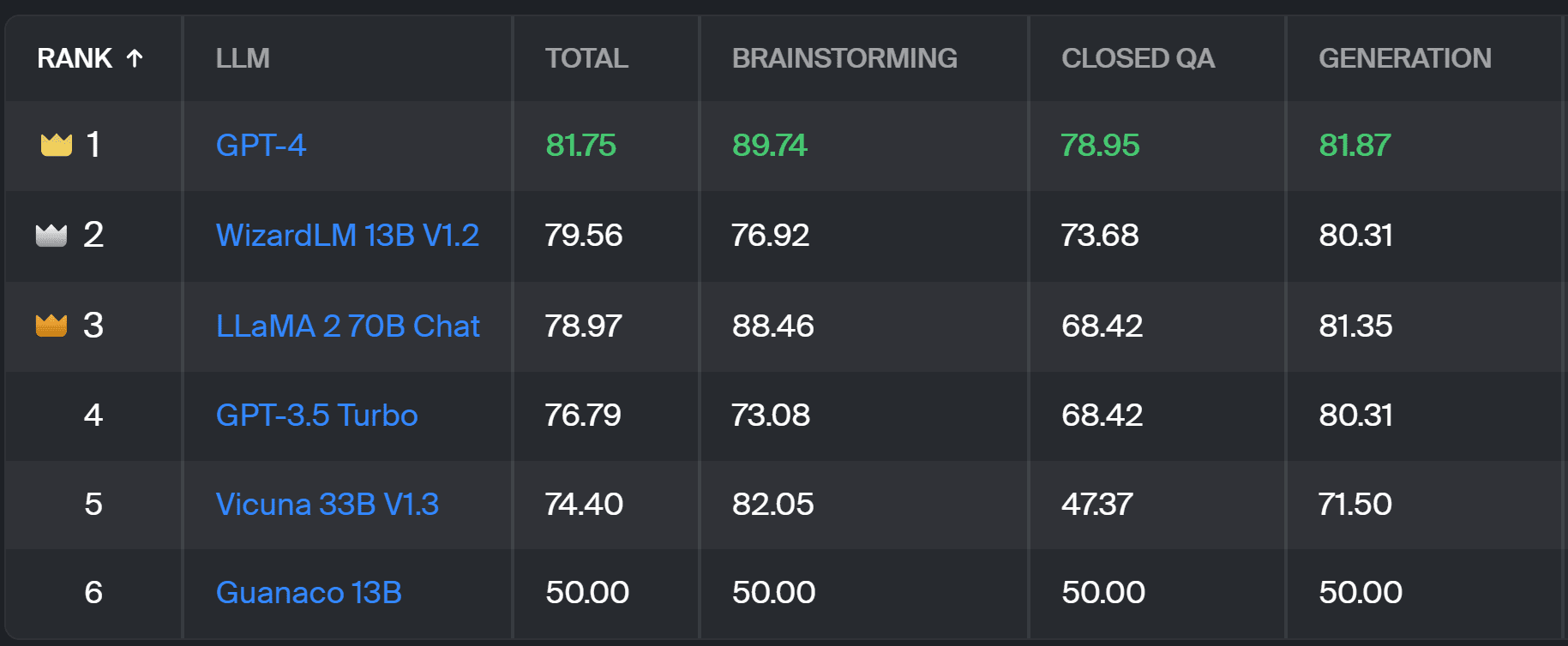

Toloka-Bestenliste – Screenshot vom Autor

Die für dieses Projekt verwendete Bewertung ähnelt der in AlpacaEval durchgeführten. Die Ergebnisse auf der Bestenliste stellen die Siegesquote des jeweiligen Modells im Vergleich zum dar Guanako 13B Modell, das hier als Basisvergleich dient. Die Wahl von Guanaco 13B ist eine Verbesserung der AlpacaEval-Methode, die das bald veraltete text-davinci-003-Modell als Basis verwendet.

Die eigentliche Bewertung erfolgt durch menschliche Expertenannotatoren anhand einer Reihe realer Eingabeaufforderungen. Für jede Eingabeaufforderung erhalten Annotatoren zwei Vervollständigungen und werden gefragt, welche sie bevorzugen. Details zur Methodik finden Sie hier hier.

Diese Art der menschlichen Bewertung ist nützlicher als jede andere automatische Bewertungsmethode und sollte die dafür verwendete menschliche Bewertung verbessern LMSYS-Bestenliste. Der Nachteil der LMSYS-Methode besteht darin, dass jeder mit dem Link können an der Auswertung teilnehmen, was ernsthafte Fragen zur Qualität der auf diese Weise gesammelten Daten aufwirft. Eine geschlossene Gruppe von Expertenannotatoren hat ein besseres Potenzial für zuverlässige Ergebnisse, und Toloka wendet zusätzliche Qualitätskontrolltechniken an, um die Datenqualität sicherzustellen.

In diesem Artikel haben wir eine vielversprechende neue Lösung zur Bewertung von LLMs vorgestellt – das Toloka Leaderboard. Der Ansatz ist innovativ, kombiniert die Stärken bestehender Methoden, fügt aufgabenspezifische Granularität hinzu und nutzt zuverlässige menschliche Annotationstechniken zum Vergleich der Modelle.

Erkunden Sie das Forum und teilen Sie uns Ihre Meinungen und Verbesserungsvorschläge mit.

Magdalena Konkiewicz ist Data Evangelist bei Toloka, einem globalen Unternehmen, das schnelle und skalierbare KI-Entwicklung unterstützt. Sie hat einen Master-Abschluss in Künstlicher Intelligenz von der Universität Edinburgh und hat als NLP-Ingenieurin, Entwicklerin und Datenwissenschaftlerin für Unternehmen in Europa und Amerika gearbeitet. Sie war auch an der Lehre und Betreuung von Datenwissenschaftlern beteiligt und schreibt regelmäßig Beiträge zu Veröffentlichungen zu Datenwissenschaft und maschinellem Lernen.

- SEO-gestützte Content- und PR-Distribution. Holen Sie sich noch heute Verstärkung.

- PlatoData.Network Vertikale generative KI. Motiviere dich selbst. Hier zugreifen.

- PlatoAiStream. Web3-Intelligenz. Wissen verstärkt. Hier zugreifen.

- PlatoESG. Kohlenstoff, CleanTech, Energie, Umwelt, Solar, Abfallwirtschaft. Hier zugreifen.

- PlatoHealth. Informationen zu Biotechnologie und klinischen Studien. Hier zugreifen.

- Quelle: https://www.kdnuggets.com/a-better-way-to-evaluate-llms?utm_source=rss&utm_medium=rss&utm_campaign=a-better-way-to-evaluate-llms

- :hast

- :Ist

- :nicht

- :Wo

- $UP

- 17

- a

- Fähigkeit

- Über Uns

- oben

- über

- präsentieren

- berührt das Schneidwerkzeug

- Zusätzliche

- Fügt

- vorantreiben

- Vorschüsse

- AI

- Alle

- ebenfalls

- Amerika

- an

- und

- beantworten

- Antworten

- jedem

- gilt

- Ansatz

- Ansätze

- SIND

- Arena

- Artikel

- künstlich

- künstliche Intelligenz

- AS

- At

- automatische

- bewusst

- b

- Baseline

- BE

- weil

- war

- Besser

- Vorurteile

- Größte

- Tafel

- Körper

- gebracht

- Unternehmen

- aber

- by

- CAN

- fähig

- Häuser

- Kategorien

- challenges

- Schecks

- Wahl

- Einstufung

- klar

- geschlossen

- vereint

- kommt

- community

- Unternehmen

- vergleichen

- verglichen

- Vergleich

- Vergleich

- Konsens

- Inhalt

- Inhaltserstellung

- fortgesetzt

- trägt dazu bei

- Smartgeräte App

- Gespräch

- entspricht

- erstellt

- Schaffung

- Menschenmenge

- kuratiert

- Strom

- technische Daten

- Datenqualität

- Datenwissenschaft

- Datenwissenschaftler

- Datensätze

- entscheidet

- Definition

- Grad

- Details

- Entwickler:in / Unternehmen

- Entwicklung

- Unterschied

- anders

- Nachteil

- verschieden

- do

- die

- Dabei

- erledigt

- Nicht

- Nachteil

- jeder

- Einfache

- Edinburgh

- bewirken

- Bemühungen

- Elektrolyte

- Ingenieur

- gewährleisten

- Europa

- bewerten

- Bewerten

- Auswerten

- Auswertung

- Evangelist

- entwickelt sich

- untersuchen

- Beispiel

- vorhandenen

- erwartet

- Experte

- Fakten

- Messe

- FAST

- Favor

- Eigenschaften

- Finden Sie

- Vorname

- Aussichten für

- unten stehende Formular

- vier

- Frei

- für

- weiter

- Gewinnen

- gesammelt

- Erzeugung

- generativ

- bekommen

- GitHub

- gegeben

- Global

- gut

- gute Arbeit

- hart

- Schwerer

- Haben

- hier

- hoch

- hält

- Ultraschall

- HTTPS

- Umarmendes Gesicht

- human

- wichtig

- zu unterstützen,

- Verbesserung

- Verbesserungen

- verbessert

- in

- Information

- Anfangs-

- innovativ

- Intelligenz

- interessant

- eingeführt

- Stellt vor

- beteiligt

- IT

- SEINE

- Job

- nur

- nur einer

- KDnuggets

- Wissen

- Mangel

- Sprache

- grosse

- neueste

- lernen

- Nutzung

- !

- länger

- Verlust

- Maschine

- Maschinelles Lernen

- Aufrechterhaltung

- MACHT

- Weise

- Masse

- Master

- Kann..

- Mentoring

- Methode

- Methodik

- Methoden

- Metrisch

- Modell

- für

- mehr

- vor allem warme

- Muskel

- Need

- Neu

- neue Lösung

- Nlp

- of

- Telefongebühren sparen

- on

- EINEM

- XNUMXh geöffnet

- Meinungen

- Andere

- skizzierte

- Gesamt-

- Teil

- ausführen

- Leistung

- durchgeführt

- Plato

- Datenintelligenz von Plato

- PlatoData

- Potenzial

- bevorzugen

- vorher

- wahrscheinlich

- Aufgabenstellung:

- Probleme

- Prozessdefinierung

- Projekt

- aussichtsreich

- Eingabeaufforderungen

- richtig

- vorausgesetzt

- Publikationen

- Qualität

- Frage

- Fragen

- Erhöhung

- Bewerten

- realen Welt

- regelmäßig

- zuverlässig

- ersetzt

- Reporting

- vertreten

- diejenigen

- Antwort

- Antworten

- Folge

- Die Ergebnisse

- Rise

- Führen Sie

- s

- skalierbaren

- Skalieren

- Wissenschaft

- Wissenschaftler

- Wissenschaftler

- Partituren

- Wertung

- Suchbegriffe

- scheint

- gesehen

- ernst

- dient

- kompensieren

- mehrere

- Teilen

- sie

- sollte

- gezeigt

- Konzerte

- Seite

- ähnlich

- Single

- Lösung

- Auflösung

- einige

- manchmal

- spezifisch

- Geschwindigkeit

- Standard

- Normen

- Stärken

- so

- Unterstützung

- Nehmen

- und Aufgaben

- Einführungen

- Team

- Techniken

- Test

- Text

- als

- zur Verbesserung der Gesundheitsgerechtigkeit

- Das

- ihr

- Sie

- Dort.

- Diese

- vom Nutzer definierten

- fehlen uns die Worte.

- zu

- Vertrauen

- XNUMX

- tippe

- typisch

- Universität

- auf

- us

- Anwendungsbereich

- -

- Anwendungsfall

- benutzt

- Mitglied

- verwendet

- Verwendung von

- üblich

- Vielfalt

- Weg..

- we

- Schwäche

- GUT

- bekannt

- waren

- Was

- Was ist

- welche

- gewinnen

- mit

- .

- gearbeitet

- U

- Ihr

- Zephyrnet