Sponsored Inhalt

ChatGPT und ähnliche Tools, die auf großen Sprachmodellen (LLMs) basieren, sind erstaunlich. Aber sie sind keine Allzweckwerkzeuge.

Es ist so, als würde man andere Werkzeuge zum Bauen und Gestalten auswählen. Sie müssen das Richtige für den Job auswählen. Sie würden nicht versuchen, eine Schraube mit einem Hammer festzuziehen oder ein Hamburger-Patty mit einem Schneebesen umzudrehen. Der Vorgang wäre umständlich und würde zu einem unangenehmen Fehler führen.

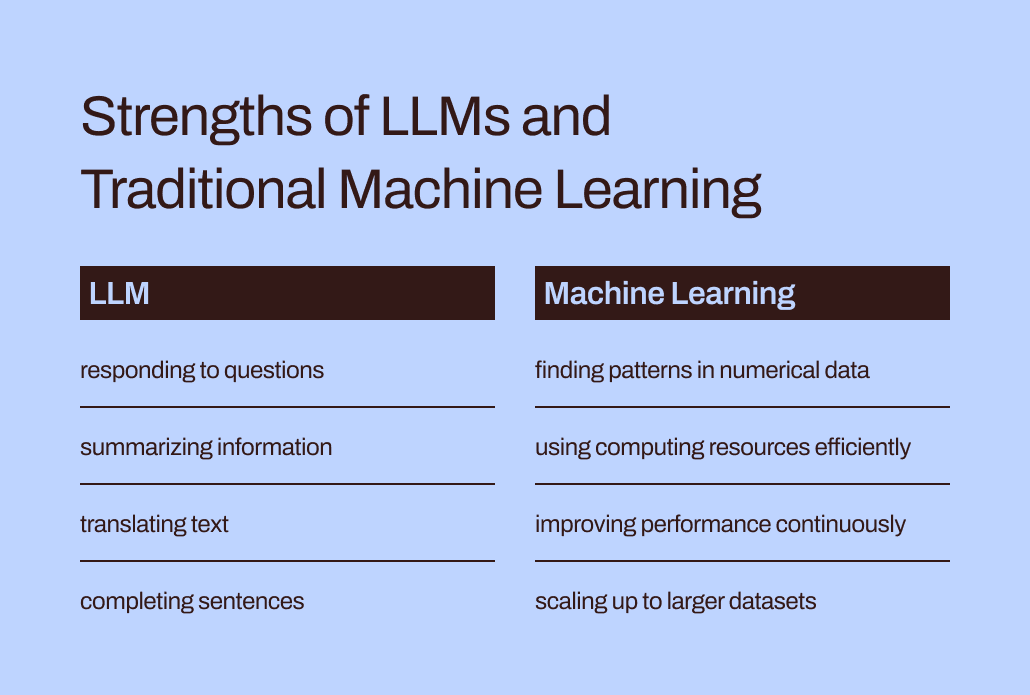

Sprachmodelle wie LLMs stellen nur einen Teil des umfassenderen Werkzeugkastens für maschinelles Lernen dar und umfassen sowohl generative KI als auch prädiktive KI. Die Auswahl des richtigen Modelltyps für maschinelles Lernen ist entscheidend, um die Anforderungen Ihrer Aufgabe zu erfüllen.

Lassen Sie uns näher darauf eingehen, warum LLMs besser dazu geeignet sind, Sie bei der Ausarbeitung von Texten oder beim Brainstorming von Geschenkideen zu unterstützen, als bei der Bewältigung der wichtigsten prädiktiven Modellierungsaufgaben Ihres Unternehmens. Den „traditionellen“ Modellen des maschinellen Lernens, die den LLMs vorausgingen und sich in Unternehmen wiederholt bewährt haben, kommt nach wie vor eine wichtige Rolle zu. Wir werden auch einen bahnbrechenden Ansatz für die gemeinsame Nutzung dieser Tools erkunden – eine aufregende Entwicklung, die wir bei Pecan nennen Prädiktive GenAI.

LLMs sind für Wörter konzipiert, nicht für Zahlen

Beim maschinellen Lernen werden verschiedene mathematische Methoden verwendet, um sogenannte „Trainingsdaten“ zu analysieren – einen Ausgangsdatensatz, der das Problem darstellt, das ein Datenanalyst oder Datenwissenschaftler lösen möchte.

Die Bedeutung von Trainingsdaten kann nicht genug betont werden. Es enthält die Muster und Beziehungen, die ein maschinelles Lernmodell „lernen“ wird, um Ergebnisse vorherzusagen, wenn ihm später neue, unsichtbare Daten zur Verfügung gestellt werden.

Was genau ist ein LLM? Large Language Models (LLMs) fallen unter den Begriff maschinelles Lernen. Sie stammen aus Deep Learning und ihre Struktur ist speziell für die Verarbeitung natürlicher Sprache entwickelt.

Man könnte sagen, dass sie auf einer Grundlage aus Worten aufgebaut sind. Ihr Ziel besteht einfach darin, vorherzusagen, welches Wort das nächste in einer Wortfolge sein wird. Beispielsweise verwendet die Autokorrekturfunktion von iPhones in iOS 17 jetzt ein LLM, um besser vorherzusagen, welches Wort Sie höchstwahrscheinlich als nächstes eingeben möchten.

Stellen Sie sich nun vor, Sie wären ein Modell für maschinelles Lernen. (Haben Sie Geduld, wir wissen, dass es weit hergeholt ist.) Ihnen wurde beigebracht, Wörter vorherzusagen. Sie haben Millionen von Wörtern aus einer Vielzahl von Quellen zu allen möglichen Themen gelesen und studiert. Ihre Mentoren (auch bekannt als Entwickler) haben Ihnen dabei geholfen, die besten Möglichkeiten zu erlernen, Wörter vorherzusagen und neuen Text zu erstellen, der den Anforderungen eines Benutzers entspricht.

Aber hier ist eine Wendung. Ein Benutzer gibt Ihnen nun eine riesige Tabelle mit Kunden- und Transaktionsdaten mit Millionen von Zahlenreihen und bittet Sie, Zahlen im Zusammenhang mit diesen vorhandenen Daten vorherzusagen.

Wie würden Ihrer Meinung nach Ihre Prognosen ausfallen? Erstens würden Sie sich wahrscheinlich darüber ärgern, dass diese Aufgabe nicht zu dem passt, wofür Sie so hart gearbeitet haben. (Glücklicherweise haben LLMs unseres Wissens noch keine Gefühle.) Noch wichtiger ist, dass von Ihnen eine Aufgabe verlangt wird, die nicht mit dem übereinstimmt, was Sie gelernt haben. Und Sie werden wahrscheinlich nicht so gute Leistungen erbringen.

Die Kluft zwischen Training und Aufgabe erklärt, warum LLMs nicht gut für Vorhersageaufgaben mit numerischen, tabellarischen Daten geeignet sind – dem primären Datenformat, das die meisten Unternehmen sammeln. Stattdessen ist ein maschinelles Lernmodell, das speziell für den Umgang mit dieser Art von Daten entwickelt und abgestimmt wurde, effektiver. Es wurde buchstäblich dafür trainiert.

Effizienz- und Optimierungsherausforderungen von LLMs

Herkömmliche Methoden des maschinellen Lernens eignen sich nicht nur besser für numerische Daten, sondern sind auch weitaus effizienter und einfacher zu optimieren, um eine bessere Leistung zu erzielen als LLMs.

Kehren wir zu Ihrer Erfahrung zurück, als Sie sich als LLM ausgab. All diese Wörter zu lesen und ihren Stil und ihre Reihenfolge zu studieren, klingt nach einer Menge Arbeit, oder? Es wäre sehr aufwändig, all diese Informationen zu verinnerlichen.

Ebenso kann das komplexe Training von LLMs zu Modellen mit Milliarden von Parametern führen. Diese Komplexität ermöglicht es diesen Modellen, die kniffligen Nuancen der menschlichen Sprache zu verstehen und darauf zu reagieren. Allerdings bringt ein intensives Training hohe Rechenanforderungen mit sich, wenn LLMs Antworten generieren. Numerisch orientierte „traditionelle“ maschinelle Lernalgorithmen wie Entscheidungsbäume oder neuronale Netze werden wahrscheinlich weitaus weniger Rechenressourcen benötigen. Und hier gilt nicht „je größer, desto besser“. Selbst wenn LLMs mit numerischen Daten umgehen könnten, würde dieser Unterschied bedeuten, dass traditionelle Methoden des maschinellen Lernens immer noch schneller, effizienter, ökologisch nachhaltiger und kostengünstiger wären.

Haben Sie ChatGPT außerdem jemals gefragt, woher es wusste, eine bestimmte Antwort zu geben? Die Antwort wird wahrscheinlich etwas vage sein:

Ich erstelle Antworten auf der Grundlage einer Mischung aus lizenzierten Daten, von menschlichen Trainern erstellten Daten und öffentlich verfügbaren Daten. Meine Ausbildung umfasste auch umfangreiche Datensätze aus verschiedenen Quellen, darunter Büchern, Websites und anderen Texten, um ein umfassendes Verständnis der menschlichen Sprache zu entwickeln. Der Trainingsprozess umfasst die Durchführung von Berechnungen auf Tausenden von GPUs über Wochen oder Monate hinweg, genaue Details und Zeitskalen sind jedoch Eigentum von OpenAI.

Wie viel des „Wissens“, das sich in dieser Antwort widerspiegelte, stammte von den menschlichen Trainern im Vergleich zu den öffentlichen Daten im Vergleich zu Büchern? Sogar ChatGPT selbst ist sich nicht sicher: „Die relativen Anteile dieser Quellen sind unbekannt, und ich habe keinen detaillierten Überblick darüber, welche spezifischen Dokumente Teil meines Trainingssatzes waren.“

Es ist ein wenig beunruhigend, dass ChatGPT so sichere Antworten auf Ihre Fragen liefert, seine Antworten aber nicht auf bestimmte Quellen zurückführen kann. Die begrenzte Interpretierbarkeit und Erklärbarkeit von LLMs stellen auch eine Herausforderung dar, sie für bestimmte Geschäftsanforderungen zu optimieren. Es kann schwierig sein, die Beweggründe hinter ihren Informationen oder Vorhersagen zu verstehen. Erschwerend kommt hinzu, dass bestimmte Unternehmen mit regulatorischen Anforderungen zu kämpfen haben, die bedeuten, dass sie in der Lage sein müssen, die Faktoren zu erklären, die die Vorhersagen eines Modells beeinflussen. Alles in allem zeigen diese Herausforderungen, dass traditionelle Modelle des maschinellen Lernens – die im Allgemeinen besser interpretierbar und erklärbar sind – wahrscheinlich besser für geschäftliche Anwendungsfälle geeignet sind.

Der richtige Platz für LLMs im Predictive Toolkit von Unternehmen

Sollten wir LLMs also einfach ihren wortbezogenen Aufgaben überlassen und sie für prädiktive Anwendungsfälle vergessen? Es könnte jetzt so aussehen, als könnten sie doch nicht dabei helfen, die Kundenabwanderung oder den Customer Lifetime Value vorherzusagen.

Hier ist die Sache: Während die Aussage „traditionelle Modelle des maschinellen Lernens“ diese Techniken allgemein verständlich und einfach anzuwenden erscheinen lässt, wissen wir aus unserer Erfahrung bei Pecan, dass Unternehmen immer noch große Schwierigkeiten haben, selbst diese bekannteren Formen der KI zu übernehmen.

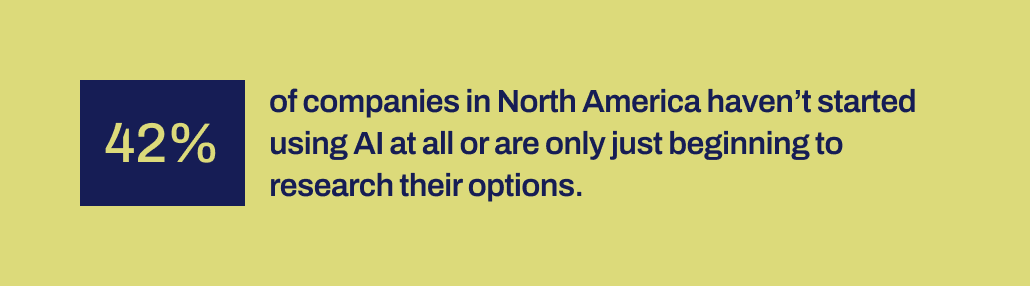

Aktuelle Untersuchungen von Workday zeigen, dass 42 % der Unternehmen in Nordamerika entweder noch nicht mit dem Einsatz von KI begonnen haben oder sich erst in einem frühen Stadium der Erkundung ihrer Optionen befinden. Und es ist über ein Jahrzehnt her, seit Tools für maschinelles Lernen für Unternehmen zugänglicher geworden sind. Sie hatten die Zeit und es stehen verschiedene Werkzeuge zur Verfügung.

Aus irgendeinem Grund waren erfolgreiche KI-Implementierungen überraschend selten, trotz der großen Begeisterung für Datenwissenschaft und KI – und ihres anerkannten Potenzials für erhebliche geschäftliche Auswirkungen. Es fehlen wichtige Mechanismen, um die Lücke zwischen den Versprechen der KI und der Fähigkeit, sie produktiv umzusetzen, zu schließen.

Und genau hier können LLMs unserer Meinung nach nun eine wichtige Brückenfunktion spielen. LLMs können Geschäftsanwendern dabei helfen, die Kluft zwischen der Identifizierung eines zu lösenden Geschäftsproblems und der Entwicklung eines Vorhersagemodells zu überwinden.

Da jetzt LLMs im Spiel sind, können Geschäfts- und Datenteams, die nicht über die Fähigkeit oder Kapazität verfügen, Modelle für maschinelles Lernen manuell zu programmieren, ihre Anforderungen jetzt besser in Modelle umsetzen. Sie können „ihre Worte nutzen“, wie Eltern gerne sagen, um den Modellierungsprozess anzukurbeln.

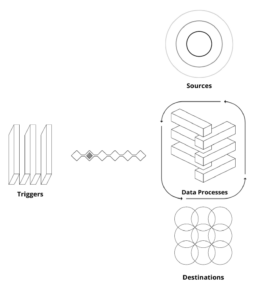

Verschmelzung von LLMs mit Techniken des maschinellen Lernens, die darauf ausgelegt sind, Geschäftsdaten optimal zu nutzen

Diese Fähigkeit ist jetzt in Pecans Predictive GenAI angekommen, das die Stärken von LLMs mit unserer bereits hochentwickelten und automatisierten Plattform für maschinelles Lernen vereint. Unser LLM-gestützter Predictive Chat sammelt den Input eines Geschäftsbenutzers, um die Definition und Entwicklung einer Vorhersagefrage zu leiten – das spezifische Problem, das der Benutzer mit einem Modell lösen möchte.

Anschließend generiert unsere Plattform mithilfe von GenAI ein Vorhersage-Notizbuch, um den nächsten Schritt zur Modellierung noch einfacher zu machen. Auch hier stützt sich das Notebook auf LLM-Funktionen und enthält vorab ausgefüllte SQL-Abfragen zur Auswahl der Trainingsdaten für das Vorhersagemodell. Pecans automatisierte Datenaufbereitungs-, Feature-Engineering-, Modellerstellungs- und Bereitstellungsfunktionen können den Rest des Prozesses in Rekordzeit erledigen, schneller als jede andere prädiktive Modellierungslösung.

Kurz gesagt: Pecans Predictive GenAI nutzt die beispiellosen Sprachkenntnisse von LLMs, um unsere erstklassige Plattform für prädiktive Modellierung für Geschäftsanwender weitaus zugänglicher und benutzerfreundlicher zu machen. Wir sind gespannt, wie dieser Ansatz vielen weiteren Unternehmen zum Erfolg mit KI verhelfen wird.

Also, während LLMs allein Obwohl sie nicht alle Ihre Prognoseanforderungen erfüllen, können sie eine wichtige Rolle bei der Weiterentwicklung Ihrer KI-Projekte spielen. Indem Pecans Predictive GenAI Ihren Anwendungsfall interpretiert und Ihnen einen Vorsprung mit automatisch generiertem SQL-Code verschafft, ist es führend bei der Vereinigung dieser Technologien. Du kannst Probieren Sie es jetzt mit einer kostenlosen Testversion aus.

- SEO-gestützte Content- und PR-Distribution. Holen Sie sich noch heute Verstärkung.

- PlatoData.Network Vertikale generative KI. Motiviere dich selbst. Hier zugreifen.

- PlatoAiStream. Web3-Intelligenz. Wissen verstärkt. Hier zugreifen.

- PlatoESG. Kohlenstoff, CleanTech, Energie, Umwelt, Solar, Abfallwirtschaft. Hier zugreifen.

- PlatoHealth. Informationen zu Biotechnologie und klinischen Studien. Hier zugreifen.

- Quelle: https://www.kdnuggets.com/2024/01/pecan-llms-used-alone-cant-address-companys-predictive-needs?utm_source=rss&utm_medium=rss&utm_campaign=why-llms-used-alone-cant-address-your-companys-predictive-needs

- :hast

- :Ist

- :nicht

- :Wo

- 15%

- 17

- a

- Fähigkeit

- Fähig

- Über uns

- zugänglich

- anerkannt

- Zusatz

- Adresse

- adoptieren

- Nach der

- aufs Neue

- AI

- Auch bekannt als:

- Algorithmen

- ausrichten

- Alle

- erlaubt

- allein

- bereits

- ebenfalls

- erstaunlich

- Amerika

- an

- Analytiker

- analysieren

- und

- beantworten

- Antworten

- jedem

- Ansatz

- SIND

- um

- angekommen

- AS

- helfen

- At

- Automatisiert

- automatisiertes maschinelles Lernen

- Im Prinzip so, wie Sie es von Google Maps kennen.

- verfügbar

- Zurück

- basierend

- BE

- Denken Sie

- wurde

- war

- Anfang

- hinter

- Sein

- Glauben

- BESTE

- Besser

- zwischen

- Milliarden

- Bit

- Bolt

- Bücher

- beide

- Geistesblitz

- BRIDGE

- Überbrückung

- breiteres

- Building

- erbaut

- Geschäft

- Auswirkungen auf das Geschäft

- Unternehmen

- aber

- by

- rufen Sie uns an!

- kam

- CAN

- Fähigkeiten

- capability

- Kapazität

- tragen

- Häuser

- Fälle

- sicher

- Herausforderungen

- Abgrund

- Chat

- ChatGPT

- Auswahl

- Code

- sammeln

- kommt

- Unternehmen

- Unternehmen

- Komplex

- Komplexität

- rechnerisch

- Berechnungen

- Computing

- zuversichtlich

- bilden

- enthält

- und beseitigen Muskelschwäche

- kostengünstiger

- könnte

- Gefertigt

- erstellen

- erstellt

- Erstellen

- kritischem

- Cross

- wichtig

- Kunde

- technische Daten

- Datenanalytiker

- Datenaufbereitung

- Datenwissenschaft

- Datenwissenschaftler

- Datensätze

- Jahrzehnte

- Entscheidung

- tief

- tiefe Lernen

- tiefer

- Definition

- Anforderungen

- Einsatz

- entworfen

- Trotz

- detailliert

- Details

- entwickeln

- entwickelt

- Entwickler

- Entwicklung

- Entwicklung

- Unterschied

- anders

- DIG

- do

- Unterlagen

- Tut nicht

- Don

- Nicht

- Lüftung

- Zeichnung

- Früh

- einfacher

- Einfache

- Effektiv

- Effizienz

- effizient

- Anstrengung

- entweder

- umfassend

- Entwicklung

- umwelt

- Äther (ETH)

- Sogar

- ÜBERHAUPT

- Beispiel

- Excel

- aufgeregt

- unterhaltsame Programmpunkte

- vorhandenen

- ERFAHRUNGEN

- Erklären

- Erklärbarkeit

- ERKUNDEN

- Möglichkeiten sondieren

- Faktoren

- Scheitern

- Fallen

- vertraut

- weit

- beschleunigt

- Merkmal

- Gefühle

- Weniger

- Vorname

- passen

- fits

- Flip

- Aussichten für

- Format

- Formen

- Zum Glück

- vorwärts

- Foundation

- Frei

- freundlich

- für

- weiter

- verschmelzen

- Lücke

- Genai

- allgemein

- erzeugen

- erzeugt

- erzeugt

- generativ

- Generative KI

- einem Kind in Not

- gegeben

- gibt

- Unterstützung

- Go

- Kundenziele

- GPUs

- Guide

- hätten

- Hammer

- Griff

- Handling

- hart

- Haben

- Port

- ganzer

- Heavy-Duty-

- Hilfe

- dazu beigetragen,

- Unternehmen

- hilft

- hoch

- hält

- hofft,

- Ultraschall

- aber

- HTTPS

- human

- i

- Ideen

- Identifizierung

- if

- Bild

- Impact der HXNUMXO Observatorien

- implementieren

- Realisierungen

- wichtig

- wichtig

- in

- Einschließlich

- Beeinflussung

- Information

- Anfangs-

- initiiert

- Varianten des Eingangssignals:

- beantragen müssen

- wollen

- in

- beteiligt

- beinhaltet

- Beteiligung

- iOS

- IT

- SEINE

- selbst

- Job

- nur

- KDnuggets

- Wissen

- bekannt

- Sprache

- grosse

- großflächig

- weitgehend

- später

- führenden

- LERNEN

- gelernt

- lernen

- Verlassen

- Zugelassen

- Lebensdauer

- Gefällt mir

- wahrscheinlich

- Limitiert

- Los

- Maschine

- Maschinelles Lernen

- Techniken des maschinellen Lernens

- gemacht

- um

- MACHT

- viele

- massiv

- Spiel

- mathematisch

- bedeuten

- Mechanismus

- Mentoren

- Methoden

- könnte

- Millionen

- Kommt demnächst...

- Mischung

- Modell

- Modellieren

- für

- Monat

- mehr

- effizienter

- vor allem warme

- ziehen um

- viel

- sollen

- my

- Natürliche

- Natürliche Sprache

- Verarbeitung natürlicher Sprache

- Need

- Bedürfnisse

- Netzwerke

- Neural

- Neuronale Netze

- Neu

- weiter

- Norden

- Nordamerika

- Notizbuch

- jetzt an

- Abschattung

- Zahlen

- erhalten

- of

- on

- EINEM

- einzige

- OpenAI

- Optimierung

- Optimieren

- Optimierung

- Optionen

- or

- Andere

- UNSERE

- Ergebnisse

- übrig

- überbewertet

- Parameter

- Eltern

- Teil

- besondere

- Muster

- ausführen

- Leistung

- wählen

- ein Bild

- Pionierarbeit

- Ort

- Plattform

- Plato

- Datenintelligenz von Plato

- PlatoData

- Play

- Potenzial

- größte treibende

- genau

- vorhersagen

- Vorhersage

- Prognosen

- prädiktive

- Vorbereitung

- primär

- wahrscheinlich

- Aufgabenstellung:

- Prozessdefinierung

- Verarbeitung

- Projekte

- Promises

- Eigentums-

- zuverlässig

- die

- Öffentlichkeit

- öffentlich

- Abfragen

- Frage

- Fragen

- Angebot

- RARE

- Begründung

- Lesen Sie mehr

- Lesebrillen

- Grund

- Rekord

- raffiniert

- reflektiert

- Regulierungsbehörden

- bezogene

- Beziehungen

- relativ

- WIEDERHOLT

- Darstellen

- Anforderung

- Voraussetzungen:

- Forschungsprojekte

- Downloads

- Reagieren

- Antwort

- Antworten

- REST

- Folge

- was zu

- Enthüllt

- Recht

- Rollen

- Laufen

- s

- sagen

- Wissenschaft

- Wissenschaftler

- sehen

- scheinen

- wählen

- Auswahl

- Reihenfolge

- kompensieren

- Short

- sollte

- erklären

- Bedeutung

- signifikant

- ähnlich

- einfach

- da

- Fähigkeiten

- So

- Lösung

- LÖSEN

- einige

- Klingen

- Geräusche

- Quellen

- spezifisch

- speziell

- Kalkulationstabelle

- SQL

- Stufen

- Anfang

- begonnen

- Schritt

- Immer noch

- Stärken

- Struktur

- Struggling

- sucht

- Studieren

- Stil

- Erfolg haben

- erfolgreich

- so

- sicher

- nachhaltiger

- T

- anpacken

- Nehmen

- Aufgabe

- und Aufgaben

- Teams

- Techniken

- Technologies

- Text

- als

- zur Verbesserung der Gesundheitsgerechtigkeit

- Das

- ihr

- Sie

- Diese

- vom Nutzer definierten

- Ding

- think

- fehlen uns die Worte.

- diejenigen

- Tausende

- spannen

- Zeit

- zu

- gemeinsam

- Tonne

- Toolkit

- Werkzeuge

- Themen

- gegenüber

- Spur

- traditionell

- trainiert

- Ausbildung

- Transaktion

- Übersetzen

- Bäume

- versuchen

- WENDE

- Twist

- tippe

- Regenschirm

- für

- verstehen

- Verständnis

- verstanden

- Vereinigung

- unbekannt

- beispiellos

- us

- -

- Anwendungsfall

- benutzt

- Mitglied

- Nutzer

- verwendet

- Verwendung von

- Wert

- Vielfalt

- verschiedene

- riesig

- Sichtbarkeit

- lebenswichtig

- vs

- will

- Weg..

- Wege

- we

- Webseiten

- Wochen

- GUT

- waren

- Was

- Was ist

- wann

- welche

- während

- warum

- weit

- werden wir

- mit

- .

- Word

- Worte

- Arbeiten

- gearbeitet

- wert

- würde

- noch

- U

- Ihr

- Zephyrnet