Kennen Sie die Kosten einer schlechten Datenqualität? Im Folgenden untersuche ich die Bedeutung der Datenbeobachtbarkeit, wie sie die Risiken fehlerhafter Daten mindern kann und wie sich der ROI messen lässt. Durch das Verständnis der Auswirkungen schlechter Daten und die Umsetzung effektiver Strategien können Unternehmen den Nutzen ihrer Datenqualitätsinitiativen maximieren.

Daten sind zu einem integralen Bestandteil moderner Entscheidungsfindung geworden, und daher ist die Datenqualität von größter Bedeutung, um sicherzustellen, dass Geschäftsbeteiligte genaue Schlussfolgerungen ziehen.

Aber hier ist der Haken, den Ihnen jeder moderne Datenführer sagen wird: Datenqualitätsmanagement ist schwierig. Es braucht Zeit und Mühe. Darüber hinaus ist der ROI (Return on Investment) oft schwer zu messen.

Wie schlimm sind schlechte Daten?

Schlechte Daten können zu erheblichen finanziellen Verlusten führen. Gartner schätzt, dass schlechte Datenqualität Unternehmen jedes Jahr durchschnittlich Kosten verursacht 12.9 Mio. US$. Im Jahr 2022, Unity-Software meldete einen Umsatzverlust von 110 Millionen US-Dollar und eine Marktkapitalisierung von 4.2 Milliarden US-Dollar. „Konsequenzen der Aufnahme fehlerhafter Daten eines Großkunden“, erklärte das Unternehmen. Ebenso werden fehlerhafte Daten verursacht Equifax, eine börsennotierte Kreditauskunftei, um Kreditgebern ungenaue Kreditauskünfte zu übermitteln Millionen der Kunden. In jüngerer Zeit führte ein Datenvorfall zu erheblichen Störungen im Flugverkehr in Großbritannien und Irland. Es wird berichtet, dass über 2,000 Flüge gestrichen wurden, was dazu führte, dass Hunderttausende Reisende festsaßen. Der kumulierte finanzielle Verlust für die Fluggesellschaften wird auf 126.5 Millionen US-Dollar geschätzt.

Die Auswirkungen fehlerhafter Daten

Daten sind das Herzstück jedes modernen Unternehmens. Die Hauptaufgabe des Datenteams besteht darin, Datenprodukte zu erstellen und zu pflegen, die den Kunden intern und extern zur Verfügung gestellt werden und gleichzeitig der Organisation ermöglichen, zu skalieren und ihre Ziele zu erreichen.

Wenn es darum geht, sicherzustellen, dass die Dateninitiativen des Unternehmens auf Erfolg ausgerichtet sind, können einige grundlegende Erwartungen an ein Datenteam wie folgt zusammengefasst werden:

- Betriebszeit: Daten sind ein Dienst und daher ist es von entscheidender Bedeutung, sicherzustellen, dass sie bei Bedarf verfügbar sind.

- Sicherheit: Einhaltung von Vorschriften (wie DSGVO oder HIPAA). Das Team ist für die Umsetzung von Maßnahmen und Praktiken zum Schutz sensibler Informationen und zur Wahrung des Datenschutzes verantwortlich.

- Zuverlässigkeit: Sowohl von den Daten als auch von der Datenplattform. Ein Teil davon betrifft die Betriebszeit, aber auch die Datenqualität und -genauigkeit im herkömmlichen Sinne.

- Maßstab: Die Datenplattform sollte eine Skalierbarkeit ermöglichen, um wachsenden Datenmengen, der Anzahl der Anwendungsfälle und den Anforderungen des Unternehmens gerecht zu werden.

- Innovation: Daten sollten Innovationen vorantreiben, und in diesem Bereich ist es wichtig, dass das Datenteam mit gutem Beispiel vorangeht, indem es Innovationen innerhalb und außerhalb von Datenpraktiken vorantreibt.

Datenqualität durch Datenbeobachtbarkeit erreichen

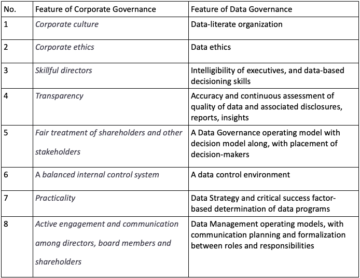

Datenbeobachtbarkeit ist eine Lösung zur proaktiven Überwachung und Aufrechterhaltung des Zustands von Daten während ihres gesamten Lebenszyklus. Durch die Implementierung von Protokollierungs-, Nachverfolgungs- und Überwachungstechniken erhalten Unternehmen Einblick in Datenströme, können Datenqualitätsprobleme schnell erkennen und beheben und Störungen bei Analyse-Dashboards verhindern. Datenkompetenz, das die Beschaffung, Interpretation und Kommunikation von Daten umfasst, ist für Entscheidungsträger von entscheidender Bedeutung, um Daten effektiv in Geschäftswert umzuwandeln. Die Pflege einer datengesteuerten Kultur und die Investition in die richtigen Tools sind entscheidende Schritte zur Erzielung von Datenqualität durch Datenbeobachtbarkeit.

Quantifizierung des ROI der Datenbeobachtbarkeit

Die Messung des ROI der Datenbeobachtbarkeit hilft Unternehmensleitern, den Wert und die Vorteile zu verstehen, die mit der Investition in diese Praxis verbunden sind. Mehrere quantifizierbare Metriken können als Ausgangspunkt für die Bewertung der Kosten fehlerhafter Daten dienen, darunter die Häufigkeit des Auftretens oder die Anzahl der Vorfälle pro Jahr, die Zeit bis zur Erkennung und die Zeit bis zur Lösung.

Der Einfluss von Probleme mit der Datenqualität kann je nach Größe und Komplexität des Geschäftsbetriebs variieren. Um den Schaden einzuschätzen und überzeugende Argumente für eine Datenbeobachtbarkeitslösung zu entwickeln, schlagen wir fünf Schlüsselmetriken vor, die Datenexperten leicht implementieren und überwachen können und die zur internen Unterstützung eines Falles verwendet werden können:

- Anzahl und Häufigkeit der Vorfälle: Während es bei einigen Unternehmen täglich zu Datenvorfällen kommt, kann es bei anderen tage- oder sogar wochenlang ohne Vorfälle bleiben. Die Schwere der Vorfälle kann von etwas „Kleinerem“ wie veralteten Daten, die mit einem Dashboard verknüpft sind, das seit Ewigkeiten niemand mehr verwendet hat, bis hin zu einem Datenduplizierungsproblem reichen, das zu einer Überlastung des Servers und schließlich zu einem Ausfall führt (wahre Geschichte, Netflix 2016). Wir stellen fest, dass es häufig mit Folgendem zusammenhängt: der Größe und Komplexität der Datenplattform, der Branche des Unternehmens (einige Branchen sind von Natur aus datenausgereifter als andere), der Art der Datenarchitektur (zentralisiert, dezentral, hybrid) usw. Die Dokumentation der Vorfälle ist hilfreich Um eine bessere Vorstellung davon zu bekommen, worauf beim nächsten Mal zu achten ist, sind wiederholte Vorfälle oft ein guter Indikator dafür, dass etwas darunter genauere Aufmerksamkeit erfordert.

- Klassifizierung des Vorfalls: Nicht alle Datenvorfälle haben den gleichen Schweregrad; Einige können geringfügig sein und leicht gemildert werden, während andere schwerwiegende Folgen haben können. Die Dokumentation der Kritikalität der Vorfälle ist wichtig, um eine ordnungsgemäße Eskalation und Priorisierung sicherzustellen. Hier kann die Datenherkunft von entscheidender Bedeutung sein, da sie die Bewertung der nachgelagerten Auswirkungen des Vorfalls ermöglicht, um die Kritikalität besser zu verstehen. Ein Vorfall, der mit dem bevorzugten Dashboard des CEO, einer Produktionsdatenbank oder einem wichtigen Datenprodukt verknüpft ist, ist wahrscheinlich von hoher Kritikalität.

- Mittlere Zeit bis zur Erkennung (MTTD): Wenn es darum geht, Vertrauen in die Daten und das Datenteam aufzubauen, ist es der Albtraum eines jeden Datenexperten, wenn Geschäftsbeteiligte als Erste Probleme mit der Datenqualität erkennen. Dies kann der Glaubwürdigkeit des Teams und der Fähigkeit des Unternehmens, wirklich datengesteuert zu werden, erheblich schaden. Wenn Sie beginnen, die Vorfälle zu dokumentieren und ihre Kritikalität einzustufen, ist es wichtig, auch den Überblick darüber zu behalten, wie sie erkannt wurden und wie lange es gedauert hat, bis das Datenteam sie erkannt hat. Diese Kennzahl kann ein guter Indikator für die Robustheit Ihres Vorfallmanagements sein, aber auch eine Reduzierung bedeutet, dass Sie das Risiko verringern, dass der Vorfall mehr Schaden anrichten könnte.

- Mittlere Zeit bis zur Lösung (MTTR): Was passiert, wenn ein Vorfall gemeldet wird? MTTR ist die durchschnittliche Zeit, die zwischen dem Erkennen eines Datenvorfalls und seiner Lösung vergeht. Die Lösungszeit wird stark von der Kritikalität des Vorfalls und der Komplexität der Datenplattform beeinflusst, weshalb wir für die Zwecke dieses Rahmenwerks den Durchschnitt berücksichtigen.

- Mittlere Produktionszeit (MTTP) ist die durchschnittliche Zeit, die für die Auslieferung neuer Datenprodukte benötigt wird, oder mit anderen Worten die durchschnittliche Zeit bis zur Markteinführung von Datenprodukten. Dies könnte die Zeit sein, die ein Analyst damit verbringt, die Daten für ein Data-Science-Modell zu „bereinigen“. Tatsächlich, laut ForbesDie Datenvorbereitung macht etwa 80 % der Arbeit von Datenwissenschaftlern aus. In einer Welt, in der wir Daten wie ein Produkt behandeln möchten, kann sich die Verbesserung der Datenqualität direkt auf die Verkürzung der Markteinführungszeit auswirken.

Zusätzlich zu den oben genannten quantifizierbaren Kennzahlen sind andere, die weniger leicht quantifizierbar, aber ebenso wichtig sind, eine Überlegung wert, wenn man die Kosten schlechter Daten betrachtet.

- Vertrauensverlust: In den Daten machen Das Datenteam. Dies ist meiner Meinung nach die gefährlichste Folge fehlerhafter Daten, die zu größeren Problemen wie Fluktuation im Datenteam oder einem Vertrauensverlust in die Fähigkeit des Unternehmens führen kann, datengesteuert zu werden und mit der sich entwickelnden digitalen Landschaft Schritt zu halten. Und wenn das Vertrauen einmal gebrochen ist, ist es sehr schwer, es wiederzugewinnen. In einer früheren Erfahrung habe ich mit Datenkonsumenten zu tun gehabt, die lieber keine Daten verwenden und sich in einem sehr volatilen Aktienhandelsumfeld lieber auf „Erfahrung“ und „Bauchgefühl“ verlassen würden, als sie zu nutzen, obwohl sie wussten, dass die Wahrscheinlichkeit hoch ist, dass sie ungenau sind .

- Produktivitätsverlust: Bei schlechten Daten sind Teams gezwungen, Fehler zu bekämpfen und zu korrigieren, sobald sie auftreten. Diese ständige Brandbekämpfung ist nicht nur anstrengend, sondern auch kontraproduktiv. Wertvolle Zeit, die für strategische Planung und Wachstumsinitiativen aufgewendet werden könnte, wird für die Fehlerbehebung verschwendet, wodurch Ressourcen von wichtigeren Aufgaben abgelenkt werden.

- Regulatorisches und Reputationsrisiko: Fehler in der Finanzberichterstattung oder der falsche Umgang mit personenbezogenen Daten können kostspielige Bußgelder und Rechtsstreitigkeiten nach sich ziehen. Der Umgang mit Compliance-Problemen beeinträchtigt die Produktivität erheblich, ganz zu schweigen von der finanziellen Belastung, die sie mit sich bringt.

- Schlechte Geschäftsentwicklung: Schlechte Daten führen nicht nur zu Produktivitätseinbußen innerhalb des Datenteams, sondern können auch die Gesamtleistung des Unternehmens beeinträchtigen, da das Unternehmen Probleme mit der digitalen Bereitschaft und Glaubwürdigkeit gegenüber seinen Kunden hat und anfällig für externe Bedrohungen wird.

Probleme mit der Datenqualität können zu verschiedenen Problemen führen, darunter Vertrauensverlust in die Daten, verminderte Teamproduktivität und -moral, Nichteinhaltung von Vorschriften und verminderte Qualität der Entscheidungsfindung. Isolierte Daten innerhalb von Abteilungen oder Geschäftseinheiten machen es schwierig, einen ganzheitlichen Überblick über die Datenlandschaft des Unternehmens zu erhalten. Dies kann zu einer ineffektiven Entscheidungsfindung führen, die Datenkultur behindern und die Einhaltung von Vorschriften wie DSGVO und HIPAA gefährden. Darüber hinaus können Datenteams frustriert sein, wenn sie zu viel Zeit mit der Behebung von Datenproblemen verbringen, was sich negativ auf ihre Arbeitszufriedenheit auswirkt und möglicherweise zur Abwanderung von Mitarbeitern führt.

Die 1x10x100-Regel

Die 1x10x100-Regel, ein weithin anerkanntes Prinzip im Vorfallmanagement, betont die steigenden Kosten, die mit schlechter Datenqualität verbunden sind. Gemäß dieser Regel betragen die Kosten für die Behebung eines Datenqualitätsproblems am Eingangspunkt etwa das Einfache der ursprünglichen Kosten. Wenn das Problem unentdeckt bleibt und sich innerhalb des Systems ausbreitet, erhöhen sich die Kosten auf etwa das Zehnfache und erfordern Korrektur- und Behebungsmaßnahmen. Wenn die schlechte Datenqualität jedoch den Endbenutzer oder die Entscheidungsphase erreicht, können die Kosten aufgrund erheblicher geschäftlicher Folgen, einschließlich Betriebsunterbrechungen, entgangener Chancen und Unzufriedenheit der Kunden, auf das unglaubliche Hundertfache der ursprünglichen Kosten in die Höhe schnellen. Diese Regel unterstreicht die exponentiellen Auswirkungen einer schlechten Datenqualität. Daher ist es für Unternehmen von entscheidender Bedeutung, in die Beobachtbarkeit der Daten zu investieren, um Probleme, falls sie auftreten, näher an der Grundursache und nicht weiter unten zu halten.

Zusammenfassung

Datenqualitätsprobleme wirken sich erheblich auf Unternehmen aus und führen zu Ressourcenverschwendung und verpassten Chancen. Investitionen in die Beobachtbarkeit von Daten sind unerlässlich, um die mit fehlerhaften Daten verbundenen Risiken zu verhindern und zu mindern. Durch die Nutzung quantifizierbarer Metriken und die Berücksichtigung nicht quantifizierbarer Faktoren können Unternehmen den ROI der Datenbeobachtbarkeit messen und ihren Wert für Entscheidungsträger demonstrieren. Die Gewährleistung des Datenvertrauens, die Förderung einer effektiven Domänenentscheidung, die Einhaltung von Vorschriften und die Förderung eines zufriedenen Datenteams sind alles entscheidende Aspekte für die Maximierung des Nutzens von Datenqualitätsinitiativen. Die Beobachtbarkeit von Daten ist eine strategische Investition, die die Genauigkeit, Zuverlässigkeit und Nutzung von Daten in der heutigen datengesteuerten Welt gewährleistet.

Unternehmen, die eine umfassende Observability-Praxis aufbauen, haben mehr Einblick in ihre miteinander verwobenen Umgebungen, was sich in weniger Ausfällen, schnellerer Problemlösung, größerem Vertrauen in die Zuverlässigkeit ihrer Apps – und letztlich mehr Umsatz und zufriedeneren Kunden – niederschlägt.

- SEO-gestützte Content- und PR-Distribution. Holen Sie sich noch heute Verstärkung.

- PlatoData.Network Vertikale generative KI. Motiviere dich selbst. Hier zugreifen.

- PlatoAiStream. Web3-Intelligenz. Wissen verstärkt. Hier zugreifen.

- PlatoESG. Kohlenstoff, CleanTech, Energie, Umwelt, Solar, Abfallwirtschaft. Hier zugreifen.

- PlatoHealth. Informationen zu Biotechnologie und klinischen Studien. Hier zugreifen.

- Quelle: https://www.dataversity.net/putting-a-number-on-bad-data/

- :hast

- :Ist

- :nicht

- :Wo

- $UP

- 000

- 1

- 100x

- 2016

- 2022

- 9

- a

- Fähigkeit

- Über uns

- oben

- unterbringen

- Nach

- Trading Konten

- Angesammelt

- Genauigkeit

- genau

- Erreichen

- anerkennen

- Ad

- Zusatz

- Adressierung

- Agentur

- Jahre

- LUFT

- Fluggesellschaften

- Alle

- erlauben

- Zulassen

- erlaubt

- ebenfalls

- an

- Analytiker

- Analytik

- machen

- ca.

- Architektur

- SIND

- Bereich

- entstehen

- um

- AS

- Aspekte

- beurteilen

- Bewertung

- damit verbundenen

- At

- Aufmerksamkeit

- verfügbar

- durchschnittlich

- bewusst

- Badewanne

- schlechte Daten

- Baseline

- Grundlage

- Schlachten

- BE

- werden

- wird

- Werden

- Sein

- unten

- Vorteile

- Besser

- zwischen

- größer

- Milliarde

- beide

- Bringing

- Gebrochen

- bauen

- Building

- Last

- Geschäft

- Geschäftsführer

- Geschäftsbetrieb

- Geschäftsleistung

- Unternehmen

- aber

- by

- CAN

- abgebrochen

- Kappe

- Häuser

- Fälle

- Ringen

- Verursachen

- verursacht

- verursacht

- zentralisierte

- herausfordernd

- Chance

- Einstufung

- klassifizieren

- näher

- CO

- kommt

- Kommunizieren

- Unternehmen

- Unternehmen

- Unternehmen

- Komplexität

- Compliance

- Vertrauen

- Folgen

- Berücksichtigung

- konstante

- KUNDEN

- und beseitigen Muskelschwäche

- Kosten

- teuer werden

- Kosten

- könnte

- kontraproduktiv

- bedeckt

- Kommunikation

- Kredit

- kritischem

- kritisch

- wichtig

- KULTUR

- Kunde

- Kunden

- Unterricht

- Organschäden

- Gefährlich

- Armaturenbrett

- Dashboards

- technische Daten

- Datenplattform

- Datenaufbereitung

- Datenschutz

- Datenqualität

- Datenwissenschaft

- datengesteuerte

- Datenbase

- DATENVERSITÄT

- Tage

- Behandlung

- dezentralisiert

- Decision Making

- Entscheidungsträger

- zeigen

- Abteilungen

- Abhängig

- entdecken

- erkannt

- Entdeckung

- schwer

- digital

- Direkt

- Störung

- Störungen

- Dokument

- dokumentieren

- Domain

- nach unten

- abtropfen

- Antrieb

- zwei

- leicht

- Effektiv

- effektiv

- Anstrengung

- Bemühungen

- umarmen

- betont

- Mitarbeiter

- gewährleisten

- Gewährleistung

- Eintrag

- Arbeitsumfeld

- Umgebungen

- Equifax

- Fehler

- Eskalation

- essential

- geschätzt

- Schätzungen

- etc

- Äther (ETH)

- Auswerten

- Event

- Jedes

- sich entwickelnden

- Beispiel

- übermäßig

- Erwartungen

- ERFAHRUNGEN

- ERKUNDEN

- exponentiell

- extern

- äußerlich

- Tatsache

- Faktoren

- beschleunigt

- Favorit

- Weniger

- Revolution

- Finden Sie

- Ende

- Vorname

- fünf

- Flüge

- folgt

- Aussichten für

- Forbes

- gezwungen

- Förderung

- Unser Ansatz

- Frequenz

- für

- Materials des

- frustriert

- Außerdem

- Gewinnen

- Gartner

- DSGVO

- ABSICHT

- Go

- Goes

- gut

- mehr

- sehr

- persönlichem Wachstum

- Wachstum

- hätten

- das passiert

- glücklicher

- hart

- Haben

- Gesundheit

- Herz

- hilft

- GUTE

- behindern

- ganzheitliche

- Ultraschall

- aber

- HTML

- HTTPS

- riesig

- hunderte

- Verletzt

- Hybrid

- i

- Idee

- identifizieren

- if

- Impact der HXNUMXO Observatorien

- Auswirkungen

- implementieren

- Implementierung

- Umsetzung

- Auswirkungen

- wichtig

- auferlegte

- Verbesserung

- in

- In anderen

- ungenau

- Zwischenfall

- Zwischenfälle

- Einschließlich

- Steigert

- Indikator

- Branchen

- Energiegewinnung

- beeinflusst

- Information

- von Natur aus

- Anfangs-

- Initiativen

- Innovation

- instrumental

- Integral

- innen

- in

- Investieren

- Investitionen

- Investition

- Beteiligung

- Irland

- Problem

- Probleme

- IT

- SEINE

- Gefährden

- Job

- nur

- Behalten

- Wesentliche

- Wissen

- Wissend

- Landschaft

- grosse

- führen

- Führer

- Führung

- führenden

- links

- Rechtlich

- Kreditgeber

- weniger

- Nutzung

- Lebenszyklus

- Gefällt mir

- wahrscheinlich

- verknüpft

- Protokollierung

- aussehen

- suchen

- verlieren

- Verlust

- Verluste

- verloren

- LP

- halten

- MACHT

- Making

- Management

- Markt

- Marktkapitalisierung

- MARKTBEOBACHTUNG

- reifen

- Maximieren

- Maximierung

- Kann..

- Mittel

- messen

- Maßnahmen

- Triff

- erwähnen

- Metrisch

- Metrik

- Million

- Moll

- Misshandlung

- vermisst

- Mildern

- Modell

- modern

- Überwachen

- Überwachung

- mehr

- Zudem zeigt

- vor allem warme

- my

- erforderlich

- Bedürfnisse

- negativ

- Netflix

- Neu

- weiter

- Anzahl

- auftreten

- Auftreten

- of

- vorgenommen,

- on

- einmal

- EINEM

- einzige

- Betriebs-

- Einkauf & Prozesse

- Meinung

- Entwicklungsmöglichkeiten

- or

- Auftrag

- Organisation

- Organisationen

- Original

- Andere

- Anders

- Ausfälle

- aussen

- übrig

- Gesamt-

- oberste

- Teil

- für

- Leistung

- persönliche

- Daten

- Planung

- Plattform

- Plato

- Datenintelligenz von Plato

- PlatoData

- Points

- balanciert

- Arm

- möglicherweise

- Praxis

- Praktiken

- Vorbereitung

- verhindern

- früher

- Prinzip

- Priorisierung

- Datenschutz

- Aufgabenstellung:

- Probleme

- Produkt

- Produktion

- PRODUKTIVITÄT

- Produkte

- Die Förderung der

- ordnungsgemäße

- bietet

- Risiken zu minimieren

- öffentlich

- Zweck

- Qualität

- quantifizierbar

- schnell

- Bewerten

- lieber

- Erreicht

- Bereitschaft

- wirklich

- kürzlich

- anerkannt

- Veteran

- Reduziert

- Reduzierung

- wiedergewinnen

- Vorschriften

- Zuverlässigkeit

- verlassen

- wiederholt

- Berichtet

- Reporting

- Auflösung

- Lösung

- Downloads

- Verantwortung

- für ihren Verlust verantwortlich.

- Folge

- Rückkehr

- Einnahmen

- Reiches

- Recht

- Risiko

- Risiken

- Robustheit

- ROI

- Wurzel

- Regel

- Schutzmaßnahmen

- gleich

- Zufriedenheit

- zufrieden

- Skalierbarkeit

- Skalieren

- Wissenschaft

- Wissenschaftler

- Partituren

- senden

- Sinn

- empfindlich

- ernst

- brauchen

- serviert

- Server

- mehrere

- Schwere

- Schiff

- sollte

- Bedeutung

- signifikant

- bedeutend

- Isoliert

- Ähnlich

- Größe

- die Höhe schnellen

- Lösung

- einige

- etwas

- Sourcing

- Ausgabe

- verbrachte

- Stufe

- Staffelung

- Stakeholder

- Anfang

- Beginnen Sie

- angegeben

- Shritte

- Strategisch

- STRATEGISCHE INVESTITIONEN

- Strategien

- Ströme

- stark

- Kämpft

- Erfolg

- so

- Support

- System

- nimmt

- und Aufgaben

- Team

- Teams

- Techniken

- erzählen

- als

- zur Verbesserung der Gesundheitsgerechtigkeit

- Das

- ihr

- Sie

- Dort.

- deswegen

- vom Nutzer definierten

- fehlen uns die Worte.

- Tausende

- Bedrohungen

- Durch

- während

- Zeit

- zu

- heutigen

- nahm

- Werkzeuge

- gegenüber

- Tracing

- verfolgen sind

- gehandelt

- traditionell

- der Verkehr

- Übersetzen

- Reisende

- behandeln

- wirklich

- Vertrauen

- fluktuation

- tippe

- Vereinigtes Königreich

- Letztlich

- unter

- Unterstrichen

- verstehen

- Verständnis

- unentdeckt

- Bereiche

- Betriebszeit

- -

- benutzt

- wertvoll

- Wert

- verschiedene

- sehr

- Anzeigen

- angesehen

- Sichtbarkeit

- flüchtig

- Volumen

- vs

- Verwundbar

- wollen

- verschwendet

- Wege

- we

- Wochen

- waren

- Was

- wann

- welche

- während

- WHO

- warum

- weit

- werden wir

- mit

- .

- ohne

- Worte

- Arbeiten

- gearbeitet

- weltweit wie ausgehandelt und gekauft ausgeführt wird.

- wert

- würde

- WSJ

- Jahr

- U

- Ihr

- Zephyrnet