Generiert mit Midjourney

Unternehmen in allen Branchen und Teilen der Welt drängen darauf, die Leistungsfähigkeit großer Sprachmodelle (LLMs) wie ChatGPT von OpenAI, Claude von Anthropic und Jurassic von AI12Lab zu integrieren, um die Leistung in einer Vielzahl von Geschäftsanwendungen wie Marktforschung und Kundenservice zu steigern und Inhaltsgenerierung.

Allerdings erfordert die Erstellung einer LLM-Anwendung auf Unternehmensebene andere Tools und Kenntnisse als die Erstellung herkömmlicher Anwendungen für maschinelles Lernen (ML). Unternehmensführer und Führungskräfte, die die Markenbotschaft und zuverlässige Servicequalität bewahren möchten, müssen ein tieferes Verständnis für die Funktionsweise von LLMs und die Vor- und Nachteile verschiedener Tools in einem LLM-Anwendungsstack entwickeln.

In diesem Artikel geben wir Ihnen eine grundlegende Einführung in die allgemeine Strategie und die Tools, die Sie zum Erstellen und Ausführen einer LLM-Anwendung für Ihr Unternehmen benötigen.

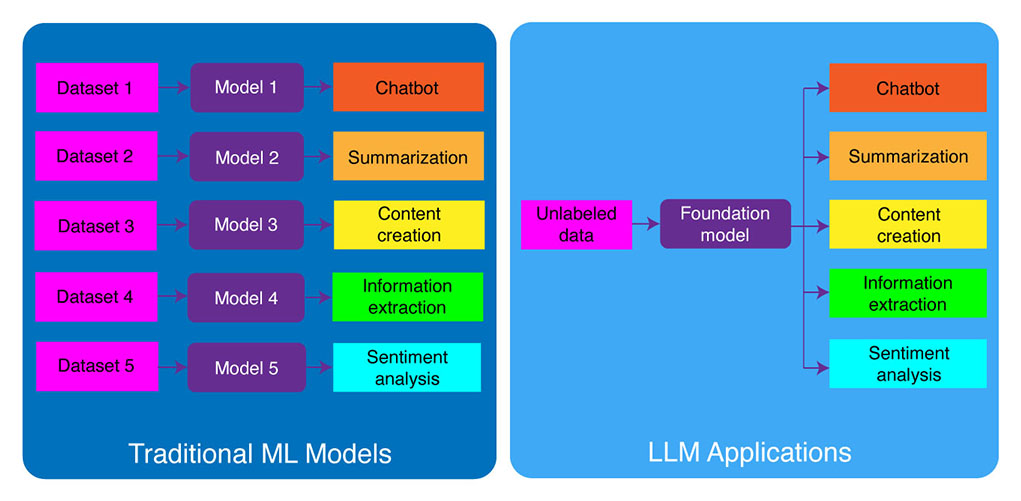

Traditionelle ML-Entwicklung vs. LLM-Anwendungen

Herkömmliche Modelle für maschinelles Lernen waren aufgabenspezifisch, was bedeutete, dass Sie für jede Aufgabe ein separates Modell erstellen mussten. Wenn Sie beispielsweise die Kundenstimmung analysieren möchten, müssen Sie ein Modell erstellen, und wenn Sie einen Chatbot für den Kundensupport erstellen möchten, müssen Sie ein anderes Modell erstellen.

Dieser Prozess des Erstellens und Trainierens aufgabenspezifischer ML-Modelle ist zeitaufwändig und erfordert viele Daten. Die Art der Datensätze, die zum Trainieren dieser verschiedenen ML-Modelle benötigt werden, variiert ebenfalls je nach Aufgabe. Um ein Modell zur Analyse der Kundenstimmung zu trainieren, benötigen Sie einen Datensatz von Kundenbewertungen, die mit einer entsprechenden Stimmung (positiv, negativ, neutral) gekennzeichnet wurden. Um ein Modell zum Erstellen eines Kundensupport-Chatbots zu trainieren, benötigen Sie einen Datensatz von Gesprächen zwischen Kunden und dem technischen Support.

Große Sprachmodelle haben dies geändert. LLMs werden anhand eines umfangreichen Text- und Code-Datensatzes vorab trainiert, wodurch sie eine Vielzahl von Aufgaben sofort gut bewältigen können, darunter:

- Textzusammenfassung

- Inhaltserstellung

- Übersetzungen

- Informationsextraktion

- Frage beantworten

- Stimmungsanalyse

- KUNDENSERVICE

- Verkaufsunterstützung

Der Prozess der Entwicklung von LLM-Anwendungen lässt sich in vier wesentliche Schritte unterteilen:

- Wählen Sie ein geeignetes Fundamentmodell. Es ist eine Schlüsselkomponente, die die Leistung Ihrer LLM-Anwendung definiert.

- Passen Sie das Modell bei Bedarf an. Möglicherweise müssen Sie das Modell verfeinern oder es mit der zusätzlichen Wissensdatenbank erweitern, um Ihren spezifischen Anforderungen gerecht zu werden.

- Richten Sie eine ML-Infrastruktur ein. Dazu gehört die Hardware und Software, die zum Ausführen Ihrer Anwendung erforderlich ist (z. B. Halbleiter, Chips, Cloud-Hosting, Inferenz und Bereitstellung).

- Erweitern Sie Ihre Anwendung mit zusätzlichen Tools. Diese Tools können dazu beitragen, die Effizienz, Leistung und Sicherheit Ihrer Anwendung zu verbessern.

Werfen wir nun einen Blick auf den entsprechenden Technologie-Stack.

Wenn dieser ausführliche Bildungsinhalt für Sie nützlich ist, abonnieren Sie unsere KI-Mailingliste benachrichtigt werden, wenn wir neues Material veröffentlichen.

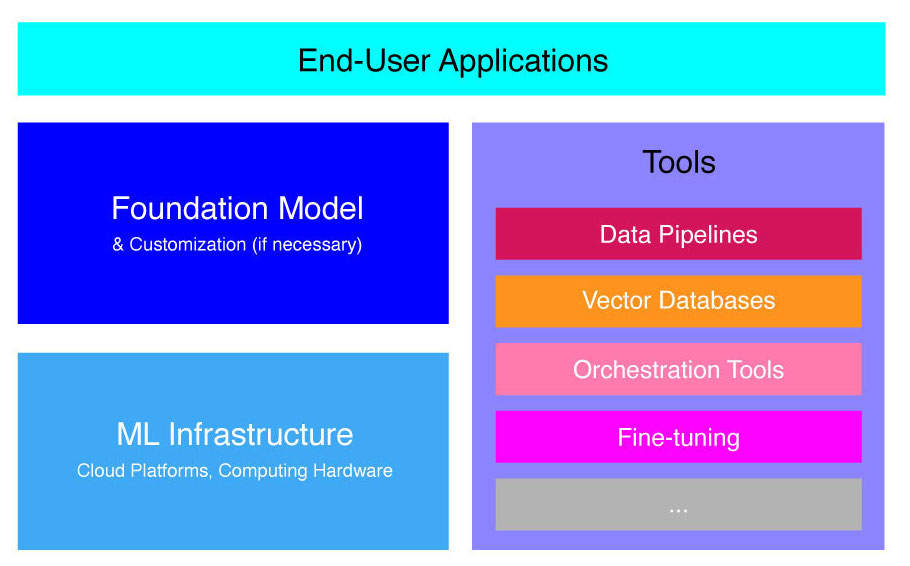

High-Level-LLM-Anwendungsstack

LLM-Anwendungen basieren auf mehreren Schlüsselkomponenten, darunter:

- Ein Gründungsmodell, was in bestimmten Anwendungsfällen möglicherweise eine Anpassung erfordert.

- ML-Infrastruktur für ausreichende Rechenressourcen über Cloud-Plattformen oder unternehmenseigene Hardware.

- Zusätzliche Werkzeuge, wie Datenpipelines, Vektordatenbanken, Orchestrierungstools, Feinabstimmung von ML-Plattformen, Tools zur Modellleistungsüberwachung usw.

Wir werden Sie kurz durch diese Komponenten führen, damit Sie das Toolkit, das zum Erstellen und Bereitstellen einer LLM-Anwendung erforderlich ist, besser verstehen.

Was sind Stiftungsmodelle?

Durch die Verwendung eines einzigen vorab trainierten LLM können Sie viel Zeit und Ressourcen sparen. Die Schulung eines solchen Modells von Grund auf ist jedoch ein zeitaufwändiger und kostspieliger Prozess, der die Fähigkeiten der meisten Unternehmen außer einigen wenigen Technologieführern übersteigt.

Mehrere Unternehmen und Forschungsteams haben diese Modelle trainiert und ermöglichen anderen Unternehmen, sie zu nutzen. Führende Beispiele sind ChatGPT, Claude, Llama, Jurassic und T5. Diese öffentlich zugänglichen Modelle werden als Stiftungsmodelle bezeichnet. Einige davon sind proprietär und können gegen eine Gebühr über API-Aufrufe abgerufen werden. Andere sind Open-Source und können kostenlos genutzt werden. Diese Modelle werden anhand eines riesigen Datensatzes unbeschrifteter Textdaten vorab trainiert, sodass sie eine Vielzahl von Aufgaben ausführen können, von der Erstellung kreativer Anzeigenkopien bis hin zur Kommunikation mit Ihren Kunden in deren Muttersprache im Namen des Unternehmens.

Es gibt zwei Haupttypen von Stiftungsmodellen: proprietäre und Open-Source-Modelle.

Proprietäre Modelle gehören einem einzelnen Unternehmen oder einer einzelnen Organisation und sind in der Regel nur gegen Gebühr erhältlich. Zu den beliebtesten Beispielen für proprietäre Modelle gehören GPT-Modelle von OpenAI, Claude-Modelle von Anthropic und Jurassic-Modelle von AI21 Labs.

Open-Source-Modelle stehen in der Regel jedem, der sie nutzen möchte, kostenlos zur Verfügung. Einige Open-Source-Modelle unterliegen jedoch Einschränkungen hinsichtlich ihrer Verwendung, z. B.: (1) sie sind nur für Forschungszwecke verfügbar, (2) sie sind nur für die kommerzielle Nutzung durch Unternehmen einer bestimmten Größe verfügbar. Die Open-Source-Community behauptet, dass solche Einschränkungen es einem Modell nicht ermöglichen, sich als „Open-Source“ zu qualifizieren. Zu den bekanntesten Beispielen für Sprachmodelle, die kostenlos genutzt werden können, gehören jedoch Llama-Modelle von Meta, Falcon-Modelle vom Technology Innovation Institute in Abu Dhabi und StableLM-Modelle von Stability AI. Lesen Sie mehr über Open-Source-Modelle und die damit verbundenen Risiken hier.

Lassen Sie uns nun einige Faktoren besprechen, die Sie bei der Auswahl eines Basismodells für Ihre LLM-Anwendung berücksichtigen sollten.

Wählen Sie ein Foundation-Modell

Die Auswahl des besten Basismodells für Ihre LLM-Anwendung kann ein herausfordernder Prozess sein, aber wir können ihn grundsätzlich in drei Schritte unterteilen:

- Wählen Sie zwischen proprietären und Open-Source-Modellen. Proprietäre Modelle sind in der Regel größer und leistungsfähiger als Open-Source-Modelle, ihre Verwendung kann jedoch teurer und weniger flexibel sein. Darüber hinaus ist der Code nicht so transparent, was es schwierig macht, Probleme mit der Leistung proprietärer Modelle zu debuggen oder zu beheben. Open-Source-Modelle hingegen erhalten in der Regel weniger Updates und weniger Support von den Entwicklern.

- Wählen Sie die Größe des Modells. Größere Modelle sind in der Regel besser in der Lage, Aufgaben zu erledigen, die viel Wissen erfordern, etwa das Beantworten von Fragen oder das Generieren kreativer Texte. Allerdings ist die Verwendung größerer Modelle auch rechenintensiver. Sie können zunächst mit größeren Modellen experimentieren und dann zu kleineren Modellen übergehen, solange die Leistung eines Modells für Ihren Anwendungsfall zufriedenstellend ist.

- Wählen Sie ein bestimmtes Modell aus. Sie können damit beginnen, die allgemeinen Benchmarks durchzugehen, um die zu testenden Modelle in die engere Auswahl zu nehmen. Anschließend testen Sie verschiedene Modelle für Ihre anwendungsspezifischen Aufgaben. Ziehen Sie für benutzerdefiniertes Benchmarking eine Berechnung in Betracht BLEU- und ROUGE-Wertungen, die Metriken, die helfen, die Anzahl der Korrekturen zu quantifizieren, die an KI-generiertem Text erforderlich sind, bevor die Ausgabe für Human-in-the-Loop-Anwendungen freigegeben wird.

Weitere Informationen zu den Unterschieden zwischen verschiedenen Sprachmodellen finden Sie hier Unser Überblick über die leistungsstärksten Sprach- (LLM) und visuellen Sprachmodelle (VLM).

Nachdem Sie ein Basismodell für Ihre Anwendung ausgewählt haben, können Sie überlegen, ob Sie das Modell für eine noch bessere Leistung anpassen müssen.

Passen Sie ein Fundamentmodell an

In einigen Fällen möchten Sie möglicherweise ein Foundation-Language-Modell anpassen, um eine bessere Leistung in Ihrem spezifischen Anwendungsfall zu erzielen. Beispielsweise möchten Sie möglicherweise Folgendes optimieren:

- Domain. Wenn Sie in bestimmten Bereichen wie Recht, Finanzen oder Gesundheitswesen tätig sind, möchten Sie möglicherweise das Vokabular des Modells in diesem Bereich erweitern, damit es Endbenutzeranfragen besser verstehen und beantworten kann.

- Aufgabe. Wenn Sie beispielsweise möchten, dass das Modell Marketingkampagnen generiert, können Sie ihm spezifische Beispiele für Markenmarketinginhalte bereitstellen. Dies hilft dem Modell, die Muster und Stile zu erlernen, die für Ihr Unternehmen und Ihre Zielgruppe geeignet sind.

- Tonfall. Wenn das Modell einen bestimmten Tonfall verwenden soll, können Sie das Modell anhand eines Datensatzes anpassen, der Beispiele Ihrer zielsprachlichen Stichproben enthält.

Es gibt drei Möglichkeiten, ein Foundation-Language-Modell anzupassen:

- Feintuning: Stellt dem Modell einen domänenspezifisch gekennzeichneten Datensatz mit etwa 100–500 Datensätzen zur Verfügung. Die Modellgewichte werden aktualisiert, was zu einer besseren Leistung bei den in diesem Datensatz dargestellten Aufgaben führen sollte.

- Domänenanpassung: Stellt dem Modell einen domänenspezifischen, unbeschrifteten Datensatz zur Verfügung, der einen großen Datenkorpus aus der entsprechenden Domäne enthält. In diesem Fall werden auch die Modellgewichte aktualisiert.

- Informationsrückgewinnung: Erweitert das Grundlagenmodell um geschlossenes Domänenwissen. Das Modell wird nicht erneut trainiert und die Modellgewichte bleiben gleich. Das Modell darf jedoch Informationen aus einer Vektordatenbank abrufen, die relevante Daten enthält.

Die ersten beiden Ansätze erfordern erhebliche Rechenressourcen, um das Modell neu zu trainieren, was normalerweise nur für große Unternehmen mit den entsprechenden technischen Fähigkeiten zur Verwaltung der Anpassung möglich ist. Kleinere Unternehmen verwenden in der Regel den gängigeren Ansatz, das Modell mithilfe einer Vektordatenbank um Domänenwissen zu erweitern, worauf wir später in diesem Artikel im Abschnitt über LLM-Tools näher eingehen.

Richten Sie die ML-Infrastruktur ein

Die ML-Infrastrukturkomponente der LLMOps-Landschaft umfasst die Cloud-Plattformen, Computerhardware und andere Ressourcen, die für die Bereitstellung und Ausführung von LLMs erforderlich sind. Diese Komponente ist besonders relevant, wenn Sie sich für die Verwendung eines Open-Source-Modells entscheiden oder das Modell für Ihre Anwendung anpassen. In diesem Fall benötigen Sie möglicherweise erhebliche Rechenressourcen, um das Modell bei Bedarf zu verfeinern und auszuführen.

Es gibt eine Reihe von Cloud-Plattformen, die Dienste für die Bereitstellung von LLMs anbieten, darunter Google Cloud Platform, Amazon Web Services und Microsoft Azure. Diese Plattformen bieten eine Reihe von Funktionen, die die Bereitstellung und Ausführung von LLMs vereinfachen, darunter:

- Vorab trainierte Modelle, die genau auf Ihre spezifische Anwendung abgestimmt werden können

- Verwaltete Infrastruktur, die sich um die zugrunde liegende Hardware und Software kümmert

- Tools und Dienste zum Überwachen und Debuggen Ihrer LLMs

Die Menge an Rechenressourcen, die Sie benötigen, hängt von der Größe und Komplexität Ihres Modells, den Aufgaben, die es ausführen soll, und dem Umfang der Geschäftsaktivität ab, in der Sie dieses Modell bereitstellen möchten.

Mit Werkzeugen erweitern

Zusätzliche LLM-angrenzende Tools können verwendet werden, um die Leistung Ihrer LLM-Anwendung weiter zu verbessern.

Datenpipelines

Wenn Sie Ihre Daten in Ihrem LLM-Produkt verwenden müssen, wird die Datenvorverarbeitungspipeline eine wesentliche Säule Ihres neuen Tech-Stacks sein, genau wie im traditionellen Enterprise-KI-Stack. Zu diesen Tools gehören Konnektoren zum Erfassen von Daten aus beliebigen Quellen, eine Datentransformationsebene und Downstream-Konnektoren. Führende Datenpipeline-Anbieter wie Databricks und Snowflake sowie neue Player wie Unstructured machen es Entwicklern einfach, auf große und äußerst heterogene Korpora natürlichsprachlicher Daten zu verweisen (z. B. Tausende von PDFs, PowerPoint-Präsentationen, Chat-Protokollen, gescraptes HTML, usw.) an einen einzigen Zugriffspunkt oder sogar in ein einzelnes Dokument, das von LLM-Anwendungen weiterverwendet werden kann.

Vektordatenbanken

Große Sprachmodelle sind auf die gleichzeitige Verarbeitung einiger tausend Wörter beschränkt und können daher große Dokumente nicht effektiv selbst verarbeiten. Um die Leistungsfähigkeit großer Dokumente zu nutzen, müssen Unternehmen Vektordatenbanken verwenden.

Vektordatenbanken sind Speichersysteme, die große Dokumente, die sie über Datenpipelines erhalten, in verwaltbare Vektoren oder Einbettungen umwandeln. LLM-Anwendungen können diese Datenbanken dann abfragen, um die richtigen Vektoren zu ermitteln und nur die notwendigen Informationsnuggets zu extrahieren.

Zu den bekanntesten derzeit verfügbaren Vektordatenbanken gehören Pinecone, Chroma und Weaviate.

Orchestrierungstools

Wenn ein Benutzer eine Anfrage an Ihre LLM-Anwendung sendet, beispielsweise eine Frage an den Kundendienst, muss die Anwendung eine Reihe von Eingabeaufforderungen erstellen, bevor diese Anfrage an das Sprachmodell gesendet wird. Die endgültige Anfrage an das Sprachmodell besteht in der Regel aus einer vom Entwickler hartcodierten Eingabeaufforderungsvorlage, Beispielen für gültige Ausgaben, sogenannten „Fow-Shot-Beispielen“, allen erforderlichen Informationen, die von externen APIs abgerufen werden, und einer Reihe relevanter Dokumente, die aus der Vektordatenbank abgerufen werden . Orchestrierungstools von Unternehmen wie LangChain oder LlamaIndex können zur Rationalisierung dieses Prozesses beitragen, indem sie gebrauchsfertige Frameworks für die Verwaltung und Ausführung von Eingabeaufforderungen bereitstellen.

Feintuning

Große Sprachmodelle, die auf riesigen Datensätzen trainiert werden, können grammatikalisch korrekte und flüssige Texte erzeugen. In bestimmten Bereichen, beispielsweise in der Medizin oder im Recht, kann es ihnen jedoch an Präzision mangeln. Die Feinabstimmung dieser Modelle anhand domänenspezifischer Datensätze ermöglicht es ihnen, die einzigartigen Merkmale dieser Bereiche zu verinnerlichen und so ihre Fähigkeit zur Generierung relevanter Texte zu verbessern.

Die Feinabstimmung eines LLM kann für kleine Unternehmen ein kostenintensiver Prozess sein. Lösungen von Unternehmen wie Weights & Biases und OctoML können jedoch bei der optimierten und effizienten Feinabstimmung helfen. Diese Lösungen bieten Unternehmen eine Plattform zur Feinabstimmung von LLMs, ohne in ihre eigene Infrastruktur investieren zu müssen.

Andere Werkzeuge

Es gibt viele andere Tools, die zum Erstellen und Ausführen von LLM-Anwendungen nützlich sein können. Beispielsweise benötigen Sie möglicherweise Beschriftungstools, wenn Sie das Modell mit Ihren spezifischen Datenproben verfeinern möchten. Möglicherweise möchten Sie auch bestimmte Tools bereitstellen, um die Leistung Ihrer Anwendung zu überwachen, da bereits geringfügige Änderungen am Basismodell oder Anforderungen von Kunden die Leistung von Eingabeaufforderungen erheblich beeinträchtigen können. Schließlich gibt es Tools, die die Modellsicherheit überwachen und Ihnen dabei helfen, die Förderung hasserfüllter Inhalte, gefährlicher Empfehlungen oder Vorurteile zu vermeiden. Die Notwendigkeit und Bedeutung dieser verschiedenen Tools hängt von Ihrem spezifischen Anwendungsfall ab.

Was kommt als nächstes in der LLM-Anwendungsentwicklung?

Die vier Schritte zur LLM-Produktentwicklung, die wir hier besprochen haben, sind eine wesentliche Grundlage der generativen KI-Strategie eines jeden Unternehmens, das große Sprachmodelle nutzt. Für technisch nicht versierte Unternehmensleiter ist es wichtig, sie zu verstehen, auch wenn Sie ein technisches Team haben, das die Details umsetzt. Wir werden in Zukunft detailliertere Tutorials veröffentlichen, die zeigen, wie Sie die breite Palette generativer KI-Tools auf dem Markt nutzen können. Im Moment ist das möglich abonnieren sie unseren newsletter um die neuesten Updates zu erhalten.

Gefällt Ihnen dieser Artikel? Melden Sie sich für weitere Updates zur Unternehmens-KI an.

Wir werden Sie informieren, wenn wir weitere zusammenfassende Artikel wie diesen veröffentlichen.

Verbunden

- SEO-gestützte Content- und PR-Distribution. Holen Sie sich noch heute Verstärkung.

- PlatoData.Network Vertikale generative KI. Motiviere dich selbst. Hier zugreifen.

- PlatoAiStream. Web3-Intelligenz. Wissen verstärkt. Hier zugreifen.

- PlatoESG. Automobil / Elektrofahrzeuge, Kohlenstoff, CleanTech, Energie, Umwelt, Solar, Abfallwirtschaft. Hier zugreifen.

- BlockOffsets. Modernisierung des Eigentums an Umweltkompensationen. Hier zugreifen.

- Quelle: https://www.topbots.com/llm-product-development-technology-stack/

- :Ist

- :nicht

- :Wo

- $UP

- 1

- a

- Fähigkeit

- Über Uns

- abu dhabi

- Zugang

- Zugriff

- Aktivität

- Ad

- Zusätzliche

- zusätzlich

- benachbart

- AI

- AI-Strategie

- erlauben

- erlaubt

- erlaubt

- ebenfalls

- Amazon

- Amazon Web Services

- Betrag

- an

- analysieren

- und

- Ein anderer

- Anthropisch

- jedem

- jemand

- Bienen

- APIs

- Anwendung

- Anwendungsentwicklung

- Anwendungen

- Ansatz

- Ansätze

- angemessen

- SIND

- Bereiche

- Artikel

- Artikel

- AS

- damit verbundenen

- At

- Publikum

- verfügbar

- vermeiden

- Azure

- Base

- Grundsätzlich gilt

- BE

- war

- Bevor

- Namen

- Sein

- Benchmarking

- Benchmarks

- BESTE

- Besser

- zwischen

- Beyond

- Vorurteile

- Auftrieb

- Box

- Marke

- gebrandmarkt

- Break

- kurz

- Gebrochen

- bauen

- Building

- erbaut

- Geschäft

- Geschäftsanwendungen

- Geschäftsführer

- Unternehmen

- aber

- by

- Berechnung

- namens

- Aufrufe

- Kampagnen

- CAN

- Fähigkeiten

- fähig

- österreichische Unternehmen

- Häuser

- Fälle

- sicher

- herausfordernd

- geändert

- Änderungen

- Chatbot

- ChatGPT

- aus der Ferne überprüfen

- Pommes frites

- Auswählen

- Auswahl

- gewählt

- aus aller Welt

- Cloud

- Cloud-Hosting

- Cloud-Plattform

- Code

- kommerziell

- gemeinsam

- Kommunizieren

- community

- Unternehmen

- Unternehmen

- Unternehmen

- Komplexität

- Komponente

- Komponenten

- zusammengesetzt

- Computing

- Nachteile

- Geht davon

- konstruieren

- enthält

- Inhalt

- Gespräche

- Kopien

- Ecke

- und beseitigen Muskelschwäche

- Korrekturen

- Dazugehörigen

- teuer werden

- Kreativ (Creative)

- Zur Zeit

- Original

- Kunde

- Kundenservice

- Kundensupport

- Kunden

- Anpassung

- anpassen

- Gefährlich

- technische Daten

- Datenbase

- Datenbanken

- Databricks

- Datensätze

- tiefer

- Definition

- Abhängig

- einsetzen

- Bereitstellen

- Einsatz

- Detail

- detailliert

- Details

- entwickeln

- Entwickler:in / Unternehmen

- Entwickler

- Entwicklung

- Entwicklung

- Dhabi

- Unterschiede

- anders

- schwer

- diskutieren

- diskutiert

- Dokument

- Unterlagen

- Tut nicht

- Domain

- Domains

- nach unten

- e

- jeder

- Einfache

- Bildungs-

- effektiv

- Effizienz

- effizient

- Elite

- ermöglichen

- zu steigern,

- Eine Verbesserung der

- bereichern

- Unternehmen

- insbesondere

- essential

- etc

- Äther (ETH)

- Sogar

- Jedes

- Beispiel

- Beispiele

- Außer

- Ausführung

- Führungskräfte

- teuer

- extern

- Faktoren

- Falke

- möglich

- Eigenschaften

- Gebühr

- wenige

- Weniger

- Finale

- Endlich

- Revolution

- Vorname

- flexibel

- Aussichten für

- Foundation

- vier

- Gerüste

- Frei

- für

- weiter

- Zukunft

- Allgemeines

- erzeugen

- Erzeugung

- Generation

- generativ

- Generative KI

- bekommen

- ABSICHT

- Globus

- Go

- gehen

- Cumolocity

- Google Cloud Platform

- Boden

- Pflege

- Hardware

- Geschirr

- Haben

- mit

- Gesundheitswesen

- Hilfe

- hier

- High-Level

- hoch

- Hosting

- Ultraschall

- Hilfe

- aber

- HTML

- HTTPS

- i

- if

- Impact der HXNUMXO Observatorien

- Umsetzung

- Bedeutung

- wichtig

- zu unterstützen,

- in

- eingehende

- das

- Dazu gehören

- Einschließlich

- Energiegewinnung

- Information

- Infrastruktur

- Innovation

- Institut

- integrieren

- in

- Einleitung

- Investieren

- IT

- jpg

- nur

- Wesentliche

- Art

- Wissen

- Wissen

- Beschriftung

- Labs

- Mangel

- Landschaft

- Sprache

- grosse

- größer

- später

- neueste

- Letzte Aktualisierung

- Recht

- Schicht

- Führung

- führenden

- LERNEN

- lernen

- Rechtlich

- weniger

- Hebelwirkung

- Hebelwirkungen

- Gefällt mir

- Einschränkungen

- Limitiert

- Lama

- Lang

- aussehen

- Los

- Maschine

- Maschinelles Lernen

- Main

- um

- MACHT

- verwalten

- flächendeckende Gesundheitsprogramme

- viele

- Markt

- Marktforschung

- Marketing

- Marketing-Kampagnen

- Marktplatz

- massiv

- Ihres Materials

- max-width

- Kann..

- Bedeutung

- Medizin

- Triff

- Meta

- Metrik

- Microsoft

- Microsoft Azure

- könnte

- Moll

- ML

- Modell

- für

- Überwachen

- Überwachung

- mehr

- vor allem warme

- Am beliebtesten

- nativen

- Natürliche

- Natürliche Sprache

- notwendig,

- Need

- erforderlich

- Bedürfnisse

- Negativ

- Neutral

- Neu

- Neue Technologie

- Newsletter

- weiter

- Nicht-technisch

- jetzt an

- Anzahl

- of

- bieten

- on

- EINEM

- Einsen

- einzige

- Open-Source-

- OpenAI

- betreiben

- Optimieren

- or

- Orchesterbearbeitung

- Organisation

- Andere

- Anders

- UNSERE

- Möglichkeiten für das Ausgangssignal:

- Überblick

- besitzen

- Besitz

- Muster

- ausführen

- Leistung

- Durchführung

- Säule

- Pipeline

- Plattform

- Plattformen

- Plato

- Datenintelligenz von Plato

- PlatoData

- Points

- Beliebt

- positiv

- möglich

- Werkzeuge

- größte treibende

- Präzision

- Presentations

- Probleme

- Prozessdefinierung

- Verarbeitung

- produziert

- Produkt

- Produktentwicklung

- prominent

- Die Förderung der

- Eigentums-

- PROS

- die

- Anbieter

- bietet

- Bereitstellung

- veröffentlichen

- Zwecke

- Putting

- qualifizieren

- Qualität

- Abfragen

- Frage

- Fragen

- Angebot

- Lesen Sie mehr

- erhalten

- Empfehlungen

- Aufzeichnungen

- Release

- Loslassen

- relevant

- zuverlässig

- vertreten

- Anforderung

- Zugriffe

- erfordern

- erfordert

- Forschungsprojekte

- Downloads

- Reagieren

- Einschränkungen

- Folge

- Überprüfung

- Bewertungen

- Recht

- Risiken

- Führen Sie

- Laufen

- Sicherheit

- gleich

- Speichern

- Skalieren

- Abschnitt

- Sicherheitdienst

- Halbleiter

- Gefühl

- getrennte

- Modellreihe

- Lösungen

- kompensieren

- mehrere

- sollte

- Schild

- signifikant

- bedeutend

- Single

- Größe

- klein

- kleinere

- So

- Software

- Lösungen

- einige

- Quelle

- spezifisch

- Stabilität

- Stapel

- Anfang

- bleiben

- Shritte

- Immer noch

- Lagerung

- Strategie

- rationalisieren

- gestrafft

- Stile

- so

- ausreichend

- ZUSAMMENFASSUNG

- Support

- Systeme und Techniken

- Nehmen

- nimmt

- Athleten

- Target

- Aufgabe

- und Aufgaben

- Team

- Teams

- Tech

- Technische

- technischer Support

- Technologie

- technologische Innovation

- Vorlage

- Testen

- als

- zur Verbesserung der Gesundheitsgerechtigkeit

- Das

- Die Zukunft

- ihr

- Sie

- dann

- Dort.

- Diese

- vom Nutzer definierten

- fehlen uns die Worte.

- diejenigen

- Tausende

- nach drei

- Durch

- Zeit

- Zeitaufwendig

- zu

- TONE

- Tonfall

- Toolkit

- Werkzeuge

- Top

- TOPBOTS

- traditionell

- Training

- trainiert

- Ausbildung

- Transformieren

- Transformation

- transparent

- Tutorials

- XNUMX

- Typen

- typisch

- zugrunde liegen,

- verstehen

- Verständnis

- einzigartiges

- Alleinstellungsmerkmale

- aktualisiert

- Updates

- -

- Anwendungsfall

- benutzt

- Mitglied

- gewöhnlich

- verschiedene

- Stimme

- vs

- wollen

- wollte

- will

- Wege

- we

- Netz

- Web-Services

- GUT

- waren

- wann

- ob

- welche

- WHO

- breit

- Große Auswahl

- werden wir

- mit

- ohne

- Worte

- Arbeiten

- würde

- U

- Ihr

- Zephyrnet