Finite-Elemente-Methoden zur Analyse tauchen in vielen Bereichen des Entwurfs elektronischer Systeme auf: mechanische Spannungsanalyse in Mehrchip-Systemen, thermische Analyse als Gegenstück zur Kühlungs- und Spannungsanalyse (z. B. Verzug) und elektromagnetische Compliance-Analyse. (Computational Fluid Dynamics – CFD – ist ein anderes Thema, das ich vielleicht in einem separaten Blog behandeln werde.) Ich habe Themen in diesem Bereich mit einem anderen Kunden behandelt und finde das Fachgebiet weiterhin attraktiv, weil es zu meinem physikalischen Hintergrund und meinem inneren Mathematikfreak passt (Lösen von Differentialgleichungen). Hier erkunde ich a jüngsten Papier von der Siemens AG zusammen mit den Technischen Universitäten München und Braunschweig.

Die Problemstellung

Finite-Elemente-Methoden sind Techniken zur numerischen Lösung von Systemen 2D/3D partieller Differentialgleichungen (PDEs), die in vielen physikalischen Analysen auftreten. Diese können von der Wärmeverteilung in einem komplexen SoC über EM-Analysen für Automobilradar bis hin zur Biegung einer mechanischen Struktur unter Belastung bis hin zum Zerknittern der Front eines Autos bei einem Unfall reichen.

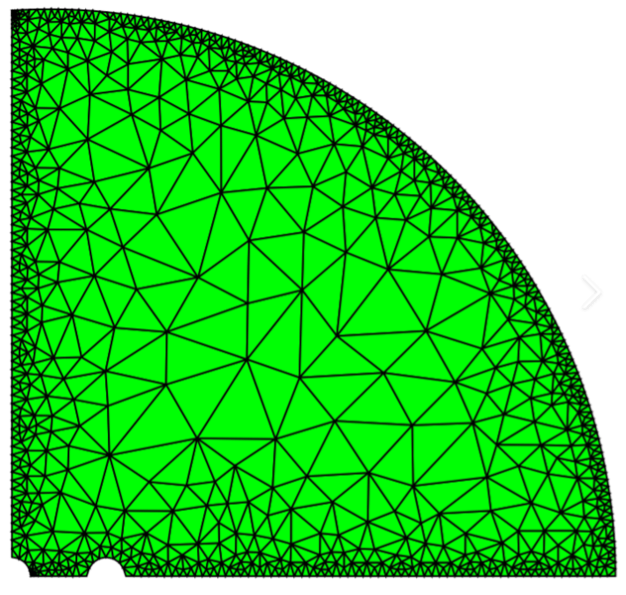

Bei der FEM wird ein Netz über den physischen Raum hinweg als diskreter Rahmen für die Analyse erstellt, der um Grenzen und insbesondere sich schnell ändernde Randbedingungen herum feinkörniger und an anderen Stellen grobkörniger ist. Die Methode überspringt die wichtigen Details und optimiert lineare Überlagerungen einfacher Funktionen über das Netz hinweg, indem die Koeffizienten in der Überlagerung variiert werden. Die Optimierung zielt darauf ab, eine beste Anpassung innerhalb einer akzeptablen Toleranz zu finden, die mit diskreten Proxys für die PDEs zusammen mit Anfangsbedingungen und Randbedingungen durch lineare Algebra und andere Methoden vereinbar ist.

Um eine akzeptable Genauigkeit zu erreichen, sind in der Regel sehr große Netze erforderlich, was zu sehr langen Laufzeiten für FEM-Lösungen für realistische Probleme führt und noch aufwändiger wird, wenn mehrere Analysen zur Erkundung von Optimierungsmöglichkeiten durchgeführt werden. Jeder Durchlauf beginnt im Wesentlichen von vorne, ohne Lerneffekt zwischen den Durchläufen, was die Möglichkeit bietet, ML-Methoden zur Beschleunigung der Analyse einzusetzen.

Möglichkeiten zur Verwendung von ML mit FEM

Ein weit verbreiteter Ansatz zur Beschleunigung von FEM-Analysen (FEAs) ist die Erstellung von Ersatzmodellen. Diese ähneln abstrakten Modellen in anderen Bereichen – vereinfachte Versionen der vollen Komplexität des ursprünglichen Modells. FEA-Experten sprechen von Reduced Order Models (ROMs), die weiterhin eine gute Annäherung an das (diskretisierte) physikalische Verhalten des Quellmodells aufweisen, aber zumindest in der Entwurfsoptimierungsphase die Notwendigkeit der Ausführung einer FEA umgehen, obwohl sie viel schneller als die FEA laufen .

Eine Möglichkeit, einen Ersatz zu erstellen, wäre, mit einer Reihe von FEAs zu beginnen und diese Informationen als Trainingsdatenbank zum Erstellen des Ersatzes zu verwenden. Dies erfordert jedoch immer noch langwierige Analysen, um Trainingssätze von Ein- und Ausgängen zu generieren. Die Autoren weisen auch auf eine weitere Schwäche eines solchen Ansatzes hin. ML verfügt über kein natives Verständnis der physikalischen Einschränkungen, die bei all diesen Anwendungen wichtig sind, und ist daher anfällig für Halluzinationen, wenn es mit einem Szenario außerhalb seines Trainingssatzes konfrontiert wird.

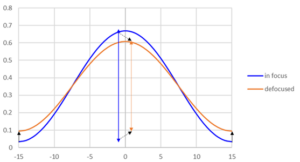

Umgekehrt ersetzt das Ersetzen von FEM durch a physikalisch informiertes neuronales Netzwerk (PINN) bezieht physikalische PDEs in Verlustfunktionsberechnungen ein und führt im Wesentlichen physikalische Einschränkungen in Gradienten-basierte Optimierungen ein. Dies ist eine clevere Idee, obwohl spätere Untersuchungen gezeigt haben, dass die Methode zwar bei einfachen Problemen funktioniert, bei Hochfrequenz- und Multiskalenmerkmalen jedoch versagt. Enttäuschend ist auch, dass die Trainingszeit für solche Methoden länger sein kann als die FEA-Laufzeiten.

In diesem Artikel wird eine interessante Alternative vorgeschlagen: die engere Kombination von FEA- und ML-Training, sodass ML-Verlustfunktionen anhand der FEA-Fehlerberechnungen trainiert werden, um Versuchslösungen im gesamten Netz anzupassen. Es besteht eine gewisse Ähnlichkeit mit dem PINN-Ansatz, jedoch mit einem wichtigen Unterschied: Dieses neuronale Netz läuft zusammen mit der FEA, um die Konvergenz zu einer Lösung im Training zu beschleunigen. Was offenbar zu einem schnelleren Training führt. In der Schlussfolgerung läuft das neuronale Netzmodell ohne die Notwendigkeit einer FEA. Konstruktionsbedingt sollte ein auf diese Weise trainiertes Modell eng an die physikalischen Einschränkungen des realen Problems angepasst werden, da es sehr genau gegen einen physikalisch bewussten Löser trainiert wurde.

Ich denke, meine Interpretation hier ist ziemlich zutreffend. Ich freue mich über Korrekturen von Experten!

Teile diesen Beitrag über:

- SEO-gestützte Content- und PR-Distribution. Holen Sie sich noch heute Verstärkung.

- PlatoData.Network Vertikale generative KI. Motiviere dich selbst. Hier zugreifen.

- PlatoAiStream. Web3-Intelligenz. Wissen verstärkt. Hier zugreifen.

- PlatoESG. Kohlenstoff, CleanTech, Energie, Umwelt, Solar, Abfallwirtschaft. Hier zugreifen.

- PlatoHealth. Informationen zu Biotechnologie und klinischen Studien. Hier zugreifen.

- Quelle: https://semiwiki.com/artificial-intelligence/341034-blending-finite-element-methods-and-ml/

- :hast

- :Ist

- $UP

- a

- Über Uns

- ABSTRACT

- beschleunigen

- akzeptabel

- Genauigkeit

- genau

- über

- AG

- gegen

- Ziel

- Alle

- ebenfalls

- Alternative

- an

- Analysen

- Analyse

- und

- Ein anderer

- Anwendungen

- Ansatz

- SIND

- Bereich

- entstehen

- um

- AS

- At

- attraktiv

- Autoren

- Automobilindustrie

- bewusst

- Hintergrund

- BE

- weil

- Werden

- war

- Verhalten

- BESTE

- zwischen

- Vermischung

- Blog

- beide

- Grenzen

- geht kaputt

- bauen

- Haufen

- aber

- by

- umgehen

- CAN

- Auto

- CFD

- Auftraggeber

- eng

- kombinieren

- häufig

- Komplex

- Komplexität

- Compliance

- rechnerisch

- Bedingungen

- konsistent

- Einschränkungen

- aufgebaut

- Baugewerbe

- fortsetzen

- Konvergenz

- Korrekturen

- Gegenstück

- Abdeckung

- bedeckt

- Crash

- Ernte

- Datenbase

- Design

- Details

- Unterschied

- anders

- enttäuschend

- Domain

- Domains

- nach unten

- Dynamik

- jeder

- elektronisch

- Element

- anderswo

- Gleichungen

- Fehler

- insbesondere

- Essenz

- im Wesentlichen

- Sogar

- zeigen

- Experten

- ERKUNDEN

- erweitern

- ziemlich

- beschleunigt

- Eigenschaften

- Finden Sie

- passen

- passend zu

- Flüssigkeit

- Fluiddynamik

- Aussichten für

- Unser Ansatz

- Frequenz

- für

- Materials des

- voller

- Funktion

- Funktionen

- Aussenseiter

- erzeugen

- gut

- Haben

- hier

- GUTE

- Ultraschall

- aber

- HTTPS

- i

- Idee

- if

- wichtig

- in

- In anderen

- beinhaltet

- Information

- informiert

- Anfangs-

- innere

- Eingänge

- Interpretation

- in

- faszinierend

- Einführung

- IT

- SEINE

- grosse

- führenden

- lernen

- am wenigsten

- Hebelwirkung

- Gefällt mir

- Lang

- länger

- Verlust

- viele

- Mathe

- max-width

- mechanisch

- Triff

- ineinander greifen

- Methode

- Methoden

- könnte

- Min.

- ML

- Modell

- für

- mehr

- viel

- mehrere

- München

- my

- nativen

- Need

- erforderlich

- Netto-

- Neural

- nicht

- of

- on

- Gelegenheit

- Optimierung

- Verbessert

- Auftrag

- Original

- Andere

- Ausgänge

- aussen

- Papier

- Phase

- physikalisch

- Physisch

- Physik

- Plato

- Datenintelligenz von Plato

- PlatoData

- Points

- Möglichkeiten

- Post

- Präsenz

- vorgeführt

- Aufgabenstellung:

- Probleme

- Proxies

- Radar

- schnell

- echt

- realistisch

- Reduziert

- erfordert

- Forschungsprojekte

- Resoniert

- Die Ergebnisse

- Führen Sie

- Laufen

- läuft

- Szenario

- kratzen

- getrennte

- kompensieren

- Sets

- sollte

- gezeigt

- Siemens

- Einfacher

- vereinfachte

- da

- So

- Lösung

- Lösungen

- LÖSEN

- Auflösung

- einige

- Quelle

- Raumfahrt

- Anfang

- beginnt

- Immer noch

- Der Stress

- Struktur

- Folge

- so

- Schlägt vor

- Überlagerung

- System

- Systeme und Techniken

- Reden

- Technische

- Techniken

- als

- zur Verbesserung der Gesundheitsgerechtigkeit

- Das

- Die Quelle

- Dort.

- deswegen

- Thermal-

- Diese

- think

- fehlen uns die Worte.

- obwohl?

- Durch

- Zeit

- mal

- zu

- gemeinsam

- Toleranz

- Themen

- Training

- trainiert

- Ausbildung

- Versuch

- für

- Verständnis

- Universitäten

- -

- benutzt

- Verwendung von

- Variieren

- Versionen

- sehr

- Weg..

- Schwäche

- willkommen

- wann

- welche

- während

- weit

- mit

- .

- ohne

- Werk

- würde

- Zephyrnet