Bild von starline

In der heutigen Welt haben sich vor allem zwei Kräfte als bahnbrechende Faktoren herauskristallisiert:

Datenwissenschaft und Cloud Computing.

Stellen Sie sich eine Welt vor, in der jede Sekunde riesige Datenmengen generiert werden.

Nun ja... Sie müssen es sich nicht vorstellen... Es ist unsere Welt!

Von Social-Media-Interaktionen bis hin zu Finanztransaktionen, von Gesundheitsakten bis hin zu E-Commerce-Präferenzen – Daten sind überall.

Aber was nützen diese Daten, wenn wir keinen Wert daraus ziehen können?

Genau das macht Data Science.

Und wo speichern, verarbeiten und analysieren wir diese Daten?

Hier glänzt Cloud Computing.

Begeben wir uns auf eine Reise, um die miteinander verflochtene Beziehung zwischen diesen beiden technologischen Wunderwerken zu verstehen.

Lasst uns (versuchen) es gemeinsam zu entdecken!

Data Science? – Die Kunst, Erkenntnisse zu gewinnen

Data Science ist die Kunst und Wissenschaft, aus umfangreichen und vielfältigen Daten aussagekräftige Erkenntnisse zu gewinnen.

Es kombiniert Fachwissen aus verschiedenen Bereichen wie Statistik und maschinellem Lernen, um Daten zu interpretieren und fundierte Entscheidungen zu treffen.

Mit der Datenexplosion ist die Rolle von Datenwissenschaftlern bei der Umwandlung von Rohdaten in Gold von entscheidender Bedeutung geworden.

Cloud Computing? – Die digitale Speicherrevolution

Unter Cloud Computing versteht man die bedarfsgerechte Bereitstellung von Computerdiensten über das Internet.

Ganz gleich, ob wir Speicher, Rechenleistung oder Datenbankdienste benötigen: Cloud Computing bietet Unternehmen und Fachleuten eine flexible und skalierbare Umgebung, in der sie ohne den Aufwand für die Wartung einer physischen Infrastruktur arbeiten können.

Die meisten von Ihnen fragen sich jedoch sicherlich: Warum hängen sie zusammen?

Kehren wir zum Anfang zurück ...

Es gibt zwei Hauptgründe, warum sich Cloud Computing zu einer zentralen oder ergänzenden Komponente der Datenwissenschaft entwickelt hat.

#1. Die zwingende Notwendigkeit der Zusammenarbeit

Zu Beginn ihrer datenwissenschaftlichen Reise beginnen junge Datenprofis normalerweise damit, Python und R auf ihren PCs einzurichten. Anschließend schreiben und führen sie Code mithilfe einer lokalen integrierten Entwicklungsumgebung (IDE) wie Jupyter Notebook Application oder RStudio aus.

Da jedoch Data-Science-Teams wachsen und fortgeschrittene Analysen immer häufiger eingesetzt werden, steigt die Nachfrage nach kollaborativen Tools zur Bereitstellung von Erkenntnissen, prädiktiven Analysen und Empfehlungssystemen.

Aus diesem Grund ist die Notwendigkeit kollaborativer Tools von größter Bedeutung. Diese Tools, die für die Ableitung von Erkenntnissen, prädiktiven Analysen und Empfehlungssystemen unerlässlich sind, werden durch reproduzierbare Forschung, Notebook-Tools und Code-Quellcodeverwaltung unterstützt. Die Integration cloudbasierter Plattformen verstärkt dieses Potenzial der Zusammenarbeit zusätzlich.

Bild von Makrovektor

Es ist wichtig zu beachten, dass die Zusammenarbeit nicht nur auf Data-Science-Teams beschränkt ist.

Es umfasst eine viel breitere Palette von Personen, darunter Stakeholder wie Führungskräfte, Abteilungsleiter und andere datenzentrierte Rollen.

#2. Das Zeitalter von Big Data

Die Big Data erfreut sich zunehmender Beliebtheit, insbesondere bei großen Technologieunternehmen. Auch wenn die genaue Definition noch unklar ist, bezieht sich der Begriff im Allgemeinen auf Datensätze, die so umfangreich sind, dass sie die Möglichkeiten von Standarddatenbanksystemen und Analysemethoden übersteigen.

Diese Datensätze überschreiten die Grenzen typischer Softwaretools und Speichersysteme hinsichtlich der Erfassung, Speicherung, Verwaltung und Verarbeitung der Daten in einem angemessenen Zeitrahmen.

Denken Sie bei der Betrachtung von Big Data immer an die 3 Vs:

- Volumen: Bezieht sich auf die schiere Datenmenge.

- abwechslungsreich: Weist auf die unterschiedlichen Formate, Typen und analytischen Anwendungen von Daten hin.

- Geschwindigkeit: Gibt die Geschwindigkeit an, mit der sich Daten entwickeln oder generiert werden.

Da die Datenmenge weiter wächst, besteht ein dringender Bedarf an leistungsfähigeren Infrastrukturen und effizienteren Analysetechniken.

Diese beiden Hauptgründe sind also der Grund, warum wir – als Datenwissenschaftler – über lokale Computer hinaus skalieren müssen.

Anstatt über eine eigene Computerinfrastruktur oder Rechenzentren zu verfügen, können Unternehmen und Fachleute den Zugriff auf alles, von Anwendungen bis hin zu Speicher, von einem Cloud-Dienstanbieter mieten.

Dadurch können Unternehmen und Fachleute für das bezahlen, was sie nutzen, wenn sie es nutzen. anstatt sich mit den Kosten und der Komplexität der Wartung einer eigenen lokalen IT-Infrastruktur auseinanderzusetzen.

Um es einfach auszudrücken: Cloud Computing ist die Bereitstellung von On-Demand-Computing-Diensten – von Anwendungen bis hin zu Speicher- und Rechenleistung – typischerweise über das Internet und auf Pay-as-you-go-Basis.

Was die gängigsten Anbieter betrifft, bin ich mir ziemlich sicher, dass Sie alle mindestens einen davon kennen. Google (Google Cloud), Amazon (Amazon Web Services) und Microsoft (Microsoft Azure) sind die drei am weitesten verbreiteten Cloud-Technologien und kontrollieren fast den gesamten Markt.

Die Cloud mag abstrakt klingen, hat aber eine greifbare Bedeutung.

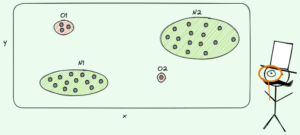

Im Kern geht es bei der Cloud um die gemeinsame Nutzung von Ressourcen durch vernetzte Computer. Stellen Sie sich das Internet als das umfangreichste Computernetzwerk vor, kleinere Beispiele sind Heimnetzwerke wie LAN oder WLAN-SSID. Diese Netzwerke teilen Ressourcen, die von Webseiten bis hin zur Datenspeicherung reichen.

In diesen Netzwerken werden einzelne Rechner bezeichnet Fiber Node. Sie kommunizieren über Protokolle wie HTTP für verschiedene Zwecke, einschließlich Statusaktualisierungen und Datenanfragen. Oftmals befinden sich diese Computer nicht vor Ort, sondern in Rechenzentren, die mit der notwendigen Infrastruktur ausgestattet sind.

Angesichts der Erschwinglichkeit von Computern und Speicher ist es heute üblich, mehrere miteinander verbundene Computer anstelle eines teuren Kraftpakets zu verwenden. Dieser vernetzte Ansatz gewährleistet einen kontinuierlichen Betrieb auch beim Ausfall eines Computers und ermöglicht die Bewältigung erhöhter Belastungen des Systems.

Beliebte Plattformen wie Twitter, Facebook und Netflix sind Beispiele für cloudbasierte Anwendungen, mit denen Millionen täglicher Benutzer ohne Abstürze verwaltet werden können. Wenn Computer im selben Netzwerk für ein gemeinsames Ziel zusammenarbeiten, spricht man von einem Gruppe.

Cluster, die als einzelne Einheit fungieren, bieten verbesserte Leistung, Verfügbarkeit und Skalierbarkeit.

Distributed Computing bezieht sich auf Software, die zur Nutzung entwickelt wurde Clustern für bestimmte Aufgaben, wie Hadoop und Spark.

Also... nochmal... was ist die Wolke?

Über die gemeinsam genutzten Ressourcen hinaus umfasst die Cloud Server, Dienste, Netzwerke und mehr, die von einer einzigen Einheit verwaltet werden.

Das Internet ist zwar ein riesiges Netzwerk, aber keine Cloud, da es keiner einzelnen Partei gehört.

Zusammenfassend lässt sich sagen, dass Data Science und Cloud Computing zwei Seiten derselben Medaille sind.

Data Science vermittelt Fachleuten alle Theorien und Techniken, die zur Wertschöpfung aus Daten erforderlich sind.

Cloud Computing stellt die Infrastruktur bereit, um genau diese Daten zu speichern und zu verarbeiten.

Während die erste uns das Wissen vermittelt, um jedes Projekt beurteilen zu können, gibt uns die zweite die Machbarkeit, es umzusetzen.

Gemeinsam bilden sie ein starkes Tandem, das technologische Innovationen vorantreibt.

Im weiteren Verlauf wird die Synergie zwischen diesen beiden stärker werden und den Weg für eine stärker datengesteuerte Zukunft ebnen.

Ergreifen Sie die Zukunft, denn sie ist datengesteuert und cloudbasiert!

Josef Ferrer ist Analytikingenieur aus Barcelona. Er hat einen Abschluss in Physikingenieurwesen und arbeitet derzeit im Bereich Data Science für die menschliche Mobilität. Er ist ein Teilzeit-Content-Creator, der sich auf Data Science und Technologie konzentriert. Sie können ihn unter kontaktieren LinkedIn, Twitter or Medium.

- SEO-gestützte Content- und PR-Distribution. Holen Sie sich noch heute Verstärkung.

- PlatoData.Network Vertikale generative KI. Motiviere dich selbst. Hier zugreifen.

- PlatoAiStream. Web3-Intelligenz. Wissen verstärkt. Hier zugreifen.

- PlatoESG. Kohlenstoff, CleanTech, Energie, Umwelt, Solar, Abfallwirtschaft. Hier zugreifen.

- PlatoHealth. Informationen zu Biotechnologie und klinischen Studien. Hier zugreifen.

- Quelle: https://www.kdnuggets.com/introduction-to-cloud-computing-for-data-science?utm_source=rss&utm_medium=rss&utm_campaign=introduction-to-cloud-computing-for-data-science

- :hast

- :Ist

- :nicht

- :Wo

- $UP

- a

- Über uns

- ABSTRACT

- Zugang

- Schauspielkunst

- advanced

- Alle

- erlaubt

- fast

- immer

- am

- Amazon

- Amazon Web Services

- unter

- Betrag

- Beträge

- verstärkt

- an

- Analyse

- Analytische

- Analytik

- analysieren

- und

- jedem

- etwas

- Anwendung

- Anwendungen

- angewandt

- Ansatz

- SIND

- Kunst

- Kunst und Wissenschaft

- AS

- beurteilen

- At

- Verfügbarkeit

- Azure

- Zurück

- Barcelona

- BE

- werden

- wird

- Anfang

- zwischen

- Beyond

- Big

- Big Data

- breiteres

- Unternehmen

- aber

- by

- namens

- CAN

- Fähigkeiten

- Capturing

- Centers

- Cloud

- Cloud Computing

- Code

- Münze

- zusammenarbeiten

- Zusammenarbeit

- kollaborative

- vereint

- gemeinsam

- mit uns kommunizieren,

- Unternehmen

- komplementär

- Komplexität

- Komponente

- Computer

- Computer

- Computing

- Berücksichtigung

- Kontakt

- Inhalt

- weiter

- kontinuierlich

- Smartgeräte App

- Kernbereich

- Kosten

- Crashing

- Schöpfer

- wichtig

- Zur Zeit

- Unterricht

- technische Daten

- Rechenzentren

- Datenwissenschaft

- Datenspeichervorrichtung

- datengesteuerte

- Datenbase

- Datensätze

- Behandlung

- Entscheidungen

- Definition

- Übergeben

- Lieferanten

- Demand

- entworfen

- Entwicklung

- digital

- entdeckt,

- verschieden

- do

- die

- Domains

- Zeichnung

- e-commerce

- effizient

- einsteigen

- entstanden

- umfasst

- Ingenieur

- Entwicklung

- verbesserte

- sorgt

- Einheit

- Arbeitsumfeld

- ausgestattet

- Era

- essential

- Sogar

- Jedes

- überall

- entwickelt sich

- genau

- Beispiele

- überschreiten

- ausführen

- Führungskräfte

- Erweitern Sie die Funktionalität der

- expansiv

- teuer

- Expertise

- Explosion

- Extrakt

- scheitert

- vertraut

- Feld

- Revolution

- Vorname

- flexibel

- konzentriert

- Aussichten für

- Streitkräfte

- unten stehende Formular

- vorwärts

- Förderung

- für

- weiter

- Zukunft

- allgemein

- erzeugt

- bekommen

- gibt

- Go

- Kundenziele

- Gold

- Cumolocity

- Gewährung

- Wachsen Sie über sich hinaus

- Hadoop

- Griff

- Haben

- he

- Gesundheitswesen

- ihm

- Startseite

- http

- HTTPS

- human

- i

- if

- Imperativ

- in

- das

- Einschließlich

- hat

- Krankengymnastik

- informiert

- Infrastruktur

- Infrastruktur

- initiieren

- Innovation

- Einblicke

- integriert

- Integration

- Interaktionen

- verbunden

- Internet

- verflochten

- in

- Einleitung

- IT

- SEINE

- Reise

- jpg

- Jupyter Notizbuch

- nur

- KDnuggets

- Wissen

- grosse

- Führung

- lernen

- am wenigsten

- Gefällt mir

- Grenzen

- Belastungen

- aus einer regionalen

- Maschine

- Maschinelles Lernen

- Main

- Aufrechterhaltung

- um

- verwalten

- verwaltet

- flächendeckende Gesundheitsprogramme

- Markt

- Bedeutung

- sinnvoll

- Medien

- Methoden

- Microsoft

- Microsoft Azure

- könnte

- Millionen

- Mobilität

- mehr

- effizienter

- vor allem warme

- schlauer bewegen

- vorwärts gehen

- viel

- mehrere

- sollen

- notwendig,

- Notwendigkeit

- Need

- Netflix

- Netzwerk

- Netzwerke

- nicht

- beachten

- Notizbuch

- jetzt an

- of

- bieten

- Angebote

- vorgenommen,

- on

- On-Demand

- EINEM

- betreiben

- Betrieb

- or

- Andere

- UNSERE

- übrig

- besitzen

- Besitzt

- Seiten

- oberste

- besonders

- Party

- Pflasterung

- AUFMERKSAMKEIT

- Personen

- Leistung

- persönliche

- Persönliche Computer

- physikalisch

- Physik

- zentrale

- Plattformen

- Plato

- Datenintelligenz von Plato

- PlatoData

- Popularität

- Potenzial

- Werkzeuge

- größte treibende

- prädiktive

- Vorausschauende Analytik

- Vorlieben

- ziemlich

- Prozessdefinierung

- Verarbeitung

- Verarbeitungsleistung

- Profis

- Projekt

- Protokolle

- Versorger

- Anbieter

- bietet

- Zwecke

- setzen

- Python

- R

- Bereich

- lieber

- Roh

- Rohdaten

- vernünftig

- Gründe

- Software Empfehlungen

- Aufzeichnungen

- bezieht sich

- bezogene

- Beziehung

- bleibt bestehen

- merken

- Mieten

- Zugriffe

- Forschungsprojekte

- Downloads

- Anstieg

- Rollen

- Rollen

- Führen Sie

- gleich

- Skalierbarkeit

- skalierbaren

- Skalieren

- Wissenschaft

- Wissenschaft und Technologie

- Wissenschaftler

- Zweite

- Dienstanbieter

- Dienstleistungen

- Einstellung

- Teilen

- von Locals geführtes

- ,,teilen"

- scheint

- Seiten

- einfach

- da

- Single

- Singular

- kleinere

- So

- Social Media

- Social Media

- Software

- Klingen

- Quelle

- Spark

- spezifisch

- Geschwindigkeit

- Stakeholder

- Stand

- Standard

- Statistiken

- Status

- Lagerung

- speichern

- stärker

- Anschließend

- zusammenfassen

- sicher

- Überschwemmt

- übertreffen

- Synergie

- System

- Systeme und Techniken

- Tandem

- greifbar

- und Aufgaben

- Teams

- Tech

- Tech-Unternehmen

- Techniken

- technologische

- Technologies

- Technologie

- Begriff

- AGB

- als

- zur Verbesserung der Gesundheitsgerechtigkeit

- Das

- Die Zukunft

- ihr

- Sie

- Theorie

- Diese

- vom Nutzer definierten

- think

- Denken

- fehlen uns die Worte.

- nach drei

- Zeitplan

- zu

- heutigen

- Werkzeuge

- Transaktionen

- versuchen

- Drehung

- XNUMX

- Typen

- typisch

- typisch

- verstehen

- Einheit

- Updates

- dringend

- us

- -

- Nutzer

- Verwendung von

- gewöhnlich

- Nutzen

- Wert

- Vielfalt

- verschiedene

- riesig

- sehr

- Weg..

- we

- Netz

- Web-Services

- Was

- wann

- welche

- während

- warum

- Wi-Fi

- werden wir

- mit

- ohne

- arbeiten,

- weltweit wie ausgehandelt und gekauft ausgeführt wird.

- schreiben

- U

- Zephyrnet