Im sich schnell entwickelnden Bereich der künstlichen Intelligenz ist die Verarbeitung natürlicher Sprache zu einem Schwerpunkt für Forscher und Entwickler geworden. Aufbauend auf den Grundlagen von Transformatorarchitektur und Das bidirektionale Upgrade von BERTIn den letzten Jahren sind mehrere bahnbrechende Sprachmodelle entstanden, die die Grenzen dessen, was Maschinen verstehen und generieren können, verschieben.

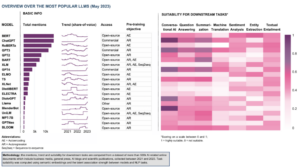

In diesem Artikel werden wir uns mit den neuesten Fortschritten in der Welt der großen Sprachmodelle befassen und die von jedem Modell eingeführten Verbesserungen, ihre Fähigkeiten und potenziellen Anwendungen untersuchen. Wir werden uns auch mit den Visual Language Models (VLMs) befassen, die darauf trainiert sind, nicht nur Text-, sondern auch visuelle Daten zu verarbeiten.

Wenn Sie gerne herumspringen möchten, finden Sie hier die von uns vorgestellten Sprachmodelle:

- GPT-3 von OpenAI

- LaMDA von Google

- PaLM von Google

- Flamingo von DeepMind

- BLIP-2 von Salesforce

- LLaMA von Meta AI

- GPT-4 von OpenAI

Wenn dieser ausführliche Bildungsinhalt für Sie nützlich ist, können Sie dies tun Abonnieren Sie unsere AI Research Mailingliste benachrichtigt werden, wenn wir neues Material veröffentlichen.

Die wichtigsten Large Language Models (LLMs) und Visual Language Models (VLMs) im Jahr 2023

1. GPT-3 von OpenAI

Zusammenfassung

Das OpenAI-Team führte GPT-3 als Alternative zu einem beschrifteten Datensatz für jede neue Sprachaufgabe ein. Sie schlugen vor, dass das Hochskalieren von Sprachmodellen die aufgabenunabhängige Leistung bei wenigen Aufnahmen verbessern kann. Um diesen Vorschlag zu testen, trainierten sie ein autoregressives Sprachmodell mit 175B-Parametern namens GPT-3, und bewertete seine Leistung bei über zwei Dutzend NLP-Aufgaben. Die Auswertung im Rahmen von „Fear-Shot Learning“, „One-Shot Learning“ und „Zero-Shot Learning“ zeigte, dass GPT-3 vielversprechende Ergebnisse erzielte und gelegentlich sogar die Ergebnisse auf dem neuesten Stand der Technik übertraf, die von fein abgestimmten Modellen erzielt wurden.

Was ist das Ziel?

- Um eine alternative Lösung für das bestehende Problem vorzuschlagen, wenn für jede neue Sprachaufgabe ein gekennzeichneter Datensatz benötigt wird.

Wie wird das Problem angegangen?

- Die Forscher schlugen vor, Sprachmodelle hochzuskalieren, um die aufgabenunabhängige Leistung bei wenigen Aufnahmen zu verbessern.

- Das GPT-3 model verwendet dasselbe Modell und dieselbe Architektur wie GPT-2, einschließlich modifizierter Initialisierung, Vornormalisierung und reversibler Tokenisierung.

- Im Gegensatz zu GPT-2 werden jedoch abwechselnd dichte und lokal gebänderte spärliche Aufmerksamkeitsmuster in den Schichten des Transformators verwendet, wie in der Sparse Transformator.

Was sind die Ergebnisse?

- Das GPT-3-Modell ohne Feinabstimmung erzielt vielversprechende Ergebnisse bei einer Reihe von NLP-Aufgaben und übertrifft gelegentlich sogar die neuesten Modelle, die für diese spezielle Aufgabe optimiert wurden:

- Auf dem CoQA Benchmark, 81.5 F1 in der Null-Schuss-Einstellung, 84.0 F1 in der Ein-Schuss-Einstellung und 85.0 F1 in der Wenig-Schuss-Einstellung, verglichen mit dem 90.7 F1-Ergebnis, das durch fein abgestimmte SOTA erzielt wurde.

- Auf dem TriviaQA Benchmark, 64.3% Genauigkeit in der Null-Schuss-Einstellung, 68.0% in der Ein-Schuss-Einstellung und 71.2% in der Wenig-Schuss-Einstellung und übertrifft den Stand der Technik (68%) um 3.2%.

- Auf dem LAMBADA Datensatz, 76.2% Genauigkeit in der Null-Schuss-Einstellung, 72.5% in der Ein-Schuss-Einstellung und 86.4% in der Wenig-Schuss-Einstellung und übertrifft den Stand der Technik (68%) um 18%.

- Die vom GPT-175-Modell mit 3B-Parametern generierten Nachrichtenartikel sind nach menschlichen Einschätzungen schwer von echten zu unterscheiden (mit einer Genauigkeit, die mit ~ 52% kaum über dem Zufallsniveau liegt).

- Trotz der bemerkenswerten Leistung von GPT-3 erhielt es gemischte Kritiken von der KI-Community:

- „Der GPT-3-Hype ist viel zu viel. Es ist beeindruckend (danke für die netten Komplimente!), Aber es hat immer noch ernsthafte Schwächen und macht manchmal sehr dumme Fehler. KI wird die Welt verändern, aber GPT-3 ist nur ein sehr früher Einblick. Wir müssen noch viel herausfinden. “ - - Sam Altman, CEO und Mitbegründer von OpenAI.

- "Ich bin schockiert, wie schwer es ist, aus GPT-3 Text über Muslime zu generieren, der nichts mit Gewalt zu tun hat ... oder getötet wird ..." - Abubakar Abid, CEO und Gründer von Gradio.

- "Nein. GPT-3 versteht die Welt, über die es spricht, grundsätzlich nicht. Eine weitere Erhöhung des Korpus wird es ihm ermöglichen, eine glaubwürdigere Pastiche zu generieren, aber seinen grundsätzlichen Mangel an Verständnis für die Welt nicht zu beheben. Demos von GPT-4 erfordern weiterhin die Ernte menschlicher Kirschen. “ - - Gary Marcus, CEO und Gründer von Robust.ai.

- "Die Extrapolation der spektakulären Leistung von GPT3 in die Zukunft legt nahe, dass die Antwort auf das Leben, das Universum und alles nur 4.398 Billionen Parameter sind." - - Geoffrey Hinton, Turing-Preisträger.

Wo kann man mehr über diese Forschung erfahren?

Wo können Sie Implementierungscode erhalten?

- Der Code selbst ist nicht verfügbar, aber einige Datensatzstatistiken zusammen mit bedingungslosen, ungefilterten 2048-Token-Beispielen von GPT-3 werden am veröffentlicht GitHub.

2. LaMDA von Google

Zusammenfassung

LaSprache MModelle für DDialog AAnwendungen (DieMDA) wurden durch die Feinabstimmung einer Gruppe von Transformer-basierten neuronalen Sprachmodellen erstellt, die speziell für Dialoge entwickelt wurden. Diese Modelle haben maximal 137B Parameter und wurden trainiert, um externe Wissensquellen zu nutzen. Die LaMDA-Entwickler hatten drei Hauptziele im Auge – Qualität, Sicherheit und Bodenständigkeit. Die Ergebnisse zeigten, dass durch Feinabstimmung die Qualitätslücke auf menschliches Niveau verringert werden kann, die Leistung des Modells jedoch in Bezug auf Sicherheit und Bodenhaftung unter dem menschlichen Niveau blieb.

Googles Barde, freigegeben kürzlich als Alternative zu ChatGPT, wird von LaMDA betrieben. Obwohl Bard oft als bezeichnet wird langweilig, könnte dies als Beweis für das Engagement von Google gewertet werden, der Sicherheit Priorität einzuräumen, selbst inmitten der intensiven Rivalität zwischen Google und Microsoft, um die Dominanz im Bereich der generativen KI zu etablieren.

Was ist das Ziel?

- Aufbau eines Modells für Open-Domain-Dialoganwendungen, bei denen ein Dialogagent in der Lage ist, sich über jedes Thema mit vernünftigen, kontextspezifischen, auf zuverlässigen Quellen basierenden und ethischen Antworten zu unterhalten.

Wie wird das Problem angegangen?

- LaMDA ist darauf aufgebaut Transformator, eine neuronale Netzwerkarchitektur, die von Google Research erfunden und 2017 als Open Source veröffentlicht wurde.

- Wie andere große Sprachmodelle, einschließlich BERT und GPT-3, wird LaMDA mit Terabytes von Textdaten trainiert, um zu lernen, wie Wörter miteinander in Beziehung stehen, und dann vorherzusagen, welche Wörter wahrscheinlich als nächstes kommen werden.

- Im Gegensatz zu den meisten Sprachmodellen wurde LaMDA jedoch auf Dialog trainiert, um Nuancen aufzugreifen, die offene Konversation von anderen Sprachformen unterscheiden.

- Das Modell wird auch fein abgestimmt, um die Sensibilität, Sicherheit und Spezifität seiner Reaktionen zu verbessern. Während Sätze wie „das ist nett“ und „ich weiß nicht“ in vielen Dialogszenarien sinnvoll sein können, führen sie wahrscheinlich nicht zu interessanten und fesselnden Gesprächen.

- Der LaMDA-Generator generiert zunächst mehrere Kandidatenantworten, die alle danach bewertet werden, wie sicher, sinnvoll, spezifisch und interessant sie sind. Antworten mit niedrigen Sicherheitswerten werden herausgefiltert, und dann wird das am besten bewertete Ergebnis als Antwort ausgewählt.

Was sind die Ergebnisse?

- Zahlreiche Experimente zeigen, dass LaMDA an fesselnden offenen Gesprächen zu einer Vielzahl von Themen teilnehmen kann.

- Eine Reihe qualitativer Bewertungen bestätigte, dass die Antworten des Modells tendenziell vernünftig, spezifisch, interessant und auf zuverlässigen externen Quellen beruhen, aber es gibt noch Raum für Verbesserungen.

- Trotz aller bisher erzielten Fortschritte erkennen die Autoren an, dass das Modell immer noch viele Einschränkungen aufweist, die dazu führen können, dass unangemessene oder sogar schädliche Reaktionen erzeugt werden.

Wo kann man mehr über diese Forschung erfahren?

Wo können Sie Implementierungscode erhalten?

- Eine Open-Source-PyTorch-Implementierung für die Pre-Training-Architektur von LaMDA ist verfügbar unter GitHub.

3. PaLM von Google

Zusammenfassung

Patrotzdem LAngst MModell (Palme) ist ein Transformer-basiertes Sprachmodell mit 540 Milliarden Parametern. PaLM wurde auf 6144 TPU v4-Chips mit Pathways trainiert, einem neuen ML-System für effizientes Training über mehrere TPU-Pods hinweg. Das Modell demonstriert die Vorteile der Skalierung beim Lernen in wenigen Schüssen und erzielt hochmoderne Ergebnisse bei Hunderten von Sprachverständnis- und Generierungs-Benchmarks. PaLM übertrifft fein abgestimmte hochmoderne Modelle bei mehrstufigen Denkaufgaben und übertrifft die durchschnittliche menschliche Leistung auf dem BIG-Benchmark.

Was ist das Ziel?

- Verbesserung des Verständnisses dafür, wie sich die Skalierung großer Sprachmodelle auf das Lernen mit wenigen Schüssen auswirkt.

Wie wird das Problem angegangen?

- Die Schlüsselidee besteht darin, das Training eines 540-Milliarden-Parameter-Sprachmodells mit dem Pathways-System zu skalieren:

- Das Team verwendete Datenparallelität auf Pod-Ebene über zwei Cloud TPU v4-Pods hinweg, während es in jedem Pod Standarddaten und Modellparallelität verwendete.

- Sie konnten das Training auf 6144 TPU v4-Chips skalieren, die größte TPU-basierte Systemkonfiguration, die bisher für das Training verwendet wurde.

- Das Modell erreichte eine Trainingseffizienz von 57.8 % Hardware-FLOPs-Nutzung, was, wie die Autoren behaupten, die höchste bisher erreichte Trainingseffizienz für große Sprachmodelle in dieser Größenordnung ist.

- Die Trainingsdaten für das PaLM-Modell umfassten eine Kombination aus englischen und mehrsprachigen Datensätzen mit hochwertigen Webdokumenten, Büchern, Wikipedia, Konversationen und GitHub-Code.

Was sind die Ergebnisse?

- Zahlreiche Experimente zeigen, dass die Modellleistung stark zunahm, als das Team auf sein größtes Modell skaliert wurde.

- Der PaLM 540B erzielte bei mehreren sehr schwierigen Aufgaben eine bahnbrechende Leistung:

- Sprachverständnis und Generierung. Das eingeführte Modell übertraf bei 28 von 29 Aufgaben, darunter Fragenbeantwortungsaufgaben, Lückentext- und Satzvervollständigungsaufgaben, kontextbezogene Leseverständnisaufgaben, Aufgaben zum gesunden Menschenverstand, SuperGLUE-Aufgaben und mehr, die Wenig-Schuss-Leistung früherer großer Modelle mehr. Die Leistung von PaLM bei BIG-Bench-Aufgaben zeigte, dass es Ursache und Wirkung unterscheiden und konzeptionelle Kombinationen in geeigneten Kontexten verstehen konnte.

- Argumentation. Mit 8-Schuss-Eingabeaufforderung löst PaLM 58 % der Probleme in GSM8K, einem Benchmark von Tausenden herausfordernden mathematischen Fragen auf Grundschulniveau, und übertrifft damit die frühere Höchstpunktzahl von 55 %, die durch die Feinabstimmung des Modells GPT-3 175B erreicht wurde. PaLM demonstriert auch die Fähigkeit, explizite Erklärungen in Situationen zu generieren, die eine komplexe Kombination aus mehrstufiger logischer Schlussfolgerung, Weltkenntnis und tiefem Sprachverständnis erfordern.

- Codegenerierung. PaLM ist auf Augenhöhe mit dem fein abgestimmten Codex 12B, verwendet jedoch 50-mal weniger Python-Code für das Training, was bestätigt, dass große Sprachmodelle das Lernen sowohl aus anderen Programmiersprachen als auch aus Daten natürlicher Sprache effektiver übertragen.

Wo kann man mehr über diese Forschung erfahren?

Wo können Sie Implementierungscode erhalten?

- Eine inoffizielle PyTorch-Implementierung der spezifischen Transformer-Architektur aus dem PaLM-Forschungspapier ist verfügbar unter GitHub. Es ist nicht skalierbar und wird nur zu Bildungszwecken veröffentlicht.

4. Flamingo von DeepMind

Zusammenfassung

Flamingo ist eine hochmoderne Familie von Visual Language Models (VLMs), die auf großen multimodalen Webkorpora mit gemischten Texten und Bildern trainiert werden. Mit diesem Training können sich die Modelle mithilfe minimaler kommentierter Beispiele, die als Eingabeaufforderung bereitgestellt werden, an neue Aufgaben anpassen. Flamingo beinhaltet wichtige architektonische Fortschritte, die darauf ausgelegt sind, die Stärken vorab trainierter rein visueller und rein sprachlicher Modelle zu vereinen, Sequenzen unterschiedlich verschachtelter visueller und textueller Daten zu verarbeiten und Bilder oder Videos nahtlos als Eingaben aufzunehmen. Die Modelle zeigen eine beeindruckende Anpassungsfähigkeit an eine Reihe von Bild- und Videoaufgaben wie visuelle Beantwortung von Fragen, Untertitelungsaufgaben und visuelle Multiple-Choice-Fragenbeantwortung und setzen neue Leistungsstandards durch aufgabenspezifische Eingabeaufforderungen beim Lernen mit wenigen Schüssen.

Was ist das Ziel?

- Um Fortschritte bei der Befähigung multimodaler Modelle zu erzielen, neue Aufgaben schnell zu erlernen und auf der Grundlage kurzer Anweisungen auszuführen:

- Das weit verbreitete Paradigma, ein Modell anhand einer großen Menge überwachter Daten vorab zu trainieren und es dann für die spezifische Aufgabe zu optimieren, ist ressourcenintensiv und erfordert Tausende von annotierten Datenpunkten sowie eine sorgfältige Abstimmung der Hyperparameter pro Aufgabe.

- Aktuelle Modelle, die ein kontrastives Objektiv verwenden, ermöglichen eine Zero-Shot-Anpassung an neue Aufgaben, sind jedoch bei offeneren Aufgaben wie Untertiteln oder visueller Beantwortung von Fragen unzureichend, da ihnen die Fähigkeit zur Sprachgenerierung fehlt.

- Diese Forschung zielt darauf ab, ein neues Modell vorzustellen, das diese Probleme effektiv angeht und eine überlegene Leistung in Regimen mit wenig Daten demonstriert.

Wie wird das Problem angegangen?

- DeepMind führte Flamingo ein, VLMs, die für das Lernen in wenigen Schritten bei verschiedenen offenen Seh- und Sprachaufgaben unter Verwendung nur weniger Eingabe-/Ausgabebeispiele konzipiert sind.

- Flamingo-Modelle sind visuell konditionierte autoregressive Textgenerierungsmodelle, die mit Bildern und/oder Videos gemischte Texttokens verarbeiten und Text als Ausgabe generieren können.

- Die Architektur von Flamingo umfasst zwei komplementäre vorab trainierte und eingefrorene Modelle:

- Ein Visionsmodell, das visuelle Szenen „wahrnehmen“ kann.

- Ein großes Sprachmodell, das mit der Durchführung grundlegender Argumentationen beauftragt ist.

- Neuartige Architekturkomponenten integrieren diese Modelle so, dass die während ihres rechenintensiven Vortrainings gewonnenen Erkenntnisse erhalten bleiben.

- Darüber hinaus verfügen Flamingo-Modelle über eine Perceiver-basierte Architektur, die es ihnen ermöglicht, hochauflösende Bilder oder Videos aufzunehmen. Diese Architektur kann aus einem breiten und variablen Spektrum visueller Eingabefunktionen eine feste Anzahl visueller Token pro Bild/Video generieren.

Was sind die Ergebnisse?

- Die Forschung zeigt, dass VLMs, ähnlich wie LLMs, die gut in wenigen Schritten lernen, aus einigen Eingabe-/Ausgabebeispielen für Bild- und Videoverständnisaufgaben wie Klassifizierung, Untertitelung oder Beantwortung von Fragen lernen können.

- Flamingo setzt neue Maßstäbe beim Lernen mit wenigen Schüssen und demonstriert überlegene Leistung bei einem breiten Spektrum von 16 multimodalen Sprach- und Bild-/Videoverständnisaufgaben.

- Bei 6 dieser 16 Aufgaben übertrifft Flamingo die Leistung des fein abgestimmten Stands der Technik, obwohl es nur 32 aufgabenspezifische Beispiele verwendet – etwa 1000 Mal weniger aufgabenspezifische Trainingsdaten als die derzeit leistungsstärksten Modelle.

Wo kann man mehr über diese Forschung erfahren?

Wo können Sie Implementierungscode erhalten?

- DeepMind hat die offizielle Implementierung von Flamingo nicht veröffentlicht.

- Eine Open-Source-Implementierung des vorgestellten Ansatzes finden Sie im OpenFlamingo Github Repo.

- Die alternative PyTorch-Implementierung ist verfügbar hier.

5. BLIP-2 von Salesforce

Zusammenfassung

BLIP-2 ist ein effizientes und generisches Pre-Training-Framework für Vision- und Sprachmodelle, das darauf ausgelegt ist, die zunehmend unerschwinglichen Kosten für das Pre-Training großer Modelle zu umgehen. BLIP-2 nutzt handelsübliche, eingefrorene, vorab trainierte Bildencoder und eingefrorene große Sprachmodelle, um das Vortraining der Bildsprache zu starten, und beinhaltet einen leichten Abfragetransformator, der in zwei Stufen vorab trainiert wurde. Die erste Stufe initiiert das Lernen der Vision-Sprach-Repräsentation anhand eines Encoders für eingefrorene Bilder, und die zweite Stufe treibt das generative Lernen der Vision-Sprache anhand eines eingefrorenen Sprachmodells voran. Obwohl BLIP-2 deutlich weniger trainierbare Parameter hat, übertrifft es modernste Methoden und übertrifft DeepMinds Flamingo80B um 8.7 % auf Zero-Shot VQAv2 mit 54x weniger trainierbaren Parametern. Das Modell weist außerdem vielversprechende Funktionen zur Zero-Shot-Bild-zu-Text-Generierung nach Anweisungen in natürlicher Sprache auf.

Was ist das Ziel?

- Um bei Vision-Language-Aufgaben eine hochmoderne Leistung zu erzielen und gleichzeitig die Rechenkosten zu senken.

Wie wird das Problem angegangen?

- Das Salesforce-Team hat ein neues Vision-Language-Pre-Training-Framework namens BLIP-2 eingeführt. Botstrapping LSprache-IMagier PUmschulung mit eingefrorenen unimodalen Modellen:

- Die vorab trainierten unimodalen Modelle bleiben während des Vortrainings eingefroren, um die Rechenkosten zu senken und das Problem des katastrophalen Vergessens zu vermeiden.

- Um die modalübergreifende Ausrichtung zu erleichtern und die Modalitätslücke zwischen vorab trainierten Bildmodellen und vorab trainierten Sprachmodellen zu schließen, schlägt das Team einen leichten Abfragetransformator (Q-Former) vor, der als Informationsengpass zwischen dem Encoder für eingefrorene Bilder und dem eingefrorenen Bild fungiert LLM.

- Q-Former ist mit einer neuen zweistufigen Strategie vorab trainiert:

- In der ersten Vortrainingsphase wird das Erlernen der visuellen Sprachdarstellung durchgeführt. Dadurch wird der Q-Former dazu gezwungen, die für den Text relevanteste visuelle Darstellung zu lernen.

- Die zweite Vortrainingsphase führt generatives Lernen von Vision zu Sprache durch, indem die Ausgabe des Q-Formers mit einem eingefrorenen LLM verknüpft wird. Der Q-Former ist so trainiert, dass seine visuelle Ausgabedarstellung vom LLM interpretiert werden kann.

Was sind die Ergebnisse?

- BLIP-2 liefert außergewöhnliche Ergebnisse auf dem neuesten Stand der Technik bei einer Vielzahl von Vision-Language-Aufgaben, einschließlich visueller Fragenbeantwortung, Bildunterschrift und Bildtext-Abruf.

- Beispielsweise übertrifft es Flamingo bei Zero-Shot VQAv8.7 um 2 %.

- Darüber hinaus wird diese herausragende Leistung mit einer deutlich höheren Rechnereffizienz erreicht:

- BLIP-2 übertrifft Flamingo-80B und verwendet dabei 54-mal weniger trainierbare Parameter.

- BLIP-2 ist in der Lage, als Reaktion auf Anweisungen in natürlicher Sprache eine Bild-zu-Text-Generierung ohne Aufnahme durchzuführen und so den Weg für die Entwicklung von Fähigkeiten wie visuellem Wissensdenken und visueller Konversation zu ebnen.

- Abschließend ist es wichtig anzumerken, dass BLIP-2 ein vielseitiger Ansatz ist, der ausgefeiltere unimodale Modelle nutzen kann, um die Leistung des Vision-Language-Pre-Trainings weiter zu verbessern.

Wo kann man mehr über diese Forschung erfahren?

Wo können Sie Implementierungscode erhalten?

Die offizielle BLIP-2-Implementierung ist verfügbar unter GitHub.

6. LLaMA von Meta AI

Zusammenfassung

Das Meta-KI-Team behauptet, dass kleinere Modelle, die mit mehr Token trainiert werden, leichter umzuschulen und für bestimmte Produktanwendungen feinabzustimmen sind. Deshalb führen sie ein Lama (Large LaSprache MModell Meta AI), eine Sammlung grundlegender Sprachmodelle mit 7B bis 65B Parametern. LLaMA 33B und 65B wurden mit 1.4 Billionen Token trainiert, während das kleinste Modell, LLaMA 7B, mit einer Billion Token trainiert wurde. Sie verwendeten ausschließlich öffentlich verfügbare Datensätze, ohne auf proprietäre oder eingeschränkte Daten angewiesen zu sein. Das Team implementierte auch wichtige architektonische Verbesserungen und Techniken zur Optimierung der Trainingsgeschwindigkeit. Folglich übertraf LLaMA-13B GPT-3, da es über zehnmal kleiner war, und LLaMA-10B zeigte eine konkurrenzfähige Leistung mit PaLM-65B.

Was ist das Ziel?

- Demonstrieren der Machbarkeit, leistungsstarke Modelle ausschließlich auf öffentlich zugänglichen Datensätzen zu trainieren, ohne sich auf proprietäre oder eingeschränkte Datenquellen zu verlassen.

- Um der Forschungsgemeinschaft kleinere und leistungsstärkere Modelle zur Verfügung zu stellen und es so denjenigen zu ermöglichen, die keinen Zugang zu großen Mengen an Infrastruktur haben, große Sprachmodelle zu studieren.

Wie wird das Problem angegangen?

- Um das LLaMA-Modell zu trainieren, verwendeten die Forscher nur Daten, die öffentlich verfügbar und mit Open Sourcing kompatibel sind.

- Sie haben auch einige Verbesserungen an der Standard-Transformer-Architektur eingeführt:

- Durch die Übernahme der GPT-3-Methodik wurde die Stabilität des Trainings verbessert, indem die Eingabe für jede Transformator-Unterschicht normalisiert wurde, anstatt die Ausgabe zu normalisieren.

- Inspiriert von den PaLM-Modellen ersetzten die Forscher die ReLU-Nichtlinearität durch die SwiGLU-Aktivierungsfunktion, um die Leistung zu verbessern.

- Inspiriert durch Suet al. (2021)eliminierten sie die absoluten Positionseinbettungen und integrierten stattdessen Rotationspositionseinbettungen (RoPE) auf jeder Schicht des Netzwerks.

- Schließlich verbesserte das Meta-KI-Team die Trainingsgeschwindigkeit ihres Modells durch:

- Verwenden einer effizienten kausalen Multi-Head-Aufmerksamkeitsimplementierung, indem Aufmerksamkeitsgewichte nicht gespeichert oder maskierte Schlüssel-/Abfragewerte berechnet werden.

- Verwenden von Checkpointing, um neu berechnete Aktivierungen während des Rückwärtsdurchgangs zu minimieren.

- Überlappung der Berechnung von Aktivierungen und der Kommunikation zwischen GPUs über das Netzwerk (aufgrund von all_reduce-Operationen).

Was sind die Ergebnisse?

- LLaMA-13B übertrifft GPT-3, obwohl es mehr als zehnmal kleiner ist, während LLaMA-10B sich gegen PaLM-65B behauptet.

Wo kann man mehr über diese Forschung erfahren?

Wo können Sie Implementierungscode erhalten?

- Meta AI bietet akademischen Forschern, Personen, die mit der Regierung, der Zivilgesellschaft, akademischen Institutionen und globalen Industrieforschungslabors in Verbindung stehen, Zugang zu LLaMA auf Einzelfallbewertungsbasis. Um sich zu bewerben, gehen Sie zu den folgenden GitHub-Repository.

7. GPT-4 von OpenAI

Zusammenfassung

GPT-4 ist ein groß angelegtes, multimodales Modell, das Bild- und Texteingaben akzeptiert und Textausgaben generiert. Aufgrund von Wettbewerbs- und Sicherheitsbedenken werden spezifische Details über die Architektur und das Training des Modells zurückgehalten. In Bezug auf die Leistung übertrifft GPT-4 frühere Sprachmodelle bei traditionellen Benchmarks und zeigt signifikante Verbesserungen beim Verständnis der Benutzerabsicht und den Sicherheitseigenschaften. Das Modell erreicht auch bei verschiedenen Prüfungen Leistungen auf menschlichem Niveau, einschließlich einer Top-10-%-Punktzahl bei einer simulierten Uniform Bar Examination.

Was ist das Ziel?

- Entwicklung eines groß angelegten, multimodalen Modells, das Bild- und Texteingaben akzeptieren und Textausgaben erzeugen kann.

- Entwicklung von Infrastruktur- und Optimierungsmethoden, die sich über eine Vielzahl von Skalen hinweg vorhersagbar verhalten.

Wie wird das Problem angegangen?

- Aufgrund der Wettbewerbslandschaft und der Auswirkungen auf die Sicherheit hat OpenAI beschlossen, Details zu Architektur, Modellgröße, Hardware, Trainingsberechnung, Datensatzkonstruktion und Trainingsmethoden zurückzuhalten.

- Sie offenbaren, dass:

- GPT-4 ist ein Transformer-basiertes Modell, das vortrainiert ist, um das nächste Token in einem Dokument vorherzusagen.

- Es verwendet öffentlich zugängliche Daten und lizenzierte Daten von Drittanbietern.

- Das Modell wurde mithilfe von Reinforcement Learning from Human Feedback (RLHF) verfeinert.

- Unbestätigte Informationen deuten darauf hin, dass GPT-4 kein singuläres, dichtes Modell wie seine Vorgänger ist, sondern eine leistungsstarke Koalition aus acht separaten Modellen, von denen jedes unglaubliche 220 Milliarden Parameter enthält.

Was sind die Ergebnisse?

- GPT-4 erreicht bei den meisten professionellen und akademischen Prüfungen Leistungen auf menschlichem Niveau und erzielt insbesondere bei einer simulierten Uniform Bar Examination eine Platzierung unter den besten 10 %.

- Das vortrainierte Basis-GPT-4-Modell übertrifft bestehende Sprachmodelle und frühere State-of-the-Art-Systeme bei traditionellen NLP-Benchmarks, ohne Benchmark-spezifisches Crafting oder zusätzliche Trainingsprotokolle.

- GPT-4 zeigt eine erhebliche Verbesserung bei der Verfolgung der Benutzerabsicht, wobei seine Antworten gegenüber den Antworten von GPT-3.5 in 70.2 % von 5,214 Eingabeaufforderungen von ChatGPT und der OpenAI-API bevorzugt werden.

- Die Sicherheitseigenschaften von GPT-4 haben sich im Vergleich zu GPT-3.5 erheblich verbessert, mit einem Rückgang von 82 % bei der Beantwortung nicht zugelassener Inhaltsanfragen und einer 29 %igen Steigerung der Einhaltung von Richtlinien für sensible Anfragen (z. B. medizinischer Rat und Selbstverletzung).

Wo kann man mehr über diese Forschung erfahren?

Wo können Sie Implementierungscode erhalten?

- Code-Implementierung von GPT-4 ist nicht verfügbar.

Reale Anwendungen großer (Visions-)Sprachmodelle

Die bedeutendsten KI-Forschungsdurchbrüche der letzten Jahre stammen von großen KI-Modellen, die auf riesigen Datensätzen trainiert wurden. Diese Modelle zeigen eine beeindruckende Leistung, und es ist faszinierend, sich vorzustellen, wie KI ganze Branchen wie Kundenservice, Marketing, E-Commerce, Gesundheitswesen, Softwareentwicklung, Journalismus und viele andere revolutionieren kann.

Große Sprachmodelle haben zahlreiche reale Anwendungen. GPT-4 listet Folgendes auf:

- Verstehen und Generieren natürlicher Sprache für Chatbots und virtuelle Assistenten.

- Maschinelle Übersetzung zwischen Sprachen.

- Zusammenfassung von Artikeln, Berichten oder anderen Textdokumenten.

- Stimmungsanalyse für Marktforschung oder Social Media Monitoring.

- Content-Generierung für Marketing, Social Media oder kreatives Schreiben.

- Frage-Antwort-Systeme für den Kundensupport oder Wissensdatenbanken.

- Textklassifizierung für Spam-Filterung, Themenkategorisierung oder Dokumentenorganisation.

- Personalisierte Sprachlern- und Tutoring-Tools.

- Unterstützung bei der Codegenerierung und Softwareentwicklung.

- Analyse und Unterstützung medizinischer, rechtlicher und technischer Dokumente.

- Barrierefreiheitstools für Menschen mit Behinderungen, wie z. B. Text-zu-Sprache und Sprache-zu-Text-Konvertierung.

- Spracherkennungs- und Transkriptionsdienste.

Wenn wir einen visuellen Teil hinzufügen, erweitern sich die Bereiche möglicher Anwendungen noch weiter:

Es ist sehr spannend, die jüngsten KI-Durchbrüche zu verfolgen und über ihre potenziellen Anwendungen in der realen Welt nachzudenken. Bevor wir diese Modelle jedoch im wirklichen Leben einsetzen, müssen wir uns mit den entsprechenden Risiken und Einschränkungen befassen, die leider sehr erheblich sind.

Risiken und Einschränkungen

Wenn Sie GPT-4 nach seinen Risiken und Einschränkungen fragen, wird es Ihnen wahrscheinlich eine lange Liste relevanter Bedenken liefern. Nachdem ich diese Liste durchgesehen und einige zusätzliche Überlegungen angestellt habe, bin ich bei den folgenden Hauptrisiken und Einschränkungen gelandet, die moderne große Sprachmodelle besitzen:

- Vorurteile und Diskriminierung: Diese Modelle lernen aus riesigen Mengen an Textdaten, die oft Vorurteile und diskriminierende Inhalte enthalten. Infolgedessen können die generierten Ergebnisse unbeabsichtigt Stereotypen, beleidigende Sprache und Diskriminierung aufgrund von Faktoren wie Geschlecht, Rasse oder Religion aufrechterhalten.

- Fehlinformationen: Große Sprachmodelle können Inhalte generieren, die sachlich falsch, irreführend oder veraltet sind. Obwohl die Modelle anhand einer Vielzahl von Quellen trainiert wurden, liefern sie möglicherweise nicht immer die genauesten oder aktuellsten Informationen. Dies geschieht häufig, weil das Modell der Erzeugung von Ausgaben Vorrang einräumt, die grammatikalisch korrekt sind oder kohärent erscheinen, auch wenn sie irreführend sind.

- Verständnismangel: Obwohl diese Modelle die menschliche Sprache zu verstehen scheinen, funktionieren sie hauptsächlich, indem sie Muster und statistische Assoziationen in den Trainingsdaten identifizieren. Sie haben kein tiefes Verständnis für die von ihnen generierten Inhalte, was manchmal zu unsinnigen oder irrelevanten Ergebnissen führen kann.

- Ungeeignete Inhalte : Sprachmodelle können manchmal anstößige, schädliche oder unangemessene Inhalte generieren. Obwohl Anstrengungen unternommen werden, um solche Inhalte zu minimieren, kann dies aufgrund der Art der Trainingsdaten und der Unfähigkeit der Modelle, Kontext oder Benutzerabsicht zu erkennen, dennoch vorkommen.

Zusammenfassung

Große Sprachmodelle haben zweifellos den Bereich der Verarbeitung natürlicher Sprache revolutioniert und ein immenses Potenzial zur Steigerung der Produktivität in verschiedenen Rollen und Branchen gezeigt. Ihre Fähigkeit, menschenähnlichen Text zu generieren, alltägliche Aufgaben zu automatisieren und Unterstützung bei kreativen und analytischen Prozessen zu bieten, hat sie zu unverzichtbaren Werkzeugen in der heutigen schnelllebigen, technologiegetriebenen Welt gemacht.

Es ist jedoch entscheidend, die mit diesen leistungsstarken Modellen verbundenen Einschränkungen und Risiken anzuerkennen und zu verstehen. Probleme wie Voreingenommenheit, Fehlinformationen und das Potenzial für böswillige Nutzung können nicht ignoriert werden. Da wir diese KI-gesteuerten Technologien weiterhin in unser tägliches Leben integrieren, ist es wichtig, ein Gleichgewicht zwischen der Nutzung ihrer Fähigkeiten und der Sicherstellung der menschlichen Überwachung zu finden, insbesondere in sensiblen und risikoreichen Situationen.

Wenn es uns gelingt, generative KI-Technologien verantwortungsbewusst einzusetzen, werden wir den Weg für eine Zukunft ebnen, in der künstliche Intelligenz und menschliches Fachwissen zusammenarbeiten, um Innovationen voranzutreiben und eine bessere Welt für alle zu schaffen.

Genießen Sie diesen Artikel? Melden Sie sich für weitere AI-Forschungsupdates an.

Wir werden Sie informieren, wenn wir weitere zusammenfassende Artikel wie diesen veröffentlichen.

Verbunden

- SEO-gestützte Content- und PR-Distribution. Holen Sie sich noch heute Verstärkung.

- PlatoData.Network Vertikale generative KI. Motiviere dich selbst. Hier zugreifen.

- PlatoAiStream. Web3-Intelligenz. Wissen verstärkt. Hier zugreifen.

- PlatoESG. Automobil / Elektrofahrzeuge, Kohlenstoff, CleanTech, Energie, Umwelt, Solar, Abfallwirtschaft. Hier zugreifen.

- BlockOffsets. Modernisierung des Eigentums an Umweltkompensationen. Hier zugreifen.

- Quelle: https://www.topbots.com/top-language-models-transforming-ai-in-2023/

- :hast

- :Ist

- :nicht

- :Wo

- $UP

- 1

- 10

- 12b

- 16

- 2%

- 2017

- 2021

- 2023

- 214

- 220

- 28

- 32

- 50

- 7

- 70

- 710

- 72

- 8

- 84

- 90

- a

- Fähigkeit

- Fähig

- Über Uns

- oben

- Absolute

- akademisch

- Akzeptieren

- Akzeptiert

- Zugang

- zugänglich

- unterbringen

- Nach

- Genauigkeit

- genau

- erreicht

- Erreicht

- Erreichen

- anerkennen

- über

- Aktivierung

- Aktivierungen

- Handlungen

- automatisch

- Anpassung

- hinzufügen

- Hinzufügen

- Zusatz

- Zusätzliche

- Adresse

- Adressen

- Die Annahme

- Fortschritte

- Beratung

- Nach der

- gegen

- Makler

- AI

- ai Forschung

- Ziel

- AL

- gleich

- Alle

- erlauben

- Zulassen

- erlaubt

- entlang

- ebenfalls

- Alternative

- Obwohl

- immer

- inmitten

- unter

- Betrag

- Beträge

- an

- Analyse

- Analytische

- und

- Ein anderer

- beantworten

- jedem

- Bienen

- erscheinen

- Anwendungen

- Bewerben

- Ansatz

- angemessen

- ca.

- architektonisch

- Architektur

- SIND

- Bereiche

- um

- Feld

- Kunst

- Artikel

- Artikel

- künstlich

- künstliche Intelligenz

- AS

- Hilfe

- Assistenten

- damit verbundenen

- Verbände

- At

- Aufmerksamkeit

- Autoren

- automatisieren

- verfügbar

- durchschnittlich

- vermeiden

- Auszeichnung

- Balance

- Bar

- Base

- basierend

- basic

- Grundlage

- BE

- weil

- werden

- Bevor

- Sein

- unten

- Benchmark

- Benchmarks

- Vorteile

- Besser

- zwischen

- vorspannen

- Vorurteile

- Milliarde

- Bücher

- Bootstrap

- beide

- Grenzen

- Durchbruch

- Durchbrüche

- BRIDGE

- breit

- bauen

- Building

- erbaut

- aber

- by

- namens

- CAN

- Kandidat

- kann keine

- Fähigkeiten

- fähig

- Kapazität

- vorsichtig

- Häuser

- katastrophal

- Verursachen

- CEO

- CEO und Gründer

- herausfordernd

- Chance

- Übernehmen

- Chatbots

- ChatGPT

- Pommes frites

- Anspruch

- Einstufung

- Cloud

- Co-Gründer

- Code

- KOHÄRENT

- Sammlung

- Kombination

- Kombinationen

- wie die

- Engagement

- Kommunikation

- community

- verglichen

- kompatibel

- wettbewerbsfähig

- komplementär

- Komplex

- Compliance

- Komponenten

- Berechnung

- Berechnen

- Computer

- Computing

- begrifflich

- Bedenken

- Konfiguration

- BESTÄTIGT

- Sich zusammenschliessen

- Folglich

- Überlegungen

- Baugewerbe

- Inhalt

- Kontext

- Kontexte

- fortsetzen

- Kontrast

- Gespräch

- Gespräche

- Umwandlung (Conversion)

- und beseitigen Muskelschwäche

- Dazugehörigen

- Kosten

- Kosten

- könnte

- erstellen

- erstellt

- Kreativ (Creative)

- glaubwürdig

- wichtig

- Strom

- Kunde

- Kundenservice

- Kundensupport

- innovativ, auf dem neuesten Stand

- Unterricht

- technische Daten

- Datenpunkte

- Datensätze

- Datum

- entschieden

- verringern

- tief

- DeepMind

- liefert

- zeigen

- Synergie

- zeigt

- demonstrieren

- Demos

- Abhängig

- Bereitstellen

- entworfen

- Trotz

- Details

- entwickeln

- Entwickler

- Entwicklung

- Entwicklung

- Dialog

- Dialog

- schwer

- Behinderungen

- Enthüllen

- Diskriminierung

- unterscheiden

- verschieden

- do

- Dokument

- Unterlagen

- die

- Herrschaft

- Nicht

- Dutzend

- Antrieb

- synchronisiert

- zwei

- im

- e

- e-commerce

- E & T

- jeder

- Früh

- einfacher

- Bildungs-

- bewirken

- effektiv

- Effizienz

- effizient

- Bemühungen

- eliminiert

- entstanden

- ermöglichen

- ermöglichen

- umfassend

- Eingriff

- Englisch

- zu steigern,

- verbesserte

- Verbesserungen

- Eine Verbesserung der

- Gewährleistung

- essential

- etablieren

- etabliert

- ethisch

- Bewerten

- Auswertung

- Auswertungen

- Sogar

- Jedes

- alles

- Beweis

- sich entwickelnden

- Untersuchung

- Beispiel

- Beispiele

- übersteigt

- außergewöhnlich

- unterhaltsame Programmpunkte

- ausschließlich

- Exponate

- vorhandenen

- Erweitern Sie die Funktionalität der

- Experimente

- Expertise

- Möglichkeiten sondieren

- extern

- f1

- erleichtern

- Faktoren

- Fallen

- Familie

- weit

- faszinierend

- schnelllebig

- Merkmal

- funktions

- Eigenschaften

- Feedback

- wenige

- Weniger

- Feld

- Abbildung

- Filterung

- Finden Sie

- Vorname

- Fixieren

- fixiert

- folgen

- Folgende

- Aussichten für

- Formen

- Foundations

- Gründer

- Unser Ansatz

- für

- eingefroren

- Funktion

- fundamental

- grundlegend

- weiter

- Zukunft

- gewonnen

- Lücke

- Geschlecht

- erzeugen

- erzeugt

- erzeugt

- Erzeugung

- Generation

- generativ

- Generative KI

- Generator

- bekommen

- GitHub

- Blick

- Global

- Go

- Kundenziele

- gehen

- gut

- der Regierung

- GPUs

- Klasse

- bahnbrechend

- Gruppe an

- hätten

- das passiert

- hart

- Hardware

- schädlich

- Haben

- mit

- Gesundheitswesen

- hier

- hochwertige

- hochauflösenden

- hohes Risiko

- höher

- höchste

- hält

- Ultraschall

- aber

- HTML

- HTTPS

- riesig

- human

- hunderte

- Hype

- Hyperparameter-Tuning

- Idee

- Identifizierung

- if

- Image

- Bilder

- immens

- Implementierung

- umgesetzt

- Auswirkungen

- wichtig

- beeindruckend

- zu unterstützen,

- verbessert

- Verbesserung

- Verbesserungen

- in

- eingehende

- Unfähigkeit

- das

- inklusive

- Einschließlich

- Incorporated

- beinhaltet

- einarbeiten

- Erhöhung

- hat

- zunehmend

- zunehmend

- Krankengymnastik

- Einzelpersonen

- Branchen

- Energiegewinnung

- Information

- Infrastruktur

- Initiiert

- Innovation

- Varianten des Eingangssignals:

- Eingänge

- beantragen müssen

- Institutionen

- Anleitung

- integrieren

- Intelligenz

- Absicht

- interessant

- in

- einführen

- eingeführt

- Erfunden

- Problem

- Probleme

- IT

- SEINE

- selbst

- Journalismus

- jpg

- nur

- Wesentliche

- Hauptziele

- Wissen

- Wissen

- Labs

- Mangel

- Landschaft

- Sprache

- Sprachen

- grosse

- großflächig

- höchste

- neueste

- Schicht

- Lagen

- führen

- LERNEN

- lernen

- Rechtlich

- weniger

- Niveau

- Cholesterinspiegel

- Hebelwirkung

- Hebelwirkungen

- Nutzung

- Zugelassen

- Lebensdauer

- leicht

- Gefällt mir

- wahrscheinlich

- Einschränkungen

- Liste

- Listen

- Leben

- Lama

- örtlich

- logisch

- Lang

- aussehen

- Los

- Sneaker

- Maschinen

- gemacht

- um

- MACHT

- viele

- Rainer

- Markt

- Marktforschung

- Marketing

- Ihres Materials

- Mathe

- max-width

- maximal

- Kann..

- sinnvoll

- Medien

- sowie medizinische

- Merge

- Meta

- Methodik

- Methoden

- Microsoft

- Geist / Bewusstsein

- minimal

- Fehlinformationen

- irreführend

- Fehler

- gemischt

- ML

- Modell

- für

- modern

- geändert

- Überwachung

- mehr

- vor allem warme

- viel

- mehrere

- Muslime

- Natürliche

- Natürliche Sprache

- Verarbeitung natürlicher Sprache

- Natur

- Need

- erforderlich

- Netzwerk

- Neural

- Neuronale Sprache

- neuronale Netzwerk

- Neu

- News

- weiter

- schön

- Nlp

- vor allem

- nichts

- Anzahl

- und viele

- Ziel

- auftreten

- of

- Offensive

- offiziell

- vorgenommen,

- on

- EINEM

- Einsen

- einzige

- XNUMXh geöffnet

- Open-Source-

- OpenAI

- betreiben

- Einkauf & Prozesse

- Optimierung

- or

- Organisation

- Andere

- Anders

- UNSERE

- outperforming

- Übertrifft

- Möglichkeiten für das Ausgangssignal:

- hervorragend

- übrig

- besitzen

- Palme

- Papier

- Paradigma

- Parameter

- Parameter

- Teil

- teilnehmen

- besonders

- passieren

- Muster

- pflastern

- Pflasterung

- für

- ausführen

- Leistung

- Durchführung

- führt

- Sätze

- wählen

- Plato

- Datenintelligenz von Plato

- PlatoData

- Schoten

- Points

- Punkte

- Politik durchzulesen

- möglich

- Potenzial

- angetriebene

- größte treibende

- vorhersagen

- bevorzugt

- früher

- in erster Linie

- Vor

- Priorisierung

- Aufgabenstellung:

- Probleme

- Prozessdefinierung

- anpassen

- Verarbeitung

- produziert

- Produkt

- PRODUKTIVITÄT

- Professionell

- Programmierung

- Programmiersprachen

- Fortschritt

- aussichtsreich

- immobilien

- schlägt vor

- Eigentums-

- Protokolle

- die

- vorausgesetzt

- bietet

- öffentlich

- veröffentlicht

- Zwecke

- Schieben

- Python

- Pytorch

- qualitativ

- Qualität

- Frage

- Fragen

- schnell

- Rennen

- Angebot

- schnell

- lieber

- Lesebrillen

- echt

- wahres Leben

- realen Welt

- kürzlich

- kürzlich

- Anerkennung

- erkennen

- Veteran

- Reduzierung

- Regime

- Verstärkung lernen

- Release

- freigegeben

- relevant

- zuverlässig

- verlässliche Quelle

- Religion

- sich auf

- bleiben

- blieb

- bemerkenswert

- ersetzt

- Meldungen

- Darstellung

- Zugriffe

- erfordern

- erfordert

- Forschungsprojekte

- Forschungsgemeinschaft

- Forscher

- ressourcenintensiv

- Umwelt und Kunden

- reagiert

- Antwort

- Antworten

- eingeschränkt

- Folge

- Die Ergebnisse

- behält

- Bewertungen

- revolutionieren

- revolutioniert

- Risiken

- Rivalität

- robust

- Rollen

- Zimmer

- Safe

- Sicherheit

- salesforce

- gleich

- Skalieren

- Waage

- Skalierung

- Szenarien

- Szenen

- Schule

- Ergebnis

- Partituren

- Wertung

- nahtlos

- Zweite

- scheinen

- gesehen

- ausgewählt

- empfindlich

- getrennte

- Modellreihe

- ernst

- Lösungen

- kompensieren

- Einstellung

- mehrere

- schockiert

- Short

- erklären

- zeigte

- Konzerte

- Schild

- signifikant

- bedeutend

- Ähnlich

- Singular

- Umstände

- Größe

- Fähigkeiten

- kleinere

- So

- bis jetzt

- Social Media

- Social Media

- Gesellschaft

- Software

- Software-Entwicklung

- allein

- Lösung

- Löst

- einige

- anspruchsvoll

- Quelle

- Quellen

- Sourcing

- Spam

- spezifisch

- speziell

- Spezifität

- spektakulär

- Speech-to-Text

- Geschwindigkeit

- Stabilität

- Stufe

- Stufen

- Standard

- Normen

- Bundesstaat

- State-of-the-art

- statistisch

- Statistiken

- Immer noch

- Strategie

- Stärken

- Streik

- Studie

- wesentlich

- Erfolg haben

- so

- vorschlagen

- Schlägt vor

- ZUSAMMENFASSUNG

- Oberteil

- Aufsicht

- Support

- übertroffen

- System

- Systeme und Techniken

- Gespräche

- Aufgabe

- und Aufgaben

- Team

- Technische

- Techniken

- Technologies

- AGB

- Test

- Texterzeugung

- Text-to-Speech

- als

- dank

- zur Verbesserung der Gesundheitsgerechtigkeit

- Das

- Die Zukunft

- Der Staat

- die Welt

- ihr

- Sie

- dann

- Dort.

- damit

- deswegen

- Diese

- vom Nutzer definierten

- think

- basierte Online-to-Offline-Werbezuordnungen von anderen gab.

- fehlen uns die Worte.

- diejenigen

- obwohl?

- Tausende

- nach drei

- Durch

- mal

- zu

- heutigen

- gemeinsam

- Zeichen

- Tokenisierung

- Tokens

- auch

- Werkzeuge

- Top

- TOPBOTS

- Thema

- Themen

- gegenüber

- traditionell

- Training

- trainiert

- Ausbildung

- privaten Transfer

- Transformator

- Transformieren

- Übersetzungen

- Billion

- Turing

- Nachhilfe

- XNUMX

- bedingungslos

- für

- verstehen

- Verständnis

- unternehmen

- zweifellos

- Unglücklicherweise

- Universum

- nicht wie

- auf dem neusten Stand

- Updates

- -

- benutzt

- Mitglied

- verwendet

- Verwendung von

- die

- Vielfalt

- verschiedene

- riesig

- vielseitig

- sehr

- Video

- Videos

- Assistent

- Seh-

- VOX

- wurde

- Weg..

- we

- Netz

- GUT

- waren

- Was

- wann

- welche

- während

- WHO

- ganze

- breit

- Große Auswahl

- Wikipedia

- werden wir

- mit

- .

- ohne

- Worte

- Arbeiten

- zusammenarbeiten

- weltweit wie ausgehandelt und gekauft ausgeführt wird.

- Schreiben

- Jahr

- noch

- U

- Zephyrnet

- Zero-Shot-Lernen