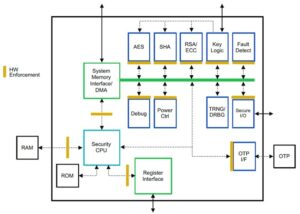

Suresh ist ein Technologiemanager mit umfassender technischer Expertise in den Bereichen Halbleiter, künstliche Intelligenz, Cybersicherheit, Internet der Dinge, Hardware, Software usw. Er war 20 Jahre in der Branche tätig und war zuletzt als Executive Director für Open-Source-Zero-Source tätig. Trust Chip-Entwicklung am Technology Innovation Institute, Abu Dhabi, und in anderen Fortune-500-Halbleiterunternehmen wie Intel, Qualcomm und MediaTek in verschiedenen Führungspositionen, wo er hochleistungsfähige, energieeffiziente, Post-Quantum-sichere und sichere Systeme erforschte und entwickelte Mikrochips/System-on-Chips (SoCs)/Beschleuniger für die Märkte Rechenzentrum, Client, Smartphone, Netzwerk, IoT und KI/ML. Er trug zum Falcon LLM bei (Platz 1 in Huggingface) und war der leitende Architekt für die benutzerdefinierte KI-Hardwareplattform (abgesagt – Prioritäten geändert). Er ist Inhaber von mehr als 15 US-Patenten und hat auf mehr als 20 Konferenzen veröffentlicht bzw. Vorträge gehalten.

Suresh ist ein Technologiemanager mit umfassender technischer Expertise in den Bereichen Halbleiter, künstliche Intelligenz, Cybersicherheit, Internet der Dinge, Hardware, Software usw. Er war 20 Jahre in der Branche tätig und war zuletzt als Executive Director für Open-Source-Zero-Source tätig. Trust Chip-Entwicklung am Technology Innovation Institute, Abu Dhabi, und in anderen Fortune-500-Halbleiterunternehmen wie Intel, Qualcomm und MediaTek in verschiedenen Führungspositionen, wo er hochleistungsfähige, energieeffiziente, Post-Quantum-sichere und sichere Systeme erforschte und entwickelte Mikrochips/System-on-Chips (SoCs)/Beschleuniger für die Märkte Rechenzentrum, Client, Smartphone, Netzwerk, IoT und KI/ML. Er trug zum Falcon LLM bei (Platz 1 in Huggingface) und war der leitende Architekt für die benutzerdefinierte KI-Hardwareplattform (abgesagt – Prioritäten geändert). Er ist Inhaber von mehr als 15 US-Patenten und hat auf mehr als 20 Konferenzen veröffentlicht bzw. Vorträge gehalten.

Suresh ist außerdem aktiv in einer Führungsposition bei RISC-V International tätig, wo er den Vorsitz der Trusted Computing Group zur Entwicklung vertraulicher RISC-V-Computing-Funktionen innehat und den Vorsitz der AI/ML Group zur Entwicklung der RISC-V-Hardwarebeschleunigung für AI/ML-Workloads wie z Transformer Large Language Models, die in ChatGPT-Anwendungen verwendet werden. Er berät außerdem Startups und Risikokapitalfirmen in den Bereichen Investitionsentscheidungsunterstützung, Produktstrategie, Technologie-Due-Diligence usw.

Er erwarb einen MBA von INSEAD, einen MS vom Birla Institute of Technology & Science Pilani, ein Systems Engineering-Zertifikat vom MIT, ein AI-Zertifikat von Stanford und ein Zertifikat für funktionale Automobilsicherheit vom TÜV SÜD.

Erzählen Sie uns von Ihrem Unternehmen

"Mastiṣka AI„Mastiṣka bedeutet auf Sanskrit Gehirn.

Welche Probleme lösen Sie?

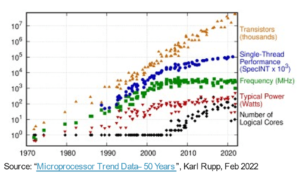

Angesichts der Vorteile von KI/GenAI wird ihre Nachfrage zwangsläufig steigen, ebenso wie ihre Nebenwirkungen auf unseren Planeten. Wie können wir die Nebenwirkungen von KI auf unserem Planeten reduzieren oder neutralisieren? Kohlenstoffabscheidung und Kernenergie gehen in die richtige Richtung. Aber wir müssen die Art und Weise, wie wir KI nutzen, grundlegend überdenken. Ist es der falsche Weg, Tonnen von Matrixmultiplikationen durchzuführen?

Unser Gehirn kann mit und unter 10 W lernen und viele Aufgaben parallel erledigen, aber warum verbrauchen diese KI-Systeme 10 Megawatt, um Modelle zu trainieren?

Vielleicht hält die Zukunft energieeffiziente Architekturen wie neuromorphe Architekturen und auf einem neuronalen Netzwerk basierende Transformatoren bereit, die dem menschlichen Gehirn am nächsten kommen und 100–1000 Mal weniger Energie verbrauchen könnten, wodurch die Kosten für den Einsatz von KI gesenkt, diese demokratisiert und unsere Umwelt gerettet werden könnten Planet.

Die aktuellen Herausforderungen, mit denen wir bei der KI konfrontiert sind, sind nämlich a) Verfügbarkeit, b) Zugänglichkeit, c) Erschwinglichkeit und d) Umweltsicherheit sowie einige Empfehlungen zu deren Bewältigung.

Wenn wir in die Zukunft blicken, werden einige nützliche AGI-Konzepte im Film „HER“ demonstriert, in dem die Figur „Samantha“ – eine Gesprächspartnerin, die natürlich ist, Emotionen versteht, Empathie zeigt, bei der Arbeit eine erstaunliche Copilotin ist – und weiterläuft Wenn wir den ganzen Tag über Handheld-Geräte verwenden, müssen wir uns möglicherweise jetzt mit den folgenden Herausforderungen befassen.

Problem 1: Die Ausbildung eines LLM kann zwischen 150 und mehr als 10 Millionen Dollar kosten und ermöglicht nur denjenigen mit größeren Mitteln die Entwicklung von KI. Darüber hinaus sind auch die Inferenzkosten enorm (kostet 10x mehr als eine Websuche)

—> Wir müssen die Energieeffizienz von Modellen/Hardware verbessern, um KI zum Wohle der Menschheit zu demokratisieren.

Problem 2: Die Ausführung riesiger KI-Modelle für Gesprächsagenten oder Empfehlungssysteme belastet die Umwelt in Bezug auf Stromverbrauch und Kühlung.

—> Wir müssen die Energieeffizienz von Modellen/Hardware verbessern, um unseren Planeten für unsere Kinder zu retten.

Problem 3: Das menschliche Gehirn ist multitaskingfähig, verbraucht aber nur 10 Watt statt Megawatt.

—> Vielleicht sollten wir Maschinen wie unsere Gehirne bauen und nicht die regulären Matrixmultiplikatoren schneller.

Die Menschheit kann nur mit nachhaltigen Innovationen gedeihen und nicht durch die Abholzung aller Wälder und das Kochen der Ozeane im Namen der Innovation. Wir müssen unseren Planeten zum Wohle unserer Kinder und künftiger Generationen schützen …

Welche Anwendungsbereiche sind Ihre stärksten?

Training und Inferenz von auf Transformatoren (und zukünftigen neuronalen Architekturen) basierenden Grundmodellen mit einer 50- bis 100-fach höheren Energieeffizienz im Vergleich zu heutigen GPU-basierten Lösungen.

Was hält Ihre Kunden nachts wach?

Probleme für Kunden, die derzeit andere Produkte verwenden:

Der Stromverbrauch für das Training riesiger Sprachmodelle ist unvorstellbar, zum Beispiel kostet das Training eines 13B-Parameter-LLM auf 390B Text-Tokens auf 200 GPUs für 7 Tage 151,744 US-Dollar (Quelle: HuggingFace neue Trainingscluster-Serviceseite – https://lnkd.in/g6Vc5cz3). Und selbst größere Modelle mit mehr als 100 B-Parametern kosten allein für das Training mehr als 10 Millionen US-Dollar. Dann zahlen Sie jedes Mal für die Inferenzierung, wenn eine neue Prompt-Anfrage eintrifft.

Forscher der University of California, Riverside, schätzen den Wasserverbrauch für die Kühlung, schätzen die Umweltauswirkungen eines ChatGPT-ähnlichen Dienstes ein und geben an, dass jedes Mal, wenn man danach fragt, 500 Milliliter Wasser verschlungen werden (ungefähr so viel wie in einer 16-Unzen-Wasserflasche). Reihe von 5 bis 50 Eingabeaufforderungen oder Fragen. Die Reichweite variiert je nach Standort der Server und Saison. Die Schätzung umfasst den indirekten Wasserverbrauch, den die Unternehmen nicht messen – etwa zur Kühlung von Kraftwerken, die die Rechenzentren mit Strom versorgen. (Quelle: https://lnkd.in/gybcxX8C)

Probleme für Nichtkunden aktueller Produkte:

Ich kann mir die Investitionsausgaben für den Kauf von Hardware nicht leisten

Ich kann es mir nicht leisten, Cloud-Dienste zu nutzen

Es ist nicht möglich, Innovationen zu entwickeln oder KI zu nutzen – wir bleiben beim Servicemodell, das jeglichen Wettbewerbsvorteil zunichte macht

Wie sieht die Wettbewerbslandschaft aus und wie differenzieren Sie sich?

- GPUs dominieren den Trainingsbereich, auch wenn in diesem Segment auch spezialisierte ASICs konkurrieren

- Für die Cloud- und Edge-Inferenz stehen zu viele Optionen zur Verfügung

Digital, analog, photonisch – was auch immer, die Leute versuchen, das gleiche Problem anzugehen.

Können Sie uns Ihre Gedanken zum aktuellen Stand der Chip-Architektur für KI/ML mitteilen, d. h. was sind Ihrer Meinung nach derzeit die wichtigsten Trends und Chancen?

Folgende Trends:

Trends 1: Vor 10 Jahren blühte das hardwaregestützte Deep Learning auf, und jetzt hemmt dieselbe Hardware den Fortschritt. Aufgrund der enormen Hardware- und Stromkosten für den Betrieb von Modellen ist es zu einer Herausforderung geworden, auf die Hardware zuzugreifen. Nur Unternehmen mit großen finanziellen Mitteln können sich diese leisten und werden zu Monopolen.

Trends 2: Da diese Modelle nun da sind, müssen wir sie für praktische Zwecke nutzen, damit die Inferenzlast steigt und CPUs mit KI-Beschleunigern wieder ins Rampenlicht rücken.

Trends 3: Startups versuchen, alternative Darstellungen von Gleitkommazahlen zu entwickeln, bei denen das traditionelle IEEE-Format – etwa logarithmisch und postbasiert – zwar gut, aber nicht ausreichend ist. Die Optimierung des PPA$-Designraums explodiert, wenn wir versuchen, den einen zu optimieren, und der andere einen Fehler macht.

Trends 4: Die Branche bewegt sich weg vom servicebasierten Modell der KI und hin zum Hosten eigener privater Modelle in den eigenen Räumlichkeiten – der Zugang zu Hardware ist jedoch aufgrund von Lieferengpässen, Sanktionen usw. eine Herausforderung

Gegenwaertiger Stand der Dinge:

Die Verfügbarkeit von Hardware und Daten hat vor 10 Jahren das Wachstum der KI vorangetrieben, jetzt hemmt dieselbe Hardware es gewissermaßen – lassen Sie mich das erklären

Seitdem es den CPUs schlecht ging und die GPUs für KI umfunktioniert wurden, ist viel passiert

Unternehmen haben sich mit vier Segmenten von KI/ML befasst, nämlich 4) Cloud-Schulung, 1) Cloud-Inferenzierung, 2) Edge-Inferenzierung und 3) Edge-Training (Verbundlernen für datenschutzrelevante Anwendungen).

Digital und Analog

Schulungsseite – eine Vielzahl von Unternehmen, die GPUs, Kundenbeschleuniger auf Basis von RISC-V, Wafer-Scale-Chips (850 Kerne) usw. herstellen, bei denen es an herkömmlichen CPUs mangelt (ihren allgemeinen Zweck). Inferenzseite – NN-Beschleuniger sind von jedem Hersteller in Smartphones, Laptops und anderen Edge-Geräten erhältlich.

Vor einiger Zeit tauchten auch analoge Memristor-basierte Architekturen auf.

Wir glauben, dass CPUs bei der Inferenz sehr gut sein können, wenn wir sie durch Beschleunigung wie Matrixerweiterungen verbessern

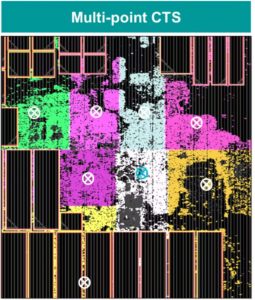

RISC-V-Seite der Dinge:

Auf der RISC-V-Seite entwickeln wir Beschleuniger für Matrixoperationen und andere nichtlineare Operationen, um mögliche Engpässe für Transformator-Workloads zu beseitigen. Von-Neumann-Engpässe werden auch dadurch angegangen, dass die Speicherarchitektur näher an der Rechenleistung liegt, sodass CPUs mit KI-Beschleunigung schließlich die richtige Wahl für Inferenzen sind.

Chancen:

Es bestehen einzigartige Möglichkeiten, den Markt der Stiftungsmodelle zu erschließen. Beispiel – OpenAI hat erwähnt, dass sie nicht in der Lage waren, genügend KI-Rechenleistung (GPUs) zu sichern, um ihre ChatGPT-Dienste weiter voranzutreiben … und die Nachrichten berichten über Stromkosten, die das Zehnfache der regulären Internetsuche betragen, und 10 ml Wasser, um die Systeme abzukühlen für jede Anfrage. Hier gibt es einen Markt zu füllen – es ist keine Nische, sondern der gesamte Markt, der die KI demokratisieren und alle oben genannten Herausforderungen bewältigen wird – a) Verfügbarkeit, b) Zugänglichkeit, c) Erschwinglichkeit und d) Umweltsicherheit

An welchen neuen Funktionen/Technologien arbeiten Sie?

Wir bauen Gehirne wie Computer auf, indem wir neuromodrische Techniken nutzen und Modelle anpassen, um die Vorteile der energieeffizienten Hardware zu nutzen, wobei wir viele der verfügbaren offenen Frameworks wiederverwenden

Wie stellen Sie sich das Wachstum oder die Veränderung des KI/ML-Sektors in den nächsten 12 bis 18 Monaten vor?

Da die Nachfrage nach GPUs gesunken ist (die etwa 30 US-Dollar kosten) und einige Teile der Welt wegen des Kaufs dieser GPUs mit Sanktionen rechnen müssen, haben einige Teile der Welt das Gefühl, in der KI-Forschung und -Entwicklung ohne Zugang zu GPUs eingefroren zu sein. Alternative Hardwareplattformen werden den Markt erobern.

Vielleicht werden die Modelle schrumpfen – kundenspezifische Modelle oder sogar grundsätzlich die Informationsdichte würden zunehmen

Dieselbe Frage, aber wie sieht es mit dem Wachstum und der Veränderung in den nächsten 3-5 Jahren aus?

a) CPUs mit KI-Erweiterungen würden den KI-Inferenzmarkt erobern

b) Modelle würden flinker und Parameter würden wegfallen, wenn sich die Informationsdichte von 16 % auf 90 % verbessert

c) Die Energieeffizienz verbessert sich, der CO2-Fußabdruck verringert sich

d) Neue Architekturen entstehen

e) Hardwarekosten und Energiekosten sinken, sodass die Eintrittsbarriere für kleinere Unternehmen zur Erstellung und Schulung von Modellen erschwinglich wird

f) Die Leute reden über den Moment vor AGI, aber mein Maßstab wäre die charakterisierte Samantha (Konversations-KI) im Film „Her“. Das ist angesichts der hohen Kosten der Skalierung vielleicht unwahrscheinlich

Welche Herausforderungen könnten das Wachstum im KI/ML-Sektor beeinflussen oder einschränken?

a) Zugriff auf Hardware

b) Energiekosten und Kühlkosten sowie Umweltschäden

Lesen Sie auch:

CEO-Interview: David Moore von Pragmatic

- SEO-gestützte Content- und PR-Distribution. Holen Sie sich noch heute Verstärkung.

- PlatoData.Network Vertikale generative KI. Motiviere dich selbst. Hier zugreifen.

- PlatoAiStream. Web3-Intelligenz. Wissen verstärkt. Hier zugreifen.

- PlatoESG. Kohlenstoff, CleanTech, Energie, Umwelt, Solar, Abfallwirtschaft. Hier zugreifen.

- PlatoHealth. Informationen zu Biotechnologie und klinischen Studien. Hier zugreifen.

- Quelle: https://semiwiki.com/ceo-interviews/338703-ceo-interview-suresh-sugumar-of-mastiska-ai/

- :hast

- :Ist

- :nicht

- :Wo

- $UP

- 1

- 10

- 150

- 20

- 20 Jahre

- 200

- 50

- 500

- 7

- a

- Fähig

- LiveBuzz

- oben

- abu dhabi

- Beschleunigung

- Beschleuniger

- Zugang

- Zugänglichkeit

- aktiv

- Adresse

- angesprochen

- Adressierung

- Vorteil

- Angelegenheiten

- aufs Neue

- Makler

- Agenten

- AGI

- vor

- AI

- KI-Modelle

- ai Forschung

- KI-Systeme

- KI-Anwendungsfälle

- AI / ML

- ausgerichtet

- Alle

- Zulassen

- erlaubt

- entlang

- ebenfalls

- Alternative

- erstaunlich

- an

- und

- Ein anderer

- jedem

- von jedem Standort

- Anwendung

- Anwendungen

- Architektur

- SIND

- Bereiche

- Kommt

- künstlich

- künstliche Intelligenz

- AS

- Asics

- fragen

- At

- Automobilindustrie

- Verfügbarkeit

- verfügbar

- ein Weg

- b

- Barriere

- basierend

- BE

- werden

- wird

- Werden

- war

- Sein

- Glauben

- unten

- Benchmark

- Nutzen

- Vorteile

- zwischen

- Beyond

- Engpässe

- gebunden

- Gehirn

- Kopf

- bauen

- Building

- aber

- Kaufe

- by

- Kalifornien

- CAN

- abgebrochen

- capability

- fähig

- Hauptstadt

- Erfassung

- Kohlenstoff

- Kohlenstoffabscheidung

- Fälle

- Centers

- CEO

- CEO-Vorstellungsgespräch

- Bescheinigung

- challenges

- Herausforderungen

- Übernehmen

- geändert

- Ändern

- Charakter

- ChatGPT

- weltweit

- Chip

- Pommes frites

- Wahl

- Chopra

- Auftraggeber

- Menu

- näher

- Cloud

- Cluster

- co2

- wie die

- Unternehmen

- Unternehmen

- verglichen

- konkurrieren

- wettbewerbsfähig

- Berechnen

- Computer

- Computer

- Computing

- Konzepte

- Kongressbegleitung

- verbrauchen

- Verbrauch

- fortsetzen

- beigetragen

- Konversations

- Konversations-KI

- cool

- Kosten

- Kosten

- könnte

- erstellen

- Strom

- Aktuellen Zustand

- Zur Zeit

- Original

- Kunde

- Kunden

- Schneiden

- Internet-Sicherheit

- technische Daten

- Rechenzentren

- Datacenter

- Christian

- Tag

- Tage

- Entscheidung

- tief

- tiefe Lernen

- tiefer

- Demand

- demokratisieren

- Demokratisierung

- Synergie

- Dichte

- Abhängig

- Design

- entwickeln

- entwickelt

- Entwicklung

- Entwicklung

- Geräte

- Dhabi

- unterscheiden

- Fleiß

- Richtung

- Direktor

- do

- die

- Dabei

- Dollar

- Nicht

- nach unten

- dr

- Drop

- zwei

- verdient

- Edge

- Effekten

- Effizienz

- effizient

- effizient

- Strom

- Stromverbrauch

- beseitigen

- eliminiert

- Emotionen

- Empathie

- Energie

- Energieeffizienz

- Entwicklung

- zu steigern,

- genug

- Ganz

- Eintrag

- Arbeitsumfeld

- Umwelt-

- vorstellen

- schätzen

- geschätzt

- etc

- Äther (ETH)

- Sogar

- schließlich

- Jedes

- Beispiel

- Exekutive

- Geschäftsführer

- existieren

- Expertise

- explodiert

- Erweiterungen

- Gesicht

- zugewandt

- Falke

- beschleunigt

- Gefühl

- füllen

- Firmen

- schweben

- konzentriert

- Fuß

- Aussichten für

- vorhersehen

- Format

- Vermögen

- Foundation

- Gerüste

- für

- eingefroren

- getankt

- funktional

- grundlegend

- Zukunft

- Allgemeines

- Generationen

- generativ

- Generative KI

- gegeben

- Go

- Goes

- gehen

- gut

- GPUs

- Gruppe an

- persönlichem Wachstum

- Wachstum

- Hardware

- Haben

- he

- daher

- hier

- GUTE

- hält

- Hosting

- Ultraschall

- HTTPS

- riesig

- Umarmendes Gesicht

- human

- Menschlichkeit

- IEEE

- if

- Image

- Impact der HXNUMXO Observatorien

- zu unterstützen,

- verbessert

- in

- In anderen

- Dazu gehören

- Erhöhung

- Energiegewinnung

- Information

- wir innovieren

- Innovation

- Innovationen

- beantragen müssen

- Institut

- Intel

- Intelligenz

- International

- Internet

- Interview

- Investition

- iot

- IT

- SEINE

- nur

- Kinder

- Art

- Mangel

- Landschaft

- Sprache

- Laptops

- grosse

- größer

- führen

- Leadership

- LERNEN

- lernen

- lassen

- Hebelwirkung

- Nutzung

- Gefällt mir

- Rampenlicht

- LIMIT

- Belastung

- located

- aussehen

- aussehen wie

- senken

- Maschinen

- Making

- Hersteller

- viele

- Markt

- Märkte

- Matrix

- max-width

- Kann..

- vielleicht

- MBA

- me

- Bedeutung

- Mittel

- messen

- Memories

- erwähnt

- könnte

- Million

- Millionen Dollar

- MIT

- Modell

- für

- Moment

- Monopole

- Monat

- mehr

- vor allem warme

- Film

- ziehen um

- MS

- sollen

- my

- Name

- nämlich

- Natürliche

- Need

- netzwerkbasiert

- Vernetzung

- Neural

- Neu

- News

- weiter

- Nische

- Nacht-

- flink

- jetzt an

- Kernenergie

- Atomkraft

- Anzahl

- Ozeane

- of

- on

- EINEM

- einzige

- XNUMXh geöffnet

- Open-Source-

- OpenAI

- Einkauf & Prozesse

- Entwicklungsmöglichkeiten

- Optimierung

- Optimieren

- Optionen

- or

- Andere

- UNSERE

- besitzen

- Seite

- Parallel

- Parameter

- Parameter

- Teile

- Patente

- AUFMERKSAMKEIT

- Personen

- vielleicht

- Planet

- Pflanzen

- Plattform

- Plattformen

- Plato

- Datenintelligenz von Plato

- PlatoData

- Fülle

- erfahren

- Taschen

- Points

- Position

- möglich

- Werkzeuge

- Kraftwerke

- Praktisch

- privat

- Aufgabenstellung:

- Probleme

- Produkt

- Produkte

- Profil

- Fortschritt

- Eingabeaufforderungen

- Risiken zu minimieren

- Zweck

- Zwecke

- Push

- Versetzt

- Qualcomm

- Frage

- Fragen

- Angebot

- Platz

- Lesen Sie mehr

- kürzlich

- Software Empfehlungen

- Empfehlungen

- Veteran

- Reduzierung

- regulär

- Meldungen

- Anforderung

- Forschungsprojekte

- Forschung und Entwicklung

- Forscher

- Recht

- Flussufer

- Rollen

- roof

- Führen Sie

- Laufen

- läuft

- Safe

- Sicherheit

- gleich

- Sanktionen

- Sandkasten

- Speichern

- Einsparung

- Skalierung

- Wissenschaft

- Suche

- Jahreszeit

- Bibliotheken

- Verbindung

- sehen

- Segmente

- Halbleiter

- Halbleiter

- Modellreihe

- Server

- Lösungen

- Dienst

- Teilen

- Engpässe

- sollte

- zeigte

- Konzerte

- Seite

- signifikant

- da

- kleinere

- Smartphone

- Smartphones

- So

- Software

- Lösungen

- Auflösung

- einige

- Quelle

- Raumfahrt

- spezialisiert

- verbrachte

- Stanford

- Anfang

- Startups

- Bundesstaat

- Strategie

- stärksten

- so

- liefern

- Support

- nachhaltiger

- Systeme und Techniken

- angehen

- anpacken

- Schneiderei

- Nehmen

- Reden

- und Aufgaben

- Technische

- Technologie

- technologische Innovation

- AGB

- Text

- als

- zur Verbesserung der Gesundheitsgerechtigkeit

- Das

- Die Zukunft

- die Informationen

- die Welt

- ihr

- Sie

- dann

- Dort.

- damit

- Diese

- vom Nutzer definierten

- fehlen uns die Worte.

- diejenigen

- obwohl?

- Entwickeln Sie

- Zeit

- zu

- heutigen

- Tokens

- morgen

- auch

- Top

- werfen

- traditionell

- Training

- Ausbildung

- Transformator

- Transformer

- Trends

- vertraut

- versuchen

- Versuch

- für

- versteht

- Universität

- University of California

- unwahrscheinlich

- us

- Anwendungsbereich

- -

- benutzt

- Verwendung von

- verschiedene

- wagen

- Risikokapital

- Venture Capital-Firmen

- sehr

- von

- wurde

- Wasser

- Weg..

- we

- Netz

- Wohl

- waren

- Was

- wann

- welche

- WHO

- warum

- werden wir

- mit

- ohne

- Arbeiten

- arbeiten,

- weltweit wie ausgehandelt und gekauft ausgeführt wird.

- würde

- Falsch

- Jahr

- U

- Ihr

- Zephyrnet