什么是向量嵌入?

向量嵌入是捕获单词、短语和其他数据类型的关系和含义的数字表示。通过向量嵌入,对象的基本特征或特征被转换为简洁且有组织的数字数组,帮助计算机快速检索信息。相似的数据点在转换为多维空间中的点后会更紧密地聚集在一起。

用途广泛,特别是在自然语言处理中(NLP)和机器学习(ML),向量嵌入有助于操纵和处理数据以完成相似性比较、聚类和分类等任务。例如,当查看文本数据时,诸如 猫 和 猫咪 尽管字母组成不同,但传达相似的含义。有效的语义搜索依赖于充分捕获术语之间的语义相似性的精确表示。

[嵌入的内容]

嵌入和向量是同一回事吗?

该条款 矢量 和 嵌入 可以在向量嵌入的上下文中互换使用。它们都指的是数字数据表示,其中每个 数据点 被表示为高维空间中的向量。

向量是指具有定义维度的数字数组,而向量嵌入使用这些向量来表示连续空间中的数据点。

这篇文章是其中的一部分

嵌入是指将数据表达为向量,以捕获重要信息、语义链接、上下文质量或通过训练算法学习的数据的有组织的表示或 机器学习模型.

向量嵌入的类型

向量嵌入有多种形式,每种形式都有不同的功能来表示不同类型的数据。以下是一些常见的向量嵌入类型:

- 词嵌入。 词嵌入是连续空间中单个词的向量表示。它们经常用于捕获任务中单词之间的语义链接,例如 情绪分析、语言翻译和单词相似度。

- 句子嵌入。 完整句子的向量表示称为句子嵌入。它们对于情感分析、文本分类和信息检索等任务很有帮助,因为它们捕获了句子的含义和上下文。

- 文档嵌入。 文档嵌入是整个文档的矢量表示,例如文章或报告。它们通常用于文档相似性、聚类和推荐系统等任务,捕获文档的一般含义和内容。

- 用户配置文件向量。 这些是用户偏好、行为或特征的矢量表示。它们用于 客户细分、个性化推荐系统和有针对性的广告来收集用户特定的数据。

- 图像向量。 这些是视觉项目的矢量表示,例如图片或视频帧。它们用于诸如以下的任务 对象识别、图像搜索和基于内容的推荐系统来捕获视觉特征。

- 产品载体。 将产品或项目表示为向量,用于产品搜索、产品分类和推荐系统,以收集产品之间的特征和相似性。

- 用户配置文件向量。 用户配置文件向量代表用户的偏好、行为或特征。它们用于用户细分、个性化推荐系统和 针对性广告 收集用户特定的数据。

向量嵌入是如何创建的?

向量嵌入是使用机器学习方法生成的,该方法训练模型将数据转换为数值向量。通常,深 卷积神经网络 用于训练这些类型的模型。生成的嵌入通常是密集的(所有值都不为零)并且是高维的(高达 2,000 个维度)。流行的模型,如 Word2Vec、GLoVE 和 BERT 将单词、短语或段落转换为文本数据的向量嵌入。

该过程通常涉及以下步骤:

- 组装一个大数据集。 收集捕获特定数据类别(无论是文本还是图像)的数据集。

- 预处理数据。 根据数据的类型,清理、准备和 数据预处理 涉及消除噪音、调整照片大小、标准化文本和执行其他操作。

- 训练模型。 为了识别数据中的链接和模式,使用数据集训练模型。为了减少目标向量和预测向量之间的差异,预训练模型的参数在训练阶段会发生变化。

- 生成向量嵌入。 经过训练,模型可以将新数据转换为数值向量,呈现有意义的结构化表示,有效封装原始数据的语义信息。

向量嵌入可以用于多种数据类型,包括时间序列数据、文本、图片、音频、 三维 (3D) 模型 和视频。由于嵌入的形成方式,具有相似语义的对象在向量空间中将具有彼此接近的向量。

向量嵌入存储在哪里?

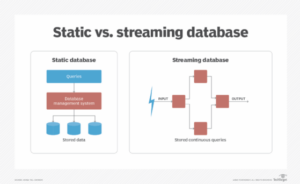

向量嵌入存储在专门的数据库中,称为 矢量数据库。这些数据库是数据特征的高维数学表示。与标准的基于标量的数据库或独立的向量索引不同,向量数据库为大规模存储和检索向量嵌入提供了特定的效率。它们提供了有效存储和检索矢量搜索功能的大量数据的能力。

矢量数据库包括几个关键组件,包括性能和 容错。确保矢量数据库具有容错性、复制性和 分片 使用技术。复制是在多个节点上生成数据副本的过程,而分片是在多个节点上对数据进行分区的过程。即使节点发生故障,这也可以提供容错能力和不间断的性能。

矢量数据库在机器学习和人工智能中非常有效(AI)应用程序,因为它们专门管理 非结构化和半结构化数据.

向量嵌入的应用

矢量嵌入在不同行业中有多种用途。向量嵌入的常见应用包括:

- 推荐系统。 矢量嵌入在 Netflix 和 Amazon 等行业巨头的推荐系统中发挥着至关重要的作用。这些嵌入使组织可以计算用户和项目之间的相似性,将用户偏好和项目特征转换为向量。此过程有助于提供根据个人用户品味量身定制的个性化建议。

- 搜索引擎。 搜索引擎 广泛使用向量嵌入来提高信息检索的有效性和效率。由于向量嵌入超出了关键字匹配的范围,因此它们可以帮助搜索引擎解释单词和句子的含义。即使确切的短语不匹配,搜索引擎仍然可以通过将单词建模为语义空间中的向量来查找和检索上下文相关的文档或其他信息。

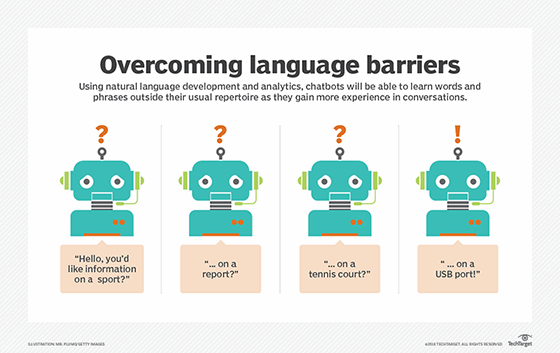

- 聊天机器人和问答系统。 向量嵌入辅助 聊天机器人和基于人工智能的生成式问答系统 理解和产生类似人类的反应。通过捕获文本的上下文和含义,嵌入可以帮助聊天机器人以有意义且合乎逻辑的方式响应用户的询问。例如,语言模型和人工智能聊天机器人,包括 GPT-4 和图像处理器,例如 达尔-E2,因产生类似人类的对话和响应而广受欢迎。

- 欺诈检测和异常值检测。 向量嵌入可用于通过评估向量之间的相似性来检测异常或欺诈活动。通过评估嵌入和精确定位之间的距离来识别不常见的模式 离群.

- 数据预处理。 改造 将未处理的数据转换为适合机器学习的格式 和深度学习模型,嵌入用于数据预处理活动。例如,词嵌入用于将词表示为向量,这有助于文本数据的处理和分析。

- 一次性学习和零次学习。 一次性学习和零次学习是向量嵌入方法,即使在提供有限的标记数据的情况下,也可以帮助机器学习模型预测新类别的结果。通过使用嵌入中包含的语义信息,即使使用少量训练实例,模型也可以概括并生成预测。

- 语义相似性和聚类。 向量嵌入可以更轻松地衡量两个对象在高维环境中的相似程度。这使得计算语义相似度、基于相关事物的嵌入进行聚类和组装等操作成为可能。

可以嵌入什么类型的东西?

许多不同类型的对象和数据类型可以使用向量嵌入来表示。可以嵌入的常见类型包括:

文本

使用文本嵌入将单词、短语或文档表示为向量。 NLP 任务(包括情感分析、语义搜索和语言翻译)经常使用嵌入。

通用句子编码器是最流行的开源嵌入模型之一,它可以有效地对单个句子和整个文本块进行编码。

图片

图像嵌入捕获图像的视觉特征并将其表示为向量。它们的用例包括对象识别、图片分类和反向图像搜索,通常称为 按图片搜索.

图像嵌入还可用于启用视觉搜索功能。通过从数据库图像中提取嵌入,用户可以将查询图像的嵌入与数据库照片的嵌入进行比较,以找到视觉上相似的匹配。这常用在 电子商务行业 应用程序,用户可以通过上传类似产品的照片来搜索商品。

Google Lens 是一款图像搜索应用程序,可将相机照片与视觉上相似的产品进行比较。例如,它可以用来匹配类似于一双运动鞋或一件衣服的互联网产品。

Audio

音频嵌入是音频信号的向量表示。矢量嵌入捕获听觉属性,让系统更有效地解释音频数据。例如,音频嵌入可用于音乐推荐、流派分类、音频相似性搜索、语音识别和说话人验证。

虽然人工智能被用于各种类型的嵌入,但音频人工智能比文本或图像人工智能受到的关注要少。谷歌语音转文本和 OpenAI Whisper 是呼叫中心、医疗技术、辅助功能和语音转文本应用程序等组织中使用的音频嵌入应用程序。

图

图嵌入使用向量来表示图中的节点和边。他们是 用于与图形分析相关的任务 例如链接预测、社区识别和推荐系统。

每个节点代表一个实体,例如人、网页或产品,每条边象征这些实体之间存在的链接或连接。这些向量嵌入可以完成从推荐朋友到 社会网络 检测网络安全问题。

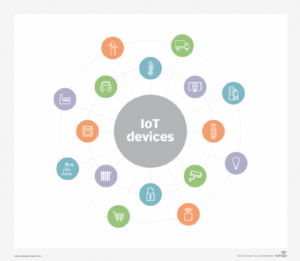

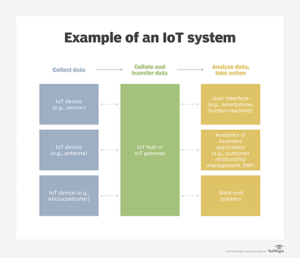

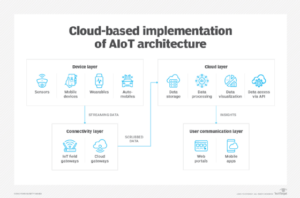

时间序列数据和 3D 模型

时间序列嵌入捕获顺序数据中的时间模式。它们用于 物联网 用于包括异常检测在内的活动的应用程序、财务数据和传感器数据, 时间序列预测 和模式识别。

3D 对象的几何方面也可以使用 3D 模型嵌入表示为向量。它们应用于 3D 重建、对象检测和形状匹配等任务。

分子

分子嵌入将化合物表示为向量。它们用于药物发现、化学相似性搜索和分子特性预测。这些嵌入还用于计算化学和药物开发,以捕获分子的结构和化学特征。

什么是 Word2Vec?

Word2Vec 是一种流行的 NLP 词向量嵌入方法。 Word2Vec 由 Google 创建,旨在将单词表示为连续向量空间中的密集向量。它可以识别文档中单词的上下文,常用于文本分类、情感分析和 机器翻译 帮助机器更有效地理解和处理自然语言。

Word2Vec 基于具有相似含义的单词应该具有相似的向量表示的原则,使模型能够捕获单词之间的语义联系。

Word2Vec 有两种基本架构, CBOW(连续词袋)和 Skip-Gram:

- CBOW。 该架构根据上下文单词预测目标单词。该模型被给予上下文或周围的单词,并负责预测中心的目标单词。例如,在句子“The Quick Brown Fox Jumps Over the Lazy Dog”中,CBOW 使用上下文或周围的单词来预测 狐狸 作为目标词。

- 斯基普-格拉姆。 与 CBOW 不同,Skip-Gram 架构根据目标单词预测上下文单词。该模型被赋予一个目标词,并被要求预测周围的上下文术语。以上面的示例句子“The Quick Brown Fox Jumps Over the Lazy Dog”为例,skip-gram 将采用目标词 狐狸 并发现上下文单词,例如“The”、“quick”、“brown”、“jumps”、“over”、“the”、“lazy”和“dog”。

众多企业开始拥抱生成式人工智能,展示了其颠覆性潜力。检查 生成式人工智能是如何发展的未来会向什么方向发展以及可能出现的挑战。

- :具有

- :是

- :在哪里

- $UP

- 000

- 1

- 26

- 27

- 31

- 360

- 3d

- 40

- 43

- a

- 以上

- 访问

- 完成

- 横过

- 行动

- 活动

- 额外

- 充分

- 广告

- 后

- AI

- 援助

- 艾滋病

- 算法

- 所有类型

- 还

- Amazon

- an

- 分析

- 和

- 异常检测

- 另一个

- 任何

- 应用领域

- 应用领域

- 应用的

- 的途径

- 方法

- 适当

- 应用

- 架构

- 保健

- 出现

- 排列

- 刊文

- 刊文

- 人造的

- 人工智能

- AS

- 方面

- 组装

- 评估

- At

- 关注我们

- 音频

- 袋

- 言语包

- 基于

- 基本包

- BE

- 因为

- 开始

- 作为

- 之间

- 超越

- 都

- 棕色

- 企业

- by

- 计算

- 呼叫

- 被称为

- 相机

- CAN

- 能力

- 容量

- 捕获

- 捕获

- 携带

- 例

- 产品类别

- Center

- 中心

- 挑战

- 变

- 特点

- 聊天机器人

- 化学

- 化学

- 类

- 分类

- 清洁

- 关闭

- 接近

- 服装

- 集群

- COM的

- 如何

- 相当常见

- 常用

- 社体的一部分

- 比较

- 比较

- 完成

- 组件

- 写作

- 理解

- 计算

- 电脑

- 计算

- 简洁

- 地都

- 内容

- 上下文

- 上下文

- 连续

- 对话

- 兑换

- 副本

- 创建

- 关键

- 网络安全

- data

- 数据点

- 数据集

- 数据库

- 数据库

- 深

- 深入学习

- 定义

- 定义

- 交货

- 示范

- 密

- 根据

- 设计

- 尽管

- 检测

- 检测

- 研发支持

- 差异

- 不同

- 尺寸

- 尺寸

- 方向

- 通过各种方式找到

- 发现

- 破坏性

- 距离

- 不同

- do

- 文件

- 文件

- 狗

- 不

- 药物

- 药物开发

- 药物发现

- ,我们将参加

- 每

- 更容易

- 边缘

- 有效

- 只

- 效用

- 效率

- 效率

- 有效

- 消除

- 嵌入式

- 嵌入

- 拥抱

- enable

- 使

- 封装

- 引擎

- 确保

- 实体

- 实体

- 环境

- 特别

- 必要

- 醚(ETH)

- 评估

- 甚至

- 一切

- 检查

- 例子

- 存在

- 表示

- 表达

- 广泛

- 功能有助于

- 失败

- 特征

- 金融

- 财务数据

- 找到最适合您的地方

- 以下

- 针对

- 申请

- 格式

- 形成

- 形式

- 狐狸

- 欺诈

- 频繁

- 新鲜

- 朋友

- 止

- 功能

- 功能

- 未来

- 获得

- 收集

- 测量

- 其他咨询

- 生成

- 产生

- 生成的

- 生成式人工智能

- 类型

- 巨头

- 特定

- 手套

- Go

- 谷歌

- 图形

- 有

- 帮助

- 有帮助

- 帮助

- 高

- 创新中心

- HTTPS

- 巨大

- ICON

- 鉴定

- 确定

- 鉴定

- if

- 图片

- 图片搜索

- 图片

- 巨大

- 改善

- in

- 包括

- 包括

- 包含

- 独立

- 指标

- 个人

- 行业

- 行业中的应用:

- 信息

- 咨询内容

- 内

- 例

- 实例

- 房源搜索

- 拟

- 网络

- 成

- 参与

- 涉及

- 问题

- IT

- 项目

- 它的

- 跳跃

- 键

- 已知

- 语言

- 大

- 知道

- 学习

- 光学棱镜

- 减

- 让

- 邮件

- 让

- 有限

- 友情链接

- 链接

- 合乎逻辑的

- 寻找

- 机

- 机器学习

- 机

- 制成

- 使

- 制作

- 管理的

- 方式

- 匹配

- 火柴

- 匹配

- 数学的

- 意

- 有意义的

- 含义

- 医生

- 可能

- ML

- 模型

- 造型

- 模型

- 分子

- 更多

- 最先进的

- 最受欢迎的产品

- 音乐

- 自然

- 自然语言

- 自然语言处理

- Netflix公司

- 神经

- 全新

- NLP

- 节点

- 节点

- 噪声

- 数

- 数字

- 众多

- 对象

- 物体检测

- 对象

- of

- 提供

- 经常

- on

- 一

- 打开

- 开放源码

- 运营

- or

- 组织

- 举办

- 原版的

- 其他名称

- 输出

- 结果

- 局外人

- 超过

- 页

- 对

- 参数

- 部分

- 模式

- 模式

- 性能

- 人

- 个性化你的

- 相

- 图片

- 短语

- 图片

- 图片

- 片

- 柏拉图

- 柏拉图数据智能

- 柏拉图数据

- 播放

- 点

- 热门

- 声望

- 可能

- 潜力

- 精确的

- 预测

- 都曾预测

- 预测

- 预测

- 预测

- 预测

- 喜好

- 准备

- 原理

- 过程

- 处理

- 处理器

- 生产

- 产品

- 生产

- 核心产品

- 本人简介

- 财产

- 提供

- 提供

- 气质

- 快速

- 范围

- 急速

- RE

- 收到

- 承认

- 承认

- 推荐

- 建议

- 建议

- 减少

- 参考

- 指

- 有关

- 关系

- 相应

- 复制

- 业务报告

- 代表

- 表示

- 代表

- 代表

- 代表

- 回应

- 回复

- 导致

- 恢复

- 反转

- 角色

- s

- 同

- 鳞片

- 搜索

- 搜索引擎

- 搜索

- 搜索

- 部分

- 分割

- 语义

- 语义

- 传感器

- 句子

- 情绪

- 系列

- 集

- 套数

- 几个

- 分片

- 应该

- 显示

- 信号

- 显著

- 类似

- 相似之处

- 自

- 小

- 运动鞋

- 一些

- 来源

- 太空

- 喇叭

- 专攻

- 专门

- 具体的

- 言语

- 语音识别

- 语音到文本

- 标准

- 步骤

- 仍

- 商店

- 存储

- 结构

- 结构化

- 这样

- 提供

- 周围

- 象征

- 产品

- T

- 量身定制

- 采取

- 服用

- 目标

- 针对

- 任务

- 技术

- 专业技术

- 条款

- 文本

- 比

- 这

- 未来

- 其

- 博曼

- 他们

- 事

- 事

- Free Introduction

- 那些

- 通过

- 次

- 时间序列

- 至

- 一起

- 公差

- 培训

- 熟练

- 产品培训

- 火车

- 改造

- 翻译

- 转

- 二

- 类型

- 类型

- 一般

- 罕见

- 理解

- 不断

- 普遍

- 不像

- 上传

- 使用

- 用过的

- 用户

- 用户

- 使用

- 运用

- 价值观

- 各种

- 各个

- 企业验证

- 通过

- 视频

- 视觉

- 视觉

- 方法..

- 卷筒纸

- 什么是

- 什么是

- ,尤其是

- 而

- 是否

- 这

- 而

- 耳语

- 全

- 宽

- 大范围

- 将

- Word

- 话

- YouTube的

- 和风网

- 零样本学习