英特尔公司的研究人员发表了一篇题为“Intel GPU 上的高效 LLM 推理解决方案”的技术论文。

摘要:

“基于 Transformer 的大型语言模型(LLM)已在许多领域得到广泛应用,LLM 推理的效率成为实际应用中的热门话题。然而,LLM通常模型结构设计复杂,运算量大,并以自回归模式进行推理,这使得设计高效的系统成为一项艰巨的任务。

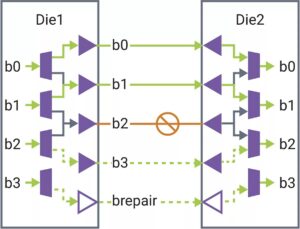

在本文中,我们提出了一种具有低延迟和高吞吐量的高效 LLM 推理解决方案。首先,我们通过融合数据移动和逐元素操作来简化LLM解码器层,以减少内存访问频率并降低系统延迟。我们还提出了分段 KV 缓存策略,将请求和响应令牌的键/值保存在单独的物理内存中,以实现有效的设备内存管理,有助于扩大运行时批量大小并提高系统吞吐量。定制的 Scaled-Dot-Product-Attention 内核旨在匹配我们基于分段 KV 缓存解决方案的融合策略。我们在 Intel GPU 上实现了 LLM 推理解决方案并公开发布。与标准 HuggingFace 实现相比,所提出的解决方案在 Intel GPU 上的一些流行的 LLM 上实现了高达 7 倍的令牌延迟降低和 27 倍的吞吐量提高。”

找出 技术论文在这里。 2023 年 XNUMX 月出版(预印本)。

吴、辉、甘毅、冯远、马晶、朱伟、徐玉涛、朱红、朱玉华、刘晓丽和谷景辉。 “基于 Intel GPU 的高效 LLM 推理解决方案。” arXiv 预印本 arXiv:2401.05391 (2023)。

相关阅读

LLM CPU 推理(英特尔)

英特尔研究人员发表了一篇题为“Efficient LLM Inference on CPUs”的技术论文。

人工智能竞赛到边缘

随着人工智能扩展到新的应用程序,推理和一些训练正在被推向更小的设备。

- :是

- $UP

- 2023

- a

- ACCESS

- 实现

- AI

- 还

- an

- 和

- 应用领域

- 保健

- AS

- At

- 基于

- 成为

- 很

- 作为

- by

- 缓存

- 挑战

- 相比

- 公司

- 定制

- data

- 十二月

- 设计

- 设计

- 设备

- 设备

- 有效

- 效率

- 高效

- 放大

- 字段

- 针对

- 频率

- 融合

- 聚变

- GPU

- 图形处理器

- 有

- 帮助

- 此处

- 高

- 更高

- 香

- 热卖

- 但是

- HTTPS

- 拥抱脸

- 实施

- 履行

- 改善

- in

- 英特尔

- IT

- JPG

- 保持

- 语言

- 大

- 潜伏

- 层

- LLM

- 低

- 降低

- 制作

- 颠覆性技术

- 许多

- 大规模

- 匹配

- 内存

- 时尚

- 模型

- 模型

- 运动

- 全新

- of

- on

- 打开

- 运营

- 我们的

- 纸类

- 演出

- 的

- 柏拉图

- 柏拉图数据智能

- 柏拉图数据

- 政策

- 热门

- 提供

- 建议

- 公然

- 发布

- 出版

- 种族

- 真实

- 减少

- 请求

- 研究人员

- 响应

- 段

- 分开

- 简化

- 尺寸

- 小

- 方案,

- 一些

- 价差

- 标准

- 结构体

- 系统

- 任务

- 文案

- Free Introduction

- 吞吐量

- 标题

- 至

- 象征

- 令牌

- 主题

- 产品培训

- 用过的

- 平时

- 是

- we

- 广泛

- 元

- 和风网