杰·达瓦尼 是联合创始人兼首席执行官 勒穆里亚实验室,一家初创公司,开发专为人工智能应用量身定制的加速计算平台。该平台突破了硬件障碍,使人工智能开发更快、更便宜、更可持续,并且不仅仅限于少数公司。

在创立 Lemurian 之前,Jay 在人工智能领域创办了另外两家公司。他也是最受好评的《深度学习数学设立的区域办事处外,我们在美国也开设了办事处,以便我们为当地客户提供更多的支持。“

Jay 是人工智能、机器人和数学方面的专家,曾担任 BlocPlay(一家构建基于区块链的游戏平台的上市公司)的首席技术官,并担任 GEC 的人工智能总监,领导了多个涵盖领域的客户项目的开发从零售、算法交易、蛋白质折叠、太空探索机器人、推荐系统等等。在业余时间,他还担任 NASA Frontier Development Lab、Spacebit 和 SiaClassic 的顾问。

上次我们介绍 Lemurian Labs 时,您关注的是机器人技术和边缘人工智能。现在您专注于数据中心和云基础设施。发生了什么事情让你想要转型?

事实上,我们确实从专注于为自主机器人应用构建高性能、低延迟、可以加速整个感知-计划-行动循环的片上系统,转变为专注于数据中心规模应用的人工智能领域特定加速器。但这不仅仅是一个普通的枢轴;它是一个普通的枢轴。这是我们认为我们有责任回应的号角。

2018 年,我们正致力于训练一个价值 2.1 亿美元的参数模型,但我们放弃了这项工作,因为成本非常高,我们无法证明其合理性。因此,想象一下我对 GPT3(OpenAI 于 2022 年 175 月以 ChatGPT 的名义发布)是一个价值 80 亿美元的参数模型感到惊讶。这个模型比我们 4 年前所做的模型大 XNUMX 倍以上,这既令人兴奋又令人恐惧。

至少可以说,训练这样一个模型的成本是惊人的。根据当前的扩展趋势,我们预计在不久的将来训练前沿人工智能模型的成本将超过 10 亿美元。虽然这些模型的功能令人震惊,但成本却高得离谱。根据这一轨迹,只有少数资源丰富、拥有自己的数据中心的公司才能负担得起训练、部署和微调这些模型的费用。这不仅仅是因为计算成本昂贵且耗电,还因为我们所依赖的软件堆栈不是为这个世界构建的。

由于地理和能源的限制,建设数据中心的地方有限。为了满足人工智能的计算需求,我们需要能够建造 zettascale 机器,而不需要 20 个核反应堆为其提供动力。我们需要一个更实用、可扩展且经济的解决方案。我们环顾四周,没有看到任何人能够解决这个问题。因此,我们从头开始,从整体上将问题视为一个系统系统,并从首要原则出发推理出解决方案。我们问自己,如果我们每天必须经济地服务 10 亿个 LLM 查询,我们将如何设计从软件到硬件的完整堆栈。我们的目标是到 200 年生产出功率低于 2028MW 的 zettascale 机器。

诀窍是从不相称的扩展的角度来看待它——系统的不同部分遵循不同的扩展规则,因此在某些时候事情会停止工作,开始破坏或者成本效益权衡不再有意义。发生这种情况时,唯一的选择就是重新设计系统。我们的评估和解决方案全面涵盖工作负载、数字系统、编程模型、编译器、运行时和硬件。

值得庆幸的是,我们现有的投资者和市场的其他部分看到了我们的愿景,我们筹集了 9 万美元的种子轮来开发我们的数字格式 - PAL,探索设计空间并集中于我们特定领域加速器的架构,并构建我们的编译器和运行时。在模拟中,我们已经能够以比现代 GPU 更小的能耗实现 20 倍的吞吐量增益,并且预计能够在相同晶体管技术的总拥有成本下将系统性能提高 8 倍。

不用说,我们还有很多工作要做,但我们对能够重新定义数据中心经济学以确保未来每个人都能充分利用人工智能的前景感到非常兴奋。

这听起来确实令人兴奋,而且这些数字听起来令人印象深刻。但您提到了数字系统、硬件、编译器和运行时作为您关注的所有内容 - 听起来对于任何公司来说都需要同时承担很多工作。这似乎是一个非常危险的提议。初创企业不应该更加专注吗?

这听起来确实像是很多不同的努力,但事实上,它是由许多相互关联的部分组成的一项努力。仅解决其中一个组件而孤立其他组件只会阻碍创新潜力,因为它会导致忽视系统效率低下和瓶颈。黄仁勋说得最好,“为了成为一家加速计算公司,你必须成为一家全栈公司”,我完全同意。他们是当前市场的领导者是有原因的。但我会对“我们不专注”的观点提出质疑。我们的重点在于我们如何整体思考问题以及如何最好地为客户解决问题。

做到这一点需要像我们这样的多学科方法。我们工作的每个部分都为其他部分提供信息和支持,使我们能够创建一个远远大于各个部分之和的解决方案。想象一下,如果你必须建造一辆赛车。您不会随意选择底盘、添加赛车轮胎并安装您能找到的最强大的发动机并进行比赛,对吧?您会考虑车身的空气动力学特性,以减少阻力并增强下压力,优化重量分布以实现良好的操控性,定制设计发动机以实现最佳性能,配备冷却系统以防止过热,指定防滚架以确保驾驶员安全等等。这些元素中的每一个都建立在另一个元素的基础上并相互影响。

也就是说,对于任何行业的任何公司来说,尝试一次性完成所有这些工作都是有风险的。为了管理风险,我们采取分阶段的方法,使我们能够与客户验证我们的技术并根据需要调整我们的策略。我们已经证明我们的数字格式有效,并且它比等效的浮点类型具有更好的功耗性能区域,同时还具有更好的数字属性,这使得更容易将神经网络量化为更小的位宽度。我们设计了一个我们有信心的架构,它既适合训练又适合推理。但比这一切更重要的是让软件正确运行,这是我们当前关注的重点。我们需要确保在我们的软件堆栈中做出正确的决策,以应对从今天起一两年或更长时间的世界。

建立一家硬件公司是艰难、昂贵且需要很长时间的。首先对软件的关注本身听起来像是一项非常可行的业务,并且在当前环境下可能对投资者更具吸引力。鉴于该领域有如此多资金雄厚的公司正在关门,努力获得客户的采用,而更大的公司正在构建自己的硬件,为什么你还要做硬件呢?

你说得对,软件企业通常比硬件公司更容易筹集资金,而且硬件非常困难。我们目前的重点主要集中在软件上,因为这是我们看到更大问题的地方。让我明确一点,问题不在于我能否让内核以高性能运行在 CPU 或 GPU 上;而在于我能否让内核以高性能运行在 CPU 或 GPU 上。这是一个长期解决的问题。今天的问题是,我们如何让开发人员更轻松地从由异构计算组成的数千个节点集群中高效地获得更高的性能,而不要求他们彻底改变工作流程。

这就是我们目前专注于通过软件堆栈来解决的问题,该软件堆栈为开发人员提供超能力并解锁仓库规模计算机的全部功能,以便我们可以更经济地训练和部署人工智能模型。

现在,在投资方面,是的,风险投资公司对他们所支持的公司类型更加挑剔,但这也意味着风险投资公司正在寻找有潜力提供真正突破性产品的公司,这些产品具有明确的商业化路径,同时具有重大影响力。我们从其他人的挑战和错误中吸取了教训,并积极设计了我们的商业模式和路线图来应对风险。同样重要的是要注意,初创公司的成功很少取决于他们如何轻松地筹集风险投资资金,而更多地与他们的足智多谋、固执和以客户为中心有关。

在你问之前,我们仍在开发硬件,但目前主要是在模拟方面。我们暂时不打算停播。但我们可以把这次谈话留到下次再说。

这当然很引人注目,而且与我们看到的其他硬件公司的做法相比,你们的分阶段方法非常不同。我理解您所说的软件堆栈将解决的问题,但是您的软件如何与市场上的各种产品区分开来?

您提到的大多数公司都专注于通过引入基于图块或任务映射的编程模型来更轻松地对 GPU 进行编程,以提高 GPU 的性能,或者构建新的编程语言以在不同的平台上调度高性能内核。支持在线组装的平台。这些是他们正在解决的重要问题,但我们认为我们正在解决的问题几乎是正交的。

让我们考虑一下硬件和软件转换的节奏。单核架构通过时钟速度和晶体管密度获得了性能,但最终时钟速度达到了稳定水平。使用多个核心的并行性避免了这一点,并提供了相当大的加速。软件大约花了十年时间才迎头赶上,因为必须重新考虑编程模型、编译器和运行时,以帮助开发人员提取这种范式的价值。然后,GPU 开始成为通用加速器,同样具有不同的编程模型。同样,开发商花了近十年的时间才在这里获取价值。

硬件再次陷入停滞状态——摩尔定律、能源和热限制、内存瓶颈、工作负载的多样性以及对计算量呈指数级增长的需求正在推动我们构建日益异构的计算机架构,以实现更好的性能、效率和总成本。硬件的这种转变当然会给软件带来挑战,因为我们没有合适的编译器和运行时来支持计算的下一次发展。但这一次,我们不应该再等 10 年,软件才能挖掘异构架构或大型集群的价值,尤其是当它们的利用率超过 80% 时。

我们关注的是构建具有基于任务并行性的异构感知编程模型,通过跨处理器优化、上下文感知编译和动态资源分配来解决可移植性能问题。对于我们来说,它是 CPU、GPU、TPU、SPU(Lemurian 架构)还是它们的网格并不重要。我知道这听起来像是很多花哨的词,但它真正的意思是,我们已经使使用单一方法对任何类型的处理器进行编程成为可能,并且我们可以以最少的成本将代码从一种处理器移植到另一种处理器。无需牺牲性能,即可在节点之间自适应、动态地安排工作。

如果你说的是真的,你可能会完全重新定义计算。我们来谈谈资金问题。您去年筹集了 9 万美元的种子资金,这表明投资者对您的愿景给予了强有力的支持和信任。从那以后你做了什么?

过去一年,在种子资金的推动下,我们取得了重大进展。我们的团队目前有 20 名成员,我们精心应对挑战,与客户互动并完善我们的方法。

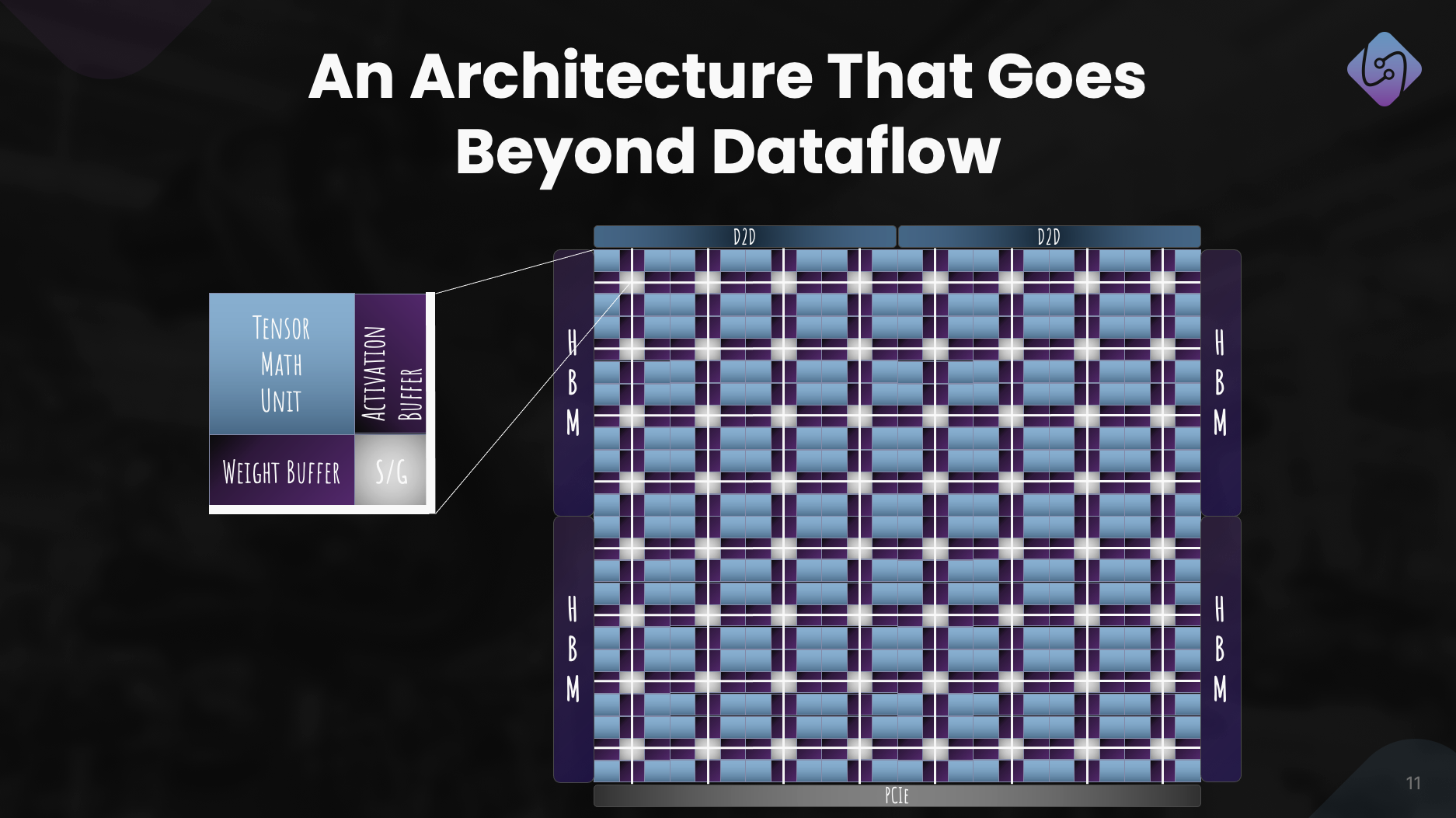

我们专注于增强 PAL 的训练和推理能力,探索加速器的计算机架构,并开发了性能指标模拟器。同时,我们重新构想了数据中心应用程序的软件堆栈,强调异构计算。

这项工作产生了一个定义明确的架构,展示了 PAL 在大规模人工智能方面的功效。除了技术进步之外,我们还寻求合作和推广,以实现访问民主化。这些努力使 Lemurian Labs 能够解决眼前的客户挑战,为我们生产芯片的发布做好准备。

Lemurian Labs 在软件堆栈开发、合作和加速器架构改进方面的中期计划是什么?

我们的近期目标是创建一个针对 CPU、GPU 和具有便携式性能的 AI 加速器的软件堆栈,并将于今年年底向早期合作伙伴提供。我们目前正在与大多数领先的半导体公司、云服务提供商、超大规模企业和人工智能公司进行对话,让他们能够访问我们的编译器和运行时。与此同时,我们继续致力于并改进我们的加速器架构,以实现真正的硬件和软件协同设计系统。当然,我们刚刚开始筹集 A 轮融资,投资者对此表现出了浓厚的兴趣,这将使我们能够扩大团队规模并实现年底软件产品交付的目标。

最后,您如何看待 Lemurian Labs 在未来几年为改变人工智能开发、可访问性和公平性的格局做出的贡献?

我们重新定义计算并不是为了商业利益或乐趣。作为利穆里亚人,我们的驱动力是我们相信人工智能的变革潜力,并且不仅仅是少数公司应该拥有资源来定义这项技术的未来以及我们如何使用它。我们也认为,到 20 年,人工智能的数据中心基础设施将消耗全球 2030% 的能源,这是令人无法接受的。我们聚集在一起,因为我们相信,如果我们能够通过大幅降低相关成本,加快人工智能创新步伐并扩大其影响,让人工智能变得更容易获得。通过解决当前硬件基础设施的挑战,我们寻求为十亿人赋予人工智能能力铺平道路,确保这一先进技术的公平分配。我们希望我们对以产品为中心的解决方案、协作和持续创新的承诺使我们成为塑造人工智能发展积极未来的驱动力。

另请参阅:

通过以下方式分享此帖子:

- :具有

- :是

- :不是

- :在哪里

- 9 百万美元

- $UP

- 1

- 10

- 20

- 2018

- 2022

- 2028

- 2030

- 20x

- 300

- 4

- a

- Able

- 关于

- 绝对

- 加快

- 加速

- 加速器

- 加速器

- 可接受

- ACCESS

- 访问

- 无障碍

- 横过

- 积极地

- 加

- 地址

- 解决

- 解决

- 调整

- 采用

- 高级

- 先进技术支持

- 进步

- 顾问

- 再次

- 向前

- AI

- AI模型

- 算法

- 算法交易

- 所有类型

- 分配

- 允许

- 几乎

- 还

- Amazon

- an

- 和

- 另一个

- 回答

- 任何

- 任何人

- 吸引人的

- 应用领域

- 的途径

- 任意地

- 架构

- 架构

- 保健

- 地区

- 围绕

- 人造的

- 人工智能

- AS

- 问

- 问

- 组装

- 评定

- 相关

- 惊人

- At

- 作者

- 自主性

- 可使用

- 背部

- 障碍

- 基于

- BE

- 因为

- 成为

- 很

- before

- 作为

- 信仰

- 相信

- 得益

- 最佳

- 更好

- 超越

- 大

- 亿

- 基于blockchain

- 板

- 身体

- 都

- 瓶颈

- 破坏

- 休息

- 扩大

- 建立

- 建筑物

- 建立

- 建

- 块

- 商业

- 商业模式

- 企业

- 但是

- by

- Cadence公司

- 呼叫

- 来了

- CAN

- 可以得到

- 能力

- 能力

- 资本

- 摔角

- Center

- CEO

- CEO访谈

- 当然

- 挑战

- 挑战

- 改变

- 机壳

- ChatGPT

- 便宜

- 清除

- 客户

- 气候

- 时钟

- 关闭

- 云端技术

- 云基础设施

- 联合创始人

- 码

- 合作

- 合作

- 未来

- 商业的

- 商业化

- 承诺

- 社体的一部分

- 公司

- 公司

- 相比

- 引人注目

- 编译

- 完全

- 组件

- 计算

- 一台

- 电脑

- 计算

- 信心

- 约束

- 消耗

- 继续

- 连续

- 贡献

- 汇集

- 谈话

- 对话

- 冷却系统

- 正确

- 价格

- 可以

- 课程

- 覆盖

- 中央处理器

- 创建信息图

- USB和Thunderbolt Cross

- 首席技术官

- 电流

- 目前

- 习俗

- 定制设计

- 顾客

- 合作伙伴

- data

- 数据中心

- 数据中心

- 天

- 十

- 决定

- 深

- 定义

- 交付

- 交货

- 需求

- 民主化

- 密度

- 部署

- 设计

- 设计

- 开发

- 发达

- 开发

- 发展

- 研发支持

- DID

- 不同

- 区分

- 副总经理

- 遥远

- 分配

- 多元化

- do

- 不

- 不会

- 做

- 美元

- 域

- 完成

- 别

- 门

- 显着

- 画

- 司机

- 驾驶

- 下降

- 动态

- 动态

- 每

- 此前

- 早

- 更容易

- 容易

- 经济

- 经济学

- 边缘

- 功效

- 效率

- 努力

- 工作的影响。

- 分子

- 强调

- 授权

- enable

- 使

- 包含

- 结束

- 能源

- 从事

- 发动机

- 提高

- 加强

- 确保

- 保证

- 整个

- 公平

- 公平

- 特别

- 等

- 终于

- 每个人

- 进化

- 超过

- 兴奋

- 令人兴奋的

- 现有

- 期望

- 昂贵

- 技术专家

- 勘探

- 探索

- 探讨

- 成倍

- 提取

- 异常地

- 事实

- 幻想

- 远

- 快

- 精选

- 感觉

- 毡

- 少数

- 找到最适合您的地方

- 姓氏:

- 漂浮的

- 专注焦点

- 重点

- 聚焦

- 遵循

- Footprint

- 针对

- 力

- 格式

- 向前

- 公司成立

- 创建

- 止

- 边疆

- 推动

- ,

- 全栈

- 充分

- 开玩笑

- 资金

- 未来

- 人工智能的未来

- Gain增益

- 获得

- 赌博

- 游戏平台

- 传动装置

- 其他咨询

- 通常

- 地域

- 得到

- 越来越

- 给

- 特定

- 给

- 目标

- 去

- 非常好

- 谷歌

- 得到了

- GPU

- 图形处理器

- 奠基

- 增长

- 民政事务总署

- 撮

- 处理

- 发生

- 发生

- 硬件

- 有

- 有

- he

- 帮助

- 此处

- 高

- 阻碍

- 他的

- 击中

- 打

- 抱有希望

- 创新中心

- How To

- HTTPS

- 黄

- 饥饿

- i

- if

- 想像

- 即时

- 影响力故事

- 重要

- 有声有色

- 改善

- 改进

- in

- 日益

- 行业中的应用:

- 效率低下

- 运筹学

- 基础设施

- 創新

- 房源搜索

- 打算

- 互联

- 兴趣

- 专属采访

- 介绍

- 投资

- 投资者

- 投资者

- 隔离

- IT

- 它的

- 詹森黄

- JPG

- 只是

- 保持

- 类

- 知道

- 实验室

- 实验室

- 景观

- 语言

- 大

- 大

- 名:

- 去年

- 潜伏

- 法律

- 领导者

- 领导

- 知道

- 最少

- 导致

- 让

- 喜欢

- ll

- LLM

- 长

- 长时间

- 不再

- 看

- 看着

- 寻找

- 占地

- 低

- 降低

- 机

- 机

- 制成

- 使

- 制作

- 制作

- 管理

- 许多

- 市场

- 市场领导者

- 数学

- 问题

- 最大宽度

- 最多

- 可能..

- me

- 手段

- 满足

- 成员

- 内存

- 提到

- 仅仅

- 网格

- 精心

- 指标

- 百万

- 最小

- 错误

- 模型

- 模型

- 现代

- 时刻

- 更多

- 最先进的

- 许多

- 多学科

- my

- 美国宇航局

- 需求

- 打印车票

- 需要

- 网络

- 神经

- 神经网络

- 全新

- 下页

- 没有

- 节点

- 节点

- 注意

- 概念

- 十一月

- 现在

- 核

- 数

- 数字

- of

- 提供

- on

- 一旦

- 一

- 仅由

- OpenAI

- 优化

- 优化

- 附加选项

- or

- 秩序

- 普通

- 其他名称

- 其它

- 我们的

- 我们自己

- 输出

- 推广

- 超过

- 大修

- 己

- 所有权

- 步伐

- 范例

- 并行

- 参数

- 部分

- 伙伴

- 部分

- 过去

- 径

- 铺

- 员工

- 性能

- 相控

- 挑

- 枢

- 地方

- 计划

- 平台

- 平台

- 柏拉图

- 柏拉图数据智能

- 柏拉图数据

- 加

- 点

- 观点

- 手提

- 位置

- 职位

- 积极

- 可能

- 帖子

- 潜力

- 可能

- 功率

- 强大

- 实用

- 漂亮

- 防止

- 主要

- 原则

- 市场问题

- 问题

- 处理

- 处理器

- 产品

- 生产

- 热销产品

- 曲目

- 代码编程

- 编程语言

- 项目

- 主张

- 前景

- 蛋白质

- 成熟

- 提供

- 供应商

- 国家

- 纯粹

- 目的

- 推动

- 查询

- 种族

- 赛车

- 提高

- 凸

- 提高

- 很少

- 阅读

- 真

- 原因

- 推荐

- 重新定义

- 重新设计

- 减少

- 指称

- 精

- 关于

- 重新想象

- 释放

- 发布

- 依靠

- 需要

- 资源

- 资源

- 责任

- REST的

- 结果

- 成果

- 零售

- 右

- 风险

- 冒险的

- 路线图

- 机器人

- 机器人

- 滚

- περίπου

- 圆

- 定位、竞价/采购和分析/优化数字媒体采购,但算法只不过是解决问题的操作和规则。

- 运行

- 牺牲

- 安全

- 说

- 同

- 保存

- 对工资盗窃

- 说

- 可扩展性

- 鳞片

- 缩放

- 始你

- 预定

- 看到

- 种子

- 种子资金

- 种子轮

- 寻找

- 似乎

- 看到

- 可选择的

- 半导体

- 感

- 系列

- A系列

- 服务

- 已服务

- 服务

- 服务供应商

- 集

- 几个

- 成型

- 转移

- 应该

- 陈列宣传

- 风景名胜

- 显著

- 表示

- 硅

- 模拟

- 模拟

- 模拟器

- 同时

- 自

- 单

- 可观

- 滑

- 小

- So

- 社会

- 软件

- 方案,

- 解决方案

- 解决

- 解决

- 解决

- 一些

- 听起来

- 声音

- 太空

- 太空探索

- 空间的

- 具体的

- 特别是

- 速度

- 速度

- 堆

- 堆栈

- 惊人的

- 开始

- 开始

- 启动

- 初创企业

- 仍

- Stop 停止

- 策略

- 进步

- 强烈

- 奋斗的

- 成功

- 这样

- 合适的

- 总和

- SUPPORT

- 支持

- 应该

- 惊

- 可持续发展

- 系统

- 系统的

- 产品

- 量身定制

- 采取

- 需要

- 服用

- 谈论

- 胶带

- 目标

- 目标

- 团队

- 科技

- 专业技术

- 比

- 这

- 未来

- 景观

- 世界

- 其

- 他们

- 然后

- 那里。

- 热

- 博曼

- 他们

- 事

- 认为

- Free Introduction

- 那些

- 虽然?

- 千

- 通过

- 吞吐量

- 次

- 轮胎

- 至

- 今晚

- 一起

- 也有

- 了

- 合计

- 强硬

- 向

- 跟踪时

- 交易

- 培训

- 产品培训

- 轨道

- 变革

- 过渡

- 转换

- 趋势

- 招

- true

- 真正

- 尝试

- 二

- 类型

- 下

- 理解

- 单元

- 解锁

- 上

- us

- 使用

- 运用

- 验证

- 折扣值

- 各个

- VC

- VC资金

- 风险投资

- 非常

- 通过

- 可行

- 查看

- 愿景

- 等待

- 想

- 仓库保管

- 是

- we

- 重量

- 井

- 定义明确

- 去

- 为

- 什么是

- ,尤其是

- 是否

- 这

- 而

- 为什么

- 将

- 也完全不需要

- 话

- 工作

- 工作流程

- 加工

- 合作

- 世界

- 世界

- 将

- 年

- 年

- 含

- 您

- 您一站式解决方案

- 和风网