法学硕士发展的最新进展已经普及了它们在各种 NLP 任务中的应用,而这些任务以前是使用旧的机器学习方法来解决的。 大型语言模型能够解决各种语言问题,例如分类、摘要、信息检索、内容创建、问答和维持对话 - 所有这些都仅使用一个模型。 但我们如何知道他们在所有这些不同的任务上都做得很好呢?

法学硕士的兴起暴露了一个尚未解决的问题:我们没有可靠的标准来评估它们。 使评估变得更加困难的是,它们用于高度多样化的任务,而我们对于每个用例的最佳答案缺乏明确的定义。

本文讨论了评估法学硕士的当前方法,并介绍了一个新的法学硕士排行榜,该排行榜利用人工评估来改进现有的评估技术。

第一种也是通常的初始评估形式是在几个精选数据集上运行模型并检查其性能。 HuggingFace 创建了一个 打开 LLM 排行榜 其中使用四个众所周知的数据集评估开放访问大型模型(AI2推理挑战赛 , 海拉斯瓦格 , 百万美元 , 真实质量保证)。 这对应于自动评估并检查模型获取某些特定问题的事实的能力。

这是一个问题的例子 百万美元 数据集。

主题:大学医学

问题:补充肌酸的预期副作用是。

- A) 肌肉无力

- B) 体重增加

- C) 肌肉痉挛

- D.电解质的损失

答案:(B)

在回答此类问题时对模型进行评分是一个重要的指标,并且非常适合事实检查,但它并不能测试模型的生成能力。 这可能是这种评估方法的最大缺点,因为生成自由文本是法学硕士最重要的特征之一。

社区内似乎达成了共识,即为了正确评估模型,我们需要人工评估。 这通常是通过比较不同模型的响应来完成的。

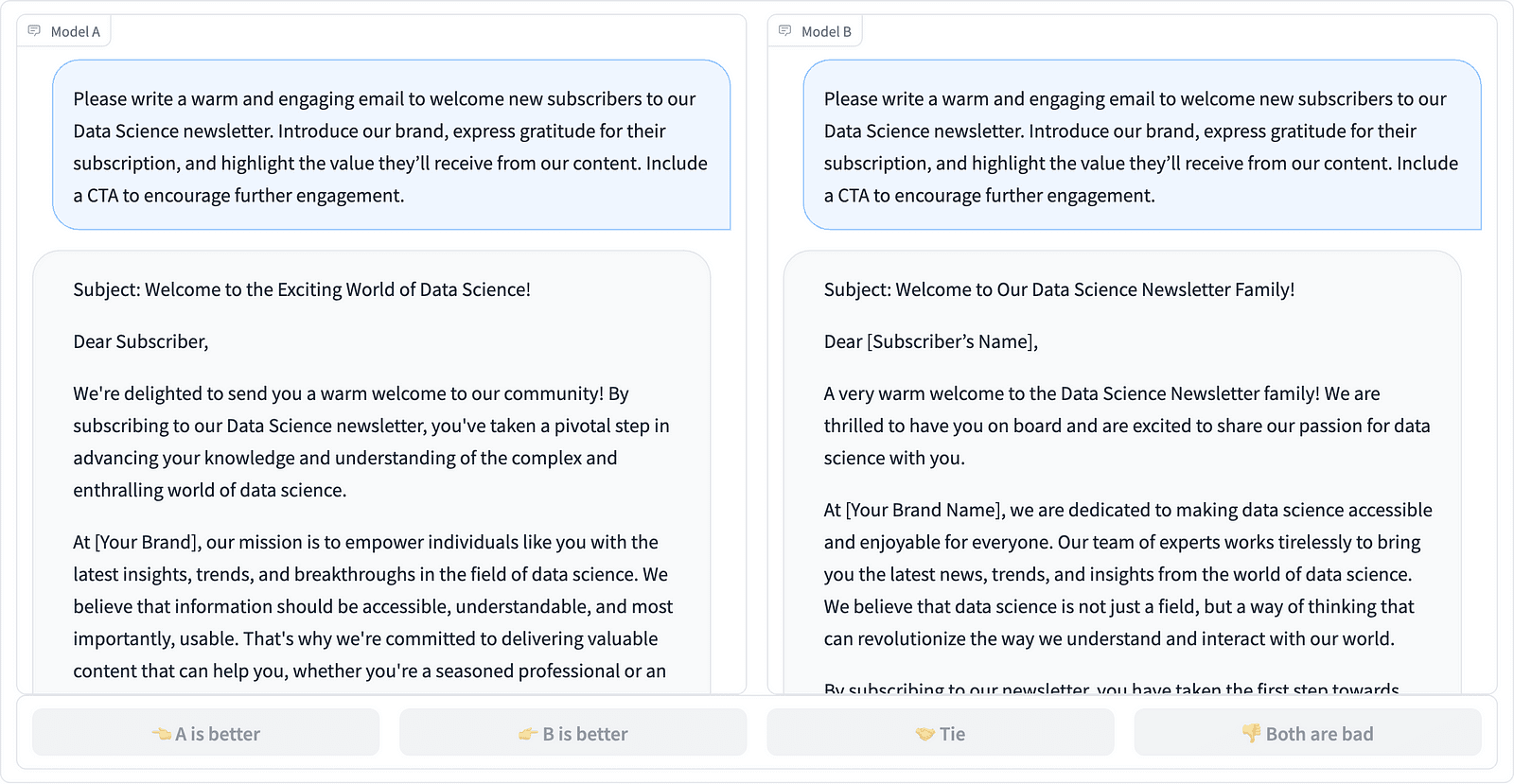

比较 LMSYS 项目中的两个提示完成 – 作者的屏幕截图

注释者决定哪个响应更好,如上面的示例所示,有时还会量化提示完成的质量差异。 LMSYS 组织创建了一个 排行榜 使用这种类型的人类评估并比较 17 种不同的模型,报告 Elo等级 对于每个型号。

由于人类评估很难规模化,因此人们一直在努力扩大规模并加快评估过程,这导致了一个有趣的项目,称为 羊驼毛评估。 这里将每个模型与基线(GPT-003 提供的 text-davinci-4)进行比较,并将人工评估替换为 GPT-4 判断。 这确实是快速且可扩展的,但是我们可以信任这里的模型来执行评分吗? 我们需要意识到模型偏差。 该项目实际上表明 GPT-4 可能更喜欢更长的答案。

随着人工智能社区寻求简单、公平和可扩展的方法,法学硕士评估方法正在不断发展。 Toloka 团队的最新开发成果是 排行榜 进一步推进现行评价标准。

新的 排行榜 将模型响应与现实世界的用户提示进行比较,这些提示按有用的 NLP 任务进行分类,如 这篇 InstructGPT 论文。 它还显示了每个模型在所有类别中的总体胜率。

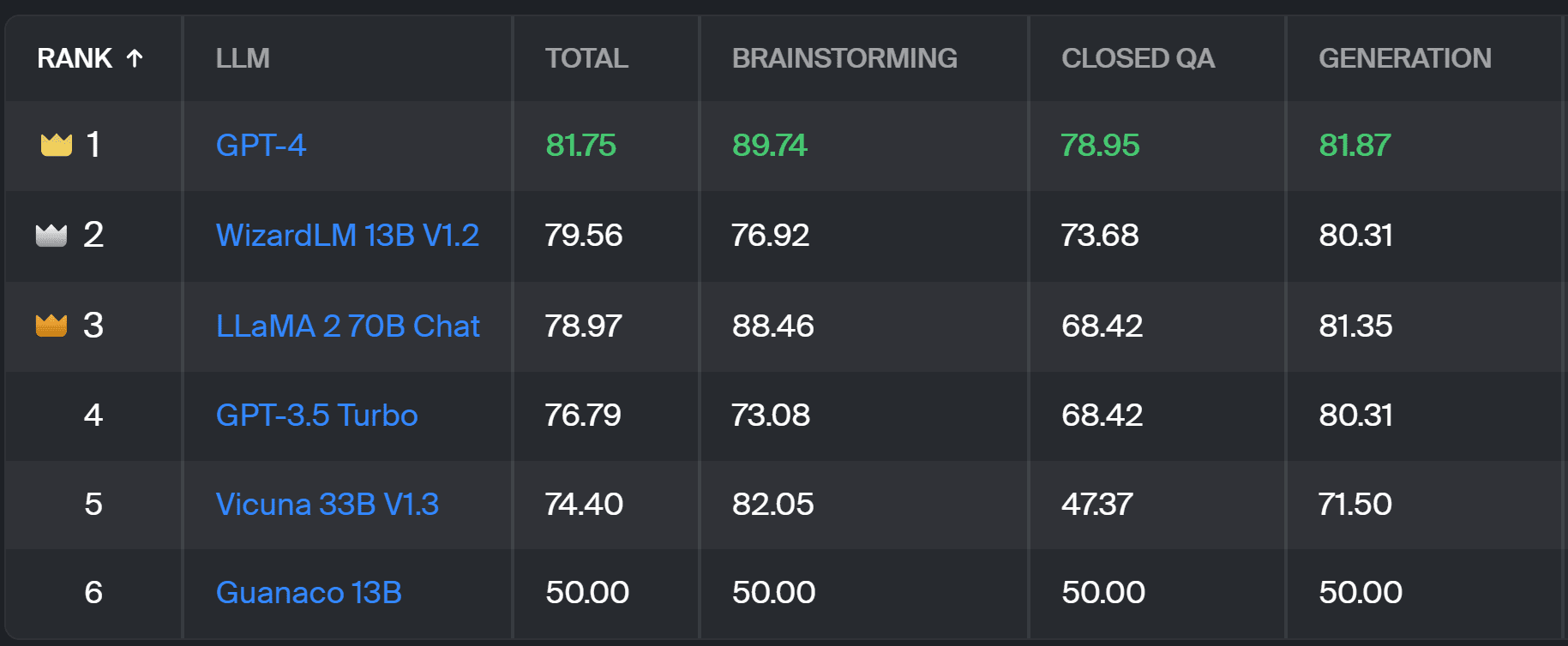

Toloka 排行榜 – 作者截图

该项目使用的评估与 AlpacaEval 中执行的评估类似。 排行榜上的分数代表了相应模型与其他模型相比的胜率 原驼13B 模型,此处用作基线比较。 Guanaco 13B 的选择是对 AlpacaEval 方法的改进,该方法使用即将过时的 text-davinci-003 模型作为基线。

实际评估是由人类专家注释者根据一组现实世界的提示完成的。 对于每个提示,注释者都会得到两种补全,并询问他们更喜欢哪一种。 您可以找到有关该方法的详细信息 相关信息.

这种类型的人工评估比任何其他自动评估方法都更有用,并且应该改进用于以下方面的人工评估: LMSYS 排行榜。 LMSYS 方法的缺点是任何人 链接 可以参与评估,从而对以这种方式收集的数据的质量提出严重质疑。 封闭的专家注释者群体更有可能获得可靠的结果,Toloka 应用额外的质量控制技术来确保数据质量。

在本文中,我们介绍了一种有前途的评估法学硕士的新解决方案——Toloka 排行榜。 该方法具有创新性,结合了现有方法的优点,增加了特定于任务的粒度,并使用可靠的人工注释技术来比较模型。

探索该板,并与我们分享您的意见和改进建议。

玛格达莱娜·康凯维奇 是 Toloka 的数据传播者,Toloka 是一家支持快速、可扩展的人工智能开发的全球公司。 她拥有爱丁堡大学人工智能硕士学位,曾在欧美企业担任 NLP 工程师、开发人员和数据科学家。 她还参与教学和指导数据科学家,并定期为数据科学和机器学习出版物撰稿。

- SEO 支持的内容和 PR 分发。 今天得到放大。

- PlatoData.Network 垂直生成人工智能。 赋予自己力量。 访问这里。

- 柏拉图爱流。 Web3 智能。 知识放大。 访问这里。

- 柏拉图ESG。 碳, 清洁科技, 能源, 环境, 太阳能, 废物管理。 访问这里。

- 柏拉图健康。 生物技术和临床试验情报。 访问这里。

- Sumber: https://www.kdnuggets.com/a-better-way-to-evaluate-llms?utm_source=rss&utm_medium=rss&utm_campaign=a-better-way-to-evaluate-llms

- :具有

- :是

- :不是

- :在哪里

- $UP

- 17

- a

- 对,能力--

- 关于

- 以上

- 横过

- 实际

- 通

- 额外

- 添加

- 推进

- 进步

- AI

- 所有类型

- 还

- 美国

- an

- 和

- 回答

- 答案

- 任何

- 适用

- 的途径

- 方法

- 保健

- 竞技场

- 刊文

- 人造的

- 人工智能

- AS

- At

- 自动表

- 察觉

- b

- 底线

- BE

- 因为

- 很

- 更好

- 偏见

- 最大

- 板

- 身体

- 带

- 企业

- 但是

- by

- CAN

- 能力

- 案件

- 类别

- 挑战

- 支票

- 选择

- 分类

- 清除

- 关闭

- 结合

- 购买的订单均

- 社体的一部分

- 公司

- 比较

- 相比

- 比较

- 对照

- 共识

- 内容

- 内容创造

- 继续

- 有助于

- 控制

- 谈话

- 对应

- 创建

- 创建

- 人群

- 策划

- 电流

- data

- 数据质量

- 数据科学

- 数据科学家

- 数据集

- 决定

- 定义

- 学位

- 详情

- 开发商

- 研发支持

- 差异

- 不同

- 坏处

- 不同

- do

- 不

- 做

- 完成

- 别

- 缺点

- 每

- 易

- 爱丁堡

- 效果

- 工作的影响。

- 电解质

- 工程师

- 确保

- 欧洲

- 评估

- 评估

- 评估

- 评估

- 传播者

- 发展

- 检查

- 例子

- 现有

- 预期

- 技术专家

- 正确

- 公平

- 高效率

- 赞成

- 特征

- 找到最适合您的地方

- 姓氏:

- 针对

- 申请

- 四

- Free

- 止

- 进一步

- Gain增益

- 云集

- 发电

- 生成的

- 得到

- GitHub上

- 特定

- 全球

- 非常好

- 好工作

- 硬

- 更难

- 有

- 相关信息

- 高度

- 持有

- 创新中心

- HTTPS

- 拥抱脸

- 人

- 重要

- 改善

- 改进

- 改善

- 提高

- in

- 信息

- 初始

- 创新

- 房源搜索

- 有趣

- 介绍

- 推出

- 参与

- IT

- 它的

- 工作

- 只是

- 只有一个

- 掘金队

- 知道

- 缺乏

- 语言

- 大

- 最新

- 学习

- 借力

- 光

- 不再

- 离

- 机

- 机器学习

- 维持

- 制作

- 方式

- 质量

- 主

- 可能..

- 师徒

- 方法

- 研究方法

- 方法

- 公

- 模型

- 模型

- 更多

- 最先进的

- 肌肉

- 需求

- 全新

- 新解决方案

- NLP

- of

- 老年人

- on

- 一

- 打开

- 意见

- 其他名称

- 概述

- 最划算

- 部分

- 演出

- 性能

- 执行

- 柏拉图

- 柏拉图数据智能

- 柏拉图数据

- 潜力

- 比较喜欢

- 先前

- 大概

- 市场问题

- 问题

- 过程

- 项目

- 有希望

- 提示

- 正确

- 提供

- 出版物

- 质量

- 题

- 有疑问吗?

- 提高

- 率

- 真实的世界

- 经常

- 可靠

- 更换

- 报告

- 代表

- 那些

- 响应

- 回复

- 结果

- 成果

- 上升

- 运行

- s

- 可扩展性

- 鳞片

- 科学

- 科学家

- 科学家

- 分数

- 得分

- 搜索

- 似乎

- 看到

- 严重

- 服务

- 集

- 几个

- Share

- 她

- 应该

- 如图

- 作品

- 侧

- 类似

- 单

- 方案,

- 解决

- 一些

- 有时

- 具体的

- 速度

- 标准

- 标准

- 优势

- 这样

- 支持

- 采取

- 任务

- 教诲

- 团队

- 技术

- test

- 文本

- 比

- 这

- 其

- 他们

- 那里。

- 博曼

- 他们

- Free Introduction

- 至

- 信任

- 二

- 类型

- 一般

- 大学

- 上

- us

- 用法

- 使用

- 用例

- 用过的

- 用户

- 使用

- 运用

- 通常

- 各种

- 方法..

- we

- 虚弱

- 井

- 知名

- 为

- 什么是

- 什么是

- 这

- 赢

- 中

- 工作

- 您

- 您一站式解决方案

- 和风网