澳大利亚的研究人员正在为盲人开发智能眼镜,利用一种名为“声学触摸”的技术将图像转化为声音。初步实验表明,这种可穿戴空间音频技术可以帮助盲人或视力严重受损的人定位附近的物体。

增强现实、实用的可穿戴相机技术和基于深度学习的计算机视觉的最新改进正在加速智能眼镜的发展,使其成为盲人或弱视人士的可行的多功能辅助技术。此类智能眼镜集成了摄像头、GPS 系统、麦克风以及惯性测量和深度传感单元,可提供导航、语音识别控制或将对象、文本或周围环境呈现为计算机合成语音等功能。

朱豪远 和悉尼科技大学的同事(UTS)和 悉尼大学 研究了在智能眼镜中添加声学触摸的方法,这种方法使用头部扫描并在物体出现在定义的视场(FOV)内时激活听觉图标。

写入 PLoS ONE的研究人员解释说,声学触摸比现有方法具有多种优势,包括易于与智能眼镜技术集成以及比计算机合成语音更直观的使用。这样的系统也可能需要较少的培训来让用户变得熟练。

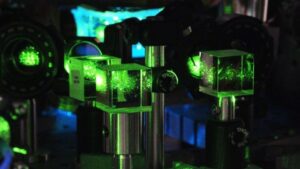

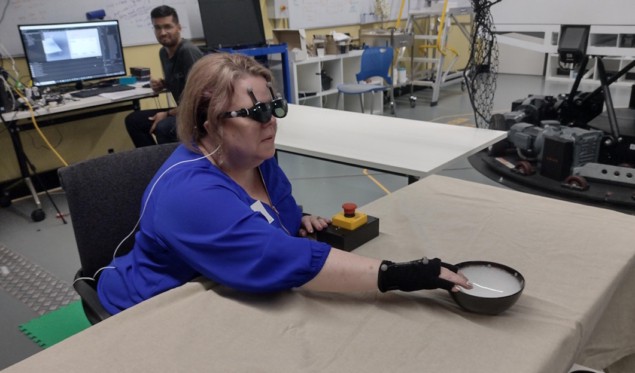

与悉尼 ARIA Research 合作(最近荣获 年度澳大利亚科技公司 为了表彰其开创性的视觉技术创新),该团队创建了一个中央凹音频设备(FAD),在七名无视力或弱视的志愿者以及七名视力正常的蒙眼参与者身上测试这些假设。 FAD 由智能手机和 NREAL 增强现实眼镜组成,团队在眼镜上附加了动作捕捉反射标记,以跟踪头部运动。

FAD 使用眼镜上的立体摄像头执行物体识别并确定物体的距离。然后,它为对象分配适当的听觉图标,例如书籍的翻页声音。当佩戴者旋转头部时,听觉图标的重复率会根据项目在听觉视野内的位置而变化。

志愿者们参加了坐式和站式练习。坐着的任务要求他们使用各种方法来寻找和处理日常物品,包括放置在一张或多张桌子上的书、瓶子、碗或杯子。这项任务测量了他们检测物品、识别声音和记住物品位置的能力。

研究人员设计这个任务是为了将 FAD 的表现与两种传统的语音提示进行比较:钟面口头指示;以及从与每个项目位于同一位置的扬声器顺序播放听觉图标。他们发现,对于盲人或低视力参与者来说,使用 FAD 的表现与两种理想条件相当。然而,蒙眼视力组在使用 FAD 时表现较差。

大脑植入使盲人妇女能够看到简单的形状

站立伸手任务要求参与者使用 FAD 搜索并伸手位于多个干扰项中的目标项。参与者被要求找到放置在三张桌子上的物体,桌子周围有四个不同形状的瓶子。该任务主要评估系统的功能性能以及搜索过程中使用全身运动时的人类行为。

“今年,我们一直在大力探索使用听觉音景来支持各种复杂的任务,”朱告诉 物理世界。 “特别是,我们探索了使用不同类型的空间声音来引导人们导航并支持体育活动,特别是乒乓球。明年,我们希望继续扩大这些领域,并在现实环境中进行研究。”

- :是

- 90

- a

- 对,能力--

- 加速

- 根据

- 声

- 活化

- 活动

- 增加

- 优点

- 还

- 其中

- an

- 和

- 出现

- 的途径

- 方法

- 适当

- 保健

- 地区

- 咏叹调

- AS

- 评估

- 假设

- At

- 音频

- 音频技术

- 增强

- 增强现实技术

- 澳大利亚

- 成为

- 很

- 行为

- 盲人

- 书

- 都

- by

- 被称为

- 相机

- 相机

- 更改

- 同事

- COM的

- 公司

- 可比

- 比较

- 复杂

- 包含

- 一台

- 计算机视觉

- 条件

- 进行

- 继续

- 控制

- 常规

- 可以

- 创建

- 杯

- 深

- 定义

- 交付

- 深度

- 设计

- 检测

- 确定

- 发展

- 研发支持

- 设备

- 不同

- 方向

- 距离

- ,我们将参加

- 每

- 缓解

- enable

- 使

- 日常

- 例子

- 现有

- 扩大

- 实验

- 说明

- 探讨

- 探索

- 找到最适合您的地方

- 针对

- 发现

- 四

- 止

- 实用

- 功能

- 眼镜

- GPS

- 团队

- 指南

- 处理

- 有

- 头

- 严重

- 帮助

- 帮助

- 抱有希望

- 但是

- HTTPS

- 人

- 图标

- 图片

- 图片

- 改善

- in

- 包含

- 合并

- 信息

- 初始

- 创新

- 积分

- 成

- 直观的

- 问题

- IT

- 项目

- 它的

- JPG

- 实验室

- 减

- 低

- 最大宽度

- 可能..

- 测量

- 数据监测

- 会员

- 方法

- 麦克风

- 杂

- 混合的现实

- 更多

- 运动

- 运动

- 运动

- 多

- 旅游导航

- 全新

- 下页

- 没有

- 虚幻

- 对象

- 对象

- of

- 优惠精选

- on

- 一

- or

- 超过

- 部分

- 与会者

- 特别

- 员工

- 性能

- 执行

- 施行

- 物理

- 物理世界

- 创举

- 放置

- 平台

- 柏拉图

- 柏拉图数据智能

- 柏拉图数据

- 播放

- 加

- 位置

- 定位的

- 实用

- 主要

- 率

- 达到

- 达

- 真实的世界

- 现实

- 最近

- 承认

- 承认

- 翻译

- 要求

- 必须

- 研究

- 研究人员

- 扫描

- 搜索

- 搜索

- 看到

- 设置

- XNUMX所

- 几个

- 形状

- 显著

- 简易

- 位于

- 智能

- 智能眼镜

- 智能手机

- 听起来

- 空间的

- 音箱

- 特别是

- 言语

- 地位

- 研究

- 这样

- 建议

- SUPPORT

- 支持

- 包围

- 悉尼

- 系统

- 产品

- 表

- 目标

- 任务

- 任务

- 团队

- 专业技术

- 告诉

- 网球

- test

- 文本

- 比

- 这

- 其

- 他们

- 然后

- 博曼

- 他们

- Free Introduction

- 那些

- 三

- 缩略图

- 至

- 了

- 触摸

- 跟踪

- 产品培训

- true

- 转

- 二

- 类型

- 单位

- 大学

- 使用

- 用户

- 使用

- 运用

- 各个

- 可行

- 愿景

- 音色

- 语音识别

- 志愿者

- 是

- we

- 耐磨

- 为

- ,尤其是

- 这

- WHO

- 中

- 女子

- 韩元

- 世界

- 更坏

- 年

- 元

- 和风网