使用中途生成

全球各个行业和各个角落的企业都在争先恐后地整合 OpenAI 的 ChatGPT、Anthropic 的 Claude 和 AI12Lab 的 Jurassic 等大型语言模型 (LLM) 的强大功能,以提高市场研究、客户服务等各种业务应用的性能和内容生成。

然而,与构建传统的机器学习 (ML) 应用程序相比,在企业规模构建 LLM 应用程序需要不同的工具集和理解。 想要保持品牌影响力和可靠服务质量的企业领导者和高管需要更深入地了解法学硕士的工作方式以及法学硕士申请堆栈中各种工具的优缺点。

在本文中,我们将向您简要介绍为您的企业构建和运行法学硕士申请所需的高级策略和工具。

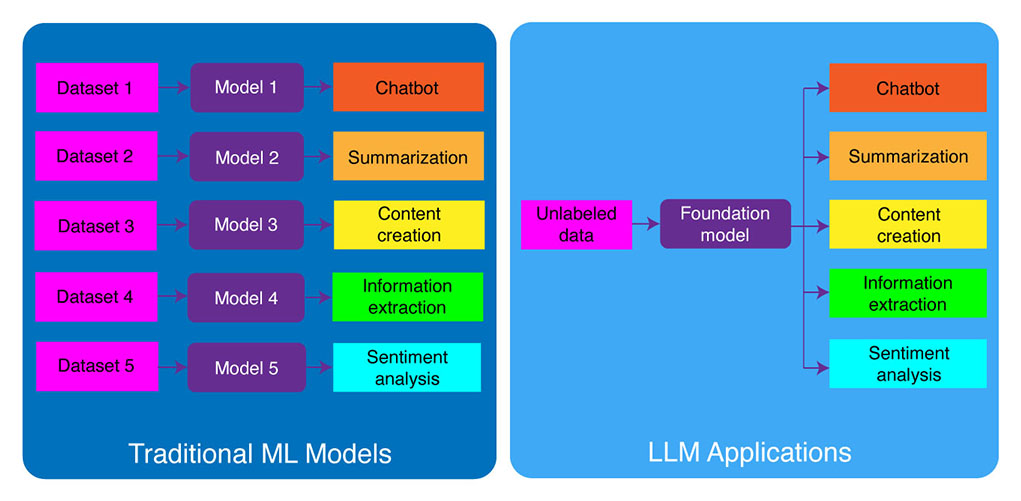

传统 ML 开发与 LLM 应用程序

传统的机器学习模型是特定于任务的,这意味着您需要为每个不同的任务构建单独的模型。 例如,如果您想分析客户情绪,则需要构建一个模型,如果您想构建客户支持聊天机器人,则需要构建另一个模型。

构建和训练特定任务的机器学习模型的过程非常耗时,并且需要大量数据。 训练这些不同的机器学习模型所需的数据集类型也会根据任务的不同而有所不同。 要训练模型来分析客户情绪,您需要一个已标记有相应情绪(正面、负面、中性)的客户评论数据集。 要训练模型来构建客户支持聊天机器人,您需要客户和技术支持之间的对话数据集。

大型语言模型改变了这一点。 法学硕士在大量文本和代码数据集上进行了预训练,这使他们能够在开箱即用的各种任务上表现良好,包括:

- 文本摘要

- 内容创建

- 翻译

- 信息提取

- 问题回答

- 情绪分析

- 客户支援

- 销售支持

开发LLM申请的过程可以分为四个基本步骤:

- 选择合适的基础型号。 它是一个关键组件,定义了 LLM 申请的性能。

- 如有必要,定制模型。 您可能需要微调模型或使用额外的知识库对其进行扩充,以满足您的特定需求。

- 设置机器学习基础设施。 这包括运行应用程序所需的硬件和软件(即半导体、芯片、云托管、推理和部署)。

- 使用附加工具增强您的应用程序。 这些工具可以帮助提高应用程序的效率、性能和安全性。

现在,我们来看看对应的技术栈。

如果这些深入的教育内容对您有用, 订阅我们的 AI 邮件列表 当我们发布新材料时被提醒。

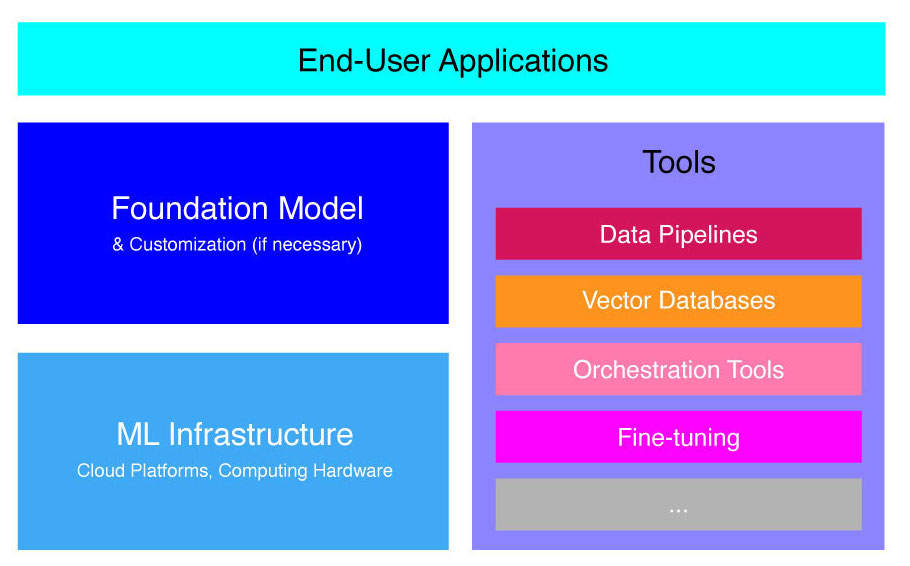

高级法学硕士申请堆栈

LLM 应用程序建立在几个关键组件之上,包括:

- 基础模型,这可能需要在特定用例中进行定制。

- 机器学习基础设施 通过云平台或公司自有硬件获取足够的计算资源。

- 其他工具,例如数据管道、向量数据库、编排工具、微调ML平台、模型性能监控工具等。

我们将简要引导您完成这些组件,以便您可以更好地了解构建和部署 LLM 应用程序所需的工具包。

什么是基础模型?

使用单一预训练的法学硕士可以为您节省大量时间和资源。 然而,从头开始训练这样的模型是一个及时且成本高昂的过程,除了少数精英技术领导者之外,这超出了大多数公司的能力。

一些公司和研究团队已经训练了这些模型并允许其他公司使用它们。 主要示例包括 ChatGPT、Claude、Llama、Jurassic 和 T5。 这些面向公众的模型称为基础模型。 其中一些是专有的,可以通过 API 调用付费访问。 其他的是开源的,可以免费使用。 这些模型在大量未标记文本数据的数据集上进行了预先训练,使它们能够执行各种任务,从生成创意广告副本到代表公司用客户的母语与客户进行沟通。

基础模型主要有两种类型:专有模型和开源模型。

专有型号 由单个公司或组织拥有,通常仅收费。 一些最流行的专有模型示例包括 OpenAI 的 GPT 模型、Anthropic 的 Claude 模型以及 AI21 Labs 的 Jurassic 模型。

开源模型 通常任何想要使用它们的人都可以免费使用。 然而,一些开源模型在使用上存在局限性,例如:(1)只能用于研究目的,(2)只能供一定规模的公司商业使用。 开源社区声称,施加此类限制并不能让模型获得“开源”资格。 尽管如此,可免费使用的语言模型的最著名例子包括 Meta 的 Llama 模型、阿布扎比技术创新研究所的 Falcon 模型以及 Stability AI 的 StableLM 模型。 阅读有关开源模型和相关风险的更多信息 相关信息.

现在让我们讨论一下为您的法学硕士申请选择基础模型时需要考虑的几个因素。

选择基础型号

为您的 LLM 申请选择最佳的基础模型可能是一个具有挑战性的过程,但我们基本上可以将其分为三个步骤:

- 在专有模型和开源模型之间进行选择。 专有模型通常比开源模型更大、能力更强,但使用成本更高且灵活性较差。 此外,代码不那么透明,这使得调试或解决专有模型性能问题变得困难。 另一方面,开源模型通常获得的更新较少,开发人员的支持也较少。

- 选择模型的尺寸。 较大的模型通常更适合执行需要大量知识的任务,例如回答问题或生成创意文本。 然而,较大的模型使用时的计算成本也更高。 您可以先尝试较大的模型,然后再尝试较小的模型,只要模型的性能满足您的用例即可。

- 选择特定型号。 您可以首先查看一般基准来筛选要测试的模型。 然后,继续针对特定于应用程序的任务测试不同的模型。 对于自定义基准测试,请考虑计算 BLEU 和 ROUGE 分数,这些指标有助于量化人工智能生成的文本在发布人机交互应用程序的输出之前所需的纠正次数。

为了更好地理解各种语言模型之间的差异,请查看 我们对最强大的语言 (LLM) 和视觉语言模型 (VLM) 的概述.

为应用程序选择基础模型后,您可以考虑是否需要自定义模型以获得更好的性能。

定制基础模型

在某些情况下,您可能需要自定义基础语言模型,以便在特定用例中获得更好的性能。 例如,您可能想要针对某些进行优化:

- 域名。 如果您在特定领域(例如法律、金融或医疗保健)开展业务,您可能希望丰富该领域的模型词汇表,以便它可以更好地理解和响应最终用户的查询。

- 任务。 例如,如果您希望模型生成营销活动,您可以为其提供品牌营销内容的具体示例。 这将帮助模型学习适合您的公司和受众的模式和风格。

- 说话的语气。 如果您需要模型使用特定的语气,您可以在包含目标语言样本示例的数据集上自定义模型。

定制基础语言模型有以下三种可能的方法:

- 微调:为模型提供约 100-500 条记录的特定领域标记数据集。 模型权重已更新,这应该会导致该数据集表示的任务具有更好的性能。

- 领域适应:为模型提供特定领域的未标记数据集,其中包含来自相应领域的大量数据。 在这种情况下,模型权重也会更新。

- 信息检索:用闭域知识增强基础模型。 模型不会重新训练,模型权重保持不变。 但是,模型可以从包含相关数据的矢量数据库中检索信息。

前两种方法需要大量的计算资源来重新训练模型,这通常只适用于拥有适当技术人才来管理定制的大公司。 较小的公司通常使用更常见的方法,即通过向量数据库用领域知识增强模型,我们将在本文后面的 LLM 工具部分详细介绍这一点。

设置机器学习基础设施

LLMOps 环境的 ML 基础设施组件包括云平台、计算硬件以及部署和运行 LLM 所需的其他资源。 如果您选择使用开源模型或为您的应用程序自定义模型,则此组件尤其相关。 在这种情况下,您可能需要大量计算资源来微调模型(如有必要)并运行它。

有许多云平台提供部署 LLM 的服务,包括 Google Cloud Platform、Amazon Web Services 和 Microsoft Azure。 这些平台提供了许多可以轻松部署和运行 LLM 的功能,包括:

- 可针对您的特定应用进行微调的预训练模型

- 负责底层硬件和软件的托管基础设施

- 用于监控和调试法学硕士的工具和服务

您需要的计算资源量取决于模型的大小和复杂性、您希望模型执行的任务以及您想要部署该模型的业务活动的规模。

使用工具增强

可以使用其他 LLM 相邻工具来进一步提高 LLM 申请的性能。

数据管道

如果您需要在法学硕士产品中使用数据,那么数据预处理管道将成为新技术堆栈的重要支柱,就像传统的企业人工智能堆栈一样。 这些工具包括用于从任何源获取数据的连接器、数据转换层和下游连接器。 领先的数据管道提供商(例如 Databricks 和 Snowflake)以及新的参与者(例如 Unstructed)使开发人员可以轻松指向大型且高度异构的自然语言数据语料库(例如,数千个 PDF、PowerPoint 演示文稿、聊天日志、抓取的 HTML、等)到单个访问点,甚至到单个文档,可供 LLM 应用程序进一步使用。

矢量数据库

大型语言模型仅限于一次处理几千个单词,因此它们无法自行有效地处理大型文档。 为了利用大型文档的力量,企业需要使用矢量数据库。

矢量数据库是一种存储系统,可将通过数据管道接收的大型文档转换为可管理的矢量或嵌入。 然后,法学硕士应用程序可以查询这些数据库以查明正确的向量,仅提取必要的信息块。

目前可用的一些最著名的载体数据库是 Pinecone、Chroma 和 Weaviate。

编排工具

当用户向 LLM 应用程序提交查询(例如客户服务问题)时,应用程序需要构建一系列提示,然后再将此查询提交到语言模型。 对语言模型的最终请求通常由开发人员硬编码的提示模板、称为少样本示例的有效输出示例、从外部 API 检索到的任何必要信息以及从向量数据库检索到的一组相关文档组成。 LangChain 或 LlamaIndex 等公司的编排工具可以通过提供用于管理和执行提示的即用型框架来帮助简化此流程。

微调

在海量数据集上训练的大型语言模型可以生成语法正确且流畅的文本。 然而,它们在某些领域可能缺乏精确性,例如医学或法律。 在特定领域的数据集上微调这些模型,使它们能够内化这些领域的独特特征,从而增强生成相关文本的能力。

对于小公司来说,微调法学硕士可能是一个成本密集的过程。 然而,Weights & Biases 和 OctoML 等公司的解决方案可以帮助简化和高效的微调。 这些解决方案为公司提供了一个调整法学硕士的平台,而无需投资自己的基础设施。

其它工具

还有许多其他工具可用于构建和运行 LLM 应用程序。 例如,如果您想使用特定数据样本微调模型,您可能需要标记工具。 您可能还需要部署特定的工具来监视应用程序的性能,因为即使基础模型的微小更改或客户的请求也会显着影响提示的性能。 最后,还有一些工具可以监控模型安全性,帮助您避免宣传仇恨内容、危险建议或偏见。 这些不同工具的必要性和重要性将取决于您的具体用例。

LLM 申请开发的下一步是什么?

我们在此讨论的法学硕士产品开发的四个步骤是任何利用大型语言模型的企业生成人工智能策略的重要基础。 即使您有一个实施细节的技术团队,理解它们对于非技术业务领导者也很重要。 我们将来将发布更详细的教程,介绍如何利用市场上各种生成式人工智能工具。 现在,您可以 订阅我们的新闻 以获取最新更新。

喜欢这篇文章吗? 注册以获取更多企业人工智能更新。

当我们发布更多像这样的摘要文章时,我们会通知您。

相关

- :是

- :不是

- :在哪里

- $UP

- 1

- a

- 对,能力--

- 关于

- 阿布扎比

- ACCESS

- 访问

- 活动

- Ad

- 额外

- 另外

- 邻

- AI

- AI战略

- 让

- 允许

- 允许

- 还

- Amazon

- 亚马逊网络服务

- 量

- an

- 分析

- 和

- 另一个

- 人类的

- 任何

- 任何人

- API

- APIs

- 应用领域

- 应用程序开发

- 应用领域

- 的途径

- 方法

- 适当

- 保健

- 地区

- 刊文

- 刊文

- AS

- 相关

- At

- 听众

- 可使用

- 避免

- Azure

- 基地

- 基本上

- BE

- 很

- before

- 代表

- 作为

- 标杆

- 基准

- 最佳

- 更好

- 之间

- 超越

- 偏见

- 促进

- 盒子

- 品牌

- 品牌

- 午休

- 简要地

- 破

- 建立

- 建筑物

- 建

- 商业

- 商业应用

- 商业领袖

- 企业

- 但是

- by

- 计算

- 被称为

- 呼叫

- 活动

- CAN

- 能力

- 能力

- 关心

- 案件

- 例

- 一定

- 挑战

- 变

- 更改

- 聊天机器人

- ChatGPT

- 查

- 碎屑

- 选择

- 选择

- 索赔

- 云端技术

- 云托管

- 云计算平台

- 码

- 商业的

- 相当常见

- 沟通

- 社体的一部分

- 公司

- 公司

- 公司的

- 复杂

- 元件

- 组件

- 由

- 计算

- 缺点

- 考虑

- 建设

- 包含

- 内容

- 对话

- 副本

- 角落

- 正确

- 矫正

- 相应

- 昂贵

- 创意奖学金

- 目前

- 习俗

- 顾客

- 客户服务

- 客户支持

- 合作伙伴

- 定制

- 定制

- 危险的

- data

- 数据库

- 数据库

- Databricks

- 数据集

- 更深

- 定义

- 根据

- 部署

- 部署

- 部署

- 细节

- 详细

- 详情

- 开发

- 开发商

- 开发

- 发展

- 研发支持

- 阿布扎比

- 差异

- 不同

- 难

- 讨论

- 讨论

- 文件

- 文件

- 不会

- 域

- 域名

- 向下

- e

- 每

- 易

- 教育的

- 只

- 效率

- 高效

- 精英

- 使

- 提高

- 加强

- 丰富

- 企业

- 特别

- 必要

- 等

- 醚(ETH)

- 甚至

- 所有的

- 例子

- 例子

- 除

- 执行

- 管理人员

- 昂贵

- 外部

- 因素

- 鹘

- 可行

- 特征

- 费

- 少数

- 少

- 最后

- 终于

- 金融

- 姓氏:

- 柔软

- 针对

- 基金会

- 四

- 框架

- Free

- 止

- 进一步

- 未来

- 其他咨询

- 生成

- 发电

- 代

- 生成的

- 生成式人工智能

- 得到

- 给

- 地球

- Go

- 去

- 谷歌

- 谷歌云

- 谷歌云平台

- 陆运

- 手

- 硬件

- 马具

- 有

- 有

- 医疗保健

- 帮助

- 相关信息

- 高水平

- 高度

- 托管

- 创新中心

- How To

- 但是

- HTML

- HTTPS

- i

- if

- 影响力故事

- 实施

- 重要性

- 重要

- 改善

- in

- 深入

- 包括

- 包括

- 包含

- 行业中的应用:

- 信息

- 基础设施

- 創新

- 研究所

- 整合

- 成

- 介绍

- 投资

- IT

- JPG

- 只是

- 键

- 类

- 知道

- 知识

- 标签

- 实验室

- 缺乏

- 景观

- 语言

- 大

- 大

- 后来

- 最新

- 最新更新

- 法律

- 层

- 领导人

- 领导

- 学习用品

- 学习

- 法律咨询

- 减

- 杠杆作用

- 杠杆

- 喜欢

- 限制

- 有限

- 骆驼

- 长

- 看

- 占地

- 机

- 机器学习

- 主要

- 使

- 制作

- 管理

- 管理的

- 许多

- 市场

- 市场调查

- 营销

- 营销活动

- 市场

- 大规模

- 材料

- 最大宽度

- 可能..

- 意

- 药物

- 满足

- 元

- 指标

- 微软

- 微软Azure

- 可能

- 未成年人

- ML

- 模型

- 模型

- 显示器

- 监控

- 更多

- 最先进的

- 最受欢迎的产品

- 本地人

- 自然

- 自然语言

- 必要

- 需求

- 打印车票

- 需要

- 负

- 一般

- 全新

- 新技术

- 订阅电子邮件

- 下页

- 非技术

- 现在

- 数

- of

- 提供

- on

- 一

- 那些

- 仅由

- 开放源码

- OpenAI

- 操作

- 优化

- or

- 管弦乐编曲

- 组织

- 其他名称

- 其它

- 我们的

- 输出

- 产量

- 简介

- 己

- 拥有

- 模式

- 演出

- 性能

- 执行

- 支柱

- 管道

- 平台

- 平台

- 柏拉图

- 柏拉图数据智能

- 柏拉图数据

- 球员

- 点

- 热门

- 积极

- 可能

- 功率

- 强大

- 平台精度

- 案例分享

- 问题

- 过程

- 处理

- 生产

- 产品

- 产品开发

- 突出

- 促进

- 所有权

- PROS

- 提供

- 供应商

- 提供

- 优

- 发布

- 目的

- 把

- 修饰

- 质量

- 查询

- 题

- 有疑问吗?

- 范围

- 阅读

- 接收

- 建议

- 记录

- 释放

- 释放

- 相应

- 可靠

- 代表

- 请求

- 要求

- 要求

- 需要

- 研究

- 资源

- 回应

- 限制

- 导致

- 回顾

- 评论

- 右

- 风险

- 运行

- 运行

- 实现安全

- 同

- 保存

- 鳞片

- 部分

- 保安

- 半导体

- 情绪

- 分开

- 系列

- 服务

- 特色服务

- 集

- 几个

- 应该

- 签署

- 显著

- 显著

- 单

- 尺寸

- 小

- 小

- So

- 软件

- 解决方案

- 一些

- 来源

- 具体的

- 稳定性

- 堆

- 开始

- 留

- 步骤

- 仍

- 存储

- 策略

- 精简

- 精简

- 风格

- 这样

- 足够

- 概要

- SUPPORT

- 产品

- 采取

- 需要

- 天赋

- 目标

- 任务

- 任务

- 团队

- 队

- 科技

- 文案

- 技术支持

- 专业技术

- 技术创新

- 模板

- 测试

- 比

- 这

- 未来

- 其

- 他们

- 然后

- 那里。

- 博曼

- 他们

- Free Introduction

- 那些

- 数千

- 三

- 通过

- 次

- 耗时的

- 至

- TONE

- 说话的语气

- 工具箱

- 工具

- 最佳

- 热门

- 传统

- 培训

- 熟练

- 产品培训

- 改造

- 转型

- 透明

- 教程

- 二

- 类型

- 一般

- 相关

- 理解

- 理解

- 独特

- 独特的功能

- 更新

- 最新动态

- 使用

- 用例

- 用过的

- 用户

- 平时

- 各个

- 通过

- 音色

- vs

- 想

- 通缉

- 希望

- 方法

- we

- 卷筒纸

- Web服务

- 井

- 为

- ,尤其是

- 是否

- 这

- WHO

- 宽

- 大范围

- 将

- 也完全不需要

- 话

- 工作

- 将

- 您

- 您一站式解决方案

- 和风网