کی طرف سے تصویر تیما میروشنیچینکو

ڈیپ فیکس کچھ سالوں سے ڈیٹا سائنس کمیونٹی میں گفتگو کا ایک بڑا موضوع رہا ہے۔ 2020 میں واپس، MIT ٹیکنالوجی کا جائزہ کہ گہری جعلی پوسٹ کی ان کے "مرکزی دھارے کے استعمال کے لئے ٹپنگ پوائنٹ" کو نشانہ بنایا تھا۔

ڈیٹا یقینی طور پر اس کی پشت پناہی کرتا ہے۔ دی وال سٹریٹ جرنل نے اطلاع دی ہے کہ 10,000 میں 2018 سے بھی کم ڈیپ فیکس آن لائن پائے گئے تھے۔ یہ تعداد اب لاکھوں میں پہنچ گئی ہے، اور ایسی بہت سی حقیقی مثالیں موجود ہیں جن کا استعمال غلط معلومات کو الجھانے اور مالیاتی دھوکہ دہی کو جاری رکھنے کے لیے کیا جاتا ہے۔

ڈیپ فیک تکنیک مکمل طور پر سائبر جرائم پیشہ افراد کو بہت سے نفیس اختیارات فراہم کر رہی ہیں۔

وہ "ناقابل قبول" بٹ کوائن پیشکش کے لیے پروموشنل مواد میں کسی مشہور شخصیت کی تصویر داخل کرنے کی صلاحیت سے کہیں آگے نکل جاتے ہیں، جو کہ یقیناً ایک گھوٹالہ ثابت ہوتا ہے۔ ڈیپ فیک ویڈیوز، خاص طور پر، دھوکہ بازوں کے ریڈار پر ہیں۔ وہ انہیں خودکار ID اور KYC چیک کے ذریعے حاصل کرنے کا طریقہ فراہم کرتے ہیں اور یہ خوفناک حد تک موثر ثابت ہوئے ہیں۔

مئی 2022 میں، جھگڑا اطلاع دی کہ "زندہ دلی کے ٹیسٹصارفین کی شناخت کی تصدیق میں مدد کے لیے بینکوں اور دیگر اداروں کے ذریعے استعمال کیا جاتا ہے جسے گہرے جعلیوں کے ذریعے آسانی سے بیوقوف بنایا جا سکتا ہے۔ متعلقہ مطالعہ سے پتہ چلا ہے کہ ٹیسٹ کیے گئے شناختی تصدیقی نظاموں میں سے 90 فیصد کمزور تھے۔

تو کیا جواب ہے؟ کیا ہم ایک ایسے دور میں داخل ہو رہے ہیں جہاں سائبر کرائمین مالیاتی اداروں کے ذریعے استعمال ہونے والے حفاظتی اقدامات کو پیچھے چھوڑنے کے لیے آسانی سے گہری جعلی ٹیکنالوجی کا استعمال کر سکتے ہیں؟ کیا ایسے کاروباروں کو اپنے خودکار نظاموں کو ختم کرنا پڑے گا اور دستی، انسانی جانچ پڑتال پر واپس جانا پڑے گا؟

سادہ جواب ہے "شاید نہیں"۔ جس طرح جرائم پیشہ افراد اس اضافے کا استعمال کر سکتے ہیں۔ AI کی ترقی، اسی طرح ان کمپنیوں کو بھی نشانہ بنایا جا سکتا ہے۔ آئیے اب دیکھتے ہیں کہ کس طرح کمزور کاروبار AI کے ساتھ AI کا مقابلہ کر سکتے ہیں۔

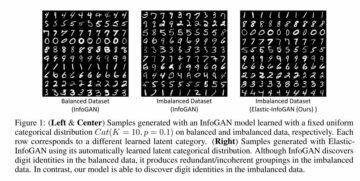

ڈیپ فیکس مصنوعی ذہانت کی متعدد تکنیکوں کا استعمال کرتے ہوئے تیار کیے جاتے ہیں، جیسے:

- جنریٹو ایڈورسریل نیٹ ورکس (GANs)

- انکوڈر/ڈیکوڈر جوڑے

- فرسٹ آرڈر موشن ماڈل

یہ تکنیکیں، اس کے چہرے پر، مشین لرننگ کمیونٹی کے خصوصی تحفظ کی طرح لگ سکتی ہیں، داخلے میں اعلیٰ رکاوٹوں اور ماہر تکنیکی علم کی ضرورت کے ساتھ مکمل۔ تاہم، AI کے دیگر عناصر کی طرح، وہ وقت کے ساتھ ساتھ کافی زیادہ قابل رسائی ہو گئے ہیں۔

کم لاگت والے، آف دی شیلف ٹولز اب غیر تکنیکی صارفین کو گہری جعلی تخلیق کرنے کی اجازت دیتے ہیں، بالکل اسی طرح جیسے کوئی بھی OpenAI میں سائن اپ کر سکتا ہے اور ChatGPT کی صلاحیتوں کی جانچ کر سکتا ہے۔

جیسا کہ حال ہی میں 2020 کے طور پر، ورلڈ اکنامک فورم نے رپورٹ کیا کہ "آرٹ کی حالتڈیپ فیک $30,000 سے کم ہے۔ لیکن 2023 میں، وارٹن اسکول کے پروفیسر ایتھن مولک نے، ایک وائرل ٹویٹر پوسٹ کے ذریعے انکشاف کیا کہ انہوں نے ایک گہری جعلی ویڈیو خود چھ منٹ سے کم وقت میں لیکچر دے رہے ہیں۔

مولک کا کل خرچ $10.99 تھا۔ اس نے اپنی آواز کی تقریباً مکمل نقل کرنے کے لیے ElevenLabs نامی سروس کا استعمال کیا، جس کی لاگت $5 ہے۔ ایک اور سروس جسے D-ID کہا جاتا ہے، ہر ماہ $5.99 پر، صرف ایک اسکرپٹ اور ایک تصویر کی بنیاد پر ایک ویڈیو تیار کرتا ہے۔ یہاں تک کہ اس نے اسکرپٹ خود بنانے کے لیے ChatGPT کا استعمال کیا۔

جب ڈیپ فیکس سب سے پہلے سامنے آنا شروع ہوئے، تو بنیادی توجہ جعلی سیاسی ویڈیوز (اور جعلی فحش نگاری) پر تھی۔ تب سے، دنیا نے دیکھا ہے:

- BuzzFeedVideos نے ایک گہرا جعلی عوامی خدمت کا اعلان تخلیق کیا ہے جس میں براک اوباما کی "خصوصیت" ہے، جس کی نقالی اداکار جارڈن پیلے نے کی ہے۔

- ایک گہری جعلی YouTube ویڈیو جس میں ڈونلڈ ٹرمپ کو ایک قطبی ہرن کے بارے میں کہانی سناتے ہوئے دکھایا گیا ہے۔

- ہیلری کلنٹن کی ایک گہری جعلی ویڈیو سنیچر نائٹ لائیو پر دکھائی گئی، جب وہ درحقیقت ایک کاسٹ ممبر کے ذریعے نقالی کر رہی تھیں۔

اگرچہ یہ مثالیں ڈیپ فیکس کا "مذاق" پہلو ظاہر کرتی ہیں، اور شاید ٹیکنالوجی کی صلاحیتوں کے بارے میں حقیقت کا جھٹکا دیتی ہیں، دھوکہ بازوں نے انہیں مذموم مقاصد کے لیے استعمال کرنے میں کوئی وقت ضائع نہیں کیا۔

دھوکہ دہی کی حقیقی زندگی کی مثالیں، ڈیپ فیک تکنیکوں کا استعمال کرتے ہوئے، بہت سی ہیں۔

گہرے جعلی گھوٹالوں کی وجہ سے ہونے والے نقصانات سینکڑوں ہزار سے کئی ملین تک ہوتے ہیں۔ 2021 میں، ایک AI وائس کلوننگ اسکینڈل کا استعمال $35 ملین کی جعلی بینک ٹرانسفر کا بندوبست کرنے کے لیے کیا گیا۔ یہ ایک بہت بڑا مالی معاوضہ تھا جو نہیں ہوا۔ کی ضرورت ویڈیو کا استعمال.

AI آؤٹ پٹ کا معیار، خاص طور پر ویڈیو، بہت زیادہ مختلف ہو سکتا ہے۔ کچھ ویڈیوز واضح طور پر انسانوں کے لیے جعلی ہیں۔ لیکن، جیسا کہ اوپر بتایا گیا ہے، خودکار نظام، جیسے کہ بینک اور فنٹیک استعمال کرتے ہیں، ماضی میں آسانی سے بے وقوف ثابت ہوئے ہیں۔

توازن مزید بدلنے کا امکان ہے کیونکہ AI کی صلاحیتیں بہتر ہوتی جارہی ہیں۔ ایک حالیہ پیشرفت "کاؤنٹر فرانزکس" کی شمولیت ہے، جہاں پتہ لگانے کے طریقہ کار کو بے وقوف بنانے کی کوشش میں، گہرے جعلیوں میں "ٹارگٹڈ پوشیدہ "شور" شامل کیا جاتا ہے۔

تو کیا کیا جا سکتا ہے؟

جس طرح دھوکہ باز مالی فائدے کے لیے جدید ترین AI ٹکنالوجی کا استعمال کرنا چاہتے ہیں، اسی طرح ٹیک فرموں جیسے کاروبار مجرموں کو پکڑنے کے لیے ٹیک کو استعمال کرنے کے طریقے تلاش کرنے میں سخت محنت کر رہے ہیں۔

AI سے لڑنے کے لیے AI کا استعمال کرنے والی کمپنیوں کی کچھ مثالیں یہ ہیں:

2022 کے آخر میں، انٹیل نے ایک AI پر مبنی ٹول لانچ کیا جسے "FakeCatcher" Intel کی رپورٹ کردہ وشوسنییتا کی شرح 96% کے ساتھ، یہ ایک ٹیکنالوجی کا استعمال کرتی ہے جسے photoplethysmography (PPG) کہا جاتا ہے۔

ٹیک ایسی چیز کا استعمال کرتی ہے جو مصنوعی طور پر تیار کردہ ویڈیوز میں موجود نہیں ہے: خون کا بہاؤ۔ جائز ویڈیوز پر تربیت یافتہ، اس کا گہرا سیکھنے والا الگورتھم اس روشنی کی پیمائش کرتا ہے جو خون کی نالیوں کے ذریعے جذب یا منعکس ہوتی ہے، جو جسم کے گرد خون کی گردش کے ساتھ رنگ بدلتی ہے۔

FakeCatcher، Intel کے ذمہ دار AI اقدام کا حصہ، "دنیا کا پہلا ریئل ٹائم ڈیپ فیک ڈیٹیکٹر جو ملی سیکنڈ میں نتائج دیتا ہے۔" یہ ایک جدید ٹیکنالوجی ہے جو اس بات کی نشانیاں تلاش کرتی ہے کہ ویڈیو میں دکھایا گیا شخص واقعی انسان ہے۔ یہ کسی ایسی چیز کی تلاش کرتا ہے جو "صحیح" ہے، بجائے اس کے کہ کسی "غلط" کو نمایاں کرنے کے لیے ڈیٹا کا تجزیہ کیا جائے۔ اس طرح یہ جعلی ہونے کا امکان ظاہر کرتا ہے۔

دریں اثنا، یونیورسٹی آف بفیلو (یو بی) کے کمپیوٹر سائنس دان اپنی ڈیپ فیک کا پتہ لگانے والی ٹیکنالوجی پر کام کر رہے ہیں۔ یہ ایسی چیز کا استعمال کرتا ہے جس کے شوقین پی سی گیمرز جانتے ہیں کہ نقل کرنے کے لیے بے پناہ پروسیسنگ پاور کی ضرورت ہوتی ہے: روشنی۔

جعلی تصاویر پر UB کے ذریعہ 94 فیصد مؤثر ہونے کا دعویٰ کیا گیا، AI ٹول یہ دیکھتا ہے کہ موضوع کی آنکھوں میں روشنی کیسے منعکس ہوتی ہے۔ کارنیا کی سطح ایک آئینے کے طور پر کام کرتی ہے، اور "عکاسی نمونے" پیدا کرتی ہے۔

سائنسدانوں کا مطالعہ، جس کا عنوان ہے "ایکسپوزنگ GAN سے تیار کردہ چہروں کو استعمال کرتے ہوئے متضاد قرنیہ اسپیکولر ہائی لائٹس"، اس بات کی نشاندہی کرتا ہے کہ "GAN کی ترکیب شدہ چہروں کو دو آنکھوں کے درمیان متضاد قرنیہ اسپیکولر جھلکیوں کے ساتھ بے نقاب کیا جا سکتا ہے"۔

یہ تجویز کرتا ہے کہ AI سسٹمز کے لیے حقیقی جھلکیوں کی تقلید کرنا "غیر معمولی" ہوگا۔ پی سی گیمرز، جو حقیقت پسندانہ روشنی کے اثرات کا تجربہ کرنے کے لیے اکثر جدید ترین رے ٹریسنگ گرافکس کارڈز میں سرمایہ کاری کرتے ہیں، یہاں کے چیلنجوں کو فطری طور پر پہچان لیں گے۔

دھوکہ دہی کا پتہ لگانے کا سب سے بڑا چیلنج دھوکہ بازوں اور ان لوگوں کے درمیان لامتناہی "بلی اور چوہے" کا کھیل ہے جو انہیں ناکام بنانے کے لیے کام کرتے ہیں۔ اس بات کا بہت زیادہ امکان ہے کہ مندرجہ بالا اعلانات کے تناظر میں، کہ لوگ پہلے سے ہی ایسی ٹیکنالوجیز بنانے پر کام کر رہے ہیں جو اس طرح کے پتہ لگانے کے طریقہ کار کو پیچھے چھوڑ سکتی ہیں اور اسے شکست دے سکتی ہیں۔

یہ بھی ایک چیز ہے کہ اس طرح کے میکانزم موجود ہیں، لیکن دوسری بات یہ ہے کہ انہیں معمول کے مطابق ان حلوں میں ضم کیا جائے جو کاروبار استعمال کرتے ہیں۔ اس سے پہلے، ہم نے ایک اعدادوشمار کا حوالہ دیا تھا جس میں بتایا گیا تھا کہ 90% حل "آسانی سے بے وقوف" بنائے جا سکتے ہیں۔ امکان یہ ہے کہ کم از کم کچھ مالیاتی ادارے اب بھی ایسے نظام استعمال کر رہے ہیں۔

ایک عقلمند دھوکہ دہی کی نگرانی حکمت عملی کے تحت کمپنیوں کی ضرورت ہوتی ہے کہ وہ خود گہرے جعلی کا پتہ لگانے سے آگے دیکھیں۔ بہت کچھ کیا جا سکتا ہے۔ اس سے پہلے ایک دھوکہ باز ویڈیو پر مبنی شناختی تصدیق یا KYC کے عمل میں حصہ لینے کے لیے کافی حد تک سسٹم میں داخل ہو جاتا ہے۔ احتیاطی تدابیر جو عمل میں پہلے جگہ تلاش کرتی ہیں ان میں AI اور مشین لرننگ کا عنصر بھی شامل ہو سکتا ہے۔

مثال کے طور پر، مشین لرننگ کو ریئل ٹائم فراڈ مانیٹرنگ اور رول سیٹ بنانے دونوں کے لیے استعمال کیا جا سکتا ہے۔ یہ تاریخی دھوکہ دہی کے واقعات کو دیکھ سکتے ہیں، ایسے نمونوں کا پتہ لگا سکتے ہیں جنہیں انسان آسانی سے کھو سکتا ہے۔ زیادہ خطرہ سمجھے جانے والے لین دین کو یکسر مسترد کیا جا سکتا ہے، یا دستی جائزہ کے لیے پاس کیا جا سکتا ہے۔ پہنچنے سے پہلے ایک ایسا مرحلہ جہاں ID چیک ہو سکتا ہے – اور اس وجہ سے دھوکہ باز کے لیے ڈیپ فیک ٹیک کا استعمال کرنے کا موقع۔

سسٹم جتنی جلدی سائبر کرائمین کا پتہ لگا لے، اتنا ہی بہتر ہے۔ اس بات کا کم امکان ہے کہ وہ جرم کو برقرار رکھ سکتے ہیں اور کاروبار کے لیے مزید چیک پر خرچ کرنے کا کم۔ ویڈیو پر مبنی آئی ڈی کی جانچ مہنگی ہے، یہاں تک کہ گہری جعلی کا پتہ لگانے کے لیے AI ٹیکنالوجی کو شامل کیے بغیر۔

اگر ڈیجیٹل فٹ پرنٹنگ جیسی تکنیکوں کے ذریعے دھوکہ دہی کرنے والوں کی شناخت اس حد تک پہنچنے سے پہلے کی جا سکتی ہے، تو بارڈر لائن کیسز کی جانچ کو بہتر بنانے کے لیے مزید وسائل دستیاب ہوں گے۔

مشین لرننگ کی فطرت کو یہ حکم دینا چاہئے کہ، وقت کے ساتھ، یہ بے ضابطگیوں کا پتہ لگانے اور دھوکہ دہی سے لڑنے میں بہتر ہوتا ہے۔ AI سے چلنے والے نظام نئے نمونوں سے سیکھ سکتے ہیں اور ممکنہ طور پر اس عمل کے ابتدائی مرحلے میں ہی جعلی لین دین کو فلٹر کر سکتے ہیں۔

جب بات خاص طور پر ڈیپ فیکس کی ہو تو اوپر دی گئی مثال امید کی ایک خاص وجہ بتاتی ہے۔ سائنسدانوں نے روشنی کی عکاسی کا استعمال کرتے ہوئے ڈیپ فیکس کی اکثریت کا پتہ لگانے کا ایک طریقہ ڈھونڈ لیا ہے۔ اس طرح کی پیشرفت دھوکہ دہی کی روک تھام میں ایک قابل ذکر قدم اور سائبر کرائمینلز کے لیے ایک قابل ذکر رکاوٹ کی نمائندگی کرتی ہے۔

نظریہ طور پر، اس طرح کی کھوج لگانے والی ٹیکنالوجی کو تعینات کرنا اس سے کہیں زیادہ آسان ہے جتنا کہ دھوکہ بازوں کے لیے اس سے بچنے کا کوئی طریقہ تلاش کرنا ہے - روشنی کے رویے کو نقل کرنا، مثال کے طور پر، رفتار اور پیمانے پر۔ ایسا لگتا ہے کہ "بلی اور چوہے" کا کھیل ہمیشہ کے لیے جاری رہے گا، لیکن بڑی ٹیک اور بڑے فنانس کے پاس وسائل اور گہری جیبیں ہیں - نظریہ میں کم از کم - ایک چھوٹا قدم آگے رہیں۔

جمی فونگ SEON کا CCO ہے اور ہر جگہ فراڈ ٹیموں کی مدد کے لیے فراڈ سے لڑنے کا اپنا گہرا تجربہ لاتا ہے۔

- SEO سے چلنے والا مواد اور PR کی تقسیم۔ آج ہی بڑھا دیں۔

- پلیٹوآئ اسٹریم۔ ویب 3 ڈیٹا انٹیلی جنس۔ علم میں اضافہ۔ یہاں تک رسائی حاصل کریں۔

- ایڈریین ایشلے کے ساتھ مستقبل کا نقشہ بنانا۔ یہاں تک رسائی حاصل کریں۔

- PREIPO® کے ساتھ PRE-IPO کمپنیوں میں حصص خریدیں اور بیچیں۔ یہاں تک رسائی حاصل کریں۔

- ماخذ: https://www.kdnuggets.com/2023/05/fighting-ai-ai-fraud-monitoring-deepfake-applications.html?utm_source=rss&utm_medium=rss&utm_campaign=fighting-ai-with-ai-fraud-monitoring-for-deepfake-applications

- : ہے

- : ہے

- : نہیں

- :کہاں

- $UP

- 000

- 10

- 2018

- 2020

- 2021

- 2022

- 2023

- a

- کی صلاحیت

- ہمارے بارے میں

- اوپر

- قابل رسائی

- کام کرتا ہے

- شامل کیا

- شکست

- آگے

- AI

- اے آئی سسٹمز

- AI سے چلنے والا

- یلگورتم

- کی اجازت

- پہلے ہی

- بھی

- ایک ساتھ

- an

- تجزیہ

- اور

- اعلان

- اعلانات

- ایک اور

- جواب

- کوئی بھی

- ایپلی کیشنز

- کیا

- ارد گرد

- مصنوعی

- مصنوعی ذہانت

- AS

- مدد

- At

- آٹومیٹڈ

- دستیاب

- واپس

- متوازن

- بینک

- بینکوں

- براک اوباما

- راہ میں حائل رکاوٹیں

- کی بنیاد پر

- BE

- بن

- ہو جاتا ہے

- رہا

- اس سے پہلے

- شروع ہوا

- کیا جا رہا ہے

- بہتر

- کے درمیان

- سے پرے

- بگ

- بڑی ٹیک

- بٹ کوائن

- خون

- جسم

- دونوں

- لاتا ہے

- بھینس

- عمارت

- کاروبار

- کاروبار

- لیکن

- by

- کہا جاتا ہے

- کر سکتے ہیں

- صلاحیتوں

- کارڈ

- مقدمات

- پکڑو

- مشہور شخصیت

- یقینی طور پر

- چیلنج

- چیلنجوں

- موقع

- تبدیل

- چیٹ جی پی ٹی

- چیک کریں

- چیک

- رنگ

- آتا ہے

- کمیونٹی

- کمپنیاں

- مکمل

- کمپیوٹر

- کافی

- جاری

- بات چیت

- قیمت

- مہنگی

- سکتا ہے

- جوڑے

- کورس

- تخلیق

- مخلوق

- جرم

- مجرم

- سائبر کریمنل

- cybercriminals

- اعداد و شمار

- ڈیٹا سائنس

- سمجھا

- گہری

- گہری جعلی

- deepfakes

- ترسیل

- تعیناتی

- بیان کیا

- کھوج

- ترقی

- رفت

- ڈیجیٹل

- ڈونالڈ

- ڈونالڈ ٹرمپ

- کیا

- دو

- اس سے قبل

- ابتدائی

- ابتدائی مرحلے

- آسان

- آسانی سے

- اقتصادی

- اکنامک فورم

- موثر

- اثرات

- عنصر

- عناصر

- ابھر کر سامنے آئے

- لامتناہی

- کافی

- اندر

- جس کا عنوان

- اندراج

- دور

- خاص طور پر

- بھی

- واقعات

- مثال کے طور پر

- مثال کے طور پر

- خصوصی

- وجود

- تجربہ

- ماہر

- ظاہر

- آنکھیں

- چہرہ

- چہرے

- حقیقت یہ ہے

- جعلی

- دور

- لڑنا

- لڑ

- فلٹر

- کی مالی اعانت

- مالی

- مالی دھوکہ دہی

- مالیاتی ادارے

- مل

- تلاش

- فن ٹیک

- فرم

- پہلا

- بہاؤ

- توجہ مرکوز

- کے لئے

- فورم

- آگے

- ملا

- دھوکہ دہی

- فراڈ کا پتہ لگانے

- فراڈ کی روک تھام

- دھوکہ دہی

- دھوکہ دہی

- سے

- مزید

- حاصل کرنا

- کھیل ہی کھیل میں

- محفل

- GANs

- پیدا

- پیدا ہوتا ہے

- حقیقی

- حاصل

- فراہم کرتا ہے

- Go

- گرافکس

- سب سے بڑا

- تھا

- ہارڈ

- ہے

- he

- مدد

- یہاں

- ہائی

- نمایاں کریں

- پر روشنی ڈالی گئی

- انتہائی

- ان

- تاریخی

- مارو

- امید ہے کہ

- کس طرح

- تاہم

- HTML

- HTTPS

- بھاری

- بھاری

- انسانی

- انسان

- سینکڑوں

- ID

- کی نشاندہی

- شناخت

- تصویر

- بہت زیادہ

- کو بہتر بنانے کے

- in

- میں گہرائی

- اشارہ کرتا ہے

- انیشی ایٹو

- جدید

- جدید ٹیکنالوجی

- اداروں

- ضم

- انٹیل

- انٹیلی جنس

- میں

- سرمایہ کاری

- شامل

- IT

- میں

- خود

- جرنل

- فوٹو

- صرف

- KDnuggets

- جان

- علم

- جانا جاتا ہے

- وائی سی

- مرحوم

- تازہ ترین

- شروع

- جانیں

- سیکھنے

- کم سے کم

- لیکچر

- چھوڑ دیا

- جائز

- کم

- روشنی

- لائٹنینگ کا

- کی طرح

- امکان

- لنکڈ

- رہتے ہیں

- دیکھو

- دیکھنا

- مشین

- مشین لرننگ

- مین سٹریم میں

- اکثریت

- بنا

- بناتا ہے

- دستی

- بہت سے

- مواد

- مئی..

- اقدامات

- نظام

- رکن

- دس لاکھ

- لاکھوں

- منٹ

- عکس

- یاد آیا

- ایم ائی ٹی

- ماڈل

- نگرانی

- مہینہ

- زیادہ

- تحریک

- چالیں

- بہت

- فطرت، قدرت

- ضرورت ہے

- نیٹ ورک

- نئی

- رات

- غیر تکنیکی

- اب

- تعداد

- اوباما

- of

- پیش کرتے ہیں

- اکثر

- on

- ایک

- آن لائن

- صرف

- اوپنائی

- مواقع

- کی اصلاح کریں

- آپشنز کے بھی

- or

- حکم

- دیگر

- باہر

- پیداوار

- پر

- خود

- جوڑے

- حصہ

- شرکت

- خاص طور پر

- منظور

- گزشتہ

- پیٹرن

- PC

- لوگ

- شاید

- انسان

- تصویر

- مقام

- پلاٹا

- افلاطون ڈیٹا انٹیلی جنس

- پلیٹو ڈیٹا

- جیب

- پوائنٹ

- سیاسی

- فحش

- پوسٹ

- ممکنہ طور پر

- طاقت

- حال (-)

- روک تھام

- پرائمری

- عمل

- پروسیسنگ

- پاور پروسیسنگ

- تیار

- ٹیچر

- پروموشنل

- ثابت ہوا

- فراہم

- فراہم کرنے

- عوامی

- مقاصد

- معیار

- ریڈار

- رینج

- شرح

- بلکہ

- اصل وقت

- حقیقت

- حقیقت

- وجہ

- حال ہی میں

- حال ہی میں

- تسلیم

- کہا جاتا ہے

- جھلکتی ہے

- مظاہر

- کی عکاسی کرتا ہے

- متعلقہ

- وشوسنییتا

- اطلاع دی

- کی نمائندگی

- کی ضرورت ہے

- وسائل

- ذمہ دار

- نتائج کی نمائش

- واپسی

- انکشاف

- واپس

- کا جائزہ لینے کے

- رسک

- معمول سے

- رن

- ہفتے کے روز

- پیمانے

- دھوکہ

- گھوٹالے

- سکول

- سائنس

- سائنسدانوں

- سیکورٹی

- حفاظتی اقدامات

- دیکھنا

- طلب کرو

- لگتا ہے

- دیکھا

- SEON

- سروس

- وہ

- منتقل

- ہونا چاہئے

- دکھائیں

- دکھایا گیا

- کی طرف

- سائن ان کریں

- نشانیاں

- سادہ

- بعد

- ایک

- چھ

- چھوٹے

- So

- حل

- کچھ

- کچھ

- بہتر

- آواز

- خاص طور پر

- تیزی

- خرچ

- اسٹیج

- نے کہا

- رہنا

- مرحلہ

- ابھی تک

- کہانی

- حکمت عملی

- سڑک

- مطالعہ

- موضوع

- اس طرح

- پتہ چلتا ہے

- سطح

- اضافے

- کے نظام

- سسٹمز

- ہدف

- ٹیموں

- ٹیک

- ٹیکنیکل

- تکنیک

- ٹیکنالوجی

- ٹیکنالوجی

- ٹیسٹ

- سے

- کہ

- ۔

- دنیا

- ان

- ان

- خود

- تو

- نظریہ

- وہاں.

- لہذا

- یہ

- وہ

- بات

- اس

- ان

- ہزاروں

- کے ذریعے

- وقت

- کرنے کے لئے

- بھی

- کے آلے

- اوزار

- موضوع

- کل

- تربیت یافتہ

- معاملات

- منتقلی

- واقعی

- ٹرمپ

- دیتا ہے

- ٹویٹر

- دو

- کے تحت

- یونیورسٹی

- استعمال کی شرائط

- استعمال کیا جاتا ہے

- صارفین

- کا استعمال کرتے ہوئے

- استعمال

- وسیع

- دہانے

- توثیق

- اس بات کی تصدیق

- بہت

- کی طرف سے

- ویڈیو

- ویڈیوز

- وائرل

- وائس

- قابل اطلاق

- جاگو

- تھا

- راستہ..

- طریقوں

- we

- تھے

- وارٹن

- کیا

- جب

- جس

- ڈبلیو

- گے

- ساتھ

- بغیر

- کام

- کام کر

- دنیا

- عالمی اقتصادی فورم

- دنیا کی

- گا

- سال

- یو ٹیوب پر

- زیفیرنیٹ