آج ہم یہ اعلان کرتے ہوئے پرجوش ہیں کہ لاما گارڈ ماڈل اب استعمال کرنے والے صارفین کے لیے دستیاب ہے۔ ایمیزون سیج میکر جمپ اسٹارٹ. لاما گارڈ بڑے لینگویج ماڈل (LLM) کی تعیناتی میں ان پٹ اور آؤٹ پٹ تحفظات فراہم کرتا ہے۔ یہ پرپل للاما کے تحت اجزاء میں سے ایک ہے، میٹا کی پہل جس میں کھلے اعتماد اور حفاظتی ٹولز اور تشخیصات شامل ہیں تاکہ ڈویلپرز کو AI ماڈلز کے ساتھ ذمہ داری سے تعمیر کرنے میں مدد ملے۔ Purple Llama کمیونٹی کو تخلیقی AI ماڈلز کے ساتھ ذمہ داری سے تعمیر کرنے میں مدد کرنے کے لیے ٹولز اور تشخیصات کو اکٹھا کرتا ہے۔ ابتدائی ریلیز میں سائبر سیکیورٹی اور LLM ان پٹ اور آؤٹ پٹ سیف گارڈز پر فوکس کیا گیا ہے۔ Purple Llama پروجیکٹ کے اندر موجود اجزاء، بشمول Llama Guard ماڈل، اجازت کے ساتھ لائسنس یافتہ ہیں، تحقیق اور تجارتی استعمال دونوں کو قابل بناتے ہیں۔

اب آپ SageMaker JumpStart کے اندر Llama Guard ماڈل استعمال کر سکتے ہیں۔ SageMaker JumpStart مشین لرننگ (ML) کا مرکز ہے۔ ایمیزون سیج میکر جو ML کے ساتھ جلدی شروع کرنے میں آپ کی مدد کرنے کے لیے بلٹ ان الگورتھم اور اینڈ ٹو اینڈ سلوشن ٹیمپلیٹس کے علاوہ فاؤنڈیشن ماڈلز تک رسائی فراہم کرتا ہے۔

اس پوسٹ میں، ہم لاما گارڈ ماڈل کو تعینات کرنے اور ذمہ دار جنریٹیو AI حل تیار کرنے کے طریقہ پر چلتے ہیں۔

لاما گارڈ ماڈل

Llama Guard Meta کا ایک نیا ماڈل ہے جو LLM کی تعیناتیوں کے لیے ان پٹ اور آؤٹ پٹ گارڈریلز فراہم کرتا ہے۔ Llama Guard ایک کھلے عام دستیاب ماڈل ہے جو عام اوپن بینچ مارکس پر مسابقتی کارکردگی کا مظاہرہ کرتا ہے اور ڈویلپرز کو ایک پہلے سے تربیت یافتہ ماڈل فراہم کرتا ہے تاکہ ممکنہ طور پر خطرناک نتائج پیدا کرنے سے بچایا جا سکے۔ اس ماڈل کو عوامی طور پر دستیاب ڈیٹا سیٹس کے مرکب پر تربیت دی گئی ہے تاکہ ممکنہ طور پر خطرناک یا خلاف ورزی کرنے والے مواد کی عام اقسام کا پتہ لگایا جا سکے جو ڈویلپر کے استعمال کے متعدد معاملات سے متعلق ہو سکتا ہے۔ بالآخر، ماڈل کا وژن یہ ہے کہ ڈویلپرز کو اس ماڈل کو اپنی مرضی کے مطابق بنانے کے لیے متعلقہ استعمال کے معاملات کی حمایت کرنے کے لیے اور اسے بہترین طریقوں کو اپنانے اور کھلے ماحولیاتی نظام کو بہتر بنانے کے لیے آسان بنانا ہے۔

Llama Guard کو ڈویلپرز کے لیے اپنی تخفیف کی حکمت عملیوں میں ضم کرنے کے لیے ایک اضافی ٹول کے طور پر استعمال کیا جا سکتا ہے، جیسے کہ چیٹ بوٹس، مواد کی اعتدال، کسٹمر سروس، سوشل میڈیا مانیٹرنگ، اور تعلیم کے لیے۔ صارف کے تیار کردہ مواد کو شائع کرنے یا اس کا جواب دینے سے پہلے Llama Guard کے ذریعے منتقل کر کے، ڈویلپر غیر محفوظ یا نامناسب زبان کو جھنڈا دے سکتے ہیں اور ایک محفوظ اور باعزت ماحول کو برقرار رکھنے کے لیے کارروائی کر سکتے ہیں۔

آئیے دریافت کریں کہ ہم SageMaker JumpStart میں لاما گارڈ ماڈل کو کس طرح استعمال کر سکتے ہیں۔

سیج میکر میں فاؤنڈیشن ماڈل

سیج میکر جمپ سٹارٹ مقبول ماڈل ہب سے ماڈلز کی ایک رینج تک رسائی فراہم کرتا ہے، بشمول ہیگنگ فیس، پائ ٹارچ ہب، اور ٹینسر فلو حب، جسے آپ سیج میکر میں اپنے ایم ایل ڈیولپمنٹ ورک فلو کے اندر استعمال کر سکتے ہیں۔ ایم ایل میں حالیہ پیشرفت نے ماڈلز کی ایک نئی کلاس کو جنم دیا ہے جس کے نام سے جانا جاتا ہے۔ بنیاد ماڈل، جو عام طور پر اربوں پیرامیٹرز پر تربیت یافتہ ہوتے ہیں اور استعمال کے معاملات کے وسیع زمرے کے مطابق ہوتے ہیں، جیسے کہ متن کا خلاصہ، ڈیجیٹل آرٹ جنریشن، اور زبان کا ترجمہ۔ چونکہ یہ ماڈلز کو تربیت دینا مہنگا ہے، اس لیے صارفین ان ماڈلز کو خود تربیت دینے کے بجائے موجودہ پہلے سے تربیت یافتہ فاؤنڈیشن ماڈلز کو استعمال کرنا چاہتے ہیں اور ضرورت کے مطابق ان کو ٹھیک کرنا چاہتے ہیں۔ سیج میکر ان ماڈلز کی کیوریٹڈ فہرست فراہم کرتا ہے جن میں سے آپ سیج میکر کنسول پر انتخاب کر سکتے ہیں۔

اب آپ SageMaker JumpStart کے اندر مختلف ماڈل فراہم کنندگان سے فاؤنڈیشن ماڈلز تلاش کر سکتے ہیں، جس سے آپ فاؤنڈیشن ماڈلز کے ساتھ تیزی سے شروعات کر سکتے ہیں۔ آپ مختلف کاموں یا ماڈل فراہم کنندگان کی بنیاد پر فاؤنڈیشن ماڈل تلاش کر سکتے ہیں، اور آسانی سے ماڈل کی خصوصیات اور استعمال کی شرائط کا جائزہ لے سکتے ہیں۔ آپ ٹیسٹ UI ویجیٹ کا استعمال کرتے ہوئے ان ماڈلز کو بھی آزما سکتے ہیں۔ جب آپ پیمانے پر فاؤنڈیشن ماڈل استعمال کرنا چاہتے ہیں، تو آپ ماڈل فراہم کنندگان کی طرف سے پہلے سے بنی ہوئی نوٹ بکس کا استعمال کرکے SageMaker کو چھوڑے بغیر اتنی آسانی سے کر سکتے ہیں۔ چونکہ ماڈلز کی میزبانی اور AWS پر تعیناتی ہوتی ہے، آپ یقین دہانی کر سکتے ہیں کہ آپ کا ڈیٹا، چاہے ماڈل کو جانچنے یا استعمال کرنے کے لیے استعمال کیا گیا ہو، تیسرے فریق کے ساتھ کبھی شیئر نہیں کیا جاتا ہے۔

آئیے دریافت کریں کہ ہم SageMaker JumpStart میں لاما گارڈ ماڈل کو کس طرح استعمال کر سکتے ہیں۔

سیج میکر جمپ اسٹارٹ میں لاما گارڈ کا ماڈل دریافت کریں۔

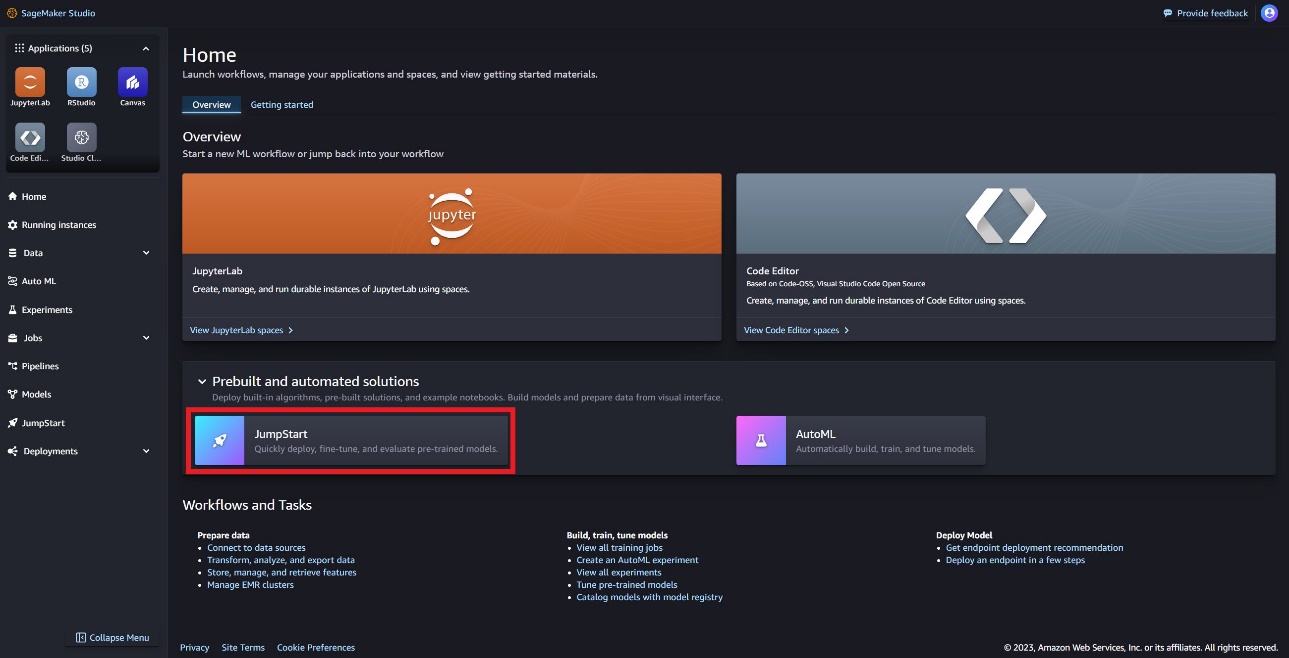

آپ SageMaker Studio UI اور SageMaker Python SDK میں SageMaker JumpStart کے ذریعے Code Llama فاؤنڈیشن ماڈلز تک رسائی حاصل کر سکتے ہیں۔ اس سیکشن میں، ہم ماڈلز کو دریافت کرنے کا طریقہ دیکھتے ہیں۔ ایمیزون سیج میکر اسٹوڈیو.

سیج میکر اسٹوڈیو ایک مربوط ترقیاتی ماحول (IDE) ہے جو ایک واحد ویب پر مبنی بصری انٹرفیس فراہم کرتا ہے جہاں آپ ڈیٹا کی تیاری سے لے کر اپنے ML ماڈلز کی تعمیر، تربیت، اور تعیناتی تک تمام ML ترقیاتی مراحل کو انجام دینے کے لیے مقصد کے لیے بنائے گئے ٹولز تک رسائی حاصل کر سکتے ہیں۔ شروع کرنے اور SageMaker اسٹوڈیو کو ترتیب دینے کے طریقے کے بارے میں مزید تفصیلات کے لیے، رجوع کریں۔ ایمیزون سیج میکر اسٹوڈیو.

سیج میکر اسٹوڈیو میں، آپ سیج میکر جمپ سٹارٹ تک رسائی حاصل کر سکتے ہیں، جس میں پہلے سے تربیت یافتہ ماڈل، نوٹ بکس، اور پہلے سے تیار کردہ حل شامل ہیں۔ پہلے سے تعمیر شدہ اور خودکار حل.

سیج میکر جمپ سٹارٹ لینڈنگ پیج پر، آپ میٹا ہب کو منتخب کر کے یا لاما گارڈ کو تلاش کر کے لاما گارڈ ماڈل تلاش کر سکتے ہیں۔

آپ Llama ماڈل کی مختلف قسموں میں سے انتخاب کر سکتے ہیں، بشمول Llama Guard، Llama-2، اور Code Llama۔

آپ ماڈل کے بارے میں تفصیلات دیکھنے کے لیے ماڈل کارڈ کا انتخاب کر سکتے ہیں جیسے کہ لائسنس، تربیت کے لیے استعمال ہونے والا ڈیٹا، اور استعمال کرنے کا طریقہ۔ آپ کو ایک بھی مل جائے گا۔ تعینات آپشن، جو آپ کو ایک لینڈنگ پیج پر لے جائے گا جہاں آپ مثال کے پے لوڈ کے ساتھ اندازہ کی جانچ کر سکتے ہیں۔

SageMaker Python SDK کے ساتھ ماڈل کو متعین کریں۔

آپ ایمیزون جمپ اسٹارٹ پر لاما گارڈ کی تعیناتی کو ظاہر کرنے والا کوڈ اور اس میں تعینات ماڈل کو استعمال کرنے کے طریقہ کی ایک مثال تلاش کر سکتے ہیں۔ اس GitHub نوٹ بک۔

درج ذیل کوڈ میں، ہم SageMaker ماڈل ہب ماڈل ID اور ماڈل ورژن کی وضاحت کرتے ہیں جو Llama Guard کو تعینات کرتے وقت استعمال کیا جائے:

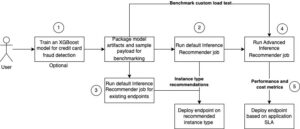

اب آپ SageMaker JumpStart کا استعمال کرتے ہوئے ماڈل کو تعینات کر سکتے ہیں۔ مندرجہ ذیل کوڈ انفرنس اینڈ پوائنٹ کے لیے ڈیفالٹ مثال ml.g5.2xlarge استعمال کرتا ہے۔ آپ پاس کر کے ماڈل کو دوسری مثال کی اقسام پر تعینات کر سکتے ہیں۔ instance_type میں JumpStartModel کلاس تعیناتی میں چند منٹ لگ سکتے ہیں۔ کامیاب تعیناتی کے لیے، آپ کو دستی طور پر تبدیل کرنا ہوگا۔ accept_eula ماڈل کی تعیناتی کے طریقہ کار میں دلیل True.

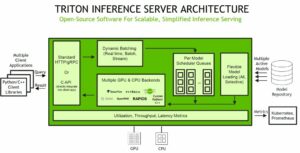

یہ ماڈل ٹیکسٹ جنریشن انفرنس (TGI) ڈیپ لرننگ کنٹینر کا استعمال کرتے ہوئے لگایا گیا ہے۔ انفرنس کی درخواستیں بہت سے پیرامیٹرز کی حمایت کرتی ہیں، بشمول درج ذیل:

- زیادہ سے زیادہ طوالت - ماڈل اس وقت تک متن تیار کرتا ہے جب تک کہ آؤٹ پٹ کی لمبائی (جس میں ان پٹ سیاق و سباق کی لمبائی شامل ہے) تک نہ پہنچ جائے۔

max_length. اگر بیان کیا جائے تو یہ ایک مثبت عدد ہونا چاہیے۔ - max_new_tokens - ماڈل اس وقت تک متن تیار کرتا ہے جب تک کہ آؤٹ پٹ کی لمبائی (ان پٹ سیاق و سباق کی لمبائی کو چھوڑ کر) تک نہ پہنچ جائے۔

max_new_tokens. اگر بیان کیا جائے تو یہ ایک مثبت عدد ہونا چاہیے۔ - num_beams - یہ لالچی تلاش میں استعمال ہونے والے شہتیروں کی تعداد کی نشاندہی کرتا ہے۔ اگر متعین کیا جائے تو یہ اس سے بڑا یا اس کے برابر کا عدد ہونا چاہیے۔

num_return_sequences. - no_repeat_ngram_size - ماڈل اس بات کو یقینی بناتا ہے کہ الفاظ کی ترتیب

no_repeat_ngram_sizeآؤٹ پٹ ترتیب میں دہرایا نہیں جاتا ہے۔ اگر بیان کیا جائے تو یہ 1 سے بڑا مثبت عدد ہونا چاہیے۔ - درجہ حرارت - یہ پیرامیٹر آؤٹ پٹ میں بے ترتیب پن کو کنٹرول کرتا ہے۔ ایک اعلیٰ

temperatureنتیجہ کم امکان والے الفاظ کے ساتھ آؤٹ پٹ کی ترتیب میں، اور کمtemperatureزیادہ امکان والے الفاظ کے ساتھ آؤٹ پٹ کی ترتیب کا نتیجہ۔ اگرtemperature0 ہے، اس کے نتیجے میں لالچی ضابطہ کشائی ہوتی ہے۔ اگر بیان کیا گیا ہے، تو یہ ایک مثبت فلوٹ ہونا چاہیے۔ - جلدی_روکنا - اگر

Trueجب تمام بیم مفروضے جملے کے ٹوکن کے اختتام پر پہنچ جاتے ہیں تو متن کی تخلیق مکمل ہو جاتی ہے۔ اگر بیان کیا گیا ہے، تو یہ بولین ہونا چاہیے۔ - do_sample - اگر

True، ماڈل امکان کے مطابق اگلے لفظ کا نمونہ کرتا ہے۔ اگر بیان کیا گیا ہے، تو یہ بولین ہونا چاہیے۔ - top_k - ٹیکسٹ جنریشن کے ہر مرحلے میں، ماڈل کے نمونے صرف سے

top_kسب سے زیادہ امکان الفاظ. اگر بیان کیا جائے تو یہ ایک مثبت عدد ہونا چاہیے۔ - ٹاپ_پی - ٹیکسٹ جنریشن کے ہر مرحلے میں، مجموعی امکان کے ساتھ الفاظ کے سب سے چھوٹے ممکنہ سیٹ سے ماڈل کے نمونے

top_p. اگر بیان کیا گیا ہے، تو یہ 0-1 کے درمیان فلوٹ ہونا چاہیے۔ - واپسی_مکمل_متن - اگر

True، ان پٹ ٹیکسٹ آؤٹ پٹ جنریٹڈ ٹیکسٹ کا حصہ ہوگا۔ اگر بیان کیا گیا ہے، تو یہ بولین ہونا چاہیے۔ پہلے سے طے شدہ قدر ہے۔False. - روک - اگر بیان کیا گیا ہے، تو یہ تاروں کی فہرست ہونی چاہیے۔ ٹیکسٹ جنریشن رک جاتا ہے اگر مخصوص سٹرنگز میں سے کوئی ایک تیار ہو جاتی ہے۔

سیج میکر اینڈ پوائنٹ کو طلب کریں۔

آپ پروگرامی طور پر مثال کے پے لوڈز سے بازیافت کرسکتے ہیں۔ JumpStartModel چیز. یہ آپ کو پہلے سے فارمیٹ شدہ ہدایات کے اشارے کو دیکھ کر جلدی شروع کرنے میں مدد کرے گا جو Llama Guard کھا سکتا ہے۔ درج ذیل کوڈ دیکھیں:

پچھلی مثال کو چلانے کے بعد، آپ دیکھ سکتے ہیں کہ آپ کے ان پٹ اور آؤٹ پٹ کو Llama Guard کے ذریعے فارمیٹ کیا جائے گا:

Llama-2 کی طرح، Llama Guard ماڈل کو حفاظتی ہدایات کی نشاندہی کرنے کے لیے خصوصی ٹوکن استعمال کرتا ہے۔ عام طور پر، پے لوڈ کو درج ذیل فارمیٹ کی پیروی کرنی چاہیے:

صارف کا اشارہ بطور دکھایا گیا ہے۔ {user_prompt} اوپر، مواد کے زمرے کی تعریفوں اور بات چیت کے لیے مزید حصے شامل کر سکتے ہیں، جو کہ درج ذیل کی طرح نظر آتے ہیں:

اگلے حصے میں، ہم کام، مواد کے زمرے، اور ہدایات کی تعریفوں کے لیے تجویز کردہ ڈیفالٹ اقدار پر تبادلہ خیال کرتے ہیں۔ بات چیت کے درمیان متبادل ہونا چاہئے User اور Agent مندرجہ ذیل متن:

Llama-2 Chat کے ساتھ بات چیت کو معتدل کریں۔

اب آپ بات چیت کے لیے ایک Llama-2 7B چیٹ ماڈل اینڈ پوائنٹ لگا سکتے ہیں اور پھر Llama-2 7B چیٹ سے آنے والے ان پٹ اور آؤٹ پٹ ٹیکسٹ کو معتدل کرنے کے لیے Llama Guard کا استعمال کر سکتے ہیں۔

ہم آپ کو Llama-2 7B چیٹ ماڈل کے ان پٹ اور آؤٹ پٹ کی مثال دکھاتے ہیں جو Llama Guard کے ذریعے معتدل کیا گیا ہے، لیکن آپ Llama Guard کو اپنی پسند کے کسی LLM کے ساتھ اعتدال کے لیے استعمال کر سکتے ہیں۔

مندرجہ ذیل کوڈ کے ساتھ ماڈل کو تعینات کریں:

اب آپ لاما گارڈ ٹاسک ٹیمپلیٹ کی وضاحت کر سکتے ہیں۔ غیر محفوظ مواد کے زمرے آپ کے مخصوص استعمال کے معاملے کے لیے حسب خواہش ایڈجسٹ کیے جا سکتے ہیں۔ آپ سادہ متن میں ہر مواد کے زمرے کے معنی کی وضاحت کر سکتے ہیں، بشمول کون سا مواد غیر محفوظ کے طور پر نشان زد کیا جانا چاہئے اور کس مواد کو محفوظ کے طور پر اجازت دی جانی چاہئے۔ درج ذیل کوڈ دیکھیں:

اگلا، ہم مددگار افعال کی وضاحت کرتے ہیں۔ format_chat_messages اور format_guard_messages چیٹ ماڈل اور لاما گارڈ ماڈل کے لیے پرامپٹ کو فارمیٹ کرنے کے لیے جس کے لیے خصوصی ٹوکن کی ضرورت ہوتی ہے:

اس کے بعد آپ ان مددگار فنکشنز کو مثال کے پیغام کے ان پٹ پرامپٹ پر لاما گارڈ کے ذریعے مثال کے ان پٹ کو چلانے کے لیے استعمال کر سکتے ہیں تاکہ یہ معلوم کیا جا سکے کہ آیا پیغام کا مواد محفوظ ہے:

درج ذیل آؤٹ پٹ اشارہ کرتا ہے کہ پیغام محفوظ ہے۔ آپ محسوس کر سکتے ہیں کہ پرامپٹ میں ایسے الفاظ شامل ہیں جو تشدد سے منسلک ہو سکتے ہیں، لیکن، اس معاملے میں، Llama Guard ان ہدایات اور غیر محفوظ زمرہ کی تعریفوں کے حوالے سے سیاق و سباق کو سمجھنے کے قابل ہے جو ہم نے پہلے فراہم کی ہیں اور یہ طے کر سکتے ہیں کہ یہ ایک محفوظ اشارہ ہے اور نہیں تشدد سے متعلق

اب جب کہ آپ نے تصدیق کر لی ہے کہ ان پٹ ٹیکسٹ آپ کے Llama Guard کے مواد کے زمروں کے حوالے سے محفوظ ہونے کے لیے پرعزم ہے، آپ اس پے لوڈ کو متعین کردہ Llama-2 7B ماڈل کو متن بنانے کے لیے بھیج سکتے ہیں:

مندرجہ ذیل ماڈل سے جواب ہے:

آخر میں، آپ اس بات کی تصدیق کرنا چاہیں گے کہ ماڈل کا جوابی متن محفوظ مواد پر مشتمل ہے۔ یہاں، آپ ان پٹ پیغامات کے لیے LLM آؤٹ پٹ جواب کو بڑھاتے ہیں اور اس پوری گفتگو کو Llama Guard کے ذریعے چلاتے ہیں تاکہ یہ یقینی بنایا جا سکے کہ بات چیت آپ کی درخواست کے لیے محفوظ ہے:

آپ مندرجہ ذیل آؤٹ پٹ دیکھ سکتے ہیں، جس سے یہ ظاہر ہوتا ہے کہ چیٹ ماڈل کا جواب محفوظ ہے:

صاف کرو

اختتامی نقطوں کی جانچ کرنے کے بعد، یقینی بنائیں کہ آپ نے SageMaker انفرنس اینڈ پوائنٹس اور ماڈل کو حذف کر دیا ہے تاکہ چارجز لگنے سے بچ سکیں۔

نتیجہ

اس پوسٹ میں، ہم نے آپ کو دکھایا کہ آپ Llama Guard کا استعمال کرتے ہوئے ان پٹس اور آؤٹ پٹس کو کیسے معتدل کر سکتے ہیں اور SageMaker JumpStart میں LLMs سے ان پٹ اور آؤٹ پٹ کے لیے گارڈریل لگا سکتے ہیں۔

جیسا کہ AI آگے بڑھ رہا ہے، ذمہ دارانہ ترقی اور تعیناتی کو ترجیح دینا اہم ہے۔ Purple Llama’s CyberSecEval اور Llama Guard جیسے ٹولز محفوظ اختراع کو فروغ دینے میں اہم کردار ادا کرتے ہیں، جو زبان کے ماڈلز کے لیے ابتدائی خطرے کی شناخت اور تخفیف رہنمائی پیش کرتے ہیں۔ 1 دن سے اخلاقی طور پر LLMs کی اپنی پوری صلاحیت کو بروئے کار لانے کے لیے انہیں AI ڈیزائن کے عمل میں شامل کیا جانا چاہیے۔

آج ہی SageMaker JumpStart میں Llama Guard اور دیگر فاؤنڈیشن ماڈلز آزمائیں اور ہمیں اپنی رائے سے آگاہ کریں!

یہ رہنمائی صرف معلوماتی مقاصد کے لیے ہے۔ آپ کو اب بھی اپنی خود مختار تشخیص کرنی چاہیے، اور اس بات کو یقینی بنانے کے لیے اقدامات کرنے چاہییں کہ آپ کوالٹی کنٹرول کے اپنے مخصوص طریقوں اور معیارات، اور مقامی قواعد، قوانین، ضوابط، لائسنس، اور استعمال کی شرائط جو آپ پر لاگو ہوتے ہیں، آپ کے مواد، اور اس رہنمائی میں حوالہ دیا گیا تھرڈ پارٹی ماڈل۔ AWS کا اس رہنمائی میں حوالہ دیئے گئے فریق ثالث کے ماڈل پر کوئی کنٹرول یا اختیار نہیں ہے، اور وہ اس بات کی کوئی نمائندگی یا ضمانت نہیں دیتا ہے کہ فریق ثالث کا ماڈل محفوظ، وائرس سے پاک، آپریشنل، یا آپ کے پیداواری ماحول اور معیارات کے ساتھ مطابقت رکھتا ہے۔ AWS کوئی نمائندگی، ضمانت یا ضمانت نہیں دیتا ہے کہ اس رہنمائی میں کسی بھی معلومات کے نتیجے میں کوئی خاص نتیجہ یا نتیجہ نکلے گا۔

مصنفین کے بارے میں

ڈاکٹر کائل الریچ کے ساتھ ایک اپلائیڈ سائنٹسٹ ہے۔ ایمیزون سیج میکر بلٹ ان الگورتھم ٹیم اس کی تحقیقی دلچسپیوں میں توسیع پذیر مشین لرننگ الگورتھم، کمپیوٹر ویژن، ٹائم سیریز، بایسیئن نان پیرامیٹرکس، اور گاوسی عمل شامل ہیں۔ اس کی پی ایچ ڈی ڈیوک یونیورسٹی سے ہے اور اس نے نیور آئی پی ایس، سیل اور نیوران میں مقالے شائع کیے ہیں۔

ڈاکٹر کائل الریچ کے ساتھ ایک اپلائیڈ سائنٹسٹ ہے۔ ایمیزون سیج میکر بلٹ ان الگورتھم ٹیم اس کی تحقیقی دلچسپیوں میں توسیع پذیر مشین لرننگ الگورتھم، کمپیوٹر ویژن، ٹائم سیریز، بایسیئن نان پیرامیٹرکس، اور گاوسی عمل شامل ہیں۔ اس کی پی ایچ ڈی ڈیوک یونیورسٹی سے ہے اور اس نے نیور آئی پی ایس، سیل اور نیوران میں مقالے شائع کیے ہیں۔

ایوان کراوٹز Amazon Web Services میں سافٹ ویئر انجینئر ہے، SageMaker JumpStart پر کام کر رہا ہے۔ وہ کلاؤڈ کمپیوٹنگ کے ساتھ مشین لرننگ کے سنگم میں دلچسپی رکھتا ہے۔ ایون نے اپنی انڈرگریجویٹ ڈگری کورنیل یونیورسٹی سے اور ماسٹر کی ڈگری یونیورسٹی آف کیلیفورنیا، برکلے سے حاصل کی۔ 2021 میں، اس نے آئی سی ایل آر کانفرنس میں مخالف نیورل نیٹ ورکس پر ایک مقالہ پیش کیا۔ اپنے فارغ وقت میں، ایوان نیویارک شہر میں کھانا پکانے، سفر کرنے، اور دوڑ لگانے سے لطف اندوز ہوتا ہے۔

ایوان کراوٹز Amazon Web Services میں سافٹ ویئر انجینئر ہے، SageMaker JumpStart پر کام کر رہا ہے۔ وہ کلاؤڈ کمپیوٹنگ کے ساتھ مشین لرننگ کے سنگم میں دلچسپی رکھتا ہے۔ ایون نے اپنی انڈرگریجویٹ ڈگری کورنیل یونیورسٹی سے اور ماسٹر کی ڈگری یونیورسٹی آف کیلیفورنیا، برکلے سے حاصل کی۔ 2021 میں، اس نے آئی سی ایل آر کانفرنس میں مخالف نیورل نیٹ ورکس پر ایک مقالہ پیش کیا۔ اپنے فارغ وقت میں، ایوان نیویارک شہر میں کھانا پکانے، سفر کرنے، اور دوڑ لگانے سے لطف اندوز ہوتا ہے۔

رچنا چڈا AWS میں اسٹریٹجک اکاؤنٹس میں ایک پرنسپل حل آرکیٹیکٹ AI/ML ہے۔ رچنا ایک پر امید ہیں جو اس بات پر یقین رکھتی ہیں کہ AI کا اخلاقی اور ذمہ دارانہ استعمال مستقبل میں معاشرے کو بہتر بنا سکتا ہے اور معاشی اور سماجی خوشحالی لا سکتا ہے۔ اپنے فارغ وقت میں، رچنا اپنے خاندان کے ساتھ وقت گزارنا، پیدل سفر کرنا اور موسیقی سننا پسند کرتی ہے۔

رچنا چڈا AWS میں اسٹریٹجک اکاؤنٹس میں ایک پرنسپل حل آرکیٹیکٹ AI/ML ہے۔ رچنا ایک پر امید ہیں جو اس بات پر یقین رکھتی ہیں کہ AI کا اخلاقی اور ذمہ دارانہ استعمال مستقبل میں معاشرے کو بہتر بنا سکتا ہے اور معاشی اور سماجی خوشحالی لا سکتا ہے۔ اپنے فارغ وقت میں، رچنا اپنے خاندان کے ساتھ وقت گزارنا، پیدل سفر کرنا اور موسیقی سننا پسند کرتی ہے۔

ڈاکٹر آشیش کھیتان Amazon SageMaker بلٹ ان الگورتھم کے ساتھ ایک سینئر اپلائیڈ سائنٹسٹ ہے اور مشین لرننگ الگورتھم تیار کرنے میں مدد کرتا ہے۔ انہوں نے یونیورسٹی آف الینوائے اربانا-چمپین سے پی ایچ ڈی کی۔ وہ مشین لرننگ اور شماریاتی اندازہ میں ایک فعال محقق ہے، اور اس نے NeurIPS، ICML، ICLR، JMLR، ACL، اور EMNLP کانفرنسوں میں بہت سے مقالے شائع کیے ہیں۔

ڈاکٹر آشیش کھیتان Amazon SageMaker بلٹ ان الگورتھم کے ساتھ ایک سینئر اپلائیڈ سائنٹسٹ ہے اور مشین لرننگ الگورتھم تیار کرنے میں مدد کرتا ہے۔ انہوں نے یونیورسٹی آف الینوائے اربانا-چمپین سے پی ایچ ڈی کی۔ وہ مشین لرننگ اور شماریاتی اندازہ میں ایک فعال محقق ہے، اور اس نے NeurIPS، ICML، ICLR، JMLR، ACL، اور EMNLP کانفرنسوں میں بہت سے مقالے شائع کیے ہیں۔

کارل البرٹسن Amazon SageMaker Algorithms اور JumpStart، SageMaker کے مشین لرننگ ہب کے لیے پروڈکٹ، انجینئرنگ اور سائنس کی رہنمائی کرتا ہے۔ وہ کاروباری قدر کو غیر مقفل کرنے کے لیے مشین لرننگ کو لاگو کرنے کا پرجوش ہے۔

کارل البرٹسن Amazon SageMaker Algorithms اور JumpStart، SageMaker کے مشین لرننگ ہب کے لیے پروڈکٹ، انجینئرنگ اور سائنس کی رہنمائی کرتا ہے۔ وہ کاروباری قدر کو غیر مقفل کرنے کے لیے مشین لرننگ کو لاگو کرنے کا پرجوش ہے۔

- SEO سے چلنے والا مواد اور PR کی تقسیم۔ آج ہی بڑھا دیں۔

- پلیٹو ڈیٹا ڈاٹ نیٹ ورک ورٹیکل جنریٹو اے آئی۔ اپنے آپ کو بااختیار بنائیں۔ یہاں تک رسائی حاصل کریں۔

- پلیٹوآئ اسٹریم۔ ویب 3 انٹیلی جنس۔ علم میں اضافہ۔ یہاں تک رسائی حاصل کریں۔

- پلیٹو ای ایس جی۔ کاربن، کلین ٹیک، توانائی ، ماحولیات، شمسی، ویسٹ مینجمنٹ یہاں تک رسائی حاصل کریں۔

- پلیٹو ہیلتھ۔ بائیوٹیک اینڈ کلینیکل ٹرائلز انٹیلی جنس۔ یہاں تک رسائی حاصل کریں۔

- ماخذ: https://aws.amazon.com/blogs/machine-learning/llama-guard-is-now-available-in-amazon-sagemaker-jumpstart/

- : ہے

- : ہے

- : نہیں

- :کہاں

- $UP

- 1

- 10

- 100

- 11

- 12

- 13

- 2021

- 39

- 7

- 8

- 9

- a

- قابلیت

- ہمارے بارے میں

- اوپر

- قبول کریں

- تک رسائی حاصل

- کے مطابق

- اکاؤنٹس

- ایکٹ

- عمل

- اعمال

- فعال

- سرگرمیوں

- اصل

- اس کے علاوہ

- ایڈجسٹ

- اپنانے

- آگے بڑھانے کے

- ترقی

- شکست

- مشورہ

- کے خلاف

- ایجنٹ

- AI

- اے آئی ماڈلز

- AI / ML

- شراب

- یلگوردمز

- تمام

- بھی

- ایمیزون

- ایمیزون سیج میکر

- ایمیزون سیج میکر جمپ اسٹارٹ

- ایمیزون ویب سروسز

- an

- اور

- اعلان کریں

- جواب

- کوئی بھی

- درخواست

- اطلاقی

- کا اطلاق کریں

- درخواست دینا

- مناسب

- کیا

- دلیل

- دلائل

- فن

- AS

- تشخیص

- مدد

- اسسٹنٹ

- منسلک

- یقین دہانی کرائی

- At

- اتھارٹی

- آٹومیٹڈ

- دستیاب

- سے اجتناب

- AWS

- کی بنیاد پر

- بنیادی

- Bayesian

- BE

- بیم

- کیونکہ

- رہا

- اس سے پہلے

- شروع کریں

- رویے

- خیال ہے

- نیچے

- معیارات

- برکلے

- BEST

- بہترین طریقوں

- کے درمیان

- اربوں

- جسم

- دونوں

- لانے

- لاتا ہے

- تعمیر

- عمارت

- تعمیر میں

- کاروبار

- لیکن

- by

- کیلی فورنیا

- کر سکتے ہیں

- بانگ

- کارڈ

- کیس

- مقدمات

- اقسام

- قسم

- سیل

- چیلنجوں

- موقع

- تبدیل

- خصوصیات

- بوجھ

- چیٹ

- چیٹ بٹس

- چیک کریں

- کیمیائی

- انتخاب

- میں سے انتخاب کریں

- منتخب کریں

- شہر

- طبقے

- صاف

- بادل

- کلاؤڈ کمپیوٹنگ

- کوڈ

- رنگ

- آنے والے

- تجارتی

- انجام دیا

- کامن

- کمیونٹی

- ہم آہنگ

- عمل

- اجزاء

- ساخت

- کمپیوٹر

- کمپیوٹر ویژن

- کمپیوٹنگ

- کانفرنس

- کانفرنسوں

- کی توثیق

- منسلک

- سنگم

- کنسول

- کھپت

- پر مشتمل ہے

- کنٹینر

- پر مشتمل ہے

- مواد

- مواد میں اعتدال

- سیاق و سباق

- جاری ہے

- کنٹرول

- کنٹرول

- کنٹرول

- بات چیت

- سنوادی

- مکالمات

- کھانا پکانے

- cornell

- سکتا ہے

- تخلیق

- مخلوق

- جرم

- فوجداری

- اہم

- cured

- گاہک

- کسٹمر سروس

- گاہکوں

- اپنی مرضی کے مطابق

- سائبر

- سائبر سیکورٹی

- سائیکل

- اعداد و شمار

- ڈیٹاسیٹس

- دن

- ضابطہ ربائی کرنا

- گہری

- گہری سیکھنے

- پہلے سے طے شدہ

- وضاحت

- تعریفیں

- ڈگری

- تعیناتی

- تعینات

- تعینات

- تعیناتی

- تعینات

- ڈیزائن

- ڈیزائن کا عمل

- خواہش

- مطلوبہ

- تفصیلی

- تفصیلات

- کھوج

- اس بات کا تعین

- کا تعین

- ترقی

- ڈیولپر

- ڈویلپرز

- ترقی

- DICT

- مختلف

- ڈیجیٹل

- ڈیجیٹل آرٹ

- معذوری

- دریافت

- تبعیض

- بات چیت

- do

- کرتا

- منشیات

- ڈیوک

- ڈیوک یونیورسٹی

- e

- ہر ایک

- اس سے قبل

- ابتدائی

- آسانی سے

- اقتصادی

- ماحول

- تعلیم

- اثرات

- بے سہل

- کو چالو کرنے کے

- کو فعال کرنا

- کی حوصلہ افزائی

- آخر

- آخر سے آخر تک

- اختتام پوائنٹ

- اختتام

- مشغول

- انجینئر

- انجنیئرنگ

- کو یقینی بنانے کے

- یقینی بناتا ہے

- ماحولیات

- برابر

- خاص طور پر

- Ether (ETH)

- اخلاقی

- کا جائزہ لینے

- اندازہ

- واقعات

- مثال کے طور پر

- اس کے علاوہ

- رعایت

- بہت پرجوش

- چھوڑ کر

- پھانسی

- موجودہ

- مہنگی

- تلاش

- ایکسپریس

- توسیع

- چہرہ

- سامنا

- جھوٹی

- خاندان

- خاصیت

- چند

- مالی

- مالی جرائم

- مل

- آتشیں ہتھیار

- پہلا

- جھنڈا لگا ہوا

- فلوٹ

- توجہ مرکوز

- پر عمل کریں

- پیچھے پیچھے

- کے بعد

- مندرجہ ذیل ہے

- کے لئے

- فارمیٹ

- فروغ

- فاؤنڈیشن

- مفت

- سے

- مکمل

- افعال

- مزید

- مستقبل

- جنس

- جنرل

- پیدا

- پیدا

- پیدا ہوتا ہے

- پیدا کرنے والے

- نسل

- پیداواری

- پیداواری AI۔

- حاصل

- GitHub کے

- دی

- دے

- Go

- جا

- ملا

- زیادہ سے زیادہ

- لالچی

- ضمانت دیتا ہے

- گارڈ

- رہنمائی

- بندوقیں

- نقصان پہنچانے

- کنٹرول

- نفرت

- ہے

- he

- صحت

- مدد

- مدد کرتا ہے

- اس کی

- یہاں

- اعلی

- لمبی پیدل سفر

- ان

- تاریخی

- میزبانی کی

- کس طرح

- کیسے

- HTML

- HTTPS

- حب

- حبس

- i

- آئی سی ایل آر

- ID

- شناخت

- شناختی

- if

- غیر قانونی

- ایلی نوائے

- فوری طور پر

- درآمد

- کو بہتر بنانے کے

- in

- شامل

- شامل ہیں

- سمیت

- آزاد

- اشارہ کرتے ہیں

- اشارہ کرتا ہے

- اشارہ کرتے ہیں

- معلومات

- معلومات

- جڑا ہوا

- ابتدائی

- انیشی ایٹو

- جدت طرازی

- ان پٹ

- آدانوں

- مثال کے طور پر

- ہدایات

- اہم کردار

- ضم

- ضم

- دلچسپی

- مفادات

- انٹرفیس

- میں

- شامل

- IT

- میں

- فوٹو

- کو مار ڈالو

- جان

- جانا جاتا ہے

- کیلی

- لینڈنگ

- لینڈنگ پیج

- زبان

- بڑے

- آخری

- قوانین

- لیڈز

- سیکھنے

- چھوڑ کر

- لمبائی

- دو

- لائسنس

- لائسنس یافتہ

- لائسنس

- کی طرح

- امکان

- امکان

- پسند

- لمیٹڈ

- لائن

- لینکس

- لسٹ

- سن

- لاما

- مقامی

- دیکھنا

- کم

- مشین

- مشین لرننگ

- برقرار رکھنے کے

- بنا

- دستی طور پر

- تیار

- بہت سے

- ماسٹر کی

- مئی..

- مطلب

- اقدامات

- میڈیا

- ذہنی

- دماغی صحت

- پیغام

- پیغامات

- میٹا

- طریقہ

- طریقوں

- شاید

- منٹ

- تخفیف

- اختلاط

- ML

- ماڈل

- ماڈل

- اعتدال پسند

- اعتدال پسند

- نگرانی

- زیادہ

- سب سے زیادہ

- موسیقی

- ضروری

- ضرور پڑھنا

- قومی

- ضرورت

- نیٹ ورک

- عصبی

- نیند نیٹ ورک

- نیورپس

- کبھی نہیں

- نئی

- NY

- نیو یارک شہر

- اگلے

- نہیں

- نوٹ بک

- نوٹ بک

- نوٹس..

- اب

- تعداد

- اعتراض

- of

- کی پیشکش

- on

- ایک

- صرف

- کھول

- کھل کر

- آپریشنل

- اختیار

- آپشنز کے بھی

- or

- نکالنے

- دیگر

- ہمارے

- باہر

- نتائج

- پیداوار

- نتائج

- پر

- خود

- ملکیت

- صفحہ

- کاغذ.

- کاغذات

- پیرامیٹر

- پیرامیٹرز

- حصہ

- خاص طور پر

- جماعتوں

- منظور

- پاسنگ

- جذباتی

- لوگ

- فی

- انجام دینے کے

- کارکردگی کا مظاہرہ

- انسان

- ذاتی

- پی ایچ ڈی

- سادہ

- منصوبہ

- منصوبہ بندی

- پلاٹا

- افلاطون ڈیٹا انٹیلی جنس

- پلیٹو ڈیٹا

- پالیسی

- مقبول

- مثبت

- ممکن

- پوسٹ

- ممکنہ

- ممکنہ طور پر

- طریقوں

- پہلے

- پیش گو

- کی تیاری

- پیش

- کی روک تھام

- پرنسپل

- ترجیح دیں

- امکان

- عمل

- عمل

- مصنوعات

- پیداوار

- منصوبے

- اشارہ کرتا ہے

- خوشحالی

- فراہم

- فراہم

- فراہم کرنے والے

- فراہم کرتا ہے

- عوامی طور پر

- شائع

- پبلشنگ

- مقاصد

- ڈال

- ازگر

- pytorch

- معیار

- جلدی سے

- ریس

- بے ترتیب پن

- رینج

- بلکہ

- تک پہنچنے

- پہنچتا ہے

- پڑھیں

- موصول

- حال ہی میں

- سفارش کی

- کا حوالہ دیتے ہیں

- کے بارے میں

- باضابطہ

- ضابطے

- متعلقہ

- جاری

- متعلقہ

- مذہب

- بار بار

- کی جگہ

- درخواستوں

- ضرورت

- تحقیق

- محقق

- وسائل

- احترام

- جواب دیں

- جواب

- ذمہ دار

- ذمہ داری سے

- باقی

- نتیجہ

- نتائج کی نمائش

- واپسی

- کا جائزہ لینے کے

- اضافہ

- رسک

- خطرہ

- سڑک موڈ

- کردار

- کردار

- قوانین

- رن

- چلتا ہے

- محفوظ

- تحفظات

- سیفٹی

- sagemaker

- سیج میکر کا اندازہ

- توسیع پذیر

- پیمانے

- سائنس

- سائنسدان

- sdk

- تلاش کریں

- تلاش

- دوسری

- سیکشن

- سیکشنز

- محفوظ بنانے

- سیکورٹی

- دیکھنا

- منتخب

- سینئر

- حساس

- سزا

- احساسات

- تسلسل

- سیریز

- سروس

- سروسز

- مقرر

- جنسی

- مشترکہ

- ہونا چاہئے

- دکھائیں

- سے ظاہر ہوا

- ظاہر

- دکھایا گیا

- ایک

- So

- سماجی

- سوشل میڈیا

- سوسائٹی

- سافٹ ویئر کی

- سافٹ ویئر انجنیئر

- حل

- حل

- خصوصی

- مخصوص

- مخصوص

- خرچ کرنا۔

- معیار

- شروع

- شروع

- شماریات

- کے اعداد و شمار

- مرحلہ

- مراحل

- ابھی تک

- رک جاتا ہے

- حکمت عملی

- حکمت عملیوں

- سٹوڈیو

- کامیاب

- اس طرح

- خود کش

- حمایت

- کی حمایت کرتا ہے

- اس بات کا یقین

- نحو

- کے نظام

- سسٹمز

- لے لو

- ٹاسک

- کاموں

- ٹیم

- سانچے

- سانچے

- ٹیسسرور

- شرائط

- ٹیسٹ

- تجربہ

- متن

- متن کی نسل

- سے

- کہ

- ۔

- مستقبل

- کے بارے میں معلومات

- چوری

- ان

- ان

- خود

- تو

- وہاں.

- یہ

- وہ

- تھرڈ

- تیسرے فریقوں

- تیسری پارٹی

- اس

- ان

- کے ذریعے

- وقت

- وقت کا سلسلہ

- کرنے کے لئے

- تمباکو

- آج

- مل کر

- ٹوکن

- ٹوکن

- کے آلے

- اوزار

- موضوعات

- اسمگلنگ

- ٹرین

- تربیت یافتہ

- ٹریننگ

- ترجمہ

- سفر

- سچ

- بھروسہ رکھو

- کوشش

- ٹرن

- اقسام

- عام طور پر

- ui

- آخر میں

- کے تحت

- سمجھ

- یونیورسٹی

- یونیورسٹی آف کیلی فورنیا

- انلاک

- جب تک

- us

- استعمال

- استعمال کی شرائط

- استعمال کیس

- استعمال کیا جاتا ہے

- رکن کا

- استعمال

- کا استعمال کرتے ہوئے

- قیمت

- اقدار

- مختلف اقسام کے

- ورژن

- لنک

- خلاف ورزی کی

- خلاف ورزی کرنا

- نقطہ نظر

- بصری

- چلنا

- چاہتے ہیں

- راستہ..

- we

- ہتھیار

- ویب

- ویب خدمات

- ویب پر مبنی ہے

- کیا

- جب

- چاہے

- جس

- ڈبلیو

- پوری

- وسیع

- گے

- ساتھ

- کے اندر

- بغیر

- لفظ

- الفاظ

- کام

- کام کا بہاؤ

- کام کر

- گا

- یارک

- آپ

- اور

- زیفیرنیٹ