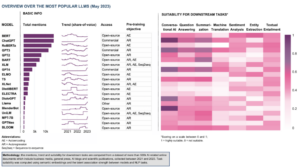

У галузі штучного інтелекту, що швидко розвивається, обробка природної мови стала центром уваги дослідників і розробників. Розбудова на фундаменті с Архітектура трансформатора та Двонаправлене оновлення BERT, за останні роки з’явилося кілька новаторських мовних моделей, які розширюють межі того, що машини можуть зрозуміти та створити.

У цій статті ми заглибимося в останні досягнення у світі великомасштабних мовних моделей, досліджуючи вдосконалення, внесені кожною моделлю, їхні можливості та потенційні застосування. Ми також розглянемо візуальні мовні моделі (VLM), які навчені обробляти не лише текстові, а й візуальні дані.

Якщо ви хочете пропустити, ось мовні моделі, які ми представили:

- GPT-3 від OpenAI

- LaMDA від Google

- PaLM від Google

- Flamingo від DeepMind

- BLIP-2 від Salesforce

- LLaMA від Meta AI

- GPT-4 від OpenAI

Якщо цей поглиблений навчальний контент стане для вас корисним, ви можете підпишіться на наш список розсилки досліджень ШІ щоб отримати попередження, коли ми випускаємо новий матеріал.

Найважливіші великі мовні моделі (LLM) і візуальні мовні моделі (VLM) у 2023 році

1. GPT-3 від OpenAI

Підсумки

Команда OpenAI представила GPT-3 як альтернативу наявності позначеного набору даних для кожного нового мовного завдання. Вони припустили, що збільшення масштабів мовних моделей може покращити продуктивність, незалежно від виконання завдань. Щоб перевірити цю пропозицію, вони навчили модель авторегресійної мови з параметрами 175B, яка називається GPT-3, і оцінив його ефективність у більш ніж двох десятках завдань НЛП. Оцінка за допомогою малократного навчання, одноразового навчання та нульового навчання показала, що GPT-3 досяг багатообіцяючих результатів і навіть інколи перевершував найсучасніші результати, досягнуті точно налаштованими моделями.

Яка мета?

- Запропонувати альтернативне вирішення існуючої проблеми, коли позначений набір даних потрібен для кожного нового мовного завдання.

Як підійти до проблеми?

- Дослідники запропонували розширити мовні моделі, щоб підвищити ефективність роботи за декілька кроків.

- Команда GPT-3 Модель використовує ту саму модель і архітектуру, що й GPT-2, включаючи модифіковану ініціалізацію, попередню нормалізацію та оборотну токенізацію.

- Однак, на відміну від GPT-2, він використовує чергування щільних та локально смугових розріджених моделей уваги в шарах трансформатора, як у Розріджений трансформатор.

Які результати?

- Модель GPT-3 без точного налаштування досягає багатообіцяючих результатів у ряді завдань НЛП і навіть іноді перевершує найсучасніші моделі, які були точно відрегульовані для цього конкретного завдання:

- на CoQA контрольний показник, 81.5 F1 у режимі нульового пострілу, 84.0 F1 у режимі одного пострілу та 85.0 F1 у налаштуваннях кількох пострілів, порівняно з оцінкою 90.7 F1, досягнутою точно налаштованою SOTA.

- на TriviaQA контрольний показник, точність 64.3% в режимі нульового пострілу, 68.0% в режимі одного пострілу та 71.2% у налаштуваннях кількох пострілів, що перевершує сучасний рівень (68%) на 3.2%.

- на LAMBADA набір даних, 76.2% точності в режимі нульового пострілу, 72.5% в режимі одного пострілу та 86.4% в налаштуванні кількох пострілів, що перевершує сучасний рівень (68%) на 18%.

- Статті новин, створені моделлю GPT-175 із параметром 3B, важко відрізнити від реальних, згідно з оцінками людей (з точністю, що ледве перевищує рівень шансу на рівні ~ 52%).

- Незважаючи на чудову продуктивність GPT-3, він отримав неоднозначні відгуки від спільноти AI:

- “Ажіотаж GPT-3 - це занадто багато. Це вражає (дякую за приємні компліменти!), Але все ж має серйозні слабкі сторони і часом робить дуже дурні помилки. ШІ збирається змінити світ, але GPT-3 - це лише дуже ранній погляд. Нам ще багато чого потрібно з’ясувати ». - Сем Альтман, генеральний директор та співзасновник OpenAI.

- "Я вражений тим, як важко генерувати текст про мусульман з GPT-3, який не має нічого спільного з насильством ... або вбивством ..." - Абубакар Абід, генеральний директор та засновник Gradio.

- "Ні. GPT-3 принципово не розуміє світу, про який говорить. Подальше збільшення корпусу дозволить йому створити більш достовірний стиль, але не виправить його фундаментальну нестачу розуміння світу. Демо-версії GPT-4 все одно вимагатимуть збирання вишні». – Гері Маркус, генеральний директор та засновник Robust.ai.

- "Екстраполяція вражаючої продуктивності GPT3 у майбутнє говорить про те, що відповідь на життя, Всесвіт і все - лише 4.398 трильйона параметрів". - Джеффрі Хінтон, лауреат премії Тьюрінга.

Де дізнатися більше про це дослідження?

Де ви можете отримати код реалізації?

- Сам код недоступний, але деякі статистичні дані набору даних разом із безумовними, нефільтрованими зразками 2048-токенів з GPT-3 опубліковані на GitHub.

2. LaMDA від Google

Підсумки

Laмова MОделі для Dдіалог Aдодатки (TheMDA) були створені в процесі тонкого налаштування групи нейронних мовних моделей на основі Transformer, спеціально розроблених для діалогів. Ці моделі мають максимум 137B параметрів і були навчені використовувати зовнішні джерела знань. Розробники LaMDA ставили перед собою три ключові цілі — якість, безпека та надійність. Результати показали, що точне налаштування дозволяє скоротити розрив якості до людського рівня, але продуктивність моделі залишалася нижчою за людський рівень щодо безпеки та заземлення.

Бард Google, випущений нещодавно як альтернатива ChatGPT, підтримується LaMDA. Незважаючи на те, що Барда часто називають нудний, це можна розглядати як доказ відданості Google пріоритету безпеки, навіть в умовах гострого суперництва між Google і Microsoft за встановлення домінування у сфері генеративного ШІ.

Яка мета?

- Побудувати модель для діалогових програм із відкритим доменом, де агент діалогу може спілкуватися на будь-яку тему з розумними, специфічними для контексту, заснованими на надійних джерелах і етичними.

Як підійти до проблеми?

- LaMDA побудовано на Трансформатор, архітектура нейронної мережі, яку Google Research винайшла та відкрила у 2017 році.

- Як і інші великі мовні моделі, включаючи BERT і GPT-3, LaMDA навчається на терабайтах текстових даних, щоб дізнатися, як слова співвідносяться одне з одним, а потім передбачити, які слова, ймовірно, будуть наступними.

- Однак, на відміну від більшості мовних моделей, LaMDA навчили діалогу, щоб вловити нюанси, які відрізняють відкриту розмову від інших форм мови.

- Модель також налаштована для підвищення чутливості, безпеки та конкретності відповідей. Хоча такі фрази, як «це добре» та «Я не знаю», можуть бути значущими в багатьох діалогових сценаріях, вони навряд чи призведуть до цікавих і привабливих розмов.

- Генератор LaMDA спочатку генерує кілька варіантів відповідей, які оцінюються на основі того, наскільки вони безпечні, розумні, конкретні та цікаві. Відповіді з низькими показниками безпеки відфільтровуються, а потім як відповідь вибирається результат із найвищим рейтингом.

Які результати?

- Численні експерименти показують, що LaMDA може брати участь у відкритих бесідах на різноманітні теми.

- Серія якісних оцінок підтвердила, що відповіді моделі, як правило, розумні, конкретні, цікаві та засновані на надійних зовнішніх джерелах, але все ще є місце для вдосконалення.

- Незважаючи на весь прогрес, досягнутий до цього часу, автори визнають, що модель все ще має багато обмежень, які можуть призвести до створення неналежних або навіть шкідливих реакцій.

Де дізнатися більше про це дослідження?

Де ви можете отримати код реалізації?

- Реалізація PyTorch з відкритим кодом для архітектури LaMDA перед навчанням доступна на GitHub.

3. PaLM від Google

Підсумки

Paшляхи Lтуга Mодель (PaLM) — це 540-мільярдна модель мови на основі Transformer. Навчання PaLM проходило на чіпах 6144 TPU v4 із використанням Pathways, нової системи ML для ефективного навчання кількох модулів TPU. Модель демонструє переваги масштабування в короткочасному навчанні, досягаючи найсучасніших результатів на сотнях тестів розуміння мови та генерації. PaLM перевершує налаштовані найсучасніші моделі в багатоетапних завданнях міркування та перевищує середню продуктивність людини на тесті BIG-bench.

Яка мета?

- Покращити розуміння того, як масштабування великих мовних моделей впливає на короткочасне навчання.

Як підійти до проблеми?

- Ключова ідея полягає в тому, щоб масштабувати навчання моделі мови з 540 мільярдами параметрів за допомогою системи Pathways:

- Команда використовувала паралелізм даних на рівні Pod у двох Cloud TPU v4 Pods, одночасно використовуючи стандартні дані та паралельність моделі всередині кожного Pod.

- Вони змогли масштабувати навчання до 6144 чіпів TPU v4, найбільшої конфігурації системи на основі TPU, яка використовувалася для навчання на сьогоднішній день.

- Модель досягла ефективності навчання 57.8% використання апаратних FLOP, що, як стверджують автори, є найвищою ефективністю навчання для великих мовних моделей у цьому масштабі.

- Навчальні дані для моделі PaLM включали комбінацію англійських та багатомовних наборів даних, що містять високоякісні веб-документи, книги, Вікіпедію, бесіди та код GitHub.

Які результати?

- Численні експерименти демонструють, що продуктивність моделі різко зросла, коли команда перейшла до своєї найбільшої моделі.

- PaLM 540B досяг проривної продуктивності в багатьох дуже складних завданнях:

- Розуміння мови та покоління. Представлена модель перевершила продуктивність попередніх великих моделей у 28 із 29 завдань, які включають завдання з відповідями на запитання, завдання на завершення речень, завдання на розуміння прочитаного в контексті, завдання на здоровий глузд, завдання SuperGLUE та більше. Ефективність PaLM у виконанні завдань BIG-стенду показала, що він може розрізняти причину та наслідок, а також розуміти концептуальні комбінації у відповідних контекстах.

- Обґрунтування. За допомогою підказки з 8-ми кадрів PaLM вирішує 58% проблем у GSM8K, еталоні тисячі складних математичних питань початкової школи, перевершуючи попередній найкращий результат у 55%, досягнутий шляхом точного налаштування моделі GPT-3 175B. PaLM також демонструє здатність генерувати чіткі пояснення в ситуаціях, які вимагають складної комбінації багатоетапного логічного висновку, знання світу та глибокого розуміння мови.

- Генерація коду. PaLM працює на рівні з налаштованим Codex 12B, використовуючи для навчання в 50 разів менше коду Python, що підтверджує, що великі мовні моделі передають навчання як з інших мов програмування, так і з даних природної мови більш ефективно.

Де дізнатися більше про це дослідження?

Де ви можете отримати код реалізації?

- Неофіційна реалізація PyTorch конкретної архітектури Transformer з наукової статті PaLM доступна на GitHub. Він не масштабується та публікується лише з освітньою метою.

4. Flamingo від DeepMind

Підсумки

Flamingo — це найсучасніше сімейство візуальних мовних моделей (VLM), навчених на великомасштабних мультимодальних веб-корпусах із змішаним текстом і зображеннями. За допомогою цього навчання моделі можуть адаптуватися до нових завдань, використовуючи мінімальні анотовані приклади, які надаються як підказка. Flamingo включає в себе ключові архітектурні вдосконалення, розроблені для об’єднання сильних сторін попередньо підготовлених лише зорових і лише мовних моделей, обробки послідовностей візуальних і текстових даних зі змінним чергуванням і безперебійного розміщення зображень і відео як вхідних даних. Моделі демонструють вражаючу адаптованість до ряду завдань із зображеннями та відео, таких як візуальні відповіді на запитання, завдання з субтитрами та візуальні відповіді на запитання з кількома варіантами вибору, встановлюючи нові стандарти продуктивності, використовуючи підказки для конкретних завдань у короткочасному навчанні.

Яка мета?

- Щоб досягти прогресу в наданні мультимодальним моделям можливості швидко навчатися та виконувати нові завдання на основі коротких інструкцій:

- Широко поширена парадигма попереднього навчання моделі на великій кількості контрольованих даних, а потім її тонкого налаштування для конкретного завдання, потребує ресурсів і вимагає тисяч анотованих точок даних разом із ретельним налаштуванням гіперпараметрів для кожного завдання.

- Сучасні моделі, які використовують контрастний об’єктив, дозволяють швидко адаптуватися до нових завдань, але не вирішують більш відкритих завдань, таких як субтитри чи візуальні відповіді на запитання, оскільки їм бракує можливостей генерування мови.

- Це дослідження має на меті представити нову модель, яка ефективно вирішує ці проблеми та демонструє чудову продуктивність у режимах з низьким рівнем даних.

Як підійти до проблеми?

- DeepMind представив Flamingo, VLM, розроблений для короткочасного навчання різноманітним відкритим баченням і мовним завданням, використовуючи лише кілька прикладів введення/виведення.

- Моделі Flamingo — це візуально обумовлені авторегресійні моделі генерації тексту, які можуть обробляти текстові маркери, змішані з зображеннями та/або відео, і генерувати текст як вихідні дані.

- Архітектура Flamingo включає дві взаємодоповнюючі попередньо навчені та заморожені моделі:

- Модель зору, здатна «сприймати» візуальні сцени.

- Велика модель мови, завданням якої є виконання основних міркувань.

- Компоненти нової архітектури інтегрують ці моделі таким чином, щоб зберегти знання, отримані під час попереднього навчання, яке потребує інтенсивного обчислення.

- Крім того, моделі Flamingo мають архітектуру на основі Perceiver, що дозволяє їм завантажувати зображення або відео високої роздільної здатності. Ця архітектура може генерувати фіксовану кількість візуальних маркерів на зображення/відео з широкого та змінного набору функцій візуального введення.

Які результати?

- Дослідження показує, що, подібно до LLM, які добре навчаються, VLM можуть навчатися на кількох прикладах введення/виведення для завдань із розуміння зображень і відео, таких як класифікація, субтитри або відповіді на запитання.

- Flamingo встановлює новий стандарт у швидкому навчанні, демонструючи чудову продуктивність у широкому діапазоні 16 мультимодальних мовних завдань і завдань із розумінням зображень/відео.

- Для 6 із цих 16 завдань Flamingo перевершує продуктивність точно налаштованого сучасного рівня техніки, навіть якщо він використовує лише 32 приклади для конкретних завдань – приблизно в 1000 разів менше навчальних даних для конкретних завдань, ніж поточні найефективніші моделі.

Де дізнатися більше про це дослідження?

Де ви можете отримати код реалізації?

- DeepMind не випускав офіційну реалізацію Flamingo.

- Ви можете знайти реалізацію представленого підходу з відкритим кодом у OpenFlamingo Github Repo.

- Доступна альтернативна реалізація PyTorch тут.

5. BLIP-2 від Salesforce

Підсумки

BLIP-2 — це ефективна загальна структура попереднього навчання для моделей зору та мови, розроблена для того, щоб обійти все більш непомірну вартість попереднього навчання великомасштабних моделей. BLIP-2 використовує готові заморожені попередньо навчені кодери зображень і заморожені великі мовні моделі для початкового попереднього навчання візуальної мови, включаючи легкий Querying Transformer, попередньо навчений у два етапи. Перший етап ініціює навчання репрезентації візуальної мови за допомогою кодера замороженого зображення, а другий етап забезпечує генеративне навчання візуального представлення мови з моделі замороженої мови. Незважаючи на значно меншу кількість параметрів, які можна навчити, BLIP-2 перевершує найсучасніші методи, перевершуючи Flamingo80B від DeepMind на 8.7% на VQAv2 з нульовим ударом із у 54 рази меншими параметрами, які можна навчити. Модель також демонструє багатообіцяючі можливості нульового генерування зображення в текст, дотримуючись інструкцій природною мовою.

Яка мета?

- Щоб отримати найсучаснішу продуктивність у завданнях мови візуалізації, одночасно зменшуючи витрати на обчислення.

Як підійти до проблеми?

- Команда Salesforce представила нову структуру попереднього навчання мовою бачення під назвою BLIP-2, Bвідстібання Lмова-Iмаг Pповторне навчання із замороженими унімодальними моделями:

- Попередньо навчені унімодальні моделі залишаються замороженими під час попереднього навчання, щоб зменшити витрати на обчислення та уникнути проблеми катастрофічного забування.

- Щоб полегшити крос-модальне вирівнювання та подолати розрив модальності між попередньо навченими моделями зору та попередньо навченими мовними моделями, команда пропонує легкий перетворювач запитів (Q-Former), який діє як вузьке місце інформації між кодувальником замороженого зображення та замороженим магістр права

- Q-former попередньо навчений нової двоетапної стратегії:

- На першому етапі попереднього навчання виконується навчання репрезентації зорової мови. Це змушує Q-Former вивчати візуальне представлення, яке найбільше відповідає тексту.

- На другому етапі попереднього навчання виконується генеративне навчання від бачення до мови шляхом підключення виходу Q-Former до замороженого LLM. Q-Former навчений так, що його вихідне візуальне представлення може бути інтерпретоване LLM.

Які результати?

- BLIP-2 забезпечує виняткові найсучасніші результати для різноманітних завдань, пов’язаних із мовою зору, охоплюючи візуальні відповіді на запитання, підписи до зображень і пошук текстових зображень.

- Наприклад, він перевершує Flamingo на 8.7% на VQAv2 з нульовим ударом.

- Крім того, ця видатна продуктивність досягається завдяки значно вищій ефективності комп’ютера:

- BLIP-2 перевершує Flamingo-80B, використовуючи в 54 рази менше параметрів, які можна навчити.

- BLIP-2 має здатність здійснювати нульову генерацію зображення в текст у відповідь на інструкції природної мови, тим самим прокладаючи шлях для розвитку таких навичок, як візуальне мислення та візуальна розмова.

- Нарешті, важливо відзначити, що BLIP-2 — це універсальний підхід, який може використовувати складніші унімодальні моделі для подальшого підвищення ефективності попереднього навчання зорової мови.

Де дізнатися більше про це дослідження?

Де ви можете отримати код реалізації?

Офіційна реалізація BLIP-2 доступна на GitHub.

6. LLaMA від Meta AI

Підсумки

Команда Meta AI стверджує, що менші моделі, навчені на більшій кількості токенів, легше перенавчати та налаштовувати для конкретних програм продукту. Тому вводять LlaMA (Lарг Laмова Mодель Мета AI), набір базових мовних моделей із параметрами від 7B до 65B. LLaMA 33B і 65B були навчені на 1.4 трильйона токенів, тоді як найменша модель, LLaMA 7B, була навчена на одному трильйоні токенів. Вони використовували виключно загальнодоступні набори даних, незалежно від конфіденційних чи обмежених даних. Команда також реалізувала ключові архітектурні вдосконалення та методи оптимізації швидкості навчання. Отже, LLaMA-13B перевершив GPT-3, будучи більш ніж у 10 разів меншим, а LLaMA-65B продемонстрував конкурентоспроможність з PaLM-540B.

Яка мета?

- Щоб продемонструвати доцільність навчання найефективніших моделей виключно на загальнодоступних наборах даних, не покладаючись на власні чи обмежені джерела даних.

- Щоб надати дослідницькому співтовариству менші та ефективніші моделі та, таким чином, дозволити тим, хто не має доступу до великої кількості інфраструктури, вивчати великі мовні моделі.

Як підійти до проблеми?

- Для навчання моделі LLaMA дослідники використовували лише загальнодоступні дані, сумісні з відкритим кодом.

- Вони також внесли кілька покращень у стандартну архітектуру Transformer:

- Приймаючи методологію GPT-3, стабільність навчання була підвищена за рахунок нормалізації входу для кожного підрівня трансформатора, а не нормалізації виходу.

- Натхненні моделями PaLM, дослідники замінили нелінійність ReLU функцією активації SwiGLU, щоб покращити продуктивність.

- Натхненний Су та інші (2021), вони усунули абсолютні позиційні вбудовування та замість цього включили поворотні позиційні вбудовування (RoPE) на кожному рівні мережі.

- Нарешті, команда Meta AI покращила швидкість навчання своєї моделі за допомогою:

- Використання ефективного причинно-наслідкового привернення уваги до багатьох голов, не зберігаючи вагові коефіцієнти уваги або обчислюючи замасковані показники ключів/запитів.

- Використання контрольних точок для мінімізації повторно обчислених активацій під час зворотного проходу.

- Перекриття обчислення активацій і зв’язку між графічними процесорами через мережу (через операції all_reduce).

Які результати?

- LLaMA-13B перевершує GPT-3, незважаючи на те, що він більш ніж у 10 разів менший, тоді як LLaMA-65B тримається в порівнянні з PaLM-540B.

Де дізнатися більше про це дослідження?

Де ви можете отримати код реалізації?

- Meta AI надає доступ до LLaMA академічним дослідникам, особам, пов’язаним з урядом, громадянським суспільством, академічними установами та глобальними галузевими дослідницькими лабораторіями на основі індивідуальної оцінки випадку. Щоб подати заявку, перейдіть до наступного GitHub сховище.

7. GPT-4 від OpenAI

Підсумки

GPT-4 це великомасштабна мультимодальна модель, яка приймає вхідні зображення та текст і генерує текстові виходи. З міркувань конкуренції та безпеки конкретні подробиці про архітектуру та навчання моделі не надаються. З точки зору продуктивності GPT-4 перевершує попередні мовні моделі за традиційними тестами та показує значні покращення в розумінні намірів користувача та властивості безпеки. Модель також досягає продуктивності на рівні людини на різних іспитах, включаючи найкращі 10% балів на симульованому єдиному іспиті адвоката.

Яка мета?

- Розробити великомасштабну мультимодальну модель, яка може приймати вхідні зображення та текст і створювати текстові виходи.

- Для розробки інфраструктури та методів оптимізації, які передбачувано поводяться в широкому діапазоні масштабів.

Як підійти до проблеми?

- Зважаючи на наслідки для конкуренції та безпеки, OpenAI вирішила не розголошувати подробиці щодо архітектури, розміру моделі, апаратного забезпечення, навчальних обчислень, побудови набору даних і методів навчання.

- Вони розкривають, що:

- GPT-4 — це модель на основі Transformer, попередньо навчена передбачати наступний маркер у документі.

- Він використовує загальнодоступні дані та сторонні ліцензовані дані.

- Модель було налаштовано за допомогою навчання з підкріпленням із зворотного зв’язку людини (RLHF).

- Непідтверджена інформація свідчить про те, що GPT-4 — це не єдина щільна модель, як її попередники, а потужна коаліція з восьми окремих моделей, кожна з яких містить приголомшливі 220 мільярдів параметрів.

Які результати?

- GPT-4 досягає продуктивності на рівні людини на більшості професійних і академічних іспитів, особливо в 10% найкращих результатів на імітаційному єдиному іспиті адвоката.

- Попередньо навчена базова модель GPT-4 перевершує існуючі мовні моделі та попередні сучасні системи на традиційних тестах НЛП, без спеціального тестування або додаткових протоколів навчання.

- GPT-4 демонструє суттєве покращення у відстеженні намірів користувача, оскільки його відповіді надають перевагу порівняно з відповідями GPT-3.5 у 70.2% із 5,214 запитів від ChatGPT та OpenAI API.

- Властивості безпеки GPT-4 значно покращилися порівняно з GPT-3.5: на 82% менше відповідей на запити забороненого вмісту та на 29% більше відповідності політикам для конфіденційних запитів (наприклад, медичні поради та самоушкодження).

Де дізнатися більше про це дослідження?

Де ви можете отримати код реалізації?

- Реалізація коду GPT-4 недоступна.

Застосування великих (візійних) мовних моделей у реальному світі

Найбільш значні прориви в дослідженнях штучного інтелекту за останні роки відбулися завдяки великим моделям штучного інтелекту, навченим на величезних наборах даних. Ці моделі демонструють вражаючу продуктивність, і захоплююче уявити, як ШІ може революціонізувати цілі галузі, такі як обслуговування клієнтів, маркетинг, електронна комерція, охорона здоров’я, розробка програмного забезпечення, журналістика та багато інших.

Великі мовні моделі мають численні застосування в реальному світі. GPT-4 містить наступне:

- Розуміння та генерація природної мови для чат-ботів і віртуальних помічників.

- Машинний переклад між мовами.

- Реферат статей, доповідей або інших текстових документів.

- Аналіз настроїв для дослідження ринку або моніторингу соціальних мереж.

- Створення контенту для маркетингу, соціальних медіа чи творчого письма.

- Системи запитань і відповідей для підтримки клієнтів або баз знань.

- Класифікація тексту для фільтрації спаму, категоризації за темами або організації документів.

- Персоналізовані інструменти для вивчення мови та навчання.

- Допомога у створенні коду та розробці програмного забезпечення.

- Аналіз та супровід медичної, юридичної та технічної документації.

- Інструменти доступності для людей з обмеженими можливостями, такі як перетворення тексту в мовлення та перетворення мовлення в текст.

- Послуги розпізнавання мовлення та транскрипції.

Якщо додати візуальну частину, то області можливих застосувань розширяться:

Дуже цікаво стежити за нещодавніми досягненнями у сфері штучного інтелекту та думати про їхні потенційні застосування в реальному світі. Однак перед розгортанням цих моделей у реальному житті нам потрібно розглянути відповідні ризики та обмеження, які, на жаль, досить значні.

Ризики та обмеження

Якщо ви запитаєте GPT-4 про його ризики та обмеження, він, швидше за все, надасть вам довгий список відповідних проблем. Проглянувши цей список і додавши деякі додаткові міркування, я отримав наступний набір ключових ризиків і обмежень, які мають сучасні великі мовні моделі:

- Упередженість і дискримінація: Ці моделі навчаються на величезній кількості текстових даних, які часто містять упередження та дискримінаційний вміст. У результаті отримані результати можуть ненавмисно увічнити стереотипи, образливу мову та дискримінацію за такими факторами, як стать, раса чи релігія.

- Дезінформація: Великі мовні моделі можуть генерувати фактично неправильний, оманливий або застарілий вміст. Хоча моделі навчаються на різноманітних джерелах, вони не завжди можуть надавати найточнішу чи найновішу інформацію. Часто це трапляється через те, що модель надає пріоритет генерації результатів, які є граматично правильними або здаються зв’язними, навіть якщо вони вводять в оману.

- Відсутність розуміння: хоча ці моделі, здається, розуміють людську мову, вони працюють переважно шляхом визначення закономірностей і статистичних зв’язків у навчальних даних. Вони не мають глибокого розуміння контенту, який вони генерують, що іноді може призвести до безглуздих або нерелевантних результатів.

- Невідповідний вміст: мовні моделі іноді можуть генерувати вміст, який є образливим, шкідливим або неприйнятним. Хоча докладаються зусилля, щоб звести до мінімуму такий вміст, він все одно може статися через характер навчальних даних і нездатність моделей розпізнати контекст або наміри користувача.

Висновок

Великі мовні моделі, безсумнівно, зробили революцію в області обробки природної мови та продемонстрували величезний потенціал у підвищенні продуктивності в різних ролях і галузях. Їхня здатність генерувати текст, схожий на людину, автоматизувати повсякденні завдання та надавати допомогу в творчих і аналітичних процесах зробила їх незамінними інструментами в сучасному швидкоплинному, орієнтованому на технології світі.

Проте вкрай важливо визнати та зрозуміти обмеження та ризики, пов’язані з цими потужними моделями. Не можна ігнорувати такі проблеми, як упередженість, дезінформація та можливість зловмисного використання. Оскільки ми продовжуємо інтегрувати ці технології, керовані штучним інтелектом, у наше повсякденне життя, важливо знайти баланс між використанням їхніх можливостей і забезпеченням нагляду з боку людини, особливо в чутливих ситуаціях і ситуаціях високого ризику.

Якщо нам вдасться відповідально запровадити генеративні технології штучного інтелекту, ми прокладемо шлях до майбутнього, де штучний інтелект і людський досвід працюватимуть разом, щоб стимулювати інновації та створювати кращий світ для всіх.

Вам подобається ця стаття? Підпишіться на отримання нових оновлень щодо досліджень ШІ.

Ми повідомимо вас, коли випустимо більше таких підсумкових статей, як ця.

споріднений

- Розповсюдження контенту та PR на основі SEO. Отримайте посилення сьогодні.

- PlatoData.Network Vertical Generative Ai. Додайте собі сили. Доступ тут.

- PlatoAiStream. Web3 Intelligence. Розширення знань. Доступ тут.

- ПлатонЕСГ. Автомобільні / електромобілі, вуглець, CleanTech, Енергія, Навколишнє середовище, Сонячна, Поводження з відходами. Доступ тут.

- BlockOffsets. Модернізація екологічної компенсаційної власності. Доступ тут.

- джерело: https://www.topbots.com/top-language-models-transforming-ai-in-2023/

- : має

- :є

- : ні

- :де

- $UP

- 1

- 10

- 12b

- 16

- 2%

- 2017

- 2021

- 2023

- 214

- 220

- 28

- 32

- 50

- 7

- 70

- 710

- 72

- 8

- 84

- 90

- a

- здатність

- Здатний

- МЕНЮ

- вище

- абсолют

- академічний

- Прийняти

- Приймає

- доступ

- доступною

- розмістити

- За

- точність

- точний

- досягнутий

- Досягає

- досягнення

- визнавати

- через

- Активація

- активації

- акти

- пристосовувати

- адаптація

- додавати

- додати

- доповнення

- Додатковий

- адреса

- адреси

- Прийняття

- досягнення

- рада

- після

- проти

- Агент

- AI

- ai дослідження

- Цілі

- AL

- так

- ВСІ

- дозволяти

- Дозволити

- дозволяє

- по

- Також

- альтернатива

- хоча

- завжди

- посеред

- серед

- кількість

- суми

- an

- аналіз

- Аналітичний

- та

- Інший

- відповідь

- будь-який

- API

- з'являтися

- застосування

- Застосовувати

- підхід

- відповідний

- приблизно

- архітектурний

- архітектура

- ЕСТЬ

- області

- навколо

- масив

- Art

- стаття

- статті

- штучний

- штучний інтелект

- AS

- Допомога

- помічники

- асоційований

- асоціаціях

- At

- увагу

- authors

- автоматизувати

- доступний

- середній

- уникнути

- нагорода

- Balance

- бар

- база

- заснований

- основний

- основа

- BE

- оскільки

- ставати

- перед тим

- буття

- нижче

- еталонний тест

- тести

- Переваги

- Краще

- між

- зміщення

- упередження

- Мільярд

- книги

- Bootstrap

- обидва

- Межі

- прорив

- прориви

- BRIDGE

- широкий

- будувати

- Створюємо

- побудований

- але

- by

- званий

- CAN

- кандидат

- не може

- можливості

- здатний

- потужність

- обережний

- випадок

- катастрофічний

- Викликати

- Генеральний директор

- Генеральний директор та засновник

- складні

- шанс

- зміна

- chatbots

- ChatGPT

- Чіпси

- стверджувати

- класифікація

- хмара

- Співзасновник

- код

- КОГЕРЕНТНИЙ

- збір

- поєднання

- комбінації

- Приходити

- зобов'язання

- Комунікація

- співтовариство

- порівняний

- сумісний

- конкурентоспроможний

- взаємодоповнюючі

- комплекс

- дотримання

- Компоненти

- обчислення

- обчислення

- комп'ютер

- обчислення

- концептуальний

- Турбота

- конфігурація

- Підтверджено

- З'єднувальний

- Отже

- міркування

- будівництво

- зміст

- контекст

- контексти

- продовжувати

- контрастність

- Розмова

- розмови

- Перетворення

- виправити

- Відповідний

- Коштувати

- витрати

- може

- створювати

- створений

- Креатив

- достовірний

- вирішальне значення

- Поточний

- клієнт

- Контакти

- підтримка клієнтів

- передовий

- щодня

- дані

- точки даних

- набори даних

- Дата

- вирішене

- зменшити

- глибокий

- Deepmind

- постачає

- демонструвати

- продемонстрований

- демонструє

- демонстрація

- Демос

- Залежно

- розгортання

- призначений

- Незважаючи на

- деталі

- розвивати

- розробників

- розвивається

- розробка

- Діалог

- Діалог

- важкий

- інвалідності

- Розкрити

- дискримінація

- розрізняти

- Різне

- do

- документ

- документація

- робить

- Панування

- Не знаю

- дюжина

- управляти

- охрестили

- два

- під час

- e

- e-commerce

- E&T

- кожен

- Рано

- легше

- освітній

- ефект

- фактично

- ефективність

- ефективний

- зусилля

- усувається

- з'явився

- включіть

- дозволяє

- охоплюючий

- залучення

- англійська

- підвищувати

- підвищена

- Удосконалення

- підвищення

- забезпечення

- істотний

- встановити

- встановлює

- етичний

- оцінюється

- оцінка

- оцінки

- Навіть

- Кожен

- все

- докази

- еволюціонує

- експертиза

- приклад

- Приклади

- перевищує

- винятковий

- захоплюючий

- виключно

- експонати

- існуючий

- Розширювати

- Експерименти

- експертиза

- Дослідження

- зовнішній

- f1

- фасилітувати

- фактори

- Падати

- сім'я

- далеко

- захоплюючий

- швидкий темп

- особливість

- ознаками

- риси

- зворотний зв'язок

- кілька

- менше

- поле

- Рисунок

- фільтрація

- знайти

- Перший

- виправляти

- фіксованою

- стежити

- після

- для

- форми

- Підвалини

- засновник

- Рамки

- від

- заморожені

- функція

- фундаментальний

- принципово

- далі

- майбутнє

- отримала

- розрив

- Стать

- породжувати

- генерується

- генерує

- породжує

- покоління

- генеративний

- Генеративний ШІ

- generator

- отримати

- GitHub

- Проблиск

- Глобальний

- Go

- мета

- буде

- добре

- Google,

- Уряд

- Графічні процесори

- клас

- новаторський

- Group

- було

- відбувається

- Жорсткий

- апаратні засоби

- шкідливий

- Мати

- має

- охорона здоров'я

- тут

- високоякісний

- висока роздільна здатність

- високий ризик

- вище

- найвищий

- тримає

- Як

- Однак

- HTML

- HTTPS

- величезний

- людина

- Сотні

- обман

- Налаштування гіперпараметрів

- ідея

- ідентифікує

- if

- зображення

- зображень

- величезний

- реалізація

- реалізовані

- наслідки

- важливо

- вражаючий

- удосконалювати

- поліпшений

- поліпшення

- поліпшення

- in

- поглиблений

- нездатність

- включати

- включені

- У тому числі

- Зареєстрований

- об'єднує

- включення

- Augmenter

- збільшений

- зростаючий

- все більше і більше

- індивідуальний

- осіб

- промисловості

- промисловість

- інформація

- Інфраструктура

- Посвячені

- інновація

- вхід

- витрати

- замість

- установи

- інструкції

- інтегрувати

- Інтелект

- намір

- цікавий

- в

- вводити

- введені

- Винайдений

- питання

- питання

- IT

- ЙОГО

- сам

- журналістика

- JPG

- просто

- ключ

- ключові цілі

- Знати

- знання

- Labs

- відсутність

- ландшафт

- мова

- мови

- великий

- масштабний

- найбільших

- останній

- шар

- шарів

- вести

- УЧИТЬСЯ

- вивчення

- легальний

- менше

- рівень

- рівні

- Важіль

- важелі

- використання

- Ліцензований

- життя

- легкий

- як

- Ймовірно

- недоліки

- список

- списки

- Місце проживання

- Лама

- локально

- логічний

- Довго

- подивитися

- серія

- низький

- Машинки для перманенту

- made

- зробити

- РОБОТИ

- багато

- Маркус

- ринок

- дослідження ринку

- Маркетинг

- матеріал

- математики

- макс-ширина

- максимальний

- Може..

- значущим

- Медіа

- медичний

- Злиття

- Meta

- Методологія

- методика

- Microsoft

- mind

- мінімальний

- Дезінформація

- вводить в оману

- помилки

- змішаний

- ML

- модель

- Моделі

- сучасний

- модифікований

- моніторинг

- більше

- найбільш

- багато

- множинний

- Мусульмани

- Природний

- Природна мова

- Обробка природних мов

- природа

- Необхідність

- необхідний

- мережу

- Нейронний

- Нейронна мова

- нейронної мережі

- Нові

- новини

- наступний

- приємно

- nlp

- особливо

- нічого

- номер

- численний

- мета

- цілей

- відбуваються

- of

- наступ

- офіційний

- часто

- on

- ONE

- ті,

- тільки

- відкрити

- з відкритим вихідним кодом

- OpenAI

- працювати

- операції

- оптимізація

- or

- організація

- Інше

- інші

- наші

- з

- випереджаючий

- Переважає

- вихід

- видатний

- над

- власний

- долоню

- Папір

- парадигма

- параметр

- параметри

- частина

- брати участь

- особливо

- проходити

- моделі

- прокладати

- Мощення

- для

- виконувати

- продуктивність

- виконанні

- виступає

- фрази

- вибирати

- plato

- Інформація про дані Платона

- PlatoData

- Стручки

- точка

- точок

- Політика

- це можливо

- потенціал

- Харчування

- потужний

- передбачати

- переважним

- попередній

- в першу чергу

- попередній

- визначення пріоритетів

- Проблема

- проблеми

- процес

- процеси

- обробка

- виробляти

- Product

- продуктивність

- професійний

- Програмування

- мови програмування

- прогрес

- перспективний

- властивості

- пропонує

- власником

- протоколи

- забезпечувати

- за умови

- забезпечує

- публічно

- опублікований

- цілей

- Натискання

- Python

- піторх

- якісний

- якість

- питання

- питань

- швидко

- Гонки

- діапазон

- швидко

- швидше

- читання

- реальний

- справжнє життя

- Реальний світ

- останній

- нещодавно

- визнання

- визнавати

- зменшити

- зниження

- режими

- навчання

- звільнити

- випущений

- доречний

- надійний

- надійні джерела

- релігія

- покладаючись

- залишатися

- залишився

- чудовий

- замінити

- Звіти

- подання

- запитів

- вимагати

- Вимагається

- дослідження

- Дослідницьке співтовариство

- Дослідники

- ресурсомісткий

- повага

- відповідаючи

- відповідь

- відповіді

- обмежений

- результат

- результати

- зберігає

- Відгуки

- здійснити революцію

- революціонізували

- ризики

- суперництво

- міцний

- ролі

- Кімната

- сейф

- Безпека

- Salesforce

- то ж

- шкала

- ваги

- Масштабування

- сценарії

- сцени

- Школа

- рахунок

- безліч

- рахунок

- плавно

- другий

- здається

- бачив

- обраний

- чутливий

- окремий

- Серія

- серйозний

- обслуговування

- Послуги

- комплект

- установка

- кілька

- приголомшений

- Короткий

- Показувати

- показав

- Шоу

- підпис

- значний

- істотно

- Аналогічно

- особливий

- ситуацій

- Розмір

- навички

- менше

- So

- так далеко

- соціальна

- соціальні медіа

- суспільство

- Софтвер

- розробка програмного забезпечення

- виключно

- рішення

- Вирішує

- деякі

- складний

- Source

- Джерела

- Про

- спам

- конкретний

- конкретно

- специфічність

- ефектний

- мовлення в текст

- швидкість

- Стабільність

- Стажування

- етапи

- standard

- стандартів

- стан

- впроваджений

- статистичний

- статистика

- Як і раніше

- Стратегія

- сильні сторони

- удар

- Вивчення

- істотний

- процвітати

- такі

- пропонувати

- Запропонує

- РЕЗЮМЕ

- чудовий

- нагляд

- підтримка

- перевершив

- система

- Systems

- Переговори

- Завдання

- завдання

- команда

- технічний

- методи

- Технології

- terms

- тест

- генерація тексту

- Перетворення тексту в мову

- ніж

- Дякую

- Що

- Команда

- Майбутнє

- Держава

- світ

- їх

- Їх

- потім

- Там.

- тим самим

- отже

- Ці

- вони

- думати

- третя сторона

- це

- ті

- хоча?

- тисячі

- три

- через

- times

- до

- сьогоднішній

- разом

- знак

- Токенізація

- Жетони

- занадто

- інструменти

- топ

- ТОПБОТИ

- тема

- теми

- до

- традиційний

- поїзд

- навчений

- Навчання

- переклад

- трансформатор

- перетворення

- Переклад

- трильйон

- турінг

- репетиторство

- два

- безумовно

- при

- розуміти

- розуміння

- вживати

- безсумнівно

- на жаль

- Всесвіт

- на відміну від

- відповідний сучасним вимогам

- Updates

- використання

- використовуваний

- користувач

- використовує

- використання

- використовує

- різноманітність

- різний

- величезний

- різнобічний

- дуже

- Відео

- Відео

- Віртуальний

- бачення

- VOX

- було

- шлях..

- we

- Web

- ДОБРЕ

- були

- Що

- коли

- який

- в той час як

- ВООЗ

- всі

- широкий

- Широкий діапазон

- Вікіпедія

- волі

- з

- в

- без

- слова

- Work

- працювати разом

- світ

- лист

- років

- ще

- ви

- зефірнет

- Zero-Shot Навчання