Дослідники корпорації Intel опублікували технічну статтю під назвою «Ефективне рішення LLM для висновків на GPU Intel».

Анотація:

«Великі мовні моделі (LLM) на основі трансформаторів широко використовуються в багатьох галузях, і ефективність висновків LLM стає гарячою темою в реальних програмах. Однак LLM зазвичай складно розроблені в модельній структурі з масивними операціями та виконують висновок у авторегресивному режимі, що робить складним завданням розробити систему з високою ефективністю.

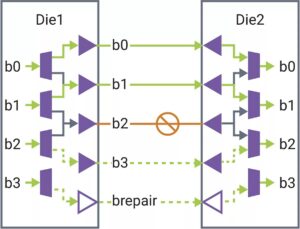

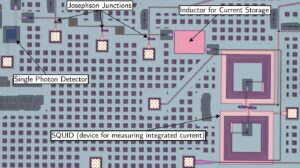

У цій статті ми пропонуємо ефективне рішення LLM для логічного висновку з низькою затримкою та високою пропускною здатністю. По-перше, ми спрощуємо рівень декодера LLM, поєднуючи переміщення даних і поелементні операції, щоб зменшити частоту доступу до пам’яті та затримку системи. Ми також пропонуємо сегментну політику кешу KV, щоб зберігати ключ/значення маркерів запиту та відповіді в окремій фізичній пам’яті для ефективного керування пам’яттю пристрою, допомагаючи збільшити розмір пакета під час виконання та покращити пропускну здатність системи. Спеціалізоване ядро Scaled-Dot-Product-Attention розроблено, щоб відповідати нашій політиці злиття на основі рішення сегментного кешу KV. Ми впроваджуємо наше рішення LLM Inference на графічному процесорі Intel і публікуємо його. У порівнянні зі стандартною реалізацією HuggingFace запропоноване рішення забезпечує до 7 разів нижчу затримку маркерів і 27 разів вищу пропускну здатність для деяких популярних LLM на графічному процесорі Intel».

Знайти технічний документ тут. Опубліковано грудень 2023 р. (препринт).

Ву, Хуей, І Ган, Фен Юань, Цзін Ма, Вей Чжу, Ютао Сюй, Хун Чжу, Юхуа Чжу, Сяолі Лю та Цзінхуей Гу. «Ефективне рішення LLM для висновків на GPU Intel». Препринт arXiv arXiv:2401.05391 (2023).

Пов'язане читання

LLM Inference на ЦП (Intel)

Дослідники Intel опублікували технічну статтю під назвою «Ефективне висновок LLM щодо процесорів».

AI мчить до краю

Висновок і деяке навчання переносяться на менші пристрої, оскільки ШІ поширюється на нові програми.

- Розповсюдження контенту та PR на основі SEO. Отримайте посилення сьогодні.

- PlatoData.Network Vertical Generative Ai. Додайте собі сили. Доступ тут.

- PlatoAiStream. Web3 Intelligence. Розширення знань. Доступ тут.

- ПлатонЕСГ. вуглець, CleanTech, Енергія, Навколишнє середовище, Сонячна, Поводження з відходами. Доступ тут.

- PlatoHealth. Розвідка про біотехнології та клінічні випробування. Доступ тут.

- джерело: https://semiengineering.com/llm-inference-on-gpus-intel/

- :є

- $UP

- 2023

- a

- доступ

- Досягає

- AI

- Також

- an

- та

- застосування

- ЕСТЬ

- AS

- At

- заснований

- стає

- було

- буття

- by

- cache

- складні

- порівняний

- КОРПОРАЦІЯ

- налаштувати

- дані

- Грудень

- дизайн

- призначений

- пристрій

- прилади

- Ефективний

- ефективність

- ефективний

- збільшити

- Поля

- для

- частота

- злиття

- злиття

- GPU

- Графічні процесори

- Мати

- допомогу

- тут

- Високий

- вище

- Гонконг

- ГАРЯЧА

- Однак

- HTTPS

- HuggingFace

- здійснювати

- реалізація

- удосконалювати

- in

- Intel

- IT

- JPG

- тримати

- мова

- великий

- Затримка

- шар

- llm

- низький

- знизити

- Робить

- управління

- багато

- масивний

- матч

- пам'ять

- режим

- модель

- Моделі

- руху

- Нові

- of

- on

- відкрити

- операції

- наші

- Папір

- виконувати

- фізичний

- plato

- Інформація про дані Платона

- PlatoData

- політика

- популярний

- пропонувати

- запропонований

- публічно

- публікувати

- опублікований

- штовхнув

- скачки

- реальний

- зменшити

- запросити

- Дослідники

- відповідь

- сегмент

- окремий

- спростити

- Розмір

- менше

- рішення

- деякі

- Спреди

- standard

- структура

- система

- Завдання

- технічний

- Команда

- це

- пропускна здатність

- під назвою

- до

- знак

- Жетони

- тема

- Навчання

- використовуваний

- зазвичай

- було

- we

- широко

- з

- юань

- зефірнет