Останні досягнення в розробці LLM популяризували їх використання для різноманітних завдань НЛП, які раніше вирішувалися за допомогою старих методів машинного навчання. Великі мовні моделі здатні вирішувати різноманітні мовні проблеми, такі як класифікація, узагальнення, пошук інформації, створення вмісту, відповіді на запитання та підтримка розмови — і все це використовуючи лише одну модель. Але як ми знаємо, що вони добре справляються з усіма цими різними завданнями?

Зростання LLM виявило невирішену проблему: у нас немає надійного стандарту для їх оцінки. Оцінку ускладнює те, що вони використовуються для дуже різноманітних завдань, і нам бракує чіткого визначення того, що є гарною відповіддю для кожного випадку використання.

У цій статті обговорюються сучасні підходи до оцінювання LLM і представлено нову таблицю лідерів LLM, що використовує людське оцінювання, яке вдосконалює існуючі методи оцінювання.

Перша і звичайна початкова форма оцінки полягає в тому, щоб запустити модель на кількох підібраних наборах даних і перевірити її продуктивність. HuggingFace створив Відкрийте таблицю лідерів LLM де великі моделі відкритого доступу оцінюються за допомогою чотирьох добре відомих наборів даних (AI2 Reasoning Challenge , HellaSwag , MMLU , TruthfulQA). Це відповідає автоматичному оцінюванню та перевіряє здатність моделі отримати факти для деяких конкретних питань.

Це приклад питання з MMLU набір даних.

Тема: коледж_медицина

Питання: Очікуваним побічним ефектом добавок креатину є.

- А) м'язова слабкість

- Б) збільшення маси тіла

- В) м'язові судоми

- Г) втрата електролітів

Відповідь: (Б)

Оцінка моделі за відповіді на запитання такого типу є важливою метрикою та добре служить для перевірки фактів, але вона не перевіряє генеративну здатність моделі. Це, мабуть, найбільший недолік цього методу оцінювання, оскільки генерування вільного тексту є однією з найважливіших функцій LLM.

Здається, у спільноті існує консенсус щодо того, що для належної оцінки моделі нам потрібна людська оцінка. Зазвичай це робиться шляхом порівняння відповідей різних моделей.

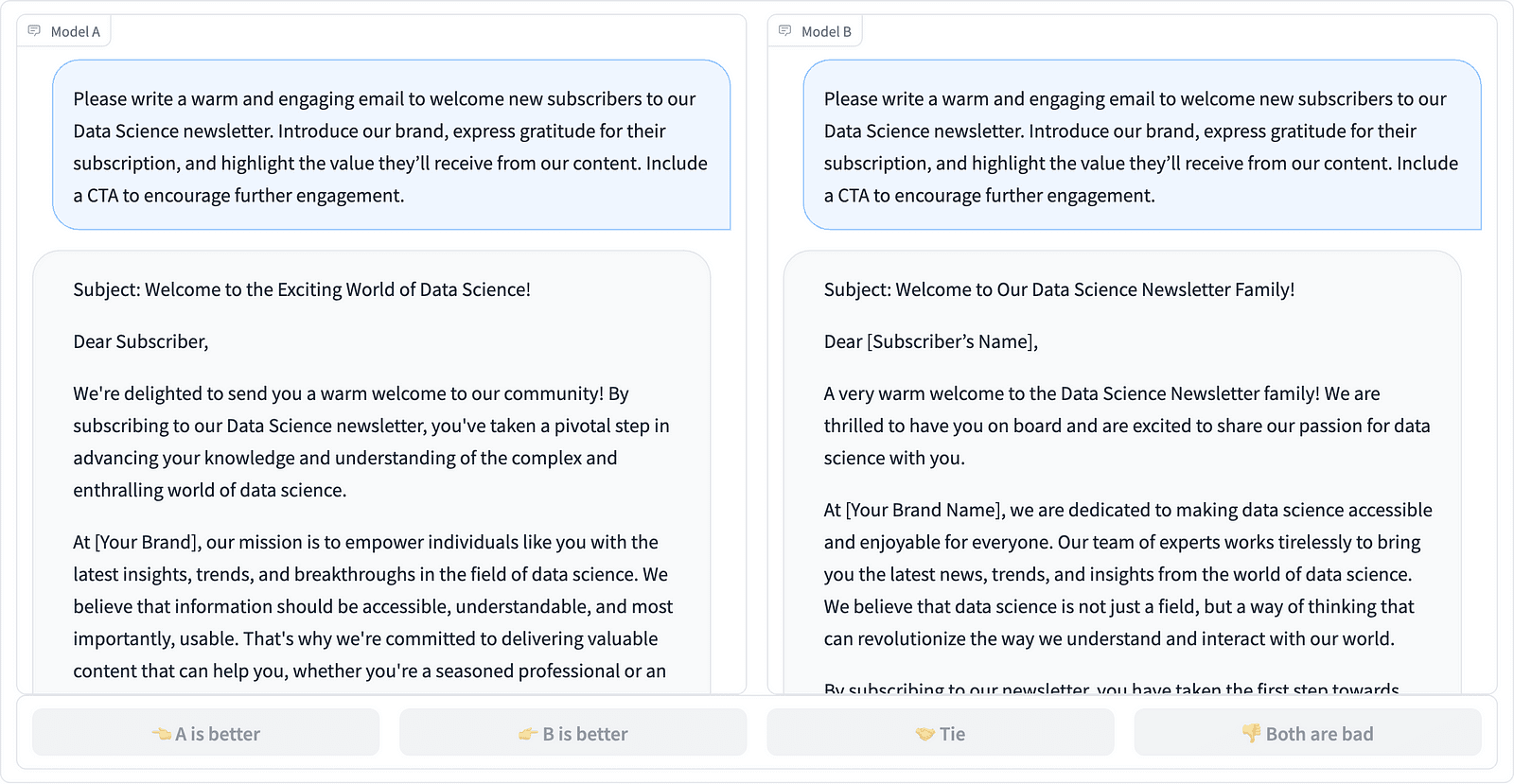

Порівняння двох швидких завершень у проекті LMSYS – скріншот автора

Анотатори вирішують, яка відповідь краща, як показано в прикладі вище, і іноді кількісно оцінюють різницю в якості швидких завершень. LMSYS Org створила a лідерів який використовує цей тип людської оцінки та порівнює 17 різних моделей, повідомляючи про Рейтинг Ело для кожної моделі.

Оскільки людське оцінювання важко масштабувати, було докладено зусиль, щоб масштабувати та прискорити процес оцінювання, і це призвело до цікавого проекту під назвою АльпакаЕваль. Тут кожна модель порівнюється з базовою лінією (text-davinci-003, наданий GPT-4), а людська оцінка замінюється судженням GPT-4. Це справді швидко та з можливістю масштабування, але чи можемо ми довіряти моделі, яка виконає оцінку? Ми повинні знати про упередженості моделі. Проект фактично показав, що GPT-4 може сприяти більшим відповідям.

Методи оцінювання LLM продовжують розвиватися, оскільки спільнота штучного інтелекту шукає прості, справедливі та масштабовані підходи. Остання розробка походить від команди Toloka з новим лідерів для подальшого вдосконалення поточних стандартів оцінювання.

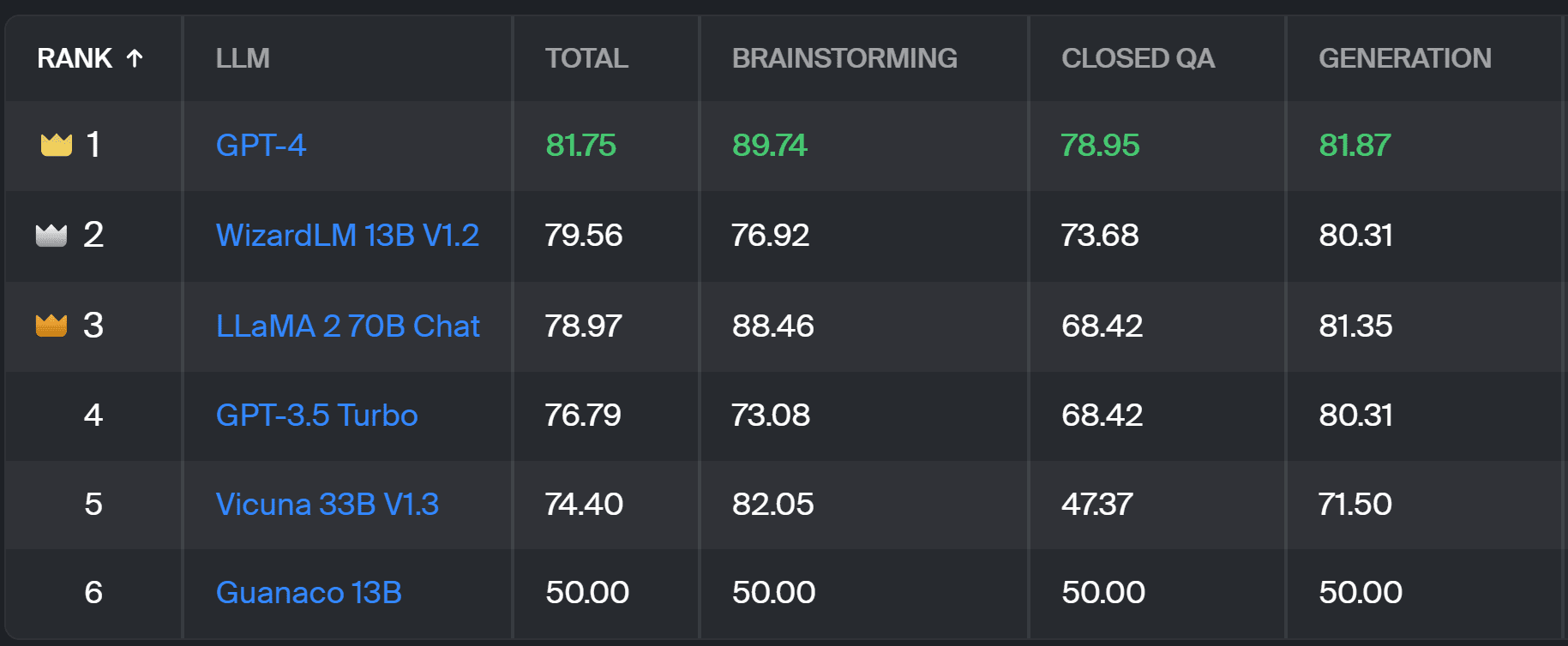

Новий лідерів порівнює відповіді моделі з підказками користувачів у реальному світі, які класифікуються за корисними завданнями НЛП, як описано в цей документ InstructGPT. Він також показує загальний рейтинг перемог кожної моделі в усіх категоріях.

Таблиця лідерів Toloka – скріншот автора

Оцінка, яка використовується для цього проекту, подібна до тієї, що виконується в AlpacaEval. Оцінки в таблиці лідерів представляють відсоток виграшів відповідної моделі порівняно з Гуанако 13B модель, яка тут служить базовим порівнянням. Вибір Guanaco 13B є вдосконаленням методу AlpacaEval, який використовує як базову модель text-davinci-003, яка незабаром застаріла.

Фактична оцінка виконується людьми-експертами-анотаторами за набором підказок реального світу. Для кожної підказки анотаторам дають два завершення та запитують, якому з них вони віддають перевагу. Ви можете знайти детальну інформацію про методологію тут.

Цей тип людського оцінювання є більш корисним, ніж будь-який інший автоматичний метод оцінювання, і має покращити оцінювання людиною, що використовується для Таблиця лідерів LMSYS. Недоліком методу LMSYS є те, що будь-хто з link можуть брати участь в оцінюванні, викликаючи серйозні сумніви щодо якості даних, зібраних таким чином. Замкнена група експертів-анотаторів має кращий потенціал для отримання надійних результатів, і Toloka застосовує додаткові методи контролю якості, щоб забезпечити якість даних.

У цій статті ми представили багатообіцяюче нове рішення для оцінювання LLM — Toloka Leaderboard. Цей підхід є інноваційним, поєднує в собі сильні сторони існуючих методів, додає деталізацію для конкретного завдання та використовує надійні методи людського анотування для порівняння моделей.

Ознайомтеся з дошкою та поділіться з нами своїми думками та пропозиціями щодо покращень.

Магдалена Конкевич є проповідником даних у Toloka, глобальній компанії, яка підтримує швидку та масштабовану розробку ШІ. Вона має ступінь магістра зі штучного інтелекту в Единбурзькому університеті та працювала інженером з НЛП, розробником і спеціалістом з обробки даних для компаній Європи та Америки. Вона також брала участь у навчанні та наставництві Data Scientists і регулярно бере участь у публікаціях Data Science та Machine Learning.

- Розповсюдження контенту та PR на основі SEO. Отримайте посилення сьогодні.

- PlatoData.Network Vertical Generative Ai. Додайте собі сили. Доступ тут.

- PlatoAiStream. Web3 Intelligence. Розширення знань. Доступ тут.

- ПлатонЕСГ. вуглець, CleanTech, Енергія, Навколишнє середовище, Сонячна, Поводження з відходами. Доступ тут.

- PlatoHealth. Розвідка про біотехнології та клінічні випробування. Доступ тут.

- джерело: https://www.kdnuggets.com/a-better-way-to-evaluate-llms?utm_source=rss&utm_medium=rss&utm_campaign=a-better-way-to-evaluate-llms

- : має

- :є

- : ні

- :де

- $UP

- 17

- a

- здатність

- МЕНЮ

- вище

- через

- фактичний

- насправді

- Додатковий

- Додає

- просування

- аванси

- AI

- ВСІ

- Також

- Америка

- an

- та

- відповідь

- Відповіді

- будь-який

- застосовується

- підхід

- підходи

- ЕСТЬ

- Арена

- стаття

- штучний

- штучний інтелект

- AS

- At

- автоматичний

- знати

- b

- Базова лінія

- BE

- оскільки

- було

- Краще

- упередження

- найбільший

- рада

- тіло

- приніс

- підприємства

- але

- by

- CAN

- здатний

- випадок

- категорії

- виклик

- Перевірки

- вибір

- класифікація

- ясно

- закрито

- комбінати

- приходить

- співтовариство

- компанія

- порівняти

- порівняний

- порівняння

- порівняння

- Консенсус

- зміст

- контент-створення

- триває

- сприяє

- контроль

- Розмова

- відповідає

- створений

- створення

- натовп

- Куратор

- Поточний

- дані

- якість даних

- наука про дані

- вчений даних

- набори даних

- вирішувати

- визначення

- Ступінь

- деталі

- Розробник

- розробка

- різниця

- різний

- Недоліком

- Різне

- do

- робить

- справи

- зроблений

- Не знаю

- зворотний бік

- кожен

- легко

- Едінбург

- ефект

- зусилля

- електроліти

- інженер

- забезпечувати

- Європа

- оцінювати

- оцінюється

- оцінки

- оцінка

- Євангеліст

- еволюціонувати

- досліджувати

- приклад

- існуючий

- очікуваний

- експерт

- Факти

- ярмарок

- ШВИДКО

- на користь

- риси

- знайти

- Перший

- для

- форма

- чотири

- Безкоштовна

- від

- далі

- Отримувати

- зібраний

- породжує

- генеративний

- отримати

- GitHub

- даний

- Глобальний

- добре

- хороша робота

- Жорсткий

- важче

- Мати

- тут

- дуже

- тримає

- Як

- HTTPS

- HuggingFace

- людина

- важливо

- удосконалювати

- поліпшення

- поліпшення

- поліпшується

- in

- інформація

- початковий

- інноваційний

- Інтелект

- цікавий

- введені

- Вводить

- залучений

- IT

- ЙОГО

- робота

- просто

- тільки один

- KDnuggets

- Знати

- відсутність

- мова

- великий

- останній

- вивчення

- використання

- світло

- довше

- від

- машина

- навчання за допомогою машини

- збереження

- РОБОТИ

- манера

- Маса

- майстер

- Може..

- наставництво

- метод

- Методологія

- методика

- метрика

- модель

- Моделі

- більше

- найбільш

- м'яз

- Необхідність

- Нові

- нове рішення

- nlp

- of

- старший

- on

- ONE

- відкрити

- Думки

- Інше

- викладені

- загальний

- частина

- виконувати

- продуктивність

- виконується

- plato

- Інформація про дані Платона

- PlatoData

- потенціал

- надавати перевагу

- раніше

- ймовірно

- Проблема

- проблеми

- процес

- проект

- перспективний

- підказок

- правильно

- за умови

- публікаціям

- якість

- питання

- питань

- залучення

- ставка

- Реальний світ

- регулярно

- надійний

- замінити

- Звітність

- представляти

- ті

- відповідь

- відповіді

- призвело до

- результати

- Зростання

- прогін

- s

- масштабовані

- шкала

- наука

- вчений

- Вчені

- безліч

- рахунок

- пошук

- Здається,

- бачив

- серйозний

- служить

- комплект

- кілька

- Поділитись

- вона

- Повинен

- показаний

- Шоу

- сторона

- аналогічний

- один

- рішення

- Розв’язування

- деякі

- іноді

- конкретний

- швидкість

- standard

- стандартів

- сильні сторони

- такі

- Підтримуючий

- Приймати

- завдання

- Навчання

- команда

- методи

- тест

- текст

- ніж

- Що

- Команда

- їх

- Їх

- Там.

- Ці

- вони

- це

- до

- Довіряйте

- два

- тип

- типово

- університет

- на

- us

- Використання

- використання

- використання випадку

- використовуваний

- користувач

- використовує

- використання

- звичайний

- різноманітність

- шлях..

- we

- слабкість

- ДОБРЕ

- добре відомі

- були

- Що

- Що таке

- який

- виграти

- з

- в

- працював

- ви

- вашу

- зефірнет