Fotoğraf Google DeepMind

2023, Büyük Dil Modellerinin ve Açık Kaynağın yılıydı. Birçok yeni girişim ve şirket, ChatGPT ve Claude gibi tescilli Yüksek Lisans'larla mücadele etmek için modellerini ve ağırlıklarını açık kaynaklı hale getirdi. 2023 için önemli şirket ve modellerden (açık kaynak) bazıları şunlardı:

- Meta (LLama, Llamav2)

- TII (Şahin 7B, 40B, 180B)

- Mistral (Mistral 7B, Mixtral8x7B)

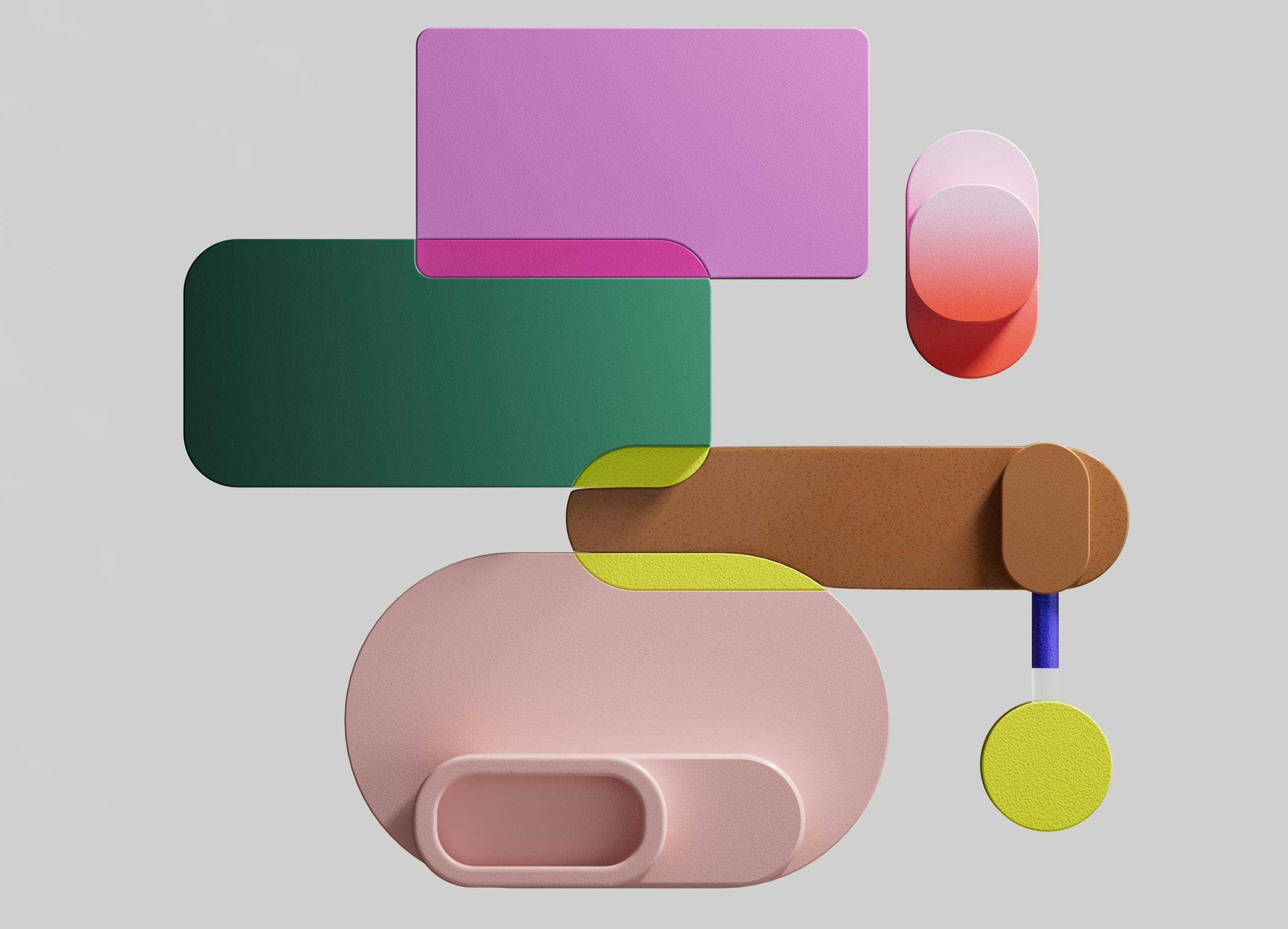

Ancak kurulumu nispeten kolay ve daha ucuz olan bir 7B modeli, 70B gibi daha büyük modellerle aynı seviyede değildir. En güçlü açık kaynak yarışmacısı, birçok büyük modelden daha iyi performans gösteren Mistral 7B idi.

Mistral-7B'nin karşılaştırılması Mistral.ai

Ancak bu küçük modeller yine de doğal uyarılara iyi yanıt vermiyor ve iyi bir istem mühendisliği gerektiriyor.

Zephyr 7B, ana hedefi kullanıcının amacına uygun ve daha büyük modellerden daha iyi performans gösteren daha küçük bir dil modeli oluşturmak olan HuggingFace H4 (Yardımcı, Dürüst, Zararsız, Huggy) ekibi tarafından oluşturulan bir modeldir.

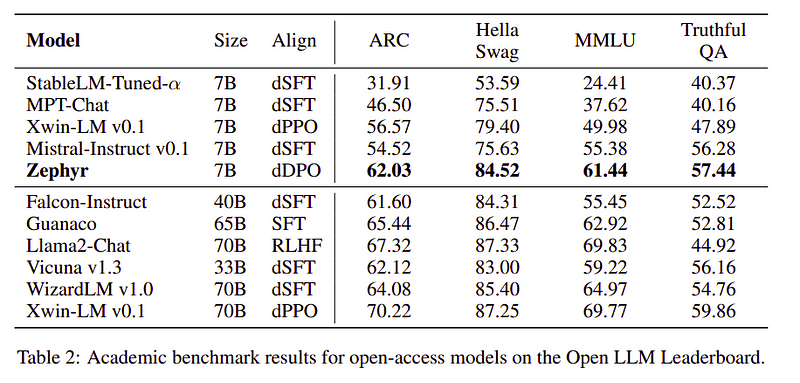

Zephyr, Mistral-7B'nin temel olarak Damıtma gücüyle oluşturulmuş uyumlu bir versiyonudur ve akademik ve konuşma kıyaslamalarında 70B modelleriyle karşılaştırılabilir.

Zephyr-7B'nin performans karşılaştırması | Kaynak: Zefir kağıdı

Zephyr-7B'nin performans karşılaştırması | Kaynak: Zefir kağıdı

Ana Özellikler

Zephyr'in olağanüstü performansının ardındaki neden H4 Takımının kullandığı bu 4 temel tekniktir.

- Kendi Kendine Talimatlı veri oluşturma ve DSFT (Saflaştırılmış Denetimli İnce Ayar)

- Geri bildirim koleksiyonu

- DSFT modelinin DDPO'su (Distile Doğrudan Tercih Optimizasyonu)

Kendi Kendine Veri Oluşturma ve DSFT

Geleneksel olarak Denetimli İnce Ayar (SFT) Yüksek kaliteli bir talimat tamamlama çifti aracılığıyla Büyük Dil Modelinde gerçekleştirilir. Bu verilerin oluşturulması maliyetlidir ve insan denetimi gerektirir (Chung ve diğerleri, 2022; Sanh ve diğerleri, 2021).

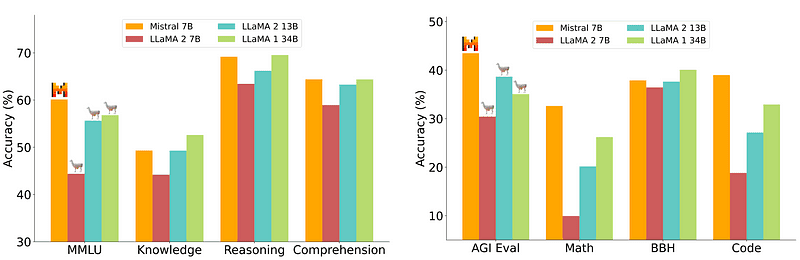

Buradaki ilginç yaklaşımlardan biri, talimatları ve yanıtları oluşturmak için bir Öğretmen modeli (halihazırda LLM eğitimi almış) kullanmaktır. Bu damıtma tekniği ilk olarak Alpaka'da kullanıldı (Taori ve diğerleri, 2023), bu da küçük bir modelin daha büyük modellerden daha iyi performans gösterebileceğini kanıtladı. Damıtılmış Denetimli İnce Ayar.

Kendi Kendine Talimat hattı | Kaynak: Kendi Kendine Talimat kağıdı

H4 Ekibi, DSFT yapmak için kullanılan yüksek kaliteli denetimli (talimat, tamamlama) veri kümelerini oluşturmak için Zephyr'i kullandı. (Oluşturulan talimatlar/tamamlamalar üzerine bir modeli eğitmek, DSFT: Damıtılmış Denetimli İnce Ayar olarak bilinen bir damıtma biçimidir).

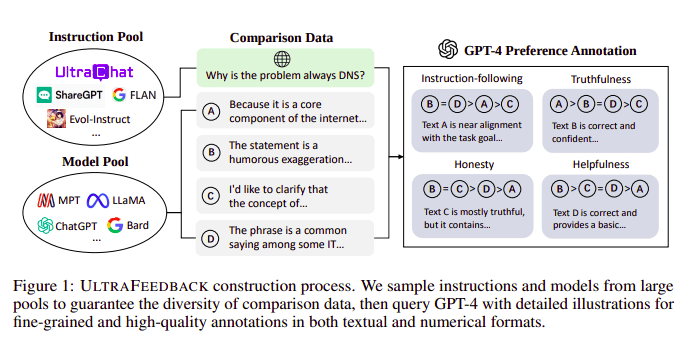

Geri Bildirim Koleksiyonu

Büyük Dil Modelleri genellikle aşağıdakilerin yardımıyla hizalanır: İnsan geri bildiriminden pekiştirmeli öğrenme (RLHF). Zephyr bunun yerine, Ultra Geribildirim yaklaşımını izleyerek modelin çıkarlarını uyumlu hale getirmek için daha iyi bir öğretmen modelinden (GPT-4 gibi) gelen Geri Bildirimi kullanıyor.

UltraFeedback yapım süreci | Kaynak: UltraFeedback kağıdı

Çalışma şekli, SFT'den gelen her bilgi istemi tarafından denetlenen istemin 4 modele (Claude, LLama, Falcon, vb.) aktarılması ve tek ipucuna karşı verilen 4 yanıtın her birinin GPT-4 yardımıyla puanlanmasıdır. Artık bir Girdi (x), en yüksek skorlu tamamlama (yw) ve düşük skorlu tamamlama (yl) olarak gösterilen rastgele bir istemden oluşan bir veri setimiz var, yani elimizde (x, yw, yl) üçlüsü var.

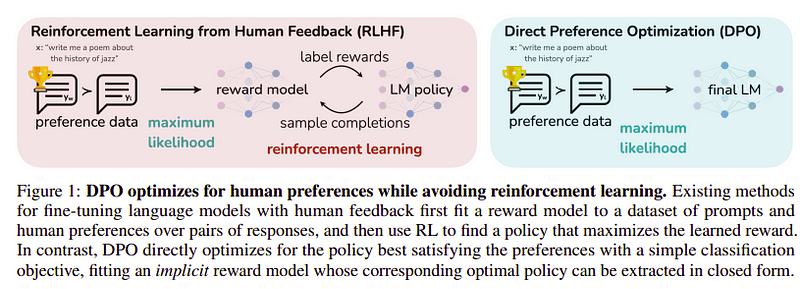

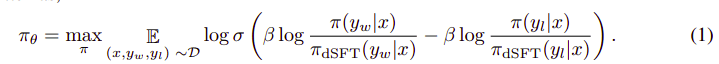

Tercih Optimizasyonu

Bu son adımın amacı, modelin tercihini yw'den (en yüksek puanlı tamamlama) yl'e (düşük puanlı tamamlama) göre maksimuma çıkarmaktır. Bu kullanılarak yapılır DPO (Doğrudan Tercih Optimizasyonu). DPO'yu kullanmak, düz RLHF'yi kullanmaktan daha basittir ve sezgisel olarak RLHF'den daha iyi performans gösterir. Bu durumdaki yaklaşım şu şekilde bilinir: dDPO çünkü öğretmen modelinin yardımıyla oluşturulan damıtılmış bir veri kümesini kullanıyor.

DPO ve RLHF | Kaynak: Zefir kağıdı

DPO ve RLHF | Kaynak: Zefir kağıdı

Genel algoritma şuna benzer:

Ve aşağıdaki adımlara çevrilebilir:

- (x, yw) ve (x, yl) olasılığını dSFT modelinden (yalnızca ileri) hesaplayın.

- dDPO modelinden (x, yw) ve (x, yl) olasılığını hesaplayın.

- Denklem 1'i hesaplayın ve güncellemek için geri yayılım yapın. Tekrarlamak

Zephyr'in kullandığı temel model, piyasaya sürüldüğü sırada en son teknolojiye sahip açık kaynak olan Mistral-7B'dir. Onlar kullandılar TRL İnce ayar ve hizalama için kütüphane. Eğitimi optimize etmek ve hızlandırmak ve GPU'dan tam olarak yararlanmak için Deep-Speed Zero 3 ve Flash-Attention 2 kullanıldı. Modeller AdamW optimizer kullanılarak eğitildi ve ağırlık azalması kullanılmadı. Tüm deneyler bfloat16 hassasiyeti kullanılarak 100 A16'de gerçekleştirildi ve tamamlanması genellikle 2-4 saat sürdü. Şuraya başvurabilirsiniz: orjinal kağıt Zephyr Eğitim Prosedürü hakkında ayrıntılı bilgi için.

Zephyr ekibi, Büyük Dil Modellerini eğitmek için en iyi teknikleri birleştirdi ve 40B modellerinin performansını yalnızca 7B parametreleriyle eşleştirdi ve 70B'yi sohbet modelleri için eşleştirdi.

Zephyr ile diğer Yüksek Lisans Derecelerinin Karşılaştırılması | Kaynak: Zefir kağıdı

Zephyr ile diğer Yüksek Lisans Derecelerinin Karşılaştırılması | Kaynak: Zefir kağıdı Zephyr ile diğer Yüksek Lisans Derecelerinin Karşılaştırılması | Kaynak: Zefir kağıdı

Zephyr ile diğer Yüksek Lisans Derecelerinin Karşılaştırılması | Kaynak: Zefir kağıdı

Zephyr modelleri Hugging Face'te herkese açık olarak mevcuttur ve diğer Dil Modellerine benzer şekilde kullanılabilir.

import torch

from transformers import pipeline

pipe = pipeline("text-generation",

model="HuggingFaceH4/zephyr-7b-alpha", # can also use the beta model

torch_dtype=torch.bfloat16,

device_map="auto")

# We use the tokenizer's chat template to format each message - see https://huggingface.co/docs/transformers/main/en/chat_templating

messages = [

{

"role": "system",

"content": "You are a friendly chatbot who always responds in the style of a pirate",

},

{"role": "user", "content": "How many helicopters can a human eat in one sitting?"},

]

prompt = pipe.tokenizer.apply_chat_template(messages, tokenize=False, add_generation_prompt=True)

outputs = pipe(prompt, max_new_tokens=256, do_sample=True, temperature=0.7, top_k=50, top_p=0.95)

print(outputs[0]["generated_text"])Çıktı:

|system|>

You are a friendly chatbot who always responds in the style of a pirate.

|user|>

How many helicopters can a human eat in one sitting?

|assistant|>

Ah, me hearty matey! But yer question be a puzzler! A human cannot eat a helicopter in one sitting, as helicopters are not edible. They be made of metal, plastic, and other materials, not food!

Zephyr-7B, yüksek lisanstan daha küçük bir modele kadar damıtmanın gücünü gösteren küçük bir modeldir. Sonuçta ortaya çıkan, MISTRAL-7B'yi temel alan ZEPHYR-7B modeli, 7B parametre sohbet modelleri için yeni bir teknoloji harikası oluşturuyor ve hatta MT-Bench'te LLAMA2-CHAT-70B'den daha iyi performans gösteriyor.

Referanslar

- Zephyr: LM Hizalamasının Doğrudan Damıtma (https://arxiv.org/abs/2310.16944)

- HuggingFace Zephyr blogu (https://huggingface.co/blog/Isamu136/understanding-zephyr)

- Kendi Kendine Talimat: https://arxiv.org/abs/2212.10560

- Ultra Geribildirim: https://arxiv.org/abs/2310.01377

Ahmet Eniş şu anda çalışan tutkulu bir makine öğrenimi mühendisi ve araştırmacısıdır. redbuffer.ai. Ahmad, günlük işinin ötesinde, makine öğrenimi topluluğuyla aktif olarak ilgileniyor. Açık bilime adanmış kar amacı gütmeyen bir kuruluş olan Cohere for AI'da bölgesel lider olarak görev yapıyor ve bir AWS topluluk oluşturucusudur. Ahmad, 2300'den fazla puana sahip olduğu Stackoverflow'a aktif olarak katkıda bulunuyor. OpenAI'nin Shap-E'si de dahil olmak üzere birçok ünlü açık kaynaklı projeye katkıda bulunmuştur.

- SEO Destekli İçerik ve Halkla İlişkiler Dağıtımı. Bugün Gücünüzü Artırın.

- PlatoData.Network Dikey Üretken Yapay Zeka. Kendine güç ver. Buradan Erişin.

- PlatoAiStream. Web3 Zekası. Bilgi Genişletildi. Buradan Erişin.

- PlatoESG. karbon, temiz teknoloji, Enerji, Çevre, Güneş, Atık Yönetimi. Buradan Erişin.

- PlatoSağlık. Biyoteknoloji ve Klinik Araştırmalar Zekası. Buradan Erişin.

- Kaynak: https://www.kdnuggets.com/exploring-the-zephyr-7b-a-comprehensive-guide-to-the-latest-large-language-model?utm_source=rss&utm_medium=rss&utm_campaign=exploring-the-zephyr-7b-a-comprehensive-guide-to-the-latest-large-language-model

- :vardır

- :dır-dir

- :olumsuzluk

- :Neresi

- $UP

- 1

- İNDİRİM

- 16

- 2021

- 2022

- 2023

- 25

- 7

- a

- akademik

- aktif

- aktif

- karşı

- AI

- AL

- algoritma

- hizalamak

- hizalı

- hiza

- Türkiye

- zaten

- Ayrıca

- her zaman

- an

- ve

- herhangi

- yaklaşım

- yaklaşımlar

- ARE

- AS

- At

- Oto

- mevcut

- AWS

- baz

- merkezli

- BE

- Çünkü

- arkasında

- kriterler

- İYİ

- beta

- Daha iyi

- Ötesinde

- büyük

- Blog

- oluşturucu

- fakat

- by

- CAN

- yapamam

- dava

- sohbet

- chatbot

- ChatGPT

- daha ucuz

- Toplamak

- mücadele

- biçerdöverler

- topluluk

- Şirketler

- karşılaştırılabilir

- karşılaştırma

- tamamlamak

- tamamlama

- kapsamlı

- inşa

- kas kütlesi inşasında ve

- içerik

- katkıda

- iştirakçi

- konuşkan

- pahalı

- yaratmak

- çevrimiçi kurslar düzenliyorlar.

- oluşturma

- Şu anda

- veri

- veri kümeleri

- gün

- adanmış

- dağıtmak

- ayrıntılar

- direkt

- do

- yapıyor

- yapılmış

- e

- E&T

- her

- kolay

- yemek

- yenilebilir

- meşgul

- mühendis

- Mühendislik

- vb

- Eter (ETH)

- Hatta

- deneyler

- Keşfetmek

- Yüz

- şahin

- ünlü

- geribesleme

- Ad

- takip etme

- İçin

- Airdrop Formu

- biçim

- arkadaş canlısı

- itibaren

- tamamen

- oluşturmak

- oluşturulan

- gol

- Tercih Etmenizin

- GPU

- rehberlik

- Var

- he

- helikopter

- helikopterler

- yardım et

- faydalı

- okuyun

- Yüksek kaliteli

- en yüksek

- onun

- dürüst

- SAAT

- Ne kadar

- Ancak

- HTTPS

- SarılmaYüz

- insan

- i

- ithalat

- önemli

- in

- derinlemesine

- Dahil olmak üzere

- giriş

- yerine

- talimatlar

- niyet

- ilginç

- ilgi alanları

- içine

- IT

- İş

- jpg

- sadece

- KDNuggets

- anahtar

- bilinen

- dil

- büyük

- büyük

- Soyad

- son

- öncülük etmek

- öğrenme

- Kütüphane

- sevmek

- lama

- GÖRÜNÜYOR

- Düşük

- makine

- makine öğrenme

- yapılmış

- Ana

- ağırlıklı olarak

- çok

- eşleşti

- malzemeler

- Maksimuma çıkarmak

- me

- mesaj

- mesajları

- metal

- model

- modelleri

- Doğal (Madenden)

- yeni

- yok hayır

- kâr amacı gütmeyen

- şimdi

- of

- on

- ONE

- açık

- açık kaynak

- OpenAI

- optimizasyon

- optimize

- orijinal

- Diğer

- daha iyi çalmak

- Mağazasından

- çıkışlar

- ödenmemiş

- tekrar

- tüm

- çift

- parametre

- parametreler

- geçti

- tutkulu

- performans

- yapılan

- gerçekleştirir

- boru

- boru hattı

- Sade

- plastik

- Platon

- Plato Veri Zekası

- PlatoVeri

- noktaları

- güç kelimesini seçerim

- Hassas

- olasılık

- prosedür

- süreç

- Projeler

- istemleri

- özel

- kanıtladı

- soru

- rasgele

- neden

- başvurmak

- bölgesel

- Nispeten

- serbest

- tekrar et

- gerektirir

- gerektirir

- araştırmacı

- Yanıtlamak

- yanıtları

- Ortaya çıkan

- Rol

- koşmak

- s

- Bilim

- attı

- puanlama

- görmek

- vermektedir

- Setleri

- gösterdi

- benzer şekilde

- basit

- tek

- Oturan

- küçük

- daha küçük

- biraz

- biraz

- Kaynak

- hız

- Startups

- state-of-the-art

- adım

- Basamaklar

- Yine

- güçlü

- stil

- böyle

- denetleme

- sistem

- öğretmen

- takım

- teknik

- teknikleri

- şablon

- göre

- o

- The

- ve bazı Asya

- Bunlar

- onlar

- Re-Tweet

- zaman

- için

- aldı

- meşale

- Tren

- eğitilmiş

- Eğitim

- transformatörler

- tipik

- Ultra

- Güncelleme

- kullanım

- Kullanılmış

- kullanıcı

- kullanım

- kullanma

- kullanmak

- versiyon

- üzerinden

- vs

- oldu

- Yol..

- we

- ağırlık

- İYİ

- vardı

- hangi

- DSÖ

- kimin

- ile

- çalışma

- çalışır

- olur

- X

- yıl

- sen

- zefir

- zefirnet

- sıfır