Yazara göre resim

Bu yazımızda Mixtral 8x7b adlı yeni ve son teknoloji açık kaynak modelini inceleyeceğiz. Ayrıca LLaMA C++ kütüphanesini kullanarak ona nasıl erişeceğimizi ve büyük dil modellerini azaltılmış bilgi işlem ve bellekle nasıl çalıştıracağımızı da öğreneceğiz.

Karışımtral 8x7b Mistral AI tarafından oluşturulan, açık ağırlıklara sahip, yüksek kaliteli, seyrek bir uzman karışımı (SMoE) modelidir. Apache 2.0 kapsamında lisanslıdır ve çoğu kıyaslamada Llama 2 70B'den daha iyi performans gösterirken 6 kat daha hızlı çıkarım sağlar. Mixtral, çoğu standart kıyaslamada GPT3.5'e uyuyor veya onu geçiyor ve maliyet/performans açısından en iyi açık ağırlıklı modeldir.

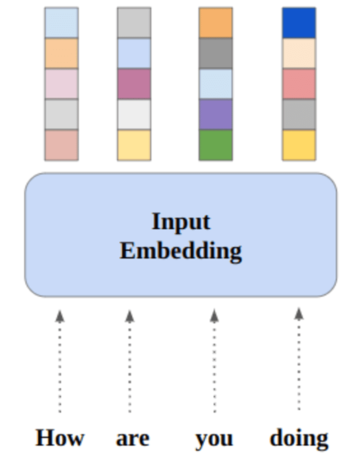

Image Uzmanların karışımı

Mixtral 8x7B, yalnızca kod çözücüye yönelik seyrek bir uzman karışımı ağı kullanır. Bu, 8 parametre grubundan seçim yapan bir ileri besleme bloğunu içerir; bir yönlendirici ağı, her bir belirteç için bu gruplardan ikisini seçer ve çıktılarını ek olarak birleştirir. Bu yöntem, maliyet ve gecikmeyi yönetirken modelin parametre sayısını artırır ve toplam 12.9 milyar parametreye sahip olmasına rağmen onu 46.7B modeli kadar verimli hale getirir.

Mixtral 8x7B modeli, 32 bin tokenden oluşan geniş bir bağlamı yönetme konusunda başarılıdır ve İngilizce, Fransızca, İtalyanca, Almanca ve İspanyolca dahil olmak üzere birçok dili destekler. Kod oluşturmada güçlü performans gösterir ve talimat takip eden bir modele ince ayar yapılarak MT-Bench gibi kıyaslamalarda yüksek puanlar elde edilebilir.

LLaMA.cpp Facebook'un LLM mimarisini temel alan büyük dil modelleri (LLM'ler) için yüksek performanslı bir arayüz sağlayan bir C/C++ kütüphanesidir. Metin oluşturma, çeviri ve soru yanıtlama gibi çeşitli görevler için kullanılabilecek hafif ve etkili bir kitaplıktır. LLaMA.cpp, LLaMA, LLaMA 2, Falcon, Alpaca, Mistral 7B, Mixtral 8x7B ve GPT4ALL dahil olmak üzere çok çeşitli LLM'leri destekler. Tüm işletim sistemleriyle uyumludur ve hem CPU'larda hem de GPU'larda çalışabilir.

Bu bölümde llama.cpp web uygulamasını Colab üzerinde çalıştıracağız. Birkaç satır kod yazarak yeni ve son teknoloji modelin performansını PC'nizde veya Google Colab'da deneyimleyebileceksiniz.

Başlamak

Öncelikle aşağıdaki komut satırını kullanarak llama.cpp GitHub deposunu indireceğiz:

!git clone --depth 1 https://github.com/ggerganov/llama.cpp.gitBundan sonra dizini repository'ye değiştireceğiz ve 'make' komutunu kullanarak llama.cpp'yi kuracağız. CUDA yüklü NVidia GPU için llama.cpp dosyasını kuruyoruz.

%cd llama.cpp

!make LLAMA_CUBLAS=1Modeli İndir

Hugging Face Hub’dan `.gguf` model dosyasının uygun versiyonunu seçerek modeli indirebiliriz. Çeşitli sürümler hakkında daha fazla bilgiyi şurada bulabilirsiniz: TheBloke/Mixtral-8x7B-Instruct-v0.1-GGUF.

Image TheBloke/Mixtral-8x7B-Instruct-v0.1-GGUF

Modeli mevcut dizine indirmek için `wget` komutunu kullanabilirsiniz.

!wget https://huggingface.co/TheBloke/Mixtral-8x7B-Instruct-v0.1-GGUF/resolve/main/mixtral-8x7b-instruct-v0.1.Q2_K.ggufLLaMA Sunucusu için Harici Adres

LLaMA sunucusunu çalıştırdığımızda, bize Colab'da işimize yaramayan bir localhost IP'si verecektir. Colab çekirdek proxy bağlantı noktasını kullanarak localhost proxy'sine bağlanmamız gerekiyor.

Aşağıdaki kodu çalıştırdıktan sonra global köprüyü alacaksınız. Daha sonra web uygulamamıza erişmek için bu bağlantıyı kullanacağız.

from google.colab.output import eval_js

print(eval_js("google.colab.kernel.proxyPort(6589)"))

https://8fx1nbkv1c8-496ff2e9c6d22116-6589-colab.googleusercontent.com/Sunucuyu Çalıştırmak

LLaMA C++ sunucusunu çalıştırmak için sunucu komutuna model dosyasının konumunu ve doğru bağlantı noktası numarasını sağlamanız gerekir. Bağlantı noktası numarasının, proxy bağlantı noktası için önceki adımda başlattığımız numarayla eşleştiğinden emin olmak önemlidir.

%cd /content/llama.cpp

!./server -m mixtral-8x7b-instruct-v0.1.Q2_K.gguf -ngl 27 -c 2048 --port 6589

Sunucu yerel olarak çalışmadığından, sohbet web uygulamasına önceki adımda proxy bağlantı noktası köprüsüne tıklayarak erişilebilir.

LLaMA C++ Web uygulaması

Chatbotu kullanmaya başlamadan önce onu özelleştirmemiz gerekiyor. Bilgi istemi bölümünde “LLaMA”yı model adınızla değiştirin. Ek olarak, oluşturulan yanıtları ayırt etmek için kullanıcı adını ve bot adını değiştirin.

Aşağı kaydırıp sohbet bölümüne yazarak sohbete başlayın. Diğer açık kaynak modellerinin doğru şekilde yanıtlayamadığı teknik soruları sormaktan çekinmeyin.

Uygulamayla ilgili sorunlarla karşılaşırsanız Google Colab'ımı kullanarak uygulamayı kendi başınıza çalıştırmayı deneyebilirsiniz: https://colab.research.google.com/drive/1gQ1lpSH-BhbKN-DdBmq5r8-8Rw8q1p9r?usp=sharing

Bu eğitimde, gelişmiş açık kaynak modeli Mixtral 8x7b'nin LLaMA C++ kitaplığını kullanarak Google Colab'da nasıl çalıştırılacağına ilişkin kapsamlı bir kılavuz sağlanmaktadır. Diğer modellerle karşılaştırıldığında Mixtral 8x7b üstün performans ve verimlilik sunarak büyük dil modelleriyle denemeler yapmak isteyen ancak kapsamlı hesaplama kaynaklarına sahip olmayanlar için mükemmel bir çözüm haline geliyor. Dizüstü bilgisayarınızda veya ücretsiz bir bulut bilişimde kolayca çalıştırabilirsiniz. Kullanıcı dostudur ve sohbet uygulamanızı başkalarının kullanması ve denemesi için bile dağıtabilirsiniz.

Umarım büyük modeli çalıştırmaya yönelik bu basit çözümü faydalı bulmuşsunuzdur. Her zaman basit ve daha iyi seçenekler arıyorum. Daha iyi bir çözümünüz varsa lütfen bana bildirin, bir dahaki sefere bunu ele alacağım.

Abid Ali Avan (@1abidaliwan), makine öğrenimi modelleri oluşturmayı seven sertifikalı bir veri bilimcisi uzmanıdır. Şu anda, makine öğrenimi ve veri bilimi teknolojileri üzerine içerik oluşturmaya ve teknik bloglar yazmaya odaklanıyor. Abid, Teknoloji Yönetimi alanında yüksek lisans ve Telekomünikasyon Mühendisliği alanında lisans derecesine sahiptir. Vizyonu, akıl hastalığı ile mücadele eden öğrenciler için bir grafik sinir ağı kullanarak bir AI ürünü oluşturmaktır.

- SEO Destekli İçerik ve Halkla İlişkiler Dağıtımı. Bugün Gücünüzü Artırın.

- PlatoData.Network Dikey Üretken Yapay Zeka. Kendine güç ver. Buradan Erişin.

- PlatoAiStream. Web3 Zekası. Bilgi Genişletildi. Buradan Erişin.

- PlatoESG. karbon, temiz teknoloji, Enerji, Çevre, Güneş, Atık Yönetimi. Buradan Erişin.

- PlatoSağlık. Biyoteknoloji ve Klinik Araştırmalar Zekası. Buradan Erişin.

- Kaynak: https://www.kdnuggets.com/running-mixtral-8x7b-on-google-colab-for-free?utm_source=rss&utm_medium=rss&utm_campaign=running-mixtral-8x7b-on-google-colab-for-free

- :dır-dir

- :olumsuzluk

- 1

- 12

- 27

- 46

- 7

- 8

- a

- Yapabilmek

- erişim

- erişilen

- elde

- Ayrıca

- adres

- ileri

- AI

- Türkiye

- Ayrıca

- her zaman

- am

- an

- ve

- cevap

- Apache

- uygulamayı yükleyeceğiz

- Uygulama

- uygun

- mimari

- ARE

- AS

- sormak

- merkezli

- BE

- başlamak

- altında

- kriterler

- İYİ

- Daha iyi

- arasında

- Engellemek

- birisinde

- Bot

- her ikisi de

- inşa etmek

- bina

- fakat

- by

- C + +

- denilen

- CAN

- Onaylı

- değişiklik

- sohbet

- chatbot

- sohbet

- seçme

- bulut

- kod

- birleştirme

- karşılaştırıldığında

- uyumlu

- kapsamlı

- bilişimsel

- hesaplamak

- bilgisayar

- bağ

- içerik

- içerik yaratımı

- bağlam

- doğru

- Ücret

- kapak

- çevrimiçi kurslar düzenliyorlar.

- oluşturma

- akım

- Şu anda

- özelleştirmek

- veri

- veri bilimi

- veri bilimcisi

- derece

- sağlıyor

- gösteriyor

- dağıtmak

- Rağmen

- ayırmak

- do

- aşağı

- indir

- her

- kolayca

- verim

- verimli

- karşılaşma

- Mühendislik

- İngilizce

- Geliştirir

- Hatta

- mükemmel

- deneyim

- deneme

- uzmanlara göre

- keşfetmek

- kapsamlı, geniş

- Yüz

- başarısız

- şahin

- Daha hızlı

- hissetmek

- az

- fileto

- odaklanma

- İçin

- bulundu

- Ücretsiz

- Fransızca

- itibaren

- işlev

- oluşturulan

- nesil

- Almanca

- almak

- GitHub

- Vermek

- Küresel

- GPU

- GPU'lar

- grafik

- Grafik Sinir Ağı

- Grubun

- rehberlik

- kullanma

- Var

- sahip olan

- he

- faydalı

- Yüksek

- yüksek performans

- Yüksek kaliteli

- onun

- tutar

- umut

- Ne kadar

- Nasıl Yapılır

- HTTPS

- merkez

- i

- if

- hastalık

- ithalat

- önemli

- in

- Dahil olmak üzere

- bilgi

- başlatılan

- kurmak

- yükleme

- arayüzey

- içine

- içerir

- IP

- sorunlar

- IT

- İtalyan

- KDNuggets

- Bilmek

- dil

- Diller

- dizüstü bilgisayar

- büyük

- Gecikme

- sonra

- ÖĞRENİN

- öğrenme

- izin

- Kütüphane

- ruhsatlı

- hafif

- sevmek

- çizgi

- hatları

- LINK

- lama

- lokal olarak

- yer

- bakıyor

- seviyor

- makine

- makine öğrenme

- yapmak

- Yapımı

- yönetim

- yönetme

- usta

- maçlar

- me

- Bellek

- zihinsel

- Zihinsel hastalık

- yöntem

- karışım

- model

- modelleri

- değiştirmek

- Daha

- çoğu

- çoklu

- my

- isim

- gerek

- ağ

- sinirsel

- sinir ağı

- yeni

- sonraki

- numara

- Nvidia

- of

- on

- ONE

- açık

- açık kaynak

- işletme

- işletim sistemleri

- Opsiyonlar

- or

- Diğer

- Diğer

- bizim

- Mağazasından

- çıktı

- çıkışlar

- kendi

- parametre

- parametreler

- PC

- performans

- Platon

- Plato Veri Zekası

- PlatoVeri

- Lütfen

- Çivi

- önceki

- PLATFORM

- profesyonel

- uygun şekilde

- sağlamak

- sağlar

- vekil

- soru

- Sorular

- menzil

- Indirimli

- ilişkin

- değiştirmek

- Depo

- araştırma

- Kaynaklar

- yanıtları

- yönlendirici

- koşmak

- koşu

- s

- Bilim

- bilim adamı

- skorları

- kaydırma

- Bölüm

- seçme

- sunucu

- Basit

- beri

- çözüm

- Kaynak

- İspanyolca

- standart

- state-of-the-art

- adım

- güçlü

- Mücadele

- Öğrenciler

- üstün

- Destekler

- elbette

- Sistemler

- görevleri

- Teknik

- Teknolojileri

- Teknoloji

- telekomünikasyon

- metin

- metin oluşturma

- o

- The

- ve bazı Asya

- Bunlar

- Re-Tweet

- Bu

- zaman

- için

- simge

- Jeton

- Toplam

- Çeviri

- denemek

- öğretici

- iki

- altında

- us

- kullanım

- Kullanılmış

- kullanıcı

- kullanıcı dostu

- kullanım

- kullanma

- çeşitlilik

- çeşitli

- versiyon

- vizyonumuz

- istemek

- we

- ağ

- Web uygulaması

- hangi

- süre

- DSÖ

- geniş

- Geniş ürün yelpazesi

- irade

- ile

- yazı yazıyor

- sen

- zefirnet