LLM'lerin geliştirilmesindeki son gelişmeler, daha önce eski makine öğrenimi yöntemleri kullanılarak ele alınan çeşitli NLP görevlerinde bunların kullanımını yaygınlaştırdı. Büyük dil modelleri, sınıflandırma, özetleme, bilgi alma, içerik oluşturma, soru yanıtlama ve konuşmayı sürdürme gibi çeşitli dil sorunlarını tek bir model kullanarak çözebilir. Peki tüm bu farklı görevlerde iyi bir iş çıkardıklarını nasıl bileceğiz?

Yüksek Lisans'ın yükselişi çözülmemiş bir sorunu gün ışığına çıkardı: Onları değerlendirmek için güvenilir bir standardımız yok. Değerlendirmeyi zorlaştıran şey, bunların çok çeşitli görevler için kullanılması ve her kullanım durumu için iyi bir cevabın ne olduğuna dair net bir tanımdan yoksun olmamızdır.

Bu makale, Yüksek Lisans'ların değerlendirilmesine yönelik güncel yaklaşımları tartışmakta ve mevcut değerlendirme tekniklerini geliştiren, insan değerlendirmesinden yararlanan yeni bir Yüksek Lisans liderlik tablosunu tanıtmaktadır.

İlk ve olağan ilk değerlendirme şekli, modeli çeşitli seçilmiş veri kümeleri üzerinde çalıştırmak ve performansını incelemektir. HuggingFace şunu oluşturdu: LLM Skor Tablosunu Aç açık erişimli büyük modellerin dört iyi bilinen veri kümesi kullanılarak değerlendirildiği yer (AI2 Muhakeme Mücadelesi , HellaSwag , MMLU , DoğruQA). Bu, otomatik değerlendirmeye karşılık gelir ve modelin bazı spesifik sorular için gerçekleri elde etme yeteneğini kontrol eder.

Bu, şu sorudan bir örnek: MMLU Veri kümesi.

Konu: kolej_tıp

Soru: Kreatin takviyesinin beklenen bir yan etkisi:

- A)kas zayıflığı

- B) vücut kitlesinde artış

- C) kas krampları

- D) elektrolit kaybı

Cevap: (B)

Bu tür soruları yanıtlayarak modelin puanlanması önemli bir ölçümdür ve doğruluk kontrolü için iyi bir hizmettir ancak modelin üretken yeteneğini test etmez. Bu muhtemelen bu değerlendirme yönteminin en büyük dezavantajıdır çünkü serbest metin oluşturmak Yüksek Lisans'ın en önemli özelliklerinden biridir.

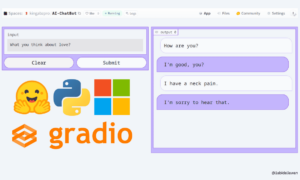

Toplumda, modeli doğru bir şekilde değerlendirmek için insan değerlendirmesine ihtiyacımız olduğu konusunda bir fikir birliği var gibi görünüyor. Bu genellikle farklı modellerden gelen yanıtları karşılaştırarak yapılır.

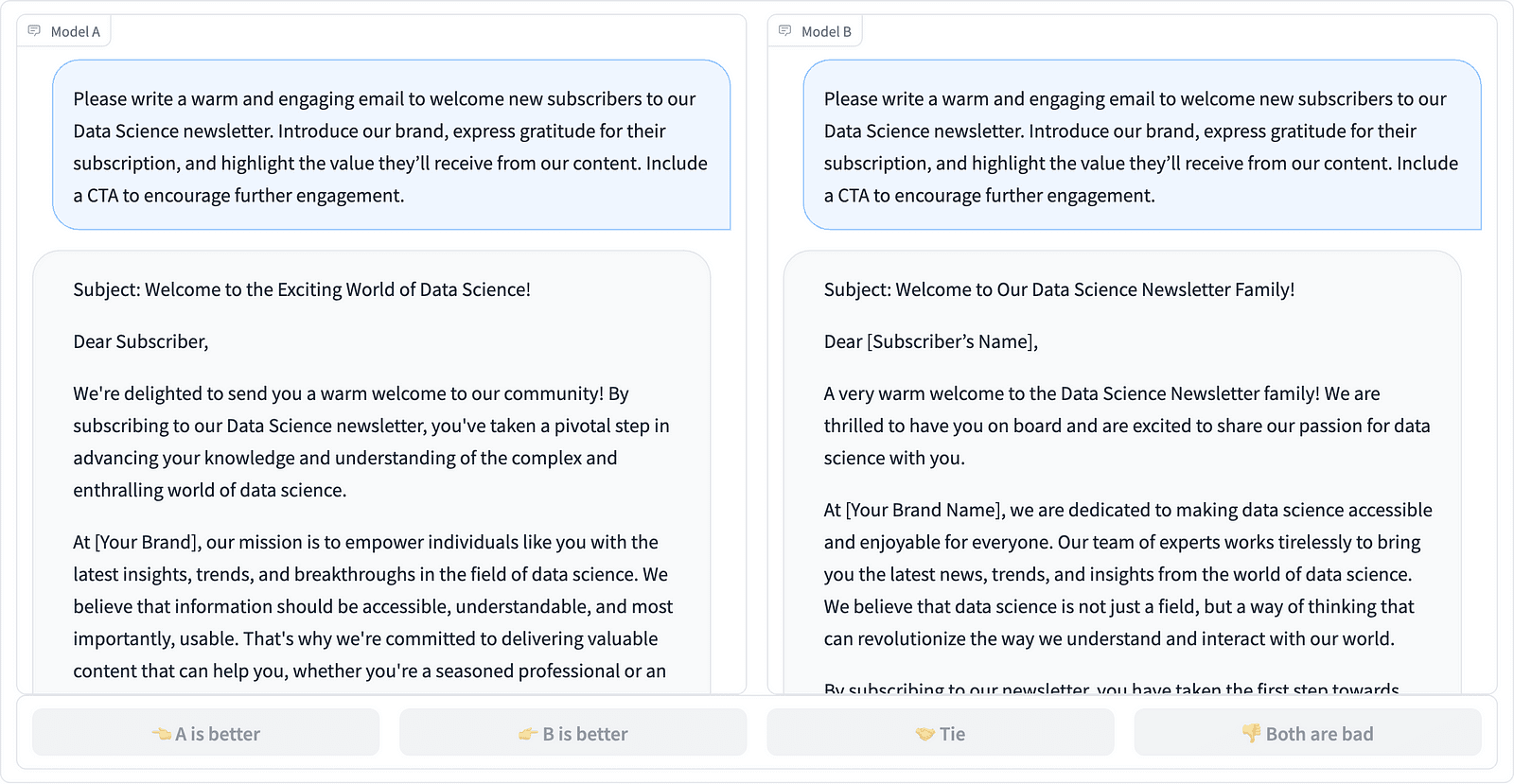

LMSYS projesinde iki istem tamamlamanın karşılaştırılması – Yazarın ekran görüntüsü

Ek açıklamalar, yukarıdaki örnekte görüldüğü gibi hangi yanıtın daha iyi olduğuna karar verir ve bazen hızlı tamamlamaların kalitesindeki farkı ölçer. LMSYS Organizasyonu bir Liderler Sıralaması Bu tür insan değerlendirmesini kullanan ve 17 farklı modeli karşılaştıran, Elo derecesi her model için.

İnsan değerlendirmesinin ölçeklendirilmesi zor olabileceğinden, değerlendirme sürecini ölçeklendirmek ve hızlandırmak için çabalar olmuştur ve bu, adı verilen ilginç bir projeyle sonuçlanmıştır. AlpakaEval. Burada her model bir temel değerle (GPT-003 tarafından sağlanan text-davinci-4) karşılaştırılır ve insan değerlendirmesinin yerini GPT-4 kararı alır. Bu gerçekten hızlı ve ölçeklenebilir ancak puanlamayı gerçekleştirmesi için buradaki modele güvenebilir miyiz? Model önyargılarının farkında olmamız gerekiyor. Proje aslında GPT-4'ün daha uzun yanıtları tercih edebileceğini gösterdi.

Yapay zeka topluluğu kolay, adil ve ölçeklenebilir yaklaşımlar ararken LLM değerlendirme yöntemleri de gelişmeye devam ediyor. En son gelişme Toloka ekibinden yeni bir özellik ile geliyor Liderler Sıralaması Mevcut değerlendirme standartlarını daha da geliştirmek.

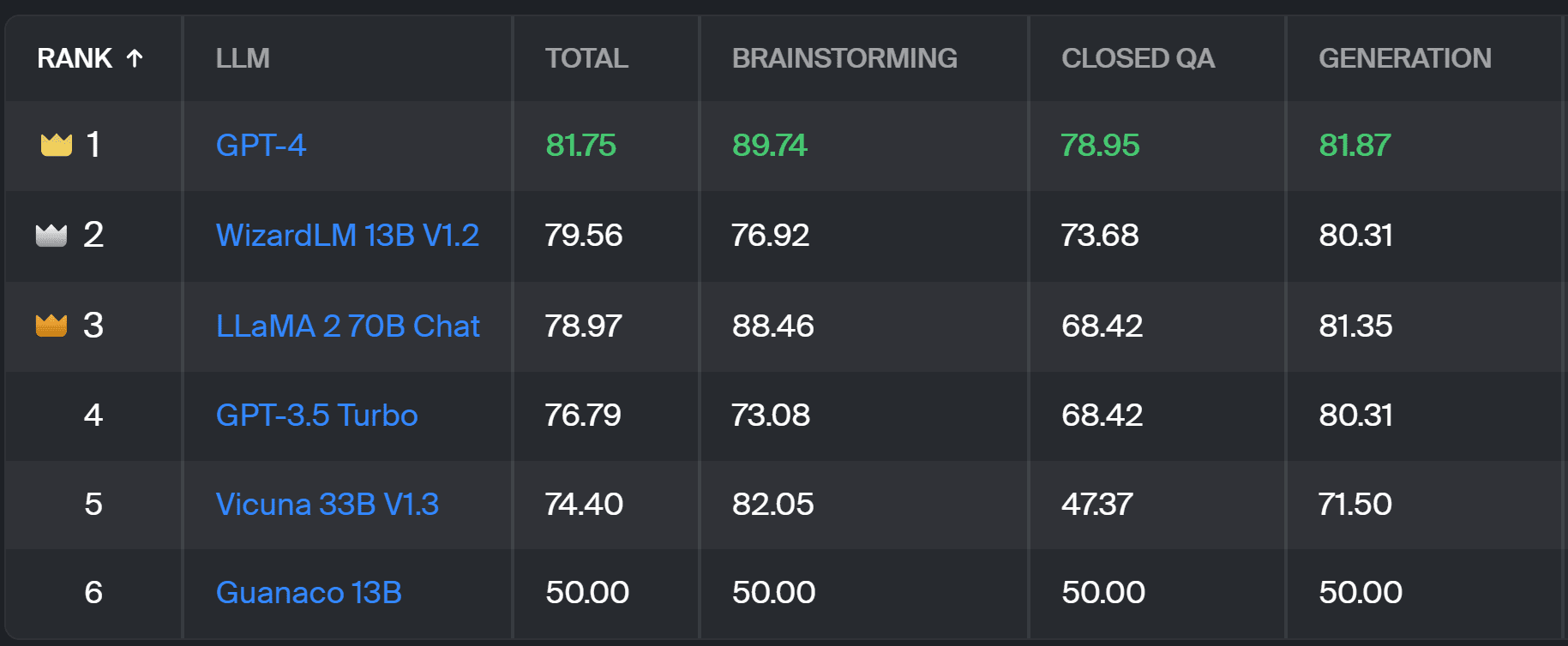

Yeni Liderler Sıralaması model yanıtlarını, aşağıda belirtildiği gibi yararlı NLP görevlerine göre kategorize edilen gerçek dünyadaki kullanıcı istemleriyle karşılaştırır. bu InstructGPT makalesi. Ayrıca her modelin tüm kategorilerdeki genel kazanma oranını da gösterir.

Toloka liderlik tablosu – Yazarın ekran görüntüsü

Bu proje için kullanılan değerlendirme AlpacaEval'de yapılan değerlendirmeye benzer. Liderlik tablosundaki puanlar, ilgili modelin kazanma oranını temsil eder. Guanako 13B Burada temel bir karşılaştırma görevi gören model. Guanaco 13B'nin seçimi, yakında güncelliğini yitirecek olan text-davinci-003 modelini temel olarak kullanan AlpacaEval yönteminde yapılan bir gelişmedir.

Gerçek değerlendirme, bir dizi gerçek dünya istemi üzerine uzman yorumcular tarafından yapılır. Her bilgi istemi için ek açıklamalara iki tamamlama verilir ve hangisini tercih ettikleri sorulur. Metodoloji ile ilgili detayları bulabilirsiniz. okuyun.

Bu tür insan değerlendirmesi, diğer otomatik değerlendirme yöntemlerinden daha faydalıdır ve araştırma için kullanılan insan değerlendirmesini geliştirmelidir. LMSYS liderlik tablosu. LMSYS yönteminin dezavantajı, Link değerlendirmede yer alabilir ve bu şekilde toplanan verilerin kalitesi hakkında ciddi sorular ortaya çıkabilir. Uzman açıklayıcılardan oluşan kapalı bir kalabalık, güvenilir sonuçlar için daha iyi bir potansiyele sahiptir ve Toloka, veri kalitesini sağlamak için ek kalite kontrol teknikleri uygular.

Bu makalede, LLM'leri değerlendirmek için umut verici yeni bir çözüm olan Toloka Liderlik Tablosunu tanıttık. Yaklaşım yenilikçidir, mevcut yöntemlerin güçlü yönlerini birleştirir, göreve özgü ayrıntı düzeyi ekler ve modelleri karşılaştırmak için güvenilir insan açıklama teknikleri kullanır.

Panoyu inceleyin ve iyileştirmelere yönelik görüş ve önerilerinizi bizimle paylaşın.

Magdalena Konkiewicz Hızlı ve ölçeklenebilir yapay zeka gelişimini destekleyen küresel bir şirket olan Toloka'da Veri Evangelistidir. Edinburgh Üniversitesi'nden Yapay Zeka alanında yüksek lisans derecesine sahiptir ve Avrupa ve Amerika'daki işletmelerde NLP Mühendisi, Geliştirici ve Veri Bilimcisi olarak çalışmıştır. Aynı zamanda Veri Bilimcilerine eğitim verme ve mentorluk yapma konularında da görev almaktadır ve Veri Bilimi ve Makine Öğrenimi yayınlarına düzenli olarak katkıda bulunmaktadır.

- SEO Destekli İçerik ve Halkla İlişkiler Dağıtımı. Bugün Gücünüzü Artırın.

- PlatoData.Network Dikey Üretken Yapay Zeka. Kendine güç ver. Buradan Erişin.

- PlatoAiStream. Web3 Zekası. Bilgi Genişletildi. Buradan Erişin.

- PlatoESG. karbon, temiz teknoloji, Enerji, Çevre, Güneş, Atık Yönetimi. Buradan Erişin.

- PlatoSağlık. Biyoteknoloji ve Klinik Araştırmalar Zekası. Buradan Erişin.

- Kaynak: https://www.kdnuggets.com/a-better-way-to-evaluate-llms?utm_source=rss&utm_medium=rss&utm_campaign=a-better-way-to-evaluate-llms

- :vardır

- :dır-dir

- :olumsuzluk

- :Neresi

- $UP

- 17

- a

- kabiliyet

- Hakkımızda

- yukarıdaki

- karşısında

- gerçek

- aslında

- Ek

- Ekler

- ilerlemek

- gelişmeler

- AI

- Türkiye

- Ayrıca

- Amerika

- an

- ve

- cevap

- cevaplar

- herhangi

- geçerlidir

- yaklaşım

- yaklaşımlar

- ARE

- Arena

- göre

- yapay

- yapay zeka

- AS

- At

- Otomatik

- farkında

- b

- Temel

- BE

- Çünkü

- olmuştur

- Daha iyi

- önyargıları

- Biggest

- yazı tahtası

- vücut

- getirdi

- işletmeler

- fakat

- by

- CAN

- yetenekli

- dava

- kategoriler

- meydan okuma

- Çekler

- seçim

- sınıflandırma

- açık

- kapalı

- biçerdöverler

- geliyor

- topluluk

- şirket

- karşılaştırmak

- karşılaştırıldığında

- karşılaştırarak

- karşılaştırma

- Fikir birliği

- içerik

- içerik yaratımı

- devam eden

- katkıda bulunur

- kontrol

- konuşma

- tekabül

- çevrimiçi kurslar düzenliyorlar.

- oluşturma

- kalabalık

- küratörlüğünü

- akım

- veri

- veri kalitesi

- veri bilimi

- veri bilimcisi

- veri kümeleri

- karar vermek

- tanım

- derece

- ayrıntılar

- Geliştirici

- gelişme

- fark

- farklı

- dezavantaj

- çeşitli

- do

- yok

- yapıyor

- yapılmış

- Dont

- olumsuz

- her

- kolay

- Edinburg

- Efekt

- çabaları

- elektrolitler

- mühendis

- sağlamak

- AVRUPA

- değerlendirmek

- değerlendirilir

- değerlendirilmesi

- değerlendirme

- Gezici vaiz

- gelişmek

- muayene etmek

- örnek

- mevcut

- beklenen

- uzman

- gerçekler

- adil

- HIZLI

- iyilik

- Özellikler

- bulmak

- Ad

- İçin

- Airdrop Formu

- dört

- Ücretsiz

- itibaren

- daha fazla

- Kazanç

- toplanmış

- üreten

- üretken

- almak

- GitHub

- verilmiş

- Küresel

- Tercih Etmenizin

- aferin

- Zor

- Daha güçlü

- Var

- okuyun

- büyük ölçüde

- tutar

- Ne kadar

- HTTPS

- SarılmaYüz

- insan

- önemli

- iyileştirmek

- iyileşme

- iyileştirmeler

- geliştirir

- in

- bilgi

- ilk

- yenilikçi

- İstihbarat

- ilginç

- tanıttı

- Tanıtımlar

- ilgili

- IT

- ONUN

- İş

- sadece

- sadece bir

- KDNuggets

- Bilmek

- Eksiklik

- dil

- büyük

- son

- öğrenme

- kaldıraç

- ışık

- uzun

- kayıp

- makine

- makine öğrenme

- sürdürmek

- YAPAR

- tavır

- Kitle

- usta

- Mayıs..

- mentorluk

- yöntem

- metodoloji

- yöntemleri

- metrik

- model

- modelleri

- Daha

- çoğu

- kas

- gerek

- yeni

- yeni çözüm

- nlp

- of

- büyük

- on

- ONE

- açık

- Görüşler

- Diğer

- özetlenen

- tüm

- Bölüm

- yapmak

- performans

- yapılan

- Platon

- Plato Veri Zekası

- PlatoVeri

- potansiyel

- tercih

- Önceden

- muhtemelen

- Sorun

- sorunlar

- süreç

- proje

- umut verici

- istemleri

- uygun şekilde

- sağlanan

- yayınlar

- kalite

- soru

- Sorular

- kaldırma

- oran

- Gerçek dünya

- düzenli

- güvenilir

- yerine

- Raporlama

- temsil etmek

- bu

- yanıt

- yanıtları

- sonuçlandı

- Sonuçlar

- Yükselmek

- koşmak

- s

- ölçeklenebilir

- ölçek

- Bilim

- bilim adamı

- bilim adamları

- skorları

- puanlama

- aramalar

- görünüyor

- görüldü

- ciddi

- vermektedir

- set

- birkaç

- paylaş

- o

- meli

- gösterilen

- Gösteriler

- yan

- benzer

- tek

- çözüm

- Çözme

- biraz

- bazen

- özel

- hız

- standart

- standartlar

- güçlü

- böyle

- Destek

- Bizi daha iyi tanımak için

- görevleri

- Öğretim

- takım

- teknikleri

- test

- metin

- göre

- o

- The

- ve bazı Asya

- Onları

- Orada.

- Bunlar

- onlar

- Re-Tweet

- için

- Güven

- iki

- tip

- tipik

- üniversite

- üzerine

- us

- kullanım

- kullanım

- kullanım durumu

- Kullanılmış

- kullanıcı

- kullanım

- kullanma

- olağan

- çeşitlilik

- Yol..

- we

- zayıflık

- İYİ

- tanınmış

- vardı

- Ne

- Nedir

- hangi

- kazanmak

- ile

- içinde

- işlenmiş

- sen

- zefirnet