Giriş

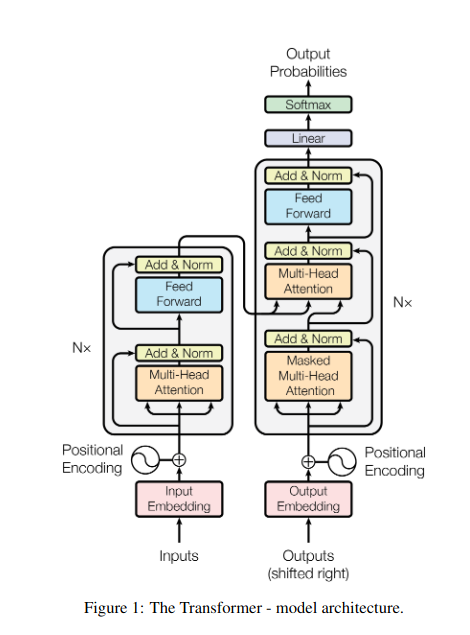

Loş bir kütüphanede durduğunuzu, karmaşık bir belgeyi çözmeye çalışırken düzinelerce başka metinle hokkabazlık yaptığınızı hayal edin. Bu, "İhtiyacınız Olan Tek Şey Dikkat" gazetesinin devrim niteliğindeki spot ışığını ortaya çıkarmasından önce Transformers'ın dünyasıydı. dikkat mekanizması.

İçindekiler

RNN'lerin sınırlamaları

Geleneksel sıralı modeller, Tekrarlayan Sinir Ağları (RNN'ler), dil kelime kelime işlendi ve bu da çeşitli sınırlamalara yol açtı:

- Kısa menzilli bağımlılık: RNN'ler uzak kelimeler arasındaki bağlantıları kavramakta zorlandı ve özne ile fiilin birbirinden çok uzak olduğu "dün hayvanat bahçesini ziyaret eden adam" gibi cümlelerin anlamını sıklıkla yanlış yorumladı.

- Sınırlı paralellik: Bilginin sıralı olarak işlenmesi doğası gereği yavaştır ve özellikle uzun sıralar için verimli eğitimi ve hesaplama kaynaklarının kullanımını engeller.

- Yerel bağlama odaklanın: RNN'ler öncelikle yakın komşuları dikkate alır ve muhtemelen cümlenin diğer kısımlarındaki önemli bilgileri kaçırır.

Bu sınırlamalar, Transformers'ın makine çevirisi ve doğal dil anlama gibi karmaşık görevleri yerine getirme yeteneğini engelledi. Sonra geldi dikkat mekanizması, kelimeler arasındaki gizli bağlantıları aydınlatan, dil işleme anlayışımızı dönüştüren devrim niteliğinde bir ışık. Peki dikkat tam olarak neyi çözdü ve Transformers için oyunu nasıl değiştirdi?

Üç temel alana odaklanalım:

Uzun Menzilli Bağımlılık

- Sorun: Geleneksel modeller sıklıkla "tepede yaşayan kadın dün gece kayan bir yıldız gördü" gibi cümlelerle karşılaşıyordu. Mesafeleri nedeniyle “kadın” ile “kayan yıldız” arasında bağlantı kurmakta zorlandıkları için yanlış yorumlara yol açtılar.

- Dikkat Mekanizması: Modelin cümle boyunca parlak bir ışık saçtığını, “kadın”ı doğrudan “kayan yıldız”a bağladığını ve cümleyi bir bütün olarak anladığını hayal edin. Mesafeden bağımsız olarak ilişkileri yakalama yeteneği, makine çevirisi ve özetleme gibi görevler için çok önemlidir.

Ayrıca Oku: Uzun Kısa Süreli Belleğe (LSTM) Genel Bir Bakış

Paralel İşlem Gücü

- Sorun: Geleneksel modeller, bir kitabı sayfa sayfa okumak gibi bilgileri sırayla işlerdi. Bu, özellikle uzun metinler için yavaş ve verimsizdi.

- Dikkat Mekanizması: Birden fazla spot ışığının aynı anda kitaplığı taradığını, metnin farklı bölümlerini paralel olarak analiz ettiğini hayal edin. Bu, modelin çalışmasını önemli ölçüde hızlandırarak büyük miktarda veriyi verimli bir şekilde işlemesine olanak tanır. Bu paralel işlem gücü, karmaşık modelleri eğitmek ve gerçek zamanlı tahminler yapmak için gereklidir.

Küresel Bağlam Farkındalığı

- Sorun: Geleneksel modeller genellikle cümlenin daha geniş bağlamını gözden kaçırarak tek tek kelimelere odaklanır. Bu durum alaycılık veya çifte anlamlandırma gibi durumlarda yanlış anlaşılmalara yol açıyordu.

- Dikkat Mekanizması: Spot ışığının tüm kütüphaneyi kapsadığını, her kitabı ele aldığını ve birbirleriyle nasıl ilişki kurduğunu anladığını hayal edin. Bu küresel bağlam farkındalığı, modelin her bir kelimeyi yorumlarken metnin tamamını dikkate almasına olanak tanıyarak daha zengin ve daha incelikli bir anlayışa yol açar.

Çok Anlamlı Kelimelerin Belirsizliğinin Giderilmesi

- Sorun: "Banka" veya "elma" gibi kelimeler isimler, fiiller ve hatta şirketler olabilir ve bu da geleneksel modellerin çözmeye çalıştığı belirsizlik yaratır.

- Dikkat Mekanizması: Modelin, "banka" kelimesinin bir cümlede geçtiği tüm yerleri aydınlattığını, ardından çevredeki bağlamı ve diğer kelimelerle olan ilişkilerini analiz ettiğini hayal edin. Dikkat mekanizması dilbilgisel yapıyı, yakındaki isimleri ve hatta geçmiş cümleleri dikkate alarak amaçlanan anlamı çıkarabilir. Çok anlamlı sözcükleri netleştirme yeteneği, makine çevirisi, metin özetleme ve diyalog sistemleri gibi görevler için çok önemlidir.

Bu dört yön (uzun vadeli bağımlılık, paralel işlem gücü, küresel bağlam farkındalığı ve belirsizliği giderme) dikkat mekanizmalarının dönüştürücü gücünü sergiliyor. Transformers'ı doğal dil işlemede ön saflara taşıyarak, karmaşık görevlerin olağanüstü doğruluk ve verimlilikle üstesinden gelmelerine olanak sağladılar.

NLP ve özellikle Yüksek Lisans'lar gelişmeye devam ettikçe, dikkat mekanizmaları şüphesiz daha da kritik bir rol oynayacaktır. Bunlar, kelimelerin doğrusal dizilimi ile insan dilinin zengin dokusu arasındaki köprüdür ve sonuçta bu dil harikalarının gerçek potansiyelini ortaya çıkarmanın anahtarıdır. Bu makale çeşitli dikkat mekanizmaları ve bunların işlevlerini ele almaktadır.

1. Kişisel Dikkat: Transformer'ın Yol Gösterici Yıldızı

Birden fazla kitapla hokkabazlık yaptığınızı ve özet yazarken her birinde belirli pasajlara atıfta bulunmanız gerektiğini düşünün. Kişisel dikkat veya Ölçeklendirilmiş Nokta-Ürün dikkati akıllı bir asistan gibi davranarak modellerin cümleler veya zaman serileri gibi sıralı verilerle aynı şeyi yapmasına yardımcı olur. Uzun vadeli bağımlılıkları ve karmaşık ilişkileri etkili bir şekilde yakalayarak dizideki her bir öğenin diğer tüm öğelerle ilgilenmesine olanak tanır.

İşte temel teknik yönlerine daha yakından bir bakış:

Vektör Gösterimi

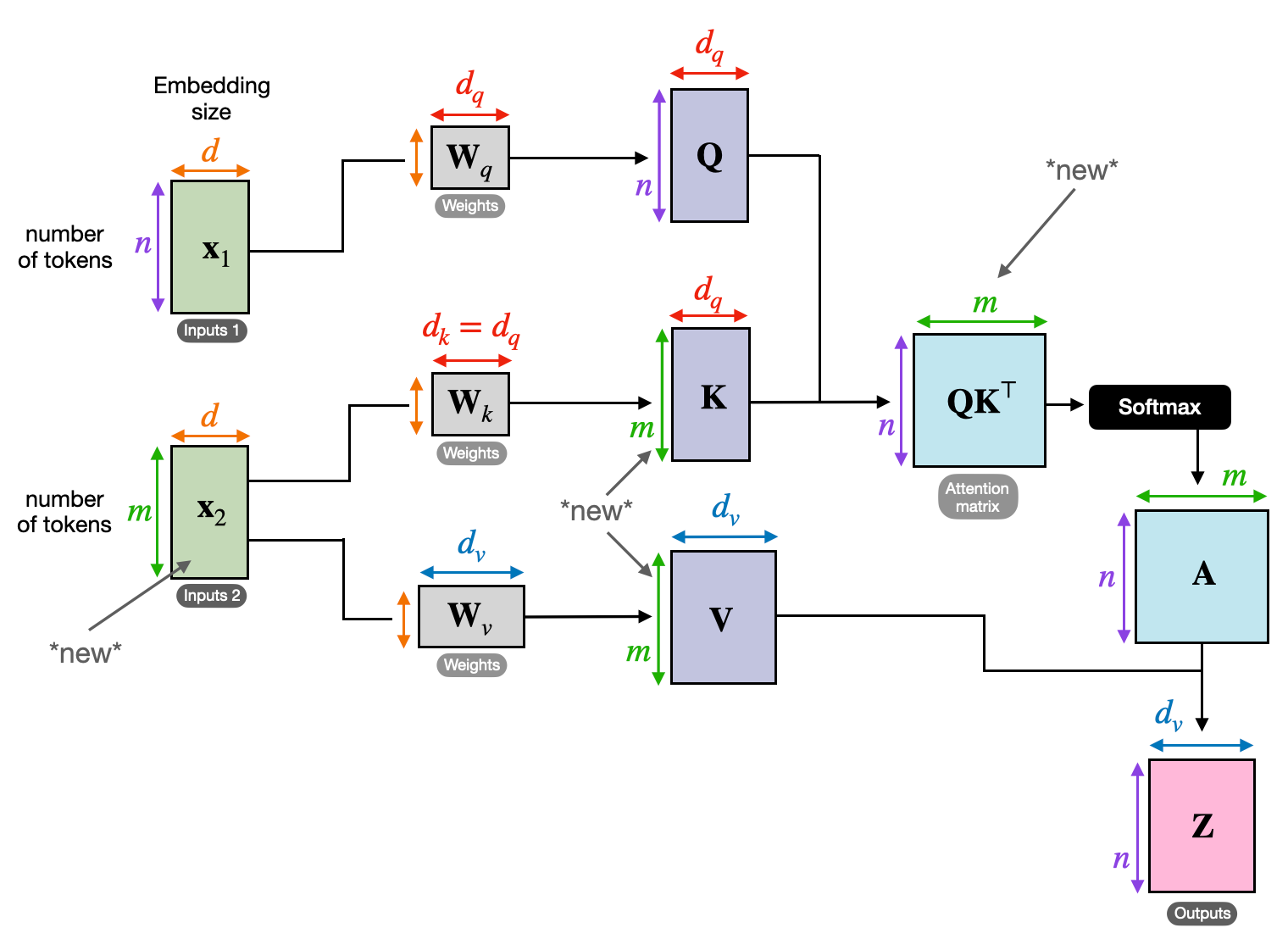

Her öğe (kelime, veri noktası), bilgi içeriğini kodlayan yüksek boyutlu bir vektöre dönüştürülür. Bu vektör uzayı elementler arasındaki etkileşimin temelini oluşturur.

QKV Dönüşümü

Üç temel matris tanımlanmıştır:

- Sorgu (S): Her bir unsurun diğerlerine yönelttiği “soruyu” temsil eder. Q, mevcut öğenin bilgi ihtiyaçlarını yakalar ve dizi içindeki ilgili bilgi arayışına rehberlik eder.

- Anahtar (K): Her elementin bilgilerinin “anahtarını” tutar. K, her bir öğenin içeriğinin özünü kodlayarak diğer öğelerin kendi ihtiyaçlarına göre potansiyel alaka düzeyini belirlemesine olanak tanır.

- Değer (V): Her öğenin paylaşmak istediği gerçek içeriği saklar. V, diğer öğelerin dikkat puanlarına göre erişebileceği ve yararlanabileceği ayrıntılı bilgileri içerir.

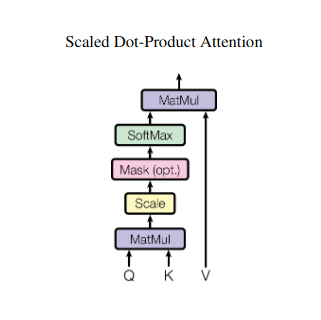

Dikkat Puanı Hesaplama

Her bir eleman çifti arasındaki uyumluluk, ilgili Q ve K vektörleri arasındaki nokta çarpımı aracılığıyla ölçülür. Daha yüksek puanlar, öğeler arasındaki potansiyel ilişkinin daha güçlü olduğunu gösterir.

Ölçeklendirilmiş Dikkat Ağırlıkları

Göreceli önemi sağlamak için bu uyumluluk puanları softmax işlevi kullanılarak normalleştirilir. Bu, mevcut öğenin bağlamı için her öğenin ağırlıklı önemini temsil eden, 0'dan 1'e kadar değişen dikkat ağırlıklarıyla sonuçlanır.

Ağırlıklı Bağlam Toplama

Dikkat ağırlıkları V matrisine uygulanır ve temel olarak her bir öğeden gelen önemli bilgiler, mevcut öğeyle olan ilgisine göre vurgulanır. Bu ağırlıklı toplam, dizideki diğer tüm öğelerden derlenen içgörüleri birleştirerek mevcut öğe için bağlamsallaştırılmış bir temsil oluşturur.

Gelişmiş Öğe Gösterimi

Zenginleştirilmiş temsiliyle öğe artık kendi içeriğinin yanı sıra dizideki diğer öğelerle olan ilişkileri hakkında daha derin bir anlayışa sahiptir. Bu dönüştürülmüş gösterim, model içindeki sonraki işlemlerin temelini oluşturur.

Bu çok adımlı süreç, kişisel dikkatin aşağıdakilere ulaşmasını sağlar:

- Uzun vadeli bağımlılıkları yakalayın: Uzak öğeler arasındaki ilişkiler, araya giren birden fazla öğeyle ayrılmış olsa bile kolayca görünür hale gelir.

- Karmaşık etkileşimleri modelleyin: Dizi içindeki ince bağımlılıklar ve korelasyonlar gün ışığına çıkarılarak veri yapısı ve dinamiklerinin daha zengin anlaşılması sağlanır.

- Her öğeyi bağlamsallaştırın: Model, her bir öğeyi ayrı ayrı değil, dizinin daha geniş çerçevesi içinde analiz ederek daha doğru ve incelikli tahminlere veya temsillere yol açar.

Öz dikkat, modellerin sıralı verileri işleme biçiminde devrim yaratarak makine çevirisi, doğal dil üretimi, zaman serisi tahmini ve ötesi gibi çeşitli alanlarda yeni olanakların kilidini açtı. Diziler içindeki gizli ilişkileri ortaya çıkarma yeteneği, içgörüleri ortaya çıkarmak ve çok çeşitli görevlerde üstün performans elde etmek için güçlü bir araç sağlar.

2. Çok Kafalı Dikkat: Farklı Lenslerle Görmek

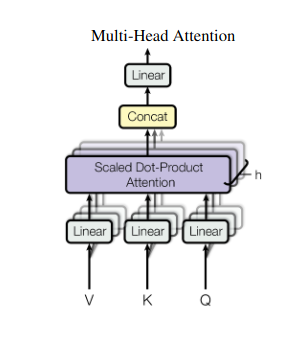

Kişisel dikkat bütünsel bir bakış açısı sağlar ancak bazen verilerin belirli yönlerine odaklanmak çok önemlidir. Çok kafalı dikkatin devreye girdiği yer burasıdır. Her biri farklı merceklerle donatılmış birden fazla asistanınız olduğunu hayal edin:

- Çoklu “kafalar” her biri giriş dizisine kendi Q, K ve V matrisleri aracılığıyla katılan, oluşturulur.

- Her kafa, uzun vadeli bağımlılıklar, sözdizimsel ilişkiler veya yerel kelime etkileşimleri gibi verilerin farklı yönlerine odaklanmayı öğrenir.

- Her bir kafadan gelen çıktılar daha sonra birleştirilir ve girdinin çok yönlü doğasını yakalayan son bir temsile yansıtılır.

Bu, modelin aynı anda çeşitli perspektifleri dikkate almasına olanak tanıyarak verilerin daha zengin ve daha incelikli bir şekilde anlaşılmasına olanak tanır.

3. Çapraz Dikkat: Diziler Arasında Köprüler Kurmak

Farklı bilgi parçaları arasındaki bağlantıları anlama yeteneği, birçok NLP görevi için çok önemlidir. Bir kitap incelemesi yazdığınızı hayal edin; yalnızca metni kelimesi kelimesine özetlemekle kalmaz, bunun yerine bölümler arasındaki içgörüleri ve bağlantıları ortaya çıkarırsınız. Girmek çapraz dikkat, diziler arasında köprüler kuran, modellerin iki farklı kaynaktan gelen bilgilerden yararlanmasını sağlayan güçlü bir mekanizma.

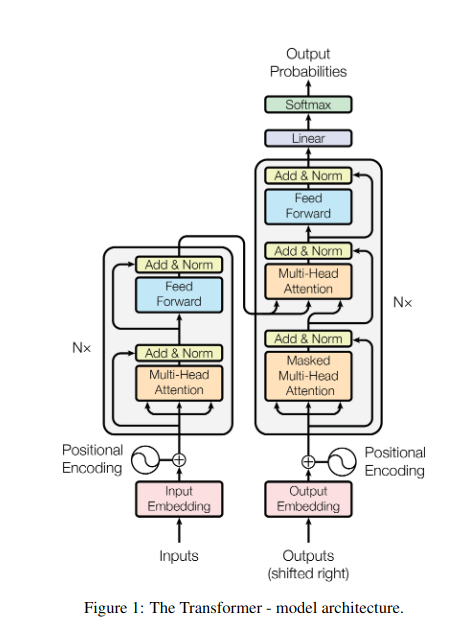

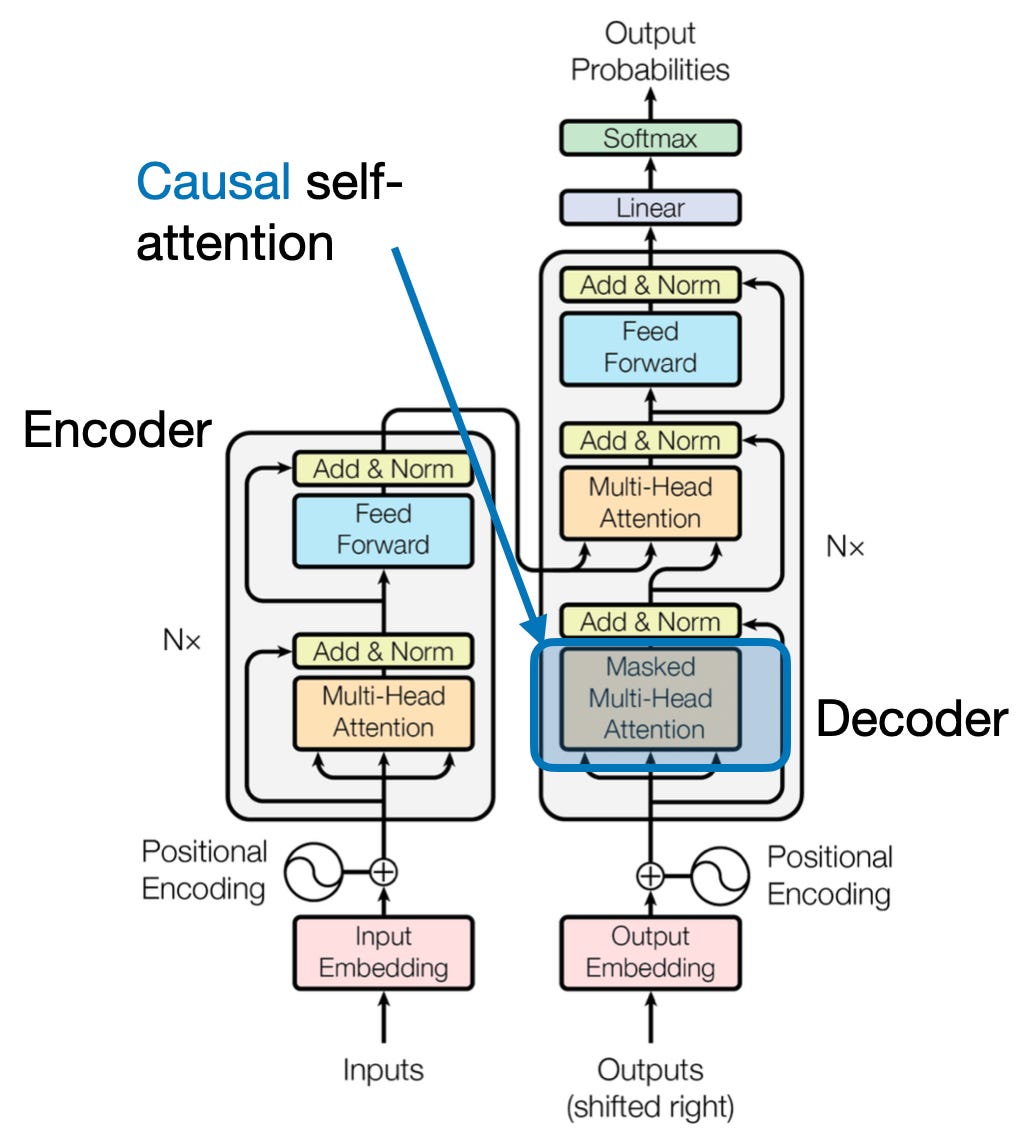

- Transformers gibi kodlayıcı-kod çözücü mimarilerinde, kodlayıcı giriş sırasını (kitap) işler ve gizli bir gösterim oluşturur.

- The şifre çözücü Çıkış sırasını (inceleme) oluştururken her adımda kodlayıcının gizli temsiline katılmak için çapraz dikkati kullanır.

- Kod çözücünün Q matrisi, kodlayıcının K ve V matrisleriyle etkileşime girerek incelemenin her cümlesini yazarken kitabın ilgili bölümlerine odaklanmasını sağlar.

Bu mekanizma, girdi ve çıktı dizileri arasındaki ilişkilerin anlaşılmasının önemli olduğu makine çevirisi, özetleme ve soru yanıtlama gibi görevler için çok değerlidir.

4. Nedensel Dikkat: Zamanın Akışını Korumak

İleriye bakmadan bir cümledeki sonraki kelimeyi tahmin ettiğinizi hayal edin. Geleneksel dikkat mekanizmaları, metin oluşturma ve zaman serisi tahmini gibi bilginin zamansal sırasını korumayı gerektiren görevlerle uğraşır. Sıraya kolayca "ileriye bakarlar" ve bu da yanlış tahminlere yol açar. Nedensel dikkat, tahminlerin yalnızca önceden işlenmiş bilgilere dayanmasını sağlayarak bu sınırlamayı giderir.

İşte Nasıl Çalışır

- Maskeleme Mekanizması: Dikkat ağırlıklarına özel bir maske uygulanarak modelin dizideki gelecekteki öğelere erişimi etkili bir şekilde engellenir. Örneğin, "kadın kim..." ifadesindeki ikinci kelimeyi tahmin ederken model, "kim" veya sonraki kelimeleri değil yalnızca "the" kelimesini dikkate alabilir.

- Otoregresif İşleme: Bilgi doğrusal olarak akar ve her öğenin temsili yalnızca kendisinden önce görünen öğelerden oluşturulur. Model, diziyi kelime kelime işler ve o noktaya kadar oluşturulan bağlama dayalı tahminler üretir.

Verilerin zamansal sırasını korumanın doğru tahminler için hayati önem taşıdığı metin oluşturma ve zaman serisi tahmini gibi görevler için nedensel dikkat çok önemlidir.

5. Küresel ve Yerel Dikkat: Dengeyi Kurmak

Dikkat mekanizmaları önemli bir ödünleşimle karşı karşıyadır: uzun vadeli bağımlılıkları yakalamak ile verimli hesaplamayı sürdürmek. Bu, iki temel yaklaşımda kendini gösterir: küresel ilgi ve yerel dikkat. Belirli bir bölüme odaklanmak yerine bir kitabın tamamını okuduğunuzu hayal edin. Küresel dikkat tüm süreci aynı anda işlerken, yerel dikkat daha küçük bir pencereye odaklanır:

- Küresel ilgi uzun vadeli bağımlılıkları ve genel bağlamı yakalar ancak uzun diziler için hesaplama açısından pahalı olabilir.

- Yerel ilgi daha verimlidir ancak uzak ilişkileri kaçırabilir.

Küresel ve yerel ilgi arasındaki seçim çeşitli faktörlere bağlıdır:

- Görev gereksinimleri: Makine çevirisi gibi görevler, uzak ilişkilerin yakalanmasını ve küresel ilginin desteklenmesini gerektirirken, duygu analizi yerel dikkatin odaklanmasını destekleyebilir.

- dizi uzunluğu: Daha uzun diziler, küresel ilgiyi hesaplama açısından pahalı hale getirir ve yerel veya hibrit yaklaşımları gerektirir.

- Modeli kapasitesi: Kaynak kısıtlamaları, küresel bağlam gerektiren görevler için bile yerel dikkat gerektirebilir.

Optimum dengeyi elde etmek için modeller şunları kullanabilir:

- Dinamik anahtarlama: önem ve mesafeye göre uyum sağlayarak, temel unsurlar için küresel dikkati ve diğerleri için yerel dikkati kullanın.

- Hibrit yaklaşımlar: her iki mekanizmayı da aynı katmanda birleştirerek, ilgili güçlerini kullanır.

Ayrıca Oku: Derin Öğrenmede Sinir Ağı Türlerinin Analizi

Sonuç

Sonuçta ideal yaklaşım, küresel ve yerel dikkat arasındaki bir spektrumda yatmaktadır. Bu ödünleşimleri anlamak ve uygun stratejileri benimsemek, modellerin farklı ölçeklerdeki ilgili bilgileri verimli bir şekilde kullanmasına olanak tanır ve bu da dizinin daha zengin ve daha doğru anlaşılmasına yol açar.

Referanslar

- Raschka, S. (2023). “LLM'lerde Öz-Dikkat, Çok Kafalı Dikkat, Çapraz Dikkat ve Nedensel Dikkati Anlamak ve Kodlamak.”

- Vaswani, A., ve diğerleri. (2017). “İhtiyacınız Olan Tek Şey Dikkat.”

- Radford, A., ve ark. (2019). “Dil Modelleri Denetimsiz Çoklu Görev Öğrenicileridir.”

İlgili bağlantılar

- SEO Destekli İçerik ve Halkla İlişkiler Dağıtımı. Bugün Gücünüzü Artırın.

- PlatoData.Network Dikey Üretken Yapay Zeka. Kendine güç ver. Buradan Erişin.

- PlatoAiStream. Web3 Zekası. Bilgi Genişletildi. Buradan Erişin.

- PlatoESG. karbon, temiz teknoloji, Enerji, Çevre, Güneş, Atık Yönetimi. Buradan Erişin.

- PlatoSağlık. Biyoteknoloji ve Klinik Araştırmalar Zekası. Buradan Erişin.

- Kaynak: https://www.analyticsvidhya.com/blog/2024/01/different-types-of-attention-mechanisms/

- :vardır

- :dır-dir

- :olumsuzluk

- :Neresi

- $UP

- 1

- 2017

- 2019

- 2023

- 302

- 320

- 321

- 7

- a

- kabiliyet

- erişim

- doğruluk

- doğru

- Başarmak

- elde

- karşısında

- eylemler

- gerçek

- adresleri

- Benimsemek

- önde

- AL

- Türkiye

- Izin

- veriyor

- am

- Belirsizlik

- tutarları

- an

- analiz

- analizler

- analiz

- ve

- yanıtlama

- ayrı

- bariz

- uygulamalı

- yaklaşım

- yaklaşımlar

- ARE

- alanlar

- göre

- AS

- yönleri

- Asistan

- yardımcıları

- At

- katılmak

- katılıyor

- Dikkat

- farkındalık

- Bakiye

- merkezli

- temel

- BE

- kiriş

- müşterimiz

- önce

- arasında

- Ötesinde

- bloke etme

- kitap

- Kitaplar

- her ikisi de

- KÖPRÜ

- köprüler

- Parlak

- Daha geniş

- getirdi

- bina

- inşa

- yapılı

- fakat

- by

- geldi

- CAN

- ele geçirmek

- yakalar

- Yakalama

- durumlarda

- değişiklik

- bölüm

- bölümler

- seçim

- yakın

- kodlama

- birleştirmek

- geliyor

- Şirketler

- uygunluk

- karmaşık

- hesaplama

- bilişimsel

- Sosyal medya

- bağlantı

- Bağlantılar

- Düşünmek

- düşünen

- kısıtlamaları

- içeren

- içerik

- bağlam

- devam etmek

- çekirdek

- bağıntılar

- çevrimiçi kurslar düzenliyorlar.

- oluşturur

- Oluşturma

- kritik

- çok önemli

- akım

- veri

- veri bilimi

- çözmek

- derin

- derin

- tanımlı

- Araştırmalar

- bağlı

- bağımlılık

- bağımlılıklar

- Bağımlılık

- bağlıdır

- detaylı

- Diyalog

- DID

- farklı

- direkt olarak

- mesafe

- Uzak

- farklı

- çeşitli

- do

- belge

- DOT

- çift

- onlarca

- dramatik

- çekmek

- gereken

- dinamik

- E&T

- her

- etkili bir şekilde

- verim

- verimli

- verimli biçimde

- eleman

- elemanları

- güçlendirici

- sağlar

- etkinleştirme

- kodlama

- zenginleştirilmiş

- sağlamak

- sağlanması

- Keşfet

- Tüm

- bütünlük

- donanımlı

- özellikle

- öz

- gerekli

- esasen

- kurulmuş

- Hatta

- Her

- gelişmek

- kesinlikle

- pahalı

- sömürmek

- çıkarmak

- Yüz

- faktörler

- uzak

- iyilik

- alan

- Alanlar

- son

- akış

- Akışları

- odak

- odaklanmış

- odaklanır

- odaklanma

- İçin

- Forefront

- formlar

- vakıf

- dört

- iskelet

- itibaren

- işlev

- işlevsellikleri

- gelecek

- oyun

- üretir

- üreten

- nesil

- Küresel

- küresel bağlam

- kavramak

- Büyümek

- Rehberler

- rehberlik

- sap

- Var

- sahip olan

- baş

- yardım

- Gizli

- Yüksek

- daha yüksek

- vurgulayarak

- tutar

- bütünsel

- Ne kadar

- HTTPS

- insan

- melez

- i

- ideal

- belirlemek

- if

- resim

- Acil

- önem

- önemli

- in

- yanlış

- birleşmeyle

- belirtmek

- bireysel

- verimsiz

- bilgi

- doğal olarak

- giriş

- anlayışlar

- örnek

- Akıllı

- yönelik

- etkileşim

- etkileşimleri

- etkileşime

- Aradan

- içine

- paha biçilmez

- izolasyon

- IT

- ONUN

- jpg

- sadece

- anahtar

- Anahtar Alanlar

- dil

- Soyad

- tabaka

- önemli

- ÖĞRENİN

- Öğren ve Büyüm

- öğrenenler

- öğrenme

- Led

- Lens

- lensler

- Kaldıraç

- kaldıraç

- Kütüphane

- yalan

- ışık

- sevmek

- sınırlama

- sınırlamaları

- yerel

- Uzun

- uzun

- Bakın

- Aşk

- makine

- makine öğrenme

- makine çevirisi

- sürdürmek

- yapmak

- Yapımı

- adam

- çok

- maske

- Matris

- maksimum genişlik

- anlam

- anlamları

- ölçülü

- mekanizma

- mekanizmaları

- Bellek

- olabilir

- kaçırmak

- eksik

- model

- modelleri

- Daha

- daha verimli

- çok yönlü

- çoklu

- Doğal (Madenden)

- Doğal lisan

- Doğal Dil Üretimi

- Doğal Dil İşleme

- Doğal Dil Anlayışı

- Tabiat

- gerek

- gerek

- ihtiyaçlar

- komşular

- ağlar

- sinirsel

- nöral ağlar

- yeni

- sonraki

- gece

- nlp

- isimler

- şimdi

- detaylı

- of

- sık sık

- on

- bir Zamanlar

- bir tek

- optimum

- or

- sipariş

- Diğer

- Diğer

- bizim

- dışarı

- çıktı

- çıkışlar

- tüm

- genel bakış

- kendi

- Kanal

- çift

- kâğıt

- Paralel

- parçalar

- pasajlar

- geçmiş

- desen

- yapmak

- performans

- perspektifler

- parçalar

- Platon

- Plato Veri Zekası

- PlatoVeri

- OYNA

- Nokta

- pozlar

- sahip

- olanakları

- güçlü

- potansiyel

- potansiyel

- güç kelimesini seçerim

- güçlü

- tahmin

- Tahminler

- korunması

- önlenmesi

- Önceden

- öncelikle

- birincil

- süreç

- işlenmiş

- Süreçler

- işleme

- İşleme gücü

- PLATFORM

- tahmin

- tahrikli

- sağlar

- soru

- menzil

- değişen

- daha doğrusu

- Okumak

- kolayca

- Okuma

- gerçek zaman

- referans

- Ne olursa olsun

- İlişkiler

- bağıl

- ilgisi

- uygun

- dikkat çekici

- temsil

- temsil

- temsil

- gerektirir

- çözmek

- kaynak

- Kaynaklar

- bu

- Sonuçlar

- yorum

- devrimci

- devrim

- Zengin

- Rol

- s

- aynı

- iğneleme

- testere

- terazi

- tarama

- Bilim

- Gol

- skorları

- Ara

- İkinci

- görme

- cümle

- duygu

- Dizi

- Dizi

- vermektedir

- birkaç

- paylaş

- parlıyor

- çekim

- kısa

- vitrin

- aynı anda

- yavaş

- daha küçük

- yalnızca

- ÇÖZMEK

- bazen

- kaynaklar

- uzay

- özel

- özellikle

- Spektrum

- hızları

- spot

- ayakta

- Star

- adım

- mağaza

- stratejileri

- güçlü

- güçlü

- yapı

- Çabalama

- Mücadele

- konu

- sonraki

- böyle

- uygun

- toplam

- özetlemek

- ÖZET

- üstün

- çevreleyen

- Sistemler

- ele almak

- alma

- goblen

- görevleri

- Teknik

- dönem

- metin

- metin oluşturma

- o

- The

- Dünya

- ve bazı Asya

- Onları

- sonra

- Bunlar

- onlar

- Re-Tweet

- üç

- İçinden

- zaman

- Zaman serisi

- için

- araç

- geleneksel

- Eğitim

- dönüştürücü

- transforme

- transformatör

- transformatörler

- dönüşüm

- Çeviri

- gerçek

- iki

- türleri

- eninde sonunda

- anlamak

- anlayış

- şüphesiz

- açma

- ortaya çıkarmak

- açıkladı

- kullanım

- kullanım

- kullanma

- çeşitli

- Geniş

- Karşı

- Görüntüle

- ziyaret

- hayati

- vs

- istemek

- istiyor

- oldu

- İYİ

- Ne

- ne zaman

- süre

- DSÖ

- bütün

- geniş

- Geniş ürün yelpazesi

- irade

- pencere

- ile

- içinde

- olmadan

- kadın

- Word

- sözler

- İş

- Dünya

- yazı yazıyor

- dün

- sen

- zefirnet

- ZOO