แซมอายุได้หกเดือนเมื่อเขาติดกล้องน้ำหนักเบาไว้บนหน้าผากเป็นครั้งแรก

ในอีกครึ่งปีข้างหน้า กล้องจับภาพตัวอย่างชีวิตของเขา เขาคลานไปรอบๆ สัตว์เลี้ยงของครอบครัว ดูพ่อแม่ทำอาหาร และร้องไห้ที่ระเบียงหน้าบ้านกับคุณยาย ขณะเดียวกันกล้องก็บันทึกทุกสิ่งที่เขาได้ยิน

สิ่งที่ดูเหมือนโฮมวิดีโอสำหรับเด็กวัยหัดเดินที่น่ารักนั้นเป็นแนวคิดที่ท้าทายจริงๆ: AI สามารถเรียนรู้ภาษาเหมือนเด็กได้หรือไม่? ผลลัพธ์ยังเผยให้เห็นว่าเด็กๆ เรียนรู้ภาษาและแนวคิดอย่างรวดเร็วตั้งแต่อายุยังน้อยได้อย่างไร

การศึกษาใหม่ in วิทยาศาสตร์ อธิบายวิธีที่นักวิจัยใช้การบันทึกของ Sam เพื่อฝึก AI ให้เข้าใจภาษา ด้วยประสบการณ์ชีวิตของเด็กคนหนึ่งเพียงเล็กน้อยในหนึ่งปี AI จึงสามารถเข้าใจแนวคิดพื้นฐาน เช่น ลูกบอล ผีเสื้อ หรือถังได้

AI ที่เรียกว่า Child's View for Contrastive Learning (CVCL) เลียนแบบวิธีการเรียนรู้ของเราเมื่อตอนเป็นเด็กวัยหัดเดินโดยการจับคู่ภาพกับเสียง มันเป็นแนวทางที่แตกต่างอย่างมากจากการใช้โมเดลภาษาขนาดใหญ่เช่นนี้ ด้านหลัง ChatGPT หรือ Bard. ความสามารถอันน่าทึ่งของโมเดลเหล่านี้ในการประดิษฐ์เรียงความ บทกวี หรือแม้แต่สคริปต์พอดแคสต์ทำให้โลกตื่นเต้นเร้าใจ แต่พวกเขาจำเป็นต้องแยกแยะคำศัพท์นับล้านล้านคำจากบทความข่าว บทภาพยนตร์ และหนังสือที่หลากหลายเพื่อพัฒนาทักษะเหล่านี้

ในทางตรงกันข้าม เด็กๆ เรียนรู้โดยใช้ข้อมูลน้อยกว่ามากและสรุปการเรียนรู้อย่างรวดเร็วเมื่อโตขึ้น นักวิทยาศาสตร์สงสัยมานานแล้วว่า AI สามารถจับความสามารถเหล่านี้จากประสบการณ์ในชีวิตประจำวันเพียงอย่างเดียวได้หรือไม่

“เราแสดงให้เห็นเป็นครั้งแรกว่าโครงข่ายประสาทเทียมที่ได้รับการฝึกอบรมเกี่ยวกับข้อมูลพัฒนาการที่สมจริงจากเด็กคนเดียวสามารถเรียนรู้ที่จะเชื่อมโยงคำศัพท์เข้ากับคำศัพท์ที่มองเห็นได้” ดร. Wai Keen Vong ผู้เขียนการศึกษาจากศูนย์วิทยาศาสตร์ข้อมูลของ NYU กล่าวในการแถลงข่าว เกี่ยวกับการวิจัย

ของเด็กเล่น

เด็ก ๆ ซึมซับคำศัพท์และความหมายจากประสบการณ์ในชีวิตประจำวันได้อย่างง่ายดาย

เมื่ออายุเพียงหกเดือน พวกเขาเริ่มเชื่อมโยงคำศัพท์กับสิ่งที่พวกเขาเห็น ตัวอย่างเช่น สิ่งที่เด้งเป็นวงกลมคือ "ลูกบอล" เมื่ออายุได้ 300 ปี พวกเขาจะรู้คำศัพท์และแนวคิดประมาณ XNUMX คำ

นักวิทยาศาสตร์ถกเถียงกันมานานแล้วว่าสิ่งนี้เกิดขึ้นได้อย่างไร ทฤษฎีหนึ่งบอกว่าเด็กๆ เรียนรู้ที่จะจับคู่สิ่งที่พวกเขาเห็นกับสิ่งที่พวกเขาได้ยิน อีกประการหนึ่งแนะนำว่าการเรียนรู้ภาษาต้องอาศัยประสบการณ์ในโลกกว้าง เช่น ปฏิสัมพันธ์ทางสังคมและความสามารถในการใช้เหตุผล

เป็นการยากที่จะแยกแนวคิดเหล่านี้ออกจากกันด้วยการทดสอบความรู้ความเข้าใจแบบดั้งเดิมในเด็กเล็ก แต่เราอาจได้คำตอบจากการฝึกฝน AI ผ่านตาและหูของเด็ก

เอ็ม3แกน?

การศึกษาครั้งใหม่นี้ใช้แหล่งข้อมูลวิดีโอที่เรียกว่า เซย์แคมซึ่งรวมถึงข้อมูลที่รวบรวมจากเด็กสามคนที่มีอายุระหว่าง 6 ถึง 32 เดือนโดยใช้กล้องที่มีลักษณะคล้าย GoPro ติดอยู่ที่หน้าผาก

กล้องจะบันทึกภาพและเสียงประมาณหนึ่งชั่วโมงสัปดาห์ละสองครั้งขณะดูแล คลาน และเล่น บทสนทนาที่ได้ยินทั้งหมดจะถูกแปลงเป็น “คำพูด” ซึ่งเป็นคำหรือประโยคที่พูดก่อนที่ผู้พูดหรือบทสนทนาจะเปลี่ยนไป ผลลัพธ์ที่ได้คือข้อมูลมัลติมีเดียมากมายจากมุมมองของเด็กทารกและเด็กเล็ก

สำหรับระบบใหม่นี้ ทีมงานได้ออกแบบโครงข่ายประสาทเทียม 2 โครงข่ายโดยมี “ผู้พิพากษา” เพื่อประสานงานโครงข่ายประสาททั้งสอง ภาพบุคคลที่หนึ่งแปลเป็นภาพใครและฉากอะไร—แม่ทำอาหารหรือเปล่า? ส่วนคำและความหมายอื่นๆ ที่ถอดรหัสจากการบันทึกเสียง

จากนั้นทั้งสองระบบก็มีความสัมพันธ์กันตามเวลา ดังนั้น AI จึงเรียนรู้ที่จะเชื่อมโยงภาพที่ถูกต้องกับคำศัพท์ ตัวอย่างเช่น AI เรียนรู้ที่จะจับคู่ภาพเด็กทารกกับคำว่า “ดูสิ มีลูกแล้ว” หรือภาพลูกบอลโยคะกับ “ว้าว นั่นมันลูกบอลใหญ่” ด้วยการฝึกฝน พวกเขาค่อยๆ เรียนรู้ที่จะแยกแนวคิดเรื่องลูกบอลโยคะออกจากเด็กทารก

“สิ่งนี้ช่วยให้แบบจำลองทราบว่าคำใดควรเชื่อมโยงกับวัตถุใด” หว่องกล่าว

จากนั้นทีมงานได้ฝึก AI ในวิดีโอจากชีวิตประมาณหนึ่งปีครึ่งของ Sam รวมกันแล้วมีเฟรมวิดีโอมากกว่า 600,000 เฟรม และคำพูดที่ถอดเสียง 37,500 คำ แม้ว่าตัวเลขจะดูมาก แต่ก็เป็นเพียงประมาณร้อยละ XNUMX ของชีวิตตื่นในแต่ละวันของ Sam และเรื่องไร้สาระ เมื่อเทียบกับปริมาณข้อมูลที่ใช้ในการฝึกโมเดลภาษาขนาดใหญ่

Baby AI กำลังมาแรง

เพื่อทดสอบระบบ ทีมงานได้ปรับแบบทดสอบความรู้ความเข้าใจทั่วไปที่ใช้วัดความสามารถทางภาษาของเด็ก พวกเขาแสดงภาพใหม่สี่ภาพให้กับ AI ได้แก่ แมว เปล ลูกบอล และสนามหญ้า และถามว่าภาพไหนคือลูกบอล

โดยรวมแล้ว AI เลือกภาพที่ถูกต้องประมาณ 62 เปอร์เซ็นต์ของเวลาทั้งหมด ประสิทธิภาพเกือบจะตรงกับอัลกอริธึมล้ำสมัยที่ได้รับการฝึกฝนกับคู่รูปภาพและข้อความกว่า 400 ล้านคู่จากเว็บ ซึ่งมีปริมาณข้อมูลมากกว่าที่ใช้ในการฝึกอบรม AI ในการศึกษานี้ พวกเขาพบว่าการเชื่อมโยงภาพวิดีโอกับเสียงเป็นสิ่งสำคัญ เมื่อทีมสับเปลี่ยนเฟรมวิดีโอและคำพูดที่เกี่ยวข้อง โมเดลก็พังโดยสิ้นเชิง

AI ยังสามารถ “คิด” นอกกรอบและสรุปสถานการณ์ใหม่ได้

ในการทดสอบอื่น ได้รับการฝึกฝนเกี่ยวกับมุมมองของแซมต่อหนังสือภาพตามที่พ่อแม่ของเขาพูดว่า “มันคือเป็ดและผีเสื้อ” ต่อมาเขาชูผีเสื้อของเล่นขึ้นมาเมื่อถูกถามว่า “คุณทำผีเสื้อได้ไหม” เมื่อถูกท้าทายด้วยภาพผีเสื้อหลากสี ซึ่งเป็นภาพที่ AI ไม่เคยเห็นมาก่อน ระบบตรวจพบตัวอย่าง "ผีเสื้อ" สามในสี่ตัวอย่างที่มีความแม่นยำมากกว่า 80 เปอร์เซ็นต์

แนวคิดของคำทั้งหมดไม่ได้คะแนนเหมือนกัน ตัวอย่างเช่น “ช้อน” เป็นการต่อสู้ดิ้นรน แต่มันก็คุ้มค่าที่จะชี้ให้เห็นว่าเหมือนยาก reCAPTCHAภาพการฝึกนั้นยากที่จะถอดรหัสแม้แต่กับมนุษย์

ความเจ็บปวด

พื้นที่ AI สร้างจากความก้าวหน้าล่าสุดในการเรียนรู้ของเครื่องแบบหลายรูปแบบซึ่งรวมข้อความ รูปภาพ เสียง หรือวิดีโอเพื่อฝึกสมองของเครื่องจักร

ด้วยข้อมูลจากประสบการณ์ของเด็กเพียงคนเดียว อัลกอริธึมจึงสามารถจับภาพว่าคำต่างๆ เกี่ยวข้องกันอย่างไร และเชื่อมโยงคำเข้ากับรูปภาพและแนวคิดได้ โดยแนะนำว่าการที่เด็กวัยหัดเดินได้ยินคำศัพท์และจับคู่คำศัพท์กับสิ่งที่พวกเขาเห็นจะช่วยสร้างคำศัพท์ได้

ไม่ได้หมายความว่ากระบวนการอื่นๆ ของสมอง เช่น สัญญาณทางสังคมและการให้เหตุผลจะไม่เข้ามามีบทบาท ผู้เขียนเขียนว่าการเพิ่มส่วนประกอบเหล่านี้ลงในอัลกอริธึมอาจช่วยปรับปรุงได้

ทีมงานวางแผนที่จะทำการทดลองต่อไป ในตอนนี้ AI “baby” เรียนรู้จากกรอบภาพนิ่งเท่านั้น และมีคำศัพท์ที่ส่วนใหญ่ประกอบด้วยคำนาม การรวมส่วนวิดีโอเข้ากับการฝึกอบรมสามารถช่วยให้ AI เรียนรู้คำกริยาได้ เนื่องจากวิดีโอมีการเคลื่อนไหวด้วย

การเพิ่มน้ำเสียงลงในข้อมูลคำพูดก็สามารถช่วยได้เช่นกัน เด็กๆ เรียนรู้ตั้งแต่เนิ่นๆ ว่า “อืม” ของแม่สามารถมีความหมายที่แตกต่างกันอย่างมากขึ้นอยู่กับน้ำเสียง

แต่โดยรวมแล้ว การผสมผสาน AI และประสบการณ์ชีวิตเข้าด้วยกันเป็นวิธีการใหม่ที่ทรงพลังในการศึกษาทั้งสมองของเครื่องจักรและสมองของมนุษย์ มันสามารถช่วยให้เราพัฒนาโมเดล AI ใหม่ที่เรียนรู้ได้เหมือนเด็ก และอาจปรับเปลี่ยนความเข้าใจของเราเกี่ยวกับวิธีที่สมองของเราเรียนรู้ภาษาและแนวความคิด

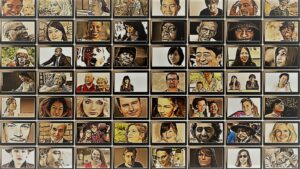

เครดิตรูปภาพ: Wai Keen Vong

- เนื้อหาที่ขับเคลื่อนด้วย SEO และการเผยแพร่ประชาสัมพันธ์ รับการขยายวันนี้

- PlatoData.Network Vertical Generative Ai เพิ่มพลังให้กับตัวเอง เข้าถึงได้ที่นี่.

- เพลโตไอสตรีม. Web3 อัจฉริยะ ขยายความรู้ เข้าถึงได้ที่นี่.

- เพลโตESG. คาร์บอน, คลีนเทค, พลังงาน, สิ่งแวดล้อม แสงอาทิตย์, การจัดการของเสีย. เข้าถึงได้ที่นี่.

- เพลโตสุขภาพ เทคโนโลยีชีวภาพและข่าวกรองการทดลองทางคลินิก เข้าถึงได้ที่นี่.

- ที่มา: https://singularityhub.com/2024/02/01/an-ai-just-learned-language-through-the-eyes-and-ears-of-a-toddler/

- :มี

- :เป็น

- :ไม่

- $ ขึ้น

- 000

- 300

- 32

- 400

- 500

- 600

- 80

- a

- ความสามารถ

- ความสามารถ

- สามารถ

- เกี่ยวกับเรา

- ข้างบน

- ความถูกต้อง

- ได้รับ

- จริง

- เหมาะ

- เพิ่ม

- ความก้าวหน้า

- อายุ

- AI

- โมเดล AI

- ขั้นตอนวิธี

- ทั้งหมด

- คนเดียว

- ด้วย

- แม้ว่า

- จำนวน

- an

- และ

- อื่น

- คำตอบ

- นอกเหนือ

- เข้าใกล้

- รอบ

- บทความ

- AS

- ภาคี

- ที่เกี่ยวข้อง

- At

- ศรุต

- เสียง

- ผู้เขียน

- ผู้เขียน

- ทารก

- ลูกบอล

- ขั้นพื้นฐาน

- BE

- เพราะ

- ก่อน

- เริ่ม

- ระหว่าง

- ใหญ่

- หนังสือ

- ร้านหนังสือเกาหลี

- ทั้งสอง

- กล่อง

- ของเล่นเพิ่มพัฒนาสมอง

- สมอง

- ที่กว้างขึ้น

- Broke

- สร้าง

- สร้าง

- แต่

- by

- ที่เรียกว่า

- ห้อง

- กล้อง

- CAN

- จับ

- ถูกจับกุม

- แมว

- ศูนย์

- ท้าทาย

- การเปลี่ยนแปลง

- ChatGPT

- เด็ก

- เด็ก

- ความรู้ความเข้าใจ

- รวม

- การรวมกัน

- อย่างไร

- ร่วมกัน

- เมื่อเทียบกับ

- อย่างสมบูรณ์

- ส่วนประกอบ

- ประกอบด้วย

- แนวคิด

- แนวความคิด

- เชื่อมต่อ

- ต่อ

- ตรงกันข้าม

- การสนทนา

- การปรุงอาหาร

- ประสานงาน

- แก้ไข

- มีความสัมพันธ์

- ได้

- counterparts

- หัตถกรรม

- เครดิต

- สำคัญมาก

- ประจำวัน

- ข้อมูล

- วิทยาศาสตร์ข้อมูล

- แปลรหัส

- ทั้งนี้ขึ้นอยู่กับ

- อธิบาย

- ได้รับการออกแบบ

- ตรวจพบ

- พัฒนา

- บทสนทนา

- ต่าง

- ย่อยอาหาร

- do

- Dont

- ลง

- dr

- แต่ละ

- ก่อน

- อย่างง่ายดาย

- แม้

- ทุกๆ

- ทุกวัน

- ทุกอย่าง

- ตัวอย่าง

- ตัวอย่าง

- ประสบการณ์

- ประสบการณ์

- การทดลอง

- Eyes

- ไกล

- ชื่อจริง

- ครั้งแรก

- สำหรับ

- หน้าผาก

- พบ

- สี่

- ราคาเริ่มต้นที่

- ด้านหน้า

- ได้รับ

- ค่อยๆ

- เข้าใจ

- ขึ้น

- มี

- ครึ่ง

- ที่เกิดขึ้น

- ยาก

- มี

- he

- ได้ยิน

- การได้ยิน

- จัดขึ้น

- ช่วย

- จะช่วยให้

- ของเขา

- หน้าแรก

- ชั่วโมง

- สรุป ความน่าเชื่อถือของ Olymp Trade?

- ที่ http

- HTTPS

- เป็นมนุษย์

- ความคิด

- if

- ภาพ

- ภาพ

- ปรับปรุง

- in

- รวมถึง

- อินพุต

- ตัวอย่าง

- การบูรณาการ

- ปฏิสัมพันธ์

- เข้าไป

- IT

- เพียงแค่

- แค่หนึ่ง

- กระตือรือร้น

- เด็ก

- ทราบ

- ภาษา

- ใหญ่

- ต่อมา

- เรียนรู้

- ได้เรียนรู้

- การเรียนรู้

- น้อยลง

- ชีวิต

- มีน้ำหนักเบา

- กดไลก์

- LINK

- การเชื่อมโยง

- นาน

- เครื่อง

- การจับคู่

- จับคู่

- การจับคู่

- อาจ..

- ความหมาย

- วัด

- วิธี

- ล้าน

- แบบ

- โมเดล

- แม่

- เดือน

- ข้อมูลเพิ่มเติม

- ส่วนใหญ่

- การเคลื่อนไหว

- มัลติมีเดีย

- เกือบทั้งหมด

- จำเป็นต้อง

- เครือข่าย

- เครือข่าย

- ประสาท

- เครือข่ายประสาท

- เครือข่ายประสาทเทียม

- ไม่เคย

- ใหม่

- ข่าว

- ถัดไป

- NIH

- คำนาม

- ตอนนี้

- ตัวเลข

- วัตถุ

- of

- เก่า

- on

- ONE

- คน

- เพียง

- or

- อื่นๆ

- ของเรา

- ออก

- ด้านนอก

- เกิน

- ทั้งหมด

- จับคู่

- คู่

- พ่อแม่

- เปอร์เซ็นต์

- การปฏิบัติ

- มุมมอง

- สัตว์เลี้ยง

- เลือก

- ภาพ

- แผน

- เพลโต

- เพลโตดาต้าอินเทลลิเจนซ์

- เพลโตดาต้า

- เล่น

- เล่น

- พอดคาสต์

- บทกวี

- ส่วน

- ที่อาจเกิดขึ้น

- ที่มีประสิทธิภาพ

- กด

- กระบวนการ

- ให้

- อย่างรวดเร็ว

- เหมือนจริง

- เหตุผล

- เมื่อเร็ว ๆ นี้

- บันทึก

- ต้อง

- การวิจัย

- นักวิจัย

- Reshape

- ทรัพยากร

- ผล

- ผลสอบ

- เปิดเผย

- รวย

- ลวก

- ปัดเศษ

- กล่าวว่า

- เดียวกัน

- กล่าว

- พูดว่า

- วิทยาศาสตร์

- นักวิทยาศาสตร์

- คะแนน

- สคริปต์

- เห็น

- เห็น

- กลุ่ม

- แยก

- น่า

- โชว์

- แสดงให้เห็นว่า

- สายตา

- เดียว

- สถานการณ์

- หก

- หกเดือน

- ทักษะ

- So

- สังคม

- เสียง

- เสียง

- ลำโพง

- การพูด

- พูด

- รัฐของศิลปะ

- ยังคง

- การต่อสู้

- ศึกษา

- อย่างเช่น

- ชี้ให้เห็นถึง

- ระบบ

- ระบบ

- นำ

- เคาะ

- ทีม

- ทดสอบ

- การทดสอบ

- ข้อความ

- กว่า

- ที่

- พื้นที่

- โลก

- ของพวกเขา

- พวกเขา

- แล้วก็

- ทฤษฎี

- ล้อยางขัดเหล่านี้ติดตั้งบนแกน XNUMX (มม.) ผลิตภัณฑ์นี้ถูกผลิตในหลายรูปทรง และหลากหลายเบอร์ความแน่นหนาของปริมาณอนุภาคขัดของมัน จะทำให้ท่านได้รับประสิทธิภาพสูงในการขัดและการใช้งานที่ยาวนาน

- พวกเขา

- สิ่ง

- นี้

- สาม

- น่าตื่นตาตื่นใจ

- ตลอด

- เวลา

- ไปยัง

- ร่วมกัน

- TONE

- ยาก

- ของเล่น

- แบบดั้งเดิม

- รถไฟ

- ผ่านการฝึกอบรม

- การฝึกอบรม

- ล้านล้าน

- สอง

- เข้าใจ

- ความเข้าใจ

- us

- มือสอง

- การใช้

- ความหลากหลาย

- มาก

- วีดีโอ

- วิดีโอ

- รายละเอียด

- ภาพ

- ภาพ

- คือ

- we

- ความมั่งคั่ง

- สัปดาห์

- คือ

- อะไร

- อะไร

- เมื่อ

- ที่

- ในขณะที่

- กว้าง

- กับ

- คำ

- คำ

- โลก

- คุ้มค่า

- เขียน

- ปี

- ปี

- โยคะ

- เธอ

- ลมทะเล