นักวิจัยในออสเตรเลียกำลังพัฒนาแว่นตาอัจฉริยะสำหรับคนตาบอด โดยใช้เทคโนโลยีที่เรียกว่า "การสัมผัสแบบอะคูสติก" เพื่อเปลี่ยนภาพให้เป็นเสียง การทดลองเบื้องต้นชี้ให้เห็นว่าเทคโนโลยีเสียงเชิงพื้นที่ที่สวมใส่ได้นี้สามารถช่วยให้ผู้พิการทางสายตาหรือมีความบกพร่องในการมองเห็นอย่างมากสามารถระบุตำแหน่งวัตถุใกล้เคียงได้

การปรับปรุงล่าสุดในด้านความเป็นจริงเสริม เทคโนโลยีกล้องสวมใส่ที่ใช้งานได้จริง และคอมพิวเตอร์วิทัศน์ที่ใช้การเรียนรู้เชิงลึก กำลังเร่งการพัฒนาแว่นตาอัจฉริยะให้เป็นเทคโนโลยีช่วยเหลืออเนกประสงค์ที่ใช้งานได้จริงสำหรับผู้ที่ตาบอดหรือมองเห็นเลือนลาง แว่นตาอัจฉริยะดังกล่าวประกอบด้วยกล้อง ระบบ GPS ไมโครโฟน และหน่วยวัดแรงเฉื่อยและการตรวจจับเชิงลึกเพื่อมอบฟังก์ชันต่างๆ เช่น การนำทาง การควบคุมการจดจำเสียง หรือการแสดงวัตถุ ข้อความ หรือสภาพแวดล้อมเป็นคำพูดที่สังเคราะห์ด้วยคอมพิวเตอร์

ฮาว หยวน จู้ และเพื่อนร่วมงานที่มหาวิทยาลัยเทคโนโลยีซิดนีย์ (UTS) และ มหาวิทยาลัยซิดนีย์ ตรวจสอบการเพิ่มระบบสัมผัสแบบอะคูสติกให้กับแว่นตาอัจฉริยะ ซึ่งเป็นวิธีการที่ใช้การสแกนศีรษะและการเปิดใช้งานไอคอนการได้ยินเมื่อวัตถุปรากฏภายในขอบเขตการมองเห็น (FOV) ที่กำหนด

เขียนเข้า PLoS ONEนักวิจัยอธิบายว่าระบบสัมผัสแบบอะคูสติกมีข้อดีหลายประการเหนือแนวทางที่มีอยู่ ซึ่งรวมถึงความง่ายในการผสานรวมกับเทคโนโลยีแว่นตาอัจฉริยะ และการใช้งานที่เป็นธรรมชาติมากกว่าคำพูดที่สังเคราะห์ด้วยคอมพิวเตอร์ ระบบดังกล่าวอาจต้องการการฝึกอบรมน้อยกว่าเพื่อให้ผู้ใช้มีความเชี่ยวชาญ

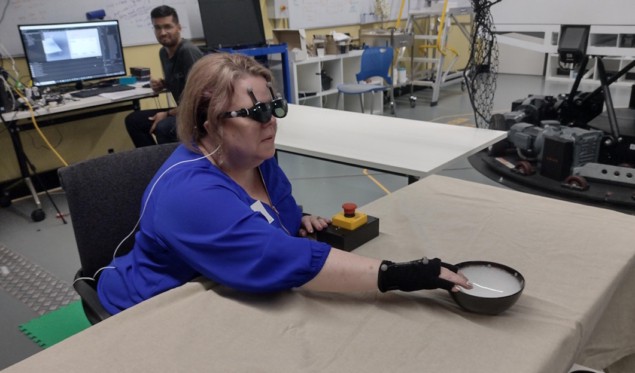

ทำงานร่วมกับ ARIA Research of Sydney (ซึ่งเพิ่งได้รับรางวัล บริษัทเทคโนโลยีแห่งออสเตรเลียแห่งปี สำหรับนวัตกรรมเทคโนโลยีการมองเห็นที่บุกเบิก) ทีมงานได้สร้างอุปกรณ์เสียงแบบลอยตัว (FAD) เพื่อทดสอบสมมติฐานเหล่านี้กับอาสาสมัครเจ็ดคนที่ไม่มีการมองเห็นหรือมองเห็นได้ไม่ชัด รวมถึงผู้เข้าร่วมที่ถูกปิดตาอีกเจ็ดคน FAD ประกอบด้วยสมาร์ทโฟนและแว่นตา NREAL ซึ่งทีมงานได้ติดเครื่องหมายสะท้อนแสงจากการจับภาพเคลื่อนไหวเพื่อให้สามารถติดตามการเคลื่อนไหวของศีรษะได้

FAD ทำการจดจำวัตถุและกำหนดระยะห่างของวัตถุโดยใช้กล้องสเตอริโอบนแว่นตา จากนั้นจะกำหนดไอคอนการได้ยินที่เหมาะสมให้กับวัตถุต่างๆ เช่น เสียงเปลี่ยนหน้าหนังสือ เป็นต้น เมื่อผู้สวมใส่หมุนศีรษะ อัตราการทำซ้ำของไอคอนการได้ยินจะเปลี่ยนไปตามตำแหน่งของรายการภายใน FOV การได้ยิน

อาสาสมัครได้มีส่วนร่วมในการออกกำลังกายทั้งแบบนั่งและยืน งานที่ต้องนั่งต้องให้พวกเขาใช้วิธีการต่างๆ ในการค้นหาและจัดการสิ่งของในชีวิตประจำวัน รวมถึงหนังสือ ขวด ชาม หรือถ้วยที่วางอยู่บนโต๊ะตัวเดียวหรือหลายตัว งานนี้วัดความสามารถในการตรวจจับสิ่งของ จดจำเสียง และจดจำตำแหน่งของสิ่งของ

นักวิจัยได้ออกแบบงานนี้เพื่อเปรียบเทียบประสิทธิภาพของ FAD กับสัญญาณคำพูดทั่วไป 2 แบบ ได้แก่ ทิศทางวาจาของหน้าปัดนาฬิกา และการเล่นตามลำดับไอคอนเสียงจากลำโพงที่อยู่ร่วมกับแต่ละรายการ พวกเขาพบว่าสำหรับผู้เข้าร่วมที่ตาบอดหรือสายตาเลือนราง ประสิทธิภาพการใช้ FAD เทียบได้กับเงื่อนไขในอุดมคติทั้งสองประการ อย่างไรก็ตาม กลุ่มผู้ถูกปิดตาจะทำงานได้แย่ลงเมื่อใช้ FAD

การปลูกถ่ายสมองทำให้ผู้หญิงตาบอดมองเห็นรูปทรงที่เรียบง่ายได้

ภารกิจยืนเอื้อมต้องการให้ผู้เข้าร่วมใช้ FAD เพื่อค้นหาและเข้าถึงสิ่งของเป้าหมายที่อยู่ท่ามกลางสิ่งของที่รบกวนสมาธิหลายรายการ ขอให้ผู้เข้าร่วมค้นหาสิ่งของที่วางอยู่บนโต๊ะสามตัวที่ล้อมรอบด้วยขวดสี่ขวดที่มีรูปร่างต่างกัน งานนี้ประเมินประสิทธิภาพการทำงานของระบบและพฤติกรรมของมนุษย์เป็นหลักเมื่อใช้การเคลื่อนไหวเต็มตัวระหว่างการค้นหา

“ปีนี้ เราได้สำรวจอย่างหนักโดยใช้โสตทัศน์เพื่อรองรับงานที่ซับซ้อนต่างๆ” Zhu กล่าว โลกฟิสิกส์. “โดยเฉพาะอย่างยิ่ง เราได้สำรวจการใช้เสียงเชิงพื้นที่ประเภทต่างๆ เพื่อนำทางผู้คนระหว่างการนำทางและสนับสนุนกิจกรรมกีฬา โดยเฉพาะปิงปอง ปีหน้าเราหวังว่าจะขยายขอบเขตเหล่านี้ต่อไปและดำเนินการศึกษาในสภาพแวดล้อมจริง”

- เนื้อหาที่ขับเคลื่อนด้วย SEO และการเผยแพร่ประชาสัมพันธ์ รับการขยายวันนี้

- PlatoData.Network Vertical Generative Ai เพิ่มพลังให้กับตัวเอง เข้าถึงได้ที่นี่.

- เพลโตไอสตรีม. Web3 อัจฉริยะ ขยายความรู้ เข้าถึงได้ที่นี่.

- เพลโตESG. คาร์บอน, คลีนเทค, พลังงาน, สิ่งแวดล้อม แสงอาทิตย์, การจัดการของเสีย. เข้าถึงได้ที่นี่.

- เพลโตสุขภาพ เทคโนโลยีชีวภาพและข่าวกรองการทดลองทางคลินิก เข้าถึงได้ที่นี่.

- ที่มา: https://physicsworld.com/a/acoustic-touch-technology-helps-blind-people-see-using-sound/

- :เป็น

- 90

- a

- ความสามารถ

- เร่ง

- ตาม

- อะคูสติก

- การกระตุ้น

- กิจกรรม

- นอกจากนี้

- ข้อได้เปรียบ

- ด้วย

- ในหมู่

- an

- และ

- ปรากฏ

- เข้าใกล้

- วิธีการ

- เหมาะสม

- เป็น

- พื้นที่

- เพลง

- AS

- การประเมิน

- สมมติฐาน

- At

- เสียง

- เทคโนโลยีเสียง

- เติม

- เพิ่มความเป็นจริง

- ออสเตรเลีย

- กลายเป็น

- รับ

- พฤติกรรม

- คนตาบอด

- หนังสือ

- ทั้งสอง

- by

- ที่เรียกว่า

- ห้อง

- กล้อง

- การเปลี่ยนแปลง

- เพื่อนร่วมงาน

- COM

- บริษัท

- เทียบเคียง

- เปรียบเทียบ

- ซับซ้อน

- ประกอบด้วย

- คอมพิวเตอร์

- วิสัยทัศน์คอมพิวเตอร์

- เงื่อนไข

- ความประพฤติ

- ต่อ

- ควบคุม

- ตามธรรมเนียม

- ได้

- ที่สร้างขึ้น

- ถ้วย

- ลึก

- กำหนด

- ส่งมอบ

- ความลึก

- ได้รับการออกแบบ

- ตรวจจับ

- แน่นอน

- ที่กำลังพัฒนา

- พัฒนาการ

- เครื่อง

- ต่าง

- คำสั่ง

- ระยะทาง

- ในระหว่าง

- แต่ละ

- ความสะดวก

- ทำให้สามารถ

- ช่วยให้

- ทุกวัน

- ตัวอย่าง

- ที่มีอยู่

- ที่ขยาย

- การทดลอง

- อธิบาย

- สำรวจ

- สำรวจ

- หา

- สำหรับ

- พบ

- สี่

- ราคาเริ่มต้นที่

- การทำงาน

- ฟังก์ชั่น

- แว่นตา

- จีพีเอส

- บัญชีกลุ่ม

- ให้คำแนะนำ

- จัดการ

- มี

- หัว

- หนัก

- ช่วย

- จะช่วยให้

- ความหวัง

- อย่างไรก็ตาม

- HTTPS

- เป็นมนุษย์

- ไอคอน

- ภาพ

- ภาพ

- การปรับปรุง

- in

- รวมทั้ง

- รวมเข้าด้วยกัน

- ข้อมูล

- แรกเริ่ม

- นวัตกรรม

- บูรณาการ

- เข้าไป

- ใช้งานง่าย

- ปัญหา

- IT

- รายการ

- ITS

- jpg

- ห้องปฏิบัติการ

- น้อยลง

- ต่ำ

- ความกว้างสูงสุด

- อาจ..

- วัด

- การวัด

- สมาชิก

- วิธีการ

- ไมโครโฟน

- ผสม

- ความเป็นจริงผสม

- ข้อมูลเพิ่มเติม

- การเคลื่อนไหว

- การเคลื่อนไหว

- การเคลื่อนไหว

- หลาย

- การเดินเรือ

- ใหม่

- ถัดไป

- ไม่

- Nreal

- วัตถุ

- วัตถุ

- of

- เสนอ

- on

- ONE

- or

- เกิน

- ส่วนหนึ่ง

- ผู้เข้าร่วม

- ในสิ่งที่สนใจ

- คน

- การปฏิบัติ

- ดำเนินการ

- ดำเนินการ

- ฟิสิกส์

- โลกฟิสิกส์

- การสำรวจ

- วางไว้

- เวที

- เพลโต

- เพลโตดาต้าอินเทลลิเจนซ์

- เพลโตดาต้า

- เล่น

- บวก

- ตำแหน่ง

- ตำแหน่ง

- ประยุกต์

- ส่วนใหญ่

- คะแนน

- มาถึง

- ถึง

- โลกแห่งความจริง

- ความจริง

- เมื่อเร็ว ๆ นี้

- การรับรู้

- รับรู้

- การแสดงผล

- ต้องการ

- จำเป็นต้องใช้

- การวิจัย

- นักวิจัย

- การสแกน

- ค้นหา

- ค้นหา

- เห็น

- การตั้งค่า

- เจ็ด

- หลาย

- รูปร่าง

- อย่างมีความหมาย

- ง่าย

- ตั้งอยู่

- สมาร์ท

- แว่นตาอัจฉริยะ

- มาร์ทโฟน

- เสียง

- เกี่ยวกับอวกาศ

- ลำโพง

- เฉพาะ

- การพูด

- ยืน

- การศึกษา

- อย่างเช่น

- แนะนำ

- สนับสนุน

- ที่สนับสนุน

- ล้อมรอบ

- ซิดนีย์

- ระบบ

- ระบบ

- ตาราง

- เป้า

- งาน

- งาน

- ทีม

- เทคโนโลยี

- บอก

- เทนนิส

- ทดสอบ

- ข้อความ

- กว่า

- ที่

- พื้นที่

- ของพวกเขา

- พวกเขา

- แล้วก็

- ล้อยางขัดเหล่านี้ติดตั้งบนแกน XNUMX (มม.) ผลิตภัณฑ์นี้ถูกผลิตในหลายรูปทรง และหลากหลายเบอร์ความแน่นหนาของปริมาณอนุภาคขัดของมัน จะทำให้ท่านได้รับประสิทธิภาพสูงในการขัดและการใช้งานที่ยาวนาน

- พวกเขา

- นี้

- เหล่านั้น

- สาม

- ภาพขนาดย่อ

- ไปยัง

- เอา

- แตะ

- การติดตาม

- การฝึกอบรม

- จริง

- กลับ

- สอง

- ชนิด

- หน่วย

- มหาวิทยาลัย

- ใช้

- ผู้ใช้

- ใช้

- การใช้

- ต่างๆ

- ทำงานได้

- วิสัยทัศน์

- เสียงพูด

- การรับรู้เสียง

- อาสาสมัคร

- คือ

- we

- เครื่องแต่งตัว

- คือ

- เมื่อ

- ที่

- WHO

- กับ

- ภายใน

- หญิง

- วอน

- โลก

- แย่ลง

- ปี

- หยวน

- ลมทะเล