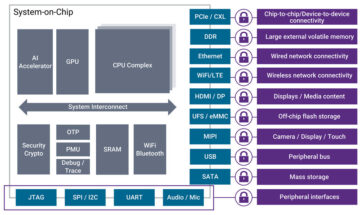

Suresh เป็นผู้บริหารเทคโนโลยีที่มีความเชี่ยวชาญทางเทคนิคอย่างลึกซึ้งในด้านเซมิคอนดักเตอร์ ปัญญาประดิษฐ์ ความปลอดภัยทางไซเบอร์ อินเทอร์เน็ตออฟธิงส์ ฮาร์ดแวร์ ซอฟต์แวร์ ฯลฯ เขาใช้เวลา 20 ปีในอุตสาหกรรมนี้ โดยล่าสุดดำรงตำแหน่งผู้อำนวยการบริหารสำหรับโอเพ่นซอร์สที่ศูนย์- วางใจการพัฒนาชิปที่ Technology Innovation Institute, อาบูดาบี และในบริษัทเซมิคอนดักเตอร์อื่นๆ ที่ติดอันดับ Fortune 500 เช่น Intel, Qualcomm และ MediaTek ในบทบาทผู้นำต่างๆ ซึ่งเขาได้ทำการวิจัยและพัฒนาประสิทธิภาพสูง ประหยัดพลังงาน ปลอดภัยหลังควอนตัม ปลอดภัย ไมโครชิป/ system-on-chips (SoCs)/ ตัวเร่งความเร็วสำหรับศูนย์ข้อมูล ไคลเอนต์ สมาร์ทโฟน ระบบเครือข่าย IoT และตลาด AI/ML เขามีส่วนร่วมใน Falcon LLM (อันดับ 1 ในด้าน Huggingface) และเป็นหัวหน้าสถาปนิกสำหรับแพลตฟอร์มฮาร์ดแวร์ AI แบบกำหนดเอง (ยกเลิก - ลำดับความสำคัญเปลี่ยนไป) เขามีสิทธิบัตรของสหรัฐอเมริกามากกว่า 15 ฉบับ และได้ตีพิมพ์/นำเสนอในการประชุมมากกว่า 20 รายการ

Suresh เป็นผู้บริหารเทคโนโลยีที่มีความเชี่ยวชาญทางเทคนิคอย่างลึกซึ้งในด้านเซมิคอนดักเตอร์ ปัญญาประดิษฐ์ ความปลอดภัยทางไซเบอร์ อินเทอร์เน็ตออฟธิงส์ ฮาร์ดแวร์ ซอฟต์แวร์ ฯลฯ เขาใช้เวลา 20 ปีในอุตสาหกรรมนี้ โดยล่าสุดดำรงตำแหน่งผู้อำนวยการบริหารสำหรับโอเพ่นซอร์สที่ศูนย์- วางใจการพัฒนาชิปที่ Technology Innovation Institute, อาบูดาบี และในบริษัทเซมิคอนดักเตอร์อื่นๆ ที่ติดอันดับ Fortune 500 เช่น Intel, Qualcomm และ MediaTek ในบทบาทผู้นำต่างๆ ซึ่งเขาได้ทำการวิจัยและพัฒนาประสิทธิภาพสูง ประหยัดพลังงาน ปลอดภัยหลังควอนตัม ปลอดภัย ไมโครชิป/ system-on-chips (SoCs)/ ตัวเร่งความเร็วสำหรับศูนย์ข้อมูล ไคลเอนต์ สมาร์ทโฟน ระบบเครือข่าย IoT และตลาด AI/ML เขามีส่วนร่วมใน Falcon LLM (อันดับ 1 ในด้าน Huggingface) และเป็นหัวหน้าสถาปนิกสำหรับแพลตฟอร์มฮาร์ดแวร์ AI แบบกำหนดเอง (ยกเลิก - ลำดับความสำคัญเปลี่ยนไป) เขามีสิทธิบัตรของสหรัฐอเมริกามากกว่า 15 ฉบับ และได้ตีพิมพ์/นำเสนอในการประชุมมากกว่า 20 รายการ

Suresh ยังดำรงตำแหน่งผู้นำที่ RISC-V International อย่างแข็งขัน โดยเขาเป็นประธาน Trusted Computing Group เพื่อพัฒนาความสามารถในการประมวลผลที่เป็นความลับของ RISC-V และเป็นประธานของ AI/ML Group เพื่อพัฒนาการเร่งความเร็วด้วยฮาร์ดแวร์ RISC-V สำหรับปริมาณงาน AI/ML เช่น Transformer รุ่นภาษาขนาดใหญ่ที่ใช้ในแอปพลิเคชันประเภท ChatGPT นอกจากนี้เขายังให้คำแนะนำแก่บริษัทสตาร์ทอัพและบริษัทร่วมลงทุนเกี่ยวกับการสนับสนุนการตัดสินใจลงทุน กลยุทธ์ผลิตภัณฑ์ ความรอบคอบด้านเทคโนโลยี ฯลฯ

เขาได้รับปริญญาโทสาขาบริหารธุรกิจจาก INSEAD, ปริญญาโทจาก Birla Institute of Technology & Science Pilani, ใบรับรองวิศวกรรมระบบจาก MIT, ใบรับรอง AI จาก Stanford และใบรับรองความปลอดภัยด้านยานยนต์จาก TÜV SÜD

บอกเราเกี่ยวกับบริษัทของคุณ

"มาสติชกา AI” (Mastiṣka หมายถึง Brain ในภาษาสันสกฤต) เป็นบริษัท AI ที่มุ่งเน้นการสร้างคอมพิวเตอร์ที่มีลักษณะคล้ายสมองเพื่อรันโมเดลพื้นฐานได้อย่างมีประสิทธิภาพมากขึ้นสำหรับกรณีการใช้งาน Generative AI ในอนาคต

คุณกำลังแก้ปัญหาอะไร

เมื่อพิจารณาถึงประโยชน์ของ AI/ GenAI ความต้องการก็จะเพิ่มขึ้นเท่านั้น และผลข้างเคียงที่จะเกิดขึ้นกับโลกของเราก็จะเพิ่มขึ้นเช่นกัน เราจะลดหรือต่อต้านผลข้างเคียงของ AI บนโลกของเราได้อย่างไร การดักจับคาร์บอนและพลังงานนิวเคลียร์อยู่ในทิศทางที่ถูกต้อง แต่เราจำเป็นต้องคิดใหม่โดยพื้นฐานเกี่ยวกับวิธีที่เราทำ AI มันเป็นวิธีที่ผิดในการคูณเมทริกซ์จำนวนมากหรือไม่?

สมองของเราสามารถเรียนรู้และทำงานหลายอย่างแบบขนาน ในและต่ำกว่า 10W แต่ทำไมระบบ AI เหล่านี้ถึงใช้ 10 เมกะวัตต์ในการฝึกโมเดล

บางทีในอนาคตอาจมีสถาปัตยกรรมที่ประหยัดพลังงาน เช่น สถาปัตยกรรมนิวโรมอร์ฟิกและหม้อแปลงที่ใช้โครงข่ายประสาทเทียมที่พุ่งเข้าหาสมองมนุษย์มากที่สุด ซึ่งอาจใช้พลังงานน้อยกว่าถึง 100-1000 เท่า ซึ่งจะช่วยลดต้นทุนในการใช้ AI และทำให้เป็นประชาธิปไตยและช่วยเรา ดาวเคราะห์.

ความท้าทายในปัจจุบันที่เราเผชิญกับ AI ได้แก่ ก) ความพร้อมใช้งาน ข) ความสามารถในการเข้าถึง ค) ความสามารถในการจ่ายได้ และ ง) ความปลอดภัยด้านสิ่งแวดล้อม พร้อมด้วยคำแนะนำบางประการเพื่อแก้ไขปัญหาเหล่านั้น

หากเราคาดการณ์ไว้ในอนาคต แนวคิด AGI ที่เป็นประโยชน์บางอย่างจะถูกแสดงให้เห็นในภาพยนตร์เรื่อง “HER” โดยที่ตัวละคร 'Samantha' ซึ่งเป็นตัวแทนการสนทนาที่เป็นธรรมชาติ เข้าใจอารมณ์ แสดงความเห็นอกเห็นใจ เป็นนักบินร่วมที่น่าทึ่งในที่ทำงาน — และดำเนินไป ต้องใช้อุปกรณ์พกพาตลอดทั้งวัน เราอาจต้องจัดการกับความท้าทายด้านล่างในตอนนี้

ปัญหาที่ 1: การฝึกอบรม LLM อาจมีค่าใช้จ่ายตั้งแต่ 150 ถึง 10+ ล้านดอลลาร์ และอนุญาตให้เฉพาะผู้ที่มีเงินในกระเป๋าลึกเท่านั้นที่จะพัฒนา AI ได้ ยิ่งไปกว่านั้น ค่าใช้จ่ายในการอนุมานก็มีมากเช่นกัน (ค่าใช้จ่ายมากกว่าการค้นหาเว็บถึง 10 เท่า)

—> เราจำเป็นต้องปรับปรุงประสิทธิภาพการใช้พลังงานของโมเดล/ฮาร์ดแวร์เพื่อทำให้ AI เป็นประชาธิปไตยเพื่อประโยชน์ของมนุษยชาติ

ปัญหาที่ 2: การใช้โมเดล AI ขนาดยักษ์สำหรับตัวแทนการสนทนาหรือระบบแนะนำ ส่งผลกระทบต่อสิ่งแวดล้อมในแง่ของการใช้ไฟฟ้าและการทำความเย็น

-> เราจำเป็นต้องปรับปรุงประสิทธิภาพการใช้พลังงานของโมเดล/ฮาร์ดแวร์ เพื่อช่วยโลกของเราเพื่อลูกหลานของเรา

ปัญหาที่ 3: สมองของมนุษย์มีความสามารถและทำงานหลายอย่างพร้อมกันได้ แต่ใช้พลังงานเพียง 10 วัตต์แทนที่จะเป็นเมกะวัตต์

-> บางทีเราควรสร้างเครื่องจักรเช่นสมองของเราและไม่ใช่ตัวคูณเมทริกซ์ปกติให้เร็วขึ้น

มนุษยชาติสามารถเจริญเติบโตได้ด้วยนวัตกรรมที่ยั่งยืนเท่านั้น ไม่ใช่โดยการตัดไม้ทำลายป่าทั้งหมดและทำให้มหาสมุทรเดือดในนามของนวัตกรรม เราต้องปกป้องโลกของเราเพื่อความผาสุกของลูกหลานของเราและคนรุ่นต่อ ๆ ไป...

แอปพลิเคชันใดที่คุณแข็งแกร่งที่สุด?

การฝึกอบรมและการอนุมานโมเดลพื้นฐานที่ใช้ Transformer (และสถาปัตยกรรมประสาทในอนาคต) มีประสิทธิภาพด้านพลังงานมากกว่า 50-100 เท่าเมื่อเปรียบเทียบกับโซลูชันที่ใช้ GPU ในปัจจุบัน

อะไรทำให้ลูกค้าของคุณนอนไม่หลับตอนกลางคืน?

ปัญหาสำหรับลูกค้าที่ปัจจุบันใช้ผลิตภัณฑ์อื่น:

ปริมาณการใช้ไฟฟ้าสำหรับการฝึกอบรมโมเดลภาษามนุษย์นั้นเกินมาตรฐาน ตัวอย่างเช่น การฝึกอบรม LLM พารามิเตอร์ 13B บนโทเค็นข้อความ 390B บน GPU 200 ตัวเป็นเวลา 7 วันมีค่าใช้จ่าย 151,744 ดอลลาร์ (ที่มา: หน้าบริการคลัสเตอร์การฝึกอบรมใหม่ของ HuggingFace – https://lnkd.in/g6Vc5cz3). และแม้แต่รุ่นขนาดใหญ่ที่มีพารามิเตอร์ 100+B ก็มีราคา 10+M ดอลลาร์สหรัฐเพื่อฝึกฝนเท่านั้น จากนั้นชำระค่าอนุมานทุกครั้งที่มีคำขอพร้อมท์ใหม่มาถึง

การใช้น้ำเพื่อความเย็น นักวิจัยจากมหาวิทยาลัยแคลิฟอร์เนีย ริเวอร์ไซด์ประมาณผลกระทบต่อสิ่งแวดล้อมของบริการที่คล้ายกับ ChatGPT และบอกว่าบริการดังกล่าวจะกลืนน้ำได้ถึง 500 มิลลิลิตร (ใกล้เคียงกับสิ่งที่อยู่ในขวดน้ำขนาด 16 ออนซ์) ทุกครั้งที่คุณถาม ชุดข้อความแจ้งหรือคำถามระหว่าง 5 ถึง 50 รายการ ช่วงจะแตกต่างกันไปขึ้นอยู่กับตำแหน่งของเซิร์ฟเวอร์และฤดูกาล การประมาณการนี้รวมการใช้น้ำทางอ้อมที่บริษัทไม่ได้วัด เช่น เพื่อทำให้โรงไฟฟ้าที่จ่ายไฟฟ้าให้กับศูนย์ข้อมูลเย็นลง (แหล่งที่มา: https://lnkd.in/gybcxX8C)

ปัญหาสำหรับผู้ที่ไม่ใช่ลูกค้าของผลิตภัณฑ์ปัจจุบัน:

ไม่สามารถจ่าย CAPEX เพื่อซื้อฮาร์ดแวร์ได้

ไม่สามารถใช้บริการคลาวด์ได้

ไม่สามารถสร้างสรรค์หรือใช้ประโยชน์จาก AI ได้ — ติดอยู่กับรูปแบบบริการที่ขจัดความได้เปรียบทางการแข่งขัน

แนวการแข่งขันมีลักษณะอย่างไรและคุณจะแยกความแตกต่างอย่างไร?

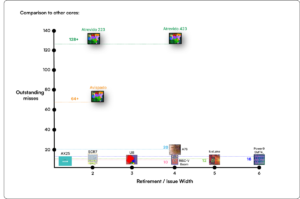

- GPU ครองพื้นที่การฝึกอบรม แม้ว่า ASIC เฉพาะทางจะแข่งขันกันในส่วนนี้ก็ตาม

- การอนุมาน Cloud & Edge มีตัวเลือกมากเกินไป

ดิจิตอล อนาล็อก และโฟโตนิค ผู้คนกำลังพยายามแก้ไขปัญหาเดียวกัน

คุณสามารถแบ่งปันความคิดของคุณเกี่ยวกับสถานะปัจจุบันของสถาปัตยกรรมชิปสำหรับ AI/ML ได้หรือไม่ ซึ่งหมายความว่า อะไรที่คุณมองว่าเป็นแนวโน้มและโอกาสที่สำคัญที่สุดในขณะนี้

แนวโน้มต่อไปนี้:

เทรนด์ที่ 1: 10 ปีที่แล้ว การเรียนรู้เชิงลึกที่ใช้ฮาร์ดแวร์มีความเจริญรุ่งเรือง และตอนนี้ฮาร์ดแวร์ตัวเดียวกันกำลังขัดขวางความก้าวหน้า เนื่องจากมีค่าใช้จ่ายด้านฮาร์ดแวร์และค่าไฟฟ้าจำนวนมากในการรันโมเดล การเข้าถึงฮาร์ดแวร์จึงกลายเป็นความท้าทาย มีเพียงบริษัทที่มีกระเป๋าเงินลึกเท่านั้นที่สามารถซื้อสิ่งเหล่านี้ได้และกำลังกลายเป็นผู้ผูกขาด

เทรนด์ที่ 2: เมื่อโมเดลเหล่านี้มาถึงแล้ว เราจำเป็นต้องใช้โมเดลเหล่านี้เพื่อการใช้งานจริงเพื่อให้ภาระการอนุมานเพิ่มขึ้น ส่งผลให้ CPU ที่มีตัวเร่งความเร็ว AI กลับมาโดดเด่นอีกครั้ง

เทรนด์ที่ 3: สตาร์ทอัพกำลังพยายามคิดหาตัวเลขทศนิยมทางเลือกซึ่งรูปแบบ IEEE ดั้งเดิม เช่น แบบลอการิทึมและแบบโพซิต นั้นดีแต่ยังไม่เพียงพอ การเพิ่มประสิทธิภาพพื้นที่การออกแบบ PPA$ จะระเบิดเมื่อเราพยายามเพิ่มประสิทธิภาพอย่างใดอย่างหนึ่งและอีกอย่างหนึ่งก็เสี่ยงโชค

เทรนด์ที่ 4: อุตสาหกรรมกำลังย้ายออกจากโมเดลที่เน้นการบริการของ AI ไปเป็นการโฮสต์โมเดลส่วนตัวของตัวเองในสถานที่ของตนเอง แต่การเข้าถึงฮาร์ดแวร์ถือเป็นความท้าทายเนื่องจากการขาดแคลนอุปทาน การคว่ำบาตร ฯลฯ

สถานะปัจจุบัน:

ความพร้อมใช้งานของฮาร์ดแวร์และข้อมูลเป็นแรงผลักดันให้เกิดการเติบโตของ AI เมื่อ 10 ปีที่แล้ว แต่ตอนนี้ฮาร์ดแวร์แบบเดียวกันกำลังขัดขวางมัน — ให้ฉันอธิบาย

นับตั้งแต่ CPU ทำงานได้อย่างน่าสังเวชและ GPU ถูกนำกลับมาใช้ใหม่เพื่อทำ AI มีหลายสิ่งหลายอย่างเกิดขึ้น

บริษัทต่างๆ จัดการกับ AI/ML ใน 4 ส่วน ได้แก่ – 1) การฝึกอบรมบนคลาวด์ 2) การอนุมานบนคลาวด์ 3) การอนุมาน Edge และ 4) การฝึกอบรม Edge (การเรียนรู้แบบรวมศูนย์สำหรับแอปพลิเคชันที่คำนึงถึงความเป็นส่วนตัว)

ดิจิตอลและอนาล็อก

ด้านการฝึกอบรม – มีบริษัทมากมายที่ทำ GPU, ตัวเร่งความเร็วของลูกค้าที่ใช้ RISC-V, ชิปขนาดเวเฟอร์ (850K คอร์) และอื่นๆ ที่ CPU แบบเดิมขาด (วัตถุประสงค์ทั่วไป) ด้านการอนุมาน – ตัวเร่งความเร็ว NN มีจำหน่ายจากผู้ผลิตทุกราย ในสมาร์ทโฟน แล็ปท็อป และอุปกรณ์ Edge อื่นๆ

สถาปัตยกรรมที่ใช้เมมริสเตอร์แบบอะนาล็อกก็ปรากฏขึ้นเมื่อไม่นานมานี้

เราเชื่อว่า CPU สามารถอนุมานได้ดีมาก หากเราปรับปรุงด้วยการเร่งความเร็ว เช่น ส่วนขยายเมทริกซ์

ด้าน RISC-V:

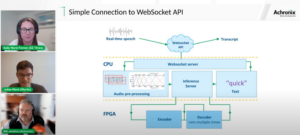

ในด้าน RISC-V เรากำลังพัฒนาตัวเร่งความเร็วสำหรับการดำเนินการเมทริกซ์และการดำเนินการที่ไม่ใช่เชิงเส้นอื่นๆ เพื่อขจัดปัญหาคอขวดที่อาจเกิดขึ้นกับปริมาณงานของหม้อแปลง ปัญหาคอขวดของ Von Neumann ยังได้รับการแก้ไขด้วยการออกแบบหน่วยความจำให้ใกล้กับการประมวลผลมากขึ้น ส่งผลให้ CPU ที่มีการเร่งความเร็ว AI เป็นตัวเลือกที่เหมาะสมสำหรับการอนุมานในที่สุด

โอกาส:

มีโอกาสพิเศษในการเติมเต็มตลาดโมเดลรากฐาน ตัวอย่าง – OpenAI กล่าวถึงว่าพวกเขาไม่สามารถรักษาความปลอดภัยคอมพิวเตอร์ AI (GPU) ได้เพียงพอที่จะผลักดันบริการ ChatGPT ต่อไป… และรายงานข่าวเกี่ยวกับค่าไฟฟ้า 10 เท่าของการค้นหาทางอินเทอร์เน็ตทั่วไป และน้ำ 500 มล. เพื่อทำให้ระบบเย็นลง สำหรับทุกคำถาม มีตลาดที่ต้องเติมเต็มที่นี่ - ไม่ใช่ตลาดเฉพาะ แต่เป็นตลาดทั้งหมดที่จะทำให้ AI เป็นประชาธิปไตยเพื่อจัดการกับความท้าทายทั้งหมดที่กล่าวมาข้างต้น - ก) ความพร้อมใช้งาน b) การเข้าถึง c) ความสามารถในการจ่าย และ d) ความปลอดภัยต่อสิ่งแวดล้อม

คุณกำลังพัฒนาฟีเจอร์/เทคโนโลยีใหม่อะไรบ้าง?

เรากำลังสร้างสมองเหมือนกับคอมพิวเตอร์ที่ใช้ประโยชน์จากเทคโนโลยี neuromodrphic และปรับแต่งโมเดลเพื่อใช้ประโยชน์จากฮาร์ดแวร์ที่ประหยัดพลังงาน โดยการนำเฟรมเวิร์กแบบเปิดที่มีอยู่กลับมาใช้ใหม่

คุณจินตนาการว่าภาคส่วน AI/ML จะเติบโตหรือเปลี่ยนแปลงในอีก 12-18 เดือนข้างหน้าอย่างไร

เนื่องจากความต้องการ GPU ลดลง (ราคาประมาณ 30 ดอลลาร์สหรัฐฯ) รวมถึงบางส่วนของโลกกำลังเผชิญกับการคว่ำบาตรในการซื้อ GPU เหล่านี้ บางส่วนของโลกรู้สึกว่าพวกเขาถูกแช่แข็งในการวิจัยและพัฒนา AI ที่ไม่มีการเข้าถึง GPU แพลตฟอร์มฮาร์ดแวร์สำรองกำลังจะเข้าสู่ตลาด

โมเดลอาจจะเริ่มหดตัว — โมเดลแบบกำหนดเองหรือแม้แต่โดยพื้นฐานแล้วความหนาแน่นของข้อมูลก็จะเพิ่มขึ้น

คำถามเดียวกัน แต่การเติบโตและการเปลี่ยนแปลงในอีก 3-5 ปีข้างหน้าจะเป็นอย่างไร?

ก) CPU ที่มีส่วนขยาย AI จะจับตลาดการอนุมาน AI

b) โมเดลจะมีความว่องไว และพารามิเตอร์จะลดลงเมื่อความหนาแน่นของข้อมูลดีขึ้นจาก 16% เป็น 90%

c) ประสิทธิภาพการใช้พลังงานดีขึ้น รอยเท้า CO2 ลดลง

d) มีสถาปัตยกรรมใหม่เกิดขึ้น

e) ต้นทุนด้านฮาร์ดแวร์และพลังงานลดลง ดังนั้นอุปสรรคในการเข้าสู่บริษัทขนาดเล็กในการสร้างและฝึกอบรมโมเดลจึงมีราคาไม่แพง

f) ผู้คนพูดถึงช่วงเวลาก่อน AGI แต่เกณฑ์มาตรฐานของฉันคือ Samantha (AI การสนทนา) ที่มีตัวละครในภาพยนตร์เรื่อง "เธอ" ซึ่งอาจไม่น่าเป็นไปได้เนื่องจากต้นทุนในการขยายขนาดสูง

ความท้าทายที่อาจส่งผลกระทบหรือจำกัดการเติบโตของภาค AI/ML มีอะไรบ้าง

ก) การเข้าถึงฮาร์ดแวร์

b) ต้นทุนพลังงานและต้นทุนการทำความเย็นและอันตรายต่อสิ่งแวดล้อม

ยังอ่าน:

บทสัมภาษณ์ซีอีโอ: David Moore จาก Pragmatic

บทสัมภาษณ์ CEO: ดร. Meghali Chopra จาก Sandbox Semiconductor

- เนื้อหาที่ขับเคลื่อนด้วย SEO และการเผยแพร่ประชาสัมพันธ์ รับการขยายวันนี้

- PlatoData.Network Vertical Generative Ai เพิ่มพลังให้กับตัวเอง เข้าถึงได้ที่นี่.

- เพลโตไอสตรีม. Web3 อัจฉริยะ ขยายความรู้ เข้าถึงได้ที่นี่.

- เพลโตESG. คาร์บอน, คลีนเทค, พลังงาน, สิ่งแวดล้อม แสงอาทิตย์, การจัดการของเสีย. เข้าถึงได้ที่นี่.

- เพลโตสุขภาพ เทคโนโลยีชีวภาพและข่าวกรองการทดลองทางคลินิก เข้าถึงได้ที่นี่.

- ที่มา: https://semiwiki.com/ceo-interviews/338703-ceo-interview-suresh-sugumar-of-mastiska-ai/

- :มี

- :เป็น

- :ไม่

- :ที่ไหน

- $ ขึ้น

- 1

- 10

- 150

- 20

- 200

- 50

- 500

- 7

- a

- สามารถ

- เกี่ยวกับเรา

- ข้างบน

- อาบูดาบี

- การเร่งความเร็ว

- เร่ง

- เข้า

- การเข้าถึง

- อย่างกระตือรือร้น

- ที่อยู่

- จ่าหน้า

- ที่อยู่

- ความได้เปรียบ

- ธุรกิจ

- อีกครั้ง

- ตัวแทน

- ตัวแทน

- AGI

- มาแล้ว

- AI

- โมเดล AI

- วิจัยไอ

- ระบบ AI

- กรณีการใช้งาน ai

- AI / ML

- ชิด

- ทั้งหมด

- การอนุญาต

- ช่วยให้

- ตาม

- ด้วย

- ทางเลือก

- น่าอัศจรรย์

- an

- และ

- อื่น

- ใด

- ทุกแห่ง

- การใช้งาน

- การใช้งาน

- สถาปัตยกรรม

- เป็น

- พื้นที่

- มาถึง

- เทียม

- ปัญญาประดิษฐ์

- AS

- Asics

- ถาม

- At

- ยานยนต์

- ความพร้อมใช้งาน

- ใช้ได้

- ไป

- b

- อุปสรรค

- ตาม

- BE

- กลายเป็น

- จะกลายเป็น

- สมควร

- รับ

- กำลัง

- เชื่อ

- ด้านล่าง

- มาตรฐาน

- ประโยชน์

- ประโยชน์ที่ได้รับ

- ระหว่าง

- เกิน

- คอขวด

- ขอบเขต

- ของเล่นเพิ่มพัฒนาสมอง

- สมอง

- สร้าง

- การก่อสร้าง

- แต่

- ซื้อ

- by

- แคลิฟอร์เนีย

- CAN

- ยกเลิก

- ความสามารถ

- สามารถ

- เมืองหลวง

- จับ

- คาร์บอน

- คาร์บอน

- กรณี

- ศูนย์

- ผู้บริหารสูงสุด

- บทสัมภาษณ์ซีอีโอ

- ใบรับรอง

- ท้าทาย

- ความท้าทาย

- เปลี่ยนแปลง

- การเปลี่ยนแปลง

- เปลี่ยนแปลง

- ตัวอักษร

- ChatGPT

- เด็ก

- ชิป

- ชิป

- ทางเลือก

- Chopra

- ไคลเอนต์

- ปิดหน้านี้

- ใกล้ชิด

- เมฆ

- Cluster

- co2

- อย่างไร

- บริษัท

- บริษัท

- เมื่อเทียบกับ

- แข่งขัน

- การแข่งขัน

- คำนวณ

- คอมพิวเตอร์

- คอมพิวเตอร์

- การคำนวณ

- แนวความคิด

- การประชุม

- บริโภค

- การบริโภค

- ต่อ

- ส่วน

- การสนทนา

- AI สนทนา

- เย็น

- ราคา

- ค่าใช้จ่าย

- ได้

- สร้าง

- ปัจจุบัน

- สถานะปัจจุบัน

- ขณะนี้

- ประเพณี

- ลูกค้า

- ลูกค้า

- ตัด

- cybersecurity

- ข้อมูล

- ศูนย์ข้อมูล

- ศูนย์ข้อมูล

- เดวิด

- วัน

- วัน

- การตัดสินใจ

- ลึก

- การเรียนรู้ลึก ๆ

- ลึก

- ความต้องการ

- ทำให้เป็นประชาธิปไตย

- democratizing

- แสดงให้เห็นถึง

- ทั้งนี้ขึ้นอยู่กับ

- ออกแบบ

- พัฒนา

- พัฒนา

- ที่กำลังพัฒนา

- พัฒนาการ

- อุปกรณ์

- บูดาบี

- แยก

- ความขยัน

- ทิศทาง

- ผู้อำนวยการ

- do

- ทำ

- การทำ

- ดอลลาร์

- Dont

- ลง

- dr

- หล่น

- สอง

- ที่ได้รับ

- ขอบ

- ผลกระทบ

- อย่างมีประสิทธิภาพ

- ที่มีประสิทธิภาพ

- อย่างมีประสิทธิภาพ

- กระแสไฟฟ้า

- ปริมาณการใช้ไฟฟ้า

- กำจัด

- ขจัด

- อารมณ์

- การเอาใจใส่

- พลังงาน

- ประสิทธิภาพการใช้พลังงาน

- ชั้นเยี่ยม

- เสริม

- พอ

- ทั้งหมด

- การเข้า

- สิ่งแวดล้อม

- สิ่งแวดล้อม

- วาดภาพ

- ประมาณการ

- ประมาณ

- ฯลฯ

- อีเธอร์ (ETH)

- แม้

- ในที่สุด

- ทุกๆ

- ตัวอย่าง

- ผู้บริหารงาน

- ผู้อำนวยการบริหาร

- มีอยู่

- ความชำนาญ

- ระเบิด

- ส่วนขยาย

- ใบหน้า

- หันหน้าไปทาง

- เหยี่ยวนกเขา

- เร็วขึ้น

- ความรู้สึก

- ใส่

- บริษัท

- ที่ลอย

- มุ่งเน้น

- เท้า

- สำหรับ

- ล่วงรู้

- รูป

- โชคลาภ

- รากฐาน

- กรอบ

- ราคาเริ่มต้นที่

- แช่แข็ง

- เชื้อเพลิง

- การทำงาน

- ลึกซึ้ง

- อนาคต

- General

- ชั่วอายุคน

- กำเนิด

- กำเนิด AI

- กำหนด

- Go

- ไป

- ไป

- ดี

- GPUs

- บัญชีกลุ่ม

- การเจริญเติบโต

- การเจริญเติบโต

- ฮาร์ดแวร์

- มี

- he

- ด้วยเหตุนี้

- โปรดคลิกที่นี่เพื่ออ่านรายละเอียดเพิ่มเติม

- จุดสูง

- ถือ

- โฮสติ้ง

- สรุป ความน่าเชื่อถือของ Olymp Trade?

- HTTPS

- ใหญ่

- กอดใบหน้า

- เป็นมนุษย์

- มนุษยชาติ

- อีอีอี

- if

- ภาพ

- ส่งผลกระทบ

- ปรับปรุง

- ช่วยเพิ่ม

- in

- ในอื่น ๆ

- รวมถึง

- เพิ่ม

- อุตสาหกรรม

- ข้อมูล

- เราสร้างสรรค์สิ่งใหม่ ๆ

- นักวิเคราะห์ส่วนบุคคลที่หาโอกาสให้เป็นไปได้มากที่สุด

- นวัตกรรม

- แทน

- สถาบัน

- อินเทล

- Intelligence

- International

- อินเทอร์เน็ต

- สัมภาษณ์

- การลงทุน

- IOT

- IT

- ITS

- เพียงแค่

- เด็ก

- ชนิด

- ไม่มี

- ภูมิประเทศ

- ภาษา

- แล็ปท็อป

- ใหญ่

- ที่มีขนาดใหญ่

- นำ

- ความเป็นผู้นำ

- เรียนรู้

- การเรียนรู้

- ให้

- เลฟเวอเรจ

- การใช้ประโยชน์

- กดไลก์

- ไฟแก็ซ

- LIMIT

- โหลด

- ที่ตั้งอยู่

- ดู

- ดูเหมือน

- ลด

- เครื่อง

- การทำ

- ผู้ผลิต

- หลาย

- ตลาด

- ตลาด

- มดลูก

- ความกว้างสูงสุด

- อาจ..

- อาจจะ

- ปริญญาโทสาขาบริหารธุรกิจ

- me

- ความหมาย

- วิธี

- วัด

- ความทรงจำ

- กล่าวถึง

- อาจ

- ล้าน

- ล้านดอลลาร์

- เอ็มไอที

- แบบ

- โมเดล

- ขณะ

- การผูกขาด

- เดือน

- ข้อมูลเพิ่มเติม

- มากที่สุด

- หนัง

- การย้าย

- MS

- ต้อง

- my

- ชื่อ

- คือ

- โดยธรรมชาติ

- จำเป็นต้อง

- ตามเครือข่าย

- เครือข่าย

- ประสาท

- ใหม่

- ข่าว

- ถัดไป

- ช่อง

- คืน

- ว่องไว

- ตอนนี้

- นิวเคลียร์

- พลังงานนิวเคลียร์

- จำนวน

- มหาสมุทร

- of

- on

- ONE

- เพียง

- เปิด

- โอเพนซอร์ส

- OpenAI

- การดำเนินการ

- โอกาส

- การเพิ่มประสิทธิภาพ

- เพิ่มประสิทธิภาพ

- Options

- or

- อื่นๆ

- ของเรา

- ออก

- ของตนเอง

- หน้า

- Parallel

- พารามิเตอร์

- พารามิเตอร์

- ส่วน

- สิทธิบัตร

- ชำระ

- คน

- บางที

- ดาวเคราะห์

- พืช

- เวที

- แพลตฟอร์ม

- เพลโต

- เพลโตดาต้าอินเทลลิเจนซ์

- เพลโตดาต้า

- มากมายเหลือเฟือ

- บวก

- กระเป๋า

- จุด

- ตำแหน่ง

- เป็นไปได้

- อำนาจ

- โรงไฟฟ้า

- ประยุกต์

- พิมพ์

- ส่วนตัว

- ปัญหา

- ปัญหาที่เกิดขึ้น

- ผลิตภัณฑ์

- ผลิตภัณฑ์

- โปรไฟล์

- ความคืบหน้า

- แจ้ง

- ป้องกัน

- วัตถุประสงค์

- วัตถุประสงค์

- ผลัก

- ทำให้

- วอลคอมม์

- คำถาม

- คำถาม

- พิสัย

- จัดอันดับ

- อ่าน

- เมื่อเร็ว ๆ นี้

- แนะนำ

- แนะนำ

- ลด

- ลด

- ปกติ

- รายงาน

- ขอ

- การวิจัย

- วิจัยและพัฒนา

- นักวิจัย

- ขวา

- ริมแม่น้ำ

- บทบาท

- หลังคา

- วิ่ง

- วิ่ง

- ทำงาน

- ปลอดภัย

- ความปลอดภัย

- เดียวกัน

- การลงโทษ

- Sandbox

- ลด

- ประหยัด

- กล่าว

- ปรับ

- วิทยาศาสตร์

- ค้นหา

- ฤดู

- ภาค

- ปลอดภัย

- เห็น

- กลุ่ม

- สารกึ่งตัวนำ

- อุปกรณ์กึ่งตัวนำ

- ชุด

- เซิร์ฟเวอร์

- บริการ

- บริการ

- การให้บริการ

- Share

- ขาดแคลน

- น่า

- แสดงให้เห็นว่า

- แสดงให้เห็นว่า

- ด้าน

- สำคัญ

- ตั้งแต่

- มีขนาดเล็กกว่า

- มาร์ทโฟน

- มาร์ทโฟน

- So

- ซอฟต์แวร์

- โซลูชัน

- การแก้

- บาง

- แหล่ง

- ช่องว่าง

- เฉพาะ

- การใช้จ่าย

- Stanford

- เริ่มต้น

- startups

- สถานะ

- กลยุทธ์

- นฤดม

- อย่างเช่น

- จัดหาอุปกรณ์

- สนับสนุน

- ที่ยั่งยืน

- ระบบ

- ต่อสู้

- การแก้ปัญหา

- การตัดเสื้อ

- เอา

- คุย

- งาน

- วิชาการ

- เทคโนโลยี

- นวัตกรรมเทคโนโลยี

- เงื่อนไขการใช้บริการ

- ข้อความ

- กว่า

- ที่

- พื้นที่

- ก้าวสู่อนาคต

- ข้อมูล

- โลก

- ของพวกเขา

- พวกเขา

- แล้วก็

- ที่นั่น

- ดังนั้น

- ล้อยางขัดเหล่านี้ติดตั้งบนแกน XNUMX (มม.) ผลิตภัณฑ์นี้ถูกผลิตในหลายรูปทรง และหลากหลายเบอร์ความแน่นหนาของปริมาณอนุภาคขัดของมัน จะทำให้ท่านได้รับประสิทธิภาพสูงในการขัดและการใช้งานที่ยาวนาน

- พวกเขา

- สิ่ง

- นี้

- เหล่านั้น

- แต่?

- เจริญเติบโต

- เวลา

- ไปยัง

- วันนี้

- ราชสกุล

- วันพรุ่งนี้

- เกินไป

- ด้านบน

- โยน

- แบบดั้งเดิม

- รถไฟ

- การฝึกอบรม

- หม้อแปลงไฟฟ้า

- หม้อแปลง

- แนวโน้ม

- ที่เชื่อถือ

- ลอง

- พยายาม

- ภายใต้

- เข้าใจ

- มหาวิทยาลัย

- มหาวิทยาลัยแห่งแคลิฟอร์เนีย

- ไม่แน่

- us

- การใช้

- ใช้

- มือสอง

- การใช้

- ต่างๆ

- บริษัท ร่วมทุน

- ร่วมทุน

- บริษัท ร่วมทุน

- มาก

- ของ

- คือ

- น้ำดื่ม

- ทาง..

- we

- เว็บ

- สวัสดิการ

- คือ

- อะไร

- เมื่อ

- ที่

- WHO

- ทำไม

- จะ

- กับ

- ไม่มี

- งาน

- การทำงาน

- โลก

- จะ

- ผิด

- ปี

- เธอ

- ของคุณ

- ลมทะเล