Jay Dawani är medgrundare och VD på Lemurian Labs, en startup som utvecklar en accelererad datorplattform skräddarsydd specifikt för AI-applikationer. Plattformen bryter igenom hårdvarubarriärerna för att göra AI-utveckling snabbare, billigare, mer hållbar och tillgänglig för fler än bara ett fåtal företag.

Innan han grundade Lemurian grundade Jay två andra företag inom AI-området. Han är också författaren till den högst rankade "Matematik för djupinlärning. "

En expert inom artificiell intelligens, robotik och matematik, har Jay fungerat som CTO för BlocPlay, ett publikt företag som bygger en blockchain-baserad spelplattform, och fungerat som direktör för AI på GEC, där han ledde utvecklingen av flera kundprojekt som täcker områden från detaljhandel, algoritmisk handel, proteinveckning, robotar för rymdutforskning, rekommendationssystem och mer. På fritiden har han även varit rådgivare på NASA Frontier Development Lab, Spacebit och SiaClassic.

Förra gången vi presenterade Lemurian Labs var du fokuserad på robotik och edge AI. Nu är du fokuserad på datacenter och molninfrastruktur. Vad hände som fick dig att vilja pivotera?

Faktum är att vi övergick från att fokusera på att bygga en högpresterande, låg latens, system-på-chip för autonoma robotapplikationer som kunde accelerera hela sense-plan-act-loopen till att bygga en domänspecifik accelerator för AI med fokus på datacenter-skala applikationer . Men det var inte bara en vanlig pivot; det var ett clarion-samtal som vi kände att vi hade ansvaret att besvara.

Under 2018 arbetade vi med att utbilda en parametermodell på 2.1 miljarder dollar, men vi övergav ansträngningen eftersom kostnaderna var så extraordinärt höga att vi inte kunde motivera det. Så föreställ dig min förvåning över att GPT3, som OpenAI släppte som ChatGPT i november 2022, var en parametermodell på 175 miljarder dollar. Den här modellen är mer än 80 gånger större än vad vi arbetade med bara fyra år tidigare, vilket är både spännande och skrämmande.

Kostnaden för att utbilda en sådan modell är minst sagt svindlande. Baserat på aktuella skalningstrender kan vi förvänta oss att kostnaden för att träna en frontier AI-modell kommer att överstiga en miljard dollar inom en inte alltför avlägsen framtid. Även om kapaciteten hos dessa modeller kommer att vara häpnadsväckande, är kostnaden löjligt hög. Baserat på denna bana kommer endast en handfull mycket välresursstarka företag med egna datacenter att ha råd att träna, distribuera och finjustera dessa modeller. Detta beror inte enbart på att datorer är dyrt och energikrävande, utan också på att mjukvarustackarna vi litar på inte byggdes för den här världen.

På grund av geografiska och energimässiga begränsningar finns det bara så många platser att bygga datacenter på. För att möta beräkningskraven för AI måste vi kunna bygga maskiner i zettaskala utan att behöva 20 kärnreaktorer för att driva den. Vi behöver en mer praktisk, skalbar och ekonomisk lösning. Vi såg oss omkring och såg ingen som var på väg att lösa detta. Och så gick vi till ritbordet för att se på problemet holistiskt som ett system av system och resonera kring en lösning från första principer. Vi frågade oss själva, hur skulle vi designa hela stacken, från mjukvara till hårdvara, om vi var tvungna att ekonomiskt betjäna 10 miljarder LLM-förfrågningar om dagen. Vi har siktet inställt på en zettaskalamaskin på under 200MW, år 2028.

Tricket är att titta på det ur synvinkeln av opåverkad skalning – olika delar av ett system följer olika skalningsregler, så någon gång slutar saker bara att fungera, börjar gå sönder eller så är kostnadsvinstavvägningen inte längre vettig. När detta händer är det enda alternativet att göra om systemet. Vår bedömning och lösning omfattar arbetsbelastning, nummersystem, programmeringsmodell, kompilator, körtid och hårdvara holistiskt.

Tack och lov ser våra befintliga investerare och resten av marknaden visionen, och vi samlade in en startrunda på 9 miljoner USD för att utveckla vårt nummerformat – PAL, för att utforska designutrymmet och konvergera till en arkitektur för vår domänspecifika accelerator, och utforma vår kompilator och körtid. I simuleringar har vi kunnat uppnå en 20X genomströmningsvinst i det mindre energifotavtrycket än moderna GPU: er, och vi räknar med att kunna leverera en 8X fördel i systemprestanda för total ägandekostnad på samma transistorteknologi.

Det behöver inte sägas att vi har mycket arbete framför oss, men vi är ganska glada över möjligheten att kunna omdefiniera datacenterekonomi för att säkerställa en framtid där AI är rikligt tillgängligt för alla.

Det låter verkligen spännande och de siffrorna låter imponerande. Men du har nämnt nummersystem, hårdvara, kompilatorer och körtider som allt du fokuserar på – det låter mycket för vilket företag som helst att ta sig an på en gång. Det verkar vara ett mycket riskabelt förslag. Är det inte meningen att startups ska vara mer fokuserade?

Det låter som många olika insatser, men det är i själva verket ett försök med många sammankopplade delar. Att bara lösa en av dessa komponenter isolerat från de andra kommer bara att hindra potentialen för innovation eftersom det resulterar i att man förbiser systemisk ineffektivitet och flaskhalsar. Jensen Huang sa det bäst, "För att vara ett accelererat datorföretag måste du vara ett fullstackföretag", och jag håller helt med. De är den nuvarande marknadsledaren av en anledning. Men jag skulle utmana föreställningen att vi inte är fokuserade. Det är i hur vi tänker kring problemet holistiskt och hur vi bäst löser det för våra kunder, som är där vårt fokus ligger.

Att göra det kräver ett tvärvetenskapligt tillvägagångssätt som vårt. Varje del av vårt arbete informerar och stödjer de andra, vilket gör det möjligt för oss att skapa en lösning som är mycket mer än summan av dess delar. Tänk om du var tvungen att bygga en racerbil. Du skulle inte godtyckligt välja ett chassi, lägga till racingdäck och släppa in den mest kraftfulla motorn du kan hitta och köra den, eller hur? Du skulle tänka på aerodynamiken hos bilens kaross för att minska luftmotståndet och förbättra nedåtkraften, optimera viktfördelningen för bra hantering, specialdesigna motorn för maximal prestanda, skaffa ett kylsystem för att förhindra överhettning, specificera en rullbur för att hålla föraren säker , etc. Vart och ett av dessa element bygger på och informerar det andra.

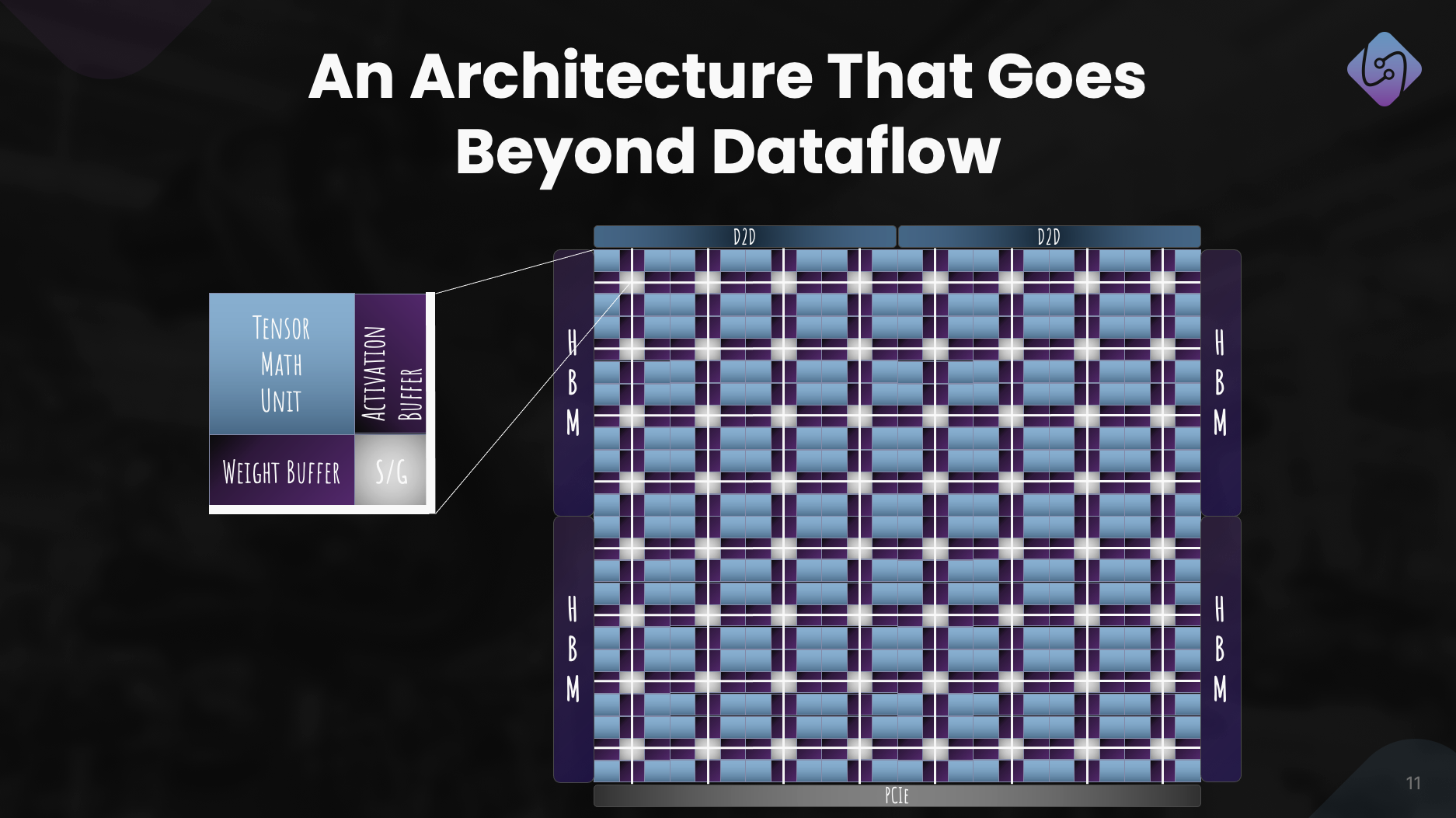

Som sagt, det är riskabelt att försöka göra allt på en gång för vilket företag som helst i vilken bransch som helst. För att hantera riskerna använder vi ett stegvis tillvägagångssätt, vilket gör att vi kan validera vår teknik med kunder och anpassa vår strategi efter behov. Vi har bevisat att vårt talformat fungerar och att det har bättre effekt-prestanda-area än motsvarande flyttalstyper, samtidigt som det har bättre numeriska egenskaper som gör det lättare att kvantisera neurala nätverk till mindre bitbredder. Vi har designat en arkitektur som vi känner oss trygga i, och den lämpar sig för både träning och slutledning. Men viktigare än allt detta är att få rätt programvara, och det är huvuddelen av vårt omedelbara fokus. Vi måste se till att vi fattar rätt beslut i vår mjukvarustapel där vi ser världen vara ett eller två år eller mer från idag.

Att bygga ett hårdvaruföretag är tufft, dyrt och tar lång tid. Fokus på mjukvara låter först som en mycket lönsam verksamhet i sig, och potentiellt mer tilltalande för investerare i det nuvarande klimatet. Varför gör ni också hårdvara eftersom så många välfinansierade företag i utrymmet stänger sina dörrar, kämpar för att få adoption hos kunder och större aktörer bygger sin egen hårdvara?

Du har helt rätt i att mjukvaruföretag generellt sett har kunnat skaffa kapital mycket lättare än hårdvaruföretag, och att hårdvaran är väldigt tuff. Vårt nuvarande fokus ligger mycket på mjukvara eftersom det är där vi ser det större problemet. Låt mig vara tydlig, problemet är inte om jag kan köra kärnor på en CPU eller GPU med hög prestanda; det är ett länge löst problem. Dagens problem är hur vi gör det lättare för utvecklare att få mer prestanda, produktivt ur flera tusen nodkluster som består av heterogena datorer utan att be dem att se över sitt arbetsflöde.

Det är problemet vi för närvarande fokuserar på att lösa med en mjukvarustapel som ger utvecklare superkrafter och låser upp den fulla kapaciteten hos datorer i lagerskala, så att vi kan träna och distribuera AI-modeller mer ekonomiskt.

Nu när det gäller investeringar, ja, VC:er är mer selektiva i den typ av företag de stödjer, men det betyder också att VC:er letar efter företag med potential att erbjuda verkligt banbrytande produkter som har en tydlig väg till kommersialisering samtidigt som de har betydande inverkan. Vi har lärt oss av andras utmaningar och misstag och har aktivt utformat vår affärsmodell och färdplan för att hantera riskerna. Det är också viktigt att notera att det som har gjort startups framgångsrika sällan har varit hur lätt de kan få in VC-finansiering, utan har mer att göra med deras påhittighet, envishet och kundfokus.

Och innan du frågar jobbar vi fortfarande med hårdvara, men framför allt med simulering just nu. Vi tänker inte spela in på ett tag. Men vi kan spara den konversationen till en annan gång.

Det är verkligen övertygande och ditt stegvisa tillvägagångssätt är mycket annorlunda jämfört med vad vi har sett andra hårdvaruföretag göra. Jag förstår problemet som du säger att din mjukvarustapel kommer att lösa, men hur skiljer sig din programvara från de olika ansträngningarna på marknaden?

De flesta av företagen du hänvisar till fokuserar på att göra det enklare att programmera GPU:er genom att introducera kakelbaserade eller uppgiftsmappande programmeringsmodeller för att få ut mer prestanda ur GPU:er, eller bygga nya programmeringsspråk för att få högpresterande kärnor schemalagda på olika plattformar med stöd för in-line montering. Det är viktiga problem som de tar upp, men vi ser problemet vi löser som nästan ortogonalt.

Låt oss för ett ögonblick tänka på kadensen för hårdvaru- och mjukvaruövergångar. Enkärniga arkitekturer fick prestanda från klockhastighet och transistortäthet, men så småningom slog klockhastigheterna en platå. Parallellism med användning av många kärnor kringgick detta och gav betydande hastigheter. Det tog mjukvaran ungefär ett decennium att komma ikapp, eftersom programmeringsmodeller, kompilatorer och körtider måste tänkas om för att hjälpa utvecklare att utvinna värdet i detta paradigm. Sedan började GPU:er bli allmänna acceleratorer, igen med en annan programmeringsmodell. Återigen tog det nästan ett decennium för utvecklare att utvinna värde här.

Återigen, hårdvaran når en platå – Moores lag, energi- och termiska begränsningar, minnesflaskhalsar och mångfalden av arbetsbelastningar plus behovet av exponentiellt mer beräkning driver oss mot att bygga allt mer heterogena datorarkitekturer för bättre prestanda, effektivitet och totalkostnad. Denna förändring av hårdvara kommer naturligtvis att skapa utmaningar för mjukvara eftersom vi inte har rätt kompilatorer och körtider för att stödja nästa utveckling av datoranvändning. Den här gången borde vi dock inte behöva vänta ytterligare 10 år på att programvara ska extrahera värdet av heterogena arkitekturer eller stora kluster, särskilt när de inte används till mer än 80 %.

Det vi fokuserar på är att bygga en heterogenitetsmedveten programmeringsmodell med uppgiftsbaserad parallellitet, som tar itu med portabel prestanda med korsprocessoroptimeringar, kontextmedveten kompilering och dynamisk resursallokering. Och för oss spelar det ingen roll om det är en CPU, GPU, TPU, SPU (Lemurians arkitektur) eller ett nät av dem alla. Jag vet att det låter som många tjusiga ord, men vad det egentligen säger är att vi har gjort det möjligt att programmera vilken typ av processor som helst med ett enda tillvägagångssätt, och vi kan porta kod från en typ av processor till en annan med minimal ansträngning utan att behöva offra prestanda och schemalägg arbete adaptivt och dynamiskt över noder.

Om det du säger är sant kan du helt enkelt omdefiniera datoranvändning. Låt oss prata om finansiering. Du samlade in 9 miljoner USD i startfinansiering förra året, vilket betyder starkt investerarstöd och tro på din vision. Vad har du gjort sedan dess?

Under det senaste året, på grund av startfinansieringen, har vi gjort betydande framsteg. Med vårt team nu på 20 medlemmar tog vi noggrant upp utmaningar, engagerade oss med kunder och förfinade vårt tillvägagångssätt.

Vi fokuserade på att förbättra PAL för träning och slutledning, utforskade datorarkitekturen för vår accelerator och utvecklade en simulator för prestandamått. Samtidigt omarbetade vi vår mjukvarustapel för datacenterapplikationer, med betoning på heterogen datoranvändning.

Denna ansträngning resulterade i en väldefinierad arkitektur som visar PAL:s effektivitet för AI i stor skala. Utöver tekniska framsteg, strävade vi efter samarbeten och uppsökande verksamhet för att demokratisera tillgången. Dessa ansträngningar positionerar Lemurian Labs för att ta itu med omedelbara kundutmaningar, förbereda sig för lanseringen av vårt produktionskisel.

Vilka är Lemurian Labs planer på medellång sikt när det gäller utveckling av mjukvarustack, samarbeten och förbättring av acceleratorns arkitektur?

Vårt omedelbara mål är att skapa en mjukvarustack som är inriktad på CPU:er, GPU:er och våra AI-acceleratorer med bärbar prestanda, som kommer att göras tillgänglig för tidiga partners i slutet av året. Vi för för närvarande samtal med de flesta av de ledande halvledarföretagen, molntjänsteleverantörer, hyperskalare och AI-företag för att ge dem tillgång till vår kompilator och körtid. Parallellt fortsätter vi att arbeta på och förbättra vår acceleratorarkitektur för ett verkligt samdesignat system av hårdvara och mjukvara. Och naturligtvis har vi precis börjat lyfta vår serie A med mycket starkt intresse från investerargemenskapen, vilket kommer att göra det möjligt för oss att växa vårt team och nå vårt mål för leverans av mjukvaruprodukter i slutet av året.

Avslutningsvis, hur ser du på att Lemurian Labs bidrar till att förändra landskapet för AI-utveckling, tillgänglighet och rättvisa under de kommande åren?

Vi hade inte för avsikt att omdefiniera datoranvändning endast för kommersiell vinning eller för skojs skull. Som lemurianer är vår drivkraft att vi tror på den transformativa potentialen hos AI och att fler än bara ett fåtal företag borde ha resurserna att definiera framtiden för denna teknik och hur vi använder den. Vi finner det inte heller acceptabelt att datacenterinfrastrukturen för AI är på väg att förbruka så mycket som 20 % av världens energi till 2030. Vi samlades alla för att vi tror att det finns en bättre väg framåt för samhället om vi kan göra AI mer tillgänglig genom att dramatiskt sänka dess tillhörande kostnader, accelerera innovationstakten inom AI och bredda dess inverkan. Genom att ta itu med utmaningarna i den nuvarande hårdvaruinfrastrukturen försöker vi bana vägen för att ge en miljard människor möjligheterna med AI, vilket säkerställer en rättvis distribution av denna avancerade teknik. Vi hoppas att vårt engagemang för produktfokuserade lösningar, samarbete och kontinuerlig innovation positionerar oss som en drivande kraft i att forma framtiden för AI-utveckling till en positiv sådan.

Läs också:

Dela det här inlägget via:

- SEO-drivet innehåll och PR-distribution. Bli förstärkt idag.

- PlatoData.Network Vertical Generative Ai. Styrka dig själv. Tillgång här.

- PlatoAiStream. Web3 Intelligence. Kunskap förstärkt. Tillgång här.

- Platoesg. Kol, CleanTech, Energi, Miljö, Sol, Avfallshantering. Tillgång här.

- PlatoHealth. Biotech och kliniska prövningar Intelligence. Tillgång här.

- Källa: https://semiwiki.com/ceo-interviews/341485-ceo-interview-jay-dawani-of-lemurian-labs-2/

- : har

- :är

- :inte

- :var

- $ 9 miljoner

- $UPP

- 1

- 10

- 20

- 2018

- 2022

- 2028

- 2030

- 20x

- 300

- 4

- a

- Able

- Om oss

- absolut

- accelerera

- accelererad

- accelerator

- acceleratorer

- godtagbart

- tillgång

- tillgänglighet

- tillgänglig

- Uppnå

- tvärs

- aktivt

- lägga till

- adress

- adresserad

- adresse

- justera

- Antagande

- avancerat

- Advanced Technology

- framsteg

- rådgivare

- igen

- framåt

- AI

- AI-modeller

- algoritmisk

- algoritmisk handel

- Alla

- fördelning

- tillåta

- nästan

- också

- amason

- an

- och

- Annan

- svara

- vilken som helst

- någon

- lockande

- tillämpningar

- tillvägagångssätt

- godtyckligt

- arkitektur

- arkitekturer

- ÄR

- områden

- runt

- konstgjord

- artificiell intelligens

- AS

- be

- be

- Montage

- bedömning

- associerad

- förvånande

- At

- Författaren

- autonom

- tillgänglig

- tillbaka

- barriärer

- baserat

- BE

- därför att

- passande

- varit

- innan

- Där vi får lov att vara utan att konstant prestera,

- tro

- tro

- fördel

- BÄST

- Bättre

- Bortom

- större

- Miljarder

- blockchain-baserade

- ombord

- kropp

- båda

- flaskhals

- Breaking

- raster

- bredda

- SLUTRESULTAT

- Byggnad

- bygger

- byggt

- bulk

- företag

- affärsmodell

- företag

- men

- by

- Kadens

- Ring

- kom

- KAN

- Kan få

- kapacitet

- kapacitet

- kapital

- brottning

- Centrum

- VD

- VD-intervju

- säkerligen

- utmanar

- utmaningar

- byte

- chassi

- ChatGPT

- billigare

- klar

- klient

- Klimat

- klocka

- stängning

- cloud

- molninfrastruktur

- Medgrundare

- koda

- samverkan

- samarbeten

- kommande

- kommersiella

- kommersialisering

- engagemang

- samfundet

- Företag

- företag

- jämfört

- övertygande

- kompilator

- fullständigt

- komponenter

- Compute

- dator

- datorer

- databehandling

- säker

- begränsningar

- konsumera

- fortsätta

- kontinuerlig

- Bidragande

- konvergerar

- Konversation

- konversationer

- kylsystem

- korrekt

- Pris

- kunde

- Naturligtvis

- beläggning

- CPU

- skapa

- Cross

- CTO

- Aktuella

- För närvarande

- beställnings

- specialdesignad

- kund

- Kunder

- datum

- Data Center

- Datacenter

- dag

- årtionde

- beslut

- djup

- definiera

- leverera

- leverans

- krav

- DEMOKRATISERA

- densitet

- distribuera

- Designa

- utformade

- utveckla

- utvecklade

- utvecklare

- utveckla

- Utveckling

- DID

- olika

- skilja

- Direktör

- Avlägsen

- fördelning

- Mångfald

- do

- gör

- inte

- gör

- dollar

- domän

- gjort

- inte

- Dörrarna

- dramatiskt

- ritning

- chaufför

- drivande

- Drop

- dynamisk

- dynamiskt

- varje

- Tidigare

- Tidig

- lättare

- lätt

- ekonomiskt

- Ekonomi

- kant

- effektivitet

- effektivitet

- ansträngning

- ansträngningar

- element

- betona

- ge

- möjliggöra

- möjliggör

- omfattar

- änden

- energi

- ingrepp

- Motor

- förbättra

- förbättra

- säkerställa

- säkerställa

- Hela

- rättvis

- eget kapital

- Motsvarande

- speciellt

- etc

- så småningom

- alla

- Utvecklingen

- överstiga

- exciterade

- spännande

- befintliga

- förvänta

- dyra

- expert

- utforskning

- utforska

- utforskas

- exponentiellt

- extrahera

- utomordentligt

- Faktum

- fantasi

- långt

- snabbare

- skisserat

- känna

- filt

- få

- hitta

- Förnamn

- flytande

- Fokus

- fokuserade

- fokusering

- följer

- Fotavtryck

- För

- kraft

- format

- Framåt

- Grundad

- grundande

- från

- Frontier

- fueled

- full

- Full stack

- fullständigt

- kul

- finansiering

- framtida

- Framtiden för AI

- Få

- vunnits

- Gaming

- spelplattform

- utväxling

- Allmänt

- allmänhet

- geografisk

- skaffa sig

- få

- Ge

- ges

- ger

- Målet

- kommer

- god

- fick

- GPU

- GPUs

- banbrytande

- Väx

- hade

- näve

- Arbetsmiljö

- hänt

- händer

- hårdvara

- Har

- har

- he

- hjälpa

- här.

- Hög

- hindra

- hans

- Träffa

- slå

- hoppas

- Hur ser din drömresa ut

- How To

- HTTPS

- huang

- Hungrig

- i

- if

- bild

- omedelbar

- Inverkan

- med Esport

- imponerande

- förbättra

- förbättring

- in

- alltmer

- industrin

- ineffektivitet

- informerar

- Infrastruktur

- Innovation

- Intelligens

- avser

- sammankopplade

- intresse

- Intervju

- införa

- investering

- investerare

- För Investerare

- isolering

- IT

- DESS

- jensen huang

- jpg

- bara

- Ha kvar

- Snäll

- Vet

- lab

- Labs

- liggande

- Språk

- Large

- större

- Efternamn

- Förra året

- Latens

- Lag

- ledare

- ledande

- lärt

- t minst

- Led

- Låt

- tycka om

- ll

- llm

- Lång

- länge sedan

- längre

- se

- såg

- du letar

- Lot

- Låg

- sänkning

- Maskinen

- Maskiner

- gjord

- göra

- GÖR

- Framställning

- hantera

- många

- marknad

- Marknadsledare

- matematik

- Materia

- max-bredd

- maximal

- Maj..

- me

- betyder

- Möt

- Medlemmar

- Minne

- nämnts

- endast

- maska

- noggrant

- Metrics

- miljon

- minimum

- misstag

- modell

- modeller

- Modern Konst

- ögonblick

- mer

- mest

- mycket

- tvärvetenskaplig

- my

- Nasa

- Behöver

- behövs

- behöver

- nätverk

- neural

- neurala nätverk

- Nya

- Nästa

- Nej

- nod

- noder

- Notera

- Begrepp

- November

- nu

- nukleär

- antal

- nummer

- of

- erbjudanden

- on

- gång

- ONE

- endast

- OpenAI

- optimeringar

- Optimera

- Alternativet

- or

- beställa

- vanlig

- Övriga

- Övrigt

- vår

- själva

- ut

- uppsökande

- över

- Renoverings

- egen

- ägande

- Fred

- paradigmet

- Parallell

- parameter

- del

- partner

- reservdelar till din klassiker

- Tidigare

- bana

- bana

- Personer

- prestanda

- Gradvis

- plocka

- pivot

- platser

- planer

- plattform

- Plattformar

- plato

- Platon Data Intelligence

- PlatonData

- plus

- Punkt

- Synvinkel

- portabel

- placera

- positioner

- positiv

- möjlig

- Inlägg

- potentiell

- potentiellt

- kraft

- den mäktigaste

- Praktisk

- pretty

- förhindra

- primärt

- Principerna

- Problem

- problem

- bearbetning

- Processorn

- Produkt

- Produktion

- Produkter

- Program

- Programmering

- programmeringsspråk

- projekt

- egenskaper

- förslag

- utsikter

- Protein

- beprövade

- förutsatt

- leverantörer

- allmän

- rent

- Syftet

- Tryckande

- sökfrågor

- Lopp

- Racing

- höja

- insamlat

- höja

- sällan

- Läsa

- verkligen

- Anledningen

- Rekommendation

- Redefine

- redesign

- minska

- hänvisar

- raffinerade

- om

- återupptäckt

- frigöra

- frigörs

- förlita

- Kräver

- resurs

- Resurser

- ansvaret

- REST

- resulte

- Resultat

- detaljhandeln

- höger

- risker

- Riskabel

- färdplan

- robotik

- robotar

- Rulla

- ungefär

- rund

- regler

- rinnande

- offra

- säker

- Nämnda

- Samma

- Save

- säga

- säger

- skalbar

- Skala

- skalning

- tidtabellen

- planerad

- se

- frö

- Fröfinansiering

- Frö Runda

- Seek

- verkar

- sett

- selektiv

- halvledare

- känsla

- Serier

- Serie A

- tjänar

- eras

- service

- tjänsteleverantörer

- in

- flera

- formning

- skifta

- skall

- visa upp

- Sevärdheter

- signifikant

- betyder

- Kisel

- simulering

- simuleringar

- Simulatorn

- samtidigt

- eftersom

- enda

- ganska stor

- Skjut

- mindre

- So

- Samhället

- Mjukvara

- lösning

- Lösningar

- LÖSA

- löst

- Lösa

- några

- ljud

- ljud

- Utrymme

- utforskning av rymden

- rumsliga

- specifik

- specifikt

- fart

- hastigheter

- stapel

- Stacks

- förbluffande

- starta

- igång

- start

- Startups

- Fortfarande

- Sluta

- Strategi

- steg

- stark

- Kämpar

- framgångsrik

- sådana

- lämplig

- summan

- stödja

- Stöder

- förment

- överraskning

- hållbart

- system

- systemisk

- System

- skräddarsydd

- Ta

- tar

- tar

- Diskussion

- tejp

- Målet

- mål

- grupp

- tech

- Teknologi

- än

- den där

- Smakämnen

- Framtiden

- Landskapet

- världen

- deras

- Dem

- sedan

- Där.

- termisk

- Dessa

- de

- saker

- tror

- detta

- de

- fastän?

- tusen

- Genom

- genomströmning

- tid

- däck

- till

- i dag

- tillsammans

- alltför

- tog

- Totalt

- seg

- mot

- spår

- Handel

- Tåg

- Utbildning

- bana

- transformativ

- övergång

- övergångar

- Trender

- knep

- sann

- verkligen

- prova

- två

- typer

- under

- förstå

- enhet

- låser upp

- på

- us

- användning

- med hjälp av

- BEKRÄFTA

- värde

- olika

- VC

- VC-finansiering

- VC

- mycket

- via

- genomförbar, livskraftig

- utsikt

- syn

- vänta

- vill

- Warehouse

- var

- we

- vikt

- VÄL

- väldefinierad

- begav sig

- były

- Vad

- när

- om

- som

- medan

- varför

- kommer

- med

- utan

- ord

- Arbete

- arbetsflöde

- arbetssätt

- fungerar

- världen

- Världens

- skulle

- år

- år

- ja

- dig

- Din

- zephyrnet