Sponsrade innehåll

ChatGPT och liknande verktyg baserade på stora språkmodeller (LLM) är fantastiska. Men de är inte allsidiga verktyg.

Det är precis som att välja andra verktyg för att bygga och skapa. Du måste välja rätt för jobbet. Du skulle inte försöka dra åt en bult med en hammare eller vända en hamburgerbiff med en visp. Processen skulle vara besvärlig, vilket skulle resultera i ett rörigt misslyckande.

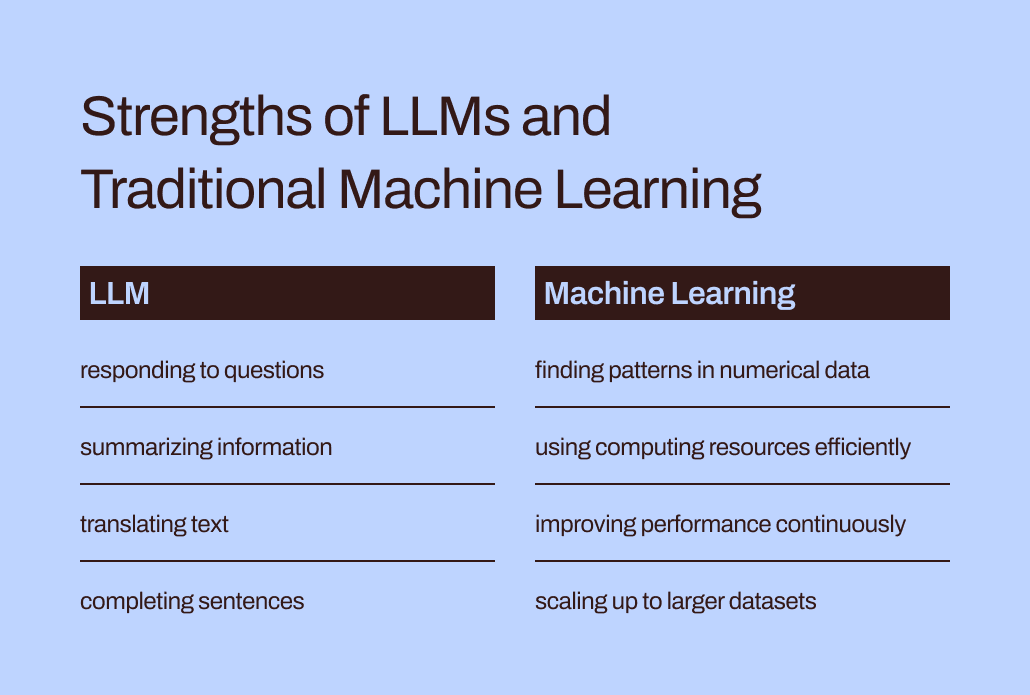

Språkmodeller som LLM:er utgör bara en del av den bredare verktygslådan för maskininlärning, som omfattar både generativ AI och prediktiv AI. Att välja rätt typ av maskininlärningsmodell är avgörande för att anpassas till kraven för din uppgift.

Låt oss gräva djupare in i varför LLM:er passar bättre för att hjälpa dig att skriva text eller brainstorma presentidéer än för att ta itu med ditt företags mest kritiska prediktiva modelleringsuppgifter. Det finns fortfarande en viktig roll för de "traditionella" maskininlärningsmodellerna som föregick LLM och som upprepade gånger har bevisat sitt värde i företag. Vi kommer också att utforska ett banbrytande tillvägagångssätt för att använda dessa verktyg tillsammans – en spännande utveckling som vi på Pecan kallar Förutsägande GenAI.

LLM är designade för ord, inte siffror

Inom maskininlärning används olika matematiska metoder för att analysera vad som kallas "träningsdata" - en initial datauppsättning som representerar det problem som en dataanalytiker eller datavetare hoppas kunna lösa.

Betydelsen av träningsdata kan inte överskattas. Den innehåller mönstren och relationerna som en maskininlärningsmodell kommer att "lära sig" att förutsäga resultat när den senare ges ny, osynlig data.

Så, vad är egentligen en LLM? Stora språkmodeller, eller LLM, faller under paraplyet maskininlärning. De kommer från djupinlärning och deras struktur är speciellt utvecklad för naturlig språkbehandling.

Man kan säga att de bygger på en grund av ord. Deras mål är helt enkelt att förutsäga vilket ord som kommer att bli nästa i en sekvens av ord. Till exempel använder iPhones autokorrigeringsfunktion i iOS 17 nu en LLM för att bättre förutsäga vilket ord du med största sannolikhet tänker skriva härnäst.

Föreställ dig nu att du är en maskininlärningsmodell. (Håda med oss, vi vet att det är en sträcka.) Du har tränats i att förutsäga ord. Du har läst och studerat miljontals ord från ett stort antal källor om alla typer av ämnen. Dina mentorer (alias utvecklare) har hjälpt dig att lära dig de bästa sätten att förutsäga ord och skapa ny text som passar en användares önskemål.

Men här är en twist. En användare ger dig nu ett enormt kalkylblad med kund- och transaktionsdata, med miljontals rader med nummer, och ber dig att förutsäga siffror relaterade till denna befintliga data.

Hur tror du att dina förutsägelser skulle bli? För det första skulle du förmodligen bli irriterad över att den här uppgiften inte stämmer överens med det du arbetat så hårt för att lära dig. (Lyckligtvis, så vitt vi vet, har LLMs ännu inte känslor.) Ännu viktigare är att du blir ombedd att göra en uppgift som inte stämmer överens med det du har lärt dig att göra. Och du kommer förmodligen inte att prestera så bra.

Klyftan mellan utbildning och uppgift hjälper till att förklara varför LLM:er inte är väl lämpade för prediktiva uppgifter som involverar numeriska data i tabellform – det primära dataformatet som de flesta företag samlar in. Istället är en maskininlärningsmodell speciellt framtagen och finjusterad för att hantera denna typ av data mer effektiv. Den har bokstavligen tränats för detta.

LLM:s effektivitets- och optimeringsutmaningar

Förutom att vara en bättre matchning för numerisk data är traditionella maskininlärningsmetoder mycket effektivare och lättare att optimera för bättre prestanda än LLM.

Låt oss gå tillbaka till din upplevelse av att vara en LLM. Att läsa alla dessa ord och studera deras stil och sekvens låter som massor av arbete, eller hur? Det skulle krävas mycket ansträngning att internalisera all den informationen.

På samma sätt kan LLM:ers komplexa utbildning resultera i modeller med miljarder parametrar. Den komplexiteten gör det möjligt för dessa modeller att förstå och svara på de knepiga nyanserna i mänskligt språk. Men tung träning kommer med tunga beräkningskrav när LLM genererar svar. Numeriskt orienterade "traditionella" maskininlärningsalgoritmer, som beslutsträd eller neurala nätverk, kommer sannolikt att behöva mycket färre datorresurser. Och det här är inte ett fall av "större är bättre." Även om LLM:er kunde hantera numerisk data skulle denna skillnad innebära att traditionella maskininlärningsmetoder fortfarande skulle vara snabbare, effektivare, mer miljömässigt hållbara och mer kostnadseffektiva.

Dessutom, har du någonsin frågat ChatGPT hur det visste att ge ett visst svar? Dess svar kommer förmodligen att vara lite vagt:

Jag genererar svar baserat på en blandning av licensierad data, data skapad av mänskliga tränare och offentligt tillgänglig data. Min utbildning involverade också storskaliga datamängder från en mängd olika källor, inklusive böcker, webbplatser och andra texter, för att utveckla en bred förståelse av mänskligt språk. Utbildningsprocessen involverar att köra beräkningar på tusentals GPU: er under veckor eller månader, men exakta detaljer och tidsskalor är proprietära för OpenAI.

Hur mycket av "kunskapen" som återspeglades i det svaret kom från de mänskliga tränarna kontra de offentliga uppgifterna kontra böckerna? Även ChatGPT själv är inte säker: "De relativa proportionerna av dessa källor är okända, och jag har inte detaljerad insyn i vilka specifika dokument som ingick i min träningsuppsättning."

Det är lite irriterande att ChatGPT ger så säkra svar på dina frågor men inte kan spåra svaren till specifika källor. LLM:ers begränsade tolkningsbarhet och förklarabarhet innebär också utmaningar när det gäller att optimera dem för särskilda affärsbehov. Det kan vara svårt att förstå logiken bakom deras information eller förutsägelser. För att ytterligare komplicera saker och ting, brottas vissa företag med regulatoriska krav som innebär att de måste kunna förklara de faktorer som påverkar en modells förutsägelser. Sammantaget visar dessa utmaningar att traditionella maskininlärningsmodeller – i allmänhet mer tolkbara och förklarliga – sannolikt är bättre lämpade för affärsanvändning.

Rätt plats för LLM:er i företagens prediktiva verktygslåda

Så, ska vi bara lämna LLM till sina ordrelaterade uppgifter och glömma dem för prediktiva användningsfall? Det kan nu verka som att de trots allt inte kan hjälpa till med att förutsäga kundavgång eller kundlivstidsvärde.

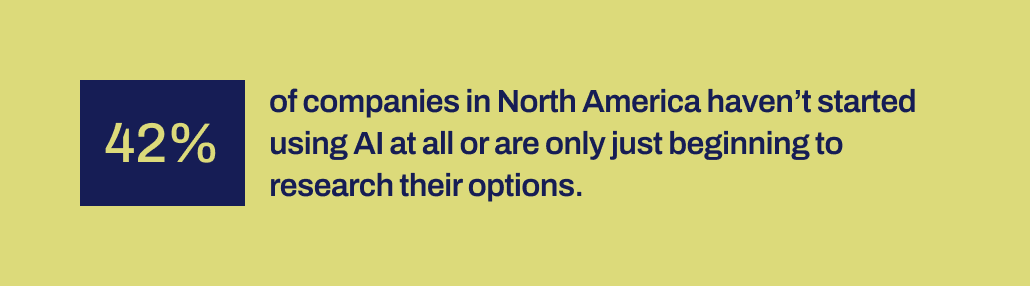

Här är grejen: Även om vi säger att "traditionella maskininlärningsmodeller" får dessa tekniker att låta allmänt förstådda och lätta att använda, vet vi från vår erfarenhet på Pecan att företag fortfarande till stor del kämpar för att ta till sig även dessa mer välbekanta former av AI.

Ny forskning från Workday visar att 42 % av företagen i Nordamerika antingen inte har börjat använda AI eller bara är i ett tidigt skede av att utforska sina alternativ. Och det har gått över ett decennium sedan verktyg för maskininlärning blev mer tillgängliga för företag. De har haft tid och olika verktyg finns tillgängliga.

Av någon anledning har framgångsrika AI-implementeringar varit förvånansvärt sällsynta trots det massiva surret kring datavetenskap och AI – och deras erkända potential för betydande affärseffekter. Någon viktig mekanism saknas för att överbrygga klyftan mellan löftena från AI och förmågan att implementera det produktivt.

Och det är just där vi tror att LLM:er nu kan spela en viktig överbryggande roll. LLM:er kan hjälpa företagsanvändare att korsa klyftan mellan att identifiera ett affärsproblem att lösa och att utveckla en prediktiv modell.

Med LLMs nu i bilden kan affärs- och datateam som inte har förmågan eller kapaciteten att handkoda maskininlärningsmodeller nu bättre översätta sina behov till modeller. De kan "använda sina ord", som föräldrar gillar att säga, för att kickstarta modelleringsprocessen.

Kombinera LLM med maskininlärningstekniker byggda för att utmärka sig på affärsdata

Den förmågan har nu kommit till Pecans Predictive GenAI, som smälter samman styrkorna hos LLM med vår redan mycket förfinade och automatiserade maskininlärningsplattform. Vår LLM-drivna Predictive Chat samlar in input från en företagsanvändare för att vägleda definitionen och utvecklingen av en prediktiv fråga – det specifika problem användaren vill lösa med en modell.

Sedan, med hjälp av GenAI, genererar vår plattform en Predictive Notebook för att göra nästa steg mot modellering ännu enklare. Återigen, med hjälp av LLM-möjligheter, innehåller notebook-datorn förifyllda SQL-frågor för att välja träningsdata för den prediktiva modellen. Pecans automatiserade dataförberedelse, funktionsteknik, modellbyggande och driftsättning kan utföra resten av processen på rekordtid, snabbare än någon annan lösning för prediktiv modellering.

Kort sagt, Pecans Predictive GenAI använder de oöverträffade språkkunskaperna hos LLMs för att göra vår klassens bästa prediktiva modelleringsplattform mycket mer tillgänglig och vänlig för företagsanvändare. Vi är glada över att se hur detta tillvägagångssätt kommer att hjälpa många fler företag att lyckas med AI.

Så, medan LLMs ensam inte är väl lämpade för att hantera alla dina prediktiva behov, kan de spela en kraftfull roll för att föra dina AI-projekt framåt. Genom att tolka ditt användningsfall och ge dig ett försprång med automatiskt genererad SQL-kod, leder Pecans Predictive GenAI vägen för att förena dessa teknologier. Du kan kolla in det nu med en gratis provperiod.

- SEO-drivet innehåll och PR-distribution. Bli förstärkt idag.

- PlatoData.Network Vertical Generative Ai. Styrka dig själv. Tillgång här.

- PlatoAiStream. Web3 Intelligence. Kunskap förstärkt. Tillgång här.

- Platoesg. Kol, CleanTech, Energi, Miljö, Sol, Avfallshantering. Tillgång här.

- PlatoHealth. Biotech och kliniska prövningar Intelligence. Tillgång här.

- Källa: https://www.kdnuggets.com/2024/01/pecan-llms-used-alone-cant-address-companys-predictive-needs?utm_source=rss&utm_medium=rss&utm_campaign=why-llms-used-alone-cant-address-your-companys-predictive-needs

- : har

- :är

- :inte

- :var

- 15%

- 17

- a

- förmåga

- Able

- Om oss

- tillgänglig

- medgav

- Dessutom

- adress

- anta

- Efter

- igen

- AI

- aka

- algoritmer

- rikta

- Alla

- tillåter

- ensam

- redan

- också

- fantastiska

- amerika

- an

- analytiker

- analysera

- och

- svara

- svar

- vilken som helst

- tillvägagångssätt

- ÄR

- runt

- anlände

- AS

- bistå

- At

- Automatiserad

- automatiserad maskininlärning

- automatiskt

- tillgänglig

- tillbaka

- baserat

- BE

- Bear

- blev

- varit

- Börjar

- bakom

- Där vi får lov att vara utan att konstant prestera,

- tro

- BÄST

- Bättre

- mellan

- miljarder

- Bit

- Bult

- Böcker

- båda

- brain

- BRO

- överbryggande

- bredare

- Byggnad

- byggt

- företag

- affärseffekter

- företag

- men

- by

- Ring

- kom

- KAN

- kapacitet

- kapacitet

- Kapacitet

- bära

- Vid

- fall

- vissa

- utmaningar

- klyfta

- chatt

- ChatGPT

- välja

- koda

- samla

- kommer

- Företag

- Företagets

- komplex

- Komplexiteten

- beräkningar

- beräkningar

- databehandling

- säker

- utgöra

- innehåller

- korrekt

- kostnadseffektiv

- kunde

- tillverkad

- skapa

- skapas

- Skapa

- kritisk

- Cross

- avgörande

- kund

- datum

- dataanalytiker

- Förberedelse av data

- datavetenskap

- datavetare

- datauppsättningar

- årtionde

- Beslutet

- djup

- djupt lärande

- djupare

- definition

- krav

- utplacering

- utformade

- Trots

- detaljerad

- detaljer

- utveckla

- utvecklade

- utvecklare

- utveckla

- Utveckling

- Skillnaden

- olika

- GRÄV

- do

- dokument

- inte

- donation

- inte

- utkast

- ritning

- Tidig

- lättare

- lätt

- Effektiv

- effektivitet

- effektiv

- ansträngning

- antingen

- encompassing

- Teknik

- miljömässigt

- Eter (ETH)

- Även

- NÅGONSIN

- exempel

- excel

- exciterade

- spännande

- befintliga

- erfarenhet

- Förklara

- Förklarbarhet

- utforska

- Utforska

- faktorer

- Misslyckande

- Höst

- bekant

- långt

- snabbare

- Leverans

- känslor

- färre

- Förnamn

- passa

- passar

- Flip

- För

- format

- former

- Lyckligtvis

- Framåt

- fundament

- Fri

- vänliga

- från

- ytterligare

- fixerings

- spalt

- genai

- allmänhet

- generera

- genereras

- genererar

- generativ

- Generativ AI

- present

- ges

- ger

- Ge

- Go

- Målet

- GPUs

- styra

- hade

- hammaren

- hantera

- Arbetsmiljö

- Hård

- Har

- hamn

- huvud

- tunga

- hjälpa

- hjälpte

- hjälpa

- hjälper

- höggradigt

- innehar

- hoppas

- Hur ser din drömresa ut

- Men

- HTTPS

- humant

- i

- idéer

- identifiera

- if

- bild

- Inverkan

- genomföra

- implementeringar

- med Esport

- viktigt

- in

- Inklusive

- påverka

- informationen

- inledande

- initieras

- ingång

- istället

- avser

- in

- involverade

- innebär

- involverar

- iOS

- IT

- DESS

- sig

- Jobb

- bara

- KDnuggets

- Vet

- känd

- språk

- Large

- storskalig

- till stor del

- senare

- ledande

- LÄRA SIG

- lärt

- inlärning

- Lämna

- Licensierade

- livstid

- tycka om

- sannolikt

- Begränsad

- Lot

- Maskinen

- maskininlärning

- Maskininlärningstekniker

- gjord

- göra

- GÖR

- många

- massiv

- Match

- matematisk

- betyda

- mekanism

- mentorer

- metoder

- kanske

- miljoner

- saknas

- blandning

- modell

- modellering

- modeller

- månader

- mer

- mer effektiv

- mest

- rörliga

- mycket

- måste

- my

- Natural

- Naturligt språk

- Naturlig språkbehandling

- Behöver

- behov

- nätverk

- neural

- neurala nätverk

- Nya

- Nästa

- Nord

- nordamerika

- anteckningsbok

- nu

- nyanser

- nummer

- erhållna

- of

- on

- ONE

- endast

- OpenAI

- optimering

- Optimera

- optimera

- Tillbehör

- or

- Övriga

- vår

- ut

- utfall

- över

- överskattas

- parametrar

- föräldrar

- del

- särskilt

- mönster

- utföra

- prestanda

- plocka

- Bild

- Banbrytande

- Plats

- plattform

- plato

- Platon Data Intelligence

- PlatonData

- Spela

- potentiell

- den mäktigaste

- exakt

- förutse

- förutsäga

- Förutsägelser

- prediktiva

- beredning

- primär

- förmodligen

- Problem

- process

- bearbetning

- projekt

- lovar

- proprietary

- beprövade

- ge

- allmän

- publicly

- sökfrågor

- fråga

- frågor

- område

- SÄLLSYNT

- logiska grunden

- Läsa

- Läsning

- Anledningen

- post

- raffinerade

- reflekterad

- regulatorer

- relaterad

- Förhållanden

- relativ

- UPPREPAT

- representerar

- begära

- Krav

- forskning

- Resurser

- Svara

- respons

- svar

- REST

- resultera

- resulterande

- avslöjar

- höger

- Roll

- rinnande

- s

- säga

- säger

- Vetenskap

- Forskare

- se

- verka

- välj

- väljer

- Sekvens

- in

- Kort

- skall

- show

- signifikans

- signifikant

- liknande

- helt enkelt

- eftersom

- färdigheter

- So

- lösning

- LÖSA

- några

- ljud

- ljud

- Källor

- specifik

- specifikt

- kalkylblad

- SQL

- stadier

- starta

- igång

- Steg

- Fortfarande

- styrkor

- struktur

- Kämpar

- studerade

- Studerar

- stil

- lyckas

- framgångsrik

- sådana

- säker

- hållbart

- T

- tackling

- Ta

- uppgift

- uppgifter

- lag

- tekniker

- Tekniken

- text

- än

- den där

- Smakämnen

- deras

- Dem

- Dessa

- de

- sak

- saker

- tror

- detta

- de

- tusentals

- spänna

- tid

- till

- tillsammans

- ton

- toolkit

- verktyg

- ämnen

- mot

- spåra

- traditionell

- tränad

- Utbildning

- transaktion

- Översätt

- Träd

- prova

- SVÄNG

- vridning

- Typ

- paraply

- under

- förstå

- förståelse

- förstått

- enande

- okänd

- enastående

- us

- användning

- användningsfall

- Begagnade

- Användare

- användare

- användningar

- med hjälp av

- värde

- mängd

- olika

- Omfattande

- synlighet

- avgörande

- vs

- vill

- Sätt..

- sätt

- we

- webbsidor

- veckor

- VÄL

- były

- Vad

- Vad är

- när

- som

- medan

- varför

- brett

- kommer

- med

- inom

- ord

- ord

- Arbete

- arbetade

- värt

- skulle

- ännu

- dig

- Din

- zephyrnet