Bland de viktigaste senaste innovationerna för att förbättra värdet och tillförlitligheten hos stora språkmodeller är Chain-of-Thought och dess derivat inklusive Tanketräd och Graf-of-Thought.

Dessa strukturer är också extremt värdefulla för att designa effektivt Människor + AI-arbetsflöden för bättre tänkande.

I den här artikeln ska jag ge en överblick över Chain-of-Thought och sedan titta på applikationer för AI-förstärkt mänsklig intelligens.

Chain-of-Thought

Stora språkmodeller (LLM) är i allmänhet utmärkta på textgenerering, men dåliga på alla uppgifter som involverar sekventiellt resonemang.

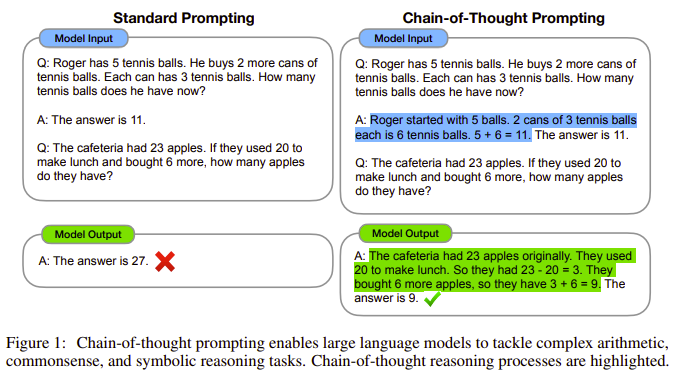

Landmärket för januari 2022 Tankekedja framkallar resonemang i stora språkmodeller redogjorde för hur en tankekedja - "en serie mellanliggande resonemangssteg" - avsevärt skulle kunna förbättra LLM-prestanda vid resonemangsuppgifter inklusive matematik och sunt förnuftspussel.

Du har förmodligen sett den här bilden från pappret gör rundorna.

Detta koncept anpassades snabbt till andra applikationer inklusive tidsmässiga resonemang, visuella språkmodeller, hämtning utökat resonemang, och många andra sätt att förbättra prestanda för AI-modeller.

Chain-of-thought har visat sig vara särskilt värdefullt i praktiska problemlösningstillämpningar. Uppenbara exempel inkluderar läkemedel, lagoch utbildning.

Googles PaLM och Med-PaLM innehåller kedja av tankestrukturer och OpenAI:s GPT-4 gör det mycket troligt, vilket innebär att när du använder en LLM är dessa metoder redan inbyggda.

Trots det, berömda uppmaningen "Låt oss reda ut detta steg för steg för att vara säkra på att vi har rätt svar" eller varianter av detta ge den bästa LLM-prestandan för många slags uppgifter.

Evolution av Chain-of-Thought

Ett antal innovationer har vuxit fram genom att bygga på Chain-of-Thought.

Effektiva resonemangsprocesser följer inte nödvändigtvis en enda bana. Det här leder till Tanketräd strukturer, beskrivna i Tankarnas träd: Avsiktlig problemlösning med stora språkmodeller.

Som visas i det här diagrammet från artikeln, kan Chain-of-Thought gå vidare till att först välja den vanligaste vägen från flera utgångar och sedan välja från den bästa av flera vägar genom tankeprocessen.

Den senaste utvecklingen på Chain-of-Thought inkluderar det mycket lovande Graf-of-Thought såväl som Hypergraph-of-Thought.

Nya "tänkande"-strukturer kommer att vara centrala för generativa AI-framsteg

Chain-of-Thought och relaterade tekniker skapades för att ta itu med begränsningarna hos LLM och förbättra deras kapacitet.

Den fortsatta utvecklingen av generativa AI-modeller kommer att förlita sig mycket mer på dessa typer av strukturerade tänkande tekniker än beräkningskapacitet eller modellstorlek. Dessa tillvägagångssätt har redan möjliggjorts små, effektiva LLM:er för att uppnå prestanda som kan närma sig de största modellerna.

Chain-of-Thought och liknande modeller leder också direkt till multiagentkedjor, där kedjor eller tankenätverk läggs ut över flera uppgiftsoptimerade modeller för att skapa mycket överlägsna resonemang och resultat än vad som kan uppnås inom en enda modell.

Förstärkt intelligens är viktigare än artificiell allmän intelligens

"Teknik bör inte syfta till att ersätta människor, snarare förstärka mänskliga förmågor." — Doug Engelbart

Drivkraften bakom nästan all AI-utveckling verkar vara att skapa maskiner som kan efterlikna och potentiellt överträffa mänsklig intelligens och kapacitet.

Det är en förståelig ambition.

Men jag är mycket, mycket mer intresserad av hur AI kan öka mänsklig intelligens.

Vi kan arbeta på båda domänerna samtidigt.

Men i alla möjliga scenarier för framsteg mot artificiell allmän intelligens kommer vi att ha det bättre om vi har lagt minst lika mycket energi på bygga, lära och tillämpa Human + AI-tänkande strukturer.

Humans + AI Thinking Workflows

Begreppet Människor + AI är hjärtat i mitt arbete.

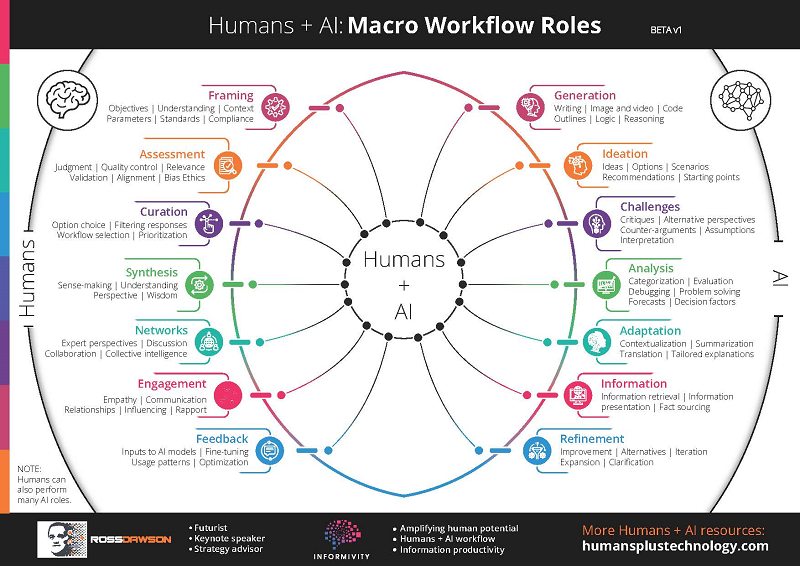

Ramverket nedan som jag skapade för ett år sedan visar min tidiga inramning av "Människor + AI-arbetsflöden", där människor och AI sekventiellt tar sig an de uppgifter som de är bäst lämpade för.

Om det är väldesignat genererar detta oundvikligen resultat som är överlägsna vad var och en kunde ensam.

Sedan dess har jag grävt mycket mer i detalj i vad som specifikt är de bästa tankestrukturerna för Humans + AI.

Dessa kommer att ligga till grund för nästa fas av förstärkt mänsklig intelligens.

Chain-of-Thought för AI-förbättrat mänskligt tänkande

Koncepten som flödar från Chain-of-Thought har utvecklats för att förbättra LLMs fristående kapacitet.

Men de visar sig också vara oerhört värdefulla för att maximera värdet av att människor och AI arbetar tillsammans.

Det finns en rad tekniker för att tillämpa Chain-of-Thought-strukturer på människor + AI-tänkande arbetsflöden.

AI-koncept tillämpas på utökad intelligens

LLM:er kan användas för att föreslå hur uppgifter kan delas upp i sekventiella (eller nätverksbaserade) element, med antingen människor eller AI som identifierar var mänskliga eller AI-förmågor kan vara bäst lämpade.

Ett specifikt tillvägagångssätt beskrivs i Människan-i-slingan genom Chain-of-Thought, där "manuell korrigering av underlogik i logik kan förbättra LLM:s resonemangsprestanda."

Att ”rama in” målen, uppgiften och strukturen, som visas i arbetsflödesdiagrammet Humans + AI, driver kvaliteten på resultaten. Detta övervakas vanligtvis bäst av människor, med hjälp av flöden som AI som föreslår eller bedömer parametrar.

Jag införlivar dessa och andra tillvägagångssätt i en uppsättning "AI-Enhanced Thinking Patterns".

Mer generellt kan en mängd olika AI-framsteg, inte bara Chain-of-Thought, användas extremt användbart för att öka mänsklig intelligens.

Jag tänker skriva en liknande artikel om att tillämpa begreppen Generativa Adversarial Networks till Human-AI symbiotisk intelligens strukturer.

Kurs om AI-förbättrat tänkande och beslutsfattande

Mitt fullständiga fokus 2024 är hur AI kan förstärka människor.

En av mina centrala aktiviteter är att köra en vanlig kohortkurs på Maven: AI-förbättrat tänkande och beslutsfattande. Kolla in länken för mer information.

Nästa årskull startar 8 februari. Som tack för att du läste igenom till slutet av denna artikel kan du få 30% rabatt genom att använda kupongen: COTARTICLE 🙂.

- SEO-drivet innehåll och PR-distribution. Bli förstärkt idag.

- PlatoData.Network Vertical Generative Ai. Styrka dig själv. Tillgång här.

- PlatoAiStream. Web3 Intelligence. Kunskap förstärkt. Tillgång här.

- Platoesg. Kol, CleanTech, Energi, Miljö, Sol, Avfallshantering. Tillgång här.

- PlatoHealth. Biotech och kliniska prövningar Intelligence. Tillgång här.

- Källa: https://rossdawson.com/applying-chain-of-thought-to-ai-enhanced-human-thinking/

- : har

- :är

- :inte

- :var

- 2022

- 2024

- 8

- a

- Om oss

- Uppnå

- uppnås

- tvärs

- aktiviteter

- anpassat

- adress

- avancera

- framsteg

- kontradiktoriskt

- sedan

- AI

- AI-modeller

- Syftet

- Alla

- nästan

- ensam

- redan

- också

- am

- ambition

- förstärka

- an

- och

- vilken som helst

- tillämpningar

- tillämpas

- Tillämpa

- tillvägagångssätt

- tillvägagångssätt

- ÄR

- Artikeln

- konstgjord

- konstgjord allmän intelligens

- AS

- bedöma

- At

- förstärka

- augmented

- BE

- varit

- bakom

- nedan

- BÄST

- Bättre

- båda

- Byggnad

- byggt

- men

- by

- KAN

- Kan få

- kapacitet

- Kapacitet

- centrala

- kedja

- kedjor

- ta

- Kohort

- fullborda

- Compute

- begrepp

- Begreppen

- fortsatte

- kunde

- kupong

- Naturligtvis

- skapa

- skapas

- Derivat

- beskriven

- design

- detalj

- detaljer

- utvecklade

- Utveckling

- utvecklingen

- direkt

- Rabatt

- do

- gör

- gör

- domäner

- Doug

- enheter

- drivande

- varje

- Tidig

- Effektiv

- effektiv

- antingen

- element

- dykt

- aktiverad

- änden

- energi

- förbättra

- lika

- Eter (ETH)

- Varje

- exempel

- överstiga

- utmärkt

- extremt

- ökänt

- långt

- Februari

- Förnamn

- Strömmande

- flöden

- Fokus

- följer

- För

- kraft

- Stiftelser

- Ramverk

- frekvent

- från

- Allmänt

- allmän intelligens

- allmänhet

- genererar

- generering

- generativ

- Generativ AI

- skaffa sig

- Har

- Hjärta

- högnivå

- Hur ser din drömresa ut

- HTTPS

- humant

- mänsklig intelligens

- Människa

- i

- SJUK

- identifiera

- if

- bild

- oerhört

- med Esport

- förbättra

- förbättra

- in

- innefattar

- Inklusive

- införliva

- införlivande

- oundvikligen

- innovationer

- Intelligens

- avser

- intresserad

- Mellanliggande

- in

- engagera

- DESS

- Januari

- bara

- Labs

- landmärke

- språk

- Large

- största

- leda

- Leads

- inlärning

- t minst

- sannolikt

- begränsningar

- LINK

- se

- Maskiner

- många

- Maven

- max-bredd

- maximera

- Maj..

- betyder

- modell

- modeller

- mer

- mest

- multipel

- my

- nödvändigtvis

- nätverk

- NeurIPS

- Nästa

- antal

- mål

- Uppenbara

- of

- sänkt

- on

- gång

- or

- Övriga

- ut

- utfall

- utgångar

- palm

- Papper

- parametrar

- särskilt

- bana

- banor

- Personer

- prestanda

- fas

- plato

- Platon Data Intelligence

- PlatonData

- dålig

- möjlig

- potentiellt

- Praktisk

- Problem

- problemlösning

- process

- processer

- Framsteg

- lovande

- föreslår

- Bevisa

- visat

- ge

- sätta

- pussel

- kvalitet

- snabbt

- område

- snarare

- Läsning

- senaste

- regelbunden

- relaterad

- tillförlitlighet

- förlita

- ersätta

- höger

- omgångar

- rinnande

- scenario

- verkar

- sett

- väljer

- Serier

- in

- skall

- visas

- Visar

- liknande

- enda

- Storlek

- So

- Lösa

- specifik

- specifikt

- startar

- Steg

- struktur

- strukturerade

- strukturer

- väsentligen

- sådana

- föreslå

- överlägsen

- säker

- Symbiotisk

- uppgift

- uppgifter

- tekniker

- text

- textgenerering

- än

- tack

- den där

- Smakämnen

- deras

- sedan

- Dessa

- de

- Tänkande

- detta

- trodde

- Genom

- till

- tillsammans

- mot

- bana

- förståeligt

- användning

- Begagnade

- med hjälp av

- vanligen

- Värdefulla

- värde

- variationer

- mängd

- mycket

- utsikt

- var

- Sätt..

- sätt

- we

- VÄL

- były

- Vad

- när

- som

- bred

- kommer

- med

- inom

- Arbete

- arbetsflöde

- arbetsflöden

- arbetssätt

- skriva

- år

- dig

- zephyrnet