Vad är multimodal AI? Det är en fråga vi ofta hör nu för tiden, eller hur? Oavsett om det är under lunchraster, i chattgrupper på kontoret eller när du chattar med vänner på kvällen, verkar det som att alla är fulla av tal om GPT-4.

Den senaste versionen av GPT-4 har väckt en uppsjö av spänning och spekulationer inom AI-gemenskapen och utanför. Som det senaste tillskottet till OpenAIs imponerande linje av AI-språkmodeller, har GPT-4 en rad avancerade funktioner, särskilt inom multimodal AI.

Med förmågan att bearbeta och integrera indata från flera modaliteter, såsom text, bilder och ljud, representerar GPT-4 ett betydande genombrott inom området AI och har genererat stort intresse och uppmärksamhet från både forskare, utvecklare och entusiaster.

Sedan GPT-4 släpptes har alla diskuterat de möjligheter som multimodal AI erbjuder. Låt oss kasta lite ljus över detta ämne genom att gå tillbaka till 6 månader tidigare först.

6 månader tidigare: Diskuterar multimodal AI

I en poddintervju med titeln "AI för nästa era,” OpenAI:s vd Sam Altman delade med sig av sina insikter om de kommande framstegen inom AI-teknik. En av samtalets höjdpunkter var Altmans avslöjande att en multimodal modell är i horisonten.

Termen "multimodal" hänvisar till en AI:s förmåga att fungera i flera lägen, inklusive text, bilder och ljud.

OpenAI:s interaktioner med människor var begränsade till textinmatning, vare sig det var genom Dall-E eller ChatGPT. En multimodal AI skulle dock kunna interagera genom tal, vilket gör det möjligt för den att lyssna på kommandon, ge information och till och med utföra uppgifter. Med lanseringen av GPT-4 kan detta förändras för gott.

Jag tror att vi kommer att få multimodala modeller om inte så mycket längre, och det kommer att öppna upp för nya saker. Jag tycker att folk gör ett fantastiskt arbete med agenter som kan använda datorer för att göra saker åt dig, använda program och idén om ett språkgränssnitt där du säger ett naturligt språk – vad du vill ha i den här typen av dialog fram och tillbaka. Du kan iterera och förfina det, och datorn gör det bara åt dig. Du ser en del av detta med DALL-E och CoPilot på mycket tidiga sätt.

-Altman

Även om Altman inte uttryckligen bekräftade att GPT-4 skulle vara multimodal under den tiden, föreslog han att sådan teknik är på gång och kommer att anlända inom en snar framtid. En spännande aspekt av hans vision för multimodal AI är dess potential att skapa nya affärsmodeller som för närvarande inte är genomförbara.

Altman drog en parallell till den mobila plattformen, som skapade otaliga möjligheter för nya satsningar och jobb. På samma sätt skulle en multimodal AI-plattform kunna låsa upp en mängd innovativa möjligheter och förändra vårt sätt att leva och arbeta. Det är ett spännande perspektiv som understryker AI:s transformativa kraft och dess förmåga att omforma vår värld på sätt vi bara kan föreställa oss.

…Jag tror att det här kommer att bli en enorm trend, och mycket stora företag kommer att byggas med detta som gränssnitt, och mer generellt [tror jag] att dessa mycket kraftfulla modeller kommer att vara en av de genuina nya tekniska plattformarna som vi har inte riktigt haft sedan mobilen. Och det kommer alltid en explosion av nya företag direkt efter, så det kommer att bli coolt. Jag tror att vi kommer att få verkliga multimodala modeller att fungera. Och så inte bara text och bilder utan varje modalitet du har i en modell kan enkelt flyttas mellan saker.

-Altman

En verkligt självlärande AI

Ett område som får jämförelsevis lite uppmärksamhet inom området för AI-forskning är strävan efter att skapa en självlärande AI. Medan nuvarande modeller är kapabla till spontan förståelse, eller "uppkomst", där nya förmågor uppstår från ökad träningsdata, skulle en verkligt självlärande AI representera ett stort steg framåt.

OpenAIs Altman talade om en AI som kan lära sig och uppgradera sina förmågor på egen hand, snarare än att vara beroende av storleken på dess träningsdata. Denna typ av AI skulle överskrida det traditionella programvaruversionsparadigmet, där företag släpper inkrementella uppdateringar, istället växer och förbättras autonomt.

Även om Altman inte föreslog att GPT-4 kommer att ha den här kapaciteten, föreslog han att det är något som OpenAI arbetar mot och är helt inom möjligheterna. Idén med en självlärande AI är en spännande idé som kan få långtgående konsekvenser för framtiden för AI och vår värld.

Visual ChatGPT ger AI-bildgenerering till den populära chatboten

Tillbaka till nuet: GPT-4 släpps

Den mycket efterlängtade versionen av GPT-4 är nu tillgänglig för vissa Plus-prenumeranter, med en ny multimodal språkmodell som accepterar text, tal, bilder och video som indata och ger textbaserade svar.

OpenAI har utpekat GPT-4 som en betydande milstolpe i sina ansträngningar att skala upp djupinlärning, och noterar att även om det kanske inte överträffar människor i många verkliga scenarier, levererar det prestanda på mänsklig nivå på olika professionella och akademiska riktmärken.

Populariteten för ChatGPT, som använder GPT-3 AI-teknik för att generera mänskliga svar på sökfrågor baserade på data som samlats in från internet, har ökat sedan debuten den 30 november.

Lanseringen av ChatGPT, en chatbot för konversation, har utlöst en AI-kapprustning mellan Microsoft och Google, som båda syftar till att integrera innehållsskapande generativ AI-teknik i deras internetsökning och kontorsproduktivitetsprodukter. Utgivningen av GPT-4 och den pågående konkurrensen mellan teknikjättar belyser den växande betydelsen av AI och dess potential att förändra hur vi interagerar med teknik.

För att bättre förstå ämnet, inbjuder vi dig att fördjupa dig i en djupare och mer teknisk diskussion om multimodal AI.

Vad är multimodal AI?

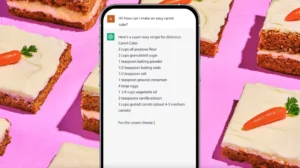

Multimodal AI är en typ av artificiell intelligens som har förmågan att bearbeta och förstå indata från olika lägen eller modaliteter, inklusive text, tal, bilder och videor. Det betyder att den kan känna igen och tolka olika former av data, inte bara en typ, vilket gör den mer mångsidig och anpassningsbar till olika situationer. I huvudsak kan multimodal AI "se", "höra" och "förstå" som en människa, vilket gör att den kan interagera med världen på ett mer naturligt och intuitivt sätt.

Tillämpningar av multimodal AI

Möjligheterna hos multimodal AI är enorma och omfattande. Här är några exempel på vad multimodal AI kan göra:

- Taligenkänning: Multimodal AI kan förstå och transkribera talat språk, vilket gör att det kan interagera med användare genom röstkommandon och naturlig språkbehandling.

- Bild- och videoigenkänning: Multimodal AI kan analysera och tolka visuell data, såsom bilder och videor, för att identifiera objekt, människor och aktiviteter.

- Textanalys: Multimodal AI kan bearbeta och förstå skriven text, inklusive naturlig språkbehandling, sentimentanalys och språköversättning.

- Multimodal integration: Multimodal AI kan kombinera indata från olika modaliteter för att bilda en mer fullständig förståelse av en situation. Till exempel kan den använda både visuella och ljudsignaler för att känna igen en persons känslor.

Hur fungerar multimodal AI?

Multimodala neurala nätverk är vanligtvis sammansatta av flera unimodala neurala nätverk, där en audiovisuell modell är ett exempel på två sådana nätverk – ett för visuell data och ett för ljuddata. Dessa individuella nätverk bearbetar sina respektive indata separat, i en process som kallas kodning.

När unimodal kodning är klar måste den extraherade informationen från varje modell kombineras. Olika fusionstekniker har föreslagits för detta ändamål, allt från grundläggande sammanlänkning till användning av uppmärksamhetsmekanismer. Multimodal datafusion är en kritisk faktor för att nå framgång i dessa modeller.

Efter fusion involverar det sista steget ett "besluts"-nätverk som accepterar den kodade och sammansmälta informationen och tränas på den specifika uppgiften.

I huvudsak består multimodala arkitekturer av tre väsentliga komponenter – unimodala kodare för varje ingångsmodalitet, ett fusionsnätverk som kombinerar funktionerna hos de olika modaliteterna och en klassificerare som gör förutsägelser baserat på sammansmälta data.

Jämförelse med nuvarande AI-modeller

Jämfört med traditionella AI-modeller som bara kan hantera en typ av data åt gången, har multimodal AI flera fördelar, inklusive:

- Mångsidighet: Multimodal AI kan hantera flera typer av data, vilket gör den mer anpassningsbar till olika situationer och användningsfall.

- Naturlig interaktion: Genom att integrera flera modaliteter kan multimodal AI interagera med användare på ett mer naturligt och intuitivt sätt, liknande hur människor kommunicerar.

- Förbättrad noggrannhet: Genom att kombinera indata från olika modaliteter kan multimodal AI förbättra noggrannheten i dess förutsägelser och klassificeringar.

Här är en sammanfattningstabell som jämför olika AI-modeller:

| AI-modell | Data typ | Applikationer |

| Textbaserad AI | text | Naturlig språkbehandling, chatbots, sentimentanalys |

| Bildbaserad AI | Bilder | Objektdetektion, bildklassificering, ansiktsigenkänning |

| Talbaserad AI | Audio | Röstassistenter, taligenkänning, transkription |

| Multimodal AI | Text, bilder, ljud, video | Naturlig interaktion, kontextuell förståelse, förbättrad noggrannhet |

Varför är multimodal AI viktigt?

Multimodal AI är viktigt eftersom det har potential att förändra hur vi interagerar med teknik och maskiner. Genom att möjliggöra mer naturliga och intuitiva interaktioner genom flera modaliteter kan multimodal AI skapa mer sömlösa och personliga användarupplevelser. Detta kan vara särskilt fördelaktigt inom områden som:

- Sjukvård: Multimodal AI kan hjälpa läkare och patienter att kommunicera mer effektivt, särskilt för dem som har begränsad rörlighet eller inte talar ett språk som modersmål.

- Utbildning: Multimodal AI kan förbättra inlärningsresultaten genom att tillhandahålla mer personlig och interaktiv undervisning som anpassar sig till en elevs individuella behov och inlärningsstil.

- Underhållning: Multimodal AI kan skapa mer uppslukande och engagerande upplevelser i videospel, filmer och andra former av media.

Fördelar med multimodal AI

Här är några av de viktigaste fördelarna med multimodal AI:

- Kontextuell förståelse: Genom att kombinera indata från flera modaliteter kan multimodal AI få en mer fullständig förståelse av en situation, inklusive sammanhanget och innebörden bakom data.

- Naturlig interaktion: Genom att möjliggöra mer naturliga och intuitiva interaktioner genom flera modaliteter kan multimodal AI skapa mer sömlösa och personliga användarupplevelser.

- Förbättrad noggrannhet: Genom att integrera flera datakällor kan multimodal AI förbättra noggrannheten i dess förutsägelser och klassificeringar.

Skapa en artificiell intelligens 101

Möjlighet att skapa nya affärsmodeller

Multimodal AI har också potential att skapa nya affärsmodeller och intäktsströmmar. Här är några exempel:

- Röstassistenter: Multimodal AI kan möjliggöra mer sofistikerade och personliga röstassistenter som kan interagera med användare genom tal, text och visuella skärmar.

- Smarta hem: Multimodal AI kan skapa mer intelligenta och lyhörda hem som kan förstå och anpassa sig till en användares preferenser och beteenden.

- Virtuella shoppingassistenter: Multimodal AI kan hjälpa kunder att navigera och anpassa sin shoppingupplevelse genom röst- och visuella interaktioner.

Framtiden för AI-teknik

Framtiden för AI-teknik är spännande, med forskare som utforskar nya sätt att skapa mer avancerade och sofistikerade AI-modeller. Här är några viktiga fokusområden:

- Självlärande AI: AI-forskare strävar efter att skapa AI som kan lära sig och förbättras på egen hand, utan behov av mänsklig inblandning. Detta kan leda till mer anpassningsbara och motståndskraftiga AI-modeller som kan hantera ett brett spektrum av uppgifter och situationer.

- Multimodal AI: Som diskuterats tidigare har multimodal AI potential att förändra hur vi interagerar med teknik och maskiner. AI-experter arbetar med att skapa mer sofistikerade och mångsidiga multimodala AI-modeller som kan förstå och bearbeta input från flera modaliteter.

- Etik och styrning: När AI blir kraftfullare och mer allmänt förekommande är det viktigt att se till att det används etiskt och ansvarsfullt. AI-forskare undersöker sätt att skapa mer transparenta och ansvarsfulla AI-system som är anpassade till mänskliga värderingar och prioriteringar.

Hur AI-forskare siktar på att skapa AI som kan lära sig själv?

AI-forskare undersöker flera sätt att skapa AI som kan lära sig av sig själv. Ett lovande forskningsområde kallas förstärkt lärande, vilket innebär att lära ut en AI-modell för att fatta beslut och vidta åtgärder baserat på feedback från omgivningen. Ett annat tillvägagångssätt kallas oövervakat lärande, vilket innebär att träna en AI-modell på ostrukturerad data och låta den hitta mönster och samband på egen hand. Genom att kombinera dessa och andra tillvägagångssätt hoppas AI-forskare skapa mer avancerade och autonoma AI-modeller som kan förbättras och anpassas över tiden.

Allt om autonom intelligens: En omfattande översikt

Potential för förbättrade AI-modeller

Förbättrade AI-modeller har potential att förändra hur vi lever och arbetar. Här är några potentiella fördelar med förbättrade AI-modeller:

- Förbättrad noggrannhet: När AI-modeller blir mer sofistikerade och avancerade kan de förbättra sin noggrannhet och minska fel inom områden som medicinsk diagnos, ekonomisk prognos och riskbedömning.

- Mer personliga upplevelser: Avancerade AI-modeller kan anpassa användarupplevelser genom att förstå individuella preferenser och beteenden. En musikströmningstjänst kan till exempel rekommendera låtar baserat på en användares lyssningshistorik och humör.

- Automatisering av tråkiga uppgifter: AI kan automatisera tråkiga och repetitiva uppgifter, vilket frigör tid för människor att fokusera på mer kreativa uppgifter på hög nivå.

GPT-4 och multimodal AI

Efter mycket förväntan och spekulationer, OpenAI har äntligen avslöjat det senaste tillskottet till sin imponerande linje av AI-språkmodeller. Systemet, kallat GPT-4, lovar att leverera banbrytande framsteg inom multimodal AI, om än med ett mer begränsat utbud av inmatningsmodaliteter än vissa hade förutspått.

Tillkännage GPT-4, en stor multimodal modell, med våra bästa resultat någonsin när det gäller kapacitet och anpassning: https://t.co/TwLFssyALF pic.twitter.com/lYWwPjZbSg

- OpenAI (@OpenAI) Mars 14, 2023

Enligt OpenAI kan modellen bearbeta både textuella och visuella input, vilket ger textbaserade utdata som visar en sofistikerad nivå av förståelse. Med sin förmåga att samtidigt tolka och integrera flera inmatningslägen, markerar GPT-4 en betydande milstolpe i utvecklingen av AI-språkmodeller som har byggt upp fart i flera år innan de har fångat den vanliga uppmärksamheten under de senaste månaderna.

OpenAI:s banbrytande GPT-modeller har fångat AI-gemenskapens fantasi sedan publiceringen av den ursprungliga forskningsartikeln 2018. Efter tillkännagivandet av GPT-2 2019 och GPT-3 2020 har dessa modeller tränats på stora datauppsättningar av text, i första hand hämtat från internet, som sedan analyseras för statistiska mönster. Detta enkla men mycket effektiva tillvägagångssätt gör det möjligt för modellerna att generera och sammanfatta skrivning, samt utföra en rad textbaserade uppgifter som översättning och kodgenerering.

Trots oro över potentiellt missbruk av GPT-modeller, lanserade OpenAI äntligen sin ChatGPT-chatbot baserad på GPT-3.5 i slutet av 2022, vilket gjorde tekniken tillgänglig för en bredare publik. Detta steg utlöste en våg av spänning och förväntan i teknikbranschen, med andra stora aktörer som Microsoft och Google som snabbt följde efter med sina egna AI-chatbotar, inklusive Bing som en del av Bings sökmotor. Lanseringen av dessa chatbots visar den växande betydelsen av GPT-modeller för att forma framtiden för AI, och deras potential att förändra hur vi kommunicerar och interagerar med teknik.

Som väntat har den ökande tillgängligheten för AI-språkmodeller inneburit en rad problem och utmaningar för olika sektorer. Till exempel har utbildningssystemet kämpat för att hantera uppkomsten av programvara som kan generera högkvalitativa högskoleuppsatser. Likaså har onlineplattformar som Stack Overflow och Clarkesworld tvingats stoppa inlämningar på grund av ett överväldigande inflöde av AI-genererat innehåll. Även tidiga tillämpningar av AI-skrivverktyg inom journalistik har stött på svårigheter.

Trots dessa utmaningar hävdar vissa experter att de negativa effekterna har varit något mindre allvarliga än vad som ursprungligen förutsågs. Som med all ny teknik har införandet av AI-språkmodeller krävt noggrant övervägande och anpassning för att säkerställa att fördelarna med tekniken maximeras samtidigt som eventuella negativa effekter minimeras.

Enligt OpenAI hade GPT-4 genomgått sex månaders säkerhetsutbildning och att det i interna tester var "82 procent mindre sannolikt att svara på förfrågningar om otillåtet innehåll och 40 procent mer sannolikt att producera faktasvar än GPT-3.5. ”

Bottom line

Cirkel tillbaka till vårt första ämne: Vad är multimodal AI? För bara sex månader sedan var konceptet med multimodal AI fortfarande till stor del begränsad till teoretisk spekulation och forskning. Men med den senaste versionen av GPT-4 ser vi nu en stor förändring i utvecklingen och adoptionen av denna teknik. Förmågan hos GPT-4, särskilt i dess förmåga att bearbeta och integrera indata från flera modaliteter, har öppnat upp en helt ny värld av möjligheter och möjligheter för området AI och bortom.

Vi kommer att se en snabb expansion av multimodala AI-applikationer inom ett brett spektrum av industrier och sektorer. Från sjukvård och utbildning till underhållning och spel, förmågan hos AI-modeller att förstå och svara på input från flera modaliteter förändrar hur vi interagerar med teknik och maskiner. Denna teknik gör det möjligt för oss att kommunicera och samarbeta med maskiner på ett mer naturligt och intuitivt sätt, med betydande konsekvenser för framtiden för arbete och produktivitet.

- SEO-drivet innehåll och PR-distribution. Bli förstärkt idag.

- Platoblockchain. Web3 Metaverse Intelligence. Kunskap förstärkt. Tillgång här.

- Källa: https://dataconomy.com/2023/03/what-is-multimodal-ai-gpt-4/

- :är

- $UPP

- 1

- 10

- 11

- 2018

- 2019

- 2020

- 2022

- 7

- 9

- a

- förmågor

- förmåga

- Able

- Om oss

- akademiska

- accepterar

- tillgänglighet

- tillgänglig

- noggrannhet

- uppnå

- tvärs

- åtgärder

- aktiviteter

- anpassa

- anpassning

- anpassar sig

- Dessutom

- Antagande

- avancerat

- framsteg

- fördelar

- ogynnsam

- Efter

- medel

- AI

- AI-plattform

- ai forskning

- AI-system

- Justerat

- tillåta

- alltid

- fantastiska

- bland

- analys

- analysera

- och

- Tillkännagivande

- Annan

- svar

- förväntan

- tillämpningar

- tillvägagångssätt

- tillvägagångssätt

- ÄR

- OMRÅDE

- områden

- konstgjord

- artificiell intelligens

- AS

- aspekt

- bedömning

- At

- uppmärksamhet

- publik

- audio

- automatisera

- autonom

- autonomt

- tillgänglig

- tillbaka

- baserat

- grundläggande

- BE

- därför att

- blir

- blir

- innan

- bakom

- Där vi får lov att vara utan att konstant prestera,

- riktmärken

- fördelaktigt

- Fördelarna

- Bättre

- mellan

- Bortom

- bing

- ståtar

- raster

- genombrott

- Bringar

- Byggnad

- byggt

- företag

- företag

- by

- kallas

- KAN

- kapacitet

- kapabel

- Kapacitet

- Fångande

- noggrann

- fall

- VD

- utmaningar

- byta

- chatbot

- chatbots

- ChatGPT

- chattar

- klassificering

- koda

- samarbeta

- College

- kombinera

- kombinerad

- kombinerar

- kombinera

- kommunicera

- samfundet

- Företag

- jämförelsevis

- jämförande

- konkurrens

- fullborda

- Avslutade

- komponenter

- sammansatt

- omfattande

- dator

- datorer

- begrepp

- oro

- Bekräfta

- betydande

- övervägande

- innehåll

- sammanhang

- kontextuella

- Konversation

- konversera

- kyla

- kunde

- skapa

- skapas

- Skapa

- Kreativ

- kritisk

- Aktuella

- För närvarande

- Kunder

- dalls

- datum

- datauppsättningar

- Dagar

- beslut

- djup

- djupt lärande

- djupare

- leverera

- levererar

- demonstrera

- demonstrerar

- beroende

- Detektering

- utvecklare

- Utveckling

- dialog

- DID

- olika

- svårigheter

- diskuteras

- diskutera

- diskussion

- displayer

- Läkare

- gör

- dubbade

- under

- varje

- Tidigare

- Tidig

- lätt

- Utbildning

- Effektiv

- effektivt

- effekter

- ansträngningar

- uppkomst

- känslor

- möjliggöra

- möjliggör

- möjliggör

- engagerande

- Motor

- säkerställa

- Underhållning

- entusiaster

- helt

- Miljö

- fel

- speciellt

- huvudsak

- väsentlig

- Även

- kväll

- Varje

- alla

- Utvecklingen

- exempel

- exempel

- Spänning

- spännande

- expansionen

- förväntat

- erfarenhet

- Erfarenheter

- experter

- Utforska

- ansikts

- Saklig

- långtgående

- möjlig

- Funktioner

- Med

- återkoppling

- fält

- slutlig

- Slutligen

- finansiella

- hitta

- Förnamn

- Fokus

- efter

- För

- formen

- former

- Framåt

- vänner

- från

- fungera

- sammansmältning

- framtida

- Framtiden för AI

- Framtid för arbetet

- Få

- Games

- Gaming

- allmänhet

- generera

- genereras

- generera

- generering

- generativ

- Generativ AI

- skaffa sig

- kommer

- god

- styrning

- banbrytande

- Gruppens

- Odling

- hantera

- Har

- hälso-och sjukvård

- höra

- hjälpa

- här.

- högnivå

- hög kvalitet

- höjdpunkter

- höggradigt

- historia

- Bostäder

- hoppas

- horisonten

- värd

- Hur ser din drömresa ut

- Men

- HTTPS

- humant

- Människa

- i

- Tanken

- identifiera

- bild

- Bildklassificering

- bildgenerering

- bilder

- fantasi

- uppslukande

- Konsekvenser

- implikationer

- vikt

- med Esport

- imponerande

- förbättra

- förbättras

- förbättra

- in

- Inklusive

- ökat

- ökande

- individuellt

- industrier

- industrin

- tillströmning

- informationen

- inledande

- initialt

- innovativa

- ingång

- insikter

- istället

- integrera

- Integrera

- integrering

- Intelligens

- Intelligent

- interagera

- interagera

- interaktion

- interaktioner

- interaktiva

- intresse

- Gränssnitt

- inre

- Internet

- ingripande

- Intervju

- Beskrivning

- intuitiv

- bjuda in

- IT

- DESS

- sig

- Lediga jobb

- journalistik

- jpg

- bara en

- Nyckel

- Nyckelområden

- Snäll

- känd

- språk

- Large

- till stor del

- Sent

- senaste

- lansera

- lanserades

- leda

- Språng

- LÄRA SIG

- inlärning

- uthyrning

- Nivå

- ljus

- tycka om

- sannolikt

- Begränsad

- linje

- Lyssna

- liten

- lever

- längre

- lunch

- Maskiner

- Vanliga

- större

- göra

- GÖR

- Framställning

- sätt

- många

- massiv

- max-bredd

- betyder

- betyder

- Media

- medicinsk

- Microsoft

- kanske

- milstolpe

- minimerande

- Mobil

- mobilitet

- modell

- modeller

- lägen

- Momentum

- månader

- humör

- mer

- flytta

- Filmer

- mycket efterlängtade

- multipel

- Musik

- musik streaming

- Natural

- Naturligt språk

- Naturlig språkbehandling

- Navigera

- Nära

- Behöver

- behov

- negativ

- nät

- nätverk

- neural

- neurala nätverk

- Nya

- Nästa

- icke infödd

- November

- objekt

- of

- erbjuds

- Office

- on

- ONE

- pågående

- nätet

- onlineplattformar

- öppet

- OpenAI

- öppnade

- möjligheter

- ursprungliga

- Övriga

- Överträffa

- egen

- Papper

- paradigmet

- Parallell

- del

- särskilt

- patienter

- mönster

- Personer

- procent

- utföra

- prestanda

- personifiera

- personlig

- plattform

- Plattformar

- plato

- Platon Data Intelligence

- PlatonData

- spelare

- plus

- podcast

- Populära

- popularitet

- Möjligheterna

- Möjligheten

- potentiell

- kraft

- den mäktigaste

- förutsagda

- Förutsägelser

- preferenser

- presentera

- presenteras

- primärt

- problem

- process

- bearbetning

- producera

- produktivitet

- Produkter

- professionell

- Program

- lovar

- lovande

- föreslagen

- utsikter

- ge

- ger

- tillhandahålla

- Offentliggörande

- Syftet

- quest

- fråga

- snabbt

- Lopp

- område

- som sträcker sig

- snabb

- snarare

- verkliga världen

- rike

- erhåller

- senaste

- erkännande

- känner igen

- rekommenderar

- minska

- hänvisar

- förstärkning lärande

- Förhållanden

- frigöra

- repetitiva

- representerar

- representerar

- förfrågningar

- Obligatorisk

- forskning

- forskare

- elastisk

- att

- Svara

- mottaglig

- begränsad

- Resultat

- intäkter

- revolutionerande

- Risk

- riskbedömning

- Säkerhet

- Sam

- Samma

- Skala

- scenarier

- sömlös

- Sök

- sökmotor

- Sektorer

- verkar

- känsla

- service

- flera

- svår

- formning

- delas

- skifta

- Gå och Handla

- signifikant

- liknande

- Enkelt

- samtidigt

- eftersom

- Situationen

- situationer

- SEX

- Sex månader

- Storlek

- So

- Mjukvara

- några

- något

- något

- sofistikerade

- Källor

- högtalare

- specifik

- spekulation

- tal

- Taligenkänning

- stapel

- Etapp

- statistisk

- Fortfarande

- streaming

- streaming service

- strömmar

- stil

- Inlagor

- abonnenter

- framgång

- sådana

- följer

- sammanfatta

- SAMMANFATTNING

- ökade

- system

- System

- bord

- Ta

- Diskussion

- uppgift

- uppgifter

- Undervisning

- tech

- tekniska jättar

- teknisk industri

- Teknisk

- tekniker

- teknisk

- Tekniken

- Teknologi

- tester

- den där

- Smakämnen

- Framtiden

- Framtidens arbete

- världen

- deras

- teoretiska

- Dessa

- saker

- tre

- Genom

- tid

- betitlad

- till

- verktyg

- ämne

- tippad

- mot

- spåra

- traditionell

- tränad

- Utbildning

- Förvandla

- transformativ

- omvandla

- Översättning

- transparent

- Trend

- triggas

- sann

- typer

- typiskt

- allmänt förekommande

- förstå

- förståelse

- låsa

- oövervakat lärande

- kommande

- Uppdateringar

- uppgradera

- us

- användning

- Användare

- användare

- Återvinnare

- Värden

- olika

- Omfattande

- Ventures

- mångsidig

- version

- Video

- videospel

- Video

- syn

- Röst

- röstkommandon

- Våg

- Sätt..

- sätt

- VÄL

- Vad

- Vad är

- om

- som

- medan

- VEM

- bred

- Brett utbud

- bredare

- kommer

- med

- inom

- utan

- bevittnar

- Arbete

- arbetssätt

- världen

- skulle

- WPEngine

- skrivning

- skriven

- år

- zephyrnet