Indiens ekonomiska rådgivande råd till premiärministern (EACPM) har skrivit ett dokument som varnar för att nuvarande globala AI-regler sannolikt kommer att vara ineffektiva, och rekommenderade att reglera tekniken med alternativa taktiker – som de som används på finansmarknaderna.

Rådet är mycket oroligt för AI. Dess dokument varnar "Genom en kombination av övervakning, övertygande meddelanden och generering av syntetiska medier kan illvillig AI i ökande grad kontrollera informationsekosystem och till och med tillverka skräddarsydda bedrägliga verkligheter för att tvinga fram mänskligt beteende, vilket inducerar massschizofreni."

Organisationen kritiserar USA:s förhållningssätt till AI som alltför praktiskt taget, Storbritanniens som utgör en risk genom att vara pro-innovation och laissez-faire, och EU:s AI-regler som bristfälliga på grund av att blockets medlemsländer splittras och antar olika inriktningar och tillämpningar av verkställighetsåtgärder.

Dokumentet hävdar också att Kinas tendens att reglera med "ett allsmäktigt centraliserat byråkratiskt system" är bristfälligt - vilket framgår av "det troliga ursprunget för labläckage till COVID-19."

Vi är genom glasögonen här, människor.

(För tydlighetens skull har US Office of the Director of National Intelligence hittade ingen indikation att viruset läckte från ett kinesiskt labb.)

Men vi avviker.

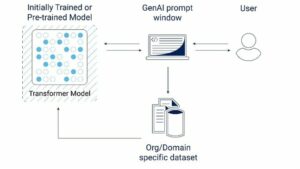

Rådet föreslår att AI ska betraktas som ett "decentraliserat självorganiserande system [som utvecklas] genom återkopplingsslingor, fasövergångar och känslighet för initiala förhållanden" och ger andra exempel på sådana system - som olinjära enheter som ses på finansmarknaderna, myrkoloniernas beteende eller trafikmönster.

”Traditionella metoder kommer till kort på grund av AI:s icke-linjära, oförutsägbara natur. AI-system är besläktade med Complex Adaptive Systems (CAS), där komponenter interagerar och utvecklas på oförutsägbara sätt." förklarade [PDF] rådet.

Rådet är inte förtjust i att förlita sig på "ex ante"-åtgärder, eftersom det är omöjligt att i förväg veta vilken risk ett AI-system kommer att innebära – dess beteende är ett resultat av för många faktorer.

Dokumentet föreslår därför att Indien antar fem regleringsåtgärder:

- Inrättande av skyddsräcken och skiljeväggar, vilket bör säkerställa att AI-teknik varken överskrider sin avsedda funktion eller inkräktar på farliga territorier – som beslutsfattande om kärnvapen. Om de på något sätt bryter mot det skyddsräcket i ett system, är skiljeväggarna där för att se till att det inte sprider sig.

- Säkerställer manuella åsidosättanden och auktoriserings-chokepoints som håller människor i kontroll och håller dem säkra med multifaktorautentisering och en granskningsprocess i flera nivåer för mänskliga beslutsfattare.

- Transparens och förklarabarhet med åtgärder som öppen licensiering för kärnalgoritmer för att främja en revisionsvänlig miljö, regelbundna revisioner och utvärderingar och standardiserad utvecklingsdokumentation.

- Distinkt ansvarighet genom fördefinierade ansvarsprotokoll, mandat standardiserad incidentrapportering och utredningsmekanismer.

- Anta ett specialiserat tillsynsorgansom ges ett brett mandat, antar ett återkopplingsdrivet tillvägagångssätt, övervakar och spårar AI-systembeteende, integrerar automatiserade varningssystem och upprättar ett nationellt register.

Rådet rekommenderade att man tittar på andra CAS-system för idéer om hur man kan leverera sina idéer – i första hand finansmarknaderna.

"Insikter från styrande kaotiska system som finansmarknader visar genomförbara regleringsmetoder för komplexa tekniker," konstaterar dokumentet, vilket tyder på att dedikerade AI-regulatorer kan utformas efter finansiella tillsynsmyndigheter som Indiens SEBI eller USA:s SEC.

Precis som dessa organ inför handelsstopp när marknader är i fara, kan tillsynsmyndigheter anta liknande "chokepoints" vid vilka AI skulle komma i strid. Obligatorisk finansiell rapportering är en bra modell för den typ av information som AI-operatörer kan behöva lämna.

Författarnas oro drivs av en övertygelse om att AI:s ökande spridning – i kombination med opaciteten i dess funktioner – innebär att kritisk infrastruktur, försvarsoperationer och många andra områden är i fara.

Bland farorna de beskriver är "runaway AI" där system rekursivt kan förbättra sig själv bortom mänsklig kontroll och "felpassa sig med mänskligt välbefinnande" och fjärilseffekten - ett scenario "där mindre förändringar kan leda till betydande, oförutsedda konsekvenser."

"Därför kan ett system med ogenomskinlig statlig kontroll över algoritmer, träningsuppsättningar och modeller med ett mål att maximera intressen leda till katastrofala resultat," varnade rådet.

Dokumentet noterar att dess föreslagna regler kan innebära att vissa scenarier måste uteslutas.

"Vi kanske aldrig tillåter ett superuppkopplat internet av allt", medger rådet. Men den drar slutsatsen att mänskligheten kan ha mer att vinna på starka regleringar.

"De som skapar AI-verktyg kommer inte att släppas lätt för förmodade oavsiktliga konsekvenser - och därigenom infoga ett ex-ante "Skin in the Game". Människor kommer att behålla åsidosättande och auktorisationsbefogenheter. Regelbundna bemyndigade revisioner kommer att behöva genomdriva förklaringen." ®

- SEO-drivet innehåll och PR-distribution. Bli förstärkt idag.

- PlatoData.Network Vertical Generative Ai. Styrka dig själv. Tillgång här.

- PlatoAiStream. Web3 Intelligence. Kunskap förstärkt. Tillgång här.

- Platoesg. Kol, CleanTech, Energi, Miljö, Sol, Avfallshantering. Tillgång här.

- PlatoHealth. Biotech och kliniska prövningar Intelligence. Tillgång här.

- Källa: https://go.theregister.com/feed/www.theregister.com/2024/02/01/indian_pms_ai_advice/

- : har

- :är

- :inte

- :var

- a

- Om oss

- adaptiv

- anta

- Anta

- avancera

- rådgivare

- rådgivande

- AI

- AI-system

- besläktad

- Varna

- algoritmer

- tillåter

- också

- alternativ

- an

- och

- ant

- tillämpningar

- tillvägagångssätt

- tillvägagångssätt

- ÄR

- argumenterar

- AS

- bedömningar

- At

- revisioner

- Autentisering

- tillstånd

- Författarna

- Automatiserad

- BE

- beteende

- Där vi får lov att vara utan att konstant prestera,

- tro

- Bortom

- block

- organ

- brott

- fört

- byråkratisk

- men

- by

- KAN

- katastrofal

- Orsak

- centraliserad

- Förändringar

- Kina

- kinesisk

- CO

- kombination

- kombinerad

- komplex

- komponenter

- oro

- avslutar

- villkor

- anslutna

- Konsekvenser

- anses

- kontroll

- Kärna

- kunde

- Rådet

- Covid-19

- Skapa

- kritisk

- Kritisk infrastruktur

- kritiserar

- Aktuella

- kundanpassad

- FARA

- faror

- decentraliserad

- Beslutsfattande

- beslutsfattare

- dedicerad

- Försvar

- leverera

- demonstrera

- demonstreras

- Utveckling

- olika

- Direktör

- avslöjande

- dokumentera

- dokumentation

- doesn

- grund

- lätt

- Ekonomisk

- ekosystem

- effekt

- förstärka

- tillämpning

- säkerställa

- enheter

- Miljö

- upprättar

- Eter (ETH)

- EU

- Även

- allt

- utvecklas

- utvecklas

- exempel

- överstiga

- Förklarbarhet

- faktorer

- Höst

- möjlig

- återkoppling

- Fält

- Fil

- finansiella

- Finansiella tillsynsmyndigheter

- fem

- bristfällig

- För

- Foster

- från

- fueled

- fungera

- Få

- lek

- generering

- ges

- glas

- Välgörenhet

- Målet

- god

- styrande

- Har

- här.

- Hur ser din drömresa ut

- How To

- HTTPS

- humant

- Mänskligheten

- Människa

- idéer

- if

- ålagts

- omöjligt

- in

- incident

- ökande

- alltmer

- indien

- indisk

- informationen

- Infrastruktur

- inledande

- insikter

- integrerar

- Intelligens

- avsedd

- interagera

- intressen

- Internet

- Undersökningen

- isn

- IT

- DESS

- jpg

- Angelägen

- Ha kvar

- hålla

- Snäll

- Vet

- lab

- leda

- Låt

- ansvar

- Licens

- tycka om

- sannolikt

- du letar

- göra

- mandat

- manuell

- många

- Marknader

- Massa

- Maximera

- Maj..

- betyda

- betyder

- åtgärder

- mekanismer

- Media

- medlem

- meddelandehantering

- metoder

- kanske

- minister

- mindre

- modell

- modeller

- monitorer

- mer

- multifaktorautentisering

- nationell

- nationer

- Natur

- Behöver

- Varken

- aldrig

- Nej

- olinjär

- inte heller

- Anmärkningar

- nukleär

- observerar

- of

- sänkt

- Office

- Byrån för direktören för National Intelligence

- on

- ONE

- opak

- öppet

- Verksamhet

- operatörer

- or

- Ursprung

- Övriga

- ut

- utfall

- översikt

- över

- åsidosätta

- mönster

- Personer

- fas

- plato

- Platon Data Intelligence

- PlatonData

- pm

- befogenheter

- fördefinierad

- presentera

- primärt

- Prime

- premiärminister

- process

- föreslagen

- föreslår

- protokoll

- RE

- realiteter

- rekommenderas

- post

- register

- regelbunden

- Reglera

- reglerande

- reglering

- föreskrifter

- Tillsynsmyndigheter

- regulatorer

- förlita

- Rapportering

- Obligatorisk

- resultera

- behålla

- översyn

- Risk

- uteslutas

- regler

- s

- säker

- säga

- scenario

- scenarier

- SEC

- sett

- Känslighet

- uppsättningar

- Kort

- skall

- signifikant

- liknande

- Hud

- några

- på något sätt

- specialiserad

- spridning

- standardiserad

- Ange

- statlig kontroll

- stark

- sådana

- Föreslår

- super

- förment

- säker

- övervakning

- syntetisk

- system

- System

- T

- taktik

- tar

- Tekniken

- Teknologi

- områden

- den där

- Smakämnen

- Storbritannien

- deras

- Dem

- Där.

- vari

- därför

- de

- de

- Genom

- till

- alltför

- verktyg

- spår

- Handel

- traditionell

- trafik

- Utbildning

- övergångar

- Uk

- oförutsedd

- oförutsägbar

- us

- Begagnade

- mycket

- virus

- varnade

- varning

- varnar

- sätt

- we

- Välfärd

- när

- som

- kommer

- med

- fungerar

- orolig

- skulle

- zephyrnet