Den snabba tillväxten av generativ AI för med sig lovande ny innovation och väcker samtidigt nya utmaningar. Dessa utmaningar inkluderar några som var vanliga före generativ AI, som fördomar och förklarabarhet, och nya unika för foundationmodeller (FM), inklusive hallucinationer och toxicitet. På AWS är vi engagerade i utveckla generativ AI på ett ansvarsfullt sätt, med ett folkcentrerat tillvägagångssätt som prioriterar utbildning, vetenskap och våra kunder, för att integrera ansvarsfull AI över hela livscykeln för AI.

Under det senaste året har vi introducerat nya funktioner i våra generativa AI-applikationer och modeller som inbyggd säkerhetsskanning i Amazon Code Whisperer, utbildning för att upptäcka och blockera skadligt innehåll Amazon Titan, och dataintegritetsskydd i Amazonas berggrund. Vår investering i säker, transparent och ansvarsfull generativ AI inkluderar samarbete med det globala samhället och beslutsfattare eftersom vi uppmuntrade och stöttade både Vita husets frivilliga AI-åtaganden och AI Safety Summit i UK. Och vi fortsätter att arbeta hand i hand med kunder för att operationalisera ansvarsfull AI med specialbyggda verktyg som Amazon SageMaker Clarify, ML Governance med Amazon SageMakerOch mycket mer.

Introducerar ny ansvarsfull AI-innovation

När generativ AI skalas till nya branscher, organisationer och användningsfall måste denna tillväxt åtföljas av en uthållig investering i ansvarsfull FM-utveckling. Kunder vill att deras FM ska byggas med säkerhet, rättvisa och säkerhet i åtanke, så att de i sin tur kan distribuera AI på ett ansvarsfullt sätt. På AWS re:Invent i år är vi glada över att kunna tillkännage nya möjligheter för att främja ansvarsfull generativ AI-innovation över en bred uppsättning möjligheter med nya inbyggda verktyg, kundskydd, resurser för att öka transparensen och verktyg för att bekämpa desinformation. Vi strävar efter att ge kunderna den information de behöver för att utvärdera FM:er mot viktiga ansvarsfulla AI-överväganden, som toxicitet och robusthet, och introducera skyddsräcken för att tillämpa skyddsåtgärder baserat på kundanvändningsfall och ansvarsfulla AI-policyer. Samtidigt vill våra kunder bli bättre informerade om säkerheten, rättvisan, säkerheten och andra egenskaper hos AI-tjänster och FM:er, när de använder dem inom sin egen organisation. Vi är glada över att kunna presentera fler resurser för att hjälpa kunder att bättre förstå våra AWS AI-tjänster och leverera den transparens de efterfrågar.

Implementering av skyddsåtgärder: Skyddsräcken för Amazon Bedrock

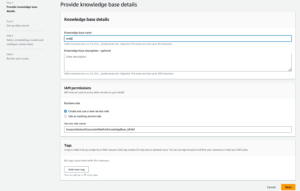

Säkerhet är en prioritet när det gäller att introducera generativ AI i stor skala. Organisationer vill främja säker interaktion mellan sina kunder och generativa AI-applikationer som undviker skadligt eller stötande språk och anpassar sig till företagets policyer. Det enklaste sättet att göra det är att införa konsekventa skyddsåtgärder i hela organisationen så att alla kan förnya sig på ett säkert sätt. Igår meddelade vi förhandsvisningen av Skyddsräcken för Amazon Bedrock—en ny funktion som gör det enkelt att implementera applikationsspecifika skyddsåtgärder baserat på kundanvändningsfall och ansvarsfulla AI-policyer.

Guardrails driver enhetlighet i hur FMs på Amazon Bedrock reagerar på oönskat och skadligt innehåll i applikationer. Kunder kan applicera skyddsräcken på stora språkmodeller på Amazon Bedrock samt på finjusterade modeller och i kombination med Agenter för Amazon Bedrock. Guardrails låter dig ange ämnen som ska undvikas, och tjänsten upptäcker och förhindrar automatiskt frågor och svar som faller inom begränsade kategorier. Kunder kan också konfigurera gränsvärden för innehållsfiltrering över kategorier inklusive hatretorik, förolämpningar, sexualiserat språk och våld för att filtrera bort skadligt innehåll till önskad nivå. Till exempel kan en nätbanksapplikation ställas in för att undvika investeringsrådgivning och begränsa olämpligt innehåll (som hatretorik, förolämpningar och våld). Inom en snar framtid kommer kunder också att kunna redigera personlig identifierbar information (PII) i användarinmatningar och FMs svar, ställa in svordomsfilter och tillhandahålla en lista med anpassade ord för att blockera interaktioner mellan användare och FMs, vilket förbättrar efterlevnaden och ytterligare skydda användarna. Med Guardrails kan du förnya dig snabbare med generativ AI samtidigt som du bibehåller skydd och skydd som överensstämmer med företagets policyer.

Identifiera den bästa FM för ett specifikt användningsfall: Model Evaluation i Amazon Bedrock

Idag har organisationer ett brett utbud av FM-alternativ för att driva sina generativa AI-applikationer. För att hitta den rätta balansen mellan noggrannhet och prestanda för deras användningsfall måste organisationer effektivt jämföra modeller och hitta det bästa alternativet baserat på viktiga ansvarsfulla AI och kvalitetsmått som är viktiga för dem. För att utvärdera modeller måste organisationer först ägna dagar åt att identifiera riktmärken, sätta upp utvärderingsverktyg och köra bedömningar, vilket allt kräver djup expertis inom datavetenskap. Dessutom är dessa tester inte användbara för att utvärdera subjektiva kriterier (t.ex. varumärkesröst, relevans och stil) som kräver bedömning genom tråkiga, tidskrävande arbetsflöden för mänsklig granskning. Den tid, expertis och resurser som krävs för dessa utvärderingar – för varje nytt användningsfall – gör det svårt för organisationer att utvärdera modeller mot ansvarsfulla AI-dimensioner och göra ett välgrundat val kring vilken modell som ger den mest exakta, säkra upplevelsen för sina kunder.

Nu tillgänglig i förhandsvisning, Modellutvärdering på Amazons berggrund hjälper kunder att utvärdera, jämföra och välja de bästa FM:erna för deras specifika användningsfall baserat på anpassade mätvärden, såsom noggrannhet och säkerhet, med antingen automatiska eller mänskliga utvärderingar. I Amazon Bedrock-konsolen väljer kunderna de FM:er de vill jämföra för en given uppgift, till exempel svar på frågor eller sammanfattning av innehåll. För automatiska utvärderingar väljer kunder fördefinierade utvärderingskriterier (t.ex. noggrannhet, robusthet och toxicitet) och laddar upp sin egen testdatauppsättning eller väljer från inbyggda, allmänt tillgängliga datauppsättningar. För subjektiva kriterier eller nyanserat innehåll som kräver bedömning kan kunder enkelt skapa mänskliga utvärderingsarbetsflöden med bara några få klick. Dessa arbetsflöden utnyttjar en kunds interna arbetslag, eller använder en hanterad arbetsstyrka från AWS för att utvärdera modellsvar. Under människobaserade utvärderingar definierar kunder användningsfallsspecifika mätvärden (t.ex. relevans, stil och varumärkesröst). När kunderna är klara med installationsprocessen, kör Amazon Bedrock utvärderingar och genererar en rapport, så att kunderna enkelt kan förstå hur modellen presterade över viktiga säkerhets- och noggrannhetskriterier och välja den bästa modellen för deras användningsfall.

Denna förmåga att utvärdera modeller är inte begränsad till Amazon Bedrock, kunder kan också använda modellutvärdering i Amazon SageMaker Clarify för att enkelt utvärdera, jämföra och välja det bästa FM-alternativet över nyckelkvalitets- och ansvarsmått som noggrannhet, robusthet och toxicitet – överallt alla FM.

Bekämpa desinformation: Vattenmärkning i Amazon Titan

Idag meddelade vi Amazon Titan Image Generator i förhandsvisning, vilket ger kunderna möjlighet att snabbt producera och förbättra högkvalitativa bilder i stor skala. Vi övervägde ansvarsfull AI under varje steg i modellutvecklingsprocessen, inklusive utbildningsval av data, byggande av filtreringsmöjligheter för att upptäcka och ta bort olämpliga användarinmatningar och modellutgångar och förbättra den demografiska mångfalden av våra modellutdata. Alla Amazon Titan-genererade bilder innehåller en osynlig vattenstämpel som standard, som är designad för att minska spridningen av desinformation genom att tillhandahålla en diskret mekanism för att identifiera AI-genererade bilder. AWS är bland de första modellleverantörerna att släppa inbyggda osynliga vattenstämplar som är integrerade i bildutgångar och är designade för att vara resistenta mot förändringar.

Bygga förtroende: Står bakom våra modeller och applikationer med gottgörelse

Att bygga kundernas förtroende är kärnan i AWS. Vi har varit på en resa med våra kunder sedan starten, och med tillväxten av generativ AI fortsätter vi att bygga innovativ teknologi tillsammans. För att kunderna ska kunna utnyttja kraften i vår generativa AI måste de veta att de är skyddade. AWS erbjuder täckning för upphovsrättsligt gottgörelse för utdata från följande Amazon generativa AI-tjänster: Amazon Titan Text Express, Amazon Titan Text Lite, Amazon Titan Embeddings, Amazon Titan Multimodal Embeddings, Amazon CodeWhisperer Professional, AWS HealthScribe, Amazon Lexoch Amazon Anpassa. Detta innebär att kunder som använder tjänsterna på ett ansvarsfullt sätt skyddas mot anspråk från tredje part som påstår intrång i upphovsrätten genom de utdata som genereras av dessa tjänster (se avsnitt 50.10 i Servicevillkor). Dessutom skyddar vår standard IP-ersättning för användning av tjänsterna kunder från tredje parts anspråk som påstår att tjänsterna har gjort intrång i IP och den data som används för att träna dem. För att uttrycka det på ett annat sätt, om du använder en Amazon generativ AI-tjänst listad ovan och någon stämmer dig för IP-intrång, kommer AWS att försvara den rättegången, som inkluderar att täcka eventuella domar mot dig eller förlikningskostnader.

Vi står bakom våra generativa AI-tjänster och arbetar för att ständigt förbättra dem. När AWS lanserar nya tjänster och generativ AI fortsätter att utvecklas, kommer AWS att fortsätta att obevekligt fokusera på att tjäna och behålla kundernas förtroende.

Ökad transparens: AWS AI Service Card för Amazon Titan Text

We introducerade AWS AI Service Cards på re:Invent 2022 som en transparensresurs för att hjälpa kunder att bättre förstå våra AWS AI-tjänster. AI Service Cards är en form av ansvarsfull AI-dokumentation som ger kunderna en enda plats för att hitta information om avsedda användningsfall och begränsningar, ansvarsfulla AI-designval och bästa praxis för implementering och prestandaoptimering för våra AI-tjänster. De är en del av en omfattande utvecklingsprocess som vi åtar oss att bygga våra tjänster på ett ansvarsfullt sätt som tar upp rättvisa, förklarabarhet, sanningsenlighet och robusthet, styrning, transparens, integritet och säkerhet, säkerhet och kontrollerbarhet.

På re:Invent i år tillkännager vi en nytt AI-servicekort för Amazon Titan Text att öka transparensen i grundmodeller. Vi lanserar också fyra nya AI Service Cards inklusive: Amazon Comprehend Detect PII, Detektion av toxicitet för transkribering av Amazon, Amazon Recognition Face Livenessoch AWS HealthScribe. Du kan utforska vart och ett av dessa kort på AWS hemsida. När generativ AI fortsätter att växa och utvecklas kommer insyn i hur tekniken utvecklas, testas och används vara en viktig komponent för att vinna både organisationers och deras kunders förtroende. På AWS är vi fast beslutna att fortsätta att ge transparensresurser som AI Service Cards till det bredare samhället – och att upprepa och samla feedback om de bästa vägarna framåt.

Investera i ansvarsfull AI under hela den generativa AI-livscykeln

Vi är glada över de nya innovationerna som tillkännagavs på re:Invent denna vecka som ger våra kunder fler verktyg, resurser och inbyggda skydd för att bygga och använda generativ AI på ett säkert sätt. Från modellutvärdering till skyddsräcken till vattenmärkning, kunder kan nu ta med generativ AI till sin organisation snabbare, samtidigt som risken minskar. Nya skydd för kunder som täckning av IP-ersättning och nya resurser för att öka transparensen som ytterligare AI-tjänstkort är också viktiga exempel på vårt engagemang för att bygga upp förtroende mellan teknikföretag, beslutsfattare, samhällsgrupper, vetenskapsmän och mer. Vi fortsätter att göra meningsfulla investeringar i ansvarsfull AI under hela livscykeln för en grundmodell – för att hjälpa våra kunder att skala AI på ett säkert, säkert och ansvarsfullt sätt.

Om författarna

Peter Hallinan leder initiativ inom vetenskapen och praktiken av Responsible AI på AWS AI, tillsammans med ett team av ansvariga AI-experter. Han har djup expertis inom AI (PhD, Harvard) och entreprenörskap (Blindsight, såld till Amazon). Hans volontärverksamhet har inkluderat att tjänstgöra som konsultprofessor vid Stanford University School of Medicine och som president för American Chamber of Commerce på Madagaskar. När det är möjligt är han iväg i bergen med sina barn: skidor, klättring, vandring och forsränning

Peter Hallinan leder initiativ inom vetenskapen och praktiken av Responsible AI på AWS AI, tillsammans med ett team av ansvariga AI-experter. Han har djup expertis inom AI (PhD, Harvard) och entreprenörskap (Blindsight, såld till Amazon). Hans volontärverksamhet har inkluderat att tjänstgöra som konsultprofessor vid Stanford University School of Medicine och som president för American Chamber of Commerce på Madagaskar. När det är möjligt är han iväg i bergen med sina barn: skidor, klättring, vandring och forsränning

Vasi Philomin är för närvarande VP of Generative AI på AWS. Han leder generativa AI-insatser inklusive Amazon Bedrock, Amazon Titan och Amazon CodeWhisperer.

Vasi Philomin är för närvarande VP of Generative AI på AWS. Han leder generativa AI-insatser inklusive Amazon Bedrock, Amazon Titan och Amazon CodeWhisperer.

- SEO-drivet innehåll och PR-distribution. Bli förstärkt idag.

- PlatoData.Network Vertical Generative Ai. Styrka dig själv. Tillgång här.

- PlatoAiStream. Web3 Intelligence. Kunskap förstärkt. Tillgång här.

- Platoesg. Kol, CleanTech, Energi, Miljö, Sol, Avfallshantering. Tillgång här.

- PlatoHealth. Biotech och kliniska prövningar Intelligence. Tillgång här.

- Källa: https://aws.amazon.com/blogs/machine-learning/announcing-new-tools-and-capabilities-to-enable-responsible-ai-innovation/

- : har

- :är

- :inte

- $UPP

- 10

- 100

- 125

- 2022

- 50

- a

- förmåga

- Able

- Om oss

- ovan

- åtföljas

- noggrannhet

- exakt

- tvärs

- aktiviteter

- Dessutom

- Annat

- adresser

- rådgivning

- mot

- AI

- AI-tjänster

- Syftet

- rikta

- lika

- Alla

- vid sidan av

- också

- amason

- Amazon Code Whisperer

- Amazon SageMaker

- Amazon Web Services

- amerikan

- bland

- an

- och

- Meddela

- meddelade

- Vi presenterar

- Annan

- vilken som helst

- Ansökan

- tillämpningar

- Ansök

- tillvägagångssätt

- ÄR

- runt

- AS

- be

- bedömningar

- At

- Automat

- automatiskt

- tillgänglig

- undvika

- undvek

- AWS

- AWS re: Invent

- Balansera

- Banking

- baserat

- BE

- varit

- innan

- bakom

- riktmärken

- BÄST

- bästa praxis

- Bättre

- mellan

- förspänning

- Blockera

- båda

- varumärke

- föra

- Bringar

- bred

- bredare

- SLUTRESULTAT

- bygga förtroende

- Byggnad

- byggt

- inbyggd

- by

- KAN

- kapacitet

- kapacitet

- kortet

- Kort

- Vid

- fall

- kategorier

- utmaningar

- Klimatkammare

- Barn

- val

- val

- Välja

- hävdar

- Klättring

- samverkan

- bekämpa

- kombination

- kommer

- Commerce

- engagemang

- engagerad

- Gemensam

- samfundet

- Företag

- företag

- jämföra

- Efterlevnad

- komponent

- förstå

- omfattande

- överväganden

- anses

- konsekvent

- Konsol

- rådgivning

- innehålla

- innehåll

- kontinuerligt

- fortsätta

- fortsätter

- fortsätter

- upphovsrätt

- upphovsrättsintrång

- Kärna

- Kostar

- täckning

- beläggning

- kriterier

- För närvarande

- beställnings

- kund

- Kunder

- datum

- dataintegritet

- datavetenskap

- datauppsättningar

- Dagar

- djup

- djup expertis

- Standard

- definiera

- leverera

- demografiska

- distribuera

- utplacering

- Designa

- utformade

- önskas

- upptäcka

- utvecklade

- Utveckling

- svårt

- dimensioner

- desinformation

- Mångfald

- do

- dokumentation

- driv

- under

- e

- varje

- tjänar

- tjänar

- enklaste

- lätt

- lätt

- Utbildning

- effektivt

- ansträngningar

- antingen

- bemyndigar

- möjliggöra

- uppmuntras

- början till slut

- förbättra

- Hela

- entreprenörskap

- Eter (ETH)

- utvärdera

- utvärdering

- utvärdering

- utvärderingar

- Varje

- alla

- utvecklas

- exempel

- exempel

- exciterade

- erfarenhet

- expertis

- experter

- Förklarbarhet

- utforska

- uttrycker

- Ansikte

- rättvisa

- Höst

- snabbare

- återkoppling

- få

- filtrera

- filtrering

- filter

- hitta

- slut

- Förnamn

- Fokus

- efter

- För

- formen

- Framåt

- Foster

- fundament

- fyra

- från

- ytterligare

- Vidare

- framtida

- samla

- genereras

- genererar

- generativ

- Generativ AI

- ges

- ger

- Välgörenhet

- styrning

- Gruppens

- Väx

- Tillväxt

- skadliga

- sele

- Harvard

- hatar

- hatpropaganda

- Har

- he

- hjälpa

- hjälper

- hög kvalitet

- vandring

- hans

- Huset

- Hur ser din drömresa ut

- HTTPS

- humant

- identifiera

- identifiera

- if

- bild

- bilder

- genomföra

- med Esport

- förbättra

- förbättra

- in

- början

- innefattar

- ingår

- innefattar

- Inklusive

- Öka

- industrier

- informationen

- informeras

- överträdelse

- initiativ

- förnya

- Innovation

- innovationer

- innovativa

- innovativ teknik

- ingångar

- integrera

- integrerade

- avsedd

- interaktioner

- in

- införa

- introducerade

- införa

- investering

- Investeringar

- osynlig

- IP

- IT

- resa

- jpg

- bara

- Nyckel

- Vet

- språk

- Large

- lanserar

- lansera

- stämning

- Leads

- Lets

- Nivå

- Hävstång

- livscykel

- tycka om

- BEGRÄNSA

- begränsningar

- Begränsad

- Lista

- Noterade

- upprätthålla

- göra

- GÖR

- förvaltade

- meningsfull

- betyder

- mekanism

- läkemedel

- Metrics

- emot

- förmildrande

- modell

- modeller

- mer

- mest

- måste

- Nära

- Behöver

- Nya

- nu

- of

- sänkt

- offensiv

- Erbjudanden

- on

- gång

- ettor

- nätet

- Internetbank

- optimering

- Alternativet

- Tillbehör

- or

- organisation

- organisationer

- Övriga

- vår

- ut

- utgångar

- egen

- del

- Tidigare

- prestanda

- utfört

- Personligen

- phd

- pii

- Plats

- plato

- Platon Data Intelligence

- PlatonData

- Strategier

- beslutsfattare

- möjlig

- kraft

- praktiken

- praxis

- VD

- förhindrar

- Förhandsvisning

- prioriterar

- prioritet

- privatpolicy

- Integritet och säkerhet

- process

- producera

- HÄDELSER

- professionell

- Professor

- lovande

- främja

- egenskaper

- skyddad

- skydda

- skyddar

- ge

- förutsatt

- leverantörer

- tillhandahålla

- publicly

- sätta

- kvalitet

- sökfrågor

- höjer

- område

- snabb

- snabbt

- RE

- minska

- frigöra

- relevans

- förblir

- ta bort

- rapport

- Obligatorisk

- Kräver

- resistent

- resurs

- Resurser

- Svara

- svar

- ansvaret

- ansvarig

- ansvarsfullt

- begränsad

- höger

- Risk

- robusthet

- rinnande

- kör

- säker

- skyddsåtgärder

- på ett säkert sätt

- Säkerhet

- sagemaker

- Samma

- Skala

- skala ai

- skalor

- scanning

- Skola

- Vetenskap

- vetenskapsmän

- §

- säkra

- säkerhet

- se

- välj

- Val

- service

- Tjänster

- portion

- in

- inställning

- lösning

- inställning

- eftersom

- enda

- So

- säljs

- några

- någon

- specifik

- tal

- spendera

- spridning

- Etapp

- stå

- standard

- stående

- stanford

- Stanford University

- strejka

- stil

- sådana

- Stämningsansökan

- Som stöds

- ihållande

- tar

- uppgift

- grupp

- Teknologi

- teknikföretag

- testade

- Testning

- tester

- text

- den där

- Smakämnen

- den information

- Storbritannien

- deras

- Dem

- Dessa

- de

- tredje part

- detta

- denna vecka

- i år

- de

- Genom

- tid

- titan

- till

- tillsammans

- verktyg

- ämnen

- Tåg

- Utbildning

- Öppenhet

- transparent

- Litar

- SVÄNG

- Uk

- förstå

- åtar

- unika

- universitet

- användning

- användningsfall

- Begagnade

- Användare

- användare

- med hjälp av

- avgörande

- Röst

- frivillig

- volontär

- vp

- vill

- vattenmärke

- vattenmärkning

- vattenmärken

- Sätt..

- sätt

- we

- webb

- webbservice

- Webbplats

- vecka

- VÄL

- były

- Vad

- när

- som

- medan

- VEM

- Hela

- bred

- Brett utbud

- brett

- kommer

- med

- inom

- ord

- Arbete

- arbetsflöden

- arbetskraft

- år

- i går

- dig

- zephyrnet