Ste obremenjeni s kupom podedovane kode, napisane za Nvidijino platformo CUDA? Intelov tehnični direktor Greg Lavender predlaga izdelavo velikega jezikovnega modela (LLM), da bi ga pretvorili v nekaj, kar deluje na drugih pospeševalnikih umetne inteligence – kot je morda lastna strojna oprema Gaudi2 ali GPU Max.

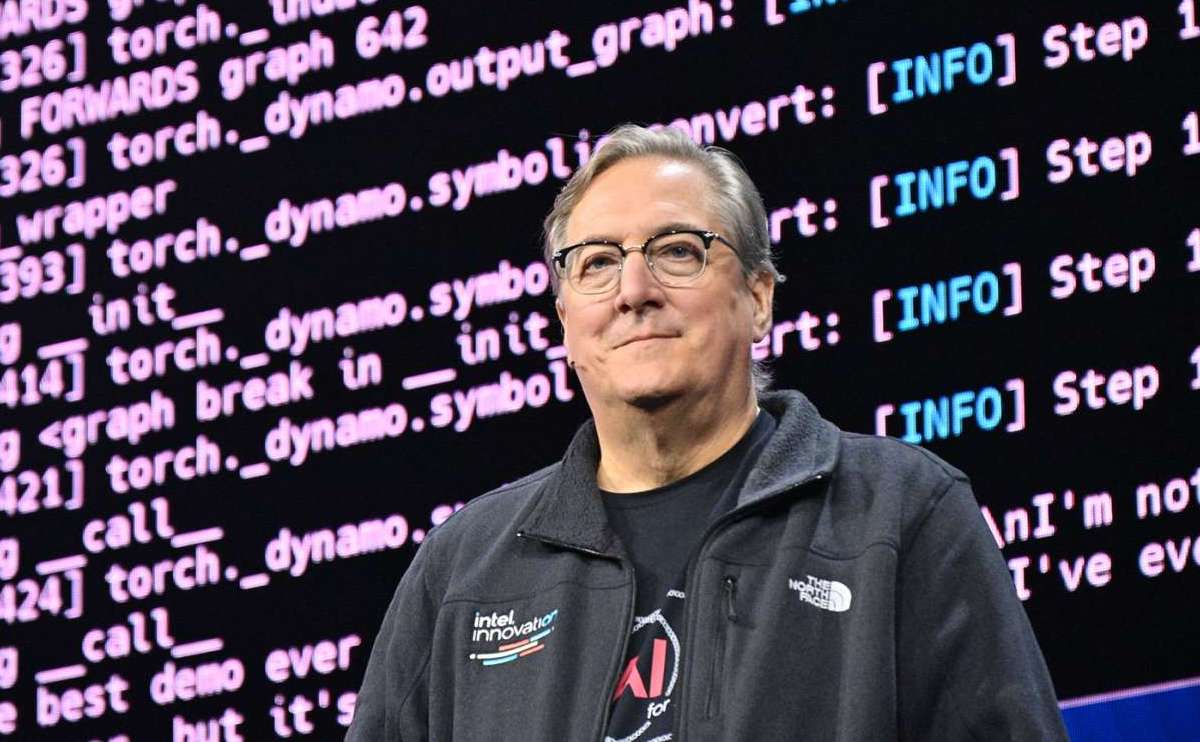

»Vsem razvijalcem bom le poslal izziv. Uporabimo LLM-je in tehnologije, kot je Copilot, da usposobimo model strojnega učenja za pretvorbo vse vaše kode CUDA v SYCL,« je pošalil med svojim osrednjim govorom o inovacijah v sredo in se skliceval na Intelov osredotočen na pospeševalnik orodje za programiranje.

Eden od izzivov, s katerimi se srečujejo Intel, AMD in drugi izdelovalci pospeševalnikov, ko si prizadevajo za sprejetje svoje strojne opreme z umetno inteligenco, je, da je treba veliko kode, napisane za Nvidijino izvajalno okolje CUDA, preoblikovati, preden jo je mogoče uporabiti na alternativnih platformah.

V nekaterih primerih je morda samo nekaj vrstic kode, ki kliče knjižnice CUDA, ki so ključne za delovanje aplikacije, vendar je zaradi tega "razmeroma lepljiva na eno mikroarhitekturo," Joe Curley, podpredsednik programskih izdelkov in ekosistema pri Intelu, povedal Register.

Intel je pri tem že dosegel nekaj napredka. Silicijev titan je veliko vložil v svoj medplatformski model vzporednega programiranja, imenovan oneAPI, in svojo ponudbo sklepanja AI, imenovano OpenVINO. V svojem govoru se je Lavender pohvalil, da se je namestitvena baza oneAPI od leta 85 povečala za 2021 odstotkov, kar po njegovem mnenju dokazuje naraščajoče navdušenje nad platformo.

Čeprav ju je razvil Intel, je vredno omeniti, da sta tako oneAPI kot OpenVINO odprtokodna in nista omejena na strojno opremo izdelovalca čipov.

Tudi Chipzilla ima sprosti na desetine odprtokodnih referenčnih kompletov za obravnavo različnih pogostih delovnih obremenitev AI/ML, od klepetalnih robotov in druge generativne AI do bolj tradicionalnih delovnih obremenitev ML, kot so zaznavanje predmetov, ustvarjanje glasu in napovedovanje finančnega tveganja.

SYCL je nedavni del Intelovih prizadevanj za prekinitev stiske CUDA nad ekosistemom programske opreme AI. Kot naše sestrsko spletno mesto Naslednja platforma poročali v začetku lanskega leta je SYCL – ali natančneje SYCLomatic – brezplačna abstrakcija med arhitekturami, ki poganja Intelov vzporedni programski jezik C++.

Na kratko, SYCL prevzame večino težkega dela – domnevno do 95 odstotkov – prenosa kode CUDA v format, ki lahko deluje na pospeševalnikih, ki niso Nvidia. Toda kot bi lahko pričakovali, je običajno potrebno nekaj natančnega prilagajanja in prilagajanja, da lahko aplikacije delujejo s polno hitrostjo.

»Če želite doseči zadnjo miljo iz Intel GPU – v primerjavi z GPE AMD v primerjavi z GPE Nvidia – boste naredili nekaj, bodisi prek mehanizma razširitve na SYCL ali preprosto tako, kako strukturirate svojo kodo,« je pojasnil Curley.

Zdi se, da Lavender nakazuje, da bi to fino nastavitev lahko dodatno avtomatiziral model LLM.

"Zagotovo bodo raziskave o tem, kako narediti točno to," je napovedal Curley. »To, kar danes mislimo kot svet z nizko kodo, brez kode, bo čez pet let popolnoma in popolnoma drugačen. Torej, to ni samo dobra ideja, to je ideja, ki se bo zgodila.«

Izziv, meni Curley, bo določitev ustreznih izvornih podatkov, na katerih boste učili svoj model.

Vendar pa je vredno omeniti tudi, da SYCL nikakor ni edini način za pisanje kode, ki je agnostična za pospeševalnik. Curley je opozoril na okvire, kot sta Triton OpenAI ali Googlov Jax, kot samo dva primera.

»Če vam iz nekega razloga ni všeč, kam smo namenjeni s SYCL, sprejmite enega od teh drugih načinov, ki so prav tako standardni. Vsi kot industrija bomo ustvarili kompilacijske verige za našo strojno opremo in vam dali enake koristi,« je dejal Curley.

Poleg izvajalnih časov programske opreme, kot je SYCL, Intel daje na voljo veliko virov v obliki programske opreme, podpore in pospeševalnikov, ki se izvajajo v svojem Developer Cloudu, da bi startupom z umetno inteligenco pomagal optimizirati svojo kodo za Gaudi2, GPU Max ali Advanced Matrix Extensions v svojih najnovejši Xeon.

Promoviran je bil tudi Intelov program Liftoff Program – katerega cilj je pridobiti novonastajajoča podjetja za programsko opremo z umetno inteligenco z zagotavljanjem tehničnega znanja in izkušenj za pomoč pri izdelavi aplikacij, ki delujejo na njegovih izdelkih.

Intel še zdaleč ni edini, ki se spopada s temi izzivi. Ta teden je Linux Foundation v sodelovanju z Arm, Fujitsu, Google Cloud, Imagination Technologies, Intel, Qualcomm Technologies in Samsung, oblikovana Fundacija Unified Acceleration (UXL). Delovna skupina želi razviti naslov oneAPI za široko paleto pospeševalnikov različnih proizvajalcev.

Po besedah Lavenderja: "Industrija ima koristi od odprtih standardiziranih programskih jezikov za programsko pospeševalno strojno opremo, h kateri lahko vsakdo prispeva in sodeluje brez zaklenjenosti prodajalca." ®

- Distribucija vsebine in PR s pomočjo SEO. Okrepite se še danes.

- PlatoData.Network Vertical Generative Ai. Opolnomočite se. Dostopite tukaj.

- PlatoAiStream. Web3 Intelligence. Razširjeno znanje. Dostopite tukaj.

- PlatoESG. Ogljik, CleanTech, Energija, Okolje, sončna energija, Ravnanje z odpadki. Dostopite tukaj.

- PlatoHealth. Obveščanje o biotehnologiji in kliničnih preskušanjih. Dostopite tukaj.

- vir: https://go.theregister.com/feed/www.theregister.com/2023/09/21/intel_ai_cuda/

- :ima

- : je

- :ne

- :kje

- $GOR

- 2021

- a

- abstrakcija

- pospešek

- plin

- pospeševalniki

- Naslov

- Sprejetje

- napredno

- AI

- AI / ML

- Cilje

- vsi

- že

- Prav tako

- alternativa

- AMD

- an

- in

- uporaba

- aplikacije

- primerno

- SE

- ARM

- AS

- At

- Avtomatizirano

- Na voljo

- baza

- BE

- pred

- meni

- koristi

- Prednosti

- tako

- Break

- izgradnjo

- Building

- Bunch

- vendar

- by

- C + +

- se imenuje

- kliče

- CAN

- primeri

- Zagotovo

- verige

- izziv

- izzivi

- klepetalnice

- Cloud

- CO

- Koda

- sodelovati

- Skupno

- popolnoma

- prispevajo

- pretvorbo

- bi

- par

- platformah

- CTO

- datum

- dokazuje,

- Odkrivanje

- določanje

- razvili

- Razvojni

- Razvijalci

- drugačen

- do

- tem

- don

- desetine

- med

- Zgodnje

- ekosistem

- prizadevanje

- prizadevanja

- objem

- navdušenje

- Eter (ETH)

- vsi

- razvijajo

- točno

- Primeri

- pričakovati

- strokovno znanje

- razložiti

- razširitev

- razširitve

- Obraz

- daleč

- finančna

- konec

- pet

- za

- obrazec

- format

- Fundacija

- okviri

- iz

- Fujitsu

- polno

- funkcija

- nadalje

- ustvarjajo

- generacija

- generativno

- Generativna AI

- dobili

- Daj

- dogaja

- dobro

- Google Cloud

- GPU

- grabežljiv

- skupina

- Pridelovanje

- goji

- imel

- Ročaji

- se zgodi

- strojna oprema

- he

- vodil

- močno

- težka

- težko dvigovanje

- pomoč

- njegov

- Kako

- HTML

- HTTPS

- i

- Ideja

- if

- domišljija

- in

- Industrija

- Inovacije

- namestitev

- Intel

- investirali

- IT

- ITS

- joe

- jpg

- samo

- Ključne

- Osrednji

- jezik

- jeziki

- velika

- Zadnja

- zadnji kilometer

- Lansko leto

- Zadnji

- plast

- učenje

- Legacy

- Naj

- knjižnice

- dviganje

- kot

- Limited

- linije

- linux

- temelj za linux

- ll

- Sklop

- nizka

- stroj

- strojno učenje

- je

- IZDELA

- Izdelava

- Matrix

- max

- mogoče

- pomeni

- Mehanizem

- morda

- ML

- Model

- več

- Najbolj

- morajo

- Naslednja

- št

- Opažam

- zdaj

- Nutshell

- Nvidia

- predmet

- Zaznavanje objektov

- of

- ponujanje

- on

- ONE

- samo

- odprite

- open source

- OpenAI

- Optimizirajte

- or

- Ostalo

- naši

- ven

- lastne

- vzporedno

- del

- Partnerstvo

- odstotkov

- platforma

- Platforme

- platon

- Platonova podatkovna inteligenca

- PlatoData

- Veliko

- Pooblastila

- napovedano

- napoved

- Izdelki

- Program

- Programiranje

- programskih jezikov

- Promovirano

- zagotavljanje

- Potiskanje

- Qualcomm

- obsegu

- RE

- Razlog

- nedavno

- relativno

- obvezna

- Raziskave

- viri

- Tveganje

- brezplačno

- Run

- tek

- s

- Je dejal

- Enako

- Samsung

- Zdi se,

- Silicij

- preprosto

- saj

- sestra

- spletna stran

- So

- Software

- nekaj

- Nekaj

- vir

- posebej

- govor

- hitrost

- standardna

- Ustanavljanjem

- lepljiv

- Struktura

- Predlaga

- podpora

- T

- tehnični

- Tehnologije

- da

- O

- njihove

- Njih

- Tukaj.

- te

- mislim

- ta

- ta teden

- skozi

- titan

- do

- danes

- Rekel

- orodje

- proti

- tradicionalna

- Vlak

- Triton

- tweaking

- dva

- poenoteno

- uporaba

- Rabljeni

- navadno

- raznolikost

- različnih

- Prodajalec

- prodajalci

- Proti

- Voice

- vp

- želeli

- je

- način..

- načini

- we

- Sreda

- teden

- Kaj

- kdaj

- ali

- ki

- široka

- bo

- z

- brez

- woo

- deluje

- Delovna skupina

- deluje

- svet

- vredno

- pisati

- napisati kodo

- pisni

- leto

- let

- jo

- Vaša rutina za

- zefirnet