Suresh je tehnološki vodja z globokim tehničnim znanjem in izkušnjami na področju polprevodnikov, umetne inteligence, kibernetske varnosti, interneta stvari, strojne opreme, programske opreme itd. V industriji je preživel 20 let, nazadnje je bil izvršni direktor za odprtokodno ničelno zaupa razvoju čipov na Inštitutu za tehnološke inovacije v Abu Dhabiju in v drugih polprevodniških podjetjih Fortune 500, kot so Intel, Qualcomm in MediaTek, v različnih vodilnih vlogah, kjer je raziskoval in razvijal visoko zmogljive, energetsko učinkovite, postkvantno varne in varne mikročipi/ sistemi na čipih (SoC)/ pospeševalniki za trge podatkovnih centrov, odjemalcev, pametnih telefonov, omrežij, interneta stvari in AI/ML. Prispeval je k Falcon LLM (uvrščen št. 1 v huggingface) in bil vodilni arhitekt za strojno platformo AI po meri (preklicano – prioritete spremenjene). Ima 15+ ameriških patentov in je objavil/predstavil na več kot 20+ konferencah.

Suresh je tehnološki vodja z globokim tehničnim znanjem in izkušnjami na področju polprevodnikov, umetne inteligence, kibernetske varnosti, interneta stvari, strojne opreme, programske opreme itd. V industriji je preživel 20 let, nazadnje je bil izvršni direktor za odprtokodno ničelno zaupa razvoju čipov na Inštitutu za tehnološke inovacije v Abu Dhabiju in v drugih polprevodniških podjetjih Fortune 500, kot so Intel, Qualcomm in MediaTek, v različnih vodilnih vlogah, kjer je raziskoval in razvijal visoko zmogljive, energetsko učinkovite, postkvantno varne in varne mikročipi/ sistemi na čipih (SoC)/ pospeševalniki za trge podatkovnih centrov, odjemalcev, pametnih telefonov, omrežij, interneta stvari in AI/ML. Prispeval je k Falcon LLM (uvrščen št. 1 v huggingface) in bil vodilni arhitekt za strojno platformo AI po meri (preklicano – prioritete spremenjene). Ima 15+ ameriških patentov in je objavil/predstavil na več kot 20+ konferencah.

Suresh je tudi aktiven na vodilnem položaju pri RISC-V International, kjer predseduje Trusted Computing Group za razvoj zaupnih računalniških zmogljivosti RISC-V in predseduje skupini AI/ML Group za razvoj strojnega pospeševanja RISC-V za delovne obremenitve AI/ML, kot je npr. Modeli velikega jezika Transformer, ki se uporabljajo v vrstah aplikacij ChatGPT. Prav tako svetuje startupom in podjetjem tveganega kapitala o podpori pri naložbenih odločitvah, produktni strategiji, tehnološkem skrbnem pregledu itd.

Pridobil je MBA pri INSEAD, magistrski naziv pri Birla Institute of Technology & Science Pilani, certifikat sistemskega inženiringa pri MIT, certifikat AI pri Stanfordu in certifikat za avtomobilsko funkcionalno varnost pri TÜV SÜD.

Povejte nam o svojem podjetju

"Mastiška AI” (Mastiṣka v sanskrtu pomeni možgani) je podjetje za umetno inteligenco, ki se osredotoča na izdelavo računalnikov, podobnih možganom, za učinkovitejše izvajanje temeljnih modelov za generativne primere uporabe umetne inteligence v prihodnosti.

Kakšne težave rešujete?

Glede na prednosti umetne inteligence/generalne umetne inteligence se bo povpraševanje po njem samo še povečalo, prav tako pa se bodo povečali tudi njegovi stranski učinki na naš planet. Kako lahko zmanjšamo ali nevtraliziramo stranske učinke umetne inteligence na našem planetu? Zajemanje ogljika in jedrska energija sta v pravi smeri. Toda temeljito moramo premisliti o tem, kako delamo AI, ali je to napačen način izvajanja ton množenja matrik?

Naši možgani se lahko učijo in opravljajo številne naloge vzporedno, pri 10 W in manj, toda zakaj ti sistemi AI porabijo 10 megavatov za usposabljanje modelov?

Morda prihodnost prinaša energetsko učinkovite arhitekture, kot so nevromorfne arhitekture in transformatorji na osnovi nevronskih mrež, ki so najbližje človeškim možganom, ki bi lahko porabili 100-1000-krat manj energije, s čimer bi zmanjšali stroške uporabe umetne inteligence, jo demokratizirali in rešili naše planet.

Trenutni izzivi, s katerimi se srečujemo pri umetni inteligenci, in sicer a) razpoložljivost, b) dostopnost, c) cenovna dostopnost in d) okoljska varnost, skupaj z nekaterimi priporočili za njihovo reševanje.

Če predvidevamo v prihodnosti, je nekaj uporabnih konceptov AGI prikazanih v filmu »HER«, kjer lik 'Samantha' – pogovorna agentka, ki je naravna, razume čustva, kaže empatijo, je neverjeten kopilot pri delu — in teče naprej. ročnih naprav ves dan, potem se bomo morda morali spoprijeti s spodnjimi izzivi prav zdaj.

Težava 1: Usposabljanje LLM lahko stane od 150 do 10+ milijonov dolarjev in omogoča samo tistim z globljimi žepi, da razvijejo AI. Poleg tega so stroški sklepanja ogromni (stanejo 10x več kot spletno iskanje)

—> Izboljšati moramo energetsko učinkovitost modelov/strojne opreme, da bi demokratizirali AI v korist človeštva.

2. težava: Izvajanje ogromnih modelov umetne inteligence za pogovorne agente ali sisteme priporočil obremenjuje okolje v smislu porabe električne energije in hlajenja.

—> Izboljšati moramo energetsko učinkovitost modelov/strojne opreme, da rešimo naš planet za naše otroke.

Težava 3: Človeški možgani so sposobni in lahko opravljajo več nalog, vendar porabijo le 10 vatov namesto megavatov.

—> Morda bi morali hitreje zgraditi stroje, kot so naši možgani, in ne navadnih matričnih množiteljev.

Človeštvo lahko uspeva samo s trajnostnimi inovacijami in ne s posekanjem vseh gozdov in vrenjem oceanov v imenu inovacij. Naš planet moramo zaščititi za dobrobit naših otrok in prihodnjih generacij ...

Katera področja uporabe so vaša najmočnejša?

Usposabljanje in sklepanje temeljnih modelov, ki temeljijo na transformatorju (in prihodnji nevronski arhitekturi), s 50- do 100-krat večjo energetsko učinkovitostjo v primerjavi z današnjimi rešitvami, ki temeljijo na GPU.

Kaj ne drži vaših strank ponoči?

Težave za stranke, ki trenutno uporabljajo druge izdelke:

Poraba električne energije za usposabljanje ogromnih jezikovnih modelov je presegla streho, na primer, usposabljanje 13B parametrov LLM na 390B besedilnih žetonih na 200 GPE za 7 dni stane 151,744 $ (Vir: HuggingFace nova storitev storitve gruče za usposabljanje – https://lnkd.in/g6Vc5cz3). In celo večji modeli s parametri 100+B stanejo 10+M $ samo za usposabljanje. Nato plačajte za sklepanje vsakič, ko prispe nova promptna zahteva.

Poraba vode za hlajenje, raziskovalci na kalifornijski univerzi Riverside so ocenili okoljski vpliv storitve, podobne ChatGPT, in pravijo, da pogoltne 500 mililitrov vode (približno količini v 16-unčni steklenici vode) vsakič, ko jo vprašate serije od 5 do 50 pozivov ali vprašanj. Razpon se razlikuje glede na lokacijo strežnikov in sezono. Ocena vključuje posredno porabo vode, ki je podjetja ne merijo – na primer za hlajenje elektrarn, ki oskrbujejo podatkovne centre z elektriko. (Vir: https://lnkd.in/gybcxX8C)

Težave za ne-kupce trenutnih izdelkov:

Ne morem si privoščiti CAPEX za nakup strojne opreme

Ne morem si privoščiti uporabe storitev v oblaku

Ne more inovirati ali izkoristiti umetne inteligence – obstal pri modelu storitev, ki odpravlja vsako konkurenčno prednost

Kakšna je konkurenčna pokrajina in kako se razlikujete?

- GPE prevladujejo v prostoru za usposabljanje, čeprav v tem segmentu tekmujejo tudi specializirani ASIC-ji

- Sklepanje Cloud & Edge ima na voljo preveč možnosti

Digitalni, analogni, fotonski – če želite, se ljudje poskušajo spoprijeti z istim problemom.

Ali lahko delite svoje misli o trenutnem stanju arhitekture čipov za AI/ML, kar pomeni, kaj trenutno vidite kot najpomembnejše trende in priložnosti?

Sledijo trendi:

Trend 1: Pred 10 leti je globoko učenje, ki ga podpira strojna oprema, cvetelo, zdaj pa ista strojna oprema zavira napredek. Zaradi visokih stroškov strojne opreme in električne energije za delovanje modelov je dostop do strojne opreme postal izziv. To si lahko privoščijo le podjetja z globokimi žepi in postajajo monopolisti.

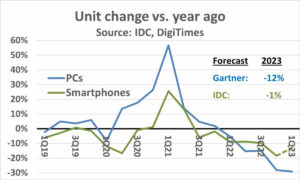

Trend 2: Zdaj, ko so ti modeli tam, jih moramo uporabiti v praktične namene, da se bo obremenitev sklepanja povečala, kar bo omogočilo, da CPE s pospeševalniki umetne inteligence spet pridejo v središče pozornosti.

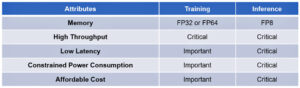

Trend 3: Zagonska podjetja poskušajo pripraviti alternativne predstavitve števil s plavajočo vejico, za katere je tradicionalni format IEEE – kot sta logaritemski in na pozitu – dober, a ne dovolj. Optimizacija prostora za načrtovanje PPA$ eksplodira, ko poskušamo optimizirati eno, drugo pa se zavrti.

Trend 4: Industrija se odmika od modela umetne inteligence, ki temelji na storitvah, k gostovanju lastnih zasebnih modelov v lastnih prostorih – vendar je dostop do strojne opreme izziv zaradi pomanjkanja ponudbe, sankcij itd.

Trenutno stanje:

Razpoložljivost strojne opreme in podatkov je spodbudila rast umetne inteligence pred 10 leti, zdaj pa jo ista strojna oprema nekako zavira – naj razložim

Odkar so bili CPU-ji slabi in so bili GPE-ji preoblikovani v AI, se je zgodilo marsikaj

Podjetja obravnavajo 4 segmente AI/ML, in sicer – 1) usposabljanje v oblaku, 2) sklepanje v oblaku, 3) robno sklepanje in 4) robno usposabljanje (zvezno učenje za aplikacije, občutljive na zasebnost).

Digitalno in analogno

Stran usposabljanja – množica podjetij, ki izdelujejo grafične procesorje, pospeševalnike strank, ki temeljijo na RISC-V, čipe v velikosti rezin (850K jeder) in tako naprej, kjer tradicionalni procesorji manjkajo (njihov splošni namen). Stran sklepanja – pospeševalniki NN so na voljo pri vseh proizvajalcih, v pametnih telefonih, prenosnikih in drugih robnih napravah.

Pred časom so se pojavile tudi arhitekture, ki temeljijo na analognih memristorjih.

Verjamemo, da so CPE lahko zelo dobri pri sklepanju, če jih izboljšamo s pospeškom, kot so matrične razširitve

RISC-V stran stvari:

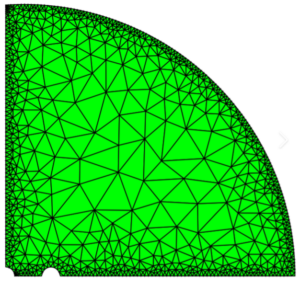

Na strani RISC-V razvijamo pospeševalnike za matrične operacije in druge nelinearne operacije, da odpravimo možna ozka grla za delovne obremenitve transformatorjev. Von Neumannova ozka grla se odpravljajo tudi z arhitekturo pomnilnikov, ki so bližje računalništvu, zaradi česar so CPE s pospeškom AI prava izbira za sklepanje.

Priložnosti:

Obstajajo edinstvene priložnosti za zapolnitev trga modelov temeljev. Primer – OpenAI omenja, da jim ni uspelo zagotoviti dovolj računalništva z umetno inteligenco (GPU-jev), da bi še naprej spodbujali svoje storitve ChatGPT ... in novice poročajo o stroških električne energije, ki so 10-krat višji od običajnega iskanja po internetu in 500 ml vode za hlajenje sistemov. za vsako poizvedbo. Tukaj je trg, ki ga je treba zapolniti – to ni niša, ampak celoten trg, ki bo demokratiziral umetno inteligenco in se spopadel z vsemi zgoraj omenjenimi izzivi – a) razpoložljivost, b) dostopnost, c) cenovna dostopnost in d) okoljska varnost

Na katerih novih funkcijah/tehnologiji delate?

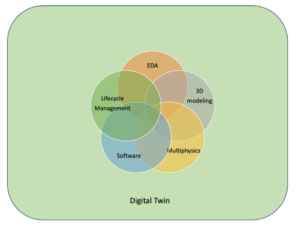

Gradimo možgane, kot so računalniki, ki izkoriščajo nevromodrfične tehnike in modele po meri, da bi izkoristili energetsko učinkovito strojno opremo, pri čemer ponovno uporabimo številne razpoložljive odprte okvire.

Kako si predstavljate rast ali spremembo sektorja AI/ML v naslednjih 12–18 mesecih?

Ker se je povpraševanje po grafičnih procesorjih povečalo (ki stane približno 30 tisoč dolarjev) in nekateri deli sveta se soočajo s sankcijami za nakup teh grafičnih procesorjev, nekateri deli sveta čutijo, da so zamrznjeni v raziskavah in razvoju AI brez dostopa do grafičnih procesorjev. Nadomestne platforme strojne opreme bodo zavzele trg.

Modeli se bodo morda začeli krčiti – modeli po meri ali pa bi se celo bistveno povečala gostota informacij

Isto vprašanje, ampak kako je z rastjo in spremembami v naslednjih 3-5 letih?

a) CPE z razširitvami AI bi zajeli trg sklepanja AI

b) Modeli bi postali okretni in parametri bi izpadli, ko bi se gostota informacij izboljšala s 16 % na 90 %.

c) Energetska učinkovitost se izboljša, odtis CO2 se zmanjša

d) Pojavijo se nove arhitekture

e) stroški strojne opreme in stroški energije se znižajo, tako da vstopna ovira za manjša podjetja pri ustvarjanju in usposabljanju modelov postane cenovno dostopna

f) ljudje govorijo o trenutku pred AGI, toda moje merilo bi bila značilna Samantha (pogovorna umetna inteligenca) v filmu "njena".. kar je morda malo verjetno glede na visoke stroške povečanja

Kateri so nekateri izzivi, ki bi lahko vplivali ali omejili rast v sektorju AI/ML?

a) Dostop do strojne opreme

b) Stroški energije in stroški hlajenja ter škoda za okolje

Preberite tudi:

Intervju z izvršnim direktorjem: David Moore iz Pragmatic

Intervju z izvršnim direktorjem: Dr. Meghali Chopra iz Sandbox Semiconductor

Intervju z izvršnim direktorjem: Dr. J Provine iz podjetja Aligned Carbon

- Distribucija vsebine in PR s pomočjo SEO. Okrepite se še danes.

- PlatoData.Network Vertical Generative Ai. Opolnomočite se. Dostopite tukaj.

- PlatoAiStream. Web3 Intelligence. Razširjeno znanje. Dostopite tukaj.

- PlatoESG. Ogljik, CleanTech, Energija, Okolje, sončna energija, Ravnanje z odpadki. Dostopite tukaj.

- PlatoHealth. Obveščanje o biotehnologiji in kliničnih preskušanjih. Dostopite tukaj.

- vir: https://semiwiki.com/ceo-interviews/338703-ceo-interview-suresh-sugumar-of-mastiska-ai/

- :ima

- : je

- :ne

- :kje

- $GOR

- 1

- 10

- 150

- 20

- 20 let

- 200

- 50

- 500

- 7

- a

- Sposobna

- O meni

- nad

- Abu Dhabi

- pospešek

- pospeševalniki

- dostop

- dostopnost

- aktivno

- Naslov

- naslovljena

- naslavljanje

- Prednost

- zadeve

- spet

- Agent

- agenti

- AGI

- Avgust

- AI

- AI modeli

- ai raziskave

- AI sistemi

- primeri uporabe ai

- AI / ML

- poravnano

- vsi

- Dovoli

- omogoča

- skupaj

- Prav tako

- alternativa

- Neverjetno

- an

- in

- Še ena

- kaj

- kjerkoli

- uporaba

- aplikacije

- Arhitektura

- SE

- območja

- Prihaja

- umetni

- Umetna inteligenca

- AS

- Asics

- vprašati

- At

- avtomobilska

- razpoložljivost

- Na voljo

- stran

- b

- ovira

- temeljijo

- BE

- postanejo

- postane

- postajajo

- bilo

- počutje

- Verjemite

- spodaj

- merilo

- koristi

- Prednosti

- med

- Poleg

- ozka grla

- zavezuje

- Brain

- možgani

- izgradnjo

- Building

- vendar

- nakup

- by

- california

- CAN

- prekinjeno

- zmožnost

- lahko

- Kapital

- zajemanje

- ogljika

- zajemanje ogljikovega

- primeri

- centri

- ceo

- Intervju predsednika uprave

- potrdilo

- izziv

- izzivi

- spremenite

- spremenilo

- spreminjanje

- značaja

- ChatGPT

- Otroci

- čip

- čipi

- izbira

- Chopra

- stranke

- Zapri

- bližje

- Cloud

- Grozd

- co2

- kako

- Podjetja

- podjetje

- v primerjavi z letom

- tekmujejo

- konkurenčno

- Izračunajte

- računalnik

- računalniki

- računalništvo

- koncepti

- konference

- porabijo

- poraba

- naprej

- prispevali

- pogovorni

- pogovorni AI

- Cool

- strošek

- stroški

- bi

- ustvarjajo

- Trenutna

- Trenutno stanje

- Trenutno

- po meri

- stranka

- Stranke, ki so

- rezanje

- Cybersecurity

- datum

- Centri podatki

- Datacenter

- David

- dan

- Dnevi

- Odločitev

- globoko

- globoko učenje

- globlje

- Povpraševanje

- demokratizirati

- Demokratiziranje

- Dokazano

- Gostota

- Odvisno

- Oblikovanje

- Razvoj

- razvili

- razvoju

- Razvoj

- naprave

- Dhabi

- razlikovati

- skrbnosti

- smer

- Direktor

- do

- ne

- tem

- dolarjev

- dont

- navzdol

- dr

- Drop

- 2

- zaslužili

- Edge

- Učinki

- učinkovitosti

- učinkovite

- učinkovito

- elektrika

- Poraba električne energije

- odpravo

- odpravlja

- čustva

- Empatija

- energija

- energetske učinkovitosti

- Inženiring

- okrepi

- dovolj

- Celotna

- Vpis

- okolje

- okolja

- predvidevanje

- oceniti

- ocenjeni

- itd

- Eter (ETH)

- Tudi

- sčasoma

- Tudi vsak

- Primer

- izvršni

- Izvršni direktor

- obstajajo

- strokovno znanje

- Eksplodira

- razširitve

- Obraz

- s katerimi se sooča

- sokol

- hitreje

- občutek

- izpolnite

- podjetja

- plavajoči

- osredotočena

- Foot

- za

- predvideti

- format

- Fortune

- Fundacija

- okviri

- iz

- zamrznjena

- gorivo

- funkcionalno

- v osnovi

- Prihodnost

- splošno

- generacije

- generativno

- Generativna AI

- dana

- Go

- goes

- dogaja

- dobro

- Grafične kartice

- skupina

- Pridelovanje

- Rast

- strojna oprema

- Imajo

- he

- zato

- tukaj

- visoka

- drži

- gostovanje

- Kako

- HTTPS

- velika

- HuggingFace

- človeškega

- Človeštvo

- IEEE

- if

- slika

- vpliv

- izboljšanje

- izboljšuje

- in

- V drugi

- vključuje

- Povečajte

- Industrija

- Podatki

- inovacije

- Inovacije

- novosti

- Namesto

- Inštitut

- Intel

- Intelligence

- Facebook Global

- Internet

- Intervju

- naložbe

- Internet stvari

- IT

- ITS

- samo

- otroci

- Otrok

- Pomanjkanje

- Pokrajina

- jezik

- prenosniki

- velika

- večja

- vodi

- Vodstvo

- UČITE

- učenje

- Naj

- Vzvod

- vzvod

- kot

- svetilka

- LIMIT

- obremenitev

- nahaja

- Poglej

- izgleda kot

- nižje

- Stroji

- Izdelava

- Proizvajalec

- več

- Tržna

- Prisotnost

- Matrix

- max širine

- Maj ..

- mogoče

- MBA

- me

- kar pomeni,

- pomeni

- merjenje

- spomini

- omenjeno

- morda

- milijonov

- milijonov dolarjev

- MIT

- Model

- modeli

- Trenutek

- monopoli

- mesecev

- več

- Najbolj

- Film

- premikanje

- MS

- morajo

- my

- Ime

- in sicer

- naravna

- Nimate

- omrežno

- mreženje

- Nevronski

- Novo

- novice

- Naslednja

- nišo

- noč

- Spreten

- zdaj

- jedrske

- Jedrska energija

- Številka

- oceanov

- of

- on

- ONE

- samo

- odprite

- open source

- OpenAI

- operacije

- Priložnosti

- optimizacija

- Optimizirajte

- možnosti

- or

- Ostalo

- naši

- ven

- lastne

- Stran

- vzporedno

- parameter

- parametri

- deli

- Patenti

- Plačajte

- ljudje

- mogoče

- planet

- rastline

- platforma

- Platforme

- platon

- Platonova podatkovna inteligenca

- PlatoData

- pletora

- plus

- žepi

- Točka

- Stališče

- mogoče

- moč

- elektrarne

- Praktično

- Tiskanje

- zasebna

- problem

- Težave

- Izdelek

- Izdelki

- profil

- Napredek

- pozove

- zaščito

- Namen

- namene

- Push

- Postavlja

- Qualcomm

- vprašanje

- vprašanja

- območje

- uvrstitev

- Preberi

- Pred kratkim

- Priporočilo

- Priporočila

- zmanjša

- zmanjšanje

- redni

- Poročila

- zahteva

- Raziskave

- raziskave in razvoj

- raziskovalci

- Pravica

- Riverside

- vloge

- strehe

- Run

- tek

- deluje

- varna

- Varnost

- Enako

- Sankcije

- peskovnik

- Shrani

- shranjevanje

- pravijo,

- skaliranje

- Znanost

- Iskalnik

- Sezona

- sektor

- zavarovanje

- glej

- segmentih

- polprevodnik

- Polprevodniki

- Serija

- strežniki

- Storitev

- Storitve

- služijo

- Delite s prijatelji, znanci, družino in partnerji :-)

- pomanjkanja

- shouldnt

- je pokazala,

- Razstave

- strani

- pomemben

- saj

- manj

- pametni telefon

- pametne telefone

- So

- Software

- rešitve

- Reševanje

- nekaj

- vir

- Vesolje

- specializirani

- porabljen

- Stanford

- Začetek

- Ustanavljanjem

- Država

- Strategija

- najmočnejši

- taka

- dobavi

- podpora

- trajnostno

- sistemi

- reševanje

- reševanje

- krojenje

- Bodite

- Pogovor

- Naloge

- tehnični

- Tehnologija

- tehnološke inovacije

- Pogoji

- besedilo

- kot

- da

- O

- Prihodnost

- informacije

- svet

- njihove

- Njih

- POTEM

- Tukaj.

- s tem

- te

- jih

- stvari

- ta

- tisti,

- čeprav?

- Uspevajo

- čas

- do

- današnje

- Boni

- jutri

- tudi

- vrh

- metati

- tradicionalna

- Vlak

- usposabljanje

- transformator

- transformatorji

- Trends

- zaupa

- poskusite

- poskuša

- pod

- razume

- univerza

- Univerza v Kaliforniji

- malo verjetno

- us

- Uporaba

- uporaba

- Rabljeni

- uporabo

- različnih

- podjetje

- tveganega kapitala

- podjetja tveganega kapitala

- zelo

- za

- je

- Voda

- način..

- we

- web

- Dobro počutje

- so bili

- Kaj

- kdaj

- ki

- WHO

- zakaj

- bo

- z

- brez

- delo

- deluje

- svet

- bi

- Napačen

- let

- jo

- Vaša rutina za

- zefirnet