Nedavni napredek pri razvoju LLM je populariziral njihovo uporabo za različne naloge NLP, ki so se jih prej lotevali s starejšimi metodami strojnega učenja. Veliki jezikovni modeli so zmožni rešiti različne jezikovne težave, kot so klasifikacija, povzemanje, iskanje informacij, ustvarjanje vsebine, odgovarjanje na vprašanja in vzdrževanje pogovora - vse z uporabo enega samega modela. Toda kako vemo, da dobro opravljajo vse te različne naloge?

Porast magistrskih študijev je razkril nerešen problem: nimamo zanesljivega standarda za njihovo ocenjevanje. Kar otežuje vrednotenje, je, da se uporabljajo za zelo raznolike naloge in nimamo jasne definicije, kaj je dober odgovor za vsak primer uporabe.

Ta članek obravnava trenutne pristope k ocenjevanju LLM in uvaja novo lestvico najboljših LLM, ki izkorišča človeško ocenjevanje, ki izboljšuje obstoječe tehnike ocenjevanja.

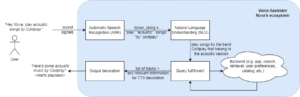

Prva in običajna začetna oblika vrednotenja je zagon modela na več izbranih naborih podatkov in pregled njegove učinkovitosti. HuggingFace je ustvaril Odprite LLM lestvico najboljših kjer se veliki modeli z odprtim dostopom ocenjujejo z uporabo štirih dobro znanih nizov podatkov (AI2 Reasoning Challenge , HellaSwag , MMLU , TruthfulQA). To ustreza samodejnemu ocenjevanju in preverja sposobnost modela, da pridobi dejstva za nekatera specifična vprašanja.

To je primer vprašanja iz MMLU nabor podatkov.

Zadeva: fakultetna_medicina

Vprašanje: Pričakovani stranski učinek dodajanja kreatina je.

- A) mišična oslabelost

- B) povečanje telesne mase

- C) mišični krči

- D) izguba elektrolitov

Odgovor: (B)

Točkovanje modela pri odgovoru na to vrsto vprašanj je pomembna metrika in dobro služi za preverjanje dejstev, vendar ne preizkuša generativne sposobnosti modela. To je verjetno največja pomanjkljivost te metode vrednotenja, saj je ustvarjanje prostega besedila ena najpomembnejših lastnosti LLM.

Zdi se, da znotraj skupnosti obstaja soglasje, da za pravilno ovrednotenje modela potrebujemo človeško vrednotenje. To se običajno naredi s primerjavo odzivov različnih modelov.

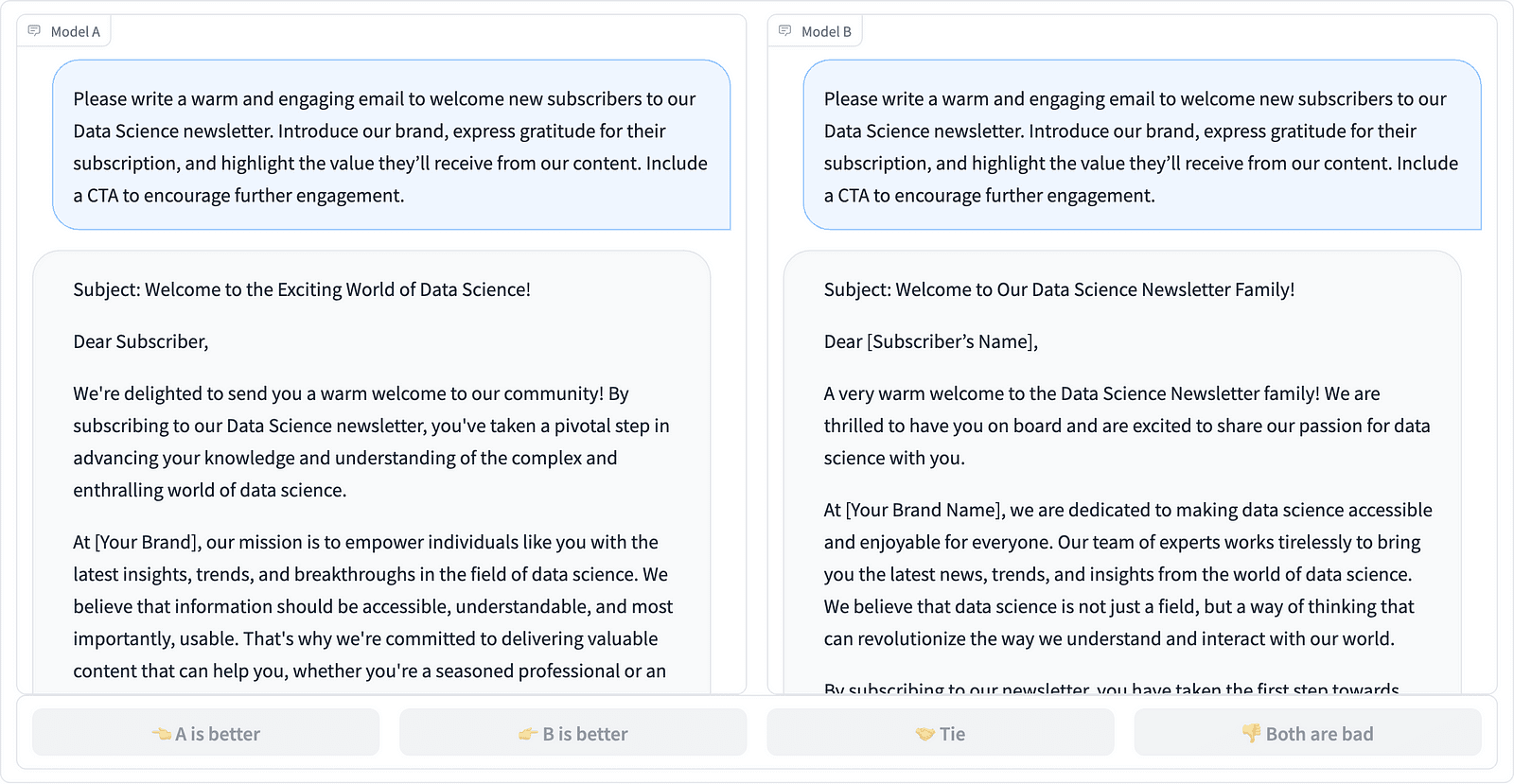

Primerjava dveh hitrih zaključkov v projektu LMSYS – posnetek zaslona avtorja

Komentatorji se odločijo, kateri odziv je boljši, kot je prikazano v zgornjem primeru, in včasih kvantificirajo razliko v kakovosti takojšnjih dokončanj. LMSYS Org je ustvaril a leaderboard ki uporablja to vrsto človeškega vrednotenja in primerja 17 različnih modelov, poroča o Elo ocena za vsak model.

Ker je človeško vrednotenje težko meriti, so bila vložena prizadevanja za povečanje in pospešitev procesa vrednotenja, kar je privedlo do zanimivega projekta, imenovanega AlpacaEval. Tu se vsak model primerja z izhodiščem (text-davinci-003, ki ga zagotavlja GPT-4), človeška ocena pa se nadomesti s presojo GPT-4. To je res hitro in razširljivo, toda ali lahko zaupamo tukajšnjemu modelu, da bo opravil točkovanje? Zavedati se moramo pristranskosti modela. Projekt je dejansko pokazal, da lahko GPT-4 daje prednost daljšim odgovorom.

Metode vrednotenja LLM se še naprej razvijajo, saj skupnost umetne inteligence išče preproste, pravične in razširljive pristope. Najnovejši razvoj prihaja iz ekipe Toloka z novim leaderboard za nadaljnji napredek trenutnih standardov ocenjevanja.

Novi leaderboard primerja odzive modela z uporabniškimi pozivi iz resničnega sveta, ki so razvrščeni po uporabnih nalogah NLP, kot je opisano v ta dokument InstructGPT. Prikazuje tudi skupno zmagovalno stopnjo vsakega modela v vseh kategorijah.

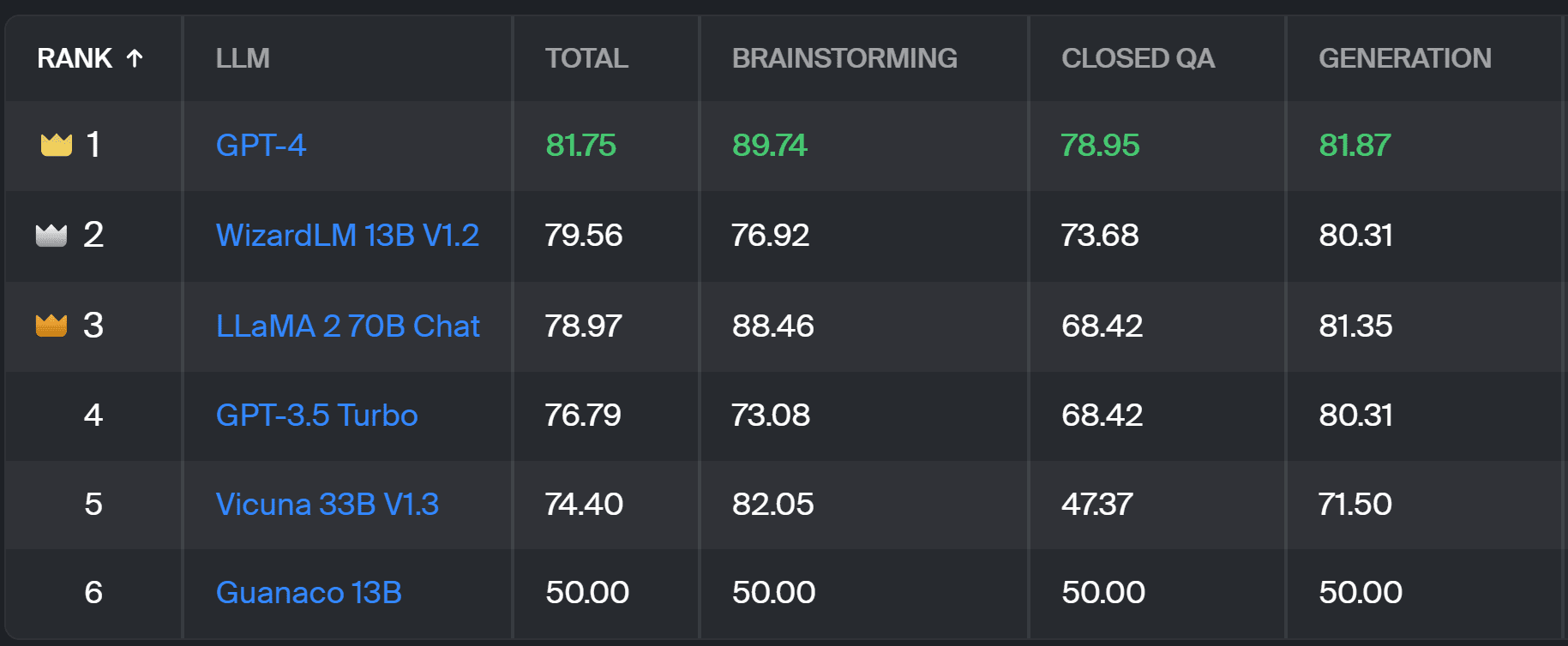

Lestvica Toloka – posnetek zaslona avtorja

Vrednotenje, uporabljeno za ta projekt, je podobno tistemu, izvedenemu v AlpacaEval. Rezultati na lestvici najboljših predstavljajo stopnjo zmage zadevnega modela v primerjavi z Guanaco 13B model, ki tukaj služi kot osnovna primerjava. Izbira Guanaco 13B je izboljšava metode AlpacaEval, ki za osnovo uporablja kmalu zastareli model text-davinci-003.

Dejansko vrednotenje opravijo človeški strokovni označevalci na podlagi niza pozivov iz resničnega sveta. Za vsak poziv dobijo opombevalci dve dopolnitvi in jih vprašajo, katero imajo raje. Podrobnosti o metodologiji najdete tukaj.

Ta vrsta človeškega vrednotenja je bolj uporabna kot katera koli druga metoda samodejnega vrednotenja in bi morala izboljšati človeško vrednotenje, ki se uporablja za Lestvica najboljših LMSYS. Slaba stran metode LMSYS je, da kdorkoli z povezava lahko sodelujejo pri vrednotenju, kar sproža resna vprašanja o kakovosti na ta način zbranih podatkov. Zaprta množica strokovnih označevalcev ima boljši potencial za zanesljive rezultate, Toloka pa uporablja dodatne tehnike nadzora kakovosti, da zagotovi kakovost podatkov.

V tem članku smo predstavili obetavno novo rešitev za ocenjevanje LLM – Toloka Leaderboard. Pristop je inovativen, združuje prednosti obstoječih metod, doda razdrobljenost, specifično za nalogo, in uporablja zanesljive tehnike človeških opomb za primerjavo modelov.

Raziščite tablo in z nami delite svoja mnenja in predloge za izboljšave.

Magdalena Konkiewicz je evangelist podatkov pri Toloki, globalnem podjetju, ki podpira hiter in razširljiv razvoj umetne inteligence. Ima magisterij iz umetne inteligence na univerzi v Edinburghu in je delala kot NLP inženirka, razvijalka in podatkovna znanstvenica za podjetja v Evropi in Ameriki. Sodelovala je tudi pri poučevanju in mentoriranju podatkovnih znanstvenikov ter redno prispeva k publikacijam Data Science in Machine Learning.

- Distribucija vsebine in PR s pomočjo SEO. Okrepite se še danes.

- PlatoData.Network Vertical Generative Ai. Opolnomočite se. Dostopite tukaj.

- PlatoAiStream. Web3 Intelligence. Razširjeno znanje. Dostopite tukaj.

- PlatoESG. Ogljik, CleanTech, Energija, Okolje, sončna energija, Ravnanje z odpadki. Dostopite tukaj.

- PlatoHealth. Obveščanje o biotehnologiji in kliničnih preskušanjih. Dostopite tukaj.

- vir: https://www.kdnuggets.com/a-better-way-to-evaluate-llms?utm_source=rss&utm_medium=rss&utm_campaign=a-better-way-to-evaluate-llms

- :ima

- : je

- :ne

- :kje

- $GOR

- 17

- a

- sposobnost

- O meni

- nad

- čez

- dejanska

- dejansko

- Dodatne

- Dodaja

- napredovanje

- napredek

- AI

- vsi

- Prav tako

- Amerika

- an

- in

- odgovor

- odgovori

- kaj

- velja

- pristop

- pristopi

- SE

- Arena

- članek

- umetni

- Umetna inteligenca

- AS

- At

- Samodejno

- zaveda

- b

- Izhodišče

- BE

- ker

- bilo

- Boljše

- pristranskosti

- največji

- svet

- telo

- prinesel

- podjetja

- vendar

- by

- CAN

- lahko

- primeru

- kategorije

- izziv

- Pregledi

- izbira

- Razvrstitev

- jasno

- zaprto

- združuje

- prihaja

- skupnost

- podjetje

- primerjate

- v primerjavi z letom

- primerjavo

- Primerjava

- Soglasje

- vsebina

- ustvarjanje vsebine

- nadaljevati

- prispeva

- nadzor

- Pogovor

- ustreza

- ustvaril

- Oblikovanje

- Množica

- kurirano

- Trenutna

- datum

- kakovosti podatkov

- znanost o podatkih

- podatkovni znanstvenik

- nabor podatkov

- odloča

- opredelitev

- Stopnja

- Podrobnosti

- Razvojni

- Razvoj

- Razlika

- drugačen

- Slabost

- razne

- do

- ne

- tem

- opravljeno

- dont

- slaba stran

- vsak

- lahka

- Edinburgh

- učinek

- prizadevanja

- elektroliti

- inženir

- zagotovitev

- Evropa

- oceniti

- ocenili

- ocenjevanje

- Ocena

- Evangelist

- razvijajo

- preučiti

- Primer

- obstoječih

- Pričakuje

- strokovnjak

- dejstva

- sejem

- FAST

- prednost

- Lastnosti

- Najdi

- prva

- za

- obrazec

- štiri

- brezplačno

- iz

- nadalje

- Gain

- zbranih

- ustvarjajo

- generativno

- dobili

- GitHub

- dana

- Globalno

- dobro

- dobro delo

- Trdi

- težje

- Imajo

- tukaj

- zelo

- drži

- Kako

- HTTPS

- HuggingFace

- človeškega

- Pomembno

- izboljšanje

- Izboljšanje

- Izboljšave

- izboljšuje

- in

- Podatki

- začetna

- inovativne

- Intelligence

- Zanimivo

- Uvedeno

- Predstavlja

- vključeni

- IT

- ITS

- Job

- samo

- samo en

- KDnuggets

- Vedite

- Pomanjkanje

- jezik

- velika

- Zadnji

- učenje

- vzvod

- light

- več

- off

- stroj

- strojno učenje

- vzdrževanje

- IZDELA

- Način

- Masa

- mojster

- Maj ..

- mentorstvo

- Metoda

- Metodologija

- Metode

- meritev

- Model

- modeli

- več

- Najbolj

- mišice

- Nimate

- Novo

- nova rešitev

- nlp

- of

- starejši

- on

- ONE

- odprite

- Komentarji

- Ostalo

- opisano

- Splošni

- del

- opravlja

- performance

- opravljeno

- platon

- Platonova podatkovna inteligenca

- PlatoData

- potencial

- raje

- prej

- verjetno

- problem

- Težave

- Postopek

- Projekt

- obetaven

- pozove

- pravilno

- če

- publikacije

- kakovost

- vprašanje

- vprašanja

- dvig

- Oceniti

- resnični svet

- redno

- zanesljiv

- nadomesti

- Poročanje

- predstavljajo

- tisti,

- Odgovor

- odgovorov

- rezultat

- Rezultati

- Rise

- Run

- s

- razširljive

- Lestvica

- Znanost

- Znanstvenik

- Znanstveniki

- rezultati

- točkovanje

- iskanja

- Zdi se,

- videl

- resno

- služi

- nastavite

- več

- Delite s prijatelji, znanci, družino in partnerji :-)

- je

- shouldnt

- pokazale

- Razstave

- strani

- Podoben

- sam

- Rešitev

- Reševanje

- nekaj

- Včasih

- specifična

- hitrost

- standardna

- standardi

- prednosti

- taka

- Podpora

- Bodite

- Naloge

- poučevanje

- skupina

- tehnike

- Test

- besedilo

- kot

- da

- O

- njihove

- Njih

- Tukaj.

- te

- jih

- ta

- do

- Zaupajte

- dva

- tip

- tipično

- univerza

- naprej

- us

- Uporaba

- uporaba

- primeru uporabe

- Rabljeni

- uporabnik

- uporablja

- uporabo

- običajno

- raznolikost

- način..

- we

- šibkost

- Dobro

- dobro znana

- so bili

- Kaj

- Kaj je

- ki

- zmago

- z

- v

- delal

- jo

- Vaša rutina za

- zefirnet