Мы все хотим, чтобы наши идеальные человеческие ценности отражались в наших технологиях. Мы ожидаем, что такие технологии, как искусственный интеллект (ИИ), не будут лгать нам, не будут дискриминировать и будут безопасными для нас и наших детей. Тем не менее, многие создатели ИИ в настоящее время сталкиваются с негативной реакцией из-за предвзятости, неточностей и проблемных методов работы с данными, выявленных в их моделях. Эти проблемы требуют большего, чем просто техническое, алгоритмическое решение или решение на основе искусственного интеллекта. На самом деле необходим целостный, социотехнический подход.

Математика демонстрирует мощную истину

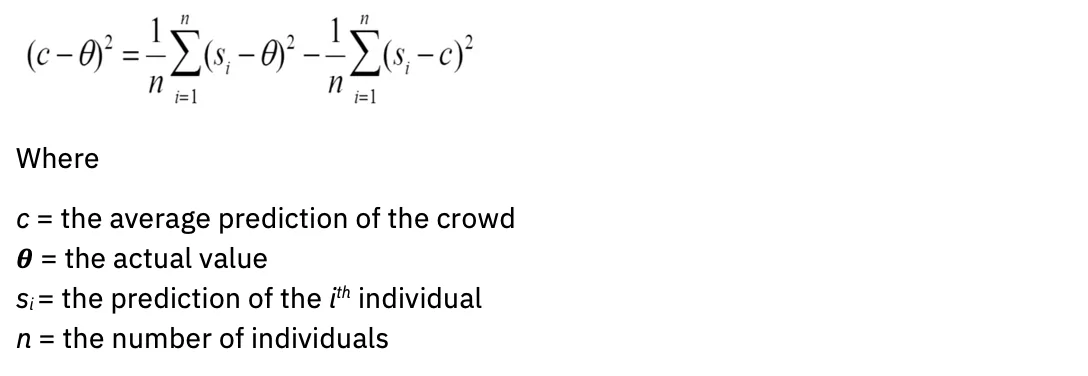

Все прогнозные модели, включая искусственный интеллект, становятся более точными, если они учитывают разнообразный человеческий интеллект и опыт. Это не мнение; оно имеет эмпирическую обоснованность. Рассмотрим теорема о предсказании разнообразия. Проще говоря, когда разнообразие в группе велико, ошибка толпы невелика, что подтверждает концепцию «мудрости толпы». В одном влиятельном исследовании было показано, что различные группы людей, решающих проблемы с низкими способностями, могут превосходить группы людей, решающих проблемы с высокими способностями (Хонг и Пейдж, 2004 г.).

На математическом языке: чем шире ваша дисперсия, тем более стандартным будет ваше среднее значение. Уравнение выглядит так:

A дальнейшее обучение предоставили дополнительные расчеты, которые уточняют статистические определения мудрой толпы, включая незнание прогнозов других членов и включение тех, у кого есть максимально разные (отрицательно коррелированные) прогнозы или суждения. Таким образом, не только объем, но и разнообразие улучшает прогнозы. Как это понимание может повлиять на оценку моделей ИИ?

(не)точность модели

Процитируем распространенный афоризм: все модели неверны. Это справедливо и в области статистики, науки и искусственного интеллекта. Модели, созданные без знания предметной области, могут привести к ошибочный выходы.

Сегодня небольшая однородная группа людей определяет, какие данные использовать для обучения генеративных моделей ИИ, которые черпаются из источников, которые значительно перепредставлены на английском языке. «Для большинства из более чем 6,000 языков мира имеющихся текстовых данных недостаточно для обучения крупномасштабной базовой модели» (из «О возможностях и рисках моделей фундамента», Боммасани и др., 2022).

Кроме того, сами модели создаются на основе ограниченных архитектур: «Почти все современные модели НЛП теперь адаптированы из одной из нескольких базовых моделей, таких как BERT, RoBERTa, BART, T5 и т. д. Хотя эта гомогенизация приводит к чрезвычайно высокий рычаг (любые улучшения в базовых моделях могут привести к немедленным выгодам во всем НЛП), это также является обязательством; все системы ИИ могут унаследовать одни и те же проблемные предубеждения некоторых базовых моделей (Боммасани и др.) "

Чтобы генеративный ИИ лучше отражал разнообразные сообщества, которым он служит, в моделях должно быть представлено гораздо более широкое разнообразие данных о людях.

Оценка точности модели идет рука об руку с оценкой систематической ошибки. Мы должны задаться вопросом: какова цель модели и для кого она оптимизирована? Рассмотрим, например, кто больше всего выигрывает от алгоритмов рекомендации контента и алгоритмов поисковых систем. Заинтересованные стороны могут иметь совершенно разные интересы и цели. Алгоритмы и модели требуют целей или прокси для ошибки Байеса: минимальной ошибки, которую должна улучшить модель. Этим доверенным лицом часто является человек, например эксперт в предметной области с опытом работы в предметной области.

Очень человечная задача: оценка рисков перед закупкой или разработкой модели

Новые правила и планы действий в области ИИ все больше подчеркивают важность алгоритмических форм оценки воздействия. Цель этих форм — собрать важную информацию о моделях ИИ, чтобы команды управления могли оценить и устранить риски перед их развертыванием. Типичные вопросы включают в себя:

- Каков вариант использования вашей модели?

- Каковы риски несопоставимого воздействия?

- Как вы оцениваете справедливость?

- Как вы делаете свою модель объяснимой?

Несмотря на то, что эта модель разработана с благими намерениями, проблема в том, что большинство владельцев моделей ИИ не понимают, как оценивать риски для своего варианта использования. Распространенным рефреном может быть: «Как моя модель может быть несправедливой, если она не собирает личную информацию (PII)?» Следовательно, формы редко заполняются с той тщательностью, которая необходима системам управления для точного выявления факторов риска.

Таким образом, подчеркивается социотехнический характер решения. Владельцу модели — физическому лицу — нельзя просто дать список флажков, чтобы оценить, причинит ли его вариант использования вред. Вместо этого необходимы группы людей с самым разным жизненным опытом, объединяющиеся в сообщества, которые обеспечивают психологическую безопасность, чтобы вести трудные разговоры о несопоставимых воздействиях.

Приветствуя более широкие перспективы для надежного искусственного интеллекта

IBM® верит в подход «нулевого клиента», внедряя рекомендации и системы, которые она создала бы для своих клиентов, в рамках консалтинговых и продуктовых решений. Этот подход распространяется и на этическую практику, поэтому IBM создала Надежный центр передового опыта в области искусственного интеллекта (COE).

Как объяснялось выше, разнообразие опыта и навыков имеет решающее значение для правильной оценки воздействия ИИ. Но перспектива участия в Центре передового опыта может напугать компанию, полную новаторов в области искусственного интеллекта, экспертов и выдающихся инженеров, поэтому необходимо развивать сообщество психологической безопасности. IBM ясно сообщает об этом, говоря: «Заинтересованы в искусственном интеллекте? Интересуетесь этикой ИИ? Тебе место за этим столом.

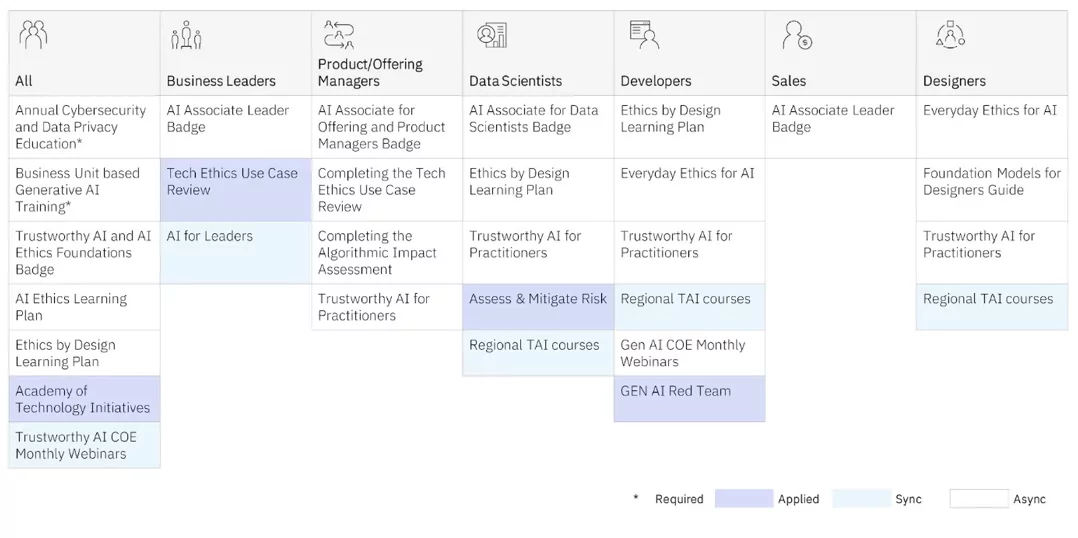

COE предлагает обучение по этике искусственного интеллекта для практиков любого уровня. Предлагаются как синхронные программы обучения (учитель и ученики в классе), так и асинхронные (самостоятельные).

Но это COE прикладной обучение, которое дает нашим практикам самое глубокое понимание, поскольку они работают с глобальными, разнообразными, многопрофильными командами над реальными проектами, чтобы лучше понять разное воздействие. Они также используют структуры дизайн-мышления, разработанные IBM. Дизайн для ИИ группа использует внутри компании и совместно с клиентами для оценки непредвиденных последствий моделей ИИ, уделяя особое внимание тем, кто часто оказывается маргинализированным. (См. Сильвию Дакворт Колесо власти и привилегий для примеров того, как личные характеристики пересекаются, приводя к привилегиям или маргинализации людей.) IBM также передала многие из инфраструктур сообществу открытого исходного кода. Проектируйте этически.

Ниже приведены некоторые из публично опубликованных IBM отчетов об этих проектах:

Инструменты управления автоматизированной моделью ИИ необходимы для получения важной информации о том, как работает ваша модель ИИ. Но учтите, что оптимально учитывать риски задолго до того, как ваша модель будет разработана и запущена в производство. Создавая сообщества разнообразных, междисциплинарных практиков, которые предлагают людям безопасное пространство для жестких дискуссий о разном влиянии, вы можете начать свой путь к практической реализации своих принципов и ответственной разработке ИИ.

На практике, когда вы нанимаете специалистов по искусственному интеллекту, учтите, что более 70% усилий по созданию моделей приходится на подбор правильных данных. Вы хотите нанять людей, которые знают, как собирать репрезентативные данные, которые также собираются с согласия. Вы также хотите, чтобы люди, которые умеют тесно сотрудничать с экспертами в предметной области, убедились, что у них правильный подход. Ключевым моментом является обеспечение этих практиков эмоциональным интеллектом, позволяющим подходить к задаче ответственного курирования ИИ со смирением и проницательностью. Мы должны целенаправленно научиться распознавать, как и когда системы ИИ могут усугубить неравенство так же, как они могут увеличить человеческий интеллект.

Измените принципы работы вашего бизнеса с помощью ИИ

Была ли эта статья полезна?

ДаНет

Больше об искусственном интеллекте

Информационные бюллетени IBM

Получайте наши информационные бюллетени и обновления тем, в которых представлены последние передовые идеи и понимание новых тенденций.

Подписаться

Больше информационных бюллетеней

- SEO-контент и PR-распределение. Получите усиление сегодня.

- PlatoData.Network Вертикальный генеративный ИИ. Расширьте возможности себя. Доступ здесь.

- ПлатонАйСтрим. Интеллект Web3. Расширение знаний. Доступ здесь.

- ПлатонЭСГ. Углерод, чистые технологии, Энергия, Окружающая среда, Солнечная, Управление отходами. Доступ здесь.

- ПлатонЗдоровье. Биотехнологии и клинические исследования. Доступ здесь.

- Источник: https://www.ibm.com/blog/why-we-need-diverse-multidisciplinary-coes-for-model-risk/

- :имеет

- :является

- :нет

- :куда

- $UP

- 000

- 1

- 16

- 2022

- 2024

- 23

- 25

- 28

- 29

- 30

- 300

- 32

- 39

- 40

- 400

- 65

- 7

- 9

- a

- способность

- О нас

- выше

- AC

- ускорять

- точность

- точный

- точно

- через

- Действие

- адаптированный

- адрес

- признавать

- принять

- Реклама

- совет

- влиять на

- агенты

- AI

- AI модели

- Системы искусственного интеллекта

- цель

- AL

- алгоритмический

- алгоритмы

- Все

- причислены

- всегда

- amp

- an

- аналитика

- и

- любой

- Применение

- Приложения

- подхода

- МЫ

- области

- гайд

- искусственный

- искусственный интеллект

- Искусственный интеллект (AI)

- AS

- спросить

- оценить

- Оценка

- оценки;

- помощники

- содействие

- At

- аудио

- увеличивать

- автор

- доступен

- избежать

- назад

- Балансировка

- BE

- было

- до

- начинать

- не являетесь

- считает,

- Преимущества

- Лучшая

- Beyond

- смещение

- предубеждения

- Блог

- блоги

- Синии

- Бостон

- изоферменты печени

- шире

- Строительство

- бизнес

- хозяйственная деятельность

- бизнес

- но

- кнопка

- by

- CAN

- захватить

- Захват

- углерод

- карта

- Карты

- заботится

- случаев

- КПП

- Категории

- Вызывать

- Центр

- Центр Совершенства

- центральный

- определенный

- вызов

- характеристика

- chatbots

- проверка

- ребенок

- Дети

- круги

- СНГ

- класс

- явно

- клиентов

- тесно

- облако

- цвет

- сочетание

- приход

- Общий

- Сообщества

- сообщество

- Компании

- Компания

- Заполненная

- сама концепция

- согласие

- вследствие этого

- Рассматривать

- консалтинг

- Container

- продолжать

- Беседы

- Основные

- исправить

- коррелирует

- Цена

- может

- создали

- Создающий

- Создатели

- критической

- толпа

- CSS

- курирование

- В настоящее время

- изготовленный на заказ

- клиент

- опыт работы с клиентами

- Клиенты

- данным

- Время

- решения

- глубоком

- По умолчанию

- Определения

- доставить

- демонстрирует

- развертывание

- описание

- Проект

- дизайн-мышления

- предназначенный

- Определять

- развивать

- развитый

- различный

- трудный

- Интернет

- цифровое преобразование

- безрассудство

- Выдающийся

- Разное

- Разнообразие

- do

- домен

- пожертвованный

- обращается

- управлять

- Е & Т

- эффекты

- усилие

- уничтожение

- вложения

- обниматься

- появление

- сотрудников

- включить

- привлечение

- Двигатель

- Инженеры

- Английский

- достаточно

- обеспечение

- Enter

- ошибка

- и т.д

- Эфир (ETH)

- этический

- этика

- оценивать

- оценки

- оценка

- Даже

- Каждая

- везде

- обострять

- пример

- Примеры

- Превосходство

- Выход

- ожидать

- опыт

- Впечатления

- эксперту

- опыта

- эксперты

- объяснены

- подвергаться

- продолжается

- чрезвычайно

- что его цель

- facebook мессенджер

- содействовал

- всего лишь пяти граммов героина

- факторы

- справедливость

- ложный

- далеко

- БЫСТРО

- несколько

- Найдите

- Фокус

- следовать

- после

- шрифты

- Что касается

- Передний край

- формы

- Год основания

- каркасы

- от

- передний

- Функции

- собирать

- собранный

- сбор

- генеративный

- Генеративный ИИ

- генератор

- получить

- данный

- дает

- Глобальный

- цель

- Цели

- идет

- хорошо

- управление

- Grammar

- значительно

- сетка

- группы

- Группы

- Рост

- инструкция

- вред

- Есть

- Заголовок

- слышать

- высота

- помощь

- полезный

- High

- его

- Наем

- Наем

- его

- имеет

- целостный

- Главная

- Как

- How To

- HTTPS

- человек

- человеческий интеллект

- смирение

- Гибридный

- Гибридное облако

- i

- БОЛЬНОЙ

- IBM

- ICO

- ICON

- идеальный

- идентифицированный

- if

- Невежество

- изображение

- немедленная

- Влияние

- Воздействие

- осуществлять

- Осуществляющий

- значение

- важную

- улучшать

- улучшение

- улучшается

- in

- включают

- В том числе

- включение

- включать

- все больше и больше

- дополнительный

- индекс

- промышленность

- влиятельный

- информация

- Инновации

- новаторы

- вход

- понимание

- размышления

- немедленно

- вместо

- Институт

- страхование

- страховщики

- Интеллекта

- Умный

- намерение

- Умышленный

- намерения

- заинтересованный

- интересы

- внутренне

- пересекаться

- вмешательство

- пугающим

- внутренний

- мобильной

- вопрос

- вопросы

- IT

- ЕГО

- январь

- присоединиться

- Присоединяйтесь к нам

- путешествие

- JPG

- всего

- хранение

- Основные

- Знать

- известный

- Отсутствие

- язык

- Языки

- большой

- крупномасштабный

- последний

- вести

- лидер

- Наша команда

- изучение

- позволять

- уровень

- Кредитное плечо

- ответственность

- ложь

- такое как

- Ограниченный

- Список

- локальным

- местный

- ВЗГЛЯДЫ

- сделать

- Создание

- управление

- руководство

- многих

- математике

- математический

- Вопрос

- макс-ширина

- Май..

- me

- значить

- Встречайте

- Messenger

- может быть

- мин

- против

- минимальный

- минут

- Мобильный телефон

- модель

- Модели

- модернизация

- БОЛЕЕ

- самых

- двигаться

- много

- многопрофильная

- должен

- my

- природа

- Навигация

- необходимо

- Необходимость

- необходимый

- потребности

- отрицательно

- Новые

- новые продукты

- Рассылки

- НЛП

- нет

- в своих размышлениях

- ничего

- сейчас

- многочисленный

- of

- от

- предлагают

- предложенный

- Предложения

- .

- on

- ONE

- с открытым исходным кодом

- Обзор

- Возможности

- оптимальный

- оптимизированный

- or

- организации

- Другое

- наши

- опережать

- выходы

- за

- собственный

- Владельцы

- страница

- участвующий

- pass

- Люди

- выполнения

- человек

- личного

- Лично

- перспективы

- PHP

- PII

- Планы

- Платон

- Платон Интеллектуальные данные

- ПлатонДанные

- плагин

- политика

- должность

- После

- потенциал

- потенциальные клиенты

- мощностью

- мощный

- практика

- практиками

- прогноз

- Predictions

- интеллектуального

- первичный

- Принципы

- Расставляйте приоритеты

- привилегия

- Проблема

- приобретение

- производит

- Производство

- производительность

- Продукция

- Программы

- проектов

- должным образом

- перспектива

- при условии

- обеспечение

- прокси

- полномочие

- психологический

- публично

- опубликованный

- положил

- Вопросы

- быстро

- цену

- редко

- Готовность

- Reading

- реальные

- Реальность

- признавать

- рекомендаций

- снижение

- совершенствовать

- отражать

- отметила

- правила

- Отчеты

- представитель

- представленный

- Запросы

- требовать

- обязательный

- исследованиям

- ответ

- ответственный

- ответственно

- отзывчивый

- доходы

- Рост выручки

- правую

- Снижение

- факторы риска

- рисках,

- Дорога

- Роботы

- безопасный

- Сохранность

- Сказал

- то же

- поговорка

- Шкала

- масштабирование

- Наука

- экран

- скрипты

- Поиск

- Поисковая система

- безопасный

- посмотреть

- поисковая оптимизация

- служит

- настройки

- должен

- показанный

- просто

- сайте

- слабина

- небольшой

- умный

- Умные Колонки

- SMS

- So

- Решение

- Решения

- некоторые

- Источники

- Space

- динамики

- Спонсоров

- квадраты

- заинтересованных сторон

- стандарт

- Начало

- современное состояние

- статистический

- статистика

- Студенты

- Кабинет

- предмет

- подписаться

- такие

- поддержка

- поддержки

- SVG

- системы

- T

- ТАБЛИЦЫ

- с

- направлена против

- учитель

- команды

- Технический

- технологии

- третичный

- текст

- чем

- благодаря

- который

- Ассоциация

- мир

- их

- Их

- тема

- сами

- Эти

- они

- think

- мышление

- этой

- те

- мысль

- продуманное лидерство

- три

- Через

- время

- Название

- в

- вместе

- инструменты

- топ

- тема

- жесткий

- Train

- Обучение

- трансформация

- Тенденции

- правда

- заслуживающий доверия

- два

- напишите

- типичный

- понимать

- несправедливый

- созданного

- отпирающий

- Updates

- на

- URL

- us

- использование

- прецедент

- использования

- Использующий

- ценностное

- Наши ценности

- разнообразие

- Различная

- очень

- Виртуальный

- объем

- W

- хотеть

- законопроект

- we

- ЧТО Ж

- Что

- Что такое

- когда

- будь то

- который

- в то время как

- КТО

- кого

- зачем

- широко

- Шире

- будете

- мудрость

- WISE

- Word

- WordPress

- Работа

- работает

- Мир

- бы

- письменный

- Неправильно

- еще

- являетесь

- ВАШЕ

- зефирнет